كيفية سحب بيانات برامج الدراسة بالخارج من GoAbroad

استخرج بيانات برامج الدراسة بالخارج والمراجعات وتفاصيل المزودين من GoAbroad. احصل على رؤى لأبحاث السوق التعليمي ومقارنات أسعار البرامج.

تم اكتشاف حماية ضد البوتات

- تحديد معدل الطلبات

- يحد من الطلبات لكل IP/جلسة عبر الوقت. يمكن تجاوزه بالبروكسيات الدوارة وتأخير الطلبات والاستخراج الموزع.

- تحدي JavaScript

- يتطلب تنفيذ JavaScript للوصول إلى المحتوى. الطلبات البسيطة تفشل؛ يلزم متصفح بدون واجهة مثل Playwright أو Puppeteer.

- حظر IP

- يحظر عناوين IP المعروفة لمراكز البيانات والعناوين المُعلَّمة. يتطلب بروكسيات سكنية أو محمولة للتجاوز الفعال.

- User-Agent Filtering

حول GoAbroad

اكتشف ما يقدمه GoAbroad وما هي البيانات القيمة التي يمكن استخراجها.

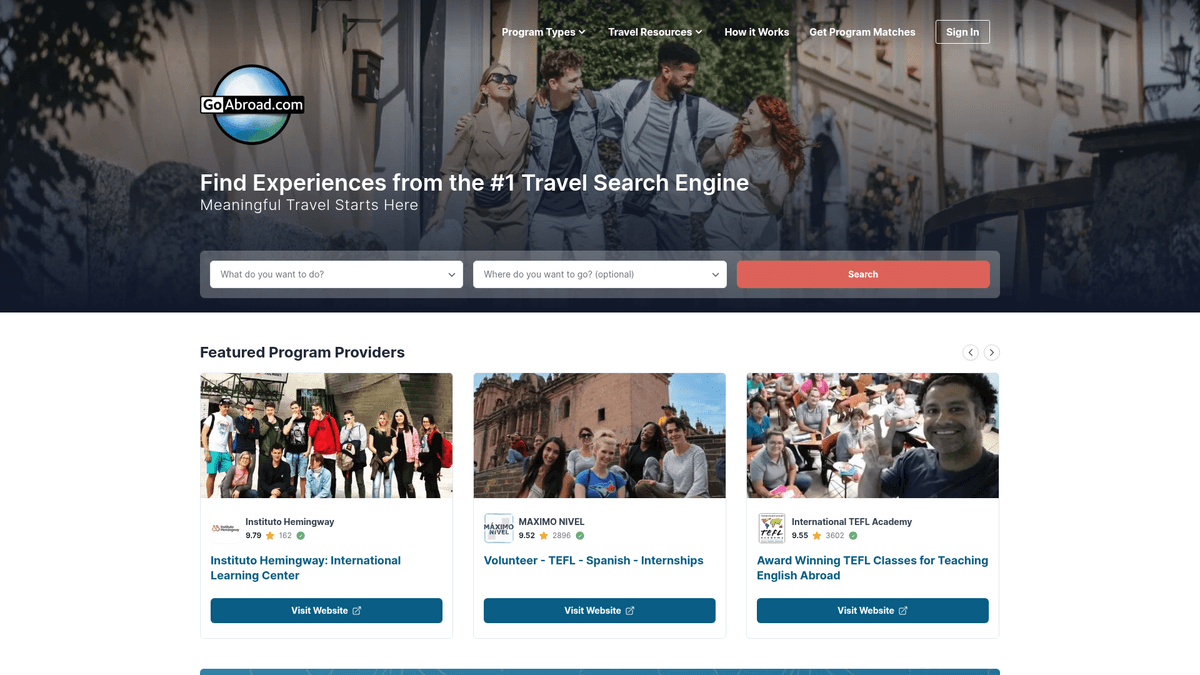

سوق عالمي للتعليم الدولي

يعد GoAbroad.com محرك بحث ودليل رائد للتعليم الدولي وسفر التجارب. يعمل كمنصة شاملة حيث يمكن للمستخدمين اكتشاف برامج الدراسة بالخارج، والتدريب الداخلي، وفرص التطوع، ومدارس اللغات في جميع أنحاء العالم. يهدف الموقع، الذي يديره فريق عالمي، إلى توفير أحدث الموارد لتجارب سفر هادفة.

بيانات مهيكلة لاستخبارات السوق

يحتوي الموقع على بيانات عالية الهيكلة لآلاف البرامج، بما في ذلك متطلبات المجال الأكاديمي، ومعلومات التكلفة، والتوافر الجغرافي. كما يتميز بمجموعة هائلة من مراجعات الطلاب الموثقة، مما يوفر رؤى نوعية حول تجربة المشاركين. هذه البيانات ضرورية للمستشارين الأكاديميين والمزودين الذين يحتاجون إلى مراقبة اتجاهات التعليم العالمية.

القيمة التجارية الاستراتيجية

يعد سحب بيانات GoAbroad ذا قيمة عالية لمزودي البرامج الذين يحتاجون إلى إجراء تحليل تنافسي وتتبع شعبية الوجهات. كما يسمح للباحثين بتحديد المجالات الناشئة في قطاع التعليم الدولي وتحسين استراتيجيات التسعير بناءً على بيانات السوق في الوقت الفعلي المجمعة من آلاف القوائم.

لماذا تجريد GoAbroad؟

اكتشف القيمة التجارية وحالات الاستخدام لاستخراج البيانات من GoAbroad.

إجراء أبحاث السوق الأكاديمية لتحديد وجهات الدراسة الرائجة.

إجراء تحليل تسعير تنافسي لمزودي التعليم الدوليين.

تحليل مشاعر الطلاب عبر آلاف المراجعات الموثقة للبرامج.

توليد عملاء محتملين لتأمين السفر الدولي وخدمات الطلاب.

تجميع البيانات لبوابات المقارنة التعليمية ومدونات السفر المتخصصة.

تحديات التجريد

التحديات التقنية التي قد تواجهها عند تجريد GoAbroad.

يتطلب عرض المحتوى الديناميكي باستخدام Next.js أداة سحب قادرة على تشغيل JavaScript.

يستخدم الترقيم زر 'تحميل المزيد'، مما يستدعي تفاعلاً مع المتصفح.

يمكن أن يكون تحديد المعدل (rate limiting) صارماً إذا تم تقديم الطلبات بسرعة كبيرة دون بروكسيات.

غالباً ما يتم تضمين البيانات في وسم script مما يتطلب تحليلاً خاصاً لـ JSON.

استخرج بيانات GoAbroad بالذكاء الاصطناعي

لا حاجة للبرمجة. استخرج البيانات في دقائق مع الأتمتة المدعومة بالذكاء الاصطناعي.

كيف يعمل

صف ما تحتاجه

أخبر الذكاء الاصطناعي بالبيانات التي تريد استخراجها من GoAbroad. فقط اكتب بلغة طبيعية — لا حاجة لأكواد أو محددات.

الذكاء الاصطناعي يستخرج البيانات

ذكاؤنا الاصطناعي يتصفح GoAbroad، يتعامل مع المحتوى الديناميكي، ويستخرج بالضبط ما طلبته.

احصل على بياناتك

احصل على بيانات نظيفة ومنظمة جاهزة للتصدير كـ CSV أو JSON أو إرسالها مباشرة إلى تطبيقاتك.

لماذا تستخدم الذكاء الاصطناعي للاستخراج

الذكاء الاصطناعي يجعل استخراج بيانات GoAbroad سهلاً بدون كتابة أكواد. منصتنا المدعومة بالذكاء الاصطناعي تفهم البيانات التي تريدها — فقط صفها بلغة طبيعية والذكاء الاصطناعي يستخرجها تلقائياً.

How to scrape with AI:

- صف ما تحتاجه: أخبر الذكاء الاصطناعي بالبيانات التي تريد استخراجها من GoAbroad. فقط اكتب بلغة طبيعية — لا حاجة لأكواد أو محددات.

- الذكاء الاصطناعي يستخرج البيانات: ذكاؤنا الاصطناعي يتصفح GoAbroad، يتعامل مع المحتوى الديناميكي، ويستخرج بالضبط ما طلبته.

- احصل على بياناتك: احصل على بيانات نظيفة ومنظمة جاهزة للتصدير كـ CSV أو JSON أو إرسالها مباشرة إلى تطبيقاتك.

Why use AI for scraping:

- يتعامل مع عرض Next.js الديناميكي وأزرار 'تحميل المزيد' دون أي برمجة.

- يتجاوز تحديد المعدل تلقائياً باستخدام تدوير البروكسي المدمج وبصمة المتصفح.

- تسمح عمليات التشغيل المجدولة بمراقبة المراجعات الجديدة أو تحديثات البرامج أسبوعياً.

- يصدر البيانات مباشرة إلى CSV أو JSON أو Google Sheets للتحليل الفوري.

أدوات تجريد الويب بدون كود لـGoAbroad

بدائل النقر والتأشير للتجريد المدعوم بالذكاء الاصطناعي

يمكن لعدة أدوات بدون كود مثل Browse.ai وOctoparse وAxiom وParseHub مساعدتك في تجريد GoAbroad بدون كتابة كود. تستخدم هذه الأدوات عادةً واجهات مرئية لتحديد البيانات، على الرغم من أنها قد تواجه صعوبة مع المحتوى الديناميكي المعقد أو إجراءات مكافحة البوتات.

سير العمل النموذجي مع أدوات بدون كود

التحديات الشائعة

منحنى التعلم

فهم المحددات ومنطق الاستخراج يستغرق وقتًا

المحددات تتعطل

تغييرات الموقع يمكن أن تكسر سير العمل بالكامل

مشاكل المحتوى الديناميكي

المواقع الغنية بـ JavaScript تتطلب حلولاً معقدة

قيود CAPTCHA

معظم الأدوات تتطلب تدخلاً يدويًا لـ CAPTCHA

حظر IP

الاستخراج المكثف قد يؤدي إلى حظر عنوان IP الخاص بك

أدوات تجريد الويب بدون كود لـGoAbroad

يمكن لعدة أدوات بدون كود مثل Browse.ai وOctoparse وAxiom وParseHub مساعدتك في تجريد GoAbroad بدون كتابة كود. تستخدم هذه الأدوات عادةً واجهات مرئية لتحديد البيانات، على الرغم من أنها قد تواجه صعوبة مع المحتوى الديناميكي المعقد أو إجراءات مكافحة البوتات.

سير العمل النموذجي مع أدوات بدون كود

- تثبيت إضافة المتصفح أو التسجيل في المنصة

- الانتقال إلى الموقع المستهدف وفتح الأداة

- اختيار عناصر البيانات المراد استخراجها بالنقر

- تكوين محددات CSS لكل حقل بيانات

- إعداد قواعد التصفح لاستخراج صفحات متعددة

- التعامل مع CAPTCHA (غالبًا يتطلب حلاً يدويًا)

- تكوين الجدولة للتشغيل التلقائي

- تصدير البيانات إلى CSV أو JSON أو الاتصال عبر API

التحديات الشائعة

- منحنى التعلم: فهم المحددات ومنطق الاستخراج يستغرق وقتًا

- المحددات تتعطل: تغييرات الموقع يمكن أن تكسر سير العمل بالكامل

- مشاكل المحتوى الديناميكي: المواقع الغنية بـ JavaScript تتطلب حلولاً معقدة

- قيود CAPTCHA: معظم الأدوات تتطلب تدخلاً يدويًا لـ CAPTCHA

- حظر IP: الاستخراج المكثف قد يؤدي إلى حظر عنوان IP الخاص بك

أمثلة الكود

import requests

from bs4 import BeautifulSoup

import json

url = 'https://www.goabroad.com/study-abroad/search/italy/study-abroad-1'

headers = {'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/91.0.4472.124 Safari/537.36'}

try:

response = requests.get(url, headers=headers)

soup = BeautifulSoup(response.text, 'html.parser')

# غالباً ما يخفي GoAbroad البيانات في وسم script خاص بـ Next.js يسمى __NEXT_DATA__

next_data = soup.find('script', id='__NEXT_DATA__')

if next_data:

data = json.loads(next_data.string)

print('Successfully extracted hydration data')

# بديل للتحليل الأساسي إذا لم تكن بيانات hydration مطلوبة

listings = soup.select('.listing-card')

for item in listings:

title = item.select_one('h4').text.strip()

print(f'Program Found: {title}')

except Exception as e:

print(f'Error: {e}')متى تستخدم

الأفضل لصفحات HTML الثابتة مع حد أدنى من JavaScript. مثالي للمدونات ومواقع الأخبار وصفحات المنتجات البسيطة.

المزايا

- ●أسرع تنفيذ (بدون عبء المتصفح)

- ●أقل استهلاك للموارد

- ●سهل التوازي مع asyncio

- ●ممتاز لواجهات API والصفحات الثابتة

القيود

- ●لا يمكنه تنفيذ JavaScript

- ●يفشل في تطبيقات الصفحة الواحدة والمحتوى الديناميكي

- ●قد يواجه صعوبة مع أنظمة مكافحة البوتات المعقدة

كيفية استخراج بيانات GoAbroad بالكود

Python + Requests

import requests

from bs4 import BeautifulSoup

import json

url = 'https://www.goabroad.com/study-abroad/search/italy/study-abroad-1'

headers = {'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/91.0.4472.124 Safari/537.36'}

try:

response = requests.get(url, headers=headers)

soup = BeautifulSoup(response.text, 'html.parser')

# غالباً ما يخفي GoAbroad البيانات في وسم script خاص بـ Next.js يسمى __NEXT_DATA__

next_data = soup.find('script', id='__NEXT_DATA__')

if next_data:

data = json.loads(next_data.string)

print('Successfully extracted hydration data')

# بديل للتحليل الأساسي إذا لم تكن بيانات hydration مطلوبة

listings = soup.select('.listing-card')

for item in listings:

title = item.select_one('h4').text.strip()

print(f'Program Found: {title}')

except Exception as e:

print(f'Error: {e}')Python + Playwright

from playwright.sync_api import sync_playwright

def scrape_goabroad():

with sync_playwright() as p:

browser = p.chromium.launch(headless=True)

page = browser.new_page()

page.goto('https://www.goabroad.com/study-abroad/search/italy/study-abroad-1')

page.wait_for_selector('.listing-card')

# النقر على زر تحميل المزيد للكشف عن المزيد من القوائم

for _ in range(3):

load_more = page.query_selector('button:has-text("Load More")')

if load_more:

load_more.click()

page.wait_for_timeout(2000)

programs = page.query_selector_all('.listing-card')

for prog in programs:

title = prog.query_selector('h4').inner_text()

print(f'Program: {title}')

browser.close()

scrape_goabroad()Python + Scrapy

import scrapy

class GoAbroadSpider(scrapy.Spider):

name = 'goabroad'

start_urls = ['https://www.goabroad.com/study-abroad/search/italy/study-abroad-1']

def parse(self, response):

# استخراج البرامج من الصفحة الأولية

for program in response.css('.listing-card'):

yield {

'title': program.css('h4::text').get(),

'provider': program.css('.provider-name::text').get(),

'rating': program.css('.rating-score::text').get()

}

# تتبع الترقيم إذا كان متاحاً

next_page = response.css('a.pagination-next::attr(href)').get()

if next_page:

yield response.follow(next_page, self.parse)Node.js + Puppeteer

const puppeteer = require('puppeteer');

(async () => {

const browser = await puppeteer.launch();

const page = await browser.newPage();

await page.goto('https://www.goabroad.com/study-abroad/search/italy/study-abroad-1');

await page.waitForSelector('.listing-card');

const data = await page.evaluate(() => {

return Array.from(document.querySelectorAll('.listing-card')).map(el => ({

title: el.querySelector('h4')?.innerText,

provider: el.querySelector('.provider-name')?.innerText

}));

});

console.log(data);

await browser.close();

})();ماذا يمكنك فعله ببيانات GoAbroad

استكشف التطبيقات العملية والرؤى من بيانات GoAbroad.

أداة مقارنة أسعار التعليم

إنشاء أداة للطلاب لمقارنة تكاليف شهادات TEFL أو الفصول الدراسية في الخارج على مستوى العالم.

كيفية التنفيذ:

- 1سحب بيانات التكلفة والمدة لأنواع معينة من البرامج.

- 2تحويل جميع الأسعار إلى عملة أساسية مثل الدولار الأمريكي باستخدام API للتحويل.

- 3بناء لوحة تحكم تتيح للمستخدمين التصفية حسب الميزانية والمنطقة.

استخدم Automatio لاستخراج البيانات من GoAbroad وبناء هذه التطبيقات بدون كتابة كود.

ماذا يمكنك فعله ببيانات GoAbroad

- أداة مقارنة أسعار التعليم

إنشاء أداة للطلاب لمقارنة تكاليف شهادات TEFL أو الفصول الدراسية في الخارج على مستوى العالم.

- سحب بيانات التكلفة والمدة لأنواع معينة من البرامج.

- تحويل جميع الأسعار إلى عملة أساسية مثل الدولار الأمريكي باستخدام API للتحويل.

- بناء لوحة تحكم تتيح للمستخدمين التصفية حسب الميزانية والمنطقة.

- مراقبة تقييمات المنافسين

يمكن لمزودي البرامج مراقبة تقييماتهم الخاصة وتقييمات منافسيهم لتحسين جودة الخدمة.

- استخراج التقييمات وعدد المراجعات للمزودين الرئيسيين شهرياً.

- تتبع التغييرات في متوسط الدرجات بمرور الوقت في جدول بيانات.

- تنبيه أصحاب المصلحة عندما ينخفض تقييم المنافس أو يرتفع بشكل ملحوظ.

- توليد العملاء المحتملين دولياً

يمكن لمزودي الخدمات مثل شركات تأمين السفر تحديد الوجهات ذات الإقبال العالي لتسويق خدماتهم للطلاب.

- سحب عدد القوائم لكل مدينة لتحديد وجهات الطلاب ذات الإقبال العالي.

- تحديد المزودين الأعلى تقييماً لشراكات B2B المحتملة.

- ربط بيانات الموقع بمتطلبات السفارات لتقديم خدمات ذات صلة.

- تطوير الشراكات الأكاديمية

يمكن للجامعات تحديد المؤسسات الشريكة المحتملة أو مزودي البرامج في مناطق محددة.

- تحديد المزودين الأعلى تقييماً في المناطق الجغرافية المستهدفة.

- استخراج تفاصيل البرنامج والديموغرافيا الخاصة بالمراجعين لتقييم الملاءمة المؤسسية.

- التواصل مع جهات الاتصال لدى المزودين بمقترحات شراكة مدعومة بالبيانات.

- تحليل مشاعر الطلاب

يمكن لفرق التسويق تحليل نص المراجعة لتحديد الجوانب الأكثر قيمة في برنامج الدراسة بالخارج.

- سحب جميع نصوص المراجعات النوعية لفئات برامج معينة.

- استخدام معالجة اللغات الطبيعية لاستخراج السمات المتكررة مثل 'الانغماس الثقافي'.

- دمج السمات الشائعة في نصوص الإعلانات وأوصاف البرامج.

عزز سير عملك مع أتمتة الذكاء الاصطناعي

يجمع Automatio بين قوة وكلاء الذكاء الاصطناعي وأتمتة الويب والتكاملات الذكية لمساعدتك على إنجاز المزيد في وقت أقل.

نصائح احترافية لتجريد GoAbroad

نصائح الخبراء لاستخراج البيانات بنجاح من GoAbroad.

تحقق دائماً من وسم البرمجية __NEXT_DATA__ أولاً، حيث يحتوي على JSON مهيكلة للصفحة بأكملها.

راقب علامة تبويب الشبكة (network tab) في المتصفح للعثور على نقاط نهاية API الداخلية المستخدمة لوظيفة تحميل المزيد (Load More).

استخدم معدل زحف بطيء (طلب واحد كل 3-5 ثوانٍ) لتجنب اكتشافك بواسطة أدوات تحديد المعدل (rate limiters) البسيطة.

استخدم تدوير البروكسيات السكنية (residential proxies) إذا كنت تخطط لسحب آلاف البرامج عبر دول متعددة.

قم بتخزين البيانات في قاعدة بيانات علائقية لتتمكن من الربط بسهولة بين المزودين ومواقع برامجهم.

الشهادات

ماذا يقول مستخدمونا

انضم إلى الآلاف من المستخدمين الراضين الذين حولوا سير عملهم

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

ذو صلة Web Scraping

How to Scrape Bilregistret.ai: Swedish Vehicle Data Extraction Guide

How to Scrape The AA (theaa.com): A Technical Guide for Car & Insurance Data

How to Scrape Biluppgifter.se: Vehicle Data Extraction Guide

How to Scrape CSS Author: A Comprehensive Web Scraping Guide

How to Scrape Car.info | Vehicle Data & Valuation Extraction Guide

How to Scrape ResearchGate: Publication and Researcher Data

How to Scrape Statista: The Ultimate Guide to Market Data Extraction

How to Scrape Weebly Websites: Extract Data from Millions of Sites

الأسئلة الشائعة حول GoAbroad

ابحث عن إجابات للأسئلة الشائعة حول GoAbroad