كيفية سحب البيانات من Open Collective: دليل البيانات المالية وبيانات المساهمين

تعرف على كيفية سحب البيانات من Open Collective للحصول على المعاملات المالية، وقوائم المساهمين، وبيانات تمويل المشاريع. استخرج رؤى شفافة لأبحاث السوق.

تم اكتشاف حماية ضد البوتات

- Cloudflare

- جدار حماية تطبيقات الويب وإدارة البوتات على مستوى المؤسسات. يستخدم تحديات JavaScript وCAPTCHA وتحليل السلوك. يتطلب أتمتة المتصفح بإعدادات التخفي.

- تحديد معدل الطلبات

- يحد من الطلبات لكل IP/جلسة عبر الوقت. يمكن تجاوزه بالبروكسيات الدوارة وتأخير الطلبات والاستخراج الموزع.

- WAF

حول Open Collective

اكتشف ما يقدمه Open Collective وما هي البيانات القيمة التي يمكن استخراجها.

حول Open Collective

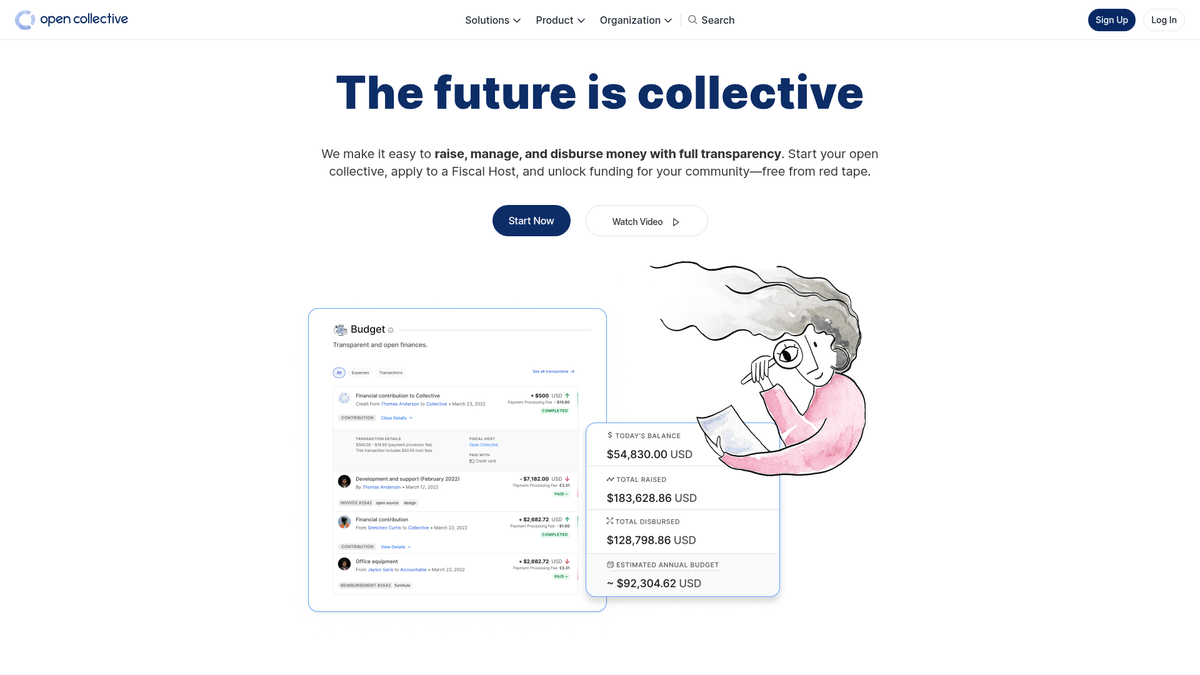

تعد Open Collective منصة مالية وقانونية فريدة مصممة لتوفير الشفافية للمنظمات التي يقودها المجتمع، ومشاريع الـ open-source، وجمعيات الأحياء. من خلال عملها كأداة تمويل لامركزية، تتيح لـ 'المجموعات' (collectives) جمع الأموال وإدارة النفقات دون الحاجة إلى كيان قانوني رسمي، وغالباً ما تستخدم مضيفين ماليين للدعم الإداري. تعتمد المشاريع التقنية الكبرى مثل Babel و Webpack على هذه المنصة لإدارة أنظمتها البيئية الممولة من المجتمع.

تشتهر المنصة بشفافيتها المطلقة؛ حيث يتم تسجيل كل معاملة، سواء كانت تبرعاً من شركة كبرى أو نفقة صغيرة لاجتماع مجتمعي، وتكون مرئية للجمهور. يوفر هذا ثروة من البيانات المتعلقة بالصحة المالية وعادات الإنفاق لبعض أهم تبعات الـ open-source في العالم.

يعد سحب البيانات من Open Collective ذا قيمة عالية للمنظمات التي تتطلع إلى إجراء أبحاث سوقية حول اقتصاد الـ open-source. فهو يسمح للمستخدمين بتحديد فرص رعاية الشركات، وتتبع اتجاهات تمويل المطورين، وتدقيق الاستدامة المالية للمشاريع البرمجية الحيوية. تعمل هذه البيانات كنافذة مباشرة على تدفق رأس المال داخل مجتمع المطورين العالمي.

لماذا تجريد Open Collective؟

اكتشف القيمة التجارية وحالات الاستخدام لاستخراج البيانات من Open Collective.

تحليل استدامة تبعات الـ open-source الحيوية

تحديد فرص رعاية الشركات المحتملة لخدمات B2B

مراقبة اتجاهات التمويل اللامركزي عبر المكدسات التقنية المختلفة

إجراء أبحاث أكاديمية حول الأنظمة المالية من نظير لنظير (P2P)

تدقيق إنفاق المجموعات غير الربحية والمجتمعية لضمان الشفافية

تتبع مشاركة المنافسين في رعاية المشاريع المجتمعية

تحديات التجريد

التحديات التقنية التي قد تواجهها عند تجريد Open Collective.

إدارة استعلامات GraphQL المعقدة لاستخراج البيانات المتداخلة بعمق

التعامل مع Next.js hydration الديناميكي والتنقل عبر التمرير اللانهائي (infinite scroll)

تخطي حماية Cloudflare عند إرسال الطلبات عالية التردد

التعامل مع حدود معدل الطلبات الصارمة على كل من واجهة API ونقاط نهاية الويب

استخرج بيانات Open Collective بالذكاء الاصطناعي

لا حاجة للبرمجة. استخرج البيانات في دقائق مع الأتمتة المدعومة بالذكاء الاصطناعي.

كيف يعمل

صف ما تحتاجه

أخبر الذكاء الاصطناعي بالبيانات التي تريد استخراجها من Open Collective. فقط اكتب بلغة طبيعية — لا حاجة لأكواد أو محددات.

الذكاء الاصطناعي يستخرج البيانات

ذكاؤنا الاصطناعي يتصفح Open Collective، يتعامل مع المحتوى الديناميكي، ويستخرج بالضبط ما طلبته.

احصل على بياناتك

احصل على بيانات نظيفة ومنظمة جاهزة للتصدير كـ CSV أو JSON أو إرسالها مباشرة إلى تطبيقاتك.

لماذا تستخدم الذكاء الاصطناعي للاستخراج

الذكاء الاصطناعي يجعل استخراج بيانات Open Collective سهلاً بدون كتابة أكواد. منصتنا المدعومة بالذكاء الاصطناعي تفهم البيانات التي تريدها — فقط صفها بلغة طبيعية والذكاء الاصطناعي يستخرجها تلقائياً.

How to scrape with AI:

- صف ما تحتاجه: أخبر الذكاء الاصطناعي بالبيانات التي تريد استخراجها من Open Collective. فقط اكتب بلغة طبيعية — لا حاجة لأكواد أو محددات.

- الذكاء الاصطناعي يستخرج البيانات: ذكاؤنا الاصطناعي يتصفح Open Collective، يتعامل مع المحتوى الديناميكي، ويستخرج بالضبط ما طلبته.

- احصل على بياناتك: احصل على بيانات نظيفة ومنظمة جاهزة للتصدير كـ CSV أو JSON أو إرسالها مباشرة إلى تطبيقاتك.

Why use AI for scraping:

- استخراج البيانات المالية المعقدة دون الحاجة لكتابة استعلامات GraphQL

- التعامل تلقائياً مع JavaScript rendering والتمرير اللانهائي

- جدولة عمليات التشغيل المتكررة لمراقبة التغيرات في ميزانية المشروع

- تخطي تدابير مكافحة البوتات (anti-bot) من خلال التنفيذ السحابي الموزع

أدوات تجريد الويب بدون كود لـOpen Collective

بدائل النقر والتأشير للتجريد المدعوم بالذكاء الاصطناعي

يمكن لعدة أدوات بدون كود مثل Browse.ai وOctoparse وAxiom وParseHub مساعدتك في تجريد Open Collective بدون كتابة كود. تستخدم هذه الأدوات عادةً واجهات مرئية لتحديد البيانات، على الرغم من أنها قد تواجه صعوبة مع المحتوى الديناميكي المعقد أو إجراءات مكافحة البوتات.

سير العمل النموذجي مع أدوات بدون كود

التحديات الشائعة

منحنى التعلم

فهم المحددات ومنطق الاستخراج يستغرق وقتًا

المحددات تتعطل

تغييرات الموقع يمكن أن تكسر سير العمل بالكامل

مشاكل المحتوى الديناميكي

المواقع الغنية بـ JavaScript تتطلب حلولاً معقدة

قيود CAPTCHA

معظم الأدوات تتطلب تدخلاً يدويًا لـ CAPTCHA

حظر IP

الاستخراج المكثف قد يؤدي إلى حظر عنوان IP الخاص بك

أدوات تجريد الويب بدون كود لـOpen Collective

يمكن لعدة أدوات بدون كود مثل Browse.ai وOctoparse وAxiom وParseHub مساعدتك في تجريد Open Collective بدون كتابة كود. تستخدم هذه الأدوات عادةً واجهات مرئية لتحديد البيانات، على الرغم من أنها قد تواجه صعوبة مع المحتوى الديناميكي المعقد أو إجراءات مكافحة البوتات.

سير العمل النموذجي مع أدوات بدون كود

- تثبيت إضافة المتصفح أو التسجيل في المنصة

- الانتقال إلى الموقع المستهدف وفتح الأداة

- اختيار عناصر البيانات المراد استخراجها بالنقر

- تكوين محددات CSS لكل حقل بيانات

- إعداد قواعد التصفح لاستخراج صفحات متعددة

- التعامل مع CAPTCHA (غالبًا يتطلب حلاً يدويًا)

- تكوين الجدولة للتشغيل التلقائي

- تصدير البيانات إلى CSV أو JSON أو الاتصال عبر API

التحديات الشائعة

- منحنى التعلم: فهم المحددات ومنطق الاستخراج يستغرق وقتًا

- المحددات تتعطل: تغييرات الموقع يمكن أن تكسر سير العمل بالكامل

- مشاكل المحتوى الديناميكي: المواقع الغنية بـ JavaScript تتطلب حلولاً معقدة

- قيود CAPTCHA: معظم الأدوات تتطلب تدخلاً يدويًا لـ CAPTCHA

- حظر IP: الاستخراج المكثف قد يؤدي إلى حظر عنوان IP الخاص بك

أمثلة الكود

import requests

# The Open Collective GraphQL endpoint

url = 'https://api.opencollective.com/graphql/v2'

# GraphQL query to get basic info about a collective

query = '''

query {

collective(slug: "webpack") {

name

stats {

totalAmountReceived { value }

balance { value }

}

}

}

'''

headers = {'Content-Type': 'application/json'}

try:

# Sending POST request to the API

response = requests.post(url, json={'query': query}, headers=headers)

response.raise_for_status()

data = response.json()

# Extracting and printing the name and balance

collective = data['data']['collective']

print(f"Name: {collective['name']}")

print(f"Balance: {collective['stats']['balance']['value']}")

except Exception as e:

print(f"An error occurred: {e}")متى تستخدم

الأفضل لصفحات HTML الثابتة مع حد أدنى من JavaScript. مثالي للمدونات ومواقع الأخبار وصفحات المنتجات البسيطة.

المزايا

- ●أسرع تنفيذ (بدون عبء المتصفح)

- ●أقل استهلاك للموارد

- ●سهل التوازي مع asyncio

- ●ممتاز لواجهات API والصفحات الثابتة

القيود

- ●لا يمكنه تنفيذ JavaScript

- ●يفشل في تطبيقات الصفحة الواحدة والمحتوى الديناميكي

- ●قد يواجه صعوبة مع أنظمة مكافحة البوتات المعقدة

كيفية استخراج بيانات Open Collective بالكود

Python + Requests

import requests

# The Open Collective GraphQL endpoint

url = 'https://api.opencollective.com/graphql/v2'

# GraphQL query to get basic info about a collective

query = '''

query {

collective(slug: "webpack") {

name

stats {

totalAmountReceived { value }

balance { value }

}

}

}

'''

headers = {'Content-Type': 'application/json'}

try:

# Sending POST request to the API

response = requests.post(url, json={'query': query}, headers=headers)

response.raise_for_status()

data = response.json()

# Extracting and printing the name and balance

collective = data['data']['collective']

print(f"Name: {collective['name']}")

print(f"Balance: {collective['stats']['balance']['value']}")

except Exception as e:

print(f"An error occurred: {e}")Python + Playwright

from playwright.sync_api import sync_playwright

def scrape_opencollective():

with sync_playwright() as p:

# Launching browser with JS support

browser = p.chromium.launch(headless=True)

page = browser.new_page()

page.goto('https://opencollective.com/discover')

# Wait for collective cards to load

page.wait_for_selector('.CollectiveCard')

# Extract data from the DOM

collectives = page.query_selector_all('.CollectiveCard')

for c in collectives:

name = c.query_selector('h2').inner_text()

print(f'Found project: {name}')

browser.close()

scrape_opencollective()Python + Scrapy

import scrapy

import json

class OpenCollectiveSpider(scrapy.Spider):

name = 'opencollective'

start_urls = ['https://opencollective.com/webpack']

def parse(self, response):

# Open Collective uses Next.js; data is often inside a script tag

next_data = response.xpath('//script[@id="__NEXT_DATA__"]/text()').get()

if next_data:

parsed_data = json.loads(next_data)

collective = parsed_data['props']['pageProps']['collective']

yield {

'name': collective.get('name'),

'balance': collective.get('stats', {}).get('balance'),

'currency': collective.get('currency')

}Node.js + Puppeteer

const puppeteer = require('puppeteer');

(async () => {

const browser = await puppeteer.launch();

const page = await browser.newPage();

await page.goto('https://opencollective.com/discover');

// Wait for the dynamic content to load

await page.waitForSelector('.CollectiveCard');

// Map over elements to extract names

const data = await page.evaluate(() => {

return Array.from(document.querySelectorAll('.CollectiveCard')).map(el => ({

name: el.querySelector('h2').innerText

}));

});

console.log(data);

await browser.close();

})();ماذا يمكنك فعله ببيانات Open Collective

استكشف التطبيقات العملية والرؤى من بيانات Open Collective.

التنبؤ بنمو الـ open-source

تحديد التقنيات الرائجة من خلال تتبع معدلات النمو المالي لفئات محددة من المجموعات.

كيفية التنفيذ:

- 1استخراج الإيرادات الشهرية للمشاريع الكبرى في وسوم محددة

- 2حساب معدلات النمو السنوي المركب (CAGR)

- 3تصور الصحة التمويلية للمشروع للتنبؤ باعتماد التقنية

استخدم Automatio لاستخراج البيانات من Open Collective وبناء هذه التطبيقات بدون كتابة كود.

ماذا يمكنك فعله ببيانات Open Collective

- التنبؤ بنمو الـ open-source

تحديد التقنيات الرائجة من خلال تتبع معدلات النمو المالي لفئات محددة من المجموعات.

- استخراج الإيرادات الشهرية للمشاريع الكبرى في وسوم محددة

- حساب معدلات النمو السنوي المركب (CAGR)

- تصور الصحة التمويلية للمشروع للتنبؤ باعتماد التقنية

- توليد العملاء المحتملين لـ SaaS

تحديد المشاريع ذات التمويل الجيد التي قد تحتاج إلى أدوات مطورين، أو استضافة، أو خدمات مهنية.

- تصفية المجموعات حسب الميزانية وإجمالي المبلغ الذي تم جمعه

- استخراج أوصاف المشاريع وعناوين URL للمواقع الخارجية

- التحقق من المكدس التقني (tech stack) من خلال مستودعات GitHub المرتبطة

- تدقيق العمل الخيري للشركات

تتبع أين تنفق الشركات الكبرى ميزانيات مساهماتها في الـ open-source.

- سحب قوائم المساهمين للمشاريع الكبرى

- التصفية بين ملفات تعريف المؤسسات وملفات التعريف الفردية

- تجميع مبالغ المساهمات حسب كيان الشركة

- أبحاث التأثير المجتمعي

تحليل كيفية توزيع المجموعات اللامركزية لأموالها لفهم التأثير الاجتماعي.

- سحب سجل المعاملات الكامل لمجموعة معينة

- تصنيف النفقات (سفر، رواتب، أجهزة)

- إنشاء تقارير حول تخصيص الموارد داخل المجموعات المجتمعية

- قناة توظيف المطورين

العثور على القادة النشطين في أنظمة بيئية محددة بناءً على تاريخهم في إدارة المجتمع والمساهمة.

- سحب قوائم الأعضاء في المجموعات التقنية الرئيسية

- مقابلة المساهمين مع ملفاتهم الشخصية العامة على وسائل التواصل الاجتماعي

- تحديد المطورين النشطين (maintainers) للتواصل رفيع المستوى

عزز سير عملك مع أتمتة الذكاء الاصطناعي

يجمع Automatio بين قوة وكلاء الذكاء الاصطناعي وأتمتة الويب والتكاملات الذكية لمساعدتك على إنجاز المزيد في وقت أقل.

نصائح احترافية لتجريد Open Collective

نصائح الخبراء لاستخراج البيانات بنجاح من Open Collective.

أعطِ الأولوية لـ GraphQL API الرسمي بدلاً من سحب البيانات من الويب (web scraping) للحصول على نتائج أكثر استقراراً وهيكلية.

عند سحب البيانات من الواجهة الأمامية (front-end)، استخدم سمات 'data-cy' في المحددات (selectors) لضمان استقرار أفضل أثناء تحديثات الموقع.

قم بتنفيذ تأخير عشوائي يتراوح بين 2-5 ثوانٍ لمحاكاة تصفح المستخدم البشري وتجنب تفعيل قيود معدل الطلبات (rate-limiting).

استخدم residential proxies دوارة إذا كنت بحاجة إلى إجراء عمليات بحث بحجم كبير من خلال صفحة /discover.

تحقق من ملف robots.txt للتأكد من أن تكرار عمليات سحب البيانات يحترم بارامترات crawl-delay المسموح بها في الموقع.

الشهادات

ماذا يقول مستخدمونا

انضم إلى الآلاف من المستخدمين الراضين الذين حولوا سير عملهم

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

ذو صلة Web Scraping

How to Scrape Moon.ly | Step-by-Step NFT Data Extraction Guide

How to Scrape Yahoo Finance: Extract Stock Market Data

How to Scrape Rocket Mortgage: A Comprehensive Guide

How to Scrape jup.ag: Jupiter DEX Web Scraper Guide

How to Scrape Indiegogo: The Ultimate Crowdfunding Data Extraction Guide

How to Scrape ICO Drops: Comprehensive Crypto Data Guide

How to Scrape Crypto.com: Comprehensive Market Data Guide

How to Scrape Coinpaprika: Crypto Market Data Extraction Guide

الأسئلة الشائعة حول Open Collective

ابحث عن إجابات للأسئلة الشائعة حول Open Collective