Jak scrapovat Seeking Alpha: Finanční data a přepisy (transcripts)

Naučte se, jak scrapovat Seeking Alpha pro akciové zprávy, hodnocení analytiků a přepisy výsledků. Zjistěte, jak obejít Cloudflare a automaticky extrahovat...

Detekována anti-bot ochrana

- Cloudflare

- Podnikový WAF a správa botů. Používá JavaScript výzvy, CAPTCHA a analýzu chování. Vyžaduje automatizaci prohlížeče se stealth nastavením.

- DataDome

- Detekce botů v reálném čase pomocí ML modelů. Analyzuje otisk zařízení, síťové signály a vzorce chování. Běžný na e-commerce stránkách.

- Google reCAPTCHA

- CAPTCHA systém od Google. v2 vyžaduje interakci uživatele, v3 běží tiše s hodnocením rizika. Lze vyřešit pomocí CAPTCHA služeb.

- Omezení rychlosti

- Omezuje požadavky na IP/relaci v čase. Lze obejít rotujícími proxy, zpožděním požadavků a distribuovaným scrapingem.

- Blokování IP

- Blokuje známé IP datových center a označené adresy. Vyžaduje rezidenční nebo mobilní proxy pro efektivní obejití.

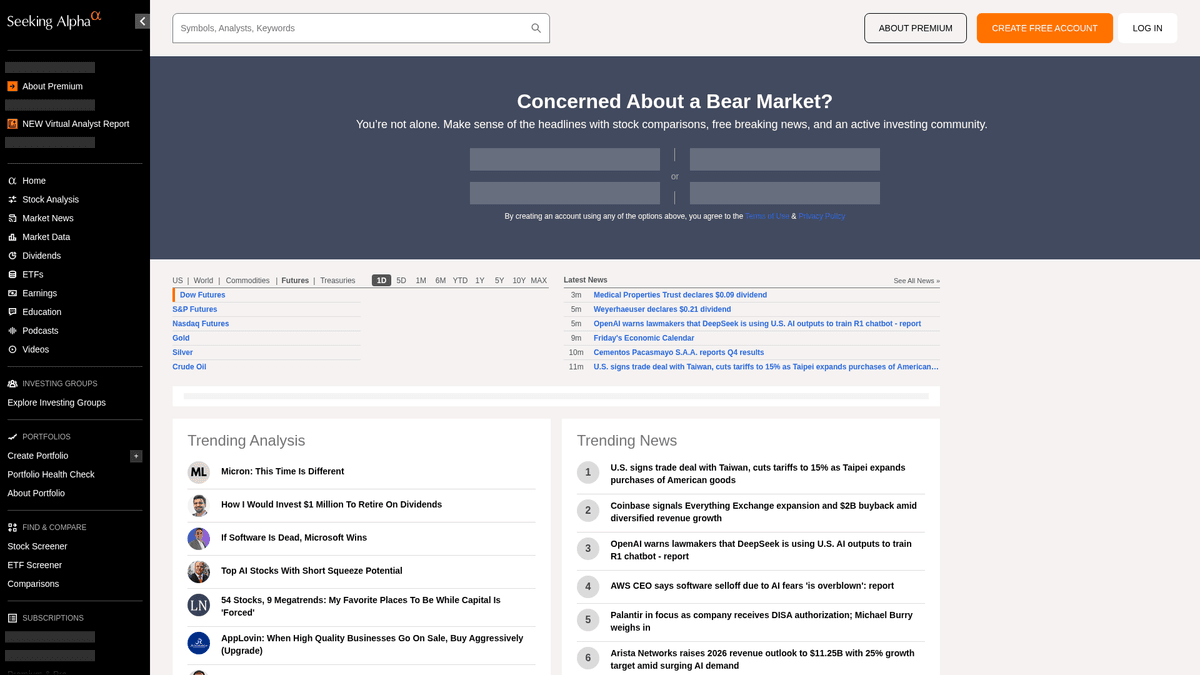

O Seeking Alpha

Objevte, co Seeking Alpha nabízí a jaká cenná data lze extrahovat.

Přední centrum pro finanční analýzy

Seeking Alpha je přední crowdsourcingová platforma pro finanční výzkum, která slouží jako klíčový most mezi syrovými tržními daty a využitelnými investičními poznatky. Hostuje rozsáhlou knihovnu analytických článků, tržní zprávy v reálném čase a nejkomplexnější internetové úložiště přepisů hovorů o výsledcích (earnings transcripts) pro tisíce veřejně obchodovaných společností.

Rozmanitý datový ekosystém

Platforma nabízí bohatství strukturovaných i nestrukturovaných dat, včetně investičních nápadů, dividendové historie a vlastních Quant hodnocení, která překonávají trh. Obsah spravovaný profesionálním redakčním týmem generují tisíce nezávislých analytiků, jejichž příspěvky musí před publikací splňovat vysoké standardy kvality a souladu s předpisy.

Strategická hodnota pro extrakci dat

Scrapování Seeking Alpha je zásadní pro finanční analytiky a kvantitativní obchodníky, kteří provádějí analýzu sentimentu, sledují historické trendy výsledků a monitorují zprávy u konkrétních tickerů. Data poskytují detailní pohled na psychologii trhu a firemní výkonnost, což lze využít k budování sofistikovaných finančních modelů a provádění konkurenční analýzy.

Proč Scrapovat Seeking Alpha?

Objevte obchodní hodnotu a případy použití pro extrakci dat z Seeking Alpha.

Budování enginů pro kvantitativní analýzu sentimentu pro algoritmické obchodování

Agregace přepisů hovorů o výsledcích pro finanční výzkum založený na LLM

Monitorování změn dividend a výplatních poměrů pro příjmová portfolia

Sledování výkonnosti analytiků a posunů v hodnocení napříč konkrétními sektory

Vývoj dashboardů s tržními zprávami v reálném čase pro institucionální klienty

Provádění historické konkurenční analýzy výhledů společností oproti skutečným výsledkům

Výzvy Scrapování

Technické výzvy, se kterými se můžete setkat při scrapování Seeking Alpha.

Agresivní anti-bot detekce využívající Cloudflare a DataDome

Nutnost přihlášení pro přístup k plným textům přepisů hovorů o výsledcích

Dynamické načítání dat přes AJAX/XHR vyžadující plné vykreslení prohlížečem

Sofistikovaný rate limiting, který spouští trvalé zákazy IP pro vysokofrekvenční požadavky

Komplexní HTML struktury s často se měnícími CSS selektory

Scrapujte Seeking Alpha pomocí AI

Žádný kód není potřeba. Extrahujte data během minut s automatizací poháněnou AI.

Jak to funguje

Popište, co potřebujete

Řekněte AI, jaká data chcete extrahovat z Seeking Alpha. Stačí to napsat přirozeným jazykem — žádný kód ani selektory.

AI extrahuje data

Naše umělá inteligence prochází Seeking Alpha, zpracovává dynamický obsah a extrahuje přesně to, co jste požadovali.

Získejte svá data

Získejte čistá, strukturovaná data připravená k exportu jako CSV, JSON nebo k odeslání přímo do vašich aplikací.

Proč používat AI pro scrapování

AI usnadňuje scrapování Seeking Alpha bez psaní kódu. Naše platforma poháněná umělou inteligencí rozumí, jaká data chcete — stačí je popsat přirozeným jazykem a AI je automaticky extrahuje.

How to scrape with AI:

- Popište, co potřebujete: Řekněte AI, jaká data chcete extrahovat z Seeking Alpha. Stačí to napsat přirozeným jazykem — žádný kód ani selektory.

- AI extrahuje data: Naše umělá inteligence prochází Seeking Alpha, zpracovává dynamický obsah a extrahuje přesně to, co jste požadovali.

- Získejte svá data: Získejte čistá, strukturovaná data připravená k exportu jako CSV, JSON nebo k odeslání přímo do vašich aplikací.

Why use AI for scraping:

- No-code prostředí eliminuje potřebu správy složitých knihoven pro automatizaci prohlížeče

- Vestavěná schopnost zpracovávat stránky náročné na JavaScript a dynamické načítání obsahu

- Cloudové spouštění umožňuje plánovaný, objemný sběr dat bez využití lokálních zdrojů

- Automatické řešení standardních vzorců anti-bot detekce a otisků prohlížeče

No-code webové scrapery pro Seeking Alpha

Alternativy point-and-click k AI scrapingu

Několik no-code nástrojů jako Browse.ai, Octoparse, Axiom a ParseHub vám může pomoci scrapovat Seeking Alpha bez psaní kódu. Tyto nástroje obvykle používají vizuální rozhraní pro výběr dat, i když mohou mít problémy se složitým dynamickým obsahem nebo anti-bot opatřeními.

Typický workflow s no-code nástroji

Běžné výzvy

Křivka učení

Pochopení selektorů a logiky extrakce vyžaduje čas

Selektory se rozbijí

Změny webu mohou rozbít celý pracovní postup

Problémy s dynamickým obsahem

Weby s hodně JavaScriptem vyžadují složitá řešení

Omezení CAPTCHA

Většina nástrojů vyžaduje ruční zásah u CAPTCHA

Blokování IP

Agresivní scrapování může vést k zablokování vaší IP

No-code webové scrapery pro Seeking Alpha

Několik no-code nástrojů jako Browse.ai, Octoparse, Axiom a ParseHub vám může pomoci scrapovat Seeking Alpha bez psaní kódu. Tyto nástroje obvykle používají vizuální rozhraní pro výběr dat, i když mohou mít problémy se složitým dynamickým obsahem nebo anti-bot opatřeními.

Typický workflow s no-code nástroji

- Nainstalujte rozšíření prohlížeče nebo se zaregistrujte na platformě

- Přejděte na cílový web a otevřete nástroj

- Vyberte datové prvky k extrakci kliknutím

- Nakonfigurujte CSS selektory pro každé datové pole

- Nastavte pravidla stránkování pro scrapování více stránek

- Vyřešte CAPTCHA (často vyžaduje ruční řešení)

- Nakonfigurujte plánování automatických spuštění

- Exportujte data do CSV, JSON nebo připojte přes API

Běžné výzvy

- Křivka učení: Pochopení selektorů a logiky extrakce vyžaduje čas

- Selektory se rozbijí: Změny webu mohou rozbít celý pracovní postup

- Problémy s dynamickým obsahem: Weby s hodně JavaScriptem vyžadují složitá řešení

- Omezení CAPTCHA: Většina nástrojů vyžaduje ruční zásah u CAPTCHA

- Blokování IP: Agresivní scrapování může vést k zablokování vaší IP

Příklady kódu

import requests

from bs4 import BeautifulSoup

# URL pro nejnovější zprávy z trhu

url = 'https://seekingalpha.com/market-news'

# Standardní hlavičky prohlížeče pro napodobení lidského chování

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/120.0.0.0 Safari/537.36',

'Accept-Language': 'en-US,en;q=0.9',

'Referer': 'https://seekingalpha.com/'

}

def scrape_sa_news():

try:

response = requests.get(url, headers=headers, timeout=10)

if response.status_code == 200:

soup = BeautifulSoup(response.text, 'html.parser')

# Extrakce titulků pomocí atributů data-test-id

headlines = soup.find_all('a', {'data-test-id': 'post-list-item-title'})

for item in headlines:

print(f'Titulek zprávy: {item.text.strip()}')

else:

print(f'Zablokováno se stavovým kódem: {response.status_code}')

except Exception as e:

print(f'Došlo k chybě: {e}')

if __name__ == "__main__":

scrape_sa_news()Kdy použít

Nejlepší pro statické HTML stránky s minimem JavaScriptu. Ideální pro blogy, zpravodajské weby a jednoduché e-commerce produktové stránky.

Výhody

- ●Nejrychlejší provedení (bez režie prohlížeče)

- ●Nejnižší spotřeba zdrojů

- ●Snadná paralelizace s asyncio

- ●Skvělé pro API a statické stránky

Omezení

- ●Nemůže spustit JavaScript

- ●Selhává na SPA a dynamickém obsahu

- ●Může mít problémy se složitými anti-bot systémy

Jak scrapovat Seeking Alpha pomocí kódu

Python + Requests

import requests

from bs4 import BeautifulSoup

# URL pro nejnovější zprávy z trhu

url = 'https://seekingalpha.com/market-news'

# Standardní hlavičky prohlížeče pro napodobení lidského chování

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/120.0.0.0 Safari/537.36',

'Accept-Language': 'en-US,en;q=0.9',

'Referer': 'https://seekingalpha.com/'

}

def scrape_sa_news():

try:

response = requests.get(url, headers=headers, timeout=10)

if response.status_code == 200:

soup = BeautifulSoup(response.text, 'html.parser')

# Extrakce titulků pomocí atributů data-test-id

headlines = soup.find_all('a', {'data-test-id': 'post-list-item-title'})

for item in headlines:

print(f'Titulek zprávy: {item.text.strip()}')

else:

print(f'Zablokováno se stavovým kódem: {response.status_code}')

except Exception as e:

print(f'Došlo k chybě: {e}')

if __name__ == "__main__":

scrape_sa_news()Python + Playwright

from playwright.sync_api import sync_playwright

def run(playwright):

# Spuštění prohlížeče Chromium

browser = playwright.chromium.launch(headless=True)

context = browser.new_context(

user_agent='Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/120.0.0.0 Safari/537.36'

)

page = context.new_page()

try:

# Navigace na stránku s přepisy konkrétního symbolu

page.goto('https://seekingalpha.com/symbol/AAPL/transcripts')

# Čekání na dynamické vykreslení hlavního obsahu

page.wait_for_selector('article', timeout=15000)

# Vyhledání a extrakce titulků přepisů

titles = page.locator('h3').all_inner_texts()

for title in titles:

print(f'Nalezen přepis: {title}')

except Exception as e:

print(f'Extrakce selhala: {e}')

finally:

browser.close()

with sync_playwright() as playwright:

run(playwright)Python + Scrapy

import scrapy

class SeekingAlphaSpider(scrapy.Spider):

name = 'sa_spider'

allowed_domains = ['seekingalpha.com']

start_urls = ['https://seekingalpha.com/latest-articles']

custom_settings = {

'DOWNLOAD_DELAY': 8,

'USER_AGENT': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) Chrome/120.0.0.0',

'ROBOTSTXT_OBEY': False,

'COOKIES_ENABLED': True

}

def parse(self, response):

for article in response.css('article'):

yield {

'title': article.css('h3 a::text').get(),

'link': response.urljoin(article.css('h3 a::attr(href)').get()),

'author': article.css('span[data-test-id="author-name"]::text').get()

}

# Zpracování jednoduché paginace přes odkazy 'next'

next_page = response.css('a.next_page::attr(href)').get()

if next_page:

yield response.follow(next_page, self.parse)Node.js + Puppeteer

const puppeteer = require('puppeteer');

(async () => {

const browser = await puppeteer.launch({ headless: true });

const page = await browser.newPage();

// Nastavení kvalitního User-Agent

await page.setUserAgent('Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/120.0.0.0 Safari/537.36');

try {

// Navigace na domovskou stránku Seeking Alpha

await page.goto('https://seekingalpha.com/', { waitUntil: 'networkidle2' });

// Vyhodnocení skriptů v kontextu prohlížeče pro extrakci titulků

const trending = await page.evaluate(() => {

const nodes = Array.from(document.querySelectorAll('h3'));

return nodes.map(n => n.innerText.trim());

});

console.log('Populární obsah:', trending);

} catch (err) {

console.error('Puppeteer narazil na chybu:', err);

} finally {

await browser.close();

}

})();Co Můžete Dělat S Daty Seeking Alpha

Prozkoumejte praktické aplikace a poznatky z dat Seeking Alpha.

Kvantitativní analýza sentimentu

Finanční firmy využívají články analytiků k určení tržního sentimentu pro konkrétní akciové sektory.

Jak implementovat:

- 1Extrahujte všechny analytické články pro konkrétní průmyslový ticker.

- 2Zpracujte obsah pomocí NLP engine pro výpočet polarity sentimentu.

- 3Integrujte skóre sentimentu do stávajících obchodních algoritmů.

- 4Spouštějte automatická upozornění na nákup/prodej na základě posunů v sentimentu.

Použijte Automatio k extrakci dat z Seeking Alpha a vytvoření těchto aplikací bez psaní kódu.

Co Můžete Dělat S Daty Seeking Alpha

- Kvantitativní analýza sentimentu

Finanční firmy využívají články analytiků k určení tržního sentimentu pro konkrétní akciové sektory.

- Extrahujte všechny analytické články pro konkrétní průmyslový ticker.

- Zpracujte obsah pomocí NLP engine pro výpočet polarity sentimentu.

- Integrujte skóre sentimentu do stávajících obchodních algoritmů.

- Spouštějte automatická upozornění na nákup/prodej na základě posunů v sentimentu.

- Extrakce poznatků z hospodářských výsledků

Extrahujte kritické firemní výhledy přímo z přepisů výsledků pro rychlé reportování.

- Automatizujte denní scraping sekce Earnings Transcripts.

- Vyhledávejte specifická finanční klíčová slova jako 'EBITDA' nebo 'Outlook'.

- Izolujte věty obsahující metriky výhledu managementu.

- Exportujte zjištění do strukturovaného CSV pro revizi investičním výborem.

- Benchmarking dividendových výnosů

Porovnávejte dividendovou výkonnost u tisíců akcií a hledejte výnosové příležitosti.

- Scrapujte historii dividend a výplatní poměry pro definovaný seznam akcií.

- Vypočítejte průměrný výnos oproti historickým trendům pomocí scrapovaných dat.

- Identifikujte akcie, které nedávno zvýšily svou distribuci.

- Aktualizujte soukromý dashboard s porovnáním výnosů v reálném čase.

- Sledování výkonnosti analytiků

Identifikujte vysoce přesné autory, které se vyplatí sledovat pro lepší investiční nápady.

- Scrapujte historická hodnocení a články od nejlépe hodnocených autorů.

- Porovnejte data publikace článků s vývojem ceny akcií.

- Seřaďte autory podle přesnosti jejich doporučení 'Koupit' nebo 'Prodat'.

- Zasílejte automatická oznámení, když vysoce hodnocení autoři zveřejní nové nápady.

Zrychlete svuj workflow s AI automatizaci

Automatio kombinuje silu AI agentu, webove automatizace a chytrych integraci, aby vam pomohl dosahnout vice za kratsi cas.

Profesionální Tipy Pro Scrapování Seeking Alpha

Odborné rady pro úspěšnou extrakci dat z Seeking Alpha.

Používejte prémiové rezidenční proxy, abyste efektivně obešli ochranu Cloudflare/DataDome.

Střídejte User-Agent řetězce a udržujte konzistentní otisky prohlížeče (browser fingerprints) v rámci jedné relace.

Implementujte náhodné čekací doby mezi 10 až 30 sekundami, abyste napodobili vzorce chování skutečných uživatelů.

Scrapujte po uzavření trhu nebo o víkendech, abyste snížili pravděpodobnost omezení kvůli vysokému provozu (rate limits).

Prozkoumejte kartu 'Network' ve vývojářských nástrojích (DevTools) a hledejte interní JSON API endpointy (v3/api) pro získání čistších dat.

Pokud potřebujete scrapovat data přístupná pouze po přihlášení, udržujte perzistentní session cookies.

Reference

Co rikaji nasi uzivatele

Pridejte se k tisicum spokojenych uzivatelu, kteri transformovali svuj workflow

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Souvisejici Web Scraping

How to Scrape Yahoo Finance: Extract Stock Market Data

How to Scrape Moon.ly | Step-by-Step NFT Data Extraction Guide

How to Scrape Rocket Mortgage: A Comprehensive Guide

How to Scrape Open Collective: Financial and Contributor Data Guide

How to Scrape jup.ag: Jupiter DEX Web Scraper Guide

How to Scrape Indiegogo: The Ultimate Crowdfunding Data Extraction Guide

How to Scrape ICO Drops: Comprehensive Crypto Data Guide

How to Scrape Crypto.com: Comprehensive Market Data Guide

Casto kladene dotazy o Seeking Alpha

Najdete odpovedi na bezne otazky o Seeking Alpha