Sådan scraper du Open Collective: Guide til finansielle data og bidragsyderdata

Lær hvordan du scraper Open Collective for finansielle transaktioner, lister over bidragsydere og data om projektfinansiering. Udtræk gennemsigtig indsigt til...

Anti-bot beskyttelse opdaget

- Cloudflare

- Enterprise WAF og bot-håndtering. Bruger JavaScript-udfordringer, CAPTCHAs og adfærdsanalyse. Kræver browserautomatisering med stealth-indstillinger.

- Hastighedsbegrænsning

- Begrænser forespørgsler pr. IP/session over tid. Kan omgås med roterende proxyer, forespørgselsforsinkelser og distribueret scraping.

- WAF

Om Open Collective

Opdag hvad Open Collective tilbyder og hvilke værdifulde data der kan udtrækkes.

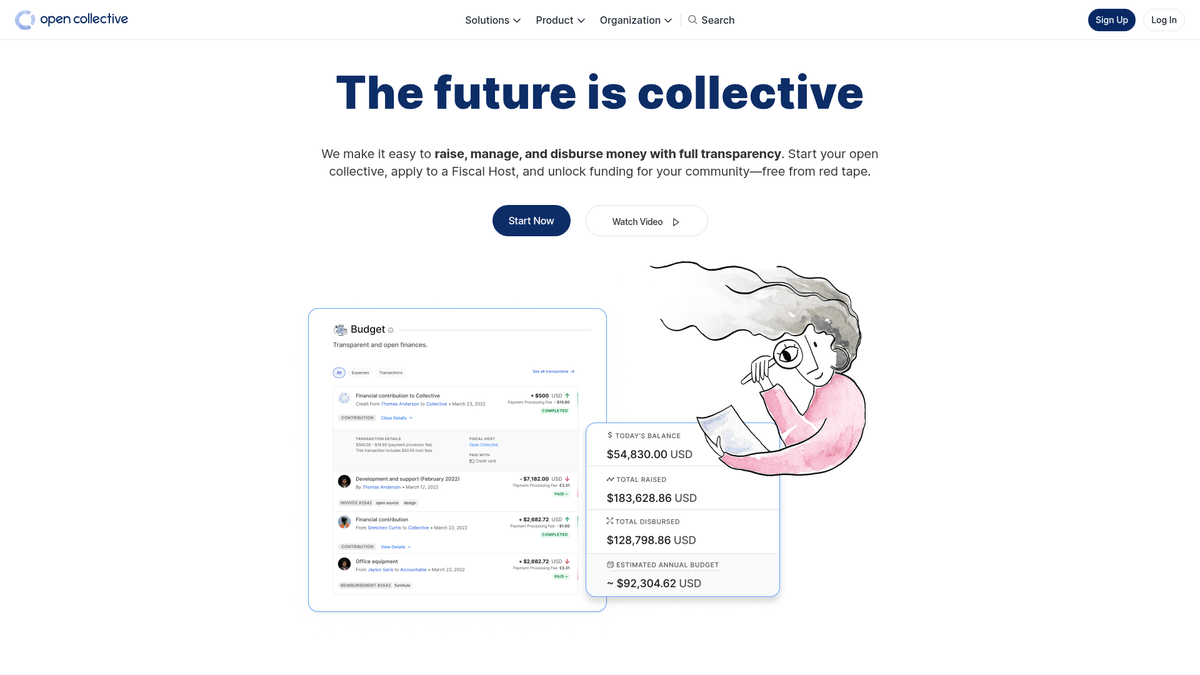

Om Open Collective

Open Collective er en unik finansiel og juridisk platform designet til at skabe gennemsigtighed for samfundsdrevne organisationer, open-source projekter og naboforeninger. Ved at fungere som et decentraliseret finansieringsværktøj gør det muligt for 'collectives' at indsamle penge og administrere udgifter uden behov for en formel juridisk enhed, ofte ved at benytte fiscal hosts til administrativ støtte. Store teknologiprojekter som Babel og Webpack er afhængige af denne platform til at administrere deres community-finansierede økosystemer.

Platformen er kendt for sin radikale gennemsigtighed. Hver eneste transaktion, uanset om det er en donation fra en stor virksomhed eller en lille udgift til et lokalt meetup, logges og er offentligt synlig. Dette giver en rigdom af data vedrørende den finansielle sundhed og forbrugsvaner i nogle af verdens mest kritiske open-source-afhængigheder.

Scraping af Open Collective er yderst værdifuldt for organisationer, der ønsker at udføre markedsundersøgelser af open-source-økonomien. Det giver brugere mulighed for at identificere potentielle virksomhedssponsorater, spore tendenser i udviklerfinansiering og revidere den finansielle bæredygtighed af kritiske softwareprojekter. Dataene fungerer som et direkte vindue ind i kapitalstrømmen inden for det globale udvikler-community.

Hvorfor Skrabe Open Collective?

Opdag forretningsværdien og brugsscenarier for dataudtrækning fra Open Collective.

Analysér bæredygtigheden af kritiske open-source-afhængigheder

Identificér potentielle virksomhedssponsorater til B2B-services

Overvåg tendenser for decentraliseret finansiering på tværs af forskellige tech-stacks

Udfør akademisk forskning i peer-to-peer finansielle systemer

Revidér non-profit- og community-gruppers forbrug for gennemsigtighed

Spor konkurrenters involvering i sponsorater af community-projekter

Skrabningsudfordringer

Tekniske udfordringer du kan støde på når du skraber Open Collective.

Håndtering af komplekse GraphQL-forespørgsler til udtræk af dybt indlejrede data

Håndtering af dynamisk Next.js hydration og paginering med infinite scroll

Omgåelse af Cloudflare-beskyttelse ved højfrekvente anmodninger

Håndtering af strenge rate limits på både API og web-endpoints

Skrab Open Collective med AI

Ingen kode nødvendig. Udtræk data på minutter med AI-drevet automatisering.

Sådan fungerer det

Beskriv hvad du har brug for

Fortæl AI'en hvilke data du vil udtrække fra Open Collective. Skriv det bare på almindeligt sprog — ingen kode eller selektorer nødvendige.

AI udtrækker dataene

Vores kunstige intelligens navigerer Open Collective, håndterer dynamisk indhold og udtrækker præcis det du bad om.

Få dine data

Modtag rene, strukturerede data klar til eksport som CSV, JSON eller send direkte til dine apps og workflows.

Hvorfor bruge AI til skrabning

AI gør det nemt at skrabe Open Collective uden at skrive kode. Vores AI-drevne platform bruger kunstig intelligens til at forstå hvilke data du ønsker — beskriv det på almindeligt sprog, og AI udtrækker dem automatisk.

How to scrape with AI:

- Beskriv hvad du har brug for: Fortæl AI'en hvilke data du vil udtrække fra Open Collective. Skriv det bare på almindeligt sprog — ingen kode eller selektorer nødvendige.

- AI udtrækker dataene: Vores kunstige intelligens navigerer Open Collective, håndterer dynamisk indhold og udtrækker præcis det du bad om.

- Få dine data: Modtag rene, strukturerede data klar til eksport som CSV, JSON eller send direkte til dine apps og workflows.

Why use AI for scraping:

- Udtræk komplekse finansielle data uden at skrive GraphQL-forespørgsler

- Håndtér automatisk JavaScript-rendering og infinite scroll

- Planlæg tilbagevendende kørsler for at overvåge ændringer i projektbudgetter

- Omgå anti-bot-foranstaltninger via distribueret cloud-afvikling

No-code webscrapere til Open Collective

Point-and-click alternativer til AI-drevet scraping

Flere no-code værktøjer som Browse.ai, Octoparse, Axiom og ParseHub kan hjælpe dig med at scrape Open Collective uden at skrive kode. Disse værktøjer bruger typisk visuelle interfaces til at vælge data, selvom de kan have problemer med komplekst dynamisk indhold eller anti-bot foranstaltninger.

Typisk workflow med no-code værktøjer

Almindelige udfordringer

Indlæringskurve

At forstå selektorer og ekstraktionslogik tager tid

Selektorer går i stykker

Webstedsændringer kan ødelægge hele din arbejdsgang

Problemer med dynamisk indhold

JavaScript-tunge sider kræver komplekse løsninger

CAPTCHA-begrænsninger

De fleste værktøjer kræver manuel indgriben for CAPTCHAs

IP-blokering

Aggressiv scraping kan føre til blokering af din IP

No-code webscrapere til Open Collective

Flere no-code værktøjer som Browse.ai, Octoparse, Axiom og ParseHub kan hjælpe dig med at scrape Open Collective uden at skrive kode. Disse værktøjer bruger typisk visuelle interfaces til at vælge data, selvom de kan have problemer med komplekst dynamisk indhold eller anti-bot foranstaltninger.

Typisk workflow med no-code værktøjer

- Installer browserudvidelse eller tilmeld dig platformen

- Naviger til målwebstedet og åbn værktøjet

- Vælg dataelementer med point-and-click

- Konfigurer CSS-selektorer for hvert datafelt

- Opsæt pagineringsregler til at scrape flere sider

- Håndter CAPTCHAs (kræver ofte manuel løsning)

- Konfigurer planlægning for automatiske kørsler

- Eksporter data til CSV, JSON eller forbind via API

Almindelige udfordringer

- Indlæringskurve: At forstå selektorer og ekstraktionslogik tager tid

- Selektorer går i stykker: Webstedsændringer kan ødelægge hele din arbejdsgang

- Problemer med dynamisk indhold: JavaScript-tunge sider kræver komplekse løsninger

- CAPTCHA-begrænsninger: De fleste værktøjer kræver manuel indgriben for CAPTCHAs

- IP-blokering: Aggressiv scraping kan føre til blokering af din IP

Kodeeksempler

import requests

# Open Collective GraphQL endpoint

url = 'https://api.opencollective.com/graphql/v2'

# GraphQL-forespørgsel for at få basisinfo om et collective

query = '''

query {

collective(slug: "webpack") {

name

stats {

totalAmountReceived { value }

balance { value }

}

}

}

'''

headers = {'Content-Type': 'application/json'}

try:

# Sender POST-anmodning til API'en

response = requests.post(url, json={'query': query}, headers=headers)

response.raise_for_status()

data = response.json()

# Udtrækker og printer navn og balance

collective = data['data']['collective']

print(f"Navn: {collective['name']}")

print(f"Balance: {collective['stats']['balance']['value']}")

except Exception as e:

print(f"Der opstod en fejl: {e}")Hvornår skal det bruges

Bedst til statiske HTML-sider med minimal JavaScript. Ideel til blogs, nyhedssider og simple e-handelsprodukt sider.

Fordele

- ●Hurtigste udførelse (ingen browser overhead)

- ●Laveste ressourceforbrug

- ●Let at parallelisere med asyncio

- ●Fremragende til API'er og statiske sider

Begrænsninger

- ●Kan ikke køre JavaScript

- ●Fejler på SPA'er og dynamisk indhold

- ●Kan have problemer med komplekse anti-bot systemer

Sådan scraper du Open Collective med kode

Python + Requests

import requests

# Open Collective GraphQL endpoint

url = 'https://api.opencollective.com/graphql/v2'

# GraphQL-forespørgsel for at få basisinfo om et collective

query = '''

query {

collective(slug: "webpack") {

name

stats {

totalAmountReceived { value }

balance { value }

}

}

}

'''

headers = {'Content-Type': 'application/json'}

try:

# Sender POST-anmodning til API'en

response = requests.post(url, json={'query': query}, headers=headers)

response.raise_for_status()

data = response.json()

# Udtrækker og printer navn og balance

collective = data['data']['collective']

print(f"Navn: {collective['name']}")

print(f"Balance: {collective['stats']['balance']['value']}")

except Exception as e:

print(f"Der opstod en fejl: {e}")Python + Playwright

from playwright.sync_api import sync_playwright

def scrape_opencollective():

with sync_playwright() as p:

# Start browser med JS-support

browser = p.chromium.launch(headless=True)

page = browser.new_page()

page.goto('https://opencollective.com/discover')

# Vent på at collective-kort indlæses

page.wait_for_selector('.CollectiveCard')

# Udtræk data fra DOM'en

collectives = page.query_selector_all('.CollectiveCard')

for c in collectives:

name = c.query_selector('h2').inner_text()

print(f'Fundet projekt: {name}')

browser.close()

scrape_opencollective()Python + Scrapy

import scrapy

import json

class OpenCollectiveSpider(scrapy.Spider):

name = 'opencollective'

start_urls = ['https://opencollective.com/webpack']

def parse(self, response):

# Open Collective bruger Next.js; data ligger ofte i et script-tag

next_data = response.xpath('//script[@id="__NEXT_DATA__"]/text()').get()

if next_data:

parsed_data = json.loads(next_data)

collective = parsed_data['props']['pageProps']['collective']

yield {

'name': collective.get('name'),

'balance': collective.get('stats', {}).get('balance'),

'currency': collective.get('currency')

}Node.js + Puppeteer

const puppeteer = require('puppeteer');

(async () => {

const browser = await puppeteer.launch();

const page = await browser.newPage();

await page.goto('https://opencollective.com/discover');

// Vent på, at det dynamiske indhold indlæses

await page.waitForSelector('.CollectiveCard');

// Map over elementer for at udtrække navne

const data = await page.evaluate(() => {

return Array.from(document.querySelectorAll('.CollectiveCard')).map(el => ({

name: el.querySelector('h2').innerText

}));

});

console.log(data);

await browser.close();

})();Hvad Du Kan Gøre Med Open Collective-Data

Udforsk praktiske anvendelser og indsigter fra Open Collective-data.

Prognose for Open Source-vækst

Identificér trending teknologier ved at spore den finansielle vækstrate for specifikke collective-kategorier.

Sådan implementeres:

- 1Udtræk månedlig omsætning for top-projekter inden for specifikke tags

- 2Beregn den årlige vækstrate (CAGR)

- 3Visualisér projekternes finansielle sundhed for at forudsige tech-adoption

Brug Automatio til at udtrække data fra Open Collective og bygge disse applikationer uden at skrive kode.

Hvad Du Kan Gøre Med Open Collective-Data

- Prognose for Open Source-vækst

Identificér trending teknologier ved at spore den finansielle vækstrate for specifikke collective-kategorier.

- Udtræk månedlig omsætning for top-projekter inden for specifikke tags

- Beregn den årlige vækstrate (CAGR)

- Visualisér projekternes finansielle sundhed for at forudsige tech-adoption

- Leadgenerering til SaaS

Identificér vel-finansierede projekter, der kan have brug for udviklerværktøjer, hosting eller professionelle services.

- Filtrér collectives efter budget og samlet indsamlet beløb

- Udtræk projektbeskrivelser og eksterne website-URL'er

- Verificér deres tech-stack via linkede GitHub-repositories

- Revision af virksomheders filantropi

Spor, hvor store virksomheder bruger deres budgetter til open-source-bidrag.

- Scrape lister over bidragsydere for top-projekter

- Filtrér efter virksomhedsprofiler vs. individuelle profiler

- Aggregér bidragsbeløb efter virksomhed

- Forskning i samfundsmæssig påvirkning

Analysér, hvordan decentraliserede grupper fordeler deres midler for at forstå social impact.

- Scrape hele transaktionsloggen for et specifikt collective

- Kategorisér udgifter (rejser, lønninger, hardware)

- Generér rapporter om ressourceallokering i community-grupper

- Pipeline til rekruttering af udviklere

Find aktive ledere i specifikke økosystemer baseret på deres community-management og historik for bidrag.

- Scrape medlemslister for vigtige tekniske collectives

- Krydsreferér bidragsydere med deres offentlige sociale profiler

- Identificér aktive maintainers for målrettet outreach

Supercharg din arbejdsgang med AI-automatisering

Automatio kombinerer kraften fra AI-agenter, webautomatisering og smarte integrationer for at hjælpe dig med at udrette mere på kortere tid.

Professionelle Tips til Skrabning af Open Collective

Ekspertråd til succesfuld dataudtrækning fra Open Collective.

Prioritér den officielle GraphQL API frem for web scraping for at få mere stabile og strukturerede resultater.

Når du scraper front-end'en, skal du bruge 'data-cy'-attributter i dine selectors for bedre stabilitet under opdateringer af sitet.

Implementér en tilfældig forsinkelse på mellem 2-5 sekunder for at efterligne menneskelig browsing og undgå rate-limiting-triggere.

Brug roterende residential proxies, hvis du har brug for at udføre søgninger i store mængder via /discover-siden.

Tjek robots.txt-filen for at sikre, at din scraping-frekvens respekterer sitets tilladte crawl-delay-parametre.

Anmeldelser

Hvad vores brugere siger

Slut dig til tusindvis af tilfredse brugere, der har transformeret deres arbejdsgang

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Relateret Web Scraping

How to Scrape Moon.ly | Step-by-Step NFT Data Extraction Guide

How to Scrape Yahoo Finance: Extract Stock Market Data

How to Scrape Rocket Mortgage: A Comprehensive Guide

How to Scrape jup.ag: Jupiter DEX Web Scraper Guide

How to Scrape Indiegogo: The Ultimate Crowdfunding Data Extraction Guide

How to Scrape ICO Drops: Comprehensive Crypto Data Guide

How to Scrape Crypto.com: Comprehensive Market Data Guide

How to Scrape Coinpaprika: Crypto Market Data Extraction Guide

Ofte stillede spørgsmål om Open Collective

Find svar på almindelige spørgsmål om Open Collective