Qwen3.5-397B-A17B

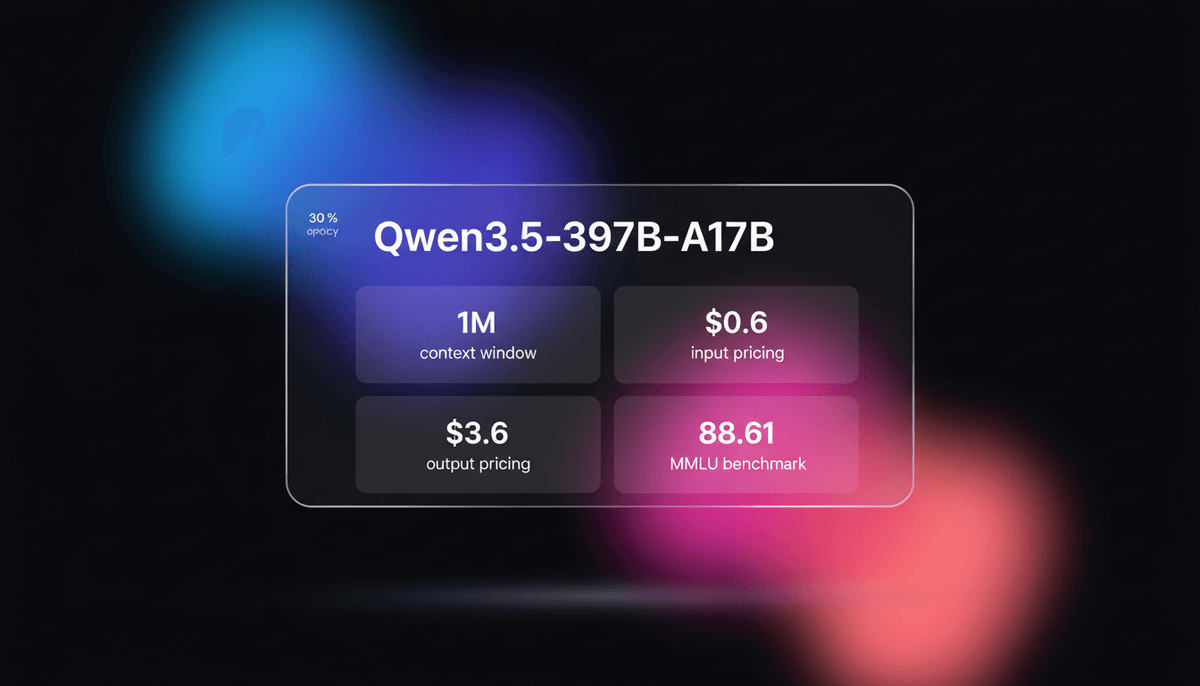

Qwen3.5-397B-A17B er Alibabas flagship open-weight MoE model. Den har nativ multimodal reasoning, et 1M context window og 19x decoding throughput...

Om Qwen3.5-397B-A17B

Lær om Qwen3.5-397B-A17Bs muligheder, funktioner og hvordan den kan hjælpe dig med at opnå bedre resultater.

Et monumentalt spring i åben AI

Qwen3.5-397B-A17B repræsenterer et monumentalt spring i Alibaba Clouds AI-strategi, hvor de skifter fra at være en stærk open-source udfordrer til et dominerende frontier-level system designet til æraen for agentic AI. Udgivet den 16. februar 2026, er den flagship i Qwen3.5-serien og benytter en massiv 397-milliarder-parameter Mixture-of-Experts (MoE) arkitektur. Ved kun at aktivere 17 milliarder parameters per token, opnår den et hidtil uset 19x decoding throughput boost sammenlignet med forgængeren Qwen3-Max, mens den indsnævrer præstationsgabet til verdens mest avancerede lukkede modeller.

Unified Multimodal Powerhouse

Modellen er et samlet, nativt multimodal powerhouse. I modsætning til tidligere versioner, der krævede separate vision-language adaptere, har Qwen3.5 early-fusion multimodalitet trænet på billioner af multimodale tokens. Dette gør det muligt for den at se og udføre reasoning over to timers videoindhold, fungere som en GUI-agent på tværs af desktop- og mobil-interfaces og håndtere komplekse kodningsopgaver i sin specialiserede Thinking mode. Med et udvidet vokabular på 250.000 tokens, der understøtter 201 sprog, står den som det fremmeste globale valg til flersproget og multimodal automatisering.

Arkitekteret til den agentic æra

Udover simpel chat er Qwen3.5-397B optimeret til brug af værktøjer og autonome workflows. Dens høje scores i benchmarks for function-calling og instruktionsfølgelse gør den til en ideel rygrad for visuel softwareudvikling og forskning på ph.d.-niveau. Ved at tilbyde state-of-the-art ydeevne under en Apache 2.0-licens, har Alibaba givet fællesskabet et troværdigt og højeffektivt alternativ til de mest begrænsede closed-source modeller.

Anvendelser for Qwen3.5-397B-A17B

Opdag de forskellige måder, du kan bruge Qwen3.5-397B-A17B til at opnå gode resultater.

Autonome GUI-agenter

Navigerer i komplekse PC- og smartphone-interfaces for at færdiggøre multi-step workflows til kontorautomatisering.

Long-Form Video Intelligence

Uddrager dyb kausal reasoning og resuméer fra kontinuerlige videofiler på op til 120 minutters varighed.

Vibe Coding & Prototyping

Oversætter UI-skitser direkte til produktionsklar React- og frontend-logik i et enkelt forsøg.

Forskning på ph.d.-niveau

Løser STEM-problemer på kandidatniveau ved hjælp af specialiseret intern chain-of-thought Thinking mode.

Multilingual global support

Engagerer brugere på tværs af 201 sprog med overlegen tokenization-effektivitet for ikke-engelske alfabeter.

Visuel softwareudvikling

Transformerer wireframes og screenshots til ren, layout-bevidst HTML, CSS og JavaScript-kode.

Styrker

Begrænsninger

API hurtig start

alibaba/qwen-3.5-plus

import OpenAI from 'openai';

const client = new OpenAI({

apiKey: process.env.DASHSCOPE_API_KEY,

baseURL: 'https://dashscope-intl.aliyuncs.com/compatible-mode/v1',

});

async function main() {

const completion = await client.chat.completions.create({

model: 'qwen-3.5-397b-instruct',

messages: [{ role: 'user', content: 'Analyze this 2-hour video context.' }],

extra_body: { enable_thinking: true },

});

console.log(completion.choices[0].message.content);

}

main();Installér SDK'et og begynd at foretage API-kald på få minutter.

Hvad folk siger om Qwen3.5-397B-A17B

Se hvad fællesskabet mener om Qwen3.5-397B-A17B

“Qwen3.5-397B er dybest set open-source-fællesskabets svar på GPT-4o. SVG-kapaciteten alene er vanvittig til webdesign.”

“De 19x throughput-boost får Qwen3.5 til at føles betydeligt mere responsiv end nogen anden model af denne størrelse, jeg har testet.”

“Apache 2.0 til en model af denne størrelse er en total game changer for lokal AI-udvikling og privatlivsfokuserede virksomheder.”

“MoE-routingen i 3.5-397B-modellen er mærkbart mere intelligent end den forrige 2.5-generation; den følger faktisk logik.”

“De 1M context på en open-weight model af denne kaliber er aldrig set før i det nuværende økosystem.”

“Video-reasoning er ikke bare frame-for-frame; det er faktisk tidslig forståelse, der føles milevidt foran nuværende vision-LLM'er.”

Videoer om Qwen3.5-397B-A17B

Se vejledninger, anmeldelser og diskussioner om Qwen3.5-397B-A17B

“Den slår Claude Opus 4.5 på browser-opgaver samt Gemini 3 Pro i flere multimodale opgaver.”

“Angiveligt 19 gange hurtigere end Qwen 3 Max, som understøtter 201 sprog og dialekter.”

“Den gjorde et fantastisk stykke arbejde med den fotorealistiske sommerfugl... bedre end de fleste open-source modeller.”

“397B-modellen er essentielt den første open-weights model, der for alvor konkurrerer ved grænsen for AGI.”

“Skalering med MoE fungerer tydeligvis for Alibaba, og deres seneste benchmark-resultater beviser det.”

“Denne model matcher hvad deres Qwen Max kunne præstere... men den kan gøre det med et hastighedsboost på op til 19x.”

“Tokenizeren er gået til et vokabular på 250K... hvilket matcher Gemini og Google-tokenizeren.”

“Man skal se Qwen-teamet som et Frontier Lab... de kaster sig over opgaver, som lukkede laboratorier fokuserer på.”

“Tokenization er meget mere effektiv for ikke-latinske skrifttyper sammenlignet med tidligere Llama-iterationer.”

“Thinking mode tilføjer betydelig latency, men gevinsten i nøjagtighed er det værd til kodning og reasoning.”

“Dette er en samlet vision-language model... hvor tidligere modeller havde en specifik VL-variant, har denne alt indeholdt i en enkelt model.”

“Videoforståelse gør det muligt for den at fange tidslige detaljer, som frame-extraction-metoder overser.”

“Når det kommer til kodning, føles den lige så responsiv som GPT-4o-modellen, men med bedre instruktionsfølgelse.”

“GUI-agent-kapacitet til desktop er den mest fremtrædende funktion her til automatisering i den virkelige verden.”

“Den håndterer 120 minutters video uden at miste kontekst, hvilket er massivt til analyse.”

Supercharg din arbejdsgang med AI-automatisering

Automatio kombinerer kraften fra AI-agenter, webautomatisering og smarte integrationer for at hjælpe dig med at udrette mere på kortere tid.

Pro-tips til Qwen3.5-397B-A17B

Eksperttips til at hjælpe dig med at få mest muligt ud af Qwen3.5-397B-A17B og opnå bedre resultater.

Slå Thinking Mode til/fra

Brug enable_thinking-parameteren til logiktunge opgaver for at aktivere dybe interne reasoning-stier.

Udnyt nativ søgning

Aktiver search-parameteren for at verificere fakta mod webdata i realtid og eksekvere Python-kode.

Optimer video-prompts

Angiv specifikke tidsstempel-ankre for at fokusere dit 1M token context window på de mest relevante segmenter.

Valg af regionalt endpoint

Brug dashscope-intl-endpointet for brugere uden for det kinesiske fastland for at reducere netværks-latency.

Anmeldelser

Hvad vores brugere siger

Slut dig til tusindvis af tilfredse brugere, der har transformeret deres arbejdsgang

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Relateret AI Models

GPT-5.1

OpenAI

GPT-5.1 is OpenAI’s advanced reasoning flagship featuring adaptive thinking, native multimodality, and state-of-the-art performance in math and technical...

Kimi K2.5

Moonshot

Discover Moonshot AI's Kimi K2.5, a 1T-parameter open-source agentic model featuring native multimodal capabilities, a 262K context window, and SOTA reasoning.

Grok-4

xAI

Grok-4 by xAI is a frontier model featuring a 2M token context window, real-time X platform integration, and world-record reasoning capabilities.

Claude Opus 4.5

Anthropic

Claude Opus 4.5 is Anthropic's most powerful frontier model, delivering record-breaking 80.9% SWE-bench performance and advanced autonomous agency for coding.

Claude Sonnet 4.6

Anthropic

Claude Sonnet 4.6 offers frontier performance for coding and computer use with a massive 1M token context window for only $3/1M tokens.

Gemini 3 Flash

Gemini 3 Flash is Google's high-speed multimodal model featuring a 1M token context window, elite 90.4% GPQA reasoning, and autonomous browser automation tools.

Claude Opus 4.6

Anthropic

Claude Opus 4.6 is Anthropic's flagship model featuring a 1M token context window, Adaptive Thinking, and world-class coding and reasoning performance.

GLM-4.7

Zhipu (GLM)

GLM-4.7 by Zhipu AI is a flagship 358B MoE model featuring a 200K context window, elite 73.8% SWE-bench performance, and native Deep Thinking for agentic...

Ofte stillede spørgsmål om Qwen3.5-397B-A17B

Find svar på almindelige spørgsmål om Qwen3.5-397B-A17B