Claude Sonnet 4.6

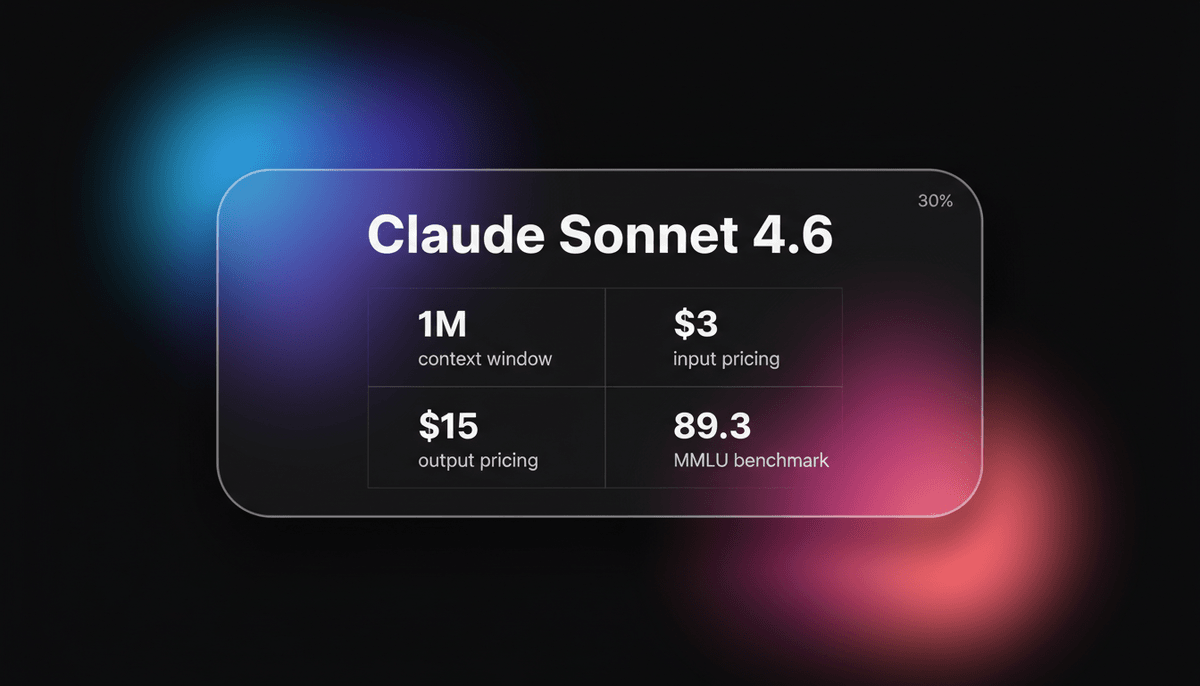

Claude Sonnet 4.6 bietet frontier performance für coding und Computer Use mit einem gewaltigen 1M token context window für nur $3/1M tokens.

Über Claude Sonnet 4.6

Erfahren Sie mehr über die Fähigkeiten, Funktionen und Einsatzmöglichkeiten von Claude Sonnet 4.6.

Ein Generationensprung in der Intelligenz

Claude Sonnet 4.6 ist das bisher leistungsfähigste und vielseitigste model von Anthropic, konzipiert als Hochleistungs-Arbeitstier für komplexe Enterprise- und Entwickler-Workflows. Veröffentlicht am 17. Februar 2026, stellt es einen bedeutenden Generationensprung gegenüber der 4.5-Serie dar und führt Computer Use-Fähigkeiten auf menschlichem Niveau sowie ein massives 1-Million-token context window in der Beta ein. Das model ist für agentic Aufgaben optimiert, was bedeutet, dass es nicht nur Text verarbeitet, sondern autonom mehrstufige Operationen in verschiedenen Softwareumgebungen planen und ausführen kann.

Technische Raffinesse und Multimodalität

Technisch schließt Sonnet 4.6 die Lücke zwischen der Geschwindigkeit von Modellen der Mittelklasse und dem tiefen reasoning der Opus-Klasse. Es verfügt über Adaptive Thinking, was es ihm ermöglicht, den internen Aufwand für das reasoning basierend auf der Komplexität der Aufgabe zu skalieren. Dieses model ist zum neuen Standard für Claude Free- und Pro-Nutzer geworden und bietet flagship-Intelligenz in den Bereichen coding, Finanzanalyse und Dokumentenverständnis. Es ist ein wahrhaft natives multimodal model, das text, image, audio und video inputs unterstützt, um eine Vielzahl von Medienverarbeitungsaufgaben mit state-of-the-art Genauigkeit zu bewältigen.

Der neue Industriestandard für Agenten

Mit seinem exzellenten Preis-Leistungs-Verhältnis ist Sonnet 4.6 als primäre Engine für AI-Agenten positioniert. Es erreicht branchenführende Ergebnisse bei SWE-bench Verified (79,6 %) und OSWorld-Verified (72,5 %), was seine überlegene Fähigkeit unterstreicht, reale Software-Engineering-Probleme und komplexe Betriebssystemaufgaben zu bewältigen. Durch die Bereitstellung von Intelligenz auf Opus-Niveau zu einem Bruchteil der Kosten ermöglicht es Entwicklern den Aufbau autonomer Systeme, die zuvor rechentechnisch oder finanziell untragbar waren.

Anwendungsfälle für Claude Sonnet 4.6

Entdecken Sie die verschiedenen Möglichkeiten, Claude Sonnet 4.6 für großartige Ergebnisse zu nutzen.

Autonome Softwareentwicklung

Verwendung von Claude Code, um ganze Repositories zu refactoren und komplexe Features mit repository-weitem context zu implementieren.

Computer Use auf menschlichem Niveau

Automatisierung von Legacy-Software und Web-Workflows durch visuelle Analyse des Bildschirms und Interaktion über virtuelle Maus und Tastatur.

Verständnis von Finanzdokumenten

Analyse von tausenden Seiten an Einreichungen und Tabellen, um komplexe Investmentstrategien oder Risiken zu bewerten.

Echtzeit-Business-Simulation

Durchführung von agentic Simulationen, bei denen das model ein virtuelles Unternehmen leitet und auf Rentabilität optimiert.

Mehrsprachiges technisches Schreiben

Erstellung technischer Dokumentation in dutzenden Sprachen unter perfekter Einhaltung architektonischer Spezifikationen.

Frontend-UI/UX-Generierung

Erstellung moderner Dashboard-Interfaces mit Fokus auf Typografie, Farblehre und responsivem Layout.

Stärken

Einschränkungen

API-Schnellstart

anthropic/claude-sonnet-4-6

import Anthropic from '@anthropic-ai/sdk';

const anthropic = new Anthropic({

apiKey: process.env.ANTHROPIC_API_KEY,

});

const msg = await anthropic.messages.create({

model: 'claude-sonnet-4-6',

max_tokens: 1024,

messages: [

{ role: 'user', content: 'Analyze this codebase for security vulnerabilities.' }

],

});

console.log(msg.content);Installieren Sie das SDK und beginnen Sie in wenigen Minuten mit API-Aufrufen.

Was die Leute über Claude Sonnet 4.6 sagen

Sehen Sie, was die Community über Claude Sonnet 4.6 denkt

“Claude Sonnet 4.6 erreichte 94 % in unserem Versicherungs-benchmark und ist damit das leistungsstärkste model für Computer Use, das wir getestet haben.”

“Der Hype ist echt, das ist ohne Zweifel das beste (und unterhaltsamste) LLM, das ich je benutzt habe! Meilenweit über allem, was ich bisher gesehen habe.”

“Claude Sonnet 4.6 ist extrem witzig, nicht nur 'gelegentlich lustig'. Insgesamt herzlich, ehrlich und prosozial.”

“Sonnet 4.6 ist beim coding so viel besser als Cline. Ich öffne Dateien nicht einmal mehr manuell.”

“Das 1M context window ist ein Gamechanger für die Migration von codebases. Ich habe einfach meinen gesamten Legacy-Stack hochgeladen.”

“Es verarbeitet komplexe Tabellenkalkulationen und Webformulare mit fast schon unheimlicher Präzision. Die Computer Use Beta ist endlich bereit.”

Videos über Claude Sonnet 4.6

Schauen Sie Tutorials, Rezensionen und Diskussionen über Claude Sonnet 4.6

“Sonnet 4.6 hat eine höhere Punktzahl beim GDP val erreicht, das reale, bedeutungsvolle Aufgaben misst.”

“Es wird immer schwieriger, überhaupt zu wissen, ob diese Modelle zu CBRN-Dingen fähig sind.”

“Das Verhältnis von Geschwindigkeit zu Intelligenz ist hier im Grunde von keinem anderen model auf dem Markt unerreicht.”

“Anthropic konzentriert sich mit diesem Release eindeutig auf die agentic Seite des Hauses.”

“Die Kostenstruktur macht dies zum neuen Standard für jeden API-Entwickler mit hohem Volumen.”

“Dieses model ist etwa doppelt so schnell wie das Opus-model aus dem letzten Monat.”

“Zusammenfassend lässt sich sagen, Leute, dieses model bietet das beste Preis-Leistungs-Verhältnis für Enterprise-coding.”

“Die Vision-Fähigkeiten zur Interpretation komplexer Architekturdiagramme wurden erheblich verbessert.”

“Ich konnte ihm 50 Dateien geben, und es hat die gesamte Routing-Logik perfekt refactored.”

“Es fühlt sich in seinem Kommunikationsstil viel menschlicher an als GPT-4o.”

“In einigen Bereichen schlägt es tatsächlich Opus 4.6, während es gleichzeitig 40 % günstiger ist.”

“Wenn wir das context window füllen, neigt die Effektivität dazu zu sinken, sobald wir etwa 150.000 tokens erreichen.”

“Das Feature für adaptive reasoning ermöglicht es im Grunde, zwischen Geschwindigkeit und tiefer Logik zu wechseln.”

“Dieses Release fühlt sich wie das erste echte 'agent-first' model von Anthropic an.”

“Ich würde es für alles verwenden, außer vielleicht für absolut hochkarätiges kreatives Schreiben.”

Optimieren Sie Ihren Workflow mit KI-Automatisierung

Automatio kombiniert die Kraft von KI-Agenten, Web-Automatisierung und intelligenten Integrationen, um Ihnen zu helfen, mehr in weniger Zeit zu erreichen.

Pro-Tipps für Claude Sonnet 4.6

Expertentipps, um das Beste aus Claude Sonnet 4.6 herauszuholen.

Context Compaction nutzen

Aktivieren Sie die Compaction-Funktion in der API, um den älteren Gesprächsverlauf bei langen Sessions automatisch zusammenzufassen.

Thinking tokens strategisch einsetzen

Legen Sie für Mathematik oder komplexe Logik ein höheres Budget für thinking tokens fest, damit das model verschiedene reasoning-Pfade untersuchen kann.

Auf SPEC-Compliance hin prompten

Bitten Sie das model explizit darum, moderne architektonische Best Practices einzuhalten, da es von Natur aus auf aktualisierte Tools zurückgreift.

Artifacts für UI nutzen

Ermutigen Sie das model, UI-Artifacts zu verwenden, um Code-Generierungen vom Chat-Thread zu trennen und so Echtzeit-Iterationen zu ermöglichen.

Erfahrungsberichte

Was Unsere Nutzer Sagen

Schliessen Sie sich Tausenden zufriedener Nutzer an, die ihren Workflow transformiert haben

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Verwandte AI Models

Gemini 3 Flash

Gemini 3 Flash is Google's high-speed multimodal model featuring a 1M token context window, elite 90.4% GPQA reasoning, and autonomous browser automation tools.

Claude Opus 4.6

Anthropic

Claude Opus 4.6 is Anthropic's flagship model featuring a 1M token context window, Adaptive Thinking, and world-class coding and reasoning performance.

Qwen3.5-397B-A17B

alibaba

Qwen3.5-397B-A17B is Alibaba's flagship open-weight MoE model. It features native multimodal reasoning, a 1M context window, and a 19x decoding throughput...

DeepSeek-V3.2-Speciale

DeepSeek

DeepSeek-V3.2-Speciale is a reasoning-first LLM featuring gold-medal math performance, DeepSeek Sparse Attention, and a 131K context window. Rivaling GPT-5...

GPT-5.1

OpenAI

GPT-5.1 is OpenAI’s advanced reasoning flagship featuring adaptive thinking, native multimodality, and state-of-the-art performance in math and technical...

Gemini 3 Pro

Google's Gemini 3 Pro is a multimodal powerhouse featuring a 1M token context window, native video processing, and industry-leading reasoning performance.

Kimi K2.5

Moonshot

Discover Moonshot AI's Kimi K2.5, a 1T-parameter open-source agentic model featuring native multimodal capabilities, a 262K context window, and SOTA reasoning.

Grok-4

xAI

Grok-4 by xAI is a frontier model featuring a 2M token context window, real-time X platform integration, and world-record reasoning capabilities.

Häufig gestellte Fragen zu Claude Sonnet 4.6

Finden Sie Antworten auf häufige Fragen zu Claude Sonnet 4.6