Comment scraper Open Collective : Guide des données financières et des contributeurs

Découvrez comment scraper Open Collective pour obtenir les transactions financières, les listes de contributeurs et les données de financement de projets....

Protection Anti-Bot Détectée

- Cloudflare

- WAF et gestion de bots de niveau entreprise. Utilise des défis JavaScript, des CAPTCHAs et l'analyse comportementale. Nécessite l'automatisation du navigateur avec des paramètres furtifs.

- Limitation de débit

- Limite les requêtes par IP/session dans le temps. Peut être contourné avec des proxys rotatifs, des délais de requête et du scraping distribué.

- WAF

À Propos de Open Collective

Découvrez ce que Open Collective offre et quelles données précieuses peuvent être extraites.

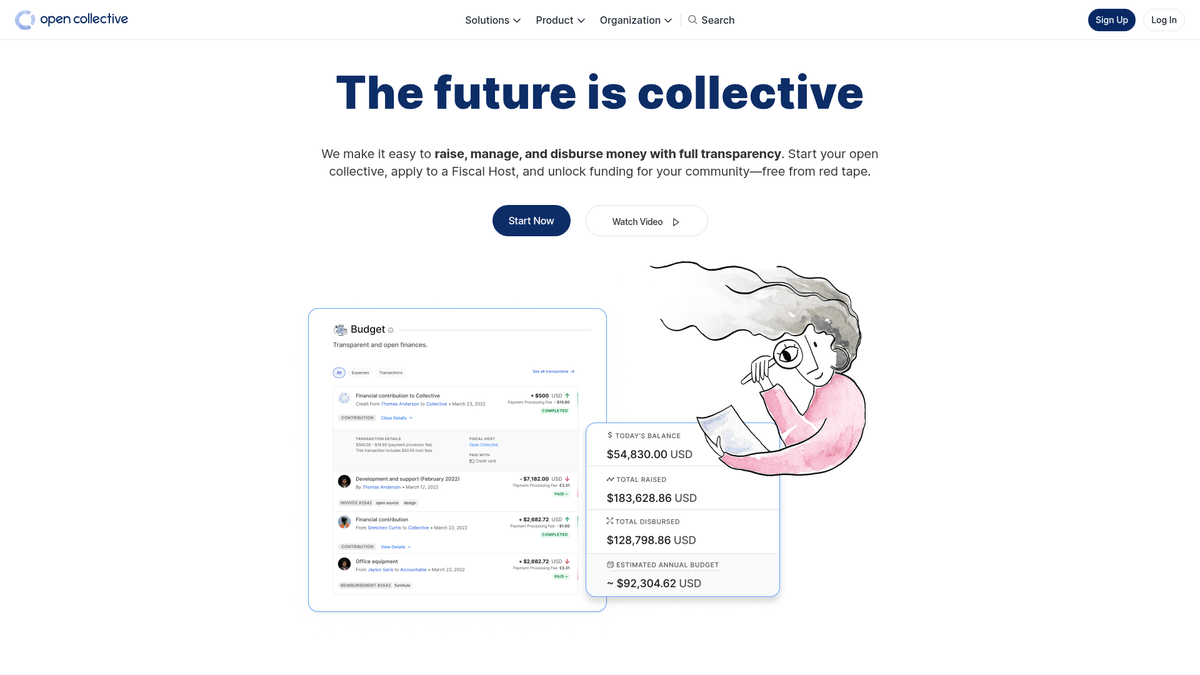

À propos d'Open Collective

Open Collective est une plateforme financière et juridique unique conçue pour assurer la transparence des organisations dirigées par la communauté, des projets de logiciels open-source et des associations de quartier. En agissant comme un outil de financement décentralisé, elle permet aux « collectifs » de lever des fonds et de gérer des dépenses sans avoir besoin d'une entité juridique formelle, en utilisant souvent des hôtes fiscaux pour le soutien administratif. Des projets technologiques majeurs comme Babel et Webpack s'appuient sur cette plateforme pour gérer leurs écosystèmes financés par la communauté.

La plateforme est réputée pour sa transparence radicale. Chaque transaction, qu'il s'agisse d'un don d'une grande entreprise ou d'une petite dépense pour une rencontre communautaire, est enregistrée et visible publiquement. Cela fournit une mine de données concernant la santé financière et les habitudes de dépense de certaines des dépendances open-source les plus critiques au monde.

Scraper Open Collective est extrêmement précieux pour les organisations souhaitant réaliser des études de marché sur l'économie de l'open-source. Cela permet aux utilisateurs d'identifier des pistes de sponsoring d'entreprise, de suivre les tendances de financement des développeurs et d'auditer la viabilité financière de projets logiciels critiques. Les données servent de fenêtre directe sur le flux de capital au sein de la communauté mondiale des développeurs.

Pourquoi Scraper Open Collective?

Découvrez la valeur commerciale et les cas d'utilisation pour l'extraction de données de Open Collective.

Analyser la pérennité de l'open-source

Suivez la santé financière et la viabilité à long terme de projets d'infrastructure technologique critiques tels que Webpack, Babel et Logseq.

Prospection de parrainage d'entreprise

Identifiez les organisations qui parrainent déjà des logiciels open-source pour établir une liste ciblée de prospects potentiels pour vos propres initiatives.

Audits de transparence financière

Surveillez la manière dont les groupes décentralisés et les collectifs communautaires allouent leurs fonds pour garantir la responsabilité envers les donateurs et les parties prenantes.

Découverte des tendances du marché

Évaluez quelles catégories — telles que la technologie, l'activisme environnemental ou l'éducation — connaissent la plus forte croissance en matière de financement communautaire.

Recherche de contributeurs et d'influenceurs

Découvrez les principaux contributeurs individuels et entreprises au sein de niches spécifiques pour trouver des influenceurs clés pour vos campagnes de sensibilisation ou de recrutement.

Suivi de l'impact des subventions

Regroupez les données sur la manière dont les subventions importantes sont décaissées à travers plusieurs projets pour mesurer l'impact réel des dépenses philanthropiques.

Défis du Scraping

Défis techniques que vous pouvez rencontrer lors du scraping de Open Collective.

Rendu lourd en JavaScript

Open Collective est conçu comme une application web moderne qui nécessite l'exécution complète de JavaScript pour afficher les registres financiers et les listes de contributeurs.

Architecture GraphQL complexe

Le site récupère des données via des requêtes GraphQL profondément imbriquées, ce qui rend l'analyse HTML traditionnelle moins efficace que la surveillance des réponses API.

Modèles de chargement dynamique

L'historique des transactions et les listes de membres utilisent souvent le défilement infini ou des boutons 'Charger plus' qui nécessitent une automatisation pilotée par les événements pour une extraction complète.

Cloudflare et limitation de débit

Le scraping à haute fréquence peut déclencher le Web Application Firewall (WAF) de Cloudflare ou entraîner des bannissements temporaires d'IP en raison de limites de débit mondiales strictes.

Structures de données imbriquées

Les informations sur les hôtes fiscaux, les collectifs et les dépenses sont réparties sur différents niveaux de pages, nécessitant une navigation complexe en plusieurs étapes.

Scrapez Open Collective avec l'IA

Aucun code requis. Extrayez des données en minutes avec l'automatisation par IA.

Comment ça marche

Décrivez ce dont vous avez besoin

Dites à l'IA quelles données vous souhaitez extraire de Open Collective. Tapez simplement en langage naturel — pas de code ni de sélecteurs.

L'IA extrait les données

Notre intelligence artificielle navigue sur Open Collective, gère le contenu dynamique et extrait exactement ce que vous avez demandé.

Obtenez vos données

Recevez des données propres et structurées, prêtes à exporter en CSV, JSON ou à envoyer directement à vos applications.

Pourquoi utiliser l'IA pour le scraping

L'IA facilite le scraping de Open Collective sans écrire de code. Notre plateforme alimentée par l'intelligence artificielle comprend quelles données vous voulez — décrivez-les en langage naturel et l'IA les extrait automatiquement.

How to scrape with AI:

- Décrivez ce dont vous avez besoin: Dites à l'IA quelles données vous souhaitez extraire de Open Collective. Tapez simplement en langage naturel — pas de code ni de sélecteurs.

- L'IA extrait les données: Notre intelligence artificielle navigue sur Open Collective, gère le contenu dynamique et extrait exactement ce que vous avez demandé.

- Obtenez vos données: Recevez des données propres et structurées, prêtes à exporter en CSV, JSON ou à envoyer directement à vos applications.

Why use AI for scraping:

- Extraction de données visuelle: Extrayez des dossiers financiers complexes et des tableaux de contributeurs à l'aide d'une interface pointer-cliquer, sans avoir à écrire de logique de requête GraphQL.

- Gestion intelligente de la pagination: Gérez automatiquement le défilement infini ou les boutons 'Charger plus' pour vous assurer que chaque dépense ou don est capturé dans le registre.

- Plannings de surveillance automatisés: Configurez un bot récurrent pour scraper des données toutes les 24 heures, garantissant ainsi que vous disposez toujours du solde et des relevés de transactions les plus récents.

- Contournement des mesures anti-bots: Utilisez la rotation d'IP intégrée et des fonctionnalités d'interaction de type humain pour éviter d'être signalé par Cloudflare lors d'un scraping à grande échelle.

- Exportation directe en JSON/CSV: Transformez instantanément les données web brutes en formats structurés prêts à être analysés dans Google Sheets, Excel ou des bases de données internes.

Scrapers Web No-Code pour Open Collective

Alternatives pointer-cliquer au scraping alimenté par l'IA

Plusieurs outils no-code comme Browse.ai, Octoparse, Axiom et ParseHub peuvent vous aider à scraper Open Collective sans écrire de code. Ces outils utilisent généralement des interfaces visuelles pour sélectionner les données, bien qu'ils puissent avoir des difficultés avec le contenu dynamique complexe ou les mesures anti-bot.

Workflow Typique avec les Outils No-Code

Défis Courants

Courbe d'apprentissage

Comprendre les sélecteurs et la logique d'extraction prend du temps

Les sélecteurs cassent

Les modifications du site web peuvent casser tout le workflow

Problèmes de contenu dynamique

Les sites riches en JavaScript nécessitent des solutions complexes

Limitations des CAPTCHAs

La plupart des outils nécessitent une intervention manuelle pour les CAPTCHAs

Blocage d'IP

Le scraping agressif peut entraîner le blocage de votre IP

Scrapers Web No-Code pour Open Collective

Plusieurs outils no-code comme Browse.ai, Octoparse, Axiom et ParseHub peuvent vous aider à scraper Open Collective sans écrire de code. Ces outils utilisent généralement des interfaces visuelles pour sélectionner les données, bien qu'ils puissent avoir des difficultés avec le contenu dynamique complexe ou les mesures anti-bot.

Workflow Typique avec les Outils No-Code

- Installer l'extension de navigateur ou s'inscrire sur la plateforme

- Naviguer vers le site web cible et ouvrir l'outil

- Sélectionner en point-and-click les éléments de données à extraire

- Configurer les sélecteurs CSS pour chaque champ de données

- Configurer les règles de pagination pour scraper plusieurs pages

- Gérer les CAPTCHAs (nécessite souvent une résolution manuelle)

- Configurer la planification pour les exécutions automatiques

- Exporter les données en CSV, JSON ou se connecter via API

Défis Courants

- Courbe d'apprentissage: Comprendre les sélecteurs et la logique d'extraction prend du temps

- Les sélecteurs cassent: Les modifications du site web peuvent casser tout le workflow

- Problèmes de contenu dynamique: Les sites riches en JavaScript nécessitent des solutions complexes

- Limitations des CAPTCHAs: La plupart des outils nécessitent une intervention manuelle pour les CAPTCHAs

- Blocage d'IP: Le scraping agressif peut entraîner le blocage de votre IP

Exemples de Code

import requests

# Le point de terminaison GraphQL d'Open Collective

url = 'https://api.opencollective.com/graphql/v2'

# Requête GraphQL pour obtenir des infos de base sur un collectif

query = '''

query {

collective(slug: "webpack") {

name

stats {

totalAmountReceived { value }

balance { value }

}

}

}

'''

headers = {'Content-Type': 'application/json'}

try:

# Envoi de la requête POST à l'API

response = requests.post(url, json={'query': query}, headers=headers)

response.raise_for_status()

data = response.json()

# Extraction et affichage du nom et du solde

collective = data['data']['collective']

print(f"Nom : {collective['name']}")

print(f"Solde : {collective['stats']['balance']['value']}")

except Exception as e:

print(f"Une erreur est survenue : {e}")Quand Utiliser

Idéal pour les pages HTML statiques avec peu de JavaScript. Parfait pour les blogs, sites d'actualités et pages e-commerce simples.

Avantages

- ●Exécution la plus rapide (sans surcharge navigateur)

- ●Consommation de ressources minimale

- ●Facile à paralléliser avec asyncio

- ●Excellent pour les APIs et pages statiques

Limitations

- ●Ne peut pas exécuter JavaScript

- ●Échoue sur les SPAs et contenu dynamique

- ●Peut avoir des difficultés avec les systèmes anti-bot complexes

Comment Scraper Open Collective avec du Code

Python + Requests

import requests

# Le point de terminaison GraphQL d'Open Collective

url = 'https://api.opencollective.com/graphql/v2'

# Requête GraphQL pour obtenir des infos de base sur un collectif

query = '''

query {

collective(slug: "webpack") {

name

stats {

totalAmountReceived { value }

balance { value }

}

}

}

'''

headers = {'Content-Type': 'application/json'}

try:

# Envoi de la requête POST à l'API

response = requests.post(url, json={'query': query}, headers=headers)

response.raise_for_status()

data = response.json()

# Extraction et affichage du nom et du solde

collective = data['data']['collective']

print(f"Nom : {collective['name']}")

print(f"Solde : {collective['stats']['balance']['value']}")

except Exception as e:

print(f"Une erreur est survenue : {e}")Python + Playwright

from playwright.sync_api import sync_playwright

def scrape_opencollective():

with sync_playwright() as p:

# Lancement du navigateur avec support JS

browser = p.chromium.launch(headless=True)

page = browser.new_page()

page.goto('https://opencollective.com/discover')

# Attendre que les cartes de collectifs chargent

page.wait_for_selector('.CollectiveCard')

# Extraire les données du DOM

collectives = page.query_selector_all('.CollectiveCard')

for c in collectives:

name = c.query_selector('h2').inner_text()

print(f'Projet trouvé : {name}')

browser.close()

scrape_opencollective()Python + Scrapy

import scrapy

import json

class OpenCollectiveSpider(scrapy.Spider):

name = 'opencollective'

start_urls = ['https://opencollective.com/webpack']

def parse(self, response):

# Open Collective utilise Next.js; les données sont souvent dans une balise script

next_data = response.xpath('//script[@id="__NEXT_DATA__"]/text()').get()

if next_data:

parsed_data = json.loads(next_data)

collective = parsed_data['props']['pageProps']['collective']

yield {

'name': collective.get('name'),

'balance': collective.get('stats', {}).get('balance'),

'currency': collective.get('currency')

}Node.js + Puppeteer

const puppeteer = require('puppeteer');

(async () => {

const browser = await puppeteer.launch();

const page = await browser.newPage();

await page.goto('https://opencollective.com/discover');

// Attendre le chargement du contenu dynamique

await page.waitForSelector('.CollectiveCard');

// Parcourir les éléments pour extraire les noms

const data = await page.evaluate(() => {

return Array.from(document.querySelectorAll('.CollectiveCard')).map(el => ({

name: el.querySelector('h2').innerText

}));

});

console.log(data);

await browser.close();

})();Que Pouvez-Vous Faire Avec Les Données de Open Collective

Explorez les applications pratiques et les insights des données de Open Collective.

Prévision de croissance de l'open-source

Identifiez les technologies émergentes en suivant les taux de croissance financière de catégories spécifiques de collectifs.

Comment implémenter :

- 1Extraire les revenus mensuels des meilleurs projets dans des tags spécifiques

- 2Calculer les taux de croissance annuels composés (CAGR)

- 3Visualiser la santé du financement des projets pour prédire l'adoption technologique

Utilisez Automatio pour extraire des données de Open Collective et créer ces applications sans écrire de code.

Que Pouvez-Vous Faire Avec Les Données de Open Collective

- Prévision de croissance de l'open-source

Identifiez les technologies émergentes en suivant les taux de croissance financière de catégories spécifiques de collectifs.

- Extraire les revenus mensuels des meilleurs projets dans des tags spécifiques

- Calculer les taux de croissance annuels composés (CAGR)

- Visualiser la santé du financement des projets pour prédire l'adoption technologique

- Génération de leads pour SaaS

Identifiez des projets bien financés qui pourraient avoir besoin d'outils de développement, d'hébergement ou de services professionnels.

- Filtrer les collectifs par budget et montant total collecté

- Extraire les descriptions de projets et les URL de sites web externes

- Vérifier la stack technique via les dépôts GitHub liés

- Audit de la philanthropie d'entreprise

Suivez où les grandes entreprises dépensent leurs budgets de contribution open-source.

- Scraper les listes de contributeurs pour les meilleurs projets

- Filtrer les profils d'organisations par rapport aux profils individuels

- Agréger les montants des contributions par entité d'entreprise

- Recherche sur l'impact communautaire

Analysez comment les groupes décentralisés distribuent leurs fonds pour comprendre l'impact social.

- Scraper le grand livre complet des transactions pour un collectif spécifique

- Catégoriser les dépenses (voyages, salaires, matériel)

- Générer des rapports sur l'allocation des ressources au sein des groupes communautaires

- Pipeline de recrutement de développeurs

Trouvez des leaders actifs dans des écosystèmes spécifiques basés sur leur gestion de communauté et leur historique de contribution.

- Scraper les listes de membres de collectifs techniques clés

- Recouper les contributeurs avec leurs profils sociaux publics

- Identifier les mainteneurs actifs pour une approche stratégique de haut niveau

Optimisez votre flux de travail avec l'Automatisation IA

Automatio combine la puissance des agents IA, de l'automatisation web et des integrations intelligentes pour vous aider a accomplir plus en moins de temps.

Conseils Pro pour Scraper Open Collective

Conseils d'experts pour extraire avec succès les données de Open Collective.

Extraire via les slugs d'URL

La méthode la plus simple pour cibler des collectifs spécifiques consiste à utiliser leurs slugs d'URL uniques, qui peuvent être récupérés depuis la page de découverte principale.

Vérifier la présence de __NEXT_DATA__

Le code source de la page contient souvent une balise script avec l'ID __NEXT_DATA__ qui héberge du JSON pré-rendu, ce qui peut être plus rapide que le scraping de l'interface utilisateur.

Utiliser les sélecteurs 'data-cy'

Ciblez les attributs 'data-cy' dans vos sélecteurs, car il s'agit d'identifiants de test qui restent stables même lorsque les classes CSS changent lors des mises à jour du site.

Surveiller les requêtes XHR

Utilisez les outils de développement du navigateur pour trouver les appels directs aux endpoints GraphQL, car ils fournissent la structure de données la plus propre pour les transactions financières.

Implémenter des délais aléatoires

Ajoutez des temps d'attente aléatoires entre 2 et 6 secondes pour imiter une navigation naturelle et rester discret face à la détection automatisée des bots.

Exploiter la documentation officielle

Consultez la documentation de l'API GraphQL d'Open Collective pour comprendre les conventions de nommage des différents champs de données financières.

Témoignages

Ce Que Disent Nos Utilisateurs

Rejoignez des milliers d'utilisateurs satisfaits qui ont transforme leur flux de travail

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Associés Web Scraping

How to Scrape Moon.ly | Step-by-Step NFT Data Extraction Guide

How to Scrape Yahoo Finance: Extract Stock Market Data

How to Scrape Rocket Mortgage: A Comprehensive Guide

How to Scrape jup.ag: Jupiter DEX Web Scraper Guide

How to Scrape Indiegogo: The Ultimate Crowdfunding Data Extraction Guide

How to Scrape ICO Drops: Comprehensive Crypto Data Guide

How to Scrape Crypto.com: Comprehensive Market Data Guide

How to Scrape Coinpaprika: Crypto Market Data Extraction Guide

Questions Fréquentes sur Open Collective

Trouvez des réponses aux questions courantes sur Open Collective