Comment scraper Seeking Alpha : données financières et transcriptions

Découvrez comment scraper Seeking Alpha pour les actualités boursières, les notations d'analystes et les transcriptions de résultats. Apprenez à contourner...

Protection Anti-Bot Détectée

- Cloudflare

- WAF et gestion de bots de niveau entreprise. Utilise des défis JavaScript, des CAPTCHAs et l'analyse comportementale. Nécessite l'automatisation du navigateur avec des paramètres furtifs.

- DataDome

- Détection de bots en temps réel avec des modèles ML. Analyse l'empreinte d'appareil, les signaux réseau et les schémas comportementaux. Courant sur les sites e-commerce.

- Google reCAPTCHA

- Système CAPTCHA de Google. v2 nécessite une interaction utilisateur, v3 fonctionne silencieusement avec un score de risque. Peut être résolu avec des services CAPTCHA.

- Limitation de débit

- Limite les requêtes par IP/session dans le temps. Peut être contourné avec des proxys rotatifs, des délais de requête et du scraping distribué.

- Blocage IP

- Bloque les IP de centres de données connues et les adresses signalées. Nécessite des proxys résidentiels ou mobiles pour contourner efficacement.

À Propos de Seeking Alpha

Découvrez ce que Seeking Alpha offre et quelles données précieuses peuvent être extraites.

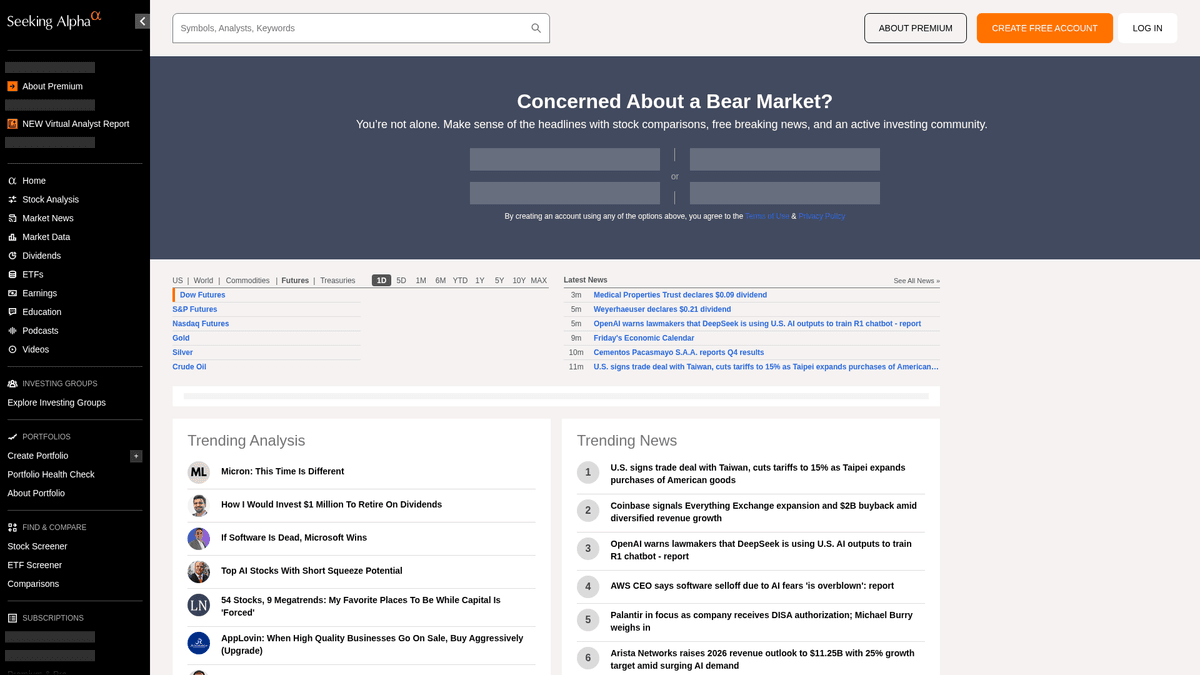

Le pôle majeur pour l'intelligence financière

Seeking Alpha est une plateforme de recherche financière participative de premier plan qui sert de pont essentiel entre les données brutes du marché et les perspectives d'investissement exploitables. Elle héberge une vaste bibliothèque d'articles d'analyse, des actualités du marché en temps réel et le répertoire de transcriptions d'appels de résultats le plus complet du web pour des milliers de sociétés cotées en bourse.

Un écosystème de données diversifié

La plateforme offre une mine de données structurées et non structurées, notamment des idées d'actions, des historiques de dividendes et les notations propriétaires Quant qui sur-performent le marché. Géré par une équipe éditoriale professionnelle, le contenu est généré par des milliers d'analystes indépendants dont les contributions doivent répondre à des normes de qualité et de conformité élevées avant publication.

Valeur stratégique pour l'extraction de données

Le scraping de Seeking Alpha est essentiel pour les analystes financiers et les traders quantitatifs qui effectuent des analyses de sentiment, suivent les tendances historiques des résultats et surveillent les actualités de tickers spécifiques. Les données fournissent des informations granulaires sur la psychologie du marché et la performance des entreprises, utilisables pour construire des modèles financiers sophistiqués et réaliser une veille concurrentielle.

Pourquoi Scraper Seeking Alpha?

Découvrez la valeur commerciale et les cas d'utilisation pour l'extraction de données de Seeking Alpha.

Analyse de sentiment

Extrayez des articles et des commentaires collaboratifs pour effectuer du traitement du langage naturel afin d'évaluer le sentiment du marché sur des tickers boursiers spécifiques.

Intelligence sur les résultats financiers

Collectez les transcriptions des appels de résultats pour identifier les tendances clés des prévisions d'entreprise, les perspectives financières et le sentiment des dirigeants dans divers secteurs.

Notations Quant propriétaires

Surveillez les notations Quant uniques de Seeking Alpha et les scores de conviction des analystes pour alimenter des signaux de trading automatisés ou des outils de gestion de portefeuille.

Veille concurrentielle

Suivez ce que les analystes les mieux notés disent des concurrents de votre secteur pour rester en avance sur les évolutions de l'industrie et les attentes du marché.

Archivage de données historiques

Constituez un référentiel privé de recommandations d'analystes et de réactions des cours de bourse pour évaluer la précision à long terme de rédacteurs financiers spécifiques.

Défis du Scraping

Défis techniques que vous pouvez rencontrer lors du scraping de Seeking Alpha.

Détection de bots avancée

Seeking Alpha utilise une sécurité périmétrique sophistiquée comme Cloudflare et PerimeterX qui surveillent les empreintes de navigateurs automatisés et les schémas comportementaux.

Paywalls de contenu Premium

De nombreux ensembles de données de haute valeur, y compris les mesures quantitatives détaillées et les transcriptions historiques, sont protégés par un abonnement nécessitant une gestion de session sécurisée.

Rendu de contenu dynamique

La plateforme utilise un framework React moderne, ce qui signifie que les données sont souvent chargées de manière asynchrone via des requêtes XHR plutôt que d'être présentes dans la source HTML initiale.

Limitation de débit stricte

Des fréquences de requêtes agressives déclenchent rapidement des erreurs 403 Forbidden et des bannissements temporaires d'IP si le comportement de scrapage ne simule pas un utilisateur humain.

Scrapez Seeking Alpha avec l'IA

Aucun code requis. Extrayez des données en minutes avec l'automatisation par IA.

Comment ça marche

Décrivez ce dont vous avez besoin

Dites à l'IA quelles données vous souhaitez extraire de Seeking Alpha. Tapez simplement en langage naturel — pas de code ni de sélecteurs.

L'IA extrait les données

Notre intelligence artificielle navigue sur Seeking Alpha, gère le contenu dynamique et extrait exactement ce que vous avez demandé.

Obtenez vos données

Recevez des données propres et structurées, prêtes à exporter en CSV, JSON ou à envoyer directement à vos applications.

Pourquoi utiliser l'IA pour le scraping

L'IA facilite le scraping de Seeking Alpha sans écrire de code. Notre plateforme alimentée par l'intelligence artificielle comprend quelles données vous voulez — décrivez-les en langage naturel et l'IA les extrait automatiquement.

How to scrape with AI:

- Décrivez ce dont vous avez besoin: Dites à l'IA quelles données vous souhaitez extraire de Seeking Alpha. Tapez simplement en langage naturel — pas de code ni de sélecteurs.

- L'IA extrait les données: Notre intelligence artificielle navigue sur Seeking Alpha, gère le contenu dynamique et extrait exactement ce que vous avez demandé.

- Obtenez vos données: Recevez des données propres et structurées, prêtes à exporter en CSV, JSON ou à envoyer directement à vos applications.

Why use AI for scraping:

- Masquage furtif de l'empreinte numérique: Automatio effectue automatiquement la rotation des empreintes de navigateur et des en-têtes pour contourner les systèmes de détection comme Cloudflare sans nécessiter de configuration manuelle.

- Support du rendu dynamique: L'architecture de navigateur headless de l'outil garantit que tous les composants basés sur React et les graphiques financiers sont entièrement rendus avant le début de l'extraction des données.

- Gestion de session sans code: Gérez facilement les connexions et les cookies persistants pour accéder aux transcriptions premium et aux notations des analystes sans écrire de scripts d'authentification complexes.

- Sélection visuelle des données: Sélectionnez visuellement les données des tableaux financiers complexes, garantissant une extraction stable même lorsque les classes CSS ou les mises en page changent.

Scrapers Web No-Code pour Seeking Alpha

Alternatives pointer-cliquer au scraping alimenté par l'IA

Plusieurs outils no-code comme Browse.ai, Octoparse, Axiom et ParseHub peuvent vous aider à scraper Seeking Alpha sans écrire de code. Ces outils utilisent généralement des interfaces visuelles pour sélectionner les données, bien qu'ils puissent avoir des difficultés avec le contenu dynamique complexe ou les mesures anti-bot.

Workflow Typique avec les Outils No-Code

Défis Courants

Courbe d'apprentissage

Comprendre les sélecteurs et la logique d'extraction prend du temps

Les sélecteurs cassent

Les modifications du site web peuvent casser tout le workflow

Problèmes de contenu dynamique

Les sites riches en JavaScript nécessitent des solutions complexes

Limitations des CAPTCHAs

La plupart des outils nécessitent une intervention manuelle pour les CAPTCHAs

Blocage d'IP

Le scraping agressif peut entraîner le blocage de votre IP

Scrapers Web No-Code pour Seeking Alpha

Plusieurs outils no-code comme Browse.ai, Octoparse, Axiom et ParseHub peuvent vous aider à scraper Seeking Alpha sans écrire de code. Ces outils utilisent généralement des interfaces visuelles pour sélectionner les données, bien qu'ils puissent avoir des difficultés avec le contenu dynamique complexe ou les mesures anti-bot.

Workflow Typique avec les Outils No-Code

- Installer l'extension de navigateur ou s'inscrire sur la plateforme

- Naviguer vers le site web cible et ouvrir l'outil

- Sélectionner en point-and-click les éléments de données à extraire

- Configurer les sélecteurs CSS pour chaque champ de données

- Configurer les règles de pagination pour scraper plusieurs pages

- Gérer les CAPTCHAs (nécessite souvent une résolution manuelle)

- Configurer la planification pour les exécutions automatiques

- Exporter les données en CSV, JSON ou se connecter via API

Défis Courants

- Courbe d'apprentissage: Comprendre les sélecteurs et la logique d'extraction prend du temps

- Les sélecteurs cassent: Les modifications du site web peuvent casser tout le workflow

- Problèmes de contenu dynamique: Les sites riches en JavaScript nécessitent des solutions complexes

- Limitations des CAPTCHAs: La plupart des outils nécessitent une intervention manuelle pour les CAPTCHAs

- Blocage d'IP: Le scraping agressif peut entraîner le blocage de votre IP

Exemples de Code

import requests

from bs4 import BeautifulSoup

# URL pour les dernières actualités du marché

url = 'https://seekingalpha.com/market-news'

# Headers standards de navigateur pour imiter un comportement humain

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/120.0.0.0 Safari/537.36',

'Accept-Language': 'fr-FR,fr;q=0.9,en-US;q=0.8,en;q=0.7',

'Referer': 'https://seekingalpha.com/'

}

def scrape_sa_news():

try:

response = requests.get(url, headers=headers, timeout=10)

if response.status_code == 200:

soup = BeautifulSoup(response.text, 'html.parser')

# Extraction des titres en utilisant les attributs data-test-id

headlines = soup.find_all('a', {'data-test-id': 'post-list-item-title'})

for item in headlines:

print(f'Titre News : {item.text.strip()}')

else:

print(f'Bloqué avec le statut : {response.status_code}')

except Exception as e:

print(f'Une erreur est survenue : {e}')

if __name__ == "__main__":

scrape_sa_news()Quand Utiliser

Idéal pour les pages HTML statiques avec peu de JavaScript. Parfait pour les blogs, sites d'actualités et pages e-commerce simples.

Avantages

- ●Exécution la plus rapide (sans surcharge navigateur)

- ●Consommation de ressources minimale

- ●Facile à paralléliser avec asyncio

- ●Excellent pour les APIs et pages statiques

Limitations

- ●Ne peut pas exécuter JavaScript

- ●Échoue sur les SPAs et contenu dynamique

- ●Peut avoir des difficultés avec les systèmes anti-bot complexes

Comment Scraper Seeking Alpha avec du Code

Python + Requests

import requests

from bs4 import BeautifulSoup

# URL pour les dernières actualités du marché

url = 'https://seekingalpha.com/market-news'

# Headers standards de navigateur pour imiter un comportement humain

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/120.0.0.0 Safari/537.36',

'Accept-Language': 'fr-FR,fr;q=0.9,en-US;q=0.8,en;q=0.7',

'Referer': 'https://seekingalpha.com/'

}

def scrape_sa_news():

try:

response = requests.get(url, headers=headers, timeout=10)

if response.status_code == 200:

soup = BeautifulSoup(response.text, 'html.parser')

# Extraction des titres en utilisant les attributs data-test-id

headlines = soup.find_all('a', {'data-test-id': 'post-list-item-title'})

for item in headlines:

print(f'Titre News : {item.text.strip()}')

else:

print(f'Bloqué avec le statut : {response.status_code}')

except Exception as e:

print(f'Une erreur est survenue : {e}')

if __name__ == "__main__":

scrape_sa_news()Python + Playwright

from playwright.sync_api import sync_playwright

def run(playwright):

# Lancement d'un navigateur Chromium

browser = playwright.chromium.launch(headless=True)

context = browser.new_context(

user_agent='Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/120.0.0.0 Safari/537.36'

)

page = context.new_page()

try:

# Navigation vers une page de symbole boursier spécifique

page.goto('https://seekingalpha.com/symbol/AAPL/transcripts')

# Attente du rendu dynamique du contenu principal

page.wait_for_selector('article', timeout=15000)

# Localisation et extraction des titres de transcriptions

titles = page.locator('h3').all_inner_texts()

for title in titles:

print(f'Transcription trouvée : {title}')

except Exception as e:

print(f'L\'extraction a échoué : {e}')

finally:

browser.close()

with sync_playwright() as playwright:

run(playwright)Python + Scrapy

import scrapy

class SeekingAlphaSpider(scrapy.Spider):

name = 'sa_spider'

allowed_domains = ['seekingalpha.com']

start_urls = ['https://seekingalpha.com/latest-articles']

custom_settings = {

'DOWNLOAD_DELAY': 8,

'USER_AGENT': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) Chrome/120.0.0.0',

'ROBOTSTXT_OBEY': False,

'COOKIES_ENABLED': True

}

def parse(self, response):

for article in response.css('article'):

yield {

'title': article.css('h3 a::text').get(),

'link': response.urljoin(article.css('h3 a::attr(href)').get()),

'author': article.css('span[data-test-id="author-name"]::text').get()

}

# Gestion d'une pagination simple via les liens 'suivant'

next_page = response.css('a.next_page::attr(href)').get()

if next_page:

yield response.follow(next_page, self.parse)Node.js + Puppeteer

const puppeteer = require('puppeteer');

(async () => {

const browser = await puppeteer.launch({ headless: true });

const page = await browser.newPage();

// Configuration d'un User-Agent de haute qualité

await page.setUserAgent('Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/120.0.0.0 Safari/537.36');

try {

// Navigation vers la page d'accueil de Seeking Alpha

await page.goto('https://seekingalpha.com/', { waitUntil: 'networkidle2' });

// Évaluation des scripts dans le contexte du navigateur pour extraire les titres

const trending = await page.evaluate(() => {

const nodes = Array.from(document.querySelectorAll('h3'));

return nodes.map(n => n.innerText.trim());

});

console.log('Contenu Tendance:', trending);

} catch (err) {

console.error('Puppeteer a rencontré une erreur:', err);

} finally {

await browser.close();

}

})();Que Pouvez-Vous Faire Avec Les Données de Seeking Alpha

Explorez les applications pratiques et les insights des données de Seeking Alpha.

Analyse de sentiment quantitative

Les sociétés financières utilisent les articles d'analystes pour déterminer le sentiment du marché pour des secteurs boursiers spécifiques.

Comment implémenter :

- 1Extraire tous les articles d'analyse pour un ticker industriel spécifique.

- 2Traiter le contenu via un moteur NLP pour calculer la polarité du sentiment.

- 3Intégrer les scores de sentiment dans les algorithmes de trading existants.

- 4Déclencher des alertes automatisées d'achat/vente basées sur les changements de sentiment.

Utilisez Automatio pour extraire des données de Seeking Alpha et créer ces applications sans écrire de code.

Que Pouvez-Vous Faire Avec Les Données de Seeking Alpha

- Analyse de sentiment quantitative

Les sociétés financières utilisent les articles d'analystes pour déterminer le sentiment du marché pour des secteurs boursiers spécifiques.

- Extraire tous les articles d'analyse pour un ticker industriel spécifique.

- Traiter le contenu via un moteur NLP pour calculer la polarité du sentiment.

- Intégrer les scores de sentiment dans les algorithmes de trading existants.

- Déclencher des alertes automatisées d'achat/vente basées sur les changements de sentiment.

- Extraction d'insights sur les résultats

Extrayez les prévisions critiques des entreprises directement des transcriptions de résultats pour un reporting rapide.

- Automatiser un scraping quotidien de la section Transcriptions de résultats (Earnings Transcripts).

- Rechercher des mots-clés financiers spécifiques comme 'EBITDA' ou 'Perspectives'.

- Isoler les phrases contenant des mesures de guidage de la direction.

- Exporter les résultats vers un CSV structuré pour examen par le comité d'investissement.

- Analyse comparative du rendement des dividendes

Comparez la performance des dividendes sur des milliers d'actions pour identifier des opportunités de rendement.

- Scraper l'historique des dividendes et les ratios de distribution pour une liste d'actions définie.

- Calculer le rendement moyen par rapport aux tendances historiques en utilisant les données scrapées.

- Identifier les actions ayant récemment augmenté leur distribution.

- Mettre à jour un tableau de bord privé avec des comparaisons de rendement en temps réel.

- Suivi de la performance des analystes

Identifiez les auteurs les plus précis à suivre pour obtenir de meilleures idées d'investissement.

- Scraper les notations historiques et les articles des auteurs les mieux notés.

- Recouper les dates de publication des articles avec la performance du cours de l'action.

- Classer les auteurs en fonction de la précision de leurs recommandations 'Achat' ou 'Vente'.

- Envoyer des notifications automatisées lorsque les auteurs les mieux classés publient de nouvelles idées.

Optimisez votre flux de travail avec l'Automatisation IA

Automatio combine la puissance des agents IA, de l'automatisation web et des integrations intelligentes pour vous aider a accomplir plus en moins de temps.

Conseils Pro pour Scraper Seeking Alpha

Conseils d'experts pour extraire avec succès les données de Seeking Alpha.

Prioriser les proxies résidentiels

Seeking Alpha place sur liste noire la plupart des IP de datacenter ; l'utilisation de proxies résidentiels permet à votre trafic d'apparaître comme celui d'utilisateurs internet légitimes.

Cibler les points de terminaison d'API internes

Inspectez le trafic réseau pour trouver des appels d'API internes basés sur JSON (v3/api), qui sont souvent plus faciles à analyser que les structures HTML brutes.

Implémenter des délais d'apparence humaine

Aléatoirisez le timing de vos interactions et maintenez un volume de requêtes faible pour éviter de déclencher les systèmes de détection comportementale qui recherchent des schémas robotiques.

Utiliser les attributs de données pour les sélecteurs

Ciblez les attributs 'data-test-id' dans vos sélecteurs, car ils sont moins susceptibles de changer lors des mises à jour du site par rapport aux classes CSS dynamiques de React.

Scraper pendant les heures creuses

Effectuez la collecte de données à grande échelle pendant la fermeture des marchés ou les week-ends pour réduire le risque de déclencher des limitations de débit liées au trafic élevé.

Témoignages

Ce Que Disent Nos Utilisateurs

Rejoignez des milliers d'utilisateurs satisfaits qui ont transforme leur flux de travail

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Associés Web Scraping

How to Scrape Yahoo Finance: Extract Stock Market Data

How to Scrape Moon.ly | Step-by-Step NFT Data Extraction Guide

How to Scrape Rocket Mortgage: A Comprehensive Guide

How to Scrape Open Collective: Financial and Contributor Data Guide

How to Scrape jup.ag: Jupiter DEX Web Scraper Guide

How to Scrape Indiegogo: The Ultimate Crowdfunding Data Extraction Guide

How to Scrape ICO Drops: Comprehensive Crypto Data Guide

How to Scrape Crypto.com: Comprehensive Market Data Guide

Questions Fréquentes sur Seeking Alpha

Trouvez des réponses aux questions courantes sur Seeking Alpha