MiniMax M2.5

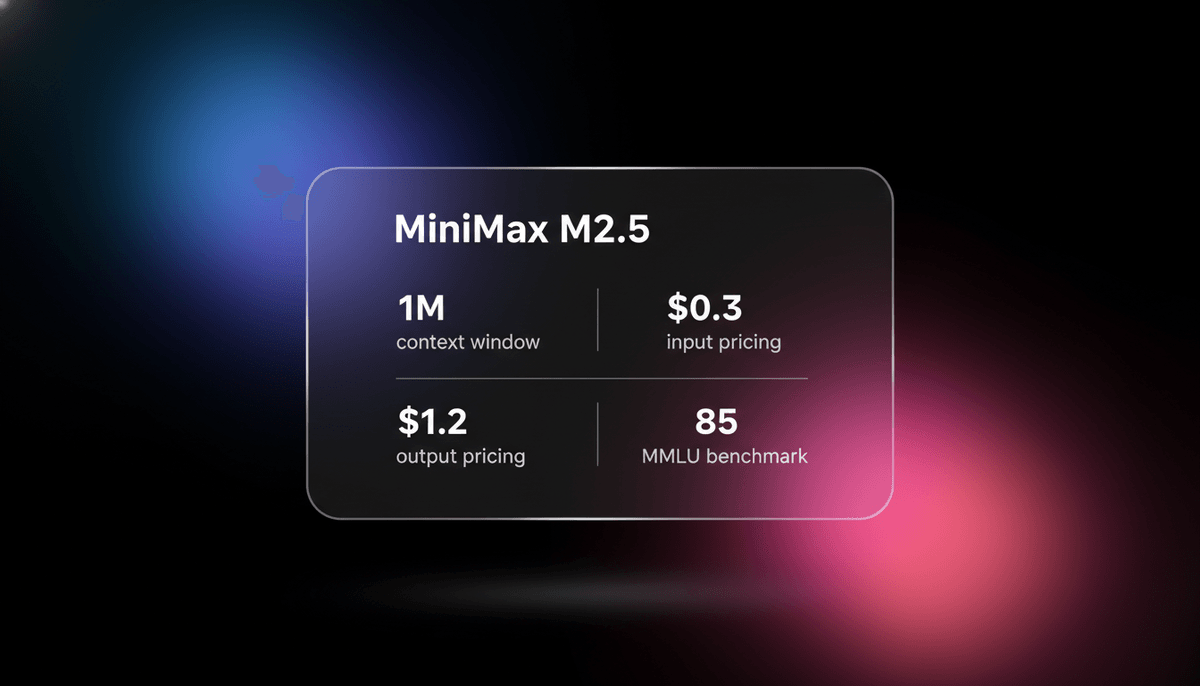

MiniMax M2.5 est un model MoE SOTA doté d'une context window de 1M et de capacités de coding agentic d'élite à un prix disruptif pour les agents autonomes.

À propos de MiniMax M2.5

Découvrez les capacités, fonctionnalités et façons d'utiliser MiniMax M2.5.

Intelligence Frontier haute efficacité

MiniMax M2.5 représente une avancée majeure dans l'efficacité de l'IA de classe frontier model. En tant que model Mixture-of-Experts (MoE), il utilise une architecture sparse avec 230 milliards de parameters au total, mais n'active que 10 milliards de parameters par token. Cette conception lui permet d'offrir des performances compétitives par rapport aux modèles flagship mondiaux tout en restant nettement plus rapide et moins coûteux à exploiter. Sorti début 2026, il est spécifiquement optimisé pour les charges de travail « agentic » où l'IA doit planifier, exécuter et s'auto-corriger sur des tâches multi-étapes.

Reasoning architectural et coding

L'une des caractéristiques les plus distinctives de M2.5 est sa pensée architecturale émergente. Contrairement aux LLM standards qui génèrent du code de manière linéaire, M2.5 est entraîné pour cartographier les hiérarchies de projets et les structures logiques avant d'écrire les fichiers. Cette capacité, combinée à une context window d'un million de tokens, en fait un choix de premier ordre pour l'ingénierie logicielle autonome, les revues de code à grande échelle et la gestion de dépôts complexes. Il supporte plus de 10 langages de programmation et affiche un throughput natif allant jusqu'à 100 tokens par seconde.

Cas d'utilisation de MiniMax M2.5

Découvrez les différentes façons d'utiliser MiniMax M2.5 pour obtenir d'excellents résultats.

Ingénierie logicielle agentic

Génération et tests autonomes de projets multi-fichiers dans des environnements sandbox en utilisant le mode Architecte.

Bureautique de haute précision

Exécution de tâches complexes sur Word, PowerPoint et Excel, incluant la modélisation financière professionnelle.

Recherche Web autonome

Navigation sur des pages Web denses en informations pour effectuer une recherche et une synthèse d'informations de niveau expert.

Support technique bilingue

Maîtrise de niveau natif en chinois et en anglais pour le débogage complexe et la planification architecturale.

Prototypage de simulation 3D

Génération d'environnements 3D fonctionnels et de composants interactifs comme Three.js en un seul essai.

Revue de code en entreprise

Réalisation de revues de code complètes et de tests système sur plus de 10 langages de programmation avec une supervision architecturale.

Points forts

Limitations

Démarrage rapide API

minimax/minimax-m2.5

import OpenAI from "openai";

const client = new OpenAI({

apiKey: process.env.MINIMAX_API_KEY,

baseURL: "https://api.minimax.chat/v1",

});

async function main() {

const response = await client.chat.completions.create({

model: "minimax-m2.5",

messages: [{ role: "user", content: "Plan like an architect and code a 3D Formula 1 car drifting." }],

});

console.log(response.choices[0].message.content);

}

main();Installez le SDK et commencez à faire des appels API en quelques minutes.

Ce que les gens disent de MiniMax M2.5

Voyez ce que la communauté pense de MiniMax M2.5

“MiniMax M2.5 est un model de coding et agentic de premier plan, bien plus rapide et considérablement moins cher.”

“La vitesse de M2.5 s'accumule rapidement dans les boucles d'agents. Il est conçu pour des charges de travail de production permanentes.”

“On dirait plus un assistant infatigable qu'un bot lent. La vitesse change vraiment la donne pour ma configuration.”

“Cela ressemble à une véritable révolution... le coût est un dixième de celui des modèles flagship propriétaires.”

“Il atteint 80,2 % sur SWE Bench Verified. C'est un changement d'ordre de grandeur pour l'économie des agents.”

“Le mode de planification architecturale rend enfin les agents de coding autonomes assez fiables pour les équipes de développement.”

Vidéos sur MiniMax M2.5

Regardez des tutoriels, critiques et discussions sur MiniMax M2.5

“Il rend enfin l'idée d'une intelligence trop peu coûteuse pour être mesurée véritablement réaliste.”

“La qualité est bel et bien là... remarquablement fonctionnel même pour des animations frontend complexes.”

“Ce model dévore littéralement les benchmark de coding en ce moment.”

“Sa capacité à s'auto-corriger pendant la boucle agentic est ce qui le distingue de M2.1.”

“Je n'ai vu ce niveau de rapport performance-prix dans aucune autre sortie cette année.”

“Une amélioration significative par rapport aux générations précédentes est la capacité de M2.5 à penser et planifier comme un architecte.”

“Cet outil va s'imposer comme un instrument de coding agentic très, très puissant.”

“Remarquez comment il décompose la structure des dossiers avant d'écrire les composants React réels.”

“Les capacités de reasoning ici sont bien supérieures à son poids en parameters actifs.”

“Si vous construisez des agents de développement autonomes, vous devez tester ce model immédiatement.”

“Si vous voulez l'utiliser pour votre propre workflow, vous obtiendrez probablement de très bons résultats pour le coding.”

“Ils ne sont certainement pas à la traîne... ils se rapprochent en termes de performance globale.”

“Le support vision multimodal gère mieux les wireframes d'interface utilisateur complexes que certains modèles propriétaires.”

“Nous voyons une tendance où la vitesse devient aussi importante que l'intelligence brute pour les agents.”

“M2.5 représente la maturation de l'écosystème MiniMax pour les développeurs mondiaux.”

Optimisez votre flux de travail avec l'Automatisation IA

Automatio combine la puissance des agents IA, de l'automatisation web et des integrations intelligentes pour vous aider a accomplir plus en moins de temps.

Conseils Pro pour MiniMax M2.5

Conseils d'experts pour tirer le meilleur parti de MiniMax M2.5.

Exploitez le mode Architecte

Incitez explicitement le model à « planifier comme un architecte » pour déclencher son reasoning approfondi et sa décomposition de structure de fichiers.

Utilisez le feedback itératif

Pour les animations 3D ou SVG complexes, fournissez un feedback sur les erreurs fonctionnelles pour tirer parti de l'auto-correction agentic du model.

Gérez le prompt caching

Profitez de la context window de 1M en mettant en cache de grands ensembles de documentation pour réduire les coûts jusqu'à 90 %.

Basculez sur la version Lightning

Utilisez la version Lightning pour le coding d'interfaces utilisateur interactives en temps réel afin d'atteindre des vitesses de 100 tokens par seconde.

Témoignages

Ce Que Disent Nos Utilisateurs

Rejoignez des milliers d'utilisateurs satisfaits qui ont transforme leur flux de travail

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Associés AI Models

GLM-5

Zhipu (GLM)

GLM-5 is Zhipu AI's 744B parameter open-weight powerhouse, excelling in long-horizon agentic tasks, coding, and factual accuracy with a 200k context window.

Qwen3-Coder-Next

alibaba

Qwen3-Coder-Next is Alibaba Cloud's elite Apache 2.0 coding model, featuring an 80B MoE architecture and 256k context window for advanced local development.

GPT-5.4

OpenAI

GPT-5.4 is OpenAI's frontier model featuring a 1.05M context window and Extreme Reasoning. It excels at autonomous UI interaction and long-form data analysis.

Gemini 3.1 Flash-Lite

Gemini 3.1 Flash-Lite is Google's fastest, most cost-efficient model. Features 1M context, native multimodality, and 363 tokens/sec speed for scale.

GPT-5.3 Instant

OpenAI

Explore GPT-5.3 Instant, OpenAI's "Anti-Cringe" model. Features a 128K context window, 26.8% fewer hallucinations, and a natural, helpful tone for everyday...

Gemini 3.1 Pro

Gemini 3.1 Pro is Google's elite multimodal model featuring the DeepThink reasoning engine, a 1M+ context window, and industry-leading ARC-AGI logic scores.

Claude Sonnet 4.6

Anthropic

Claude Sonnet 4.6 offers frontier performance for coding and computer use with a massive 1M token context window for only $3/1M tokens.

Qwen3.5-397B-A17B

alibaba

Qwen3.5-397B-A17B is Alibaba's flagship open-weight MoE model. It features native multimodal reasoning, a 1M context window, and a 19x decoding throughput...

Questions Fréquentes sur MiniMax M2.5

Trouvez des réponses aux questions courantes sur MiniMax M2.5