Qwen3.5-397B-A17B

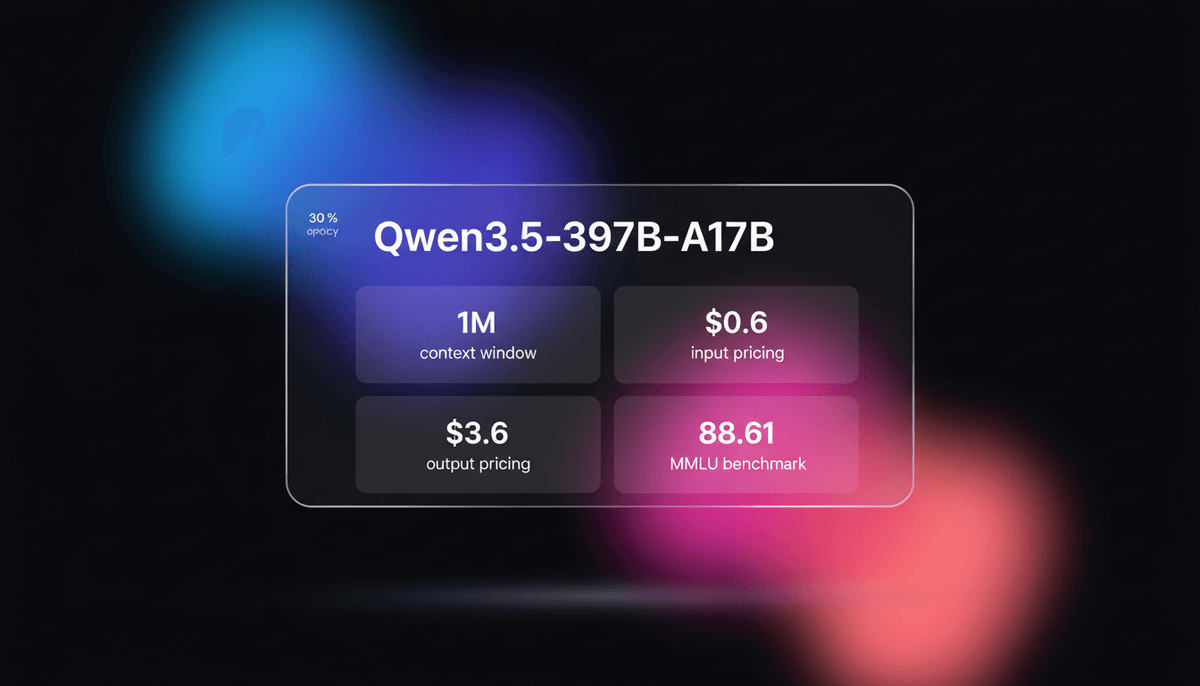

Qwen3.5-397B-A17B est le flagship des models MoE open-weight d'Alibaba. Il dispose d'un reasoning multimodal natif, d'une context window de 1M et d'un...

À propos de Qwen3.5-397B-A17B

Découvrez les capacités, fonctionnalités et façons d'utiliser Qwen3.5-397B-A17B.

Un bond monumental pour l'IA ouverte

Qwen3.5-397B-A17B représente une avancée monumentale dans la stratégie IA d'Alibaba Cloud, passant d'un solide concurrent open-source à un système dominant de niveau frontier model conçu pour l'ère de l'agentic AI. Lancé le 16 février 2026, il est le flagship de la série Qwen3.5, utilisant une architecture massive de 397 milliards de parameters Mixture-of-Experts (MoE). En n'activant que 17 milliards de parameters par token, il atteint un boost de 19x du decoding throughput par rapport à son prédécesseur, Qwen3-Max, tout en réduisant l'écart de performance avec les models propriétaires les plus avancés au monde.

Un moteur multimodal unifié

Le model est un moteur multimodal natif et unifié. Contrairement aux versions précédentes qui nécessitaient des adaptateurs vision-langage séparés, Qwen3.5 intègre une multimodality par fusion précoce entraînée sur des milliers de milliards de tokens multimodaux. Cela lui permet de visionner et de raisonner sur plus de deux heures de contenu vidéo, de fonctionner comme un agent GUI sur des interfaces bureau et mobiles, et de gérer des tâches de code complexes dans son Thinking mode spécialisé. Avec un vocabulaire étendu de 250 000 tokens supportant 201 langues, il s'impose comme le choix mondial de premier plan pour l'automatisation multilingue et multimodal.

Conçu pour l'ère des agents

Au-delà du simple chat, Qwen3.5-397B est optimisé pour l'utilisation d'outils et les flux de travail autonomes. Ses scores élevés dans les benchmarks de function-calling et de respect des instructions en font une base idéale pour l'ingénierie logicielle visuelle et la recherche de niveau doctorat. En offrant des performances state-of-the-art sous une licence Apache 2.0, Alibaba a fourni à la communauté une alternative crédible et hautement efficace aux models closed-source les plus restreints.

Cas d'utilisation de Qwen3.5-397B-A17B

Découvrez les différentes façons d'utiliser Qwen3.5-397B-A17B pour obtenir d'excellents résultats.

Agents GUI autonomes

Navigue dans des interfaces complexes sur PC et smartphone pour accomplir des flux de travail d'automatisation de bureau en plusieurs étapes.

Intelligence vidéo longue durée

Extrait des résumés et un reasoning causal approfondi à partir de fichiers vidéo continus pouvant durer jusqu'à 120 minutes.

Vibe Coding et prototypage

Traduit des croquis d'interface utilisateur directement en code React et logique frontend prête pour la production en un seul prompt.

Recherche de niveau doctorat

Résout des problèmes STEM de niveau universitaire en utilisant le mode Thinking spécialisé avec chain-of-thought interne.

Support mondial multilingue

Interagit avec les utilisateurs dans 201 langues avec une efficacité de tokenization supérieure pour les alphabets non latins.

Ingénierie logicielle visuelle

Transforme des wireframes et des captures d'écran en code HTML, CSS et JavaScript propre et respectueux de la mise en page.

Points forts

Limitations

Démarrage rapide API

alibaba/qwen-3.5-plus

import OpenAI from 'openai';

const client = new OpenAI({

apiKey: process.env.DASHSCOPE_API_KEY,

baseURL: 'https://dashscope-intl.aliyuncs.com/compatible-mode/v1',

});

async function main() {

const completion = await client.chat.completions.create({

model: 'qwen-3.5-397b-instruct',

messages: [{ role: 'user', content: 'Analyze this 2-hour video context.' }],

extra_body: { enable_thinking: true },

});

console.log(completion.choices[0].message.content);

}

main();Installez le SDK et commencez à faire des appels API en quelques minutes.

Ce que les gens disent de Qwen3.5-397B-A17B

Voyez ce que la communauté pense de Qwen3.5-397B-A17B

“Qwen3.5-397B est fondamentalement la réponse de la communauté open-source à GPT-4o. La capacité SVG à elle seule est incroyable pour le web design.”

“Le boost de 19x du throughput rend Qwen3.5 nettement plus réactif que n'importe quel autre model de cette taille que j'ai testé.”

“L'Apache 2.0 pour un model de cette envergure change totalement la donne pour le développement IA local et les entreprises soucieuses de la confidentialité.”

“Le routage MoE dans le model 3.5-397B est notablement plus intelligent que la génération 2.5 précédente ; il suit réellement une logique.”

“La context window de 1M sur un model open-weight de ce calibre est sans précédent dans l'écosystème actuel.”

“Le reasoning vidéo n'est pas seulement du image par image ; c'est une véritable compréhension temporelle qui semble être à des années-lumière des LLM de vision actuels.”

Vidéos sur Qwen3.5-397B-A17B

Regardez des tutoriels, critiques et discussions sur Qwen3.5-397B-A17B

“Il bat Claude Opus 4.5 sur la navigation web ainsi que Gemini 3 Pro dans plusieurs tâches multimodal.”

“Annoncé comme étant 19 fois plus rapide que le Qwen 3 Max, il supporte 201 langues et dialectes.”

“Il a fait un excellent travail avec le papillon photoréaliste... mieux que la plupart des models open-source.”

“Le model 397B est essentiellement le premier model open-weights à véritablement rivaliser au niveau de la frontière de l'AGI.”

“Le scaling avec MoE fonctionne clairement pour Alibaba et leurs derniers résultats de benchmark le prouvent.”

“Ce model égale ce que leur Qwen Max était capable de faire... mais avec un boost de vitesse allant jusqu'à 19x.”

“Le tokenizer est passé à un vocabulaire de 250K... s'alignant sur Gemini et le tokenizer de Google.”

“Il faut voir l'équipe Qwen comme un Frontier Lab... ils s'attaquent à des tâches sur lesquelles les labos propriétaires se concentrent.”

“La tokenization est beaucoup plus efficace pour les scripts non latins par rapport aux précédentes itérations de Llama.”

“Le Thinking mode ajoute une latency significative mais le gain de précision en vaut la peine pour le code et le reasoning.”

“C'est un model vision-langage unifié... là où les models précédents avaient une variante VL spécifique, celui-ci contient tout dans un seul model.”

“La compréhension vidéo lui permet de saisir des détails temporels que les méthodes d'extraction de frames ignorent.”

“En termes de code, il semble aussi réactif que le model GPT-4o mais avec un meilleur respect des instructions.”

“La capacité d'agent GUI pour bureau est la fonctionnalité phare ici pour l'automatisation réelle.”

“Il gère 120 minutes de vidéo sans perdre le contexte, ce qui est tout simplement massif pour l'analyse.”

Optimisez votre flux de travail avec l'Automatisation IA

Automatio combine la puissance des agents IA, de l'automatisation web et des integrations intelligentes pour vous aider a accomplir plus en moins de temps.

Conseils Pro pour Qwen3.5-397B-A17B

Conseils d'experts pour tirer le meilleur parti de Qwen3.5-397B-A17B.

Activer le Thinking Mode

Utilisez le paramètre enable_thinking pour les tâches complexes afin d'activer des chemins de reasoning interne profonds.

Exploiter la recherche native

Activez le paramètre search dans le corps de la requête pour vérifier des faits par rapport aux données du web en temps réel et exécuter du code python.

Optimiser les prompts vidéo

Fournissez des ancres temporelles spécifiques pour concentrer la context window de 1M de tokens sur les segments les plus pertinents.

Sélection de l'endpoint régional

Utilisez l'endpoint dashscope-intl pour les utilisateurs hors de Chine continentale afin de réduire la latency réseau.

Témoignages

Ce Que Disent Nos Utilisateurs

Rejoignez des milliers d'utilisateurs satisfaits qui ont transforme leur flux de travail

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Associés AI Models

GPT-5.1

OpenAI

GPT-5.1 is OpenAI’s advanced reasoning flagship featuring adaptive thinking, native multimodality, and state-of-the-art performance in math and technical...

Kimi K2.5

Moonshot

Discover Moonshot AI's Kimi K2.5, a 1T-parameter open-source agentic model featuring native multimodal capabilities, a 262K context window, and SOTA reasoning.

Grok-4

xAI

Grok-4 by xAI is a frontier model featuring a 2M token context window, real-time X platform integration, and world-record reasoning capabilities.

Claude Opus 4.5

Anthropic

Claude Opus 4.5 is Anthropic's most powerful frontier model, delivering record-breaking 80.9% SWE-bench performance and advanced autonomous agency for coding.

Claude Sonnet 4.6

Anthropic

Claude Sonnet 4.6 offers frontier performance for coding and computer use with a massive 1M token context window for only $3/1M tokens.

Gemini 3 Flash

Gemini 3 Flash is Google's high-speed multimodal model featuring a 1M token context window, elite 90.4% GPQA reasoning, and autonomous browser automation tools.

Claude Opus 4.6

Anthropic

Claude Opus 4.6 is Anthropic's flagship model featuring a 1M token context window, Adaptive Thinking, and world-class coding and reasoning performance.

GLM-4.7

Zhipu (GLM)

GLM-4.7 by Zhipu AI is a flagship 358B MoE model featuring a 200K context window, elite 73.8% SWE-bench performance, and native Deep Thinking for agentic...

Questions Fréquentes sur Qwen3.5-397B-A17B

Trouvez des réponses aux questions courantes sur Qwen3.5-397B-A17B