Kako vršiti scraping Hacker Newsa (news.ycombinator.com)

Naučite kako strugati Hacker News za ekstrakciju najboljih tech priča, oglasa za posao i rasprava zajednice. Savršeno za istraživanje tržišta i analizu...

Otkrivena anti-bot zaštita

- Ograničenje brzine

- Ograničava zahtjeve po IP-u/sesiji tijekom vremena. Može se zaobići rotacijskim proxyjevima, kašnjenjima zahtjeva i distribuiranim scrapingom.

- IP blokiranje

- Blokira poznate IP adrese podatkovnih centara i označene adrese. Zahtijeva rezidencijalne ili mobilne proxyje za učinkovito zaobilaženje.

- User-Agent Filtering

O Hacker News

Otkrijte što Hacker News nudi i koji se vrijedni podaci mogu izvući.

Tehnološko središte

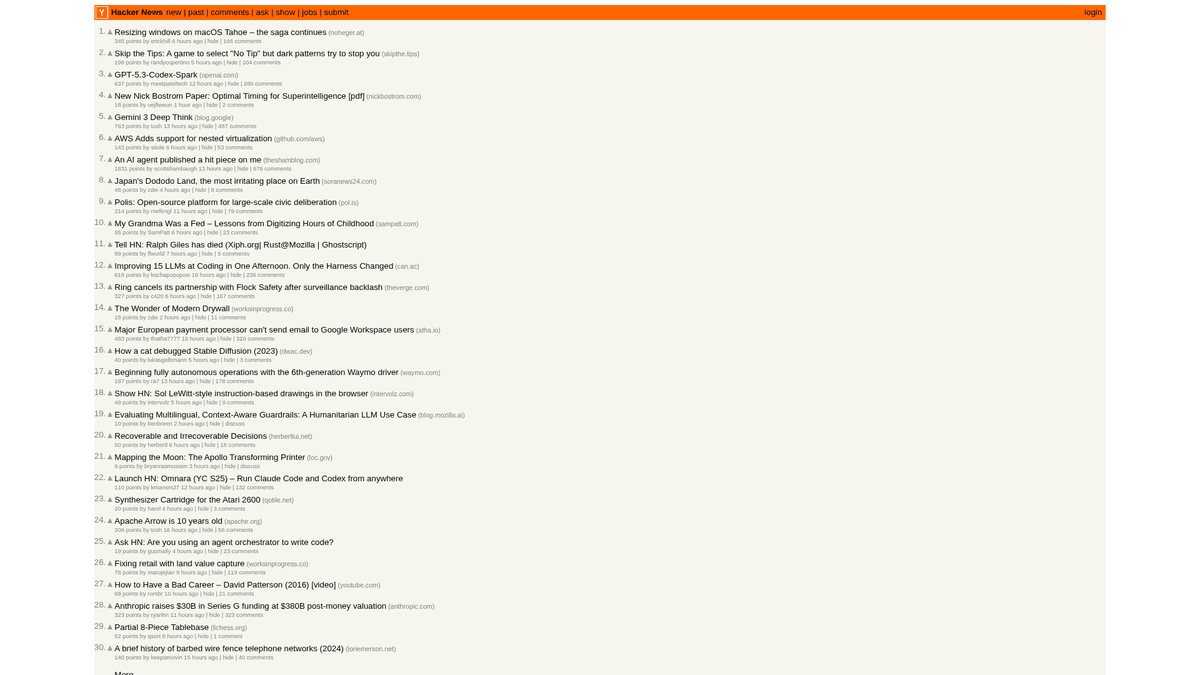

Hacker News je društvena vijest stranica fokusirana na računalnu znanost i poduzetništvo, kojom upravlja startup inkubator Y Combinator. Funkcionira kao platforma vođena zajednicom gdje korisnici šalju poveznice na tehničke članke, startup vijesti i dubinske rasprave.

Bogatstvo podataka

Platforma sadrži obilje podataka u stvarnom vremenu, uključujući najpopularnije tech priče, lansiranja startupova u sekciji "Show HN", pitanja zajednice u "Ask HN" i specijalizirane oglasnike za posao. Smatra se pulsom ekosustava Silicijske doline i šire globalne developerske zajednice.

Strateška vrijednost

Scraping ovih podataka omogućuje tvrtkama i istraživačima praćenje novih tehnologija, praćenje spominjanja konkurenata i identificiranje utjecajnih lidera mišljenja. Budući da je izgled stranice izuzetno stabilan i lagan, on je jedan od najpouzdanijih izvora za automatiziranu agregaciju tehničkih vijesti.

Zašto Scrapati Hacker News?

Otkrijte poslovnu vrijednost i slučajeve korištenja za izvlačenje podataka iz Hacker News.

Rano prepoznavanje novih programskih jezika i developer alata

Praćenje startup ekosustava za nova lansiranja i vijesti o financiranju

Generiranje leadova za tehničko zapošljavanje praćenjem 'Who is Hiring' niti

Analiza sentimenta o izdanjima softvera i korporativnim objavama

Izgradnja visokokvalitetnih agregatora tehničkih vijesti za specifičnu publiku

Akademsko istraživanje o širenju informacija u tehničkim zajednicama

Izazovi Scrapanja

Tehnički izazovi s kojima se možete susresti prilikom scrapanja Hacker News.

Raščlanjivanje ugniježđenih HTML tablica korištenih za izgled stranice

Obrada relativnih vremenskih nizova poput 'prije 2 sata' za pohranu u bazu podataka

Upravljanje rate limitima na strani servera koji uzrokuju privremene zabrane IP adresa

Ekstrakcija dubokih hijerarhija komentara koje se protežu kroz više stranica

Scrapajte Hacker News s AI-jem

Bez kodiranja. Ekstrahirajte podatke u minutama s automatizacijom pogonjenom AI-jem.

Kako funkcionira

Opišite što trebate

Recite AI-ju koje podatke želite ekstrahirati s Hacker News. Jednostavno upišite na prirodnom jeziku — bez koda ili selektora.

AI ekstrahira podatke

Naša umjetna inteligencija navigira Hacker News, obrađuje dinamički sadržaj i ekstrahira točno ono što ste tražili.

Dobijte svoje podatke

Primite čiste, strukturirane podatke spremne za izvoz kao CSV, JSON ili slanje izravno u vaše aplikacije.

Zašto koristiti AI za scrapanje

AI olakšava scrapanje Hacker News bez pisanja koda. Naša platforma pogonjena umjetnom inteligencijom razumije koje podatke želite — jednostavno ih opišite na prirodnom jeziku i AI će ih automatski ekstrahirati.

How to scrape with AI:

- Opišite što trebate: Recite AI-ju koje podatke želite ekstrahirati s Hacker News. Jednostavno upišite na prirodnom jeziku — bez koda ili selektora.

- AI ekstrahira podatke: Naša umjetna inteligencija navigira Hacker News, obrađuje dinamički sadržaj i ekstrahira točno ono što ste tražili.

- Dobijte svoje podatke: Primite čiste, strukturirane podatke spremne za izvoz kao CSV, JSON ili slanje izravno u vaše aplikacije.

Why use AI for scraping:

- Point-and-click odabir priča bez pisanja složenih CSS selektora

- Automatsko rukovanje gumbom 'More' za besprijekornu paginaciju

- Ugrađeno izvršavanje u cloudu kako biste spriječili rate-limiting vaše lokalne IP adrese

- Zakazano pokretanje scrapinga za automatsko snimanje naslovnice svakih sat vremena

- Izravan izvoz u Google Sheets ili webhooks za obavijesti u stvarnom vremenu

No-Code Web Scraperi za Hacker News

Klikni-i-odaberi alternative AI scrapanju

Nekoliko no-code alata poput Browse.ai, Octoparse, Axiom i ParseHub mogu vam pomoći scrapati Hacker News bez pisanja koda. Ovi alati obično koriste vizualna sučelja za odabir podataka, iako mogu imati problema sa složenim dinamičkim sadržajem ili anti-bot mjerama.

Tipični Tijek Rada s No-Code Alatima

Česti Izazovi

Krivulja učenja

Razumijevanje selektora i logike ekstrakcije zahtijeva vrijeme

Selektori se kvare

Promjene na web stranici mogu pokvariti cijeli tijek rada

Problemi s dinamičkim sadržajem

Stranice bogate JavaScriptom zahtijevaju složena rješenja

Ograničenja CAPTCHA

Većina alata zahtijeva ručnu intervenciju za CAPTCHA

Blokiranje IP-a

Agresivno scrapanje može dovesti do blokiranja vaše IP adrese

No-Code Web Scraperi za Hacker News

Nekoliko no-code alata poput Browse.ai, Octoparse, Axiom i ParseHub mogu vam pomoći scrapati Hacker News bez pisanja koda. Ovi alati obično koriste vizualna sučelja za odabir podataka, iako mogu imati problema sa složenim dinamičkim sadržajem ili anti-bot mjerama.

Tipični Tijek Rada s No-Code Alatima

- Instalirajte proširenje preglednika ili se registrirajte na platformi

- Navigirajte do ciljane web stranice i otvorite alat

- Odaberite podatkovne elemente za ekstrakciju klikom

- Konfigurirajte CSS selektore za svako podatkovno polje

- Postavite pravila paginacije za scrapanje više stranica

- Riješite CAPTCHA (često zahtijeva ručno rješavanje)

- Konfigurirajte raspored za automatska pokretanja

- Izvezite podatke u CSV, JSON ili povežite putem API-ja

Česti Izazovi

- Krivulja učenja: Razumijevanje selektora i logike ekstrakcije zahtijeva vrijeme

- Selektori se kvare: Promjene na web stranici mogu pokvariti cijeli tijek rada

- Problemi s dinamičkim sadržajem: Stranice bogate JavaScriptom zahtijevaju složena rješenja

- Ograničenja CAPTCHA: Većina alata zahtijeva ručnu intervenciju za CAPTCHA

- Blokiranje IP-a: Agresivno scrapanje može dovesti do blokiranja vaše IP adrese

Primjeri koda

import requests

from bs4 import BeautifulSoup

url = 'https://news.ycombinator.com/'

headers = {'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36'}

try:

response = requests.get(url, headers=headers)

response.raise_for_status()

soup = BeautifulSoup(response.text, 'html.parser')

# Stories are contained in rows with class 'athing'

posts = soup.select('.athing')

for post in posts:

title_element = post.select_one('.titleline > a')

title = title_element.text

link = title_element['href']

print(f'Title: {title}

Link: {link}

---')

except Exception as e:

print(f'Scraping failed: {e}')Kada Koristiti

Najbolje za statične HTML stranice gdje se sadržaj učitava na strani poslužitelja. Najbrži i najjednostavniji pristup kada JavaScript renderiranje nije potrebno.

Prednosti

- ●Najbrže izvršavanje (bez opterećenja preglednika)

- ●Najniža potrošnja resursa

- ●Lako paralelizirati s asynciom

- ●Izvrsno za API-je i statične stranice

Ograničenja

- ●Ne može izvršiti JavaScript

- ●Ne uspijeva na SPA-ovima i dinamičkom sadržaju

- ●Može imati problema sa složenim anti-bot sustavima

How to Scrape Hacker News with Code

Python + Requests

import requests

from bs4 import BeautifulSoup

url = 'https://news.ycombinator.com/'

headers = {'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36'}

try:

response = requests.get(url, headers=headers)

response.raise_for_status()

soup = BeautifulSoup(response.text, 'html.parser')

# Stories are contained in rows with class 'athing'

posts = soup.select('.athing')

for post in posts:

title_element = post.select_one('.titleline > a')

title = title_element.text

link = title_element['href']

print(f'Title: {title}

Link: {link}

---')

except Exception as e:

print(f'Scraping failed: {e}')Python + Playwright

from playwright.sync_api import sync_playwright

with sync_playwright() as p:

browser = p.chromium.launch(headless=True)

page = browser.new_page()

page.goto('https://news.ycombinator.com/')

# Wait for the table to load

page.wait_for_selector('.athing')

# Extract all story titles and links

items = page.query_selector_all('.athing')

for item in items:

title_link = item.query_selector('.titleline > a')

if title_link:

print(title_link.inner_text(), title_link.get_attribute('href'))

browser.close()Python + Scrapy

import scrapy

class HackerNewsSpider(scrapy.Spider):

name = 'hn_spider'

start_urls = ['https://news.ycombinator.com/']

def parse(self, response):

for post in response.css('.athing'):

yield {

'id': post.attrib.get('id'),

'title': post.css('.titleline > a::text').get(),

'link': post.css('.titleline > a::attr(href)').get(),

}

# Follow pagination 'More' link

next_page = response.css('a.morelink::attr(href)').get()

if next_page:

yield response.follow(next_page, self.parse)Node.js + Puppeteer

const puppeteer = require('puppeteer');

(async () => {

const browser = await puppeteer.launch();

const page = await browser.newPage();

await page.goto('https://news.ycombinator.com/');

const results = await page.evaluate(() => {

const items = Array.from(document.querySelectorAll('.athing'));

return items.map(item => ({

title: item.querySelector('.titleline > a').innerText,

url: item.querySelector('.titleline > a').href

}));

});

console.log(results);

await browser.close();

})();Što Možete Učiniti S Podacima Hacker News

Istražite praktične primjene i uvide iz podataka Hacker News.

Otkrivanje startup trendova

Identificirajte koje se industrije ili vrste proizvoda najčešće lansiraju i o kojima se najviše raspravlja.

Kako implementirati:

- 1Vršite scraping 'Show HN' kategorije na tjednoj bazi.

- 2Očistite i kategorizirajte opise startupova koristeći NLP.

- 3Rangirajte trendove na temelju glasova zajednice i sentimenta komentara.

Koristite Automatio za izvlačenje podataka iz Hacker News i izgradite ove aplikacije bez pisanja koda.

Što Možete Učiniti S Podacima Hacker News

- Otkrivanje startup trendova

Identificirajte koje se industrije ili vrste proizvoda najčešće lansiraju i o kojima se najviše raspravlja.

- Vršite scraping 'Show HN' kategorije na tjednoj bazi.

- Očistite i kategorizirajte opise startupova koristeći NLP.

- Rangirajte trendove na temelju glasova zajednice i sentimenta komentara.

- Sourcing i zapošljavanje u tech sektoru

Ekstrahirajte oglase za posao i detalje o tvrtkama iz specijaliziranih mjesečnih niti za zapošljavanje.

- Pratite ID mjesečne niti 'Who is hiring' (Tko zapošljava).

- Stružite sve komentare najviše razine koji sadrže opise poslova.

- Analizirajte tekst za specifične tech stackove poput Rusta, AI ili Reacta.

- Praćenje konkurencije

Pratite spominjanje konkurenata u komentarima kako biste razumjeli percepciju javnosti i pritužbe.

- Postavite scraper baziran na ključnim riječima za specifična imena brendova.

- Ekstrahirajte komentare korisnika i vremenske oznake za analizu sentimenta.

- Generirajte tjedna izvješća o zdravlju brenda u usporedbi s konkurentima.

- Automatizirano uređivanje sadržaja

Kreirajte visokokvalitetni tech newsletter koji uključuje samo najrelevantnije priče.

- Vršite scraping naslovnice svakih 6 sati.

- Filtrirajte objave koje prelaze prag od 200 bodova.

- Automatizirajte isporuku tih poveznica na Telegram bot ili email listu.

- Pronalazak prilika za Venture Capital

Otkrijte startupove u ranoj fazi koji dobivaju značajnu pažnju zajednice.

- Pratite 'Show HN' objave koje dođu na naslovnicu.

- Pratite stopu rasta glasova tijekom prva 4 sata.

- Obavijestite analitičare kada objava pokaže obrasce viralnog rasta.

Poboljšajte svoj radni tijek sa AI Automatizacijom

Automatio kombinira moc AI agenata, web automatizacije i pametnih integracija kako bi vam pomogao postici vise za manje vremena.

Pro Savjeti Za Scrapanje Hacker News

Stručni savjeti za uspješno izvlačenje podataka iz Hacker News.

Koristite službeni Firebase API za prikupljanje ogromnih količina povijesnih podataka kako biste izbjegli složenost raščlanjivanja (parsinga) HTML-a.

Uvijek postavite prilagođeni User-Agent kako biste odgovorno identificirali svoj bot i izbjegli trenutno blokiranje.

Implementirajte nasumični interval spavanja od 3-7 sekundi između zahtjeva kako biste oponašali ponašanje stvarnih korisnika.

Ciljajte specifične poddirektorije poput /newest za najnovije priče ili /ask za rasprave zajednice.

Spremite 'Item ID' kao primarni ključ kako biste izbjegli duplicirane unose pri čestom struganju (scraping) naslovnice.

Vršite scraping izvan vršnih sati (UTC noć) kako biste iskusili brže vrijeme odziva i smanjili rizik od ograničenja brzine (rate-limiting).

Svjedočanstva

Sto Kazu Nasi Korisnici

Pridruzite se tisucama zadovoljnih korisnika koji su transformirali svoj radni tijek

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Povezani Web Scraping

Često Postavljana Pitanja o Hacker News

Pronađite odgovore na česta pitanja o Hacker News