Hogyan gyűjtsünk adatokat a Hacker News-ról (news.ycombinator.com)

Tanulja meg, hogyan gyűjthet adatokat a Hacker News-ról a technológiai hírek, álláshirdetések és közösségi viták kinyeréséhez. Ideális piackutatáshoz és...

Anti-bot védelem észlelve

- Sebességkorlátozás

- IP/munkamenet alapú kéréseket korlátoz időben. Forgó proxykkal, kéréskésleltetéssel és elosztott scrapinggel megkerülhető.

- IP-blokkolás

- Ismert adatközponti IP-ket és megjelölt címeket blokkol. Lakossági vagy mobil proxyk szükségesek a hatékony megkerüléshez.

- User-Agent Filtering

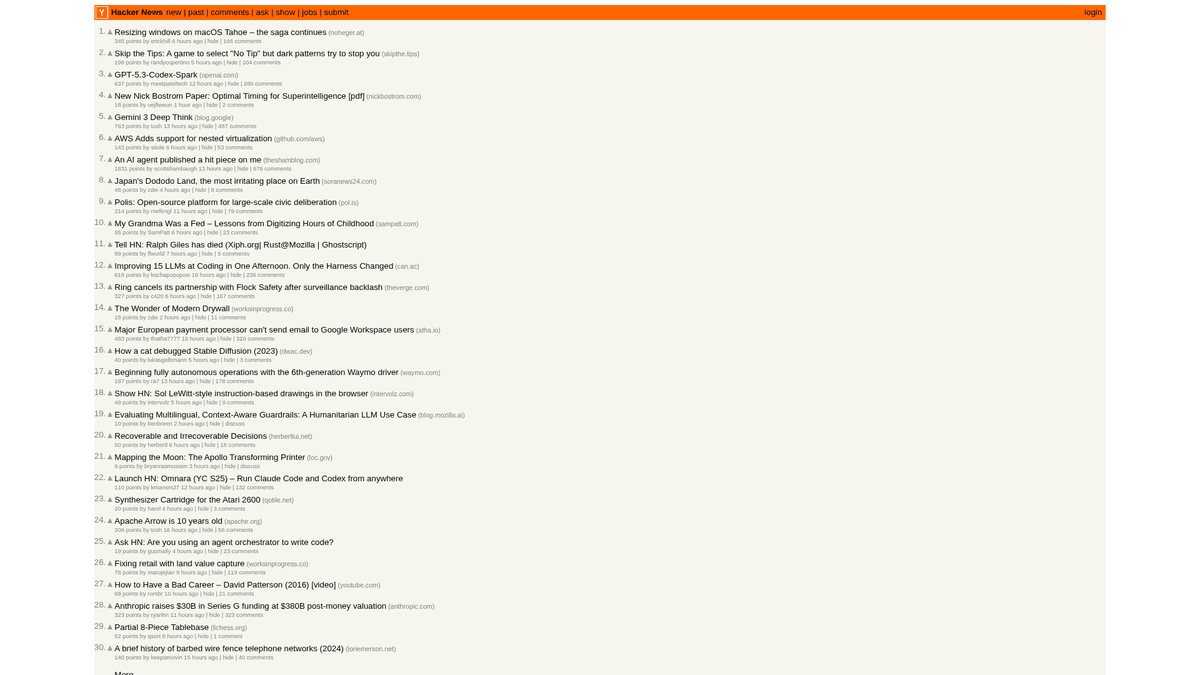

A(z) Hacker News Névjegye

Fedezze fel, mit kínál a(z) Hacker News és milyen értékes adatok nyerhetők ki.

A Tech Hub

A Hacker News egy számítástechnikára és vállalkozásra fókuszáló közösségi híroldal, amelyet a Y Combinator startup inkubátor üzemeltet. Közösségvezérelt platformként működik, ahol a felhasználók technikai cikkekre, startup hírekre és mélyreható vitákra mutató linkeket osztanak meg.

Adatgazdagság

A platform rengeteg valós idejű adatot tartalmaz, beleértve a felkapott tech sztorikat, a "Show HN" startup indulásokat, az "Ask HN" közösségi kérdéseket és speciális állásportálokat. Széles körben a Silicon Valley ökoszisztéma és a globális fejlesztői közösség ütőereként tekintenek rá.

Stratégiai érték

Ezen adatok kinyerése lehetővé teszi a vállalkozások és kutatók számára a feltörekvő technológiák monitorozását, a versenytársak említéseinek nyomon követését és a véleményvezérek azonosítását. Mivel az oldal elrendezése rendkívül stabil és letisztult, ez az egyik legmegbízhatóbb forrás az automatizált technikai hírek aggregálásához.

Miért Kell Scrapelni a(z) Hacker News-t?

Fedezze fel a(z) Hacker News-ból történő adatkinyerés üzleti értékét és felhasználási eseteit.

Feltörekvő programozási nyelvek és fejlesztői eszközök korai felismerése

A startup ökoszisztéma figyelése az új indulások és finanszírozási hírek miatt

Lead generálás technikai toborzáshoz a 'Who is Hiring' szálak monitorozásával

Hangulatelemzés a szoftvermegjelenésekről és vállalati bejelentésekről

Magas minőségű technikai hírek aggregálása rétegközönségek számára

Akadémiai kutatás az információterjedésről technikai közösségekben

Scraping Kihívások

Technikai kihívások, amelyekkel a(z) Hacker News scrapelésekor találkozhat.

Az elrendezéshez használt egymásba ágyazott HTML táblázatszerkezetek feldolgozása

A relatív időformátumok (pl. '2 hours ago') kezelése az adatbázisban történő tároláshoz

A szerveroldali rate limitek kezelése, amelyek ideiglenes IP-tiltást válthatnak ki

A több oldalon átívelő, mély komment-hierarchiák kinyerése

Scrapeld a Hacker News-t AI-val

Nincs szükség kódolásra. Nyerj ki adatokat percek alatt AI-vezérelt automatizálással.

Hogyan működik

Írd le, mire van szükséged

Mondd el az AI-nak, milyen adatokat szeretnél kinyerni a Hacker News-ról. Csak írd be természetes nyelven — nincs szükség kódra vagy szelektorokra.

Az AI kinyeri az adatokat

Mesterséges intelligenciánk navigál a Hacker News-on, kezeli a dinamikus tartalmat, és pontosan azt nyeri ki, amit kértél.

Kapd meg az adataidat

Kapj tiszta, strukturált adatokat, amelyek készen állnak CSV, JSON exportra vagy közvetlenül az alkalmazásaidba küldésre.

Miért érdemes AI-t használni a scrapeléshez

Az AI megkönnyíti a Hacker News scrapelését kódírás nélkül. Mesterséges intelligenciával működő platformunk megérti, milyen adatokra van szükséged — csak írd le természetes nyelven, és az AI automatikusan kinyeri őket.

How to scrape with AI:

- Írd le, mire van szükséged: Mondd el az AI-nak, milyen adatokat szeretnél kinyerni a Hacker News-ról. Csak írd be természetes nyelven — nincs szükség kódra vagy szelektorokra.

- Az AI kinyeri az adatokat: Mesterséges intelligenciánk navigál a Hacker News-on, kezeli a dinamikus tartalmat, és pontosan azt nyeri ki, amit kértél.

- Kapd meg az adataidat: Kapj tiszta, strukturált adatokat, amelyek készen állnak CSV, JSON exportra vagy közvetlenül az alkalmazásaidba küldésre.

Why use AI for scraping:

- Bejegyzések kiválasztása kattintással, bonyolult CSS selektorok írása nélkül

- A 'More' gomb automatikus kezelése a zökkenőmentes lapozáshoz

- Beépített felhőalapú futtatás, hogy elkerülje a saját IP-címe rate-limitingjét

- Ütemezett scraping futtatások a címlap óránkénti automatikus rögzítéséhez

- Közvetlen exportálás Google Sheets-be vagy Webhook-ok használata valós idejű riasztásokhoz

No-Code Web Scraperek a Hacker News számára

Kattints-és-válassz alternatívák az AI-alapú scrapeléshez

Számos no-code eszköz, mint a Browse.ai, Octoparse, Axiom és ParseHub segíthet a Hacker News scrapelésében kódírás nélkül. Ezek az eszközök általában vizuális felületeket használnak az adatok kiválasztásához, bár nehézségeik lehetnek összetett dinamikus tartalmakkal vagy anti-bot intézkedésekkel.

Tipikus Munkafolyamat No-Code Eszközökkel

Gyakori Kihívások

Tanulási görbe

A szelektorok és a kinyerési logika megértése időt igényel

Szelektorok elromlanak

A weboldal változásai tönkretehetik a teljes munkafolyamatot

Dinamikus tartalom problémák

JavaScript-gazdag oldalak komplex megoldásokat igényelnek

CAPTCHA korlátozások

A legtöbb eszköz manuális beavatkozást igényel CAPTCHA esetén

IP blokkolás

Az agresszív scraping az IP blokkolásához vezethet

No-Code Web Scraperek a Hacker News számára

Számos no-code eszköz, mint a Browse.ai, Octoparse, Axiom és ParseHub segíthet a Hacker News scrapelésében kódírás nélkül. Ezek az eszközök általában vizuális felületeket használnak az adatok kiválasztásához, bár nehézségeik lehetnek összetett dinamikus tartalmakkal vagy anti-bot intézkedésekkel.

Tipikus Munkafolyamat No-Code Eszközökkel

- Böngésző bővítmény telepítése vagy regisztráció a platformon

- Navigálás a célweboldalra és az eszköz megnyitása

- Adatelemek kiválasztása kattintással

- CSS szelektorok konfigurálása minden adatmezőhöz

- Lapozási szabályok beállítása több oldal scrapeléséhez

- CAPTCHA kezelése (gyakran manuális megoldás szükséges)

- Ütemezés konfigurálása automatikus futtatásokhoz

- Adatok exportálása CSV, JSON formátumba vagy API-n keresztüli csatlakozás

Gyakori Kihívások

- Tanulási görbe: A szelektorok és a kinyerési logika megértése időt igényel

- Szelektorok elromlanak: A weboldal változásai tönkretehetik a teljes munkafolyamatot

- Dinamikus tartalom problémák: JavaScript-gazdag oldalak komplex megoldásokat igényelnek

- CAPTCHA korlátozások: A legtöbb eszköz manuális beavatkozást igényel CAPTCHA esetén

- IP blokkolás: Az agresszív scraping az IP blokkolásához vezethet

Kod peldak

import requests

from bs4 import BeautifulSoup

url = 'https://news.ycombinator.com/'

headers = {'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36'}

try:

response = requests.get(url, headers=headers)

response.raise_for_status()

soup = BeautifulSoup(response.text, 'html.parser')

# A bejegyzések az 'athing' osztályú sorokban találhatók

posts = soup.select('.athing')

for post in posts:

title_element = post.select_one('.titleline > a')

title = title_element.text

link = title_element['href']

print(f'Cím: {title}

Link: {link}

---')

except Exception as e:

print(f'Sikertelen adatgyűjtés: {e}')Mikor Használjuk

A legjobb statikus HTML oldalakhoz, ahol a tartalom szerver oldalon töltődik. A leggyorsabb és legegyszerűbb megközelítés, amikor JavaScript renderelés nem szükséges.

Előnyök

- ●Leggyorsabb végrehajtás (nincs böngésző overhead)

- ●Legalacsonyabb erőforrás-fogyasztás

- ●Könnyen párhuzamosítható asyncio-val

- ●Kiváló API-khoz és statikus oldalakhoz

Korlátok

- ●Nem tudja végrehajtani a JavaScriptet

- ●Nem működik SPA-knál és dinamikus tartalmaknál

- ●Problémái lehetnek összetett anti-bot rendszerekkel

How to Scrape Hacker News with Code

Python + Requests

import requests

from bs4 import BeautifulSoup

url = 'https://news.ycombinator.com/'

headers = {'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36'}

try:

response = requests.get(url, headers=headers)

response.raise_for_status()

soup = BeautifulSoup(response.text, 'html.parser')

# A bejegyzések az 'athing' osztályú sorokban találhatók

posts = soup.select('.athing')

for post in posts:

title_element = post.select_one('.titleline > a')

title = title_element.text

link = title_element['href']

print(f'Cím: {title}

Link: {link}

---')

except Exception as e:

print(f'Sikertelen adatgyűjtés: {e}')Python + Playwright

from playwright.sync_api import sync_playwright

with sync_playwright() as p:

browser = p.chromium.launch(headless=True)

page = browser.new_page()

page.goto('https://news.ycombinator.com/')

# Várakozás a táblázat betöltésére

page.wait_for_selector('.athing')

# Az összes hír címének és linkjének kinyerése

items = page.query_selector_all('.athing')

for item in items:

title_link = item.query_selector('.titleline > a')

if title_link:

print(title_link.inner_text(), title_link.get_attribute('href'))

browser.close()Python + Scrapy

import scrapy

class HackerNewsSpider(scrapy.Spider):

name = 'hn_spider'

start_urls = ['https://news.ycombinator.com/']

def parse(self, response):

for post in response.css('.athing'):

yield {

'id': post.attrib.get('id'),

'title': post.css('.titleline > a::text').get(),

'link': post.css('.titleline > a::attr(href)').get(),

}

# Lapozás a 'More' link követésével

next_page = response.css('a.morelink::attr(href)').get()

if next_page:

yield response.follow(next_page, self.parse)Node.js + Puppeteer

const puppeteer = require('puppeteer');

(async () => {

const browser = await puppeteer.launch();

const page = await browser.newPage();

await page.goto('https://news.ycombinator.com/');

const results = await page.evaluate(() => {

const items = Array.from(document.querySelectorAll('.athing'));

return items.map(item => ({

title: item.querySelector('.titleline > a').innerText,

url: item.querySelector('.titleline > a').href

}));

});

console.log(results);

await browser.close();

})();Mit Tehet a(z) Hacker News Adataival

Fedezze fel a(z) Hacker News adataiból származó gyakorlati alkalmazásokat és betekintéseket.

Startup trendek felfedezése

Azonosítsa, mely iparágak vagy terméktípusok indulnak el és kerülnek a leggyakrabban megvitatásra.

Hogyan implementáljuk:

- 1Gyűjtse a 'Show HN' kategória adatait heti rendszerességgel.

- 2Tisztítsa és kategorizálja a startup leírásokat NLP segítségével.

- 3Rangsorolja a trendeket a közösségi szavazatok és a kommentek hangulata alapján.

Használja az Automatio-t adatok kinyeréséhez a Hacker News-ből és építse meg ezeket az alkalmazásokat kódírás nélkül.

Mit Tehet a(z) Hacker News Adataival

- Startup trendek felfedezése

Azonosítsa, mely iparágak vagy terméktípusok indulnak el és kerülnek a leggyakrabban megvitatásra.

- Gyűjtse a 'Show HN' kategória adatait heti rendszerességgel.

- Tisztítsa és kategorizálja a startup leírásokat NLP segítségével.

- Rangsorolja a trendeket a közösségi szavazatok és a kommentek hangulata alapján.

- Tech sourcing és toborzás

Álláshirdetések és cégadatok kinyerése speciális havi toborzási bejegyzésekből.

- Figyelje a havi 'Who is hiring' (Ki vesz fel embereket) bejegyzés ID-jét.

- Gyűjtse ki az összes felső szintű hozzászólást, amely álláshirdetéseket tartalmaz.

- Elemezze a szövegeket konkrét technológiák, például Rust, AI vagy React után kutatva.

- Versenytárselemzés

Kövesse nyomon a versenytársak említését a kommentekben a közvélemény és a panaszok megértéséhez.

- Állítson be kulcsszóalapú scrapert konkrét márkanevekre.

- Nyerje ki a felhasználói kommenteket és időbélyegeket a hangulatelemzéshez.

- Készítsen heti jelentéseket a márka állapotáról a versenytársakhoz képest.

- Automatizált tartalomkezelés

Hozzon létre egy magas minőségű tech hírlevelet, amely csak a legrelevánsabb sztorikat tartalmazza.

- Scrapingelje a címlapot 6 óránként.

- Szűrjön azokra a posztokra, amelyek meghaladják a 200 pontos küszöböt.

- Automatizálja ezen linkek küldését egy Telegram botra vagy e-mail listára.

- Venture Capital Lead generálás

Fedezze fel a korai fázisú startupokat, amelyek jelentős közösségi figyelmet kapnak.

- Kövesse a címlapra kerülő 'Show HN' bejegyzéseket.

- Figyelje a szavazatok növekedési ütemét az első 4 órában.

- Riasztsa az elemzőket, ha egy poszt virális növekedési mintákat mutat.

Turbozd fel a munkafolyamatodat AI automatizalasal

Az Automatio egyesiti az AI ugynokk, a web automatizalas es az okos integraciok erejet, hogy segitsen tobbet elerni kevesebb ido alatt.

Profi Tippek a(z) Hacker News Scrapeléséhez

Szakértői tanácsok a(z) Hacker News-ból történő sikeres adatkinyeréshez.

Használja a hivatalos Firebase API-t a tömeges korábbi adatok gyűjtéséhez, hogy elkerülje az HTML-feldolgozás bonyolultságát.

Mindig állítson be egyedi User-Agent értéket, hogy felelősségteljesen azonosítsa botját, és elkerülje az azonnali kitiltást.

Alkalmazzon véletlenszerű, 3-7 másodperces szüneteket a kérések között, hogy utánozza az emberi böngészési viselkedést.

Célozzon meg konkrét alkönyvtárakat, mint például a /newest-et a friss hírekhez vagy az /ask-ot a közösségi megbeszélésekhez.

Mentse el az 'Item ID'-t elsődleges kulcsként, hogy elkerülje a duplikált bejegyzéseket a főoldal gyakori scrapingelése során.

Végezze a scraping folyamatot csúcsidőn kívül (UTC éjszaka) a gyorsabb válaszidők és az alacsonyabb rate-limiting kockázat érdekében.

Velemenyek

Mit mondanak a felhasznaloink

Csatlakozz tobb ezer elegedett felhasznalohoz, akik atalakitottak a munkafolyamatukat

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Kapcsolodo Web Scraping

Gyakran ismetelt kerdesek a Hacker News-rol

Talalj valaszokat a Hacker News-val kapcsolatos gyakori kerdesekre