Hogyan gyűjtsünk adatokat az Open Collective-ről: Pénzügyi és közreműködői adatgyűjtési útmutató

Ismerje meg, hogyan gyűjthet adatokat az Open Collective-ről tranzakciókról, közreműködőkről és finanszírozásról. Átlátható betekintés piackutatáshoz.

Anti-bot védelem észlelve

- Cloudflare

- Vállalati szintű WAF és botkezelés. JavaScript kihívásokat, CAPTCHA-kat és viselkedéselemzést használ. Böngészőautomatizálás szükséges rejtett beállításokkal.

- Sebességkorlátozás

- IP/munkamenet alapú kéréseket korlátoz időben. Forgó proxykkal, kéréskésleltetéssel és elosztott scrapinggel megkerülhető.

- WAF

A(z) Open Collective Névjegye

Fedezze fel, mit kínál a(z) Open Collective és milyen értékes adatok nyerhetők ki.

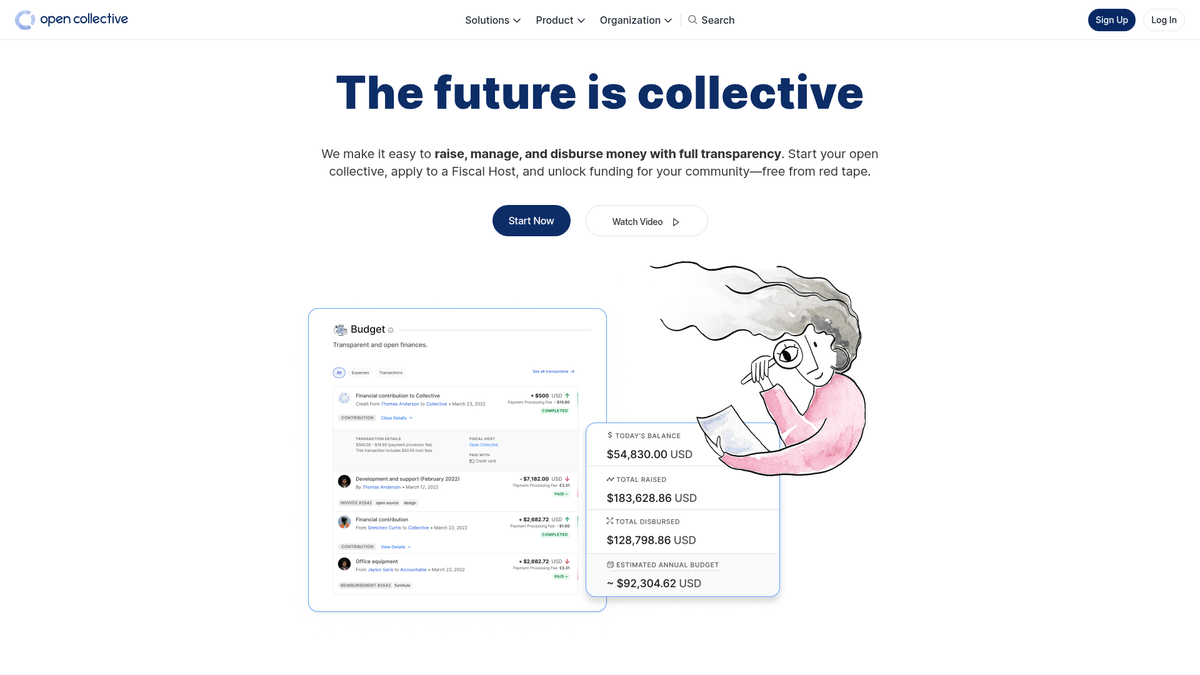

Az Open Collective-ről

Az Open Collective egy egyedülálló pénzügyi és jogi platform, amelyet a közösség által vezetett szervezetek, open-source szoftverprojektek és szomszédsági egyesületek átláthatóságának biztosítására terveztek. Decentralizált finanszírozási eszközként lehetővé teszi a „kollektívák” számára, hogy pénzt gyűjtsenek és kezeljék a költségeket formális jogi személyiség nélkül, gyakran fiskális hostokat igénybe véve az adminisztratív támogatáshoz. Olyan jelentős technológiai projektek, mint a Babel és a Webpack, erre a platformra támaszkodnak közösségi finanszírozású ökoszisztémájuk kezelésében.

A platform a radikális transzparenciáról híres. Minden tranzakció, legyen az egy nagyvállalati adomány vagy egy kisebb közösségi találkozó költsége, rögzítésre kerül és nyilvánosan látható. Ez rengeteg adatot szolgáltat a világ legkritikusabb open-source függőségeinek pénzügyi állapotáról és költési szokásairól.

Az Open Collective scrapingje rendkívül értékes azon szervezetek számára, amelyek piaci kutatást szeretnének végezni az open-source gazdaságról. Lehetővé teszi a felhasználók számára a vállalati szponzorációs lehetőségek azonosítását, a fejlesztői finanszírozási trendek nyomon követését és a kritikus szoftverprojektek pénzügyi fenntarthatóságának ellenőrzését. Az adatok közvetlen betekintést nyújtanak a globális fejlesztői közösségen belüli tőkeáramlásba.

Miért Kell Scrapelni a(z) Open Collective-t?

Fedezze fel a(z) Open Collective-ból történő adatkinyerés üzleti értékét és felhasználási eseteit.

Kritikus open-source függőségek fenntarthatóságának elemzése

Potenciális vállalati szponzorációs leadek azonosítása B2B szolgáltatásokhoz

Decentralizált finanszírozási trendek figyelése különböző technológiai stackeknél

Akadémiai kutatások végzése peer-to-peer pénzügyi rendszerekről

Nonprofit és közösségi csoportok költéseinek ellenőrzése az átláthatóság érdekében

Versenytársak részvételének nyomon követése közösségi projekt-szponzorációkban

Scraping Kihívások

Technikai kihívások, amelyekkel a(z) Open Collective scrapelésekor találkozhat.

Összetett GraphQL lekérdezések kezelése a mélyen beágyazott adatok kinyeréséhez

A dinamikus Next.js hidratáció és a végtelen görgetéses (infinite scroll) lapozás kezelése

A Cloudflare védelem megkerülése nagy gyakoriságú kérések esetén

Szigorú rate-limiting kezelése mind az API, mind a webes végpontokon

Scrapeld a Open Collective-t AI-val

Nincs szükség kódolásra. Nyerj ki adatokat percek alatt AI-vezérelt automatizálással.

Hogyan működik

Írd le, mire van szükséged

Mondd el az AI-nak, milyen adatokat szeretnél kinyerni a Open Collective-ról. Csak írd be természetes nyelven — nincs szükség kódra vagy szelektorokra.

Az AI kinyeri az adatokat

Mesterséges intelligenciánk navigál a Open Collective-on, kezeli a dinamikus tartalmat, és pontosan azt nyeri ki, amit kértél.

Kapd meg az adataidat

Kapj tiszta, strukturált adatokat, amelyek készen állnak CSV, JSON exportra vagy közvetlenül az alkalmazásaidba küldésre.

Miért érdemes AI-t használni a scrapeléshez

Az AI megkönnyíti a Open Collective scrapelését kódírás nélkül. Mesterséges intelligenciával működő platformunk megérti, milyen adatokra van szükséged — csak írd le természetes nyelven, és az AI automatikusan kinyeri őket.

How to scrape with AI:

- Írd le, mire van szükséged: Mondd el az AI-nak, milyen adatokat szeretnél kinyerni a Open Collective-ról. Csak írd be természetes nyelven — nincs szükség kódra vagy szelektorokra.

- Az AI kinyeri az adatokat: Mesterséges intelligenciánk navigál a Open Collective-on, kezeli a dinamikus tartalmat, és pontosan azt nyeri ki, amit kértél.

- Kapd meg az adataidat: Kapj tiszta, strukturált adatokat, amelyek készen állnak CSV, JSON exportra vagy közvetlenül az alkalmazásaidba küldésre.

Why use AI for scraping:

- Összetett pénzügyi adatok kinyerése GraphQL lekérdezések írása nélkül

- A JavaScript renderelés és a végtelen görgetés automatikus kezelése

- Ütemezett futtatások a projekt költségvetési változásainak nyomon követéséhez

- Anti-bot intézkedések megkerülése elosztott cloud futtatáson keresztül

No-Code Web Scraperek a Open Collective számára

Kattints-és-válassz alternatívák az AI-alapú scrapeléshez

Számos no-code eszköz, mint a Browse.ai, Octoparse, Axiom és ParseHub segíthet a Open Collective scrapelésében kódírás nélkül. Ezek az eszközök általában vizuális felületeket használnak az adatok kiválasztásához, bár nehézségeik lehetnek összetett dinamikus tartalmakkal vagy anti-bot intézkedésekkel.

Tipikus Munkafolyamat No-Code Eszközökkel

Gyakori Kihívások

Tanulási görbe

A szelektorok és a kinyerési logika megértése időt igényel

Szelektorok elromlanak

A weboldal változásai tönkretehetik a teljes munkafolyamatot

Dinamikus tartalom problémák

JavaScript-gazdag oldalak komplex megoldásokat igényelnek

CAPTCHA korlátozások

A legtöbb eszköz manuális beavatkozást igényel CAPTCHA esetén

IP blokkolás

Az agresszív scraping az IP blokkolásához vezethet

No-Code Web Scraperek a Open Collective számára

Számos no-code eszköz, mint a Browse.ai, Octoparse, Axiom és ParseHub segíthet a Open Collective scrapelésében kódírás nélkül. Ezek az eszközök általában vizuális felületeket használnak az adatok kiválasztásához, bár nehézségeik lehetnek összetett dinamikus tartalmakkal vagy anti-bot intézkedésekkel.

Tipikus Munkafolyamat No-Code Eszközökkel

- Böngésző bővítmény telepítése vagy regisztráció a platformon

- Navigálás a célweboldalra és az eszköz megnyitása

- Adatelemek kiválasztása kattintással

- CSS szelektorok konfigurálása minden adatmezőhöz

- Lapozási szabályok beállítása több oldal scrapeléséhez

- CAPTCHA kezelése (gyakran manuális megoldás szükséges)

- Ütemezés konfigurálása automatikus futtatásokhoz

- Adatok exportálása CSV, JSON formátumba vagy API-n keresztüli csatlakozás

Gyakori Kihívások

- Tanulási görbe: A szelektorok és a kinyerési logika megértése időt igényel

- Szelektorok elromlanak: A weboldal változásai tönkretehetik a teljes munkafolyamatot

- Dinamikus tartalom problémák: JavaScript-gazdag oldalak komplex megoldásokat igényelnek

- CAPTCHA korlátozások: A legtöbb eszköz manuális beavatkozást igényel CAPTCHA esetén

- IP blokkolás: Az agresszív scraping az IP blokkolásához vezethet

Kod peldak

import requests

# The Open Collective GraphQL endpoint

url = 'https://api.opencollective.com/graphql/v2'

# GraphQL query to get basic info about a collective

query = '''

query {

collective(slug: "webpack") {

name

stats {

totalAmountReceived { value }

balance { value }

}

}

}

'''

headers = {'Content-Type': 'application/json'}

try:

# Sending POST request to the API

response = requests.post(url, json={'query': query}, headers=headers)

response.raise_for_status()

data = response.json()

# Extracting and printing the name and balance

collective = data['data']['collective']

print(f"Name: {collective['name']}")

print(f"Balance: {collective['stats']['balance']['value']}")

except Exception as e:

print(f"An error occurred: {e}")Mikor Használjuk

A legjobb statikus HTML oldalakhoz, ahol a tartalom szerver oldalon töltődik. A leggyorsabb és legegyszerűbb megközelítés, amikor JavaScript renderelés nem szükséges.

Előnyök

- ●Leggyorsabb végrehajtás (nincs böngésző overhead)

- ●Legalacsonyabb erőforrás-fogyasztás

- ●Könnyen párhuzamosítható asyncio-val

- ●Kiváló API-khoz és statikus oldalakhoz

Korlátok

- ●Nem tudja végrehajtani a JavaScriptet

- ●Nem működik SPA-knál és dinamikus tartalmaknál

- ●Problémái lehetnek összetett anti-bot rendszerekkel

How to Scrape Open Collective with Code

Python + Requests

import requests

# The Open Collective GraphQL endpoint

url = 'https://api.opencollective.com/graphql/v2'

# GraphQL query to get basic info about a collective

query = '''

query {

collective(slug: "webpack") {

name

stats {

totalAmountReceived { value }

balance { value }

}

}

}

'''

headers = {'Content-Type': 'application/json'}

try:

# Sending POST request to the API

response = requests.post(url, json={'query': query}, headers=headers)

response.raise_for_status()

data = response.json()

# Extracting and printing the name and balance

collective = data['data']['collective']

print(f"Name: {collective['name']}")

print(f"Balance: {collective['stats']['balance']['value']}")

except Exception as e:

print(f"An error occurred: {e}")Python + Playwright

from playwright.sync_api import sync_playwright

def scrape_opencollective():

with sync_playwright() as p:

# Launching browser with JS support

browser = p.chromium.launch(headless=True)

page = browser.new_page()

page.goto('https://opencollective.com/discover')

# Wait for collective cards to load

page.wait_for_selector('.CollectiveCard')

# Extract data from the DOM

collectives = page.query_selector_all('.CollectiveCard')

for c in collectives:

name = c.query_selector('h2').inner_text()

print(f'Found project: {name}')

browser.close()

scrape_opencollective()Python + Scrapy

import scrapy

import json

class OpenCollectiveSpider(scrapy.Spider):

name = 'opencollective'

start_urls = ['https://opencollective.com/webpack']

def parse(self, response):

# Open Collective uses Next.js; data is often inside a script tag

next_data = response.xpath('//script[@id="__NEXT_DATA__"]/text()').get()

if next_data:

parsed_data = json.loads(next_data)

collective = parsed_data['props']['pageProps']['collective']

yield {

'name': collective.get('name'),

'balance': collective.get('stats', {}).get('balance'),

'currency': collective.get('currency')

}Node.js + Puppeteer

const puppeteer = require('puppeteer');

(async () => {

const browser = await puppeteer.launch();

const page = await browser.newPage();

await page.goto('https://opencollective.com/discover');

// Wait for the dynamic content to load

await page.waitForSelector('.CollectiveCard');

// Map over elements to extract names

const data = await page.evaluate(() => {

return Array.from(document.querySelectorAll('.CollectiveCard')).map(el => ({

name: el.querySelector('h2').innerText

}));

});

console.log(data);

await browser.close();

})();Mit Tehet a(z) Open Collective Adataival

Fedezze fel a(z) Open Collective adataiból származó gyakorlati alkalmazásokat és betekintéseket.

Open Source növekedési előrejelzés

Trendi technológiák azonosítása az egyes kollektíva-kategóriák pénzügyi növekedési ütemének nyomon követésével.

Hogyan implementáljuk:

- 1Havi bevételek kinyerése a legfontosabb projektekhez meghatározott címkék alapján

- 2Összetett éves növekedési ütem (CAGR) számítása

- 3A projektek finanszírozási állapotának vizualizálása a technológiai adoptáció előrejelzéséhez

Használja az Automatio-t adatok kinyeréséhez a Open Collective-ből és építse meg ezeket az alkalmazásokat kódírás nélkül.

Mit Tehet a(z) Open Collective Adataival

- Open Source növekedési előrejelzés

Trendi technológiák azonosítása az egyes kollektíva-kategóriák pénzügyi növekedési ütemének nyomon követésével.

- Havi bevételek kinyerése a legfontosabb projektekhez meghatározott címkék alapján

- Összetett éves növekedési ütem (CAGR) számítása

- A projektek finanszírozási állapotának vizualizálása a technológiai adoptáció előrejelzéséhez

- SaaS Lead generálás

Jól finanszírozott projektek azonosítása, amelyeknek fejlesztői eszközökre, hostingra vagy szakmai szolgáltatásokra lehet szükségük.

- Kollektívák szűrése költségvetés és az összes összegyűjtött összeg alapján

- Projektleírások és külső weboldal URL-ek kinyerése

- A technológiai stack ellenőrzése a linkelt GitHub repozitóriumokon keresztül

- Vállalati filantrópia audit

Annak nyomon követése, hogy a nagyvállalatok hol költik el open-source hozzájárulási költségvetésüket.

- Közreműködői listák gyűjtése a legfontosabb projektekhez

- Szervezeti profilok és egyéni profilok szűrése

- A hozzájárulási összegek összesítése vállalati entitásonként

- Közösségi hatásvizsgálat

Annak elemzése, hogyan osztják el a decentralizált csoportok a forrásaikat a társadalmi hatás megértése érdekében.

- A teljes tranzakciós napló kinyerése egy adott kollektívához

- Költségek kategorizálása (utazás, fizetések, hardver)

- Jelentések készítése az erőforrás-elosztásról a közösségi csoportokon belül

- Fejlesztői toborzási pipeline

Aktív vezetők keresése specifikus ökoszisztémákban a közösségi menedzsment és közreműködési előzményeik alapján.

- A kulcsfontosságú technikai kollektívák taglistáinak gyűjtése

- A közreműködők kereszthivatkozása nyilvános közösségi profiljaikkal

- Aktív karbantartók azonosítása magas szintű kapcsolatfelvétel céljából

Turbozd fel a munkafolyamatodat AI automatizalasal

Az Automatio egyesiti az AI ugynokk, a web automatizalas es az okos integraciok erejet, hogy segitsen tobbet elerni kevesebb ido alatt.

Profi Tippek a(z) Open Collective Scrapeléséhez

Szakértői tanácsok a(z) Open Collective-ból történő sikeres adatkinyeréshez.

Részesítse előnyben a hivatalos GraphQL API-t a web scraping helyett a stabilabb és strukturáltabb eredmények érdekében.

A front-end scraping során használja a 'data-cy' attribútumokat a szelektorokban a weboldal frissítései során fellépő stabilitási hibák elkerülése érdekében.

Alkalmazzon 2-5 másodperc közötti véletlenszerű késleltetést az emberi böngészés szimulálásához és a rate-limiting triggerek elkerüléséhez.

Használjon rotált lakossági proxykat (residential proxies), ha nagy volumenű kereséseket kell végeznie a /discover oldalon keresztül.

Ellenőrizze a robots.txt fájlt, hogy a scraping gyakorisága tiszteletben tartsa az oldal által engedélyezett crawl-delay paramétereket.

Velemenyek

Mit mondanak a felhasznaloink

Csatlakozz tobb ezer elegedett felhasznalohoz, akik atalakitottak a munkafolyamatukat

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Kapcsolodo Web Scraping

How to Scrape Moon.ly | Step-by-Step NFT Data Extraction Guide

How to Scrape Yahoo Finance: Extract Stock Market Data

How to Scrape Rocket Mortgage: A Comprehensive Guide

How to Scrape jup.ag: Jupiter DEX Web Scraper Guide

How to Scrape Indiegogo: The Ultimate Crowdfunding Data Extraction Guide

How to Scrape ICO Drops: Comprehensive Crypto Data Guide

How to Scrape Crypto.com: Comprehensive Market Data Guide

How to Scrape Coinpaprika: Crypto Market Data Extraction Guide

Gyakran ismetelt kerdesek a Open Collective-rol

Talalj valaszokat a Open Collective-val kapcsolatos gyakori kerdesekre