Cara Melakukan Scraping Open Collective: Panduan Data Keuangan dan Kontributor

Pelajari cara melakukan scraping Open Collective untuk transaksi keuangan, daftar kontributor, dan data pendanaan proyek. Ekstrak wawasan transparan untuk...

Perlindungan Anti-Bot Terdeteksi

- Cloudflare

- WAF dan manajemen bot tingkat enterprise. Menggunakan tantangan JavaScript, CAPTCHA, dan analisis perilaku. Memerlukan otomatisasi browser dengan pengaturan stealth.

- Pembatasan kecepatan

- Membatasi permintaan per IP/sesi dari waktu ke waktu. Dapat dilewati dengan proxy berputar, penundaan permintaan, dan scraping terdistribusi.

- WAF

Tentang Open Collective

Temukan apa yang ditawarkan Open Collective dan data berharga apa yang dapat diekstrak.

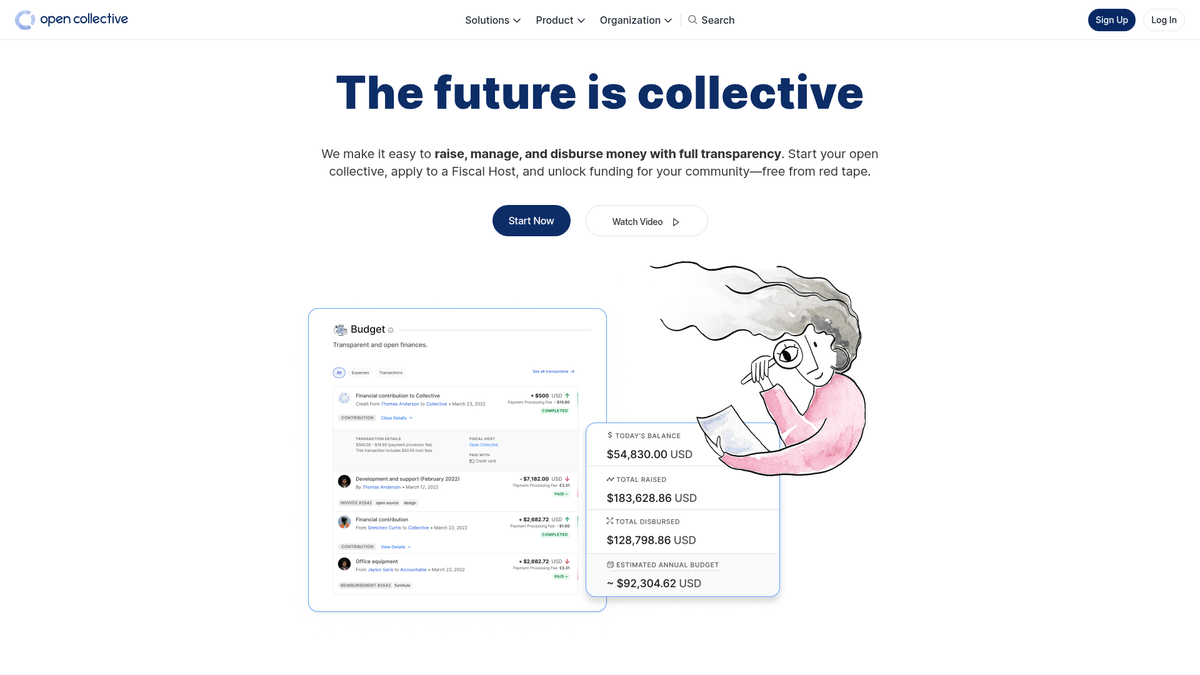

Tentang Open Collective

Open Collective adalah platform keuangan dan hukum unik yang dirancang untuk memberikan transparansi bagi organisasi berbasis komunitas, proyek perangkat lunak open-source, dan asosiasi lingkungan. Dengan bertindak sebagai alat pendanaan terdesentralisasi, platform ini memungkinkan 'kolektif' untuk mengumpulkan dana dan mengelola pengeluaran tanpa memerlukan entitas hukum formal, seringkali menggunakan fiscal hosts untuk dukungan administratif. Proyek teknologi besar seperti Babel dan Webpack mengandalkan platform ini untuk mengelola ekosistem yang didanai komunitas mereka.

Platform ini terkenal karena transparansinya yang radikal. Setiap transaksi, baik itu donasi dari perusahaan besar maupun pengeluaran kecil untuk pertemuan komunitas, dicatat dan dapat dilihat secara publik. Hal ini menyediakan kekayaan data mengenai kesehatan keuangan dan kebiasaan belanja dari beberapa dependensi open-source paling kritis di dunia.

Melakukan scraping Open Collective sangat berharga bagi organisasi yang ingin melakukan riset pasar pada ekonomi open-source. Ini memungkinkan pengguna untuk mengidentifikasi prospek sponsor korporat, melacak tren pendanaan developer, dan mengaudit keberlanjutan finansial dari proyek perangkat lunak kritis. Data tersebut berfungsi sebagai jendela langsung ke dalam aliran modal dalam komunitas developer global.

Mengapa Melakukan Scraping Open Collective?

Temukan nilai bisnis dan kasus penggunaan untuk ekstraksi data dari Open Collective.

Menganalisis keberlanjutan dependensi open-source yang kritis

Mengidentifikasi prospek sponsor korporat potensial untuk layanan B2B

Memantau tren pendanaan terdesentralisasi di berbagai tech stack

Melakukan riset akademik pada sistem keuangan peer-to-peer

Mengaudit pengeluaran kelompok nirlaba dan komunitas untuk transparansi

Melacak keterlibatan kompetitor dalam sponsor proyek komunitas

Tantangan Scraping

Tantangan teknis yang mungkin Anda hadapi saat melakukan scraping Open Collective.

Mengelola query GraphQL yang kompleks untuk ekstraksi data bersarang yang dalam

Menangani hidrasi dynamic Next.js dan navigasi infinite scroll

Melewati proteksi Cloudflare pada permintaan frekuensi tinggi

Menghadapi rate limits yang ketat baik pada API maupun endpoint web

Scrape Open Collective dengan AI

Tanpa koding. Ekstrak data dalam hitungan menit dengan otomatisasi berbasis AI.

Cara Kerjanya

Jelaskan apa yang Anda butuhkan

Beritahu AI data apa yang ingin Anda ekstrak dari Open Collective. Cukup ketik dalam bahasa sehari-hari — tanpa kode atau selektor.

AI mengekstrak data

Kecerdasan buatan kami menjelajahi Open Collective, menangani konten dinamis, dan mengekstrak persis apa yang Anda minta.

Dapatkan data Anda

Terima data bersih dan terstruktur siap diekspor sebagai CSV, JSON, atau dikirim langsung ke aplikasi Anda.

Mengapa menggunakan AI untuk scraping

AI memudahkan scraping Open Collective tanpa menulis kode. Platform berbasis kecerdasan buatan kami memahami data apa yang Anda inginkan — cukup jelaskan dalam bahasa sehari-hari dan AI akan mengekstraknya secara otomatis.

How to scrape with AI:

- Jelaskan apa yang Anda butuhkan: Beritahu AI data apa yang ingin Anda ekstrak dari Open Collective. Cukup ketik dalam bahasa sehari-hari — tanpa kode atau selektor.

- AI mengekstrak data: Kecerdasan buatan kami menjelajahi Open Collective, menangani konten dinamis, dan mengekstrak persis apa yang Anda minta.

- Dapatkan data Anda: Terima data bersih dan terstruktur siap diekspor sebagai CSV, JSON, atau dikirim langsung ke aplikasi Anda.

Why use AI for scraping:

- Ekstrak data keuangan kompleks tanpa menulis query GraphQL

- Menangani rendering JavaScript dan infinite scroll secara otomatis

- Jadwalkan eksekusi berulang untuk memantau perubahan anggaran proyek

- Lewati langkah-langkah anti-bot melalui eksekusi cloud terdistribusi

Web Scraper Tanpa Kode untuk Open Collective

Alternatif klik-dan-pilih untuk scraping berbasis AI

Beberapa alat tanpa kode seperti Browse.ai, Octoparse, Axiom, dan ParseHub dapat membantu Anda melakukan scraping Open Collective tanpa menulis kode. Alat-alat ini biasanya menggunakan antarmuka visual untuk memilih data, meskipun mungkin kesulitan dengan konten dinamis kompleks atau tindakan anti-bot.

Alur Kerja Umum dengan Alat Tanpa Kode

Tantangan Umum

Kurva pembelajaran

Memahami selector dan logika ekstraksi membutuhkan waktu

Selector rusak

Perubahan situs web dapat merusak seluruh alur kerja

Masalah konten dinamis

Situs berbasis JavaScript memerlukan solusi yang kompleks

Keterbatasan CAPTCHA

Sebagian besar alat memerlukan intervensi manual untuk CAPTCHA

Pemblokiran IP

Scraping agresif dapat menyebabkan IP Anda diblokir

Web Scraper Tanpa Kode untuk Open Collective

Beberapa alat tanpa kode seperti Browse.ai, Octoparse, Axiom, dan ParseHub dapat membantu Anda melakukan scraping Open Collective tanpa menulis kode. Alat-alat ini biasanya menggunakan antarmuka visual untuk memilih data, meskipun mungkin kesulitan dengan konten dinamis kompleks atau tindakan anti-bot.

Alur Kerja Umum dengan Alat Tanpa Kode

- Instal ekstensi browser atau daftar di platform

- Navigasi ke situs web target dan buka alat

- Pilih elemen data yang ingin diekstrak dengan point-and-click

- Konfigurasikan selector CSS untuk setiap field data

- Atur aturan paginasi untuk scraping beberapa halaman

- Tangani CAPTCHA (sering memerlukan penyelesaian manual)

- Konfigurasikan penjadwalan untuk eksekusi otomatis

- Ekspor data ke CSV, JSON atau hubungkan melalui API

Tantangan Umum

- Kurva pembelajaran: Memahami selector dan logika ekstraksi membutuhkan waktu

- Selector rusak: Perubahan situs web dapat merusak seluruh alur kerja

- Masalah konten dinamis: Situs berbasis JavaScript memerlukan solusi yang kompleks

- Keterbatasan CAPTCHA: Sebagian besar alat memerlukan intervensi manual untuk CAPTCHA

- Pemblokiran IP: Scraping agresif dapat menyebabkan IP Anda diblokir

Contoh Kode

import requests

# The Open Collective GraphQL endpoint

url = 'https://api.opencollective.com/graphql/v2'

# GraphQL query to get basic info about a collective

query = '''

query {

collective(slug: "webpack") {

name

stats {

totalAmountReceived { value }

balance { value }

}

}

}

'''

headers = {'Content-Type': 'application/json'}

try:

# Sending POST request to the API

response = requests.post(url, json={'query': query}, headers=headers)

response.raise_for_status()

data = response.json()

# Extracting and printing the name and balance

collective = data['data']['collective']

print(f"Name: {collective['name']}")

print(f"Balance: {collective['stats']['balance']['value']}")\except Exception as e:

print(f"An error occurred: {e}")Kapan Digunakan

Terbaik untuk halaman HTML statis di mana konten dimuat di sisi server. Pendekatan tercepat dan paling sederhana ketika rendering JavaScript tidak diperlukan.

Kelebihan

- ●Eksekusi tercepat (tanpa overhead browser)

- ●Konsumsi sumber daya terendah

- ●Mudah diparalelkan dengan asyncio

- ●Bagus untuk API dan halaman statis

Keterbatasan

- ●Tidak dapat mengeksekusi JavaScript

- ●Gagal pada SPA dan konten dinamis

- ●Mungkin kesulitan dengan sistem anti-bot kompleks

How to Scrape Open Collective with Code

Python + Requests

import requests

# The Open Collective GraphQL endpoint

url = 'https://api.opencollective.com/graphql/v2'

# GraphQL query to get basic info about a collective

query = '''

query {

collective(slug: "webpack") {

name

stats {

totalAmountReceived { value }

balance { value }

}

}

}

'''

headers = {'Content-Type': 'application/json'}

try:

# Sending POST request to the API

response = requests.post(url, json={'query': query}, headers=headers)

response.raise_for_status()

data = response.json()

# Extracting and printing the name and balance

collective = data['data']['collective']

print(f"Name: {collective['name']}")

print(f"Balance: {collective['stats']['balance']['value']}")\except Exception as e:

print(f"An error occurred: {e}")Python + Playwright

from playwright.sync_api import sync_playwright

def scrape_opencollective():

with sync_playwright() as p:

# Launching browser with JS support

browser = p.chromium.launch(headless=True)

page = browser.new_page()

page.goto('https://opencollective.com/discover')

# Wait for collective cards to load

page.wait_for_selector('.CollectiveCard')

# Extract data from the DOM

collectives = page.query_selector_all('.CollectiveCard')

for c in collectives:

name = c.query_selector('h2').inner_text()

print(f'Found project: {name}')

browser.close()

scrape_opencollective()Python + Scrapy

import scrapy

import json

class OpenCollectiveSpider(scrapy.Spider):

name = 'opencollective'

start_urls = ['https://opencollective.com/webpack']

def parse(self, response):

# Open Collective uses Next.js; data is often inside a script tag

next_data = response.xpath('//script[@id="__NEXT_DATA__"]/text()').get()

if next_data:

parsed_data = json.loads(next_data)

collective = parsed_data['props']['pageProps']['collective']

yield {

'name': collective.get('name'),

'balance': collective.get('stats', {}).get('balance'),

'currency': collective.get('currency')

}Node.js + Puppeteer

const puppeteer = require('puppeteer');

(async () => {

const browser = await puppeteer.launch();

const page = await browser.newPage();

await page.goto('https://opencollective.com/discover');

// Wait for the dynamic content to load

await page.waitForSelector('.CollectiveCard');

// Map over elements to extract names

const data = await page.evaluate(() => {

return Array.from(document.querySelectorAll('.CollectiveCard')).map(el => ({

name: el.querySelector('h2').innerText

}));

});

console.log(data);

await browser.close();

})();Apa yang Dapat Anda Lakukan Dengan Data Open Collective

Jelajahi aplikasi praktis dan wawasan dari data Open Collective.

Prakiraan Pertumbuhan Open Source

Identifikasi teknologi yang sedang tren dengan melacak tingkat pertumbuhan finansial dari kategori kolektif tertentu.

Cara mengimplementasikan:

- 1Ekstrak pendapatan bulanan untuk proyek-proyek teratas dalam tag tertentu

- 2Hitung tingkat pertumbuhan tahunan majemuk (CAGR)

- 3Visualisasikan kesehatan pendanaan proyek untuk memprediksi adopsi teknologi

Gunakan Automatio untuk mengekstrak data dari Open Collective dan membangun aplikasi ini tanpa menulis kode.

Apa yang Dapat Anda Lakukan Dengan Data Open Collective

- Prakiraan Pertumbuhan Open Source

Identifikasi teknologi yang sedang tren dengan melacak tingkat pertumbuhan finansial dari kategori kolektif tertentu.

- Ekstrak pendapatan bulanan untuk proyek-proyek teratas dalam tag tertentu

- Hitung tingkat pertumbuhan tahunan majemuk (CAGR)

- Visualisasikan kesehatan pendanaan proyek untuk memprediksi adopsi teknologi

- Lead Generation untuk SaaS

Identifikasi proyek dengan pendanaan baik yang mungkin membutuhkan alat pengembang, hosting, atau layanan profesional.

- Filter kolektif berdasarkan anggaran dan total jumlah yang terkumpul

- Ekstrak deskripsi proyek dan URL situs web eksternal

- Verifikasi tech stack melalui repositori GitHub yang ditautkan

- Audit Filantropi Perusahaan

Lacak di mana perusahaan besar menghabiskan anggaran kontribusi open-source mereka.

- Scrape daftar kontributor untuk proyek-proyek teratas

- Filter untuk profil organisasi vs profil individu

- Agregasikan jumlah kontribusi berdasarkan entitas korporat

- Riset Dampak Komunitas

Analisis bagaimana kelompok terdesentralisasi mendistribusikan dana mereka untuk memahami dampak sosial.

- Scrape seluruh buku besar transaksi untuk kolektif tertentu

- Kategorikan pengeluaran (perjalanan, gaji, perangkat keras)

- Hasilkan laporan alokasi sumber daya dalam grup komunitas

- Pipeline Rekrutmen Developer

Temukan pemimpin aktif dalam ekosistem tertentu berdasarkan manajemen komunitas dan riwayat kontribusi mereka.

- Scrape daftar anggota dari kolektif teknis utama

- Referensi silang kontributor dengan profil sosial publik mereka

- Identifikasi maintainer aktif untuk penjangkauan tingkat tinggi

Tingkatkan alur kerja Anda dengan Otomatisasi AI

Automatio menggabungkan kekuatan agen AI, otomatisasi web, dan integrasi cerdas untuk membantu Anda mencapai lebih banyak dalam waktu lebih singkat.

Tips Pro untuk Scraping Open Collective

Saran ahli untuk ekstraksi data yang sukses dari Open Collective.

Prioritaskan GraphQL API resmi daripada web scraping untuk hasil yang lebih stabil dan terstruktur.

Saat melakukan scraping pada front-end, gunakan atribut 'data-cy' pada selektor Anda untuk stabilitas yang lebih baik saat situs diperbarui.

Implementasikan jeda acak antara 2-5 detik untuk meniru perilaku browsing manusia dan menghindari pemicu rate-limiting.

Gunakan rotating residential proxies jika Anda perlu melakukan pencarian bervolume tinggi melalui halaman /discover.

Periksa file robots.txt untuk memastikan frekuensi scraping Anda menghormati parameter crawl-delay yang diizinkan situs.

Testimoni

Apa Kata Pengguna Kami

Bergabunglah dengan ribuan pengguna puas yang telah mengubah alur kerja mereka

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Terkait Web Scraping

How to Scrape Moon.ly | Step-by-Step NFT Data Extraction Guide

How to Scrape Yahoo Finance: Extract Stock Market Data

How to Scrape Rocket Mortgage: A Comprehensive Guide

How to Scrape jup.ag: Jupiter DEX Web Scraper Guide

How to Scrape Indiegogo: The Ultimate Crowdfunding Data Extraction Guide

How to Scrape ICO Drops: Comprehensive Crypto Data Guide

How to Scrape Crypto.com: Comprehensive Market Data Guide

How to Scrape Coinpaprika: Crypto Market Data Extraction Guide

Pertanyaan yang Sering Diajukan tentang Open Collective

Temukan jawaban untuk pertanyaan umum tentang Open Collective