Open Collectiveをスクレイピングする方法:財務および貢献者データの取得ガイド

財務取引、貢献者リスト、プロジェクト資金データのためにOpen Collectiveをスクレイピングする方法を学びましょう。市場調査に役立つ透明性の高いインサイトを抽出します。

ボット対策検出

- Cloudflare

- エンタープライズ級のWAFとボット管理。JavaScriptチャレンジ、CAPTCHA、行動分析を使用。ステルス設定でのブラウザ自動化が必要。

- レート制限

- 時間あたりのIP/セッションごとのリクエストを制限。ローテーションプロキシ、リクエスト遅延、分散スクレイピングで回避可能。

- WAF

Open Collectiveについて

Open Collectiveが提供するものと抽出可能な貴重なデータを発見してください。

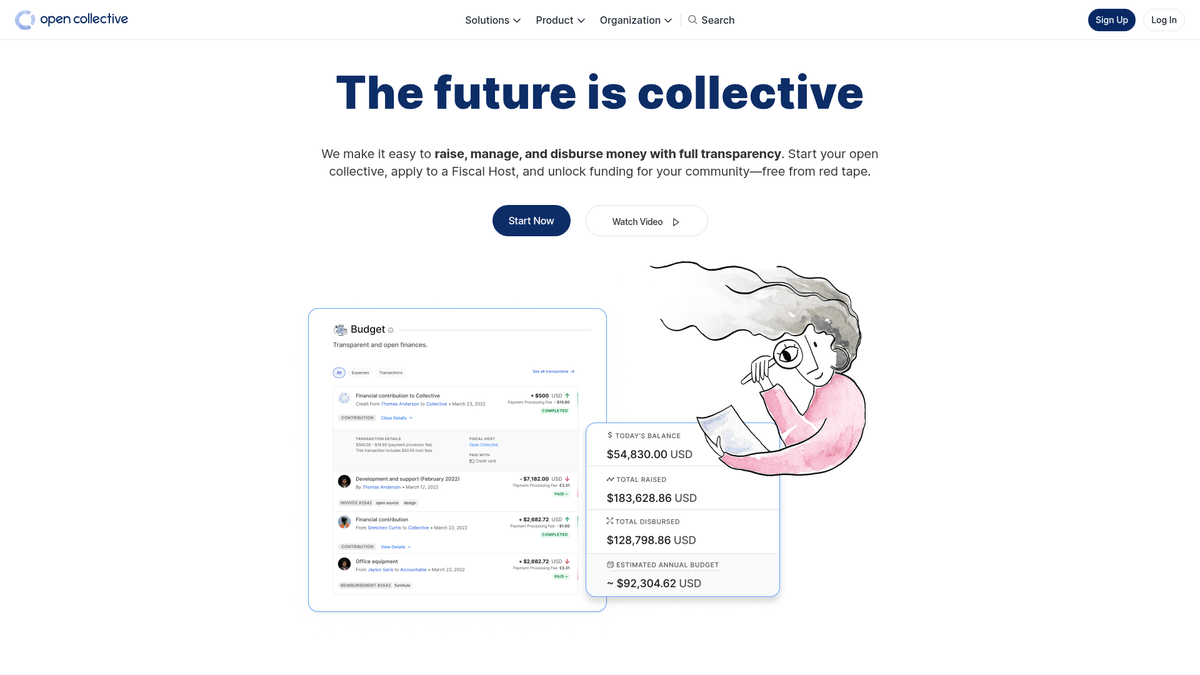

Open Collectiveについて

Open Collectiveは、コミュニティ主導の組織、オープンソースソフトウェアプロジェクト、近隣住民団体に透明性を提供するために設計された、独自の財務および法的プラットフォームです。分散型の資金調達ツールとして機能することで、正式な法人がなくても「コレクティブ(集団)」が資金を募り、支出を管理することを可能にし、多くの場合、事務サポートのために会計ホスト(fiscal hosts)を利用します。BabelやWebpackのような主要なテックプロジェクトも、コミュニティ資金によるエコシステムの管理をこのプラットフォームに依存しています。

このプラットフォームは、その徹底した透明性で知られています。大企業からの寄付であれ、コミュニティのミートアップのための少額の支出であれ、すべての取引が記録され、公開されています。これにより、世界で最も重要なオープンソースの依存関係にあるプロジェクトの財務健全性や支出傾向に関する豊富なデータが得られます。

Open Collectiveのスクレイピングは、オープンソース経済に関する市場調査を行いたい組織にとって非常に価値があります。これにより、企業のスポンサーシップのリードを特定し、開発者の資金調達トレンドを追跡し、重要なソフトウェアプロジェクトの財務的持続可能性を監査することができます。このデータは、グローバルな開発者コミュニティ内での資本の流れを直接把握するための窓口となります。

なぜOpen Collectiveをスクレイピングするのか?

Open Collectiveからのデータ抽出のビジネス価値とユースケースを発見してください。

重要なオープンソースの依存関係にあるプロジェクトの持続可能性を分析する

B2Bサービス向けの潜在的な企業スポンサーシップリードを特定する

異なる技術スタックにわたる分散型資金調達のトレンドを監視する

ピアツーピアの金融システムに関する学術研究を実施する

透明性のために非営利団体やコミュニティグループの支出を監査する

コミュニティプロジェクトのスポンサーシップにおける競合他社の関与を追跡する

スクレイピングの課題

Open Collectiveのスクレイピング時に遭遇する可能性のある技術的課題。

深くネストされたデータ抽出のための複雑なGraphQLクエリの管理

動的なNext.jsのhydrationと無限スクロールのページネーションへの対応

高頻度リクエストにおけるCloudflare保護のバイパス

APIとウェブエンドポイントの両方における厳格なrate limitsへの対処

Open CollectiveをAIでスクレイピング

コーディング不要。AI搭載の自動化で数分でデータを抽出。

仕組み

必要なものを記述

Open Collectiveから抽出したいデータをAIに伝えてください。自然言語で入力するだけ — コードやセレクターは不要です。

AIがデータを抽出

人工知能がOpen Collectiveをナビゲートし、動的コンテンツを処理し、あなたが求めたものを正確に抽出します。

データを取得

CSV、JSONでエクスポートしたり、アプリやワークフローに直接送信できる、クリーンで構造化されたデータを受け取ります。

なぜスクレイピングにAIを使うのか

AIを使えば、コードを書かずにOpen Collectiveを簡単にスクレイピングできます。人工知能搭載のプラットフォームが必要なデータを理解します — 自然言語で記述するだけで、AIが自動的に抽出します。

How to scrape with AI:

- 必要なものを記述: Open Collectiveから抽出したいデータをAIに伝えてください。自然言語で入力するだけ — コードやセレクターは不要です。

- AIがデータを抽出: 人工知能がOpen Collectiveをナビゲートし、動的コンテンツを処理し、あなたが求めたものを正確に抽出します。

- データを取得: CSV、JSONでエクスポートしたり、アプリやワークフローに直接送信できる、クリーンで構造化されたデータを受け取ります。

Why use AI for scraping:

- GraphQLクエリを書かずに複雑な財務データを抽出

- JavaScriptのレンダリングと無限スクロールを自動的に処理

- プロジェクトの予算変更を監視するための定期実行のスケジュール設定

- 分散クラウド実行によるアンチボット対策のバイパス

Open Collective用ノーコードWebスクレイパー

AI搭載スクレイピングのポイント&クリック代替手段

Browse.ai、Octoparse、Axiom、ParseHubなどのノーコードツールは、コードを書かずにOpen Collectiveをスクレイピングするのに役立ちます。これらのツールは視覚的なインターフェースを使用してデータを選択しますが、複雑な動的コンテンツやアンチボット対策には苦戦する場合があります。

ノーコードツールでの一般的なワークフロー

一般的な課題

学習曲線

セレクタと抽出ロジックの理解に時間がかかる

セレクタの破損

Webサイトの変更によりワークフロー全体が壊れる可能性がある

動的コンテンツの問題

JavaScript多用サイトは複雑な回避策が必要

CAPTCHAの制限

ほとんどのツールはCAPTCHAに手動介入が必要

IPブロック

過度なスクレイピングはIPのブロックにつながる可能性がある

Open Collective用ノーコードWebスクレイパー

Browse.ai、Octoparse、Axiom、ParseHubなどのノーコードツールは、コードを書かずにOpen Collectiveをスクレイピングするのに役立ちます。これらのツールは視覚的なインターフェースを使用してデータを選択しますが、複雑な動的コンテンツやアンチボット対策には苦戦する場合があります。

ノーコードツールでの一般的なワークフロー

- ブラウザ拡張機能をインストールするかプラットフォームに登録する

- ターゲットWebサイトに移動してツールを開く

- ポイント&クリックで抽出するデータ要素を選択する

- 各データフィールドのCSSセレクタを設定する

- 複数ページをスクレイピングするためのページネーションルールを設定する

- CAPTCHAに対処する(多くの場合手動解決が必要)

- 自動実行のスケジュールを設定する

- データをCSV、JSONにエクスポートするかAPIで接続する

一般的な課題

- 学習曲線: セレクタと抽出ロジックの理解に時間がかかる

- セレクタの破損: Webサイトの変更によりワークフロー全体が壊れる可能性がある

- 動的コンテンツの問題: JavaScript多用サイトは複雑な回避策が必要

- CAPTCHAの制限: ほとんどのツールはCAPTCHAに手動介入が必要

- IPブロック: 過度なスクレイピングはIPのブロックにつながる可能性がある

コード例

import requests

# Open CollectiveのGraphQLエンドポイント

url = 'https://api.opencollective.com/graphql/v2'

# コレクティブの基本情報を取得するためのGraphQLクエリ

query = '''

query {

collective(slug: "webpack") {

name

stats {

totalAmountReceived { value }

balance { value }

}

}

}

'''

headers = {'Content-Type': 'application/json'}

try:

# APIへPOSTリクエストを送信

response = requests.post(url, json={'query': query}, headers=headers)

response.raise_for_status()

data = response.json()

# 名前と残高を抽出して表示

collective = data['data']['collective']

print(f"Name: {collective['name']}")

print(f"Balance: {collective['stats']['balance']['value']}")

except Exception as e:

print(f"エラーが発生しました: {e}")いつ使うか

JavaScriptが最小限の静的HTMLページに最適。ブログ、ニュースサイト、シンプルなEコマース製品ページに理想的。

メリット

- ●最速の実行(ブラウザオーバーヘッドなし)

- ●最小限のリソース消費

- ●asyncioで簡単に並列化

- ●APIと静的ページに最適

制限事項

- ●JavaScriptを実行できない

- ●SPAや動的コンテンツで失敗

- ●複雑なアンチボットシステムで苦戦する可能性

コードでOpen Collectiveをスクレイピングする方法

Python + Requests

import requests

# Open CollectiveのGraphQLエンドポイント

url = 'https://api.opencollective.com/graphql/v2'

# コレクティブの基本情報を取得するためのGraphQLクエリ

query = '''

query {

collective(slug: "webpack") {

name

stats {

totalAmountReceived { value }

balance { value }

}

}

}

'''

headers = {'Content-Type': 'application/json'}

try:

# APIへPOSTリクエストを送信

response = requests.post(url, json={'query': query}, headers=headers)

response.raise_for_status()

data = response.json()

# 名前と残高を抽出して表示

collective = data['data']['collective']

print(f"Name: {collective['name']}")

print(f"Balance: {collective['stats']['balance']['value']}")

except Exception as e:

print(f"エラーが発生しました: {e}")Python + Playwright

from playwright.sync_api import sync_playwright

def scrape_opencollective():

with sync_playwright() as p:

# JSをサポートするブラウザを起動

browser = p.chromium.launch(headless=True)

page = browser.new_page()

page.goto('https://opencollective.com/discover')

# コレクティブカードがロードされるのを待機

page.wait_for_selector('.CollectiveCard')

# DOMからデータを抽出

collectives = page.query_selector_all('.CollectiveCard')

for c in collectives:

name = c.query_selector('h2').inner_text()

print(f'見つかったプロジェクト: {name}')

browser.close()

scrape_opencollective()Python + Scrapy

import scrapy

import json

class OpenCollectiveSpider(scrapy.Spider):

name = 'opencollective'

start_urls = ['https://opencollective.com/webpack']

def parse(self, response):

# Open CollectiveはNext.jsを使用しており、データはしばしばscriptタグ内にあります

next_data = response.xpath('//script[@id="__NEXT_DATA__"]/text()').get()

if next_data:

parsed_data = json.loads(next_data)

collective = parsed_data['props']['pageProps']['collective']

yield {

'name': collective.get('name'),

'balance': collective.get('stats', {}).get('balance'),

'currency': collective.get('currency')

}Node.js + Puppeteer

const puppeteer = require('puppeteer');

(async () => {

const browser = await puppeteer.launch();

const page = await browser.newPage();

await page.goto('https://opencollective.com/discover');

// 動的なコンテンツがロードされるのを待機

await page.waitForSelector('.CollectiveCard');

// 要素をループして名前を抽出

const data = await page.evaluate(() => {

return Array.from(document.querySelectorAll('.CollectiveCard')).map(el => ({

name: el.querySelector('h2').innerText

}));

});

console.log(data);

await browser.close();

})();Open Collectiveデータで何ができるか

Open Collectiveデータからの実用的なアプリケーションとインサイトを探索してください。

オープンソースの成長予測

特定のコレクティブカテゴリーの財務成長率を追跡することで、トレンドの技術を特定します。

実装方法:

- 1特定のタグに含まれるトッププロジェクトの月間収益を抽出する

- 2年平均成長率(CAGR)を算出する

- 3プロジェクトの資金状況を可視化し、技術の普及を予測する

Automatioを使用してOpen Collectiveからデータを抽出し、コードを書かずにこれらのアプリケーションを構築しましょう。

Open Collectiveデータで何ができるか

- オープンソースの成長予測

特定のコレクティブカテゴリーの財務成長率を追跡することで、トレンドの技術を特定します。

- 特定のタグに含まれるトッププロジェクトの月間収益を抽出する

- 年平均成長率(CAGR)を算出する

- プロジェクトの資金状況を可視化し、技術の普及を予測する

- SaaS向けのリードジェネレーション

開発ツール、ホスティング、または専門サービスを必要としている可能性のある、資金が豊富なプロジェクトを特定します。

- 予算と総調達額でコレクティブをフィルタリングする

- プロジェクトの説明と外部ウェブサイトのURLを抽出する

- リンクされたGitHubリポジトリを通じて技術スタックを確認する

- 企業のフィランソロピー監査

主要企業がオープンソースへの貢献予算をどこに費やしているかを追跡します。

- トッププロジェクトの貢献者リストをスクレイピングする

- 組織プロフィールと個人プロフィールをフィルタリングする

- 企業体ごとの貢献額を集計する

- コミュニティインパクト調査

分散型グループがどのように資金を分配しているかを分析し、社会的インパクトを理解します。

- 特定のコレクティブの全取引履歴をスクレイピングする

- 支出(旅費、給与、ハードウェア)をカテゴリー化する

- コミュニティグループ内のリソース配分に関するレポートを作成する

- 開発者採用パイプライン

コミュニティ管理や貢献履歴に基づき、特定のエコシステムにおけるアクティブなリーダーを見つけます。

- 主要な技術コレクティブのメンバーリストをスクレイピングする

- 貢献者と公開ソーシャルプロフィールを照合する

- 高度なアウトリーチのためにアクティブなメンテナーを特定する

ワークフローを強化する AI自動化

AutomatioはAIエージェント、ウェブ自動化、スマート統合のパワーを組み合わせ、より短時間でより多くのことを達成するお手伝いをします。

Open Collectiveスクレイピングのプロのヒント

Open Collectiveからデータを正常に抽出するための専門家のアドバイス。

より安定し、構造化された結果を得るために、Webスクレイピングよりも公式のGraphQL APIを優先してください。

フロントエンドをスクレイピングする際は、サイトの更新時の安定性を高めるため、セレクターに「data-cy」属性を使用してください。

人間によるブラウジングを模倣し、rate-limitingを回避するために、2〜5秒のランダムな遅延を実装してください。

/discover ページを通じて大量の検索を実行する必要がある場合は、ローテーションする住宅用プロキシ(residential proxies)を使用してください。

robots.txt ファイルを確認し、スクレイピングの頻度がサイトで許可されている crawl-delay パラメータを尊重していることを確認してください。

お客様の声

ユーザーの声

ワークフローを変革した何千人もの満足したユーザーに加わりましょう

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

関連 Web Scraping

How to Scrape Moon.ly | Step-by-Step NFT Data Extraction Guide

How to Scrape Yahoo Finance: Extract Stock Market Data

How to Scrape Rocket Mortgage: A Comprehensive Guide

How to Scrape jup.ag: Jupiter DEX Web Scraper Guide

How to Scrape Indiegogo: The Ultimate Crowdfunding Data Extraction Guide

How to Scrape ICO Drops: Comprehensive Crypto Data Guide

How to Scrape Crypto.com: Comprehensive Market Data Guide

How to Scrape Coinpaprika: Crypto Market Data Extraction Guide

Open Collectiveについてのよくある質問

Open Collectiveに関するよくある質問への回答を見つけてください