Hoe Hacker News te scrapen (news.ycombinator.com)

Leer hoe je Hacker News kunt scrapen om de beste tech-verhalen, vacatures en community-discussies te extraheren. Perfect voor marktonderzoek en trendanalyse.

Anti-Bot Beveiliging Gedetecteerd

- Snelheidsbeperking

- Beperkt verzoeken per IP/sessie over tijd. Kan worden omzeild met roterende proxy's, verzoekvertragingen en gedistribueerde scraping.

- IP-blokkering

- Blokkeert bekende datacenter-IP's en gemarkeerde adressen. Vereist residentiële of mobiele proxy's om effectief te omzeilen.

- User-Agent Filtering

Over Hacker News

Ontdek wat Hacker News biedt en welke waardevolle gegevens kunnen worden geëxtraheerd.

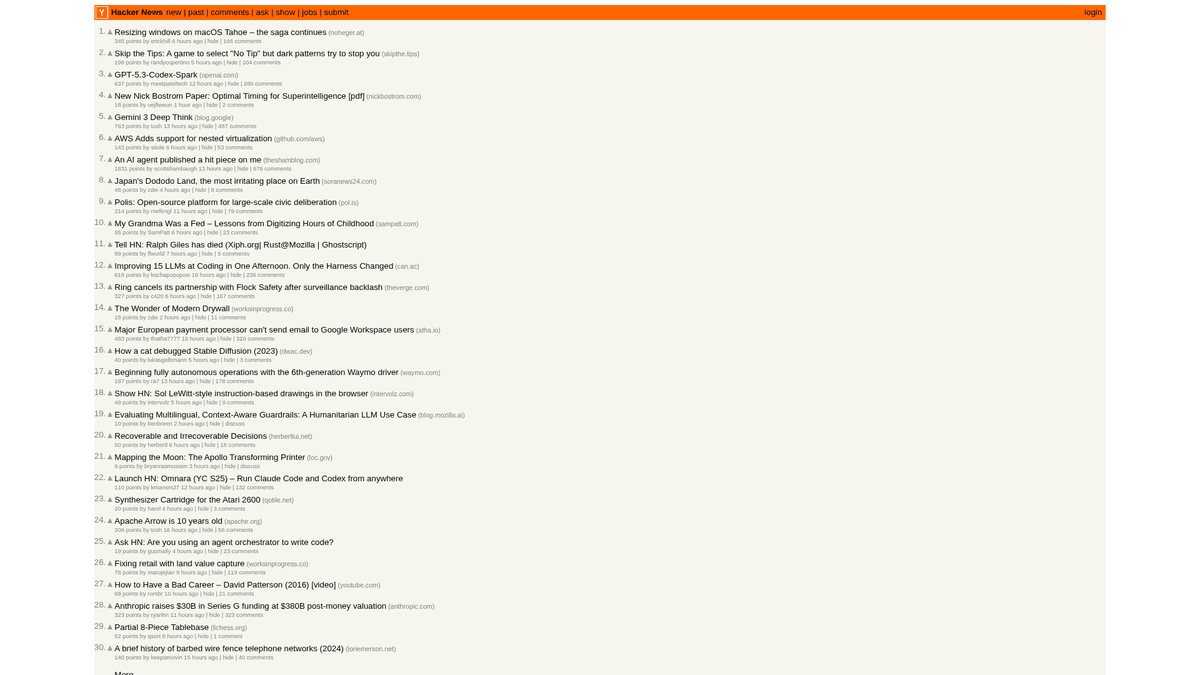

De Tech Hub

Hacker News is een sociale nieuwswebsite gericht op computerwetenschappen en ondernemerschap, beheerd door de startup-incubator Y Combinator. Het fungeert als een community-gedreven platform waar gebruikers links delen naar technische artikelen, startup-nieuws en diepgaande discussies.

Rijkdom aan data

Het platform bevat een schat aan real-time data, waaronder geüpvotede tech-verhalen, "Show HN" startup-lanceringen, "Ask HN" community-vragen en gespecialiseerde vacaturebanken. Het wordt algemeen beschouwd als de polsslag van het Silicon Valley-ecosysteem en de bredere wereldwijde developer-community.

Strategische waarde

Door deze data te scrapen, kunnen bedrijven en onderzoekers opkomende technologieën monitoren, vermeldingen van concurrenten volgen en invloedrijke thought leaders identificeren. Omdat de lay-out van de site opmerkelijk stabiel en licht is, is het een van de meest betrouwbare bronnen voor geautomatiseerde technische nieuwsaggregatie.

Waarom Hacker News Scrapen?

Ontdek de zakelijke waarde en gebruiksmogelijkheden voor data-extractie van Hacker News.

Identificeer vroegtijdig opkomende programmeertalen en developer-tools

Monitor het startup-ecosysteem voor nieuwe lanceringen en financieringsnieuws

Leadgeneratie voor technische werving door 'Who is Hiring' threads te monitoren

Sentimentanalyse op software-releases en bedrijfsaankondigingen

Bouwen van high-signal technische nieuwsaggregators voor niche-doelgroepen

Academisch onderzoek naar informatieverspreiding in technische gemeenschappen

Scraping Uitdagingen

Technische uitdagingen die u kunt tegenkomen bij het scrapen van Hacker News.

Parsen van geneste HTML-tabelstructuren gebruikt voor lay-outs

Omgaan met relatieve tijd-strings zoals '2 hours ago' voor database-opslag

Beheren van server-side rate-limits die tijdelijke IP-verboden veroorzaken

Extraheren van diepe commentaarhiërarchieën die meerdere pagina's beslaan

Scrape Hacker News met AI

Geen code nodig. Extraheer gegevens in minuten met AI-aangedreven automatisering.

Hoe het werkt

Beschrijf wat je nodig hebt

Vertel de AI welke gegevens je wilt extraheren van Hacker News. Typ het gewoon in natuurlijke taal — geen code of selectors nodig.

AI extraheert de gegevens

Onze kunstmatige intelligentie navigeert Hacker News, verwerkt dynamische content en extraheert precies wat je hebt gevraagd.

Ontvang je gegevens

Ontvang schone, gestructureerde gegevens klaar om te exporteren als CSV, JSON of direct naar je applicaties te sturen.

Waarom AI gebruiken voor scraping

AI maakt het eenvoudig om Hacker News te scrapen zonder code te schrijven. Ons AI-aangedreven platform gebruikt kunstmatige intelligentie om te begrijpen welke gegevens je wilt — beschrijf het in natuurlijke taal en de AI extraheert ze automatisch.

How to scrape with AI:

- Beschrijf wat je nodig hebt: Vertel de AI welke gegevens je wilt extraheren van Hacker News. Typ het gewoon in natuurlijke taal — geen code of selectors nodig.

- AI extraheert de gegevens: Onze kunstmatige intelligentie navigeert Hacker News, verwerkt dynamische content en extraheert precies wat je hebt gevraagd.

- Ontvang je gegevens: Ontvang schone, gestructureerde gegevens klaar om te exporteren als CSV, JSON of direct naar je applicaties te sturen.

Why use AI for scraping:

- Point-and-click selectie van verhalen zonder complexe CSS-selectors te schrijven

- Automatische afhandeling van de 'More'-knop voor naadloze paginering

- Ingebouwde cloud-uitvoering om te voorkomen dat je lokale IP wordt beperkt door rate-limiting

- Geplande scraping-runs om de voorpagina elk uur automatisch vast te leggen

- Directe export naar Google Sheets of Webhooks voor real-time meldingen

No-Code Web Scrapers voor Hacker News

Point-and-click alternatieven voor AI-aangedreven scraping

Verschillende no-code tools zoals Browse.ai, Octoparse, Axiom en ParseHub kunnen u helpen Hacker News te scrapen zonder code te schrijven. Deze tools gebruiken visuele interfaces om data te selecteren, hoewel ze moeite kunnen hebben met complexe dynamische content of anti-bot maatregelen.

Typische Workflow met No-Code Tools

Veelvoorkomende Uitdagingen

Leercurve

Het begrijpen van selectors en extractielogica kost tijd

Selectors breken

Websitewijzigingen kunnen je hele workflow kapotmaken

Problemen met dynamische content

JavaScript-zware sites vereisen complexe oplossingen

CAPTCHA-beperkingen

De meeste tools vereisen handmatige interventie voor CAPTCHAs

IP-blokkering

Agressief scrapen kan leiden tot blokkering van je IP

No-Code Web Scrapers voor Hacker News

Verschillende no-code tools zoals Browse.ai, Octoparse, Axiom en ParseHub kunnen u helpen Hacker News te scrapen zonder code te schrijven. Deze tools gebruiken visuele interfaces om data te selecteren, hoewel ze moeite kunnen hebben met complexe dynamische content of anti-bot maatregelen.

Typische Workflow met No-Code Tools

- Browserextensie installeren of registreren op het platform

- Navigeren naar de doelwebsite en de tool openen

- Data-elementen selecteren met point-and-click

- CSS-selectors configureren voor elk dataveld

- Paginatieregels instellen voor het scrapen van meerdere pagina's

- CAPTCHAs afhandelen (vereist vaak handmatige oplossing)

- Planning configureren voor automatische uitvoering

- Data exporteren naar CSV, JSON of verbinden via API

Veelvoorkomende Uitdagingen

- Leercurve: Het begrijpen van selectors en extractielogica kost tijd

- Selectors breken: Websitewijzigingen kunnen je hele workflow kapotmaken

- Problemen met dynamische content: JavaScript-zware sites vereisen complexe oplossingen

- CAPTCHA-beperkingen: De meeste tools vereisen handmatige interventie voor CAPTCHAs

- IP-blokkering: Agressief scrapen kan leiden tot blokkering van je IP

Codevoorbeelden

import requests

from bs4 import BeautifulSoup

url = 'https://news.ycombinator.com/'

headers = {'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36'}

try:

response = requests.get(url, headers=headers)

response.raise_for_status()

soup = BeautifulSoup(response.text, 'html.parser')

# Verhalen bevinden zich in rijen met de class 'athing'

posts = soup.select('.athing')

for post in posts:

title_element = post.select_one('.titleline > a')

title = title_element.text

link = title_element['href']

print(f'Title: {title}

Link: {link}

---')

except Exception as e:

print(f'Scraping mislukt: {e}')Wanneer Gebruiken

Ideaal voor statische HTML-pagina's met minimale JavaScript. Perfect voor blogs, nieuwssites en eenvoudige e-commerce productpagina's.

Voordelen

- ●Snelste uitvoering (geen browser overhead)

- ●Laagste resourceverbruik

- ●Makkelijk te paralleliseren met asyncio

- ●Uitstekend voor API's en statische pagina's

Beperkingen

- ●Kan geen JavaScript uitvoeren

- ●Faalt op SPA's en dynamische content

- ●Kan moeite hebben met complexe anti-bot systemen

Hoe Hacker News te Scrapen met Code

Python + Requests

import requests

from bs4 import BeautifulSoup

url = 'https://news.ycombinator.com/'

headers = {'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36'}

try:

response = requests.get(url, headers=headers)

response.raise_for_status()

soup = BeautifulSoup(response.text, 'html.parser')

# Verhalen bevinden zich in rijen met de class 'athing'

posts = soup.select('.athing')

for post in posts:

title_element = post.select_one('.titleline > a')

title = title_element.text

link = title_element['href']

print(f'Title: {title}

Link: {link}

---')

except Exception as e:

print(f'Scraping mislukt: {e}')Python + Playwright

from playwright.sync_api import sync_playwright

with sync_playwright() as p:

browser = p.chromium.launch(headless=True)

page = browser.new_page()

page.goto('https://news.ycombinator.com/')

# Wacht tot de tabel is geladen

page.wait_for_selector('.athing')

# Extraheer alle titels en links van de verhalen

items = page.query_selector_all('.athing')

for item in items:

title_link = item.query_selector('.titleline > a')

if title_link:

print(title_link.inner_text(), title_link.get_attribute('href'))

browser.close()Python + Scrapy

import scrapy

class HackerNewsSpider(scrapy.Spider):

name = 'hn_spider'

start_urls = ['https://news.ycombinator.com/']

def parse(self, response):

for post in response.css('.athing'):

yield {

'id': post.attrib.get('id'),

'title': post.css('.titleline > a::text').get(),

'link': post.css('.titleline > a::attr(href)').get(),

}

# Volg de pagineringslink 'More'

next_page = response.css('a.morelink::attr(href)').get()

if next_page:

yield response.follow(next_page, self.parse)Node.js + Puppeteer

const puppeteer = require('puppeteer');

(async () => {

const browser = await puppeteer.launch();

const page = await browser.newPage();

await page.goto('https://news.ycombinator.com/');

const results = await page.evaluate(() => {

const items = Array.from(document.querySelectorAll('.athing'));

return items.map(item => ({

title: item.querySelector('.titleline > a').innerText,

url: item.querySelector('.titleline > a').href

}));

});

console.log(results);

await browser.close();

})();Wat U Kunt Doen Met Hacker News Data

Verken praktische toepassingen en inzichten uit Hacker News data.

Trendontdekking voor startups

Identificeer welke sectoren of producttypen het vaakst worden gelanceerd en besproken.

Hoe te implementeren:

- 1Scrape wekelijks de 'Show HN'-categorie.

- 2Schoon startup-beschrijvingen op en categoriseer ze met behulp van NLP.

- 3Rangschik trends op basis van community upvotes en het sentiment van reacties.

Gebruik Automatio om data van Hacker News te extraheren en deze applicaties te bouwen zonder code te schrijven.

Wat U Kunt Doen Met Hacker News Data

- Trendontdekking voor startups

Identificeer welke sectoren of producttypen het vaakst worden gelanceerd en besproken.

- Scrape wekelijks de 'Show HN'-categorie.

- Schoon startup-beschrijvingen op en categoriseer ze met behulp van NLP.

- Rangschik trends op basis van community upvotes en het sentiment van reacties.

- Tech-sourcing & Recruitment

Extraheer vacatures en bedrijfsgegevens uit gespecialiseerde maandelijkse hiring threads.

- Monitor de maandelijkse 'Who is hiring' thread ID.

- Scrape alle top-level reacties die functiebeschrijvingen bevatten.

- Parse de tekst voor specifieke tech stacks zoals Rust, AI of React.

- Concurrentieanalyse

Volg vermeldingen van concurrenten in reacties om de publieke opinie en klachten te begrijpen.

- Stel een op trefwoorden gebaseerde scraper in voor specifieke merknamen.

- Extraheer gebruikersreacties en timestamps voor sentimentanalyse.

- Genereer wekelijkse rapporten over de merkgezondheid ten opzichte van concurrenten.

- Geautomatiseerde content-curatie

Maak een high-signal tech-nieuwsbrief die alleen de meest relevante verhalen bevat.

- Scrape de voorpagina elke 6 uur.

- Filter op posts met meer dan 200 punten.

- Automatiseer de levering van deze links naar een Telegram-bot of e-maillijst.

- Venture Capital Lead Gen

Ontdek vroege-fase startups die aanzienlijke tractie krijgen binnen de community.

- Volg 'Show HN'-posts die de voorpagina bereiken.

- Monitor de groeisnelheid van upvotes gedurende de eerste 4 uur.

- Stel analisten op de hoogte wanneer een post virale groeipatronen vertoont.

Supercharge je workflow met AI-automatisering

Automatio combineert de kracht van AI-agents, webautomatisering en slimme integraties om je te helpen meer te bereiken in minder tijd.

Pro Tips voor het Scrapen van Hacker News

Expertadvies voor het succesvol extraheren van gegevens uit Hacker News.

Gebruik de officiële Firebase API voor het verzamelen van massale historische data om de complexiteit van HTML-parsing te vermijden.

Stel altijd een aangepaste User-Agent in om je bot op een verantwoordelijke manier te identificeren en onmiddellijke blokkades te voorkomen.

Implementeer een willekeurig sleep interval van 3-7 seconden tussen verzoeken om menselijk browsegedrag na te bootsen.

Richt je op specifieke subdirectories zoals /newest voor de nieuwste verhalen of /ask voor community-discussies.

Sla de 'Item ID' op als primaire sleutel om dubbele records te voorkomen bij het frequent scrapen van de voorpagina.

Scrape tijdens daluren (UTC-nacht) voor snellere responstijden en een lager risico op rate-limiting.

Testimonials

Wat onze gebruikers zeggen

Sluit je aan bij duizenden tevreden gebruikers die hun workflow hebben getransformeerd

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Gerelateerd Web Scraping

Veelgestelde vragen over Hacker News

Vind antwoorden op veelvoorkomende vragen over Hacker News