Hoe Seeking Alpha te scrapen: Financiële data & transcripts

Leer hoe u Seeking Alpha kunt scrapen voor aandelennieuws, analistenratings en earnings transcripts. Leer hoe u Cloudflare omzeilt en automatisch financiële...

Anti-Bot Beveiliging Gedetecteerd

- Cloudflare

- Enterprise WAF en botbeheer. Gebruikt JavaScript-uitdagingen, CAPTCHAs en gedragsanalyse. Vereist browserautomatisering met stealth-instellingen.

- DataDome

- Realtime botdetectie met ML-modellen. Analyseert apparaatfingerprint, netwerksignalen en gedragspatronen. Veel voorkomend op e-commercesites.

- Google reCAPTCHA

- Googles CAPTCHA-systeem. v2 vereist gebruikersinteractie, v3 draait onzichtbaar met risicoscore. Kan worden opgelost met CAPTCHA-diensten.

- Snelheidsbeperking

- Beperkt verzoeken per IP/sessie over tijd. Kan worden omzeild met roterende proxy's, verzoekvertragingen en gedistribueerde scraping.

- IP-blokkering

- Blokkeert bekende datacenter-IP's en gemarkeerde adressen. Vereist residentiële of mobiele proxy's om effectief te omzeilen.

Over Seeking Alpha

Ontdek wat Seeking Alpha biedt en welke waardevolle gegevens kunnen worden geëxtraheerd.

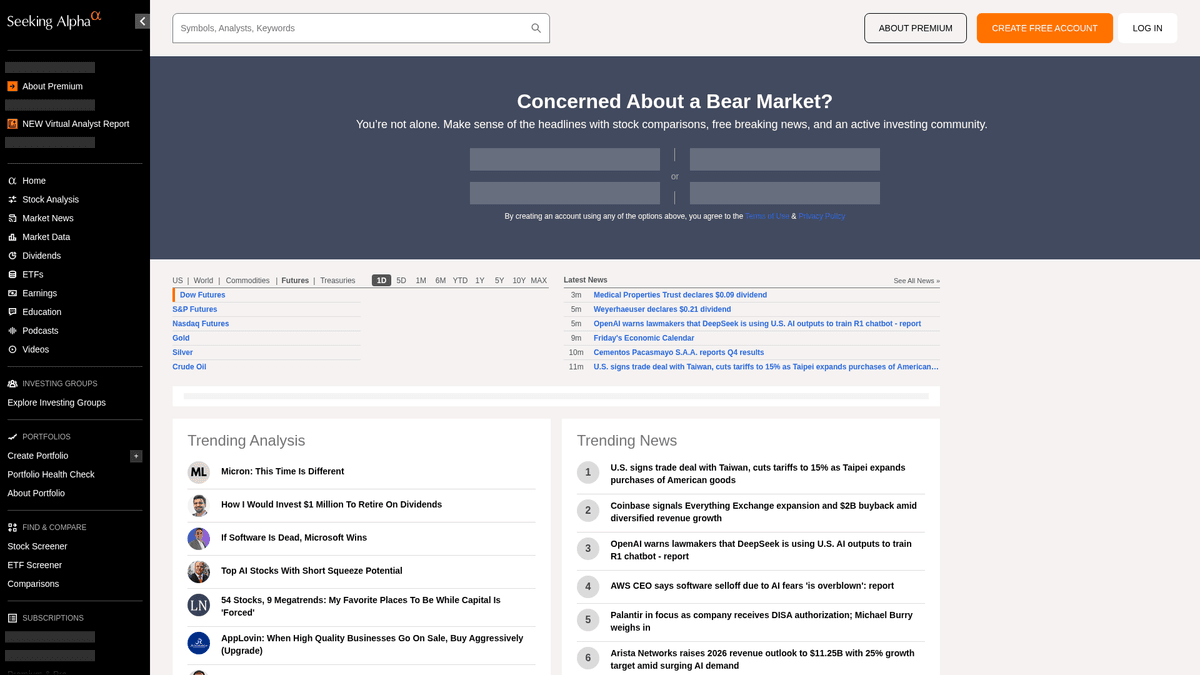

De toonaangevende hub voor financiële intelligentie

Seeking Alpha is een toonaangevend crowd-sourced financieel onderzoeksplatform dat dient als een vitale brug tussen ruwe marktgegevens en bruikbare beleggingsinzichten. Het biedt een uitgebreide bibliotheek met analyse-artikelen, realtime marktnieuws en de meest uitgebreide verzameling van earnings call transcripts op internet voor duizenden beursgenoteerde bedrijven.

Divers data-ecosysteem

Het platform biedt een schat aan gestructureerde en ongestructureerde data, waaronder aandelentips, dividendgeschiedenis en de eigen marktverslaande Quant-ratings. De inhoud wordt beheerd door een professioneel redactieteam en wordt gegenereerd door duizenden onafhankelijke analisten wiens bijdragen aan hoge kwaliteits- en compliancestandaarden moeten voldoen voordat ze worden gepubliceerd.

Strategische waarde voor data-extractie

Het scrapen van Seeking Alpha is essentieel voor financieel analisten en kwantitatieve traders die sentimentanalyse uitvoeren, historische winsttrends volgen en nieuws over specifieke tickers monitoren. De data biedt granulaire inzichten in de marktpsychologie en bedrijfsprestaties die kunnen worden gebruikt om geavanceerde financiële modellen te bouwen en concurrentieonderzoek te doen.

Waarom Seeking Alpha Scrapen?

Ontdek de zakelijke waarde en gebruiksmogelijkheden voor data-extractie van Seeking Alpha.

Het bouwen van kwantitatieve sentimentanalyse-engines voor algoritmische handel

Het verzamelen van earnings call transcripts voor op LLM gebaseerd financieel onderzoek

Het monitoren van dividendwijzigingen en payout-ratio's voor inkomstenportfolio's

Het volgen van prestaties van analisten en ratingverschuivingen in specifieke sectoren

Het ontwikkelen van realtime marktnieuws-dashboards voor institutionele klanten

Het uitvoeren van historische concurrentieanalyses op bedrijfsvooruitzichten versus resultaten

Scraping Uitdagingen

Technische uitdagingen die u kunt tegenkomen bij het scrapen van Seeking Alpha.

Agressieve anti-bot detectie met Cloudflare en DataDome perimeterbeveiliging

Login-vereisten voor toegang tot de volledige tekst van earnings call transcripts

Dynamische datalading via AJAX/XHR die volledige browser-rendering vereist

Geavanceerde rate limiting die persistente IP-blokkades veroorzaakt bij hoogfrequente verzoeken

Complexe HTML-structuren met frequent veranderende CSS-selectors

Scrape Seeking Alpha met AI

Geen code nodig. Extraheer gegevens in minuten met AI-aangedreven automatisering.

Hoe het werkt

Beschrijf wat je nodig hebt

Vertel de AI welke gegevens je wilt extraheren van Seeking Alpha. Typ het gewoon in natuurlijke taal — geen code of selectors nodig.

AI extraheert de gegevens

Onze kunstmatige intelligentie navigeert Seeking Alpha, verwerkt dynamische content en extraheert precies wat je hebt gevraagd.

Ontvang je gegevens

Ontvang schone, gestructureerde gegevens klaar om te exporteren als CSV, JSON of direct naar je applicaties te sturen.

Waarom AI gebruiken voor scraping

AI maakt het eenvoudig om Seeking Alpha te scrapen zonder code te schrijven. Ons AI-aangedreven platform gebruikt kunstmatige intelligentie om te begrijpen welke gegevens je wilt — beschrijf het in natuurlijke taal en de AI extraheert ze automatisch.

How to scrape with AI:

- Beschrijf wat je nodig hebt: Vertel de AI welke gegevens je wilt extraheren van Seeking Alpha. Typ het gewoon in natuurlijke taal — geen code of selectors nodig.

- AI extraheert de gegevens: Onze kunstmatige intelligentie navigeert Seeking Alpha, verwerkt dynamische content en extraheert precies wat je hebt gevraagd.

- Ontvang je gegevens: Ontvang schone, gestructureerde gegevens klaar om te exporteren als CSV, JSON of direct naar je applicaties te sturen.

Why use AI for scraping:

- No-code omgeving elimineert de noodzaak voor het beheren van complexe browser automatisering-libraries

- Ingebouwde capaciteit om JavaScript-zware sites en dynamische content-loading te verwerken

- Cloud-uitvoering maakt geplande dataverzameling van groot volume mogelijk zonder lokale middelen

- Automatische afhandeling van standaard anti-bot detectiepatronen en browser fingerprinting

No-Code Web Scrapers voor Seeking Alpha

Point-and-click alternatieven voor AI-aangedreven scraping

Verschillende no-code tools zoals Browse.ai, Octoparse, Axiom en ParseHub kunnen u helpen Seeking Alpha te scrapen zonder code te schrijven. Deze tools gebruiken visuele interfaces om data te selecteren, hoewel ze moeite kunnen hebben met complexe dynamische content of anti-bot maatregelen.

Typische Workflow met No-Code Tools

Veelvoorkomende Uitdagingen

Leercurve

Het begrijpen van selectors en extractielogica kost tijd

Selectors breken

Websitewijzigingen kunnen je hele workflow kapotmaken

Problemen met dynamische content

JavaScript-zware sites vereisen complexe oplossingen

CAPTCHA-beperkingen

De meeste tools vereisen handmatige interventie voor CAPTCHAs

IP-blokkering

Agressief scrapen kan leiden tot blokkering van je IP

No-Code Web Scrapers voor Seeking Alpha

Verschillende no-code tools zoals Browse.ai, Octoparse, Axiom en ParseHub kunnen u helpen Seeking Alpha te scrapen zonder code te schrijven. Deze tools gebruiken visuele interfaces om data te selecteren, hoewel ze moeite kunnen hebben met complexe dynamische content of anti-bot maatregelen.

Typische Workflow met No-Code Tools

- Browserextensie installeren of registreren op het platform

- Navigeren naar de doelwebsite en de tool openen

- Data-elementen selecteren met point-and-click

- CSS-selectors configureren voor elk dataveld

- Paginatieregels instellen voor het scrapen van meerdere pagina's

- CAPTCHAs afhandelen (vereist vaak handmatige oplossing)

- Planning configureren voor automatische uitvoering

- Data exporteren naar CSV, JSON of verbinden via API

Veelvoorkomende Uitdagingen

- Leercurve: Het begrijpen van selectors en extractielogica kost tijd

- Selectors breken: Websitewijzigingen kunnen je hele workflow kapotmaken

- Problemen met dynamische content: JavaScript-zware sites vereisen complexe oplossingen

- CAPTCHA-beperkingen: De meeste tools vereisen handmatige interventie voor CAPTCHAs

- IP-blokkering: Agressief scrapen kan leiden tot blokkering van je IP

Codevoorbeelden

import requests

from bs4 import BeautifulSoup

# URL voor het laatste marktnieuws

url = 'https://seekingalpha.com/market-news'

# Standaard browser headers om menselijk gedrag na te bootsen

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/120.0.0.0 Safari/537.36',

'Accept-Language': 'en-US,en;q=0.9',

'Referer': 'https://seekingalpha.com/'

}

def scrape_sa_news():

try:

response = requests.get(url, headers=headers, timeout=10)

if response.status_code == 200:

soup = BeautifulSoup(response.text, 'html.parser')

# Extraheer koppen met behulp van data-test-id attributen

headlines = soup.find_all('a', {'data-test-id': 'post-list-item-title'})

for item in headlines:

print(f'Nieuwstitel: {item.text.strip()}')

else:

print(f'Geblokkeerd met status: {response.status_code}')

except Exception as e:

print(f'Fout opgetreden: {e}')

if __name__ == "__main__":

scrape_sa_news()Wanneer Gebruiken

Ideaal voor statische HTML-pagina's met minimale JavaScript. Perfect voor blogs, nieuwssites en eenvoudige e-commerce productpagina's.

Voordelen

- ●Snelste uitvoering (geen browser overhead)

- ●Laagste resourceverbruik

- ●Makkelijk te paralleliseren met asyncio

- ●Uitstekend voor API's en statische pagina's

Beperkingen

- ●Kan geen JavaScript uitvoeren

- ●Faalt op SPA's en dynamische content

- ●Kan moeite hebben met complexe anti-bot systemen

Hoe Seeking Alpha te Scrapen met Code

Python + Requests

import requests

from bs4 import BeautifulSoup

# URL voor het laatste marktnieuws

url = 'https://seekingalpha.com/market-news'

# Standaard browser headers om menselijk gedrag na te bootsen

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/120.0.0.0 Safari/537.36',

'Accept-Language': 'en-US,en;q=0.9',

'Referer': 'https://seekingalpha.com/'

}

def scrape_sa_news():

try:

response = requests.get(url, headers=headers, timeout=10)

if response.status_code == 200:

soup = BeautifulSoup(response.text, 'html.parser')

# Extraheer koppen met behulp van data-test-id attributen

headlines = soup.find_all('a', {'data-test-id': 'post-list-item-title'})

for item in headlines:

print(f'Nieuwstitel: {item.text.strip()}')

else:

print(f'Geblokkeerd met status: {response.status_code}')

except Exception as e:

print(f'Fout opgetreden: {e}')

if __name__ == "__main__":

scrape_sa_news()Python + Playwright

from playwright.sync_api import sync_playwright

def run(playwright):

# Start een Chromium browser

browser = playwright.chromium.launch(headless=True)

context = browser.new_context(

user_agent='Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/120.0.0.0 Safari/537.36'

)

page = context.new_page()

try:

# Navigeer naar een specifieke aandelensymboolpagina

page.goto('https://seekingalpha.com/symbol/AAPL/transcripts')

# Wacht tot de hoofdinhoud dynamisch gerenderd is

page.wait_for_selector('article', timeout=15000)

# Lokaliseer en extraheer transcript-titels

titles = page.locator('h3').all_inner_texts()

for title in titles:

print(f'Transcript gevonden: {title}')

except Exception as e:

print(f'Extractie mislukt: {e}')

finally:

browser.close()

with sync_playwright() as playwright:

run(playwright)Python + Scrapy

import scrapy

class SeekingAlphaSpider(scrapy.Spider):

name = 'sa_spider'

allowed_domains = ['seekingalpha.com']

start_urls = ['https://seekingalpha.com/latest-articles']

custom_settings = {

'DOWNLOAD_DELAY': 8,

'USER_AGENT': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) Chrome/120.0.0.0',

'ROBOTSTXT_OBEY': False,

'COOKIES_ENABLED': True

}

def parse(self, response):

for article in response.css('article'):

yield {

'title': article.css('h3 a::text').get(),

'link': response.urljoin(article.css('h3 a::attr(href)').get()),

'author': article.css('span[data-test-id="author-name"]::text').get()

}

# Verwerk eenvoudige paginering via 'next' links

next_page = response.css('a.next_page::attr(href)').get()

if next_page:

yield response.follow(next_page, self.parse)Node.js + Puppeteer

const puppeteer = require('puppeteer');

(async () => {

const browser = await puppeteer.launch({ headless: true });

const page = await browser.newPage();

// Stel hoogwaardige User-Agent in

await page.setUserAgent('Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/120.0.0.0 Safari/537.36');

try {

// Navigeer naar Seeking Alpha homepage

await page.goto('https://seekingalpha.com/', { waitUntil: 'networkidle2' });

// Evalueer scripts in de browsercontext om titels te extraheren

const trending = await page.evaluate(() => {

const nodes = Array.from(document.querySelectorAll('h3'));

return nodes.map(n => n.innerText.trim());

});

console.log('Trending Content:', trending);

} catch (err) {

console.error('Puppeteer heeft een fout aangetroffen:', err);

} finally {

await browser.close();

}

})();Wat U Kunt Doen Met Seeking Alpha Data

Verken praktische toepassingen en inzichten uit Seeking Alpha data.

Kwantitatieve sentimentanalyse

Financiële instellingen gebruiken artikelen van analisten om het marktsentiment voor specifieke aandelensectoren te bepalen.

Hoe te implementeren:

- 1Extraheer alle analyse-artikelen voor een specifieke aandelenticker.

- 2Verwerk de inhoud via een NLP-engine om de sentimentpolariteit te berekenen.

- 3Integreer sentimentscores in bestaande trading-algoritmes.

- 4Trigger automatische koop/verkoop-alerts op basis van sentimentverschuivingen.

Gebruik Automatio om data van Seeking Alpha te extraheren en deze applicaties te bouwen zonder code te schrijven.

Wat U Kunt Doen Met Seeking Alpha Data

- Kwantitatieve sentimentanalyse

Financiële instellingen gebruiken artikelen van analisten om het marktsentiment voor specifieke aandelensectoren te bepalen.

- Extraheer alle analyse-artikelen voor een specifieke aandelenticker.

- Verwerk de inhoud via een NLP-engine om de sentimentpolariteit te berekenen.

- Integreer sentimentscores in bestaande trading-algoritmes.

- Trigger automatische koop/verkoop-alerts op basis van sentimentverschuivingen.

- Extractie van winstinzichten

Extraheer kritieke bedrijfsvooruitzichten direct uit earnings transcripts voor snelle rapportage.

- Automatiseer een dagelijkse scrape van de sectie Earnings Transcripts.

- Zoek naar specifieke financiële trefwoorden zoals 'EBITDA' of 'Outlook'.

- Isoleer de zinnen die management guidance-metrieken bevatten.

- Exporteer de bevindingen naar een gestructureerde CSV voor beoordeling door het investeringscomité.

- Dividendrendement Benchmarking

Vergelijk dividendprestaties van duizenden aandelen om rendementskansen te vinden.

- Scrape dividendgeschiedenis en payout-ratio's voor een gedefinieerde lijst met aandelen.

- Bereken het gemiddelde rendement versus historische trends met behulp van gescrapete data.

- Identificeer aandelen die onlangs hun uitkering hebben verhoogd.

- Update een privé-dashboard met realtime rendementsvergelijkingen.

- Tracking van analistenprestaties

Identificeer auteurs met een hoge nauwkeurigheid om te volgen voor betere investeringsideeën.

- Scrape historische beoordelingen en artikelen van top-analisten.

- Koppel publicatiedatums van artikelen aan de prestaties van de aandelenkoers.

- Rangschik auteurs op basis van de nauwkeurigheid van hun 'Buy'- of 'Sell'-aanbevelingen.

- Verstuur automatische meldingen wanneer hooggeplaatste auteurs nieuwe ideeën posten.

Supercharge je workflow met AI-automatisering

Automatio combineert de kracht van AI-agents, webautomatisering en slimme integraties om je te helpen meer te bereiken in minder tijd.

Pro Tips voor het Scrapen van Seeking Alpha

Expertadvies voor het succesvol extraheren van gegevens uit Seeking Alpha.

Gebruik premium residential proxies om de Cloudflare/DataDome-beveiliging effectief te omzeilen.

Roteer je User-Agent strings en behoud consistente browser fingerprints binnen een sessie.

Implementeer gerandomiseerde wachttijden tussen 10 en 30 seconden om menselijk browsegedrag na te bootsen.

Scrape tijdens beurssluiting of in het weekend om de kans op rate limits bij druk verkeer te verkleinen.

Bekijk het 'Network'-tabblad in DevTools voor interne JSON API-endpoints (v3/api) voor schonere data.

Bewaar persistente sessie-cookies als je data achter een login-wall moet scrapen.

Testimonials

Wat onze gebruikers zeggen

Sluit je aan bij duizenden tevreden gebruikers die hun workflow hebben getransformeerd

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Gerelateerd Web Scraping

How to Scrape Yahoo Finance: Extract Stock Market Data

How to Scrape Moon.ly | Step-by-Step NFT Data Extraction Guide

How to Scrape Rocket Mortgage: A Comprehensive Guide

How to Scrape Open Collective: Financial and Contributor Data Guide

How to Scrape jup.ag: Jupiter DEX Web Scraper Guide

How to Scrape Indiegogo: The Ultimate Crowdfunding Data Extraction Guide

How to Scrape ICO Drops: Comprehensive Crypto Data Guide

How to Scrape Crypto.com: Comprehensive Market Data Guide

Veelgestelde vragen over Seeking Alpha

Vind antwoorden op veelvoorkomende vragen over Seeking Alpha