Jak scrapować Hacker News (news.ycombinator.com)

Dowiedz się, jak scrapować Hacker News, aby wyodrębniać topowe newsy technologiczne, oferty pracy i dyskusje społeczności. Idealne do badań rynkowych i analizy...

Wykryto ochronę przed botami

- Ograniczanie szybkości

- Ogranicza liczbę żądań na IP/sesję w czasie. Można obejść za pomocą rotacyjnych proxy, opóźnień żądań i rozproszonego scrapingu.

- Blokowanie IP

- Blokuje znane IP centrów danych i oznaczone adresy. Wymaga rezydencjalnych lub mobilnych proxy do skutecznego obejścia.

- User-Agent Filtering

O Hacker News

Odkryj, co oferuje Hacker News i jakie cenne dane można wyodrębnić.

Centrum Technologii

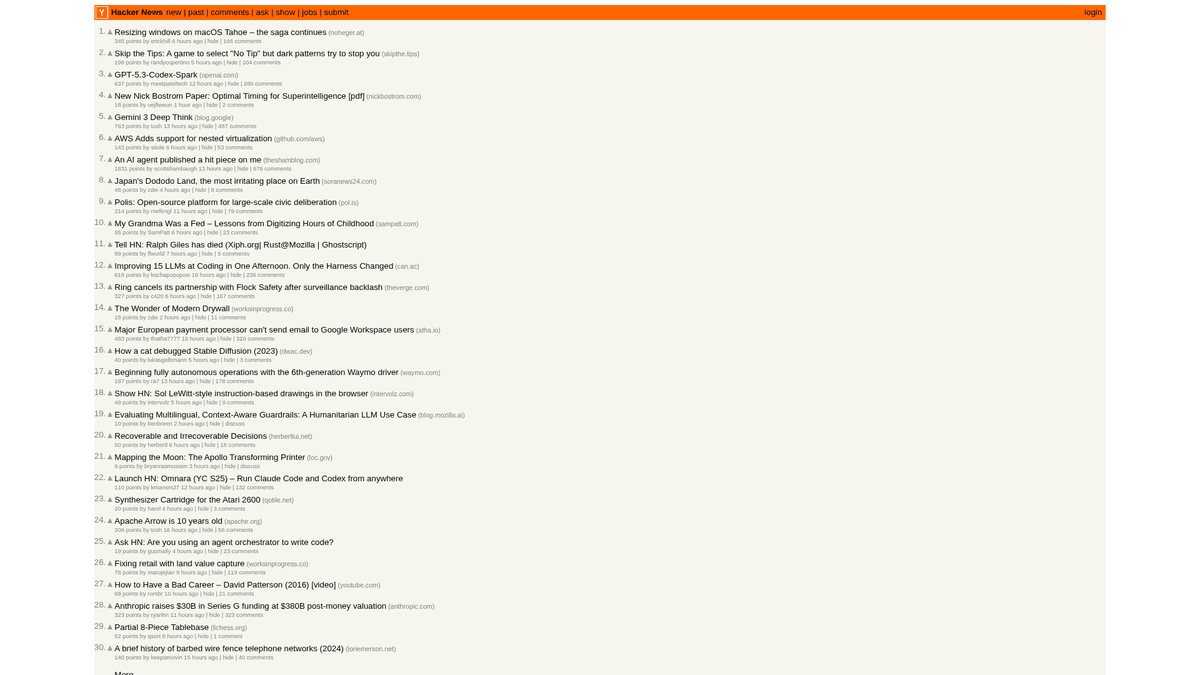

Hacker News to serwis społecznościowy skupiony na informatyce i przedsiębiorczości, prowadzony przez inkubator startupów Y Combinator. Funkcjonuje jako platforma napędzana przez społeczność, gdzie użytkownicy przesyłają linki do artykułów technicznych, wiadomości o startupach i pogłębionych dyskusji.

Bogactwo Danych

Platforma zawiera mnóstwo danych w czasie rzeczywistym, w tym najpopularniejsze historie technologiczne, premiery startupów w sekcji „Show HN”, pytania społeczności „Ask HN” oraz wyspecjalizowane tablice ogłoszeń o pracy. Jest powszechnie uważana za puls ekosystemu Doliny Krzemowej i globalnej społeczności programistów.

Wartość Strategiczna

Scrapowanie tych danych pozwala firmom i badaczom monitorować emerging technologies, śledzić wzmianki o konkurencji i identyfikować wpływowych liderów opinii. Ponieważ układ strony jest niezwykle stabilny i lekki, jest to jedno z najbardziej niezawodnych źródeł do zautomatyzowanej agregacji wiadomości technicznych.

Dlaczego Scrapować Hacker News?

Odkryj wartość biznesową i przypadki użycia ekstrakcji danych z Hacker News.

Wczesne identyfikowanie wschodzących języków programowania i narzędzi deweloperskich

Monitorowanie ekosystemu startupów pod kątem nowych premier i informacji o finansowaniu

Pozyskiwanie leadów do rekrutacji technicznej poprzez monitorowanie wątków 'Who is Hiring'

Analiza sentymentu dotycząca wydań oprogramowania i ogłoszeń korporacyjnych

Budowanie agregatorów nowinek technicznych o wysokiej jakości dla niszowych odbiorców

Badania akademickie nad propagacją informacji w społecznościach technicznych

Wyzwania Scrapowania

Wyzwania techniczne, które możesz napotkać podczas scrapowania Hacker News.

Parsowanie zagnieżdżonych struktur tabel HTML używanych do układu strony

Obsługa relatywnych znaczników czasu, takich jak '2 hours ago', na potrzeby bazy danych

Zarządzanie rate limits po stronie serwera, które wyzwalają tymczasowe blokady IP

Wyodrębnianie głębokich hierarchii komentarzy rozciągających się na wiele stron

Scrapuj Hacker News z AI

Bez kodowania. Wyodrębnij dane w kilka minut dzięki automatyzacji opartej na AI.

Jak to działa

Opisz, czego potrzebujesz

Powiedz AI, jakie dane chcesz wyodrębnić z Hacker News. Po prostu wpisz to w języku naturalnym — bez kodu czy selektorów.

AI wyodrębnia dane

Nasza sztuczna inteligencja nawiguje po Hacker News, obsługuje dynamiczną treść i wyodrębnia dokładnie to, o co prosiłeś.

Otrzymaj swoje dane

Otrzymaj czyste, ustrukturyzowane dane gotowe do eksportu jako CSV, JSON lub do bezpośredniego przesłania do twoich aplikacji.

Dlaczego warto używać AI do scrapowania

AI ułatwia scrapowanie Hacker News bez pisania kodu. Nasza platforma oparta na sztucznej inteligencji rozumie, jakich danych potrzebujesz — po prostu opisz je w języku naturalnym, a AI wyodrębni je automatycznie.

How to scrape with AI:

- Opisz, czego potrzebujesz: Powiedz AI, jakie dane chcesz wyodrębnić z Hacker News. Po prostu wpisz to w języku naturalnym — bez kodu czy selektorów.

- AI wyodrębnia dane: Nasza sztuczna inteligencja nawiguje po Hacker News, obsługuje dynamiczną treść i wyodrębnia dokładnie to, o co prosiłeś.

- Otrzymaj swoje dane: Otrzymaj czyste, ustrukturyzowane dane gotowe do eksportu jako CSV, JSON lub do bezpośredniego przesłania do twoich aplikacji.

Why use AI for scraping:

- Wybieranie artykułów metodą point-and-click bez pisania złożonych selektorów CSS

- Automatyczna obsługa przycisku 'More' dla płynnej paginacji

- Wbudowana egzekucja w chmurze, aby zapobiec blokowaniu Twojego lokalnego IP przez rate-limited

- Harmonogram scrapowania pozwalający na automatyczne pobieranie danych ze strony głównej co godzinę

- Bezpośredni eksport do Google Sheets lub Webhooks dla alertów w czasie rzeczywistym

Scrapery No-Code dla Hacker News

Alternatywy point-and-click dla scrapingu opartego na AI

Różne narzędzia no-code jak Browse.ai, Octoparse, Axiom i ParseHub mogą pomóc w scrapowaniu Hacker News bez pisania kodu. Te narzędzia używają wizualnych interfejsów do wyboru danych, choć mogą mieć problemy ze złożoną dynamiczną zawartością lub zabezpieczeniami anti-bot.

Typowy Workflow z Narzędziami No-Code

Częste Wyzwania

Krzywa uczenia

Zrozumienie selektorów i logiki ekstrakcji wymaga czasu

Selektory się psują

Zmiany na stronie mogą zepsuć cały przepływ pracy

Problemy z dynamiczną treścią

Strony bogate w JavaScript wymagają złożonych obejść

Ograniczenia CAPTCHA

Większość narzędzi wymaga ręcznej interwencji przy CAPTCHA

Blokowanie IP

Agresywne scrapowanie może prowadzić do zablokowania IP

Scrapery No-Code dla Hacker News

Różne narzędzia no-code jak Browse.ai, Octoparse, Axiom i ParseHub mogą pomóc w scrapowaniu Hacker News bez pisania kodu. Te narzędzia używają wizualnych interfejsów do wyboru danych, choć mogą mieć problemy ze złożoną dynamiczną zawartością lub zabezpieczeniami anti-bot.

Typowy Workflow z Narzędziami No-Code

- Zainstaluj rozszerzenie przeglądarki lub zarejestruj się na platformie

- Przejdź do docelowej strony i otwórz narzędzie

- Wybierz elementy danych do wyodrębnienia metodą point-and-click

- Skonfiguruj selektory CSS dla każdego pola danych

- Ustaw reguły paginacji do scrapowania wielu stron

- Obsłuż CAPTCHA (często wymaga ręcznego rozwiązywania)

- Skonfiguruj harmonogram automatycznych uruchomień

- Eksportuj dane do CSV, JSON lub połącz przez API

Częste Wyzwania

- Krzywa uczenia: Zrozumienie selektorów i logiki ekstrakcji wymaga czasu

- Selektory się psują: Zmiany na stronie mogą zepsuć cały przepływ pracy

- Problemy z dynamiczną treścią: Strony bogate w JavaScript wymagają złożonych obejść

- Ograniczenia CAPTCHA: Większość narzędzi wymaga ręcznej interwencji przy CAPTCHA

- Blokowanie IP: Agresywne scrapowanie może prowadzić do zablokowania IP

Przykłady kodu

import requests

from bs4 import BeautifulSoup

url = 'https://news.ycombinator.com/'

headers = {'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36'}

try:

response = requests.get(url, headers=headers)

response.raise_for_status()

soup = BeautifulSoup(response.text, 'html.parser')

# Stories are contained in rows with class 'athing'

posts = soup.select('.athing')

for post in posts:

title_element = post.select_one('.titleline > a')

title = title_element.text

link = title_element['href']

print(f'Title: {title}

Link: {link}

---')

except Exception as e:

print(f'Scraping failed: {e}')Kiedy Używać

Najlepsze dla statycznych stron HTML z minimalnym JavaScript. Idealne dla blogów, serwisów informacyjnych i prostych stron produktowych e-commerce.

Zalety

- ●Najszybsze wykonanie (bez narzutu przeglądarki)

- ●Najniższe zużycie zasobów

- ●Łatwe do zrównoleglenia z asyncio

- ●Świetne dla API i stron statycznych

Ograniczenia

- ●Nie może wykonywać JavaScript

- ●Zawodzi na SPA i dynamicznej zawartości

- ●Może mieć problemy ze złożonymi systemami anti-bot

Jak scrapować Hacker News za pomocą kodu

Python + Requests

import requests

from bs4 import BeautifulSoup

url = 'https://news.ycombinator.com/'

headers = {'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36'}

try:

response = requests.get(url, headers=headers)

response.raise_for_status()

soup = BeautifulSoup(response.text, 'html.parser')

# Stories are contained in rows with class 'athing'

posts = soup.select('.athing')

for post in posts:

title_element = post.select_one('.titleline > a')

title = title_element.text

link = title_element['href']

print(f'Title: {title}

Link: {link}

---')

except Exception as e:

print(f'Scraping failed: {e}')Python + Playwright

from playwright.sync_api import sync_playwright

with sync_playwright() as p:

browser = p.chromium.launch(headless=True)

page = browser.new_page()

page.goto('https://news.ycombinator.com/')

# Wait for the table to load

page.wait_for_selector('.athing')

# Extract all story titles and links

items = page.query_selector_all('.athing')

for item in items:

title_link = item.query_selector('.titleline > a')

if title_link:

print(title_link.inner_text(), title_link.get_attribute('href'))

browser.close()Python + Scrapy

import scrapy

class HackerNewsSpider(scrapy.Spider):

name = 'hn_spider'

start_urls = ['https://news.ycombinator.com/']

def parse(self, response):

for post in response.css('.athing'):

yield {

'id': post.attrib.get('id'),

'title': post.css('.titleline > a::text').get(),

'link': post.css('.titleline > a::attr(href)').get(),

}

# Follow pagination 'More' link

next_page = response.css('a.morelink::attr(href)').get()

if next_page:

yield response.follow(next_page, self.parse)Node.js + Puppeteer

const puppeteer = require('puppeteer');

(async () => {

const browser = await puppeteer.launch();

const page = await browser.newPage();

await page.goto('https://news.ycombinator.com/');

const results = await page.evaluate(() => {

const items = Array.from(document.querySelectorAll('.athing'));

return items.map(item => ({

title: item.querySelector('.titleline > a').innerText,

url: item.querySelector('.titleline > a').href

}));

});

console.log(results);

await browser.close();

})();Co Możesz Zrobić Z Danymi Hacker News

Poznaj praktyczne zastosowania i wnioski z danych Hacker News.

Odkrywanie trendów w startupach

Identyfikuj, które branże lub typy produktów są najczęściej uruchamiane i omawiane.

Jak wdrożyć:

- 1Scrapuj kategorię 'Show HN' w cyklu tygodniowym.

- 2Czyść i kategoryzuj opisy startupów za pomocą NLP.

- 3Rankuj trendy na podstawie głosów społeczności i sentymentu komentarzy.

Użyj Automatio do wyodrębnienia danych z Hacker News i budowania tych aplikacji bez pisania kodu.

Co Możesz Zrobić Z Danymi Hacker News

- Odkrywanie trendów w startupach

Identyfikuj, które branże lub typy produktów są najczęściej uruchamiane i omawiane.

- Scrapuj kategorię 'Show HN' w cyklu tygodniowym.

- Czyść i kategoryzuj opisy startupów za pomocą NLP.

- Rankuj trendy na podstawie głosów społeczności i sentymentu komentarzy.

- Sourcing techniczny i rekrutacja

Wyodrębniaj ogłoszenia o pracy i dane firm z wyspecjalizowanych miesięcznych wątków rekrutacyjnych.

- Monitoruj ID miesięcznego wątku 'Who is hiring'.

- Scrapuj wszystkie komentarze pierwszego poziomu zawierające opisy stanowisk.

- Parsuj tekst pod kątem konkretnych stosów technologicznych, takich jak Rust, AI lub React.

- Analityka konkurencji

Śledź wzmianki o konkurentach w komentarzach, aby zrozumieć odbiór publiczny i najczęstsze skargi.

- Skonfiguruj scraper oparty na słowach kluczowych dla konkretnych nazw marek.

- Wyodrębniaj komentarze użytkowników i znaczniki czasu do analizy sentymentu.

- Generuj cotygodniowe raporty o kondycji marki na tle konkurencji.

- Automatyczna kuratela treści

Stwórz wartościowy newsletter technologiczny zawierający wyłącznie najistotniejsze historie.

- Scrapuj stronę główną co 6 godzin.

- Filtruj posty, które przekraczają próg 200 punktów.

- Zautomatyzuj przesyłanie tych linków do bota na Telegramie lub listy e-mailowej.

- Pozyskiwanie leadów dla Venture Capital

Odkrywaj startupy na wczesnym etapie rozwoju, które zyskują znaczące zainteresowanie społeczności.

- Śledź posty 'Show HN', które trafiają na stronę główną.

- Monitoruj tempo wzrostu upvotes w ciągu pierwszych 4 godzin.

- Alarmuj analityków, gdy post wykazuje wiralowe wzorce wzrostu.

Przyspiesz swoj workflow z automatyzacja AI

Automatio laczy moc agentow AI, automatyzacji web i inteligentnych integracji, aby pomoc Ci osiagnac wiecej w krotszym czasie.

Profesjonalne Porady dla Scrapowania Hacker News

Porady ekspertów dotyczące skutecznej ekstrakcji danych z Hacker News.

Używaj oficjalnego Firebase API do zbierania ogromnych ilości danych historycznych, aby uniknąć złożoności parsowania HTML.

Zawsze ustawiaj własny User-Agent, aby odpowiedzialnie identyfikować swojego bota i unikać natychmiastowego blokowania.

Zaimplementuj losowe interwały sleep od 3 do 7 sekund między żądaniami, aby naśladować zachowanie człowieka.

Celuj w konkretne podkatalogi, takie jak /newest dla najnowszych treści lub /ask dla dyskusji społecznościowych.

Przechowuj 'Item ID' jako klucz główny (primary key), aby uniknąć duplikatów przy częstym scrapowaniu strony głównej.

Scrapuj w godzinach poza szczytem (noc wg czasu UTC), aby uzyskać krótsze czasy odpowiedzi i mniejsze ryzyko rate limiting.

Opinie

Co mowia nasi uzytkownicy

Dolacz do tysiecy zadowolonych uzytkownikow, ktorzy przeksztalcili swoj workflow

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Powiazane Web Scraping

Często Zadawane Pytania o Hacker News

Znajdź odpowiedzi na częste pytania o Hacker News