Jak scrapować Open Collective: Przewodnik po danych finansowych i kontrybutorach

Dowiedz się, jak scrapować Open Collective pod kątem transakcji finansowych, list kontrybutorów i danych o finansowaniu projektów. Uzyskaj wgląd w rynek.

Wykryto ochronę przed botami

- Cloudflare

- Korporacyjny WAF i zarządzanie botami. Używa wyzwań JavaScript, CAPTCHA i analizy behawioralnej. Wymaga automatyzacji przeglądarki z ustawieniami stealth.

- Ograniczanie szybkości

- Ogranicza liczbę żądań na IP/sesję w czasie. Można obejść za pomocą rotacyjnych proxy, opóźnień żądań i rozproszonego scrapingu.

- WAF

O Open Collective

Odkryj, co oferuje Open Collective i jakie cenne dane można wyodrębnić.

O Open Collective

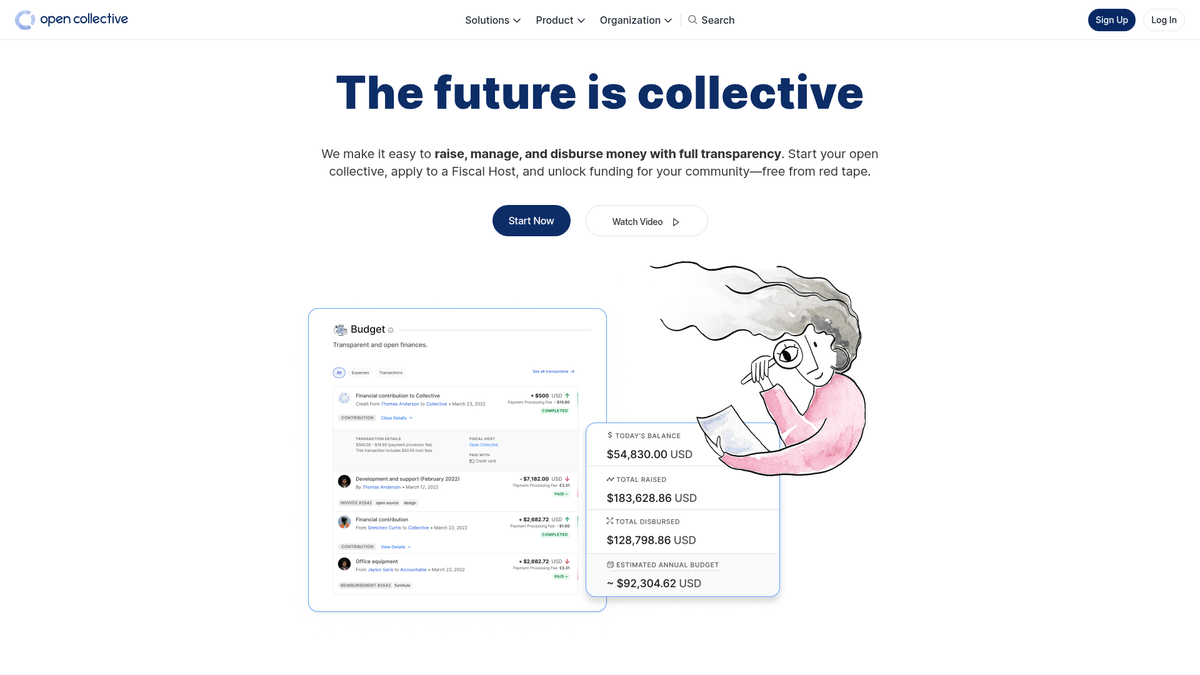

Open Collective to unikalna platforma finansowa i prawna, stworzona w celu zapewnienia przejrzystości organizacjom społecznościowym, projektom open-source oraz stowarzyszeniom lokalnym. Działając jako scentralizowane narzędzie do finansowania, pozwala „kolektywom” zbierać fundusze i zarządzać wydatkami bez potrzeby posiadania formalnej osobowości prawnej, często korzystając z tzw. gospodarzy fiskalnych (fiscal hosts). Kluczowe projekty technologiczne, takie jak Babel czy Webpack, polegają na tej platformie w zarządzaniu swoimi ekosystemami finansowanymi przez społeczność.

Platforma słynie z radykalnej przejrzystości. Każda transakcja – od darowizny od dużej korporacji po drobny wydatek na lokalne spotkanie – jest rejestrowana i publicznie widoczna. Stanowi to bogate źródło danych na temat kondycji finansowej i nawyków wydatkowych niektórych z najważniejszych projektów open-source na świecie.

Scrapowanie Open Collective jest niezwykle wartościowe dla organizacji przeprowadzających badania rynku w gospodarce open-source. Pozwala użytkownikom identyfikować potencjalnych sponsorów korporacyjnych, śledzić trendy w finansowaniu programistów oraz audytować stabilność finansową krytycznych projektów programistycznych. Dane te służą jako bezpośredni wgląd w przepływ kapitału w globalnej społeczności deweloperskiej.

Dlaczego Scrapować Open Collective?

Odkryj wartość biznesową i przypadki użycia ekstrakcji danych z Open Collective.

Analiza stabilności krytycznych zależności open-source

Identyfikacja potencjalnych sponsorów korporacyjnych dla usług B2B

Monitorowanie trendów zdecentralizowanego finansowania w różnych tech stackach

Prowadzenie badań akademickich nad systemami finansowymi peer-to-peer

Audyt wydatków organizacji non-profit i grup społecznych dla zapewnienia przejrzystości

Śledzenie zaangażowania konkurencji w sponsorowanie projektów społecznościowych

Wyzwania Scrapowania

Wyzwania techniczne, które możesz napotkać podczas scrapowania Open Collective.

Zarządzanie złożonymi zapytaniami GraphQL przy ekstrakcji głęboko zagnieżdżonych danych

Obsługa dynamicznej hydracji Next.js i paginacji typu infinite scroll

Omijanie zabezpieczeń Cloudflare przy dużej częstotliwości żądań

Radzenie sobie z rygorystycznymi limitami rate-limiting zarówno w API, jak i na stronie www

Scrapuj Open Collective z AI

Bez kodowania. Wyodrębnij dane w kilka minut dzięki automatyzacji opartej na AI.

Jak to działa

Opisz, czego potrzebujesz

Powiedz AI, jakie dane chcesz wyodrębnić z Open Collective. Po prostu wpisz to w języku naturalnym — bez kodu czy selektorów.

AI wyodrębnia dane

Nasza sztuczna inteligencja nawiguje po Open Collective, obsługuje dynamiczną treść i wyodrębnia dokładnie to, o co prosiłeś.

Otrzymaj swoje dane

Otrzymaj czyste, ustrukturyzowane dane gotowe do eksportu jako CSV, JSON lub do bezpośredniego przesłania do twoich aplikacji.

Dlaczego warto używać AI do scrapowania

AI ułatwia scrapowanie Open Collective bez pisania kodu. Nasza platforma oparta na sztucznej inteligencji rozumie, jakich danych potrzebujesz — po prostu opisz je w języku naturalnym, a AI wyodrębni je automatycznie.

How to scrape with AI:

- Opisz, czego potrzebujesz: Powiedz AI, jakie dane chcesz wyodrębnić z Open Collective. Po prostu wpisz to w języku naturalnym — bez kodu czy selektorów.

- AI wyodrębnia dane: Nasza sztuczna inteligencja nawiguje po Open Collective, obsługuje dynamiczną treść i wyodrębnia dokładnie to, o co prosiłeś.

- Otrzymaj swoje dane: Otrzymaj czyste, ustrukturyzowane dane gotowe do eksportu jako CSV, JSON lub do bezpośredniego przesłania do twoich aplikacji.

Why use AI for scraping:

- Ekstrakcja złożonych danych finansowych bez pisania zapytań GraphQL

- Automatyczna obsługa renderowania JavaScript i infinite scroll

- Harmonogramowanie cyklicznych uruchomień do monitorowania zmian w budżetach projektów

- Omijanie systemów anty-botowych dzięki rozproszonej egzekucji w chmurze

Scrapery No-Code dla Open Collective

Alternatywy point-and-click dla scrapingu opartego na AI

Różne narzędzia no-code jak Browse.ai, Octoparse, Axiom i ParseHub mogą pomóc w scrapowaniu Open Collective bez pisania kodu. Te narzędzia używają wizualnych interfejsów do wyboru danych, choć mogą mieć problemy ze złożoną dynamiczną zawartością lub zabezpieczeniami anti-bot.

Typowy Workflow z Narzędziami No-Code

Częste Wyzwania

Krzywa uczenia

Zrozumienie selektorów i logiki ekstrakcji wymaga czasu

Selektory się psują

Zmiany na stronie mogą zepsuć cały przepływ pracy

Problemy z dynamiczną treścią

Strony bogate w JavaScript wymagają złożonych obejść

Ograniczenia CAPTCHA

Większość narzędzi wymaga ręcznej interwencji przy CAPTCHA

Blokowanie IP

Agresywne scrapowanie może prowadzić do zablokowania IP

Scrapery No-Code dla Open Collective

Różne narzędzia no-code jak Browse.ai, Octoparse, Axiom i ParseHub mogą pomóc w scrapowaniu Open Collective bez pisania kodu. Te narzędzia używają wizualnych interfejsów do wyboru danych, choć mogą mieć problemy ze złożoną dynamiczną zawartością lub zabezpieczeniami anti-bot.

Typowy Workflow z Narzędziami No-Code

- Zainstaluj rozszerzenie przeglądarki lub zarejestruj się na platformie

- Przejdź do docelowej strony i otwórz narzędzie

- Wybierz elementy danych do wyodrębnienia metodą point-and-click

- Skonfiguruj selektory CSS dla każdego pola danych

- Ustaw reguły paginacji do scrapowania wielu stron

- Obsłuż CAPTCHA (często wymaga ręcznego rozwiązywania)

- Skonfiguruj harmonogram automatycznych uruchomień

- Eksportuj dane do CSV, JSON lub połącz przez API

Częste Wyzwania

- Krzywa uczenia: Zrozumienie selektorów i logiki ekstrakcji wymaga czasu

- Selektory się psują: Zmiany na stronie mogą zepsuć cały przepływ pracy

- Problemy z dynamiczną treścią: Strony bogate w JavaScript wymagają złożonych obejść

- Ograniczenia CAPTCHA: Większość narzędzi wymaga ręcznej interwencji przy CAPTCHA

- Blokowanie IP: Agresywne scrapowanie może prowadzić do zablokowania IP

Przykłady kodu

import requests

# The Open Collective GraphQL endpoint

url = 'https://api.opencollective.com/graphql/v2'

# GraphQL query to get basic info about a collective

query = '''

query {

collective(slug: "webpack") {

name

stats {

totalAmountReceived { value }

balance { value }

}

}

}

'''

headers = {'Content-Type': 'application/json'}

try:

# Sending POST request to the API

response = requests.post(url, json={'query': query}, headers=headers)

response.raise_for_status()

data = response.json()

# Extracting and printing the name and balance

collective = data['data']['collective']

print(f"Name: {collective['name']}")

print(f"Balance: {collective['stats']['balance']['value']}")

except Exception as e:

print(f"An error occurred: {e}")Kiedy Używać

Najlepsze dla statycznych stron HTML z minimalnym JavaScript. Idealne dla blogów, serwisów informacyjnych i prostych stron produktowych e-commerce.

Zalety

- ●Najszybsze wykonanie (bez narzutu przeglądarki)

- ●Najniższe zużycie zasobów

- ●Łatwe do zrównoleglenia z asyncio

- ●Świetne dla API i stron statycznych

Ograniczenia

- ●Nie może wykonywać JavaScript

- ●Zawodzi na SPA i dynamicznej zawartości

- ●Może mieć problemy ze złożonymi systemami anti-bot

Jak scrapować Open Collective za pomocą kodu

Python + Requests

import requests

# The Open Collective GraphQL endpoint

url = 'https://api.opencollective.com/graphql/v2'

# GraphQL query to get basic info about a collective

query = '''

query {

collective(slug: "webpack") {

name

stats {

totalAmountReceived { value }

balance { value }

}

}

}

'''

headers = {'Content-Type': 'application/json'}

try:

# Sending POST request to the API

response = requests.post(url, json={'query': query}, headers=headers)

response.raise_for_status()

data = response.json()

# Extracting and printing the name and balance

collective = data['data']['collective']

print(f"Name: {collective['name']}")

print(f"Balance: {collective['stats']['balance']['value']}")

except Exception as e:

print(f"An error occurred: {e}")Python + Playwright

from playwright.sync_api import sync_playwright

def scrape_opencollective():

with sync_playwright() as p:

# Launching browser with JS support

browser = p.chromium.launch(headless=True)

page = browser.new_page()

page.goto('https://opencollective.com/discover')

# Wait for collective cards to load

page.wait_for_selector('.CollectiveCard')

# Extract data from the DOM

collectives = page.query_selector_all('.CollectiveCard')

for c in collectives:

name = c.query_selector('h2').inner_text()

print(f'Found project: {name}')

browser.close()

scrape_opencollective()Python + Scrapy

import scrapy

import json

class OpenCollectiveSpider(scrapy.Spider):

name = 'opencollective'

start_urls = ['https://opencollective.com/webpack']

def parse(self, response):

# Open Collective uses Next.js; data is often inside a script tag

next_data = response.xpath('//script[@id="__NEXT_DATA__"]/text()').get()

if next_data:

parsed_data = json.loads(next_data)

collective = parsed_data['props']['pageProps']['collective']

yield {

'name': collective.get('name'),

'balance': collective.get('stats', {}).get('balance'),

'currency': collective.get('currency')

}Node.js + Puppeteer

const puppeteer = require('puppeteer');

(async () => {

const browser = await puppeteer.launch();

const page = await browser.newPage();

await page.goto('https://opencollective.com/discover');

// Wait for the dynamic content to load

await page.waitForSelector('.CollectiveCard');

// Map over elements to extract names

const data = await page.evaluate(() => {

return Array.from(document.querySelectorAll('.CollectiveCard')).map(el => ({

name: el.querySelector('h2').innerText

}));

});

console.log(data);

await browser.close();

})();Co Możesz Zrobić Z Danymi Open Collective

Poznaj praktyczne zastosowania i wnioski z danych Open Collective.

Prognozowanie wzrostu Open Source

Identyfikuj trendy technologiczne, śledząc tempo wzrostu finansowego określonych kategorii kolektywów.

Jak wdrożyć:

- 1Wyodrębnij miesięczne przychody dla topowych projektów w konkretnych tagach

- 2Oblicz złożone roczne wskaźniki wzrostu (CAGR)

- 3Wizualizuj kondycję finansową projektów, aby przewidzieć adopcję technologii

Użyj Automatio do wyodrębnienia danych z Open Collective i budowania tych aplikacji bez pisania kodu.

Co Możesz Zrobić Z Danymi Open Collective

- Prognozowanie wzrostu Open Source

Identyfikuj trendy technologiczne, śledząc tempo wzrostu finansowego określonych kategorii kolektywów.

- Wyodrębnij miesięczne przychody dla topowych projektów w konkretnych tagach

- Oblicz złożone roczne wskaźniki wzrostu (CAGR)

- Wizualizuj kondycję finansową projektów, aby przewidzieć adopcję technologii

- Generowanie leadów dla SaaS

Znajduj dobrze sfinansowane projekty, które mogą potrzebować narzędzi deweloperskich, hostingu lub usług profesjonalnych.

- Filtruj kolektywy według budżetu i całkowitej zebranej kwoty

- Wyodrębnij opisy projektów i adresy zewnętrznych stron internetowych

- Weryfikuj tech stack poprzez powiązane repozytoria GitHub

- Audyt filantropii korporacyjnej

Śledź, na jakie projekty open-source największe korporacje przeznaczają swoje budżety na wsparcie społeczności.

- Scrapuj listy kontrybutorów dla czołowych projektów

- Filtruj profile organizacyjne i indywidualne

- Agreguj kwoty wpłat według podmiotów korporacyjnych

- Badanie wpływu społecznego

Analizuj, jak zdecentralizowane grupy dystrybuują fundusze, aby zrozumieć ich realny wpływ społeczny.

- Scrapuj pełną księgę transakcji dla konkretnego kolektywu

- Kategoryzuj wydatki (podróże, wynagrodzenia, sprzęt)

- Generuj raporty na temat alokacji zasobów w grupach społecznościowych

- Pipeline rekrutacyjny deweloperów

Znajduj liderów w konkretnych ekosystemach na podstawie ich historii zarządzania społecznością i wkładu w projekty.

- Scrapuj listy członków kluczowych kolektywów technicznych

- Krzyżuj dane kontrybutorów z ich publicznymi profilami społecznościowymi

- Identyfikuj aktywnych maintainerów do bezpośredniego kontaktu

Przyspiesz swoj workflow z automatyzacja AI

Automatio laczy moc agentow AI, automatyzacji web i inteligentnych integracji, aby pomoc Ci osiagnac wiecej w krotszym czasie.

Profesjonalne Porady dla Scrapowania Open Collective

Porady ekspertów dotyczące skutecznej ekstrakcji danych z Open Collective.

Priorytetyzuj oficjalne GraphQL API nad web scrapingiem, aby uzyskać bardziej stabilne i uporządkowane wyniki.

Podczas scrapowania front-endu używaj atrybutów 'data-cy' w selektorach, co zapewni większą stabilność przy aktualizacjach strony.

Wprowadź losowe opóźnienia rzędu 2-5 sekund, aby naśladować naturalne zachowanie użytkownika i unikać limitów zapytań.

Używaj rotacyjnych residential proxies, jeśli musisz wykonywać dużą liczbę wyszukiwań na stronie /discover.

Sprawdzaj plik robots.txt, aby upewnić się, że częstotliwość scrapowania jest zgodna z dozwolonymi parametrami crawl-delay.

Opinie

Co mowia nasi uzytkownicy

Dolacz do tysiecy zadowolonych uzytkownikow, ktorzy przeksztalcili swoj workflow

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Powiazane Web Scraping

How to Scrape Moon.ly | Step-by-Step NFT Data Extraction Guide

How to Scrape Yahoo Finance: Extract Stock Market Data

How to Scrape Rocket Mortgage: A Comprehensive Guide

How to Scrape jup.ag: Jupiter DEX Web Scraper Guide

How to Scrape Indiegogo: The Ultimate Crowdfunding Data Extraction Guide

How to Scrape ICO Drops: Comprehensive Crypto Data Guide

How to Scrape Crypto.com: Comprehensive Market Data Guide

How to Scrape Coinpaprika: Crypto Market Data Extraction Guide

Często Zadawane Pytania o Open Collective

Znajdź odpowiedzi na częste pytania o Open Collective