Como fazer scraping do Seeking Alpha: Dados Financeiros e Transcrições

Saiba como fazer o scraping do Seeking Alpha para notícias de ações, classificações de analistas e transcrições de lucros. Aprenda a contornar o Cloudflare e...

Proteção Anti-Bot Detectada

- Cloudflare

- WAF e gestão de bots de nível empresarial. Usa desafios JavaScript, CAPTCHAs e análise comportamental. Requer automação de navegador com configurações stealth.

- DataDome

- Detecção de bots em tempo real com modelos ML. Analisa fingerprint do dispositivo, sinais de rede e padrões comportamentais. Comum em sites de e-commerce.

- Google reCAPTCHA

- Sistema CAPTCHA do Google. v2 requer interação do usuário, v3 funciona silenciosamente com pontuação de risco. Pode ser resolvido com serviços de CAPTCHA.

- Limitação de taxa

- Limita requisições por IP/sessão ao longo do tempo. Pode ser contornado com proxies rotativos, atrasos de requisição e scraping distribuído.

- Bloqueio de IP

- Bloqueia IPs de data centers conhecidos e endereços sinalizados. Requer proxies residenciais ou móveis para contornar efetivamente.

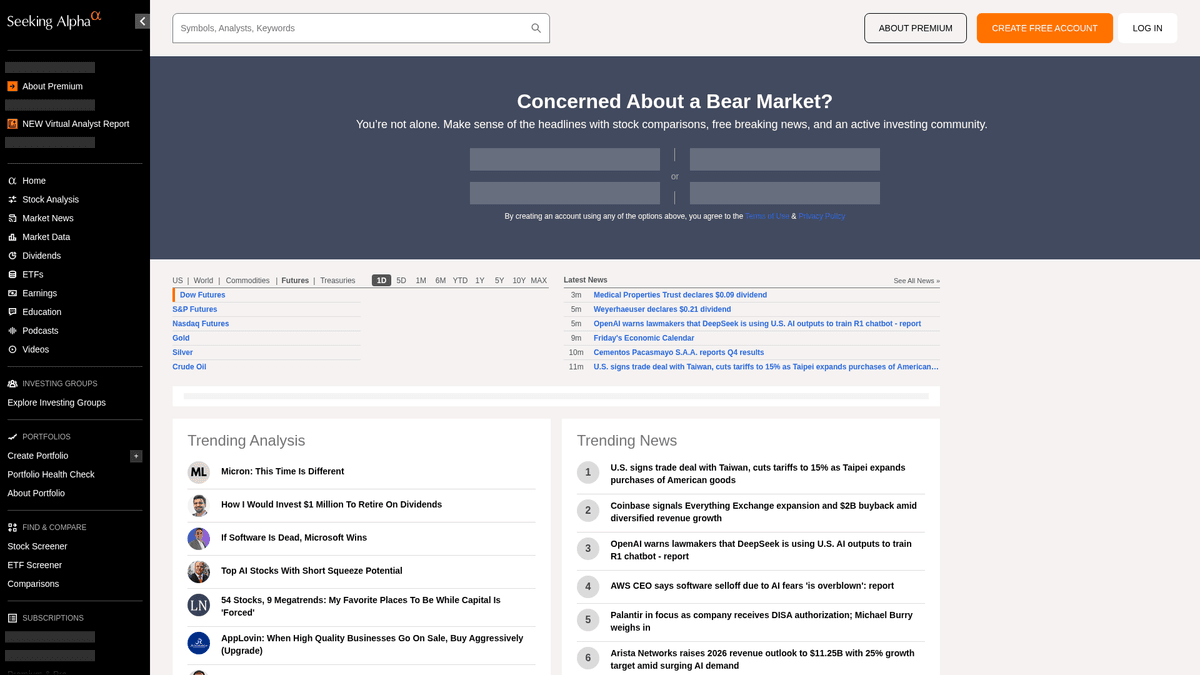

Sobre Seeking Alpha

Descubra o que Seeking Alpha oferece e quais dados valiosos podem ser extraídos.

O Principal Hub de Inteligência Financeira

O Seeking Alpha é uma plataforma líder de pesquisa financeira colaborativa que serve como uma ponte vital entre dados de mercado brutos e insights de investimento acionáveis. Ele hospeda uma extensa biblioteca de artigos de análise, notícias de mercado em tempo real e o repositório mais abrangente da internet de transcrições de chamadas de resultados para milhares de empresas de capital aberto.

Ecossistema de Dados Diversificado

A plataforma oferece uma riqueza de dados estruturados e não estruturados, incluindo ideias de ações, históricos de dividendos e as classificações proprietárias Quant que superam o mercado. Gerenciado por uma equipe editorial profissional, o conteúdo é gerado por milhares de analistas independentes cujas contribuições devem atender a altos padrões de qualidade e conformidade antes da publicação.

Valor Estratégico para Extração de Dados

Fazer o scraping do Seeking Alpha é essencial para analistas financeiros e traders quantitativos que realizam análise de sentimento, acompanham tendências históricas de ganhos e monitoram notícias em tickers específicos. Os dados fornecem insights granulares sobre a psicologia do mercado e o desempenho corporativo que podem ser usados para construir modelos financeiros sofisticados e realizar inteligência competitiva.

Por Que Fazer Scraping de Seeking Alpha?

Descubra o valor comercial e os casos de uso para extração de dados de Seeking Alpha.

Análise de Sentimento

Extraia artigos e comentários colaborativos para realizar processamento de linguagem natural para medir o sentimento do mercado sobre tickers de ações específicos.

Inteligência de Lucros

Colete transcrições de chamadas de lucros para identificar as principais tendências de orientação corporativa, perspectivas financeiras e o sentimento executivo em vários setores.

Classificações Quant Proprietárias

Monitore as classificações Quant exclusivas do Seeking Alpha e as pontuações de convicção dos analistas para alimentar sinais de negociação automatizados ou ferramentas de gestão de portfólio.

Pesquisa Competitiva

Acompanhe o que os analistas mais bem avaliados estão dizendo sobre os concorrentes em seu setor para se manter à frente das mudanças na indústria e das expectativas do mercado.

Arquivamento de Dados Históricos

Crie um repositório privado de recomendações de analistas e reações de preços de ações para avaliar a precisão a longo prazo de escritores de investimentos específicos.

Desafios do Scraping

Desafios técnicos que você pode encontrar ao fazer scraping de Seeking Alpha.

Detecção Avançada de Bots

O Seeking Alpha utiliza segurança de perímetro sofisticada, como Cloudflare e PerimeterX, que monitoram fingerprints de navegadores automatizados e padrões comportamentais.

Paywalls de Conteúdo Premium

Muitos conjuntos de dados de alto valor, incluindo métricas quantitativas detalhadas e transcrições históricas, estão atrás de uma barreira de assinatura que exige gerenciamento de sessão seguro.

Renderização de Conteúdo Dinâmico

A plataforma utiliza um framework React moderno, o que significa que os dados são frequentemente carregados de forma assíncrona via solicitações XHR, em vez de estarem presentes no código-fonte HTML inicial.

Limite de Taxa Estrito

Frequências de solicitação agressivas acionam rapidamente erros 403 Forbidden e banimentos temporários de IP se o comportamento do scraping não imitar um usuário humano.

Scrape Seeking Alpha com IA

Sem código necessário. Extraia dados em minutos com automação por IA.

Como Funciona

Descreva o que você precisa

Diga à IA quais dados você quer extrair de Seeking Alpha. Apenas digite em linguagem natural — sem código ou seletores.

A IA extrai os dados

Nossa inteligência artificial navega Seeking Alpha, lida com conteúdo dinâmico e extrai exatamente o que você pediu.

Obtenha seus dados

Receba dados limpos e estruturados prontos para exportar como CSV, JSON ou enviar diretamente para seus aplicativos.

Por Que Usar IA para Scraping

A IA facilita o scraping de Seeking Alpha sem escrever código. Nossa plataforma com inteligência artificial entende quais dados você quer — apenas descreva em linguagem natural e a IA os extrai automaticamente.

How to scrape with AI:

- Descreva o que você precisa: Diga à IA quais dados você quer extrair de Seeking Alpha. Apenas digite em linguagem natural — sem código ou seletores.

- A IA extrai os dados: Nossa inteligência artificial navega Seeking Alpha, lida com conteúdo dinâmico e extrai exatamente o que você pediu.

- Obtenha seus dados: Receba dados limpos e estruturados prontos para exportar como CSV, JSON ou enviar diretamente para seus aplicativos.

Why use AI for scraping:

- Mascaramento de Fingerprint Stealth: O Automatio rotaciona automaticamente os fingerprints e cabeçalhos do navegador para ignorar sistemas de detecção como o Cloudflare sem exigir configuração manual.

- Suporte para Renderização Dinâmica: A arquitetura de navegador headless da ferramenta garante que todos os componentes baseados em React e gráficos financeiros sejam totalmente renderizados antes do início da extração de dados.

- Gerenciamento de Sessão Sem Código: Gerencie facilmente logins e cookies persistentes para acessar transcrições premium e classificações de analistas sem escrever scripts de autenticação complexos.

- Seleção Visual de Dados: Escolha dados de tabelas financeiras complexas visualmente, garantindo uma extração estável mesmo quando as classes CSS subjacentes ou os layouts de página mudam.

Scrapers Web No-Code para Seeking Alpha

Alternativas point-and-click ao scraping com IA

Várias ferramentas no-code como Browse.ai, Octoparse, Axiom e ParseHub podem ajudá-lo a fazer scraping de Seeking Alpha sem escrever código. Essas ferramentas usam interfaces visuais para selecionar dados, embora possam ter dificuldades com conteúdo dinâmico complexo ou medidas anti-bot.

Workflow Típico com Ferramentas No-Code

Desafios Comuns

Curva de aprendizado

Compreender seletores e lógica de extração leva tempo

Seletores quebram

Mudanças no site podem quebrar todo o fluxo de trabalho

Problemas com conteúdo dinâmico

Sites com muito JavaScript requerem soluções complexas

Limitações de CAPTCHA

A maioria das ferramentas requer intervenção manual para CAPTCHAs

Bloqueio de IP

Scraping agressivo pode resultar no bloqueio do seu IP

Scrapers Web No-Code para Seeking Alpha

Várias ferramentas no-code como Browse.ai, Octoparse, Axiom e ParseHub podem ajudá-lo a fazer scraping de Seeking Alpha sem escrever código. Essas ferramentas usam interfaces visuais para selecionar dados, embora possam ter dificuldades com conteúdo dinâmico complexo ou medidas anti-bot.

Workflow Típico com Ferramentas No-Code

- Instalar extensão do navegador ou registrar-se na plataforma

- Navegar até o site alvo e abrir a ferramenta

- Selecionar com point-and-click os elementos de dados a extrair

- Configurar seletores CSS para cada campo de dados

- Configurar regras de paginação para scraping de múltiplas páginas

- Resolver CAPTCHAs (frequentemente requer intervenção manual)

- Configurar agendamento para execuções automáticas

- Exportar dados para CSV, JSON ou conectar via API

Desafios Comuns

- Curva de aprendizado: Compreender seletores e lógica de extração leva tempo

- Seletores quebram: Mudanças no site podem quebrar todo o fluxo de trabalho

- Problemas com conteúdo dinâmico: Sites com muito JavaScript requerem soluções complexas

- Limitações de CAPTCHA: A maioria das ferramentas requer intervenção manual para CAPTCHAs

- Bloqueio de IP: Scraping agressivo pode resultar no bloqueio do seu IP

Exemplos de Código

import requests

from bs4 import BeautifulSoup

# URL para as últimas notícias do mercado

url = 'https://seekingalpha.com/market-news'

# Headers de navegador padrão para imitar comportamento humano

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/120.0.0.0 Safari/537.36',

'Accept-Language': 'en-US,en;q=0.9',

'Referer': 'https://seekingalpha.com/'

}

def scrape_sa_news():

try:

response = requests.get(url, headers=headers, timeout=10)

if response.status_code == 200:

soup = BeautifulSoup(response.text, 'html.parser')

# Extrai manchetes usando atributos data-test-id

headlines = soup.find_all('a', {'data-test-id': 'post-list-item-title'})

for item in headlines:

print(f'Título da Notícia: {item.text.strip()}')

else:

print(f'Bloqueado com status: {response.status_code}')

except Exception as e:

print(f'Ocorreu um erro: {e}')

if __name__ == "__main__":

scrape_sa_news()Quando Usar

Ideal para páginas HTML estáticas com JavaScript mínimo. Perfeito para blogs, sites de notícias e páginas de produtos e-commerce simples.

Vantagens

- ●Execução mais rápida (sem overhead do navegador)

- ●Menor consumo de recursos

- ●Fácil de paralelizar com asyncio

- ●Ótimo para APIs e páginas estáticas

Limitações

- ●Não pode executar JavaScript

- ●Falha em SPAs e conteúdo dinâmico

- ●Pode ter dificuldades com sistemas anti-bot complexos

Como Fazer Scraping de Seeking Alpha com Código

Python + Requests

import requests

from bs4 import BeautifulSoup

# URL para as últimas notícias do mercado

url = 'https://seekingalpha.com/market-news'

# Headers de navegador padrão para imitar comportamento humano

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/120.0.0.0 Safari/537.36',

'Accept-Language': 'en-US,en;q=0.9',

'Referer': 'https://seekingalpha.com/'

}

def scrape_sa_news():

try:

response = requests.get(url, headers=headers, timeout=10)

if response.status_code == 200:

soup = BeautifulSoup(response.text, 'html.parser')

# Extrai manchetes usando atributos data-test-id

headlines = soup.find_all('a', {'data-test-id': 'post-list-item-title'})

for item in headlines:

print(f'Título da Notícia: {item.text.strip()}')

else:

print(f'Bloqueado com status: {response.status_code}')

except Exception as e:

print(f'Ocorreu um erro: {e}')

if __name__ == "__main__":

scrape_sa_news()Python + Playwright

from playwright.sync_api import sync_playwright

def run(playwright):

# Lançando um navegador Chromium

browser = playwright.chromium.launch(headless=True)

context = browser.new_context(

user_agent='Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/120.0.0.0 Safari/537.36'

)

page = context.new_page()

try:

# Navegando para a página de transcrições de um símbolo de ação específico

page.goto('https://seekingalpha.com/symbol/AAPL/transcripts')

# Aguarda a renderização dinâmica do conteúdo principal

page.wait_for_selector('article', timeout=15000)

# Localiza e extrai títulos de transcrições

titles = page.locator('h3').all_inner_texts()

for title in titles:

print(f'Transcrição encontrada: {title}')

except Exception as e:

print(f'Falha na extração: {e}')

finally:

browser.close()

with sync_playwright() as playwright:

run(playwright)Python + Scrapy

import scrapy

class SeekingAlphaSpider(scrapy.Spider):

name = 'sa_spider'

allowed_domains = ['seekingalpha.com']

start_urls = ['https://seekingalpha.com/latest-articles']

custom_settings = {

'DOWNLOAD_DELAY': 8,

'USER_AGENT': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) Chrome/120.0.0.0',

'ROBOTSTXT_OBEY': False,

'COOKIES_ENABLED': True

}

def parse(self, response):

for article in response.css('article'):

yield {

'title': article.css('h3 a::text').get(),

'link': response.urljoin(article.css('h3 a::attr(href)').get()),

'author': article.css('span[data-test-id="author-name"]::text').get()

}

# Lida com paginação simples via links 'next'

next_page = response.css('a.next_page::attr(href)').get()

if next_page:

yield response.follow(next_page, self.parse)Node.js + Puppeteer

const puppeteer = require('puppeteer');

(async () => {

const browser = await puppeteer.launch({ headless: true });

const page = await browser.newPage();

// Define um User-Agent de alta qualidade

await page.setUserAgent('Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/120.0.0.0 Safari/537.36');

try {

// Navega para a homepage do Seeking Alpha

await page.goto('https://seekingalpha.com/', { waitUntil: 'networkidle2' });

// Avalia scripts no contexto do navegador para extrair títulos

const trending = await page.evaluate(() => {

const nodes = Array.from(document.querySelectorAll('h3'));

return nodes.map(n => n.innerText.trim());

});

console.log('Conteúdo em alta:', trending);

} catch (err) {

console.error('O Puppeteer encontrou um erro:', err);

} finally {

await browser.close();

}

})();O Que Você Pode Fazer Com Os Dados de Seeking Alpha

Explore aplicações práticas e insights dos dados de Seeking Alpha.

Análise de Sentimento Quantitativa

Empresas financeiras usam artigos de analistas para determinar o sentimento do mercado para setores de ações específicos.

Como implementar:

- 1Extrair todos os artigos de análise para um ticker de setor específico.

- 2Processar o conteúdo através de um mecanismo de NLP para calcular a polaridade do sentimento.

- 3Integrar as pontuações de sentimento em algoritmos de trading existentes.

- 4Acionar alertas automatizados de compra/venda com base em mudanças de sentimento.

Use Automatio para extrair dados de Seeking Alpha e construir essas aplicações sem escrever código.

O Que Você Pode Fazer Com Os Dados de Seeking Alpha

- Análise de Sentimento Quantitativa

Empresas financeiras usam artigos de analistas para determinar o sentimento do mercado para setores de ações específicos.

- Extrair todos os artigos de análise para um ticker de setor específico.

- Processar o conteúdo através de um mecanismo de NLP para calcular a polaridade do sentimento.

- Integrar as pontuações de sentimento em algoritmos de trading existentes.

- Acionar alertas automatizados de compra/venda com base em mudanças de sentimento.

- Extração de Insights de Ganhos

Extraia orientações corporativas críticas diretamente das transcrições de ganhos para relatórios rápidos.

- Automatizar um scraping diário da seção de Transcrições de Ganhos.

- Buscar por palavras-chave financeiras específicas como 'EBITDA' ou 'Projeções'.

- Isolar as frases que contêm métricas de orientação da gestão.

- Exportar as descobertas para um CSV estruturado para revisão do comitê de investimento.

- Benchmarking de Dividend Yield

Compare o desempenho de dividendos em milhares de ações para encontrar oportunidades de rendimento.

- Extrair histórico de dividendos e taxas de payout para uma lista definida de ações.

- Calcular o rendimento médio vs. tendências históricas usando os dados coletados.

- Identificar ações que aumentaram recentemente sua distribuição.

- Atualizar um dashboard privado com comparações de rendimento em tempo real.

- Rastreamento de Desempenho de Analistas

Identifique autores de alta precisão para seguir e obter melhores ideias de investimento.

- Extrair classificações históricas e artigos de autores bem avaliados.

- Cruzar as datas de publicação dos artigos com o desempenho do preço das ações.

- Classificar os autores com base na precisão de suas recomendações de 'Compra' ou 'Venda'.

- Enviar notificações automatizadas quando autores de alto escalão postarem novas ideias.

Potencialize seu fluxo de trabalho com Automacao de IA

Automatio combina o poder de agentes de IA, automacao web e integracoes inteligentes para ajuda-lo a realizar mais em menos tempo.

Dicas Pro para Scraping de Seeking Alpha

Dicas de especialistas para extrair dados com sucesso de Seeking Alpha.

Priorize Proxies Residenciais

O Seeking Alpha coloca na lista negra a maioria dos IPs de datacenter; usar proxies residenciais faz com que seu tráfego pareça vir de usuários legítimos de internet residencial.

Alvo em Endpoints de API Internos

Inspecione o tráfego de rede para encontrar chamadas de API internas baseadas em JSON (v3/api), que geralmente são mais fáceis de analisar do que estruturas HTML brutas.

Implemente Delays Semelhantes a Humanos

Randomize o tempo de suas interações e mantenha o volume de solicitações baixo para evitar acionar sistemas de detecção comportamental que procuram padrões robóticos.

Use Atributos de Dados para Seletores

Aponte para atributos 'data-test-id' em seus seletores, pois é menos provável que eles mudem durante atualizações do site em comparação com classes CSS dinâmicas do React.

Faça o Scrape em Horários de Pouco Movimento

Realize a coleta de dados em larga escala durante o fechamento do mercado ou fins de semana para reduzir o risco de atingir limites de taxa de tráfego intenso.

Depoimentos

O Que Nossos Usuarios Dizem

Junte-se a milhares de usuarios satisfeitos que transformaram seu fluxo de trabalho

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Relacionados Web Scraping

How to Scrape Yahoo Finance: Extract Stock Market Data

How to Scrape Moon.ly | Step-by-Step NFT Data Extraction Guide

How to Scrape Rocket Mortgage: A Comprehensive Guide

How to Scrape Open Collective: Financial and Contributor Data Guide

How to Scrape jup.ag: Jupiter DEX Web Scraper Guide

How to Scrape Indiegogo: The Ultimate Crowdfunding Data Extraction Guide

How to Scrape ICO Drops: Comprehensive Crypto Data Guide

How to Scrape Crypto.com: Comprehensive Market Data Guide

Perguntas Frequentes Sobre Seeking Alpha

Encontre respostas para perguntas comuns sobre Seeking Alpha