Cum să extragi date de pe Open Collective: Ghid pentru date financiare și contribuitori

Descoperă cum să extragi date de pe Open Collective pentru tranzacții financiare, liste de contribuitori și finanțarea proiectelor. Obține informații...

Protecție anti-bot detectată

- Cloudflare

- WAF și gestionare bot de nivel enterprise. Folosește provocări JavaScript, CAPTCHA și analiză comportamentală. Necesită automatizare browser cu setări stealth.

- Limitarea ratei

- Limitează cererile per IP/sesiune în timp. Poate fi ocolit cu proxy-uri rotative, întârzieri ale cererilor și scraping distribuit.

- WAF

Despre Open Collective

Descoperiți ce oferă Open Collective și ce date valoroase pot fi extrase.

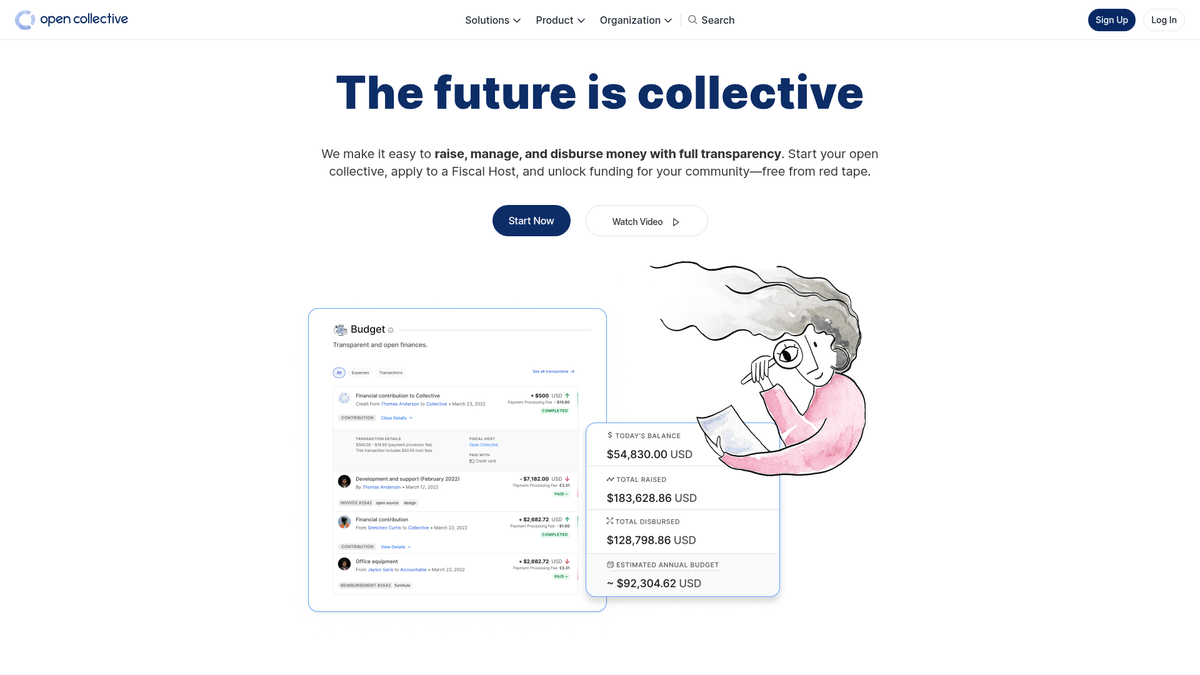

Despre Open Collective

Open Collective este o platformă financiară și juridică unică, concepută pentru a oferi transparență organizațiilor conduse de comunitate, proiectelor software open-source și asociațiilor de cartier. Funcționând ca un instrument de finanțare descentralizat, permite „colectivelor” să strângă bani și să gestioneze cheltuielile fără a fi nevoie de o entitate juridică formală, utilizând adesea gazde fiscale pentru suport administrativ. Proiecte tehnologice majore precum Babel și Webpack se bazează pe această platformă pentru a-și gestiona ecosistemele finanțate de comunitate.

Platforma este renumită pentru transparența sa radicală. Fiecare tranzacție, fie că este o donație de la o corporație mare sau o cheltuială mică pentru o întâlnire a comunității, este înregistrată și vizibilă public. Acest lucru oferă o multitudine de date privind sănătatea financiară și obiceiurile de cheltuieli ale unora dintre cele mai critice dependențe open-source din lume.

Scraping-ul pe Open Collective este extrem de valoros pentru organizațiile care doresc să efectueze cercetări de piață asupra economiei open-source. Permite utilizatorilor să identifice oportunități de sponsorizare corporativă, să urmărească tendințele de finanțare ale dezvoltatorilor și să auditeze sustenabilitatea financiară a proiectelor software critice. Datele servesc ca o fereastră directă către fluxul de capital din cadrul comunității globale de developeri.

De Ce Să Faceți Scraping La Open Collective?

Descoperiți valoarea comercială și cazurile de utilizare pentru extragerea datelor din Open Collective.

Analizarea sustenabilității dependențelor open-source critice

Identificarea potențialelor lead-uri de sponsorizare corporativă pentru servicii B2B

Monitorizarea tendințelor de finanțare descentralizată în diferite stive tehnologice

Efectuarea de cercetări academice asupra sistemelor financiare peer-to-peer

Auditarea cheltuielilor grupurilor non-profit și comunitare pentru transparență

Urmărirea implicării concurenței în sponsorizările proiectelor comunitare

Provocări De Scraping

Provocări tehnice pe care le puteți întâlni când faceți scraping la Open Collective.

Gestionarea interogărilor GraphQL complexe pentru extragerea datelor profund imbricate

Gestionarea proceselor dinamice de hidratare Next.js și a paginării prin scroll infinit

Ocolirea protecției Cloudflare pentru cererile cu frecvență ridicată

Gestionarea limitelor stricte de rată atât pentru API, cât și pentru endpoint-urile web

Extrage date din Open Collective cu AI

Fără cod necesar. Extrage date în câteva minute cu automatizare bazată pe AI.

Cum funcționează

Descrie ce ai nevoie

Spune-i AI-ului ce date vrei să extragi din Open Collective. Scrie pur și simplu în limbaj natural — fără cod sau selectori.

AI-ul extrage datele

Inteligența noastră artificială navighează Open Collective, gestionează conținutul dinamic și extrage exact ceea ce ai cerut.

Primește-ți datele

Primește date curate și structurate gata de export în CSV, JSON sau de trimis direct către aplicațiile tale.

De ce să folosești AI pentru extragere

AI-ul face ușoară extragerea datelor din Open Collective fără a scrie cod. Platforma noastră bazată pe inteligență artificială înțelege ce date dorești — descrie-le în limbaj natural și AI-ul le extrage automat.

How to scrape with AI:

- Descrie ce ai nevoie: Spune-i AI-ului ce date vrei să extragi din Open Collective. Scrie pur și simplu în limbaj natural — fără cod sau selectori.

- AI-ul extrage datele: Inteligența noastră artificială navighează Open Collective, gestionează conținutul dinamic și extrage exact ceea ce ai cerut.

- Primește-ți datele: Primește date curate și structurate gata de export în CSV, JSON sau de trimis direct către aplicațiile tale.

Why use AI for scraping:

- Extrage date financiare complexe fără a scrie interogări GraphQL

- Gestionează automat randarea JavaScript și scroll-ul infinit

- Programează rulări periodice pentru a monitoriza modificările bugetelor proiectelor

- Ocolește măsurile anti-bot prin execuție distribuită în cloud

Scrapere Web No-Code pentru Open Collective

Alternative click-și-selectează la scraping-ul alimentat de AI

Mai multe instrumente no-code precum Browse.ai, Octoparse, Axiom și ParseHub vă pot ajuta să faceți scraping la Open Collective fără a scrie cod. Aceste instrumente folosesc de obicei interfețe vizuale pentru a selecta date, deși pot avea probleme cu conținut dinamic complex sau măsuri anti-bot.

Flux de Lucru Tipic cu Instrumente No-Code

Provocări Comune

Curba de învățare

Înțelegerea selectoarelor și a logicii de extracție necesită timp

Selectoarele se strică

Modificările site-ului web pot distruge întregul flux de lucru

Probleme cu conținut dinamic

Site-urile cu mult JavaScript necesită soluții complexe

Limitări CAPTCHA

Majoritatea instrumentelor necesită intervenție manuală pentru CAPTCHA

Blocarea IP-ului

Scraping-ul agresiv poate duce la blocarea IP-ului dvs.

Scrapere Web No-Code pentru Open Collective

Mai multe instrumente no-code precum Browse.ai, Octoparse, Axiom și ParseHub vă pot ajuta să faceți scraping la Open Collective fără a scrie cod. Aceste instrumente folosesc de obicei interfețe vizuale pentru a selecta date, deși pot avea probleme cu conținut dinamic complex sau măsuri anti-bot.

Flux de Lucru Tipic cu Instrumente No-Code

- Instalați extensia de browser sau înregistrați-vă pe platformă

- Navigați la site-ul web țintă și deschideți instrumentul

- Selectați elementele de date de extras prin point-and-click

- Configurați selectoarele CSS pentru fiecare câmp de date

- Configurați regulile de paginare pentru a scrape mai multe pagini

- Gestionați CAPTCHA (necesită adesea rezolvare manuală)

- Configurați programarea pentru rulări automate

- Exportați datele în CSV, JSON sau conectați prin API

Provocări Comune

- Curba de învățare: Înțelegerea selectoarelor și a logicii de extracție necesită timp

- Selectoarele se strică: Modificările site-ului web pot distruge întregul flux de lucru

- Probleme cu conținut dinamic: Site-urile cu mult JavaScript necesită soluții complexe

- Limitări CAPTCHA: Majoritatea instrumentelor necesită intervenție manuală pentru CAPTCHA

- Blocarea IP-ului: Scraping-ul agresiv poate duce la blocarea IP-ului dvs.

Exemple de cod

import requests

# The Open Collective GraphQL endpoint

url = 'https://api.opencollective.com/graphql/v2'

# GraphQL query to get basic info about a collective

query = '''

query {

collective(slug: "webpack") {

name

stats {

totalAmountReceived { value }

balance { value }

}

}

}

'''

headers = {'Content-Type': 'application/json'}

try:

# Sending POST request to the API

response = requests.post(url, json={'query': query}, headers=headers)

response.raise_for_status()

data = response.json()

# Extracting and printing the name and balance

collective = data['data']['collective']

print(f"Name: {collective['name']}")

print(f"Balance: {collective['stats']['balance']['value']}")

except Exception as e:

print(f"An error occurred: {e}")Când Se Folosește

Cel mai bun pentru pagini HTML statice unde conținutul este încărcat pe server. Cea mai rapidă și simplă abordare când randarea JavaScript nu este necesară.

Avantaje

- ●Execuție cea mai rapidă (fără overhead de browser)

- ●Consum minim de resurse

- ●Ușor de paralelizat cu asyncio

- ●Excelent pentru API-uri și pagini statice

Limitări

- ●Nu poate executa JavaScript

- ●Eșuează pe SPA-uri și conținut dinamic

- ●Poate avea probleme cu sisteme anti-bot complexe

How to Scrape Open Collective with Code

Python + Requests

import requests

# The Open Collective GraphQL endpoint

url = 'https://api.opencollective.com/graphql/v2'

# GraphQL query to get basic info about a collective

query = '''

query {

collective(slug: "webpack") {

name

stats {

totalAmountReceived { value }

balance { value }

}

}

}

'''

headers = {'Content-Type': 'application/json'}

try:

# Sending POST request to the API

response = requests.post(url, json={'query': query}, headers=headers)

response.raise_for_status()

data = response.json()

# Extracting and printing the name and balance

collective = data['data']['collective']

print(f"Name: {collective['name']}")

print(f"Balance: {collective['stats']['balance']['value']}")

except Exception as e:

print(f"An error occurred: {e}")Python + Playwright

from playwright.sync_api import sync_playwright

def scrape_opencollective():

with sync_playwright() as p:

# Launching browser with JS support

browser = p.chromium.launch(headless=True)

page = browser.new_page()

page.goto('https://opencollective.com/discover')

# Wait for collective cards to load

page.wait_for_selector('.CollectiveCard')

# Extract data from the DOM

collectives = page.query_selector_all('.CollectiveCard')

for c in collectives:

name = c.query_selector('h2').inner_text()

print(f'Found project: {name}')

browser.close()

scrape_opencollective()Python + Scrapy

import scrapy

import json

class OpenCollectiveSpider(scrapy.Spider):

name = 'opencollective'

start_urls = ['https://opencollective.com/webpack']

def parse(self, response):

# Open Collective uses Next.js; data is often inside a script tag

next_data = response.xpath('//script[@id="__NEXT_DATA__"]/text()').get()

if next_data:

parsed_data = json.loads(next_data)

collective = parsed_data['props']['pageProps']['collective']

yield {

'name': collective.get('name'),

'balance': collective.get('stats', {}).get('balance'),

'currency': collective.get('currency')

}Node.js + Puppeteer

const puppeteer = require('puppeteer');

(async () => {

const browser = await puppeteer.launch();

const page = await browser.newPage();

await page.goto('https://opencollective.com/discover');

// Wait for the dynamic content to load

await page.waitForSelector('.CollectiveCard');

// Map over elements to extract names

const data = await page.evaluate(() => {

return Array.from(document.querySelectorAll('.CollectiveCard')).map(el => ({

name: el.querySelector('h2').innerText

}));

});

console.log(data);

await browser.close();

})();Ce Puteți Face Cu Datele Open Collective

Explorați aplicațiile practice și informațiile din datele Open Collective.

Prognoza creșterii Open Source

Identifică tehnologiile în tendințe prin urmărirea ratelor de creștere financiară ale unor categorii specifice de colective.

Cum se implementează:

- 1Extrage venitul lunar pentru proiectele de top din categorii specifice

- 2Calculează ratele compuse anuale de creștere (CAGR)

- 3Vizualizează sănătatea finanțării proiectelor pentru a prezice adoptarea tehnologiilor

Folosiți Automatio pentru a extrage date din Open Collective și a construi aceste aplicații fără a scrie cod.

Ce Puteți Face Cu Datele Open Collective

- Prognoza creșterii Open Source

Identifică tehnologiile în tendințe prin urmărirea ratelor de creștere financiară ale unor categorii specifice de colective.

- Extrage venitul lunar pentru proiectele de top din categorii specifice

- Calculează ratele compuse anuale de creștere (CAGR)

- Vizualizează sănătatea finanțării proiectelor pentru a prezice adoptarea tehnologiilor

- Generare de lead-uri pentru SaaS

Identifică proiecte bine finanțate care ar putea avea nevoie de instrumente pentru developeri, găzduire sau servicii profesionale.

- Filtrează colectivele după buget și suma totală strânsă

- Extrage descrierile proiectelor și URL-urile site-urilor externe

- Verifică stiva tehnologică prin depozitele GitHub asociate

- Audit de filantropie corporativă

Urmărește unde își cheltuiesc marile corporații bugetele alocate contribuțiilor open-source.

- Extrage listele de contribuitori pentru proiectele de top

- Filtrează profilele organizaționale față de profilele individuale

- Agregă sumele contribuțiilor pe entități corporative

- Cercetare privind impactul comunitar

Analizează modul în care grupurile descentralizate își distribuie fondurile pentru a înțelege impactul social.

- Extrage întregul registru de tranzacții pentru un anumit colectiv

- Categorisește cheltuielile (călătorii, salarii, hardware)

- Generează rapoarte privind alocarea resurselor în cadrul grupurilor comunitare

- Pipeline de recrutare developeri

Găsește lideri activi în ecosisteme specifice pe baza istoricului lor de gestionare a comunității și de contribuții.

- Extrage listele de membri ai colectivelor tehnice cheie

- Corelează contribuitorii cu profilele lor publice de social media

- Identifică menținătorii activi pentru inițiative de outreach la nivel înalt

Supraalimenteaza-ti fluxul de lucru cu automatizare AI

Automatio combina puterea agentilor AI, automatizarea web si integrarile inteligente pentru a te ajuta sa realizezi mai mult in mai putin timp.

Sfaturi Pro Pentru Scraping La Open Collective

Sfaturi de la experți pentru extragerea cu succes a datelor din Open Collective.

Prioritizează API-ul oficial GraphQL în detrimentul web scraping-ului pentru rezultate mai stabile și mai bine structurate.

Atunci când extragi date din front-end, utilizează atributele 'data-cy' în selectori pentru o mai bună stabilitate în timpul actualizărilor site-ului.

Implementează o întârziere aleatorie între 2 și 5 secunde pentru a simula navigarea umană și pentru a evita declanșarea mecanismelor de rate-limiting.

Folosește proxy-uri rezidențiale rotative dacă trebuie să efectuezi volume mari de căutări prin pagina /discover.

Verifică fișierul robots.txt pentru a te asigura că frecvența de scraping respectă parametrii crawl-delay permiși de site.

Testimoniale

Ce spun utilizatorii nostri

Alatura-te miilor de utilizatori multumiti care si-au transformat fluxul de lucru

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Similar Web Scraping

How to Scrape Moon.ly | Step-by-Step NFT Data Extraction Guide

How to Scrape Yahoo Finance: Extract Stock Market Data

How to Scrape Rocket Mortgage: A Comprehensive Guide

How to Scrape jup.ag: Jupiter DEX Web Scraper Guide

How to Scrape Indiegogo: The Ultimate Crowdfunding Data Extraction Guide

How to Scrape ICO Drops: Comprehensive Crypto Data Guide

How to Scrape Crypto.com: Comprehensive Market Data Guide

How to Scrape Coinpaprika: Crypto Market Data Extraction Guide

Intrebari frecvente despre Open Collective

Gaseste raspunsuri la intrebarile comune despre Open Collective