Cum să faci scraping pe Seeking Alpha: Date Financiare și Transcrieri

Învață cum să faci scraping pe Seeking Alpha pentru știri bursiere, ratinguri de analiști și transcrieri de earnings. Învață să ocolești Cloudflare și să...

Protecție anti-bot detectată

- Cloudflare

- WAF și gestionare bot de nivel enterprise. Folosește provocări JavaScript, CAPTCHA și analiză comportamentală. Necesită automatizare browser cu setări stealth.

- DataDome

- Detectare de boți în timp real cu modele ML. Analizează amprenta dispozitivului, semnale de rețea și tipare comportamentale. Comun pe site-urile de e-commerce.

- Google reCAPTCHA

- Sistemul CAPTCHA al Google. v2 necesită interacțiunea utilizatorului, v3 rulează silențios cu scor de risc. Poate fi rezolvat cu servicii CAPTCHA.

- Limitarea ratei

- Limitează cererile per IP/sesiune în timp. Poate fi ocolit cu proxy-uri rotative, întârzieri ale cererilor și scraping distribuit.

- Blocare IP

- Blochează IP-urile cunoscute ale centrelor de date și adresele semnalate. Necesită proxy-uri rezidențiale sau mobile pentru ocolire eficientă.

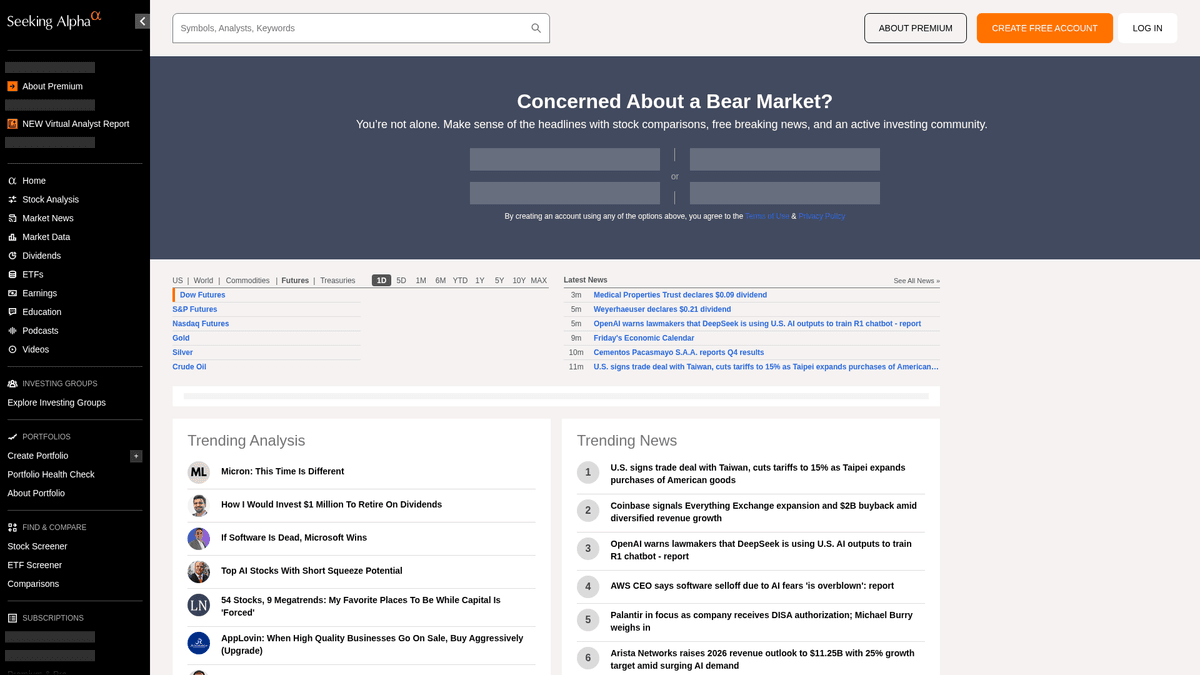

Despre Seeking Alpha

Descoperiți ce oferă Seeking Alpha și ce date valoroase pot fi extrase.

Centrul principal pentru inteligență financiară

Seeking Alpha este o platformă de cercetare financiară de top bazată pe crowd-sourcing, care servește ca o punte vitală între datele brute de piață și perspectivele de investiții aplicabile. Găzduiește o bibliotecă extinsă de articole de analiză, știri de piață în timp real și cel mai cuprinzător depozit de transcrieri de earnings din internet pentru mii de companii tranzacționate public.

Ecosistem de date diversificat

Platforma oferă o multitudine de date structurate și nestructurate, inclusiv idei de acțiuni, istoricul dividendelor și ratingurile proprii Quant care depășesc piața. Gestionat de o echipă editorială profesionistă, conținutul este generat de mii de analiști independenți ale căror contribuții trebuie să îndeplinească standarde înalte de calitate și conformitate înainte de publicare.

Valoare strategică pentru extracția datelor

Scraping-ul pe Seeking Alpha este esențial pentru analiștii financiari și traderii cantitativi care efectuează sentiment analysis, urmăresc tendințele istorice ale veniturilor și monitorizează știrile pentru anumite simboluri bursiere (tickers). Datele oferă perspective granulare asupra psihologiei pieței și performanței corporative, care pot fi utilizate pentru a construi modele financiare sofisticate și pentru a realiza inteligență competitivă.

De Ce Să Faceți Scraping La Seeking Alpha?

Descoperiți valoarea comercială și cazurile de utilizare pentru extragerea datelor din Seeking Alpha.

Construirea de motoare de analiză cantitativă a sentimentului pentru tranzacționare algoritmică

Agregarea transcrierilor de earnings pentru cercetare financiară bazată pe LLM

Monitorizarea schimbărilor de dividende și a ratelor de plată pentru portofolii de venituri

Urmărirea performanței analiștilor și a schimbărilor de rating în sectoare specifice

Dezvoltarea de dashboard-uri de știri de piață în timp real pentru clienți instituționali

Efectuarea de analize competitive istorice pe baza previziunilor companiei vs. rezultate

Provocări De Scraping

Provocări tehnice pe care le puteți întâlni când faceți scraping la Seeking Alpha.

Detectare anti-bot agresivă folosind securitatea de perimetru Cloudflare și DataDome

Cerințe de autentificare pentru accesarea transcrierilor complete de earnings

Încărcarea dinamică a datelor prin AJAX/XHR care necesită randare completă în browser

Limitare de rată sofisticată care declanșează interdicții IP persistente pentru cereri de înaltă frecvență

Structuri HTML complexe cu selectori CSS care se schimbă frecvent

Extrage date din Seeking Alpha cu AI

Fără cod necesar. Extrage date în câteva minute cu automatizare bazată pe AI.

Cum funcționează

Descrie ce ai nevoie

Spune-i AI-ului ce date vrei să extragi din Seeking Alpha. Scrie pur și simplu în limbaj natural — fără cod sau selectori.

AI-ul extrage datele

Inteligența noastră artificială navighează Seeking Alpha, gestionează conținutul dinamic și extrage exact ceea ce ai cerut.

Primește-ți datele

Primește date curate și structurate gata de export în CSV, JSON sau de trimis direct către aplicațiile tale.

De ce să folosești AI pentru extragere

AI-ul face ușoară extragerea datelor din Seeking Alpha fără a scrie cod. Platforma noastră bazată pe inteligență artificială înțelege ce date dorești — descrie-le în limbaj natural și AI-ul le extrage automat.

How to scrape with AI:

- Descrie ce ai nevoie: Spune-i AI-ului ce date vrei să extragi din Seeking Alpha. Scrie pur și simplu în limbaj natural — fără cod sau selectori.

- AI-ul extrage datele: Inteligența noastră artificială navighează Seeking Alpha, gestionează conținutul dinamic și extrage exact ceea ce ai cerut.

- Primește-ți datele: Primește date curate și structurate gata de export în CSV, JSON sau de trimis direct către aplicațiile tale.

Why use AI for scraping:

- Mediul no-code elimină necesitatea gestionării bibliotecilor complexe de automatizare a browserului

- Capacitate încorporată de a gestiona site-uri cu JavaScript intens și încărcare dinamică a conținutului

- Execuția în cloud permite colectarea programată de volume mari de date fără resurse locale

- Gestionarea automată a tiparelor standard de detectare anti-bot și a amprentelor de browser

Scrapere Web No-Code pentru Seeking Alpha

Alternative click-și-selectează la scraping-ul alimentat de AI

Mai multe instrumente no-code precum Browse.ai, Octoparse, Axiom și ParseHub vă pot ajuta să faceți scraping la Seeking Alpha fără a scrie cod. Aceste instrumente folosesc de obicei interfețe vizuale pentru a selecta date, deși pot avea probleme cu conținut dinamic complex sau măsuri anti-bot.

Flux de Lucru Tipic cu Instrumente No-Code

Provocări Comune

Curba de învățare

Înțelegerea selectoarelor și a logicii de extracție necesită timp

Selectoarele se strică

Modificările site-ului web pot distruge întregul flux de lucru

Probleme cu conținut dinamic

Site-urile cu mult JavaScript necesită soluții complexe

Limitări CAPTCHA

Majoritatea instrumentelor necesită intervenție manuală pentru CAPTCHA

Blocarea IP-ului

Scraping-ul agresiv poate duce la blocarea IP-ului dvs.

Scrapere Web No-Code pentru Seeking Alpha

Mai multe instrumente no-code precum Browse.ai, Octoparse, Axiom și ParseHub vă pot ajuta să faceți scraping la Seeking Alpha fără a scrie cod. Aceste instrumente folosesc de obicei interfețe vizuale pentru a selecta date, deși pot avea probleme cu conținut dinamic complex sau măsuri anti-bot.

Flux de Lucru Tipic cu Instrumente No-Code

- Instalați extensia de browser sau înregistrați-vă pe platformă

- Navigați la site-ul web țintă și deschideți instrumentul

- Selectați elementele de date de extras prin point-and-click

- Configurați selectoarele CSS pentru fiecare câmp de date

- Configurați regulile de paginare pentru a scrape mai multe pagini

- Gestionați CAPTCHA (necesită adesea rezolvare manuală)

- Configurați programarea pentru rulări automate

- Exportați datele în CSV, JSON sau conectați prin API

Provocări Comune

- Curba de învățare: Înțelegerea selectoarelor și a logicii de extracție necesită timp

- Selectoarele se strică: Modificările site-ului web pot distruge întregul flux de lucru

- Probleme cu conținut dinamic: Site-urile cu mult JavaScript necesită soluții complexe

- Limitări CAPTCHA: Majoritatea instrumentelor necesită intervenție manuală pentru CAPTCHA

- Blocarea IP-ului: Scraping-ul agresiv poate duce la blocarea IP-ului dvs.

Exemple de cod

import requests

from bs4 import BeautifulSoup

# URL for the latest market news

url = 'https://seekingalpha.com/market-news'

# Standard browser headers to mimic human behavior

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/120.0.0.0 Safari/537.36',

'Accept-Language': 'en-US,en;q=0.9',

'Referer': 'https://seekingalpha.com/'

}

def scrape_sa_news():

try:

response = requests.get(url, headers=headers, timeout=10)

if response.status_code == 200:

soup = BeautifulSoup(response.text, 'html.parser')

# Extract headlines using data-test-id attributes

headlines = soup.find_all('a', {'data-test-id': 'post-list-item-title'})

for item in headlines:

print(f'News Title: {item.text.strip()}')

else:

print(f'Blocked with status: {response.status_code}')

except Exception as e:

print(f'Error occurred: {e}')

if __name__ == "__main__":

scrape_sa_news()Când Se Folosește

Cel mai bun pentru pagini HTML statice unde conținutul este încărcat pe server. Cea mai rapidă și simplă abordare când randarea JavaScript nu este necesară.

Avantaje

- ●Execuție cea mai rapidă (fără overhead de browser)

- ●Consum minim de resurse

- ●Ușor de paralelizat cu asyncio

- ●Excelent pentru API-uri și pagini statice

Limitări

- ●Nu poate executa JavaScript

- ●Eșuează pe SPA-uri și conținut dinamic

- ●Poate avea probleme cu sisteme anti-bot complexe

How to Scrape Seeking Alpha with Code

Python + Requests

import requests

from bs4 import BeautifulSoup

# URL for the latest market news

url = 'https://seekingalpha.com/market-news'

# Standard browser headers to mimic human behavior

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/120.0.0.0 Safari/537.36',

'Accept-Language': 'en-US,en;q=0.9',

'Referer': 'https://seekingalpha.com/'

}

def scrape_sa_news():

try:

response = requests.get(url, headers=headers, timeout=10)

if response.status_code == 200:

soup = BeautifulSoup(response.text, 'html.parser')

# Extract headlines using data-test-id attributes

headlines = soup.find_all('a', {'data-test-id': 'post-list-item-title'})

for item in headlines:

print(f'News Title: {item.text.strip()}')

else:

print(f'Blocked with status: {response.status_code}')

except Exception as e:

print(f'Error occurred: {e}')

if __name__ == "__main__":

scrape_sa_news()Python + Playwright

from playwright.sync_api import sync_playwright

def run(playwright):

# Launching a Chromium browser

browser = playwright.chromium.launch(headless=True)

context = browser.new_context(

user_agent='Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/120.0.0.0 Safari/537.36'

)

page = context.new_page()

try:

# Navigating to a specific stock symbol page

page.goto('https://seekingalpha.com/symbol/AAPL/transcripts')

# Wait for the main content to render dynamically

page.wait_for_selector('article', timeout=15000)

# Locate and extract transcript titles

titles = page.locator('h3').all_inner_texts()

for title in titles:

print(f'Found Transcript: {title}')

except Exception as e:

print(f'Extraction failed: {e}')

finally:

browser.close()

with sync_playwright() as playwright:

run(playwright)Python + Scrapy

import scrapy

class SeekingAlphaSpider(scrapy.Spider):

name = 'sa_spider'

allowed_domains = ['seekingalpha.com']

start_urls = ['https://seekingalpha.com/latest-articles']

custom_settings = {

'DOWNLOAD_DELAY': 8,

'USER_AGENT': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) Chrome/120.0.0.0',

'ROBOTSTXT_OBEY': False,

'COOKIES_ENABLED': True

}

def parse(self, response):

for article in response.css('article'):

yield {

'title': article.css('h3 a::text').get(),

'link': response.urljoin(article.css('h3 a::attr(href)').get()),

'author': article.css('span[data-test-id="author-name"]::text').get()

}

# Handle simple pagination via 'next' links

next_page = response.css('a.next_page::attr(href)').get()

if next_page:

yield response.follow(next_page, self.parse)Node.js + Puppeteer

const puppeteer = require('puppeteer');

(async () => {

const browser = await puppeteer.launch({ headless: true });

const page = await browser.newPage();

// Set high-quality User-Agent

await page.setUserAgent('Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/120.0.0.0 Safari/537.36');

try {

// Navigate to Seeking Alpha homepage

await page.goto('https://seekingalpha.com/', { waitUntil: 'networkidle2' });

// Evaluate scripts in the browser context to extract titles

const trending = await page.evaluate(() => {

const nodes = Array.from(document.querySelectorAll('h3'));

return nodes.map(n => n.innerText.trim());

});

console.log('Trending Content:', trending);

} catch (err) {

console.error('Puppeteer encountered an error:', err);

} finally {

await browser.close();

}

})();Ce Puteți Face Cu Datele Seeking Alpha

Explorați aplicațiile practice și informațiile din datele Seeking Alpha.

Analiza cantitativă a sentimentului

Firmele financiare folosesc articolele analiștilor pentru a determina sentimentul pieței pentru sectoare specifice de acțiuni.

Cum se implementează:

- 1Extrage toate articolele de analiză pentru un anumit simbol bursier din industrie.

- 2Procesează conținutul printr-un motor NLP pentru a calcula polaritatea sentimentului.

- 3Integrează scorurile de sentiment în algoritmi de tranzacționare existenți.

- 4Declanșează alerte automate de cumpărare/vânzare bazate pe schimbările de sentiment.

Folosiți Automatio pentru a extrage date din Seeking Alpha și a construi aceste aplicații fără a scrie cod.

Ce Puteți Face Cu Datele Seeking Alpha

- Analiza cantitativă a sentimentului

Firmele financiare folosesc articolele analiștilor pentru a determina sentimentul pieței pentru sectoare specifice de acțiuni.

- Extrage toate articolele de analiză pentru un anumit simbol bursier din industrie.

- Procesează conținutul printr-un motor NLP pentru a calcula polaritatea sentimentului.

- Integrează scorurile de sentiment în algoritmi de tranzacționare existenți.

- Declanșează alerte automate de cumpărare/vânzare bazate pe schimbările de sentiment.

- Extracția perspectivelor de earnings

Extrage previziunile corporative critice direct din transcrierile de earnings pentru raportare rapidă.

- Automatizează un scraping zilnic al secțiunii Earnings Transcripts.

- Caută cuvinte cheie financiare specifice precum „EBITDA” sau „Outlook”.

- Isolează propozițiile care conțin metrici de management guidance.

- Exportă rezultatele într-un CSV structurat pentru revizuirea comitetului de investiții.

- Benchmarking pentru randamentul dividendelor

Compară performanța dividendelor pentru mii de acțiuni pentru a găsi oportunități de randament.

- Extrage istoricul dividendelor și ratele de plată pentru o listă definită de acțiuni.

- Calculează randamentul mediu vs. tendințele istorice folosind datele extrase.

- Identifică acțiunile care și-au mărit recent distribuția.

- Actualizează un dashboard privat cu comparații de randament în timp real.

- Urmărirea performanței analiștilor

Identifică autorii cu acuratețe ridicată pentru a-i urmări pentru idei de investiții mai bune.

- Extrage ratingurile istorice și articolele de la autorii cu cele mai bune evaluări.

- Corelează datele de publicare a articolelor cu performanța prețului acțiunilor.

- Clasează autorii pe baza acurateței recomandărilor de tip „Buy” sau „Sell”.

- Trimite notificări automate când autorii bine clasați postează idei noi.

Supraalimenteaza-ti fluxul de lucru cu automatizare AI

Automatio combina puterea agentilor AI, automatizarea web si integrarile inteligente pentru a te ajuta sa realizezi mai mult in mai putin timp.

Sfaturi Pro Pentru Scraping La Seeking Alpha

Sfaturi de la experți pentru extragerea cu succes a datelor din Seeking Alpha.

Folosește proxy-uri rezidențiale premium pentru a ocoli eficient perimetrul Cloudflare/DataDome.

Rotește șirurile User-Agent și menține amprente de browser consistente în cadrul unei sesiuni.

Implementează timpi de așteptare randomizați între 10 și 30 de secunde pentru a imita tiparele de navigare umană.

Efectuează scraping-ul în timpul închiderii pieței sau în weekend pentru a reduce probabilitatea limitelor de rată cauzate de traficul ridicat.

Examinează tab-ul „Network” din DevTools pentru endpoint-uri de API JSON interne (v3/api) pentru a obține date mai curate.

Păstrează cookie-uri de sesiune persistente dacă trebuie să extragi date din spatele unui perete de autentificare.

Testimoniale

Ce spun utilizatorii nostri

Alatura-te miilor de utilizatori multumiti care si-au transformat fluxul de lucru

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Similar Web Scraping

How to Scrape Yahoo Finance: Extract Stock Market Data

How to Scrape Moon.ly | Step-by-Step NFT Data Extraction Guide

How to Scrape Rocket Mortgage: A Comprehensive Guide

How to Scrape Open Collective: Financial and Contributor Data Guide

How to Scrape jup.ag: Jupiter DEX Web Scraper Guide

How to Scrape Indiegogo: The Ultimate Crowdfunding Data Extraction Guide

How to Scrape ICO Drops: Comprehensive Crypto Data Guide

How to Scrape Crypto.com: Comprehensive Market Data Guide

Intrebari frecvente despre Seeking Alpha

Gaseste raspunsuri la intrebarile comune despre Seeking Alpha