Как парсить Hacker News (news.ycombinator.com)

Узнайте, как парсить Hacker News для извлечения топовых IT-новостей, вакансий и обсуждений в сообществе. Идеально для анализа трендов и рыночных исследований.

Обнаружена защита от ботов

- Ограничение частоты запросов

- Ограничивает количество запросов на IP/сессию за определённое время. Можно обойти с помощью ротации прокси, задержек запросов и распределённого скрапинга.

- Блокировка IP

- Блокирует известные IP дата-центров и отмеченные адреса. Требует резидентных или мобильных прокси для эффективного обхода.

- User-Agent Filtering

О Hacker News

Узнайте, что предлагает Hacker News и какие ценные данные можно извлечь.

Технологический хаб

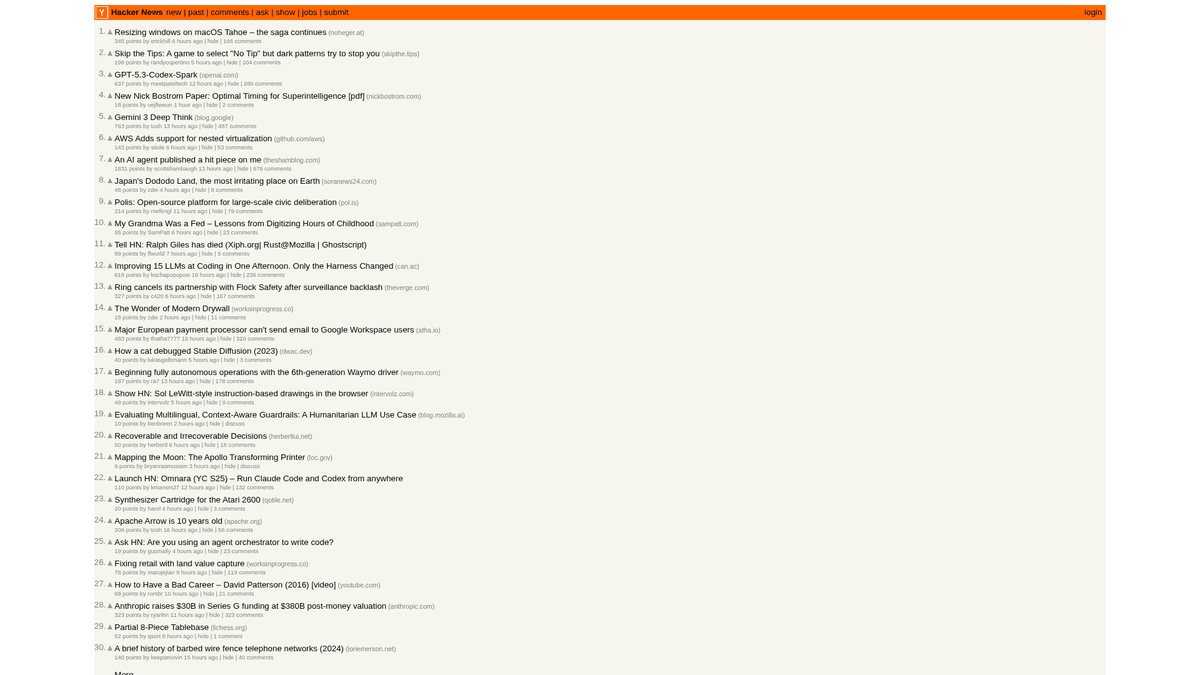

Hacker News — это социальный новостной сайт, ориентированный на компьютерные науки и предпринимательство, управляемый стартап-инкубатором Y Combinator. Он функционирует как платформа, движимая сообществом, где пользователи публикуют ссылки на технические статьи, новости стартапов и глубокие дискуссии.

Богатство данных

Платформа содержит огромное количество данных в реальном времени, включая залайканные IT-истории, запуски стартапов в разделе "Show HN", вопросы сообщества в "Ask HN" и специализированные доски вакансий. Сайт по праву считается пульсом экосистемы Кремниевой долины и мирового сообщества разработчиков.

Стратегическая ценность

Скрапинг этих данных позволяет компаниям и исследователям отслеживать emerging technologies, упоминания конкурентов и выявлять влиятельных лидеров мнений. Поскольку макет сайта крайне стабилен и лаконичен, он является одним из самых надежных источников для автоматизированной агрегации технических новостей.

Зачем Парсить Hacker News?

Узнайте о бизнес-ценности и сценариях использования извлечения данных из Hacker News.

Раннее выявление перспективных языков программирования и инструментов разработки

Мониторинг экосистемы стартапов на предмет новых запусков и новостей об инвестициях

Генерация лидов для технического рекрутинга через треды 'Who is Hiring'

Анализ тональности отзывов о новых релизах ПО и корпоративных анонсах

Создание качественных агрегаторов технических новостей для нишевых аудиторий

Академические исследования распространения информации в технических сообществах

Проблемы При Парсинге

Технические проблемы, с которыми вы можете столкнуться при парсинге Hacker News.

Парсинг вложенных структур HTML-таблиц, используемых для верстки

Обработка относительных временных строк типа '2 hours ago' для сохранения в базу данных

Управление серверными лимитами (rate limits), вызывающими временную блокировку IP

Извлечение глубоких иерархий комментариев, распределенных по нескольким страницам

Скрапинг Hacker News с помощью ИИ

Код не нужен. Извлекайте данные за минуты с автоматизацией на базе ИИ.

Как это работает

Опишите, что вам нужно

Расскажите ИИ, какие данные вы хотите извлечь из Hacker News. Просто напишите на обычном языке — без кода и селекторов.

ИИ извлекает данные

Наш искусственный интеллект навигирует по Hacker News, обрабатывает динамический контент и извлекает именно то, что вы запросили.

Получите ваши данные

Получите чистые, структурированные данные, готовые к экспорту в CSV, JSON или отправке напрямую в ваши приложения.

Почему стоит использовать ИИ для скрапинга

ИИ упрощает скрапинг Hacker News без написания кода. Наша платформа на базе искусственного интеллекта понимает, какие данные вам нужны — просто опишите их на обычном языке, и ИИ извлечёт их автоматически.

How to scrape with AI:

- Опишите, что вам нужно: Расскажите ИИ, какие данные вы хотите извлечь из Hacker News. Просто напишите на обычном языке — без кода и селекторов.

- ИИ извлекает данные: Наш искусственный интеллект навигирует по Hacker News, обрабатывает динамический контент и извлекает именно то, что вы запросили.

- Получите ваши данные: Получите чистые, структурированные данные, готовые к экспорту в CSV, JSON или отправке напрямую в ваши приложения.

Why use AI for scraping:

- Выбор нужных новостей простым кликом (point-and-click) без написания сложных CSS-селекторов

- Автоматическая обработка кнопки 'More' для бесшовной пагинации

- Встроенное облачное исполнение для предотвращения блокировки вашего локального IP

- Запуск скрапинга по расписанию для автоматического сбора данных с главной страницы каждый час

- Прямой экспорт в Google Таблицы или через Webhooks для оповещений в реальном времени

No-Code Парсеры для Hacker News

Point-and-click альтернативы AI-парсингу

Несколько no-code инструментов, таких как Browse.ai, Octoparse, Axiom и ParseHub, могут помочь парсить Hacker News без написания кода. Эти инструменты используют визуальные интерфейсы для выбора данных, хотя могут иметь проблемы со сложным динамическим контентом или антибот-защитой.

Типичный Рабочий Процесс с No-Code Инструментами

Частые Проблемы

Кривая обучения

Понимание селекторов и логики извлечения требует времени

Селекторы ломаются

Изменения на сайте могут сломать весь рабочий процесс

Проблемы с динамическим контентом

Сайты с большим количеством JavaScript требуют сложных обходных путей

Ограничения CAPTCHA

Большинство инструментов требуют ручного вмешательства для CAPTCHA

Блокировка IP

Агрессивный парсинг может привести к блокировке вашего IP

No-Code Парсеры для Hacker News

Несколько no-code инструментов, таких как Browse.ai, Octoparse, Axiom и ParseHub, могут помочь парсить Hacker News без написания кода. Эти инструменты используют визуальные интерфейсы для выбора данных, хотя могут иметь проблемы со сложным динамическим контентом или антибот-защитой.

Типичный Рабочий Процесс с No-Code Инструментами

- Установить расширение браузера или зарегистрироваться на платформе

- Перейти на целевой сайт и открыть инструмент

- Выбрать элементы данных для извлечения методом point-and-click

- Настроить CSS-селекторы для каждого поля данных

- Настроить правила пагинации для парсинга нескольких страниц

- Обработать CAPTCHA (часто требуется ручное решение)

- Настроить расписание для автоматических запусков

- Экспортировать данные в CSV, JSON или подключить через API

Частые Проблемы

- Кривая обучения: Понимание селекторов и логики извлечения требует времени

- Селекторы ломаются: Изменения на сайте могут сломать весь рабочий процесс

- Проблемы с динамическим контентом: Сайты с большим количеством JavaScript требуют сложных обходных путей

- Ограничения CAPTCHA: Большинство инструментов требуют ручного вмешательства для CAPTCHA

- Блокировка IP: Агрессивный парсинг может привести к блокировке вашего IP

Примеры кода

import requests

from bs4 import BeautifulSoup

url = 'https://news.ycombinator.com/'

headers = {'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36'}

try:

response = requests.get(url, headers=headers)

response.raise_for_status()

soup = BeautifulSoup(response.text, 'html.parser')

# Новости находятся в строках с классом 'athing'

posts = soup.select('.athing')

for post in posts:

title_element = post.select_one('.titleline > a')

title = title_element.text

link = title_element['href']

print(f'Заголовок: {title}

Ссылка: {link}

---')

except Exception as e:

print(f'Ошибка скрапинга: {e}')Когда Использовать

Лучше всего для статических HTML-страниц с минимальным JavaScript. Идеально для блогов, новостных сайтов и простых страниц товаров электронной коммерции.

Преимущества

- ●Самое быстрое выполнение (без нагрузки браузера)

- ●Минимальное потребление ресурсов

- ●Легко распараллелить с asyncio

- ●Отлично для API и статических страниц

Ограничения

- ●Не может выполнять JavaScript

- ●Не работает на SPA и динамическом контенте

- ●Может иметь проблемы со сложными антибот-системами

Как парсить Hacker News с помощью кода

Python + Requests

import requests

from bs4 import BeautifulSoup

url = 'https://news.ycombinator.com/'

headers = {'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36'}

try:

response = requests.get(url, headers=headers)

response.raise_for_status()

soup = BeautifulSoup(response.text, 'html.parser')

# Новости находятся в строках с классом 'athing'

posts = soup.select('.athing')

for post in posts:

title_element = post.select_one('.titleline > a')

title = title_element.text

link = title_element['href']

print(f'Заголовок: {title}

Ссылка: {link}

---')

except Exception as e:

print(f'Ошибка скрапинга: {e}')Python + Playwright

from playwright.sync_api import sync_playwright

with sync_playwright() as p:

browser = p.chromium.launch(headless=True)

page = browser.new_page()

page.goto('https://news.ycombinator.com/')

# Ожидание загрузки таблицы

page.wait_for_selector('.athing')

# Извлечение всех заголовков и ссылок

items = page.query_selector_all('.athing')

for item in items:

title_link = item.query_selector('.titleline > a')

if title_link:

print(title_link.inner_text(), title_link.get_attribute('href'))

browser.close()Python + Scrapy

import scrapy

class HackerNewsSpider(scrapy.Spider):

name = 'hn_spider'

start_urls = ['https://news.ycombinator.com/']

def parse(self, response):

for post in response.css('.athing'):

yield {

'id': post.attrib.get('id'),

'title': post.css('.titleline > a::text').get(),

'link': post.css('.titleline > a::attr(href)').get(),

}

# Переход по ссылке пагинации 'More'

next_page = response.css('a.morelink::attr(href)').get()

if next_page:

yield response.follow(next_page, self.parse)Node.js + Puppeteer

const puppeteer = require('puppeteer');

(async () => {

const browser = await puppeteer.launch();

const page = await browser.newPage();

await page.goto('https://news.ycombinator.com/');

const results = await page.evaluate(() => {

const items = Array.from(document.querySelectorAll('.athing'));

return items.map(item => ({

title: item.querySelector('.titleline > a').innerText,

url: item.querySelector('.titleline > a').href

}));

});

console.log(results);

await browser.close();

})();Что Можно Делать С Данными Hacker News

Изучите практические применения и инсайты из данных Hacker News.

Поиск стартап-трендов

Определяйте, какие отрасли или типы продуктов запускаются и обсуждаются чаще всего.

Как реализовать:

- 1Еженедельно парсите категорию 'Show HN'.

- 2Очищайте и категоризируйте описания стартапов с помощью NLP.

- 3Ранжируйте тренды на основе апвоутов сообщества и тональности комментариев.

Используйте Automatio для извлечения данных из Hacker News и создания этих приложений без написания кода.

Что Можно Делать С Данными Hacker News

- Поиск стартап-трендов

Определяйте, какие отрасли или типы продуктов запускаются и обсуждаются чаще всего.

- Еженедельно парсите категорию 'Show HN'.

- Очищайте и категоризируйте описания стартапов с помощью NLP.

- Ранжируйте тренды на основе апвоутов сообщества и тональности комментариев.

- Технический сорсинг и рекрутинг

Извлекайте объявления о работе и данные о компаниях из специализированных ежемесячных тредов по найму.

- Отслеживайте ID ежемесячного треда 'Who is hiring'.

- Собирайте все комментарии первого уровня, содержащие описания вакансий.

- Анализируйте текст на наличие специфических стеков технологий, таких как Rust, AI или React.

- Конкурентная разведка

Отслеживайте упоминания конкурентов в комментариях, чтобы понимать восприятие аудитории и основные жалобы.

- Настройте скрапер по ключевым словам для конкретных брендов.

- Извлекайте комментарии пользователей и временные метки для анализа тональности.

- Создавайте еженедельные отчеты о репутации бренда в сравнении с конкурентами.

- Автоматизированная курация контента

Создайте высококачественную техническую рассылку, включающую только самые актуальные истории.

- Парсите главную страницу каждые 6 часов.

- Фильтруйте посты, набравшие более 200 баллов.

- Автоматизируйте отправку этих ссылок в Telegram-бота или на электронную почту.

- Генерация лидов для венчурных инвестиций

Находите стартапы на ранних стадиях, которые получают значительный отклик в сообществе.

- Отслеживайте посты в 'Show HN', попавшие на главную страницу.

- Мониторьте скорость роста апвоутов в первые 4 часа.

- Оповещайте аналитиков, когда пост демонстрирует признаки вирального роста.

Улучшите свой рабочий процесс с ИИ-Автоматизацией

Automatio объединяет мощь ИИ-агентов, веб-автоматизации и умных интеграций, чтобы помочь вам достигать большего за меньшее время.

Советы Профессионала По Парсингу Hacker News

Экспертные советы для успешного извлечения данных из Hacker News.

Используйте официальный Firebase API для сбора больших объемов исторических данных, чтобы избежать сложностей с парсингом HTML.

Всегда устанавливайте кастомный User-Agent, чтобы ответственно идентифицировать своего бота и избежать мгновенной блокировки.

Реализуйте случайный интервал задержки (sleep) от 3 до 7 секунд между запросами для имитации поведения реального пользователя.

Таргетируйте конкретные подразделы, такие как /newest для свежих историй или /ask для обсуждений внутри сообщества.

Сохраняйте 'Item ID' как первичный ключ, чтобы избежать дублирования записей при частом скрапинге главной страницы.

Выполняйте скрапинг в часы низкой нагрузки (ночь по UTC), чтобы получить более высокую скорость ответа и снизить риски rate-limiting.

Отзывы

Что Говорят Наши Пользователи

Присоединяйтесь к тысячам довольных пользователей, которые трансформировали свой рабочий процесс

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Похожие Web Scraping

Часто задаваемые вопросы о Hacker News

Найдите ответы на частые вопросы о Hacker News