Как скрейпить Open Collective: руководство по сбору финансовых данных и данных о контрибьюторах

Узнайте, как скрейпить Open Collective для сбора транзакций, списков контрибьюторов и данных о бюджетах проектов. Руководство по извлечению прозрачных данных.

Обнаружена защита от ботов

- Cloudflare

- Корпоративный WAF и управление ботами. Использует JavaScript-проверки, CAPTCHA и анализ поведения. Требует автоматизации браузера со скрытыми настройками.

- Ограничение частоты запросов

- Ограничивает количество запросов на IP/сессию за определённое время. Можно обойти с помощью ротации прокси, задержек запросов и распределённого скрапинга.

- WAF

О Open Collective

Узнайте, что предлагает Open Collective и какие ценные данные можно извлечь.

Об Open Collective

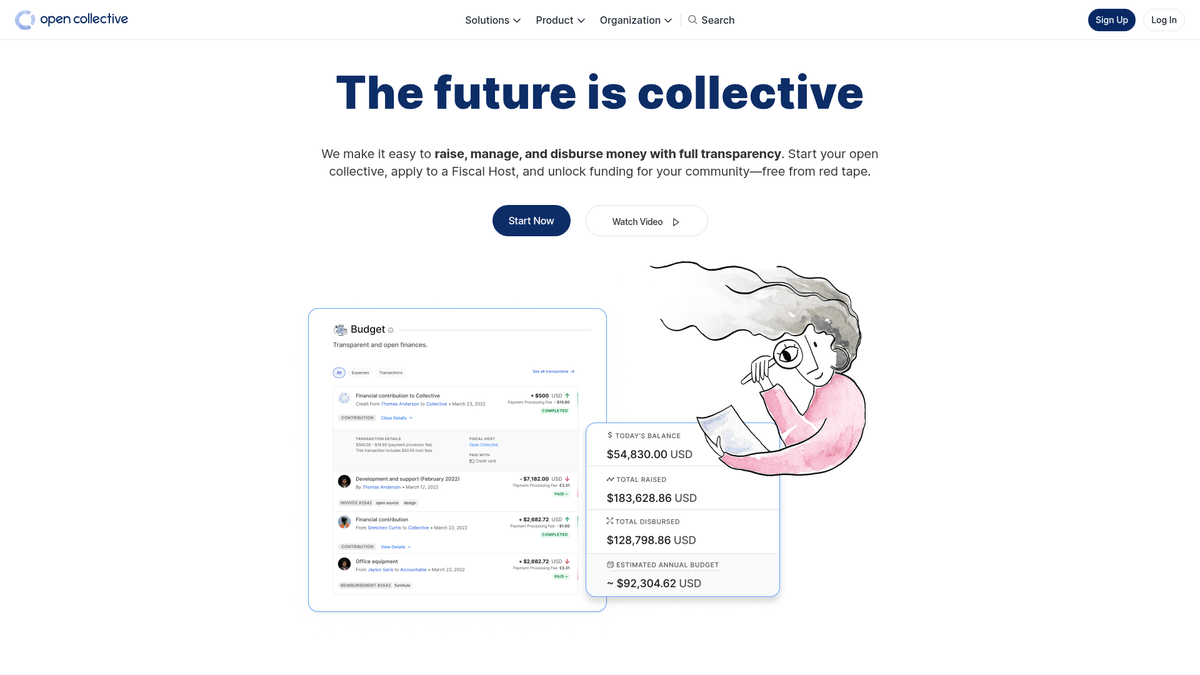

Open Collective — это уникальная финансовая и юридическая платформа, созданная для обеспечения прозрачности сообществ, open-source проектов и районных ассоциаций. Выступая в качестве децентрализованного инструмента финансирования, она позволяет «коллективам» собирать деньги и управлять расходами без необходимости создания официального юридического лица, часто используя фискальных хостов для административной поддержки. Крупные технологические проекты, такие как Babel и Webpack, полагаются на эту платформу для управления своими экосистемами, финансируемыми сообществом.

Платформа известна своей радикальной прозрачностью. Каждая транзакция, будь то пожертвование от крупной корпорации или небольшой расход на встречу сообщества, логируется и видна публично. Это дает огромный объем данных о финансовом состоянии и привычках расходования средств некоторых из самых важных в мире open-source зависимостей.

Скрейпинг Open Collective представляет большую ценность для организаций, желающих провести маркетинговое исследование экономики open-source. Это позволяет пользователям выявлять потенциальных корпоративных спонсоров, отслеживать тенденции финансирования разработчиков и проводить аудит финансовой устойчивости критически важных программных проектов. Эти данные служат прямым окном в поток капитала внутри глобального сообщества разработчиков.

Зачем Парсить Open Collective?

Узнайте о бизнес-ценности и сценариях использования извлечения данных из Open Collective.

Анализ устойчивости критически важных open-source зависимостей

Поиск потенциальных корпоративных спонсоров для B2B услуг

Мониторинг тенденций децентрализованного финансирования в различных технологических стеках

Проведение академических исследований децентрализованных финансовых систем

Аудит расходов некоммерческих организаций и сообществ для обеспечения прозрачности

Отслеживание участия конкурентов в спонсировании проектов сообщества

Проблемы При Парсинге

Технические проблемы, с которыми вы можете столкнуться при парсинге Open Collective.

Управление сложными GraphQL-запросами для глубоко вложенного извлечения данных

Обработка динамической гидратации Next.js и пагинации бесконечного скролла

Обход защиты Cloudflare при высокой частоте запросов

Работа со строгими rate limits как на API, так и на веб-эндпоинтах

Скрапинг Open Collective с помощью ИИ

Код не нужен. Извлекайте данные за минуты с автоматизацией на базе ИИ.

Как это работает

Опишите, что вам нужно

Расскажите ИИ, какие данные вы хотите извлечь из Open Collective. Просто напишите на обычном языке — без кода и селекторов.

ИИ извлекает данные

Наш искусственный интеллект навигирует по Open Collective, обрабатывает динамический контент и извлекает именно то, что вы запросили.

Получите ваши данные

Получите чистые, структурированные данные, готовые к экспорту в CSV, JSON или отправке напрямую в ваши приложения.

Почему стоит использовать ИИ для скрапинга

ИИ упрощает скрапинг Open Collective без написания кода. Наша платформа на базе искусственного интеллекта понимает, какие данные вам нужны — просто опишите их на обычном языке, и ИИ извлечёт их автоматически.

How to scrape with AI:

- Опишите, что вам нужно: Расскажите ИИ, какие данные вы хотите извлечь из Open Collective. Просто напишите на обычном языке — без кода и селекторов.

- ИИ извлекает данные: Наш искусственный интеллект навигирует по Open Collective, обрабатывает динамический контент и извлекает именно то, что вы запросили.

- Получите ваши данные: Получите чистые, структурированные данные, готовые к экспорту в CSV, JSON или отправке напрямую в ваши приложения.

Why use AI for scraping:

- Извлечение сложных финансовых данных без написания GraphQL-запросов

- Автоматическая обработка JavaScript рендеринга и бесконечного скролла

- Планирование регулярных запусков для мониторинга изменений в бюджетах проектов

- Обход антибот-систем через распределенное облачное исполнение

No-Code Парсеры для Open Collective

Point-and-click альтернативы AI-парсингу

Несколько no-code инструментов, таких как Browse.ai, Octoparse, Axiom и ParseHub, могут помочь парсить Open Collective без написания кода. Эти инструменты используют визуальные интерфейсы для выбора данных, хотя могут иметь проблемы со сложным динамическим контентом или антибот-защитой.

Типичный Рабочий Процесс с No-Code Инструментами

Частые Проблемы

Кривая обучения

Понимание селекторов и логики извлечения требует времени

Селекторы ломаются

Изменения на сайте могут сломать весь рабочий процесс

Проблемы с динамическим контентом

Сайты с большим количеством JavaScript требуют сложных обходных путей

Ограничения CAPTCHA

Большинство инструментов требуют ручного вмешательства для CAPTCHA

Блокировка IP

Агрессивный парсинг может привести к блокировке вашего IP

No-Code Парсеры для Open Collective

Несколько no-code инструментов, таких как Browse.ai, Octoparse, Axiom и ParseHub, могут помочь парсить Open Collective без написания кода. Эти инструменты используют визуальные интерфейсы для выбора данных, хотя могут иметь проблемы со сложным динамическим контентом или антибот-защитой.

Типичный Рабочий Процесс с No-Code Инструментами

- Установить расширение браузера или зарегистрироваться на платформе

- Перейти на целевой сайт и открыть инструмент

- Выбрать элементы данных для извлечения методом point-and-click

- Настроить CSS-селекторы для каждого поля данных

- Настроить правила пагинации для парсинга нескольких страниц

- Обработать CAPTCHA (часто требуется ручное решение)

- Настроить расписание для автоматических запусков

- Экспортировать данные в CSV, JSON или подключить через API

Частые Проблемы

- Кривая обучения: Понимание селекторов и логики извлечения требует времени

- Селекторы ломаются: Изменения на сайте могут сломать весь рабочий процесс

- Проблемы с динамическим контентом: Сайты с большим количеством JavaScript требуют сложных обходных путей

- Ограничения CAPTCHA: Большинство инструментов требуют ручного вмешательства для CAPTCHA

- Блокировка IP: Агрессивный парсинг может привести к блокировке вашего IP

Примеры кода

import requests

# Эндпоинт Open Collective GraphQL

url = 'https://api.opencollective.com/graphql/v2'

# GraphQL query для получения базовой информации о коллективе

query = '''

query {

collective(slug: "webpack") {

name

stats {

totalAmountReceived { value }

balance { value }

}

}

}

'''

headers = {'Content-Type': 'application/json'}

try:

# Отправка POST-запроса к API

response = requests.post(url, json={'query': query}, headers=headers)

response.raise_for_status()

data = response.json()

# Извлечение и вывод имени и баланса

collective = data['data']['collective']

print(f"Name: {collective['name']}")

print(f"Balance: {collective['stats']['balance']['value']}")

except Exception as e:

print(f"Произошла ошибка: {e}")Когда Использовать

Лучше всего для статических HTML-страниц с минимальным JavaScript. Идеально для блогов, новостных сайтов и простых страниц товаров электронной коммерции.

Преимущества

- ●Самое быстрое выполнение (без нагрузки браузера)

- ●Минимальное потребление ресурсов

- ●Легко распараллелить с asyncio

- ●Отлично для API и статических страниц

Ограничения

- ●Не может выполнять JavaScript

- ●Не работает на SPA и динамическом контенте

- ●Может иметь проблемы со сложными антибот-системами

Как парсить Open Collective с помощью кода

Python + Requests

import requests

# Эндпоинт Open Collective GraphQL

url = 'https://api.opencollective.com/graphql/v2'

# GraphQL query для получения базовой информации о коллективе

query = '''

query {

collective(slug: "webpack") {

name

stats {

totalAmountReceived { value }

balance { value }

}

}

}

'''

headers = {'Content-Type': 'application/json'}

try:

# Отправка POST-запроса к API

response = requests.post(url, json={'query': query}, headers=headers)

response.raise_for_status()

data = response.json()

# Извлечение и вывод имени и баланса

collective = data['data']['collective']

print(f"Name: {collective['name']}")

print(f"Balance: {collective['stats']['balance']['value']}")

except Exception as e:

print(f"Произошла ошибка: {e}")Python + Playwright

from playwright.sync_api import sync_playwright

def scrape_opencollective():

with sync_playwright() as p:

# Запуск браузера с поддержкой JS

browser = p.chromium.launch(headless=True)

page = browser.new_page()

page.goto('https://opencollective.com/discover')

# Ожидание загрузки карточек коллективов

page.wait_for_selector('.CollectiveCard')

# Извлечение данных из DOM

collectives = page.query_selector_all('.CollectiveCard')

for c in collectives:

name = c.query_selector('h2').inner_text()

print(f'Проект найден: {name}')

browser.close()

scrape_opencollective()Python + Scrapy

import scrapy

import json

class OpenCollectiveSpider(scrapy.Spider):

name = 'opencollective'

start_urls = ['https://opencollective.com/webpack']

def parse(self, response):

# Open Collective использует Next.js; данные часто находятся внутри тега script

next_data = response.xpath('//script[@id="__NEXT_DATA__"]/text()').get()

if next_data:

parsed_data = json.loads(next_data)

collective = parsed_data['props']['pageProps']['collective']

yield {

'name': collective.get('name'),

'balance': collective.get('stats', {}).get('balance'),

'currency': collective.get('currency')

}Node.js + Puppeteer

const puppeteer = require('puppeteer');

(async () => {

const browser = await puppeteer.launch();

const page = await browser.newPage();

await page.goto('https://opencollective.com/discover');

// Ожидание загрузки динамического контента

await page.waitForSelector('.CollectiveCard');

// Перебор элементов для извлечения имен

const data = await page.evaluate(() => {

return Array.from(document.querySelectorAll('.CollectiveCard')).map(el => ({

name: el.querySelector('h2').innerText

}));

});

console.log(data);

await browser.close();

})();Что Можно Делать С Данными Open Collective

Изучите практические применения и инсайты из данных Open Collective.

Прогнозирование роста open-source

Выявление трендовых технологий путем отслеживания темпов финансового роста конкретных категорий коллективов.

Как реализовать:

- 1Извлечение ежемесячного дохода топовых проектов по конкретным тегам

- 2Расчет совокупного среднегодового темпа роста (CAGR)

- 3Визуализация финансового здоровья проекта для прогнозирования внедрения технологий

Используйте Automatio для извлечения данных из Open Collective и создания этих приложений без написания кода.

Что Можно Делать С Данными Open Collective

- Прогнозирование роста open-source

Выявление трендовых технологий путем отслеживания темпов финансового роста конкретных категорий коллективов.

- Извлечение ежемесячного дохода топовых проектов по конкретным тегам

- Расчет совокупного среднегодового темпа роста (CAGR)

- Визуализация финансового здоровья проекта для прогнозирования внедрения технологий

- Генерация лидов для SaaS

Поиск хорошо финансируемых проектов, которым могут понадобиться инструменты разработчика, хостинг или профессиональные услуги.

- Фильтрация коллективов по бюджету и общей сумме сборов

- Извлечение описаний проектов и внешних URL-адресов сайтов

- Проверка технологического стека через связанные репозитории GitHub

- Аудит корпоративной филантропии

Отслеживание того, куда крупные корпорации тратят свои бюджеты на поддержку open-source.

- Скрейпинг списков контрибьюторов топовых проектов

- Фильтрация организационных профилей по сравнению с индивидуальными

- Агрегирование сумм вкладов по корпоративным организациям

- Исследование влияния на сообщество

Анализ того, как децентрализованные группы распределяют свои средства для понимания социального эффекта.

- Скрейпинг полной книги транзакций конкретного коллектива

- Категоризация расходов (поездки, зарплаты, оборудование)

- Создание отчетов о распределении ресурсов внутри групп сообщества

- Пайплайн для найма разработчиков

Поиск активных лидеров в конкретных экосистемах на основе их истории управления сообществом и вклада в проекты.

- Скрейпинг списков участников ключевых технических коллективов

- Сопоставление контрибьюторов с их публичными профилями в соцсетях

- Поиск активных мейнтейнеров для высокоуровневого взаимодействия

Улучшите свой рабочий процесс с ИИ-Автоматизацией

Automatio объединяет мощь ИИ-агентов, веб-автоматизации и умных интеграций, чтобы помочь вам достигать большего за меньшее время.

Советы Профессионала По Парсингу Open Collective

Экспертные советы для успешного извлечения данных из Open Collective.

Используйте официальный GraphQL API вместо веб-скрейпинга для получения более стабильных и структурированных результатов.

При скрейпинге фронтенда используйте атрибуты 'data-cy' в ваших селекторах для лучшей стабильности при обновлениях сайта.

Настройте рандомную задержку от 2 до 5 секунд, чтобы имитировать поведение человека и избежать срабатывания систем rate-limiting.

Используйте ротируемые резидентные прокси, если вам нужно выполнять большой объем поисковых запросов через страницу /discover.

Проверьте файл robots.txt, чтобы убедиться, что частота вашего скрейпинга соответствует разрешенным параметрам crawl-delay.

Отзывы

Что Говорят Наши Пользователи

Присоединяйтесь к тысячам довольных пользователей, которые трансформировали свой рабочий процесс

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Похожие Web Scraping

How to Scrape Moon.ly | Step-by-Step NFT Data Extraction Guide

How to Scrape Yahoo Finance: Extract Stock Market Data

How to Scrape Rocket Mortgage: A Comprehensive Guide

How to Scrape jup.ag: Jupiter DEX Web Scraper Guide

How to Scrape Indiegogo: The Ultimate Crowdfunding Data Extraction Guide

How to Scrape ICO Drops: Comprehensive Crypto Data Guide

How to Scrape Crypto.com: Comprehensive Market Data Guide

How to Scrape Coinpaprika: Crypto Market Data Extraction Guide

Часто задаваемые вопросы о Open Collective

Найдите ответы на частые вопросы о Open Collective