Как парсить Seeking Alpha: финансовые данные и стенограммы

Узнайте, как парсить Seeking Alpha для сбора новостей, рейтингов и стенограмм. Инструкция по обходу Cloudflare и автоматическому извлечению финансовых данных.

Обнаружена защита от ботов

- Cloudflare

- Корпоративный WAF и управление ботами. Использует JavaScript-проверки, CAPTCHA и анализ поведения. Требует автоматизации браузера со скрытыми настройками.

- DataDome

- Обнаружение ботов в реальном времени с помощью ML-моделей. Анализирует цифровой отпечаток устройства, сетевые сигналы и паттерны поведения. Часто используется на сайтах электронной коммерции.

- Google reCAPTCHA

- Система CAPTCHA от Google. v2 требует взаимодействия пользователя, v3 работает скрыто с оценкой рисков. Можно решить с помощью сервисов CAPTCHA.

- Ограничение частоты запросов

- Ограничивает количество запросов на IP/сессию за определённое время. Можно обойти с помощью ротации прокси, задержек запросов и распределённого скрапинга.

- Блокировка IP

- Блокирует известные IP дата-центров и отмеченные адреса. Требует резидентных или мобильных прокси для эффективного обхода.

О Seeking Alpha

Узнайте, что предлагает Seeking Alpha и какие ценные данные можно извлечь.

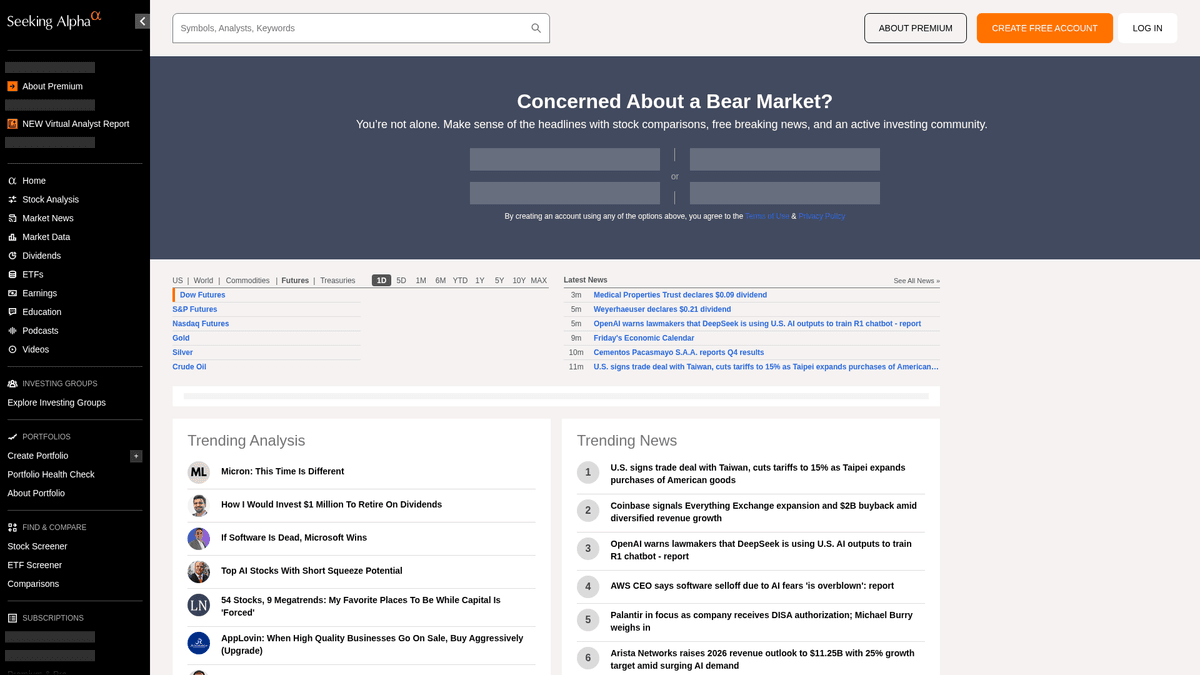

Главный хаб финансовой аналитики

Seeking Alpha — это ведущая краудсорсинговая платформа финансовых исследований, которая служит мостом между сырыми рыночными данными и практическими инвестиционными инсайтами. Здесь собрана обширная библиотека аналитических статей, рыночных новостей в реальном времени и самый полный в интернете репозиторий стенограмм звонков по доходам (earnings transcripts) для тысяч публичных компаний.

Разнообразная экосистема данных

Платформа предлагает огромное количество структурированных и неструктурированных данных, включая инвестиционные идеи, истории дивидендов и проприетарные рейтинги Quant, опережающие рынок. Контент, управляемый профессиональной редакционной группой, создается тысячами независимых аналитиков, чьи материалы проходят строгую проверку на соответствие стандартам качества перед публикацией.

Стратегическая ценность для извлечения данных

Парсинг Seeking Alpha необходим финансовым аналитикам и количественным трейдерам, которые проводят sentiment анализ, отслеживают исторические тренды доходов и мониторят новости по конкретным тикерам. Данные обеспечивают детальное понимание психологии рынка и корпоративных показателей, что позволяет строить сложные финансовые модели и проводить конкурентную разведку.

Зачем Парсить Seeking Alpha?

Узнайте о бизнес-ценности и сценариях использования извлечения данных из Seeking Alpha.

Создание систем количественного sentiment анализа для алгоритмической торговли

Агрегация стенограмм (transcripts) отчетности для финансовых исследований на базе LLM

Мониторинг изменений дивидендов и коэффициентов выплат для инвестиционных портфелей

Отслеживание эффективности аналитиков и изменений рейтингов в конкретных секторах

Разработка дашбордов рыночных новостей в реальном времени для институциональных клиентов

Проведение исторического конкурентного анализа прогнозов компаний в сравнении с результатами

Проблемы При Парсинге

Технические проблемы, с которыми вы можете столкнуться при парсинге Seeking Alpha.

Агрессивная антибот-защита с использованием периметра безопасности Cloudflare и DataDome

Требование авторизации для доступа к полным текстам стенограмм звонков (transcripts)

Динамическая загрузка данных через AJAX/XHR, требующая полного рендеринга браузера

Сложные лимиты запросов (rate limiting), вызывающие перманентные блокировки IP за высокую частоту обращений

Сложная структура HTML с часто меняющимися CSS-селекторами

Скрапинг Seeking Alpha с помощью ИИ

Код не нужен. Извлекайте данные за минуты с автоматизацией на базе ИИ.

Как это работает

Опишите, что вам нужно

Расскажите ИИ, какие данные вы хотите извлечь из Seeking Alpha. Просто напишите на обычном языке — без кода и селекторов.

ИИ извлекает данные

Наш искусственный интеллект навигирует по Seeking Alpha, обрабатывает динамический контент и извлекает именно то, что вы запросили.

Получите ваши данные

Получите чистые, структурированные данные, готовые к экспорту в CSV, JSON или отправке напрямую в ваши приложения.

Почему стоит использовать ИИ для скрапинга

ИИ упрощает скрапинг Seeking Alpha без написания кода. Наша платформа на базе искусственного интеллекта понимает, какие данные вам нужны — просто опишите их на обычном языке, и ИИ извлечёт их автоматически.

How to scrape with AI:

- Опишите, что вам нужно: Расскажите ИИ, какие данные вы хотите извлечь из Seeking Alpha. Просто напишите на обычном языке — без кода и селекторов.

- ИИ извлекает данные: Наш искусственный интеллект навигирует по Seeking Alpha, обрабатывает динамический контент и извлекает именно то, что вы запросили.

- Получите ваши данные: Получите чистые, структурированные данные, готовые к экспорту в CSV, JSON или отправке напрямую в ваши приложения.

Why use AI for scraping:

- No-code среда исключает необходимость управления сложными библиотеками автоматизации браузера

- Встроенная возможность работы с сайтами, перегруженными JavaScript, и динамической загрузкой контента

- Облачное выполнение позволяет осуществлять сбор больших объемов данных по расписанию без локальных ресурсов

- Автоматическая обработка стандартных паттернов антибот-защиты и управление отпечатками браузера

No-Code Парсеры для Seeking Alpha

Point-and-click альтернативы AI-парсингу

Несколько no-code инструментов, таких как Browse.ai, Octoparse, Axiom и ParseHub, могут помочь парсить Seeking Alpha без написания кода. Эти инструменты используют визуальные интерфейсы для выбора данных, хотя могут иметь проблемы со сложным динамическим контентом или антибот-защитой.

Типичный Рабочий Процесс с No-Code Инструментами

Частые Проблемы

Кривая обучения

Понимание селекторов и логики извлечения требует времени

Селекторы ломаются

Изменения на сайте могут сломать весь рабочий процесс

Проблемы с динамическим контентом

Сайты с большим количеством JavaScript требуют сложных обходных путей

Ограничения CAPTCHA

Большинство инструментов требуют ручного вмешательства для CAPTCHA

Блокировка IP

Агрессивный парсинг может привести к блокировке вашего IP

No-Code Парсеры для Seeking Alpha

Несколько no-code инструментов, таких как Browse.ai, Octoparse, Axiom и ParseHub, могут помочь парсить Seeking Alpha без написания кода. Эти инструменты используют визуальные интерфейсы для выбора данных, хотя могут иметь проблемы со сложным динамическим контентом или антибот-защитой.

Типичный Рабочий Процесс с No-Code Инструментами

- Установить расширение браузера или зарегистрироваться на платформе

- Перейти на целевой сайт и открыть инструмент

- Выбрать элементы данных для извлечения методом point-and-click

- Настроить CSS-селекторы для каждого поля данных

- Настроить правила пагинации для парсинга нескольких страниц

- Обработать CAPTCHA (часто требуется ручное решение)

- Настроить расписание для автоматических запусков

- Экспортировать данные в CSV, JSON или подключить через API

Частые Проблемы

- Кривая обучения: Понимание селекторов и логики извлечения требует времени

- Селекторы ломаются: Изменения на сайте могут сломать весь рабочий процесс

- Проблемы с динамическим контентом: Сайты с большим количеством JavaScript требуют сложных обходных путей

- Ограничения CAPTCHA: Большинство инструментов требуют ручного вмешательства для CAPTCHA

- Блокировка IP: Агрессивный парсинг может привести к блокировке вашего IP

Примеры кода

import requests

from bs4 import BeautifulSoup

# URL для последних новостей рынка

url = 'https://seekingalpha.com/market-news'

# Стандартные заголовки браузера для имитации поведения человека

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/120.0.0.0 Safari/537.36',

'Accept-Language': 'ru-RU,ru;q=0.9,en-US;q=0.8,en;q=0.7',

'Referer': 'https://seekingalpha.com/'

}

def scrape_sa_news():

try:

response = requests.get(url, headers=headers, timeout=10)

if response.status_code == 200:

soup = BeautifulSoup(response.text, 'html.parser')

# Извлечение заголовков с использованием атрибутов data-test-id

headlines = soup.find_all('a', {'data-test-id': 'post-list-item-title'})

for item in headlines:

print(f'Заголовок новости: {item.text.strip()}')

else:

print(f'Заблокировано со статусом: {response.status_code}')

except Exception as e:

print(f'Произошла ошибка: {e}')

if __name__ == "__main__":

scrape_sa_news()Когда Использовать

Лучше всего для статических HTML-страниц с минимальным JavaScript. Идеально для блогов, новостных сайтов и простых страниц товаров электронной коммерции.

Преимущества

- ●Самое быстрое выполнение (без нагрузки браузера)

- ●Минимальное потребление ресурсов

- ●Легко распараллелить с asyncio

- ●Отлично для API и статических страниц

Ограничения

- ●Не может выполнять JavaScript

- ●Не работает на SPA и динамическом контенте

- ●Может иметь проблемы со сложными антибот-системами

Как парсить Seeking Alpha с помощью кода

Python + Requests

import requests

from bs4 import BeautifulSoup

# URL для последних новостей рынка

url = 'https://seekingalpha.com/market-news'

# Стандартные заголовки браузера для имитации поведения человека

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/120.0.0.0 Safari/537.36',

'Accept-Language': 'ru-RU,ru;q=0.9,en-US;q=0.8,en;q=0.7',

'Referer': 'https://seekingalpha.com/'

}

def scrape_sa_news():

try:

response = requests.get(url, headers=headers, timeout=10)

if response.status_code == 200:

soup = BeautifulSoup(response.text, 'html.parser')

# Извлечение заголовков с использованием атрибутов data-test-id

headlines = soup.find_all('a', {'data-test-id': 'post-list-item-title'})

for item in headlines:

print(f'Заголовок новости: {item.text.strip()}')

else:

print(f'Заблокировано со статусом: {response.status_code}')

except Exception as e:

print(f'Произошла ошибка: {e}')

if __name__ == "__main__":

scrape_sa_news()Python + Playwright

from playwright.sync_api import sync_playwright

def run(playwright):

# Запуск браузера Chromium

browser = playwright.chromium.launch(headless=True)

context = browser.new_context(

user_agent='Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/120.0.0.0 Safari/537.36'

)

page = context.new_page()

try:

# Переход на страницу стенограмм конкретного тикера

page.goto('https://seekingalpha.com/symbol/AAPL/transcripts')

# Ожидание динамического рендеринга основного контента

page.wait_for_selector('article', timeout=15000)

# Поиск и извлечение заголовков стенограмм

titles = page.locator('h3').all_inner_texts()

for title in titles:

print(f'Найдена стенограмма: {title}')

except Exception as e:

print(f'Ошибка извлечения: {e}')

finally:

browser.close()

with sync_playwright() as playwright:

run(playwright)Python + Scrapy

import scrapy

class SeekingAlphaSpider(scrapy.Spider):

name = 'sa_spider'

allowed_domains = ['seekingalpha.com']

start_urls = ['https://seekingalpha.com/latest-articles']

custom_settings = {

'DOWNLOAD_DELAY': 8,

'USER_AGENT': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) Chrome/120.0.0.0',

'ROBOTSTXT_OBEY': False,

'COOKIES_ENABLED': True

}

def parse(self, response):

for article in response.css('article'):

yield {

'title': article.css('h3 a::text').get(),

'link': response.urljoin(article.css('h3 a::attr(href)').get()),

'author': article.css('span[data-test-id="author-name"]::text').get()

}

# Обработка простой пагинации через ссылки 'next'

next_page = response.css('a.next_page::attr(href)').get()

if next_page:

yield response.follow(next_page, self.parse)Node.js + Puppeteer

const puppeteer = require('puppeteer');

(async () => {

const browser = await puppeteer.launch({ headless: true });

const page = await browser.newPage();

// Установка качественного User-Agent

await page.setUserAgent('Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/120.0.0.0 Safari/537.36');

try {

// Переход на главную страницу Seeking Alpha

await page.goto('https://seekingalpha.com/', { waitUntil: 'networkidle2' });

// Выполнение скриптов в контексте браузера для извлечения заголовков

const trending = await page.evaluate(() => {

const nodes = Array.from(document.querySelectorAll('h3'));

return nodes.map(n => n.innerText.trim());

});

console.log('Популярный контент:', trending);

} catch (err) {

console.error('Ошибка Puppeteer:', err);

} finally {

await browser.close();

}

})();Что Можно Делать С Данными Seeking Alpha

Изучите практические применения и инсайты из данных Seeking Alpha.

Количественный sentiment анализ

Финансовые компании используют статьи аналитиков для определения рыночных настроений в конкретных секторах акций.

Как реализовать:

- 1Извлечение всех аналитических статей для конкретного отраслевого тикера.

- 2Обработка контента через NLP-движок для расчета полярности настроений.

- 3Интеграция показателей настроений в существующие торговые алгоритмы.

- 4Запуск автоматических алертов на покупку/продажу при изменении рыночных настроений.

Используйте Automatio для извлечения данных из Seeking Alpha и создания этих приложений без написания кода.

Что Можно Делать С Данными Seeking Alpha

- Количественный sentiment анализ

Финансовые компании используют статьи аналитиков для определения рыночных настроений в конкретных секторах акций.

- Извлечение всех аналитических статей для конкретного отраслевого тикера.

- Обработка контента через NLP-движок для расчета полярности настроений.

- Интеграция показателей настроений в существующие торговые алгоритмы.

- Запуск автоматических алертов на покупку/продажу при изменении рыночных настроений.

- Извлечение инсайдов из отчетности

Извлекайте критически важные корпоративные прогнозы напрямую из стенограмм отчетности для быстрого анализа.

- Автоматизация ежедневного сбора данных из раздела Earnings Transcripts.

- Поиск специфических финансовых ключевых слов, таких как «EBITDA» или «Прогноз» (Outlook).

- Выделение предложений, содержащих метрики прогнозов руководства.

- Экспорт результатов в структурированный CSV для обзора инвестиционным комитетом.

- Бенчмаркинг дивидендной доходности

Сравнивайте показатели дивидендов по тысячам акций для поиска возможностей доходности.

- Сбор истории дивидендов и коэффициентов выплат для определенного списка акций.

- Расчет средней доходности в сравнении с историческими трендами на основе собранных данных.

- Идентификация акций, которые недавно увеличили выплаты.

- Обновление частного дашборда с сравнением доходности в реальном времени.

- Отслеживание эффективности аналитиков

Выявляйте авторов с высокой точностью прогнозов для получения лучших инвестиционных идей.

- Сбор исторических рейтингов и статей от авторов с самым высоким рейтингом.

- Сопоставление дат публикации статей с динамикой цен на акции.

- Ранжирование авторов на основе точности их рекомендаций «Покупать» или «Продавать».

- Отправка автоматических уведомлений, когда высокорейтинговые авторы публикуют новые идеи.

Улучшите свой рабочий процесс с ИИ-Автоматизацией

Automatio объединяет мощь ИИ-агентов, веб-автоматизации и умных интеграций, чтобы помочь вам достигать большего за меньшее время.

Советы Профессионала По Парсингу Seeking Alpha

Экспертные советы для успешного извлечения данных из Seeking Alpha.

Используйте премиум-резидентные прокси для эффективного обхода периметра защиты Cloudflare и DataDome.

Ротируйте строки User-Agent и сохраняйте стабильные отпечатки браузера в рамках одной сессии.

Внедрите рандомизированные задержки от 10 до 30 секунд для имитации поведения реального пользователя.

Выполняйте scraping во время закрытия рынка или по выходным, чтобы снизить вероятность срабатывания rate limits из-за высокого трафика.

Изучите вкладку «Network» в DevTools на предмет внутренних JSON API эндпоинтов (v3/api) для получения более чистых данных.

Используйте постоянные сессионные cookies, если вам необходимо собирать данные, доступные только после авторизации.

Отзывы

Что Говорят Наши Пользователи

Присоединяйтесь к тысячам довольных пользователей, которые трансформировали свой рабочий процесс

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Похожие Web Scraping

How to Scrape Yahoo Finance: Extract Stock Market Data

How to Scrape Moon.ly | Step-by-Step NFT Data Extraction Guide

How to Scrape Rocket Mortgage: A Comprehensive Guide

How to Scrape Open Collective: Financial and Contributor Data Guide

How to Scrape jup.ag: Jupiter DEX Web Scraper Guide

How to Scrape Indiegogo: The Ultimate Crowdfunding Data Extraction Guide

How to Scrape ICO Drops: Comprehensive Crypto Data Guide

How to Scrape Crypto.com: Comprehensive Market Data Guide

Часто задаваемые вопросы о Seeking Alpha

Найдите ответы на частые вопросы о Seeking Alpha