Hur man scrapar Hacker News (news.ycombinator.com)

Lär dig hur du scrapar Hacker News för att extrahera de främsta tekniknyheterna, jobbannonser och community-diskussioner. Perfekt för marknadsundersökningar...

Anti-bot-skydd upptäckt

- Hastighetsbegränsning

- Begränsar förfrågningar per IP/session över tid. Kan kringgås med roterande proxyservrar, fördröjda förfrågningar och distribuerad skrapning.

- IP-blockering

- Blockerar kända datacenter-IP:er och flaggade adresser. Kräver bostads- eller mobilproxyservrar för effektiv kringgång.

- User-Agent Filtering

Om Hacker News

Upptäck vad Hacker News erbjuder och vilka värdefulla data som kan extraheras.

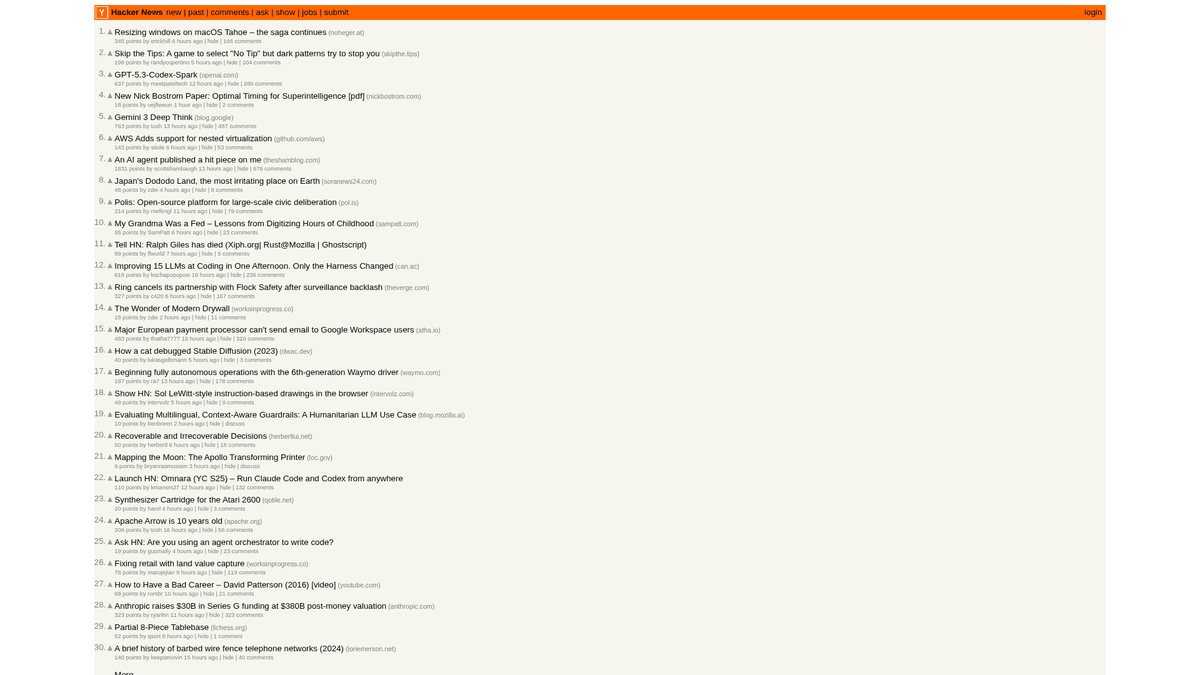

Teknikhubben

Hacker News är en webbplats för sociala nyheter med fokus på datavetenskap och entreprenörskap, som drivs av startup-inkubatorn Y Combinator. Den fungerar som en community-driven plattform där användare skickar in länkar till tekniska artiklar, startup-nyheter och djupgående diskussioner.

Riklig data

Plattformen innehåller en mängd realtidsdata, inklusive röstade tech-nyheter, "Show HN" startup-lanseringar, "Ask HN" community-frågor och specialiserade jobbannonser. Den anses allmänt vara pulsen i Silicon Valley-ekosystemet och det bredare globala utvecklar-communityt.

Strategiskt värde

Genom att scrapa denna data kan företag och forskare övervaka framväxande teknologier, spåra omnämnanden av konkurrenter och identifiera inflytelserika opinionsbildare. Eftersom webbplatsens layout är anmärkningsvärt stabil och avskalad, är den en av de mest pålitliga källorna för automatiserad aggregering av tekniska nyheter.

Varför Skrapa Hacker News?

Upptäck affärsvärdet och användningsfallen för dataextraktion från Hacker News.

Identifiera framväxande programmeringsspråk och utvecklarverktyg tidigt

Övervaka startup-ekosystemet för nya lanseringar och finansieringsnyheter

Lead-generering för teknisk rekrytering genom att övervaka 'Who is Hiring'-trådar

Sentimentanalys av mjukvarureleaser och företagsmeddelanden

Bygga tekniska nyhetsaggregatorer med hög relevans för nischade målgrupper

Akademisk forskning om informationsspridning i tekniska communities

Skrapningsutmaningar

Tekniska utmaningar du kan stöta på när du skrapar Hacker News.

Parsning av nästlade HTML-tabeller som används för layout

Hantering av relativa tidssträngar som '2 hours ago' för lagring i databas

Hantering av server-side rate-limits som utlöser tillfälliga IP-avstängningar

Extrahering av djupa kommentarshierarkier som sträcker sig över flera sidor

Skrapa Hacker News med AI

Ingen kod krävs. Extrahera data på minuter med AI-driven automatisering.

Hur det fungerar

Beskriv vad du behöver

Berätta för AI vilka data du vill extrahera från Hacker News. Skriv det bara på vanligt språk — ingen kod eller selektorer behövs.

AI extraherar datan

Vår artificiella intelligens navigerar Hacker News, hanterar dynamiskt innehåll och extraherar exakt det du bad om.

Få dina data

Få ren, strukturerad data redo att exportera som CSV, JSON eller skicka direkt till dina appar och arbetsflöden.

Varför använda AI för skrapning

AI gör det enkelt att skrapa Hacker News utan att skriva kod. Vår AI-drivna plattform använder artificiell intelligens för att förstå vilka data du vill ha — beskriv det bara på vanligt språk och AI extraherar dem automatiskt.

How to scrape with AI:

- Beskriv vad du behöver: Berätta för AI vilka data du vill extrahera från Hacker News. Skriv det bara på vanligt språk — ingen kod eller selektorer behövs.

- AI extraherar datan: Vår artificiella intelligens navigerar Hacker News, hanterar dynamiskt innehåll och extraherar exakt det du bad om.

- Få dina data: Få ren, strukturerad data redo att exportera som CSV, JSON eller skicka direkt till dina appar och arbetsflöden.

Why use AI for scraping:

- Peka-och-klicka-val av nyheter utan att skriva komplexa CSS-selektorer

- Automatisk hantering av 'More'-knappen för sömlös paginering

- Inbyggd molnkörning för att förhindra att din lokala IP utsätts för rate-limiting

- Schemalagda scraping-körningar för att automatiskt fånga förstasidan varje timme

- Direkt export till Google Sheets eller Webhooks för varningar i realtid

No-code webbskrapare för Hacker News

Peka-och-klicka-alternativ till AI-driven skrapning

Flera no-code-verktyg som Browse.ai, Octoparse, Axiom och ParseHub kan hjälpa dig att skrapa Hacker News utan att skriva kod. Dessa verktyg använder vanligtvis visuella gränssnitt för att välja data, även om de kan ha problem med komplext dynamiskt innehåll eller anti-bot-åtgärder.

Typiskt arbetsflöde med no-code-verktyg

Vanliga utmaningar

Inlärningskurva

Att förstå selektorer och extraktionslogik tar tid

Selektorer går sönder

Webbplatsändringar kan förstöra hela ditt arbetsflöde

Problem med dynamiskt innehåll

JavaScript-tunga sidor kräver komplexa lösningar

CAPTCHA-begränsningar

De flesta verktyg kräver manuell hantering av CAPTCHAs

IP-blockering

Aggressiv scraping kan leda till att din IP blockeras

No-code webbskrapare för Hacker News

Flera no-code-verktyg som Browse.ai, Octoparse, Axiom och ParseHub kan hjälpa dig att skrapa Hacker News utan att skriva kod. Dessa verktyg använder vanligtvis visuella gränssnitt för att välja data, även om de kan ha problem med komplext dynamiskt innehåll eller anti-bot-åtgärder.

Typiskt arbetsflöde med no-code-verktyg

- Installera webbläsartillägg eller registrera dig på plattformen

- Navigera till målwebbplatsen och öppna verktyget

- Välj dataelement att extrahera med point-and-click

- Konfigurera CSS-selektorer för varje datafält

- Ställ in pagineringsregler för att scrapa flera sidor

- Hantera CAPTCHAs (kräver ofta manuell lösning)

- Konfigurera schemaläggning för automatiska körningar

- Exportera data till CSV, JSON eller anslut via API

Vanliga utmaningar

- Inlärningskurva: Att förstå selektorer och extraktionslogik tar tid

- Selektorer går sönder: Webbplatsändringar kan förstöra hela ditt arbetsflöde

- Problem med dynamiskt innehåll: JavaScript-tunga sidor kräver komplexa lösningar

- CAPTCHA-begränsningar: De flesta verktyg kräver manuell hantering av CAPTCHAs

- IP-blockering: Aggressiv scraping kan leda till att din IP blockeras

Kodexempel

import requests

from bs4 import BeautifulSoup

url = 'https://news.ycombinator.com/'

headers = {'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36'}

try:

response = requests.get(url, headers=headers)

response.raise_for_status()

soup = BeautifulSoup(response.text, 'html.parser')

# Nyheter finns i rader med klassen 'athing'

posts = soup.select('.athing')

for post in posts:

title_element = post.select_one('.titleline > a')

title = title_element.text

link = title_element['href']

print(f'Title: {title}

Link: {link}

---')

except Exception as e:

print(f'Scraping failed: {e}')När ska det användas

Bäst för statiska HTML-sidor med minimal JavaScript. Idealiskt för bloggar, nyhetssidor och enkla e-handelsproduktsidor.

Fördelar

- ●Snabbaste exekveringen (ingen webbläsaröverhead)

- ●Lägsta resursförbrukning

- ●Lätt att parallellisera med asyncio

- ●Utmärkt för API:er och statiska sidor

Begränsningar

- ●Kan inte köra JavaScript

- ●Misslyckas på SPA:er och dynamiskt innehåll

- ●Kan ha problem med komplexa anti-bot-system

Hur man skrapar Hacker News med kod

Python + Requests

import requests

from bs4 import BeautifulSoup

url = 'https://news.ycombinator.com/'

headers = {'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36'}

try:

response = requests.get(url, headers=headers)

response.raise_for_status()

soup = BeautifulSoup(response.text, 'html.parser')

# Nyheter finns i rader med klassen 'athing'

posts = soup.select('.athing')

for post in posts:

title_element = post.select_one('.titleline > a')

title = title_element.text

link = title_element['href']

print(f'Title: {title}

Link: {link}

---')

except Exception as e:

print(f'Scraping failed: {e}')Python + Playwright

from playwright.sync_api import sync_playwright

with sync_playwright() as p:

browser = p.chromium.launch(headless=True)

page = browser.new_page()

page.goto('https://news.ycombinator.com/')

# Vänta på att tabellen laddas

page.wait_for_selector('.athing')

# Extrahera alla rubriker och länkar

items = page.query_selector_all('.athing')

for item in items:

title_link = item.query_selector('.titleline > a')

if title_link:

print(title_link.inner_text(), title_link.get_attribute('href'))

browser.close()Python + Scrapy

import scrapy

class HackerNewsSpider(scrapy.Spider):

name = 'hn_spider'

start_urls = ['https://news.ycombinator.com/']

def parse(self, response):

for post in response.css('.athing'):

yield {

'id': post.attrib.get('id'),

'title': post.css('.titleline > a::text').get(),

'link': post.css('.titleline > a::attr(href)').get(),

}

# Följ paginering via 'More'-länken

next_page = response.css('a.morelink::attr(href)').get()

if next_page:

yield response.follow(next_page, self.parse)Node.js + Puppeteer

const puppeteer = require('puppeteer');

(async () => {

const browser = await puppeteer.launch();

const page = await browser.newPage();

await page.goto('https://news.ycombinator.com/');

const results = await page.evaluate(() => {

const items = Array.from(document.querySelectorAll('.athing'));

return items.map(item => ({

title: item.querySelector('.titleline > a').innerText,

url: item.querySelector('.titleline > a').href

}));

});

console.log(results);

await browser.close();

})();Vad Du Kan Göra Med Hacker News-Data

Utforska praktiska tillämpningar och insikter från Hacker News-data.

Upptäckt av startup-trender

Identifiera vilka branscher eller produkttyper som lanseras och diskuteras mest frekvent.

Så här implementerar du:

- 1Scrape:a 'Show HN'-kategorin varje vecka.

- 2Rensa och kategorisera startup-beskrivningar med NLP.

- 3Ranka trender baserat på community-röster och sentiment i kommentarer.

Använd Automatio för att extrahera data från Hacker News och bygga dessa applikationer utan att skriva kod.

Vad Du Kan Göra Med Hacker News-Data

- Upptäckt av startup-trender

Identifiera vilka branscher eller produkttyper som lanseras och diskuteras mest frekvent.

- Scrape:a 'Show HN'-kategorin varje vecka.

- Rensa och kategorisera startup-beskrivningar med NLP.

- Ranka trender baserat på community-röster och sentiment i kommentarer.

- Tech Sourcing & Rekrytering

Extrahera jobbannonser och företagsinformation från specialiserade månatliga rekryteringstrådar.

- Övervaka ID för den månatliga 'Who is hiring'-tråden.

- Scrape:a alla toppkommentarer som innehåller jobbbeskrivningar.

- Parsa text för specifika tech-stackar som Rust, AI eller React.

- Konkurrensanalys

Spåra omnämnanden av konkurrenter i kommentarer för att förstå allmänhetens uppfattning och klagomål.

- Ställ in en sökordsbaserad scraper för specifika varumärken.

- Extrahera användarkommentarer och tidsstämplar för sentimentanalys.

- Generera veckorapporter om varumärkets hälsa jämfört med konkurrenter.

- Automatiserad innehållskurering

Skapa ett tekniskt nyhetsbrev med hög relevans som endast inkluderar de mest relevanta nyheterna.

- Scrape:a förstasidan var sjätte timme.

- Filtrera efter inlägg som överstiger ett tröskelvärde på 200 poäng.

- Automatisera leveransen av dessa länkar till en Telegram-bot eller e-postlista.

- Lead-generering för riskkapital

Upptäck startups i tidiga skeden som får betydande genomslag i communityt.

- Spåra 'Show HN'-inlägg som når förstasidan.

- Övervaka tillväxttakten för upvotes under de första 4 timmarna.

- Varna analytiker när ett inlägg visar virala tillväxtmönster.

Superladda ditt arbetsflode med AI-automatisering

Automatio kombinerar kraften av AI-agenter, webbautomatisering och smarta integrationer for att hjalpa dig astadkomma mer pa kortare tid.

Proffstips för Skrapning av Hacker News

Expertråd för framgångsrik dataextraktion från Hacker News.

Använd det officiella Firebase API

et för insamling av stora mängder historiska data för att undvika komplexitet vid HTML-parsing.

Ange alltid en anpassad User-Agent för att identifiera din bot på ett ansvarsfullt sätt och undvika omedelbar blockering.

Implementera ett slumpmässigt vänteintervall på 3–7 sekunder mellan förfrågningar för att efterlikna mänskligt surfbeteende.

Rikta in dig på specifika underkataloger som /newest för färska nyheter eller /ask för community-diskussioner.

Lagra 'Item ID' som primärnyckel för att undvika dubbletter när du scrapar förstasidan frekvent.

Scrape

a under tider med låg belastning (UTC natt) för snabbare svarstider och lägre risk för rate-limiting.

Omdomen

Vad vara anvandare sager

Ga med tusentals nojda anvandare som har transformerat sitt arbetsflode

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Relaterat Web Scraping

Vanliga fragor om Hacker News

Hitta svar pa vanliga fragor om Hacker News