كيفية كشط بيانات Animal Corner | أداة استخراج بيانات الحياة البرية والطبيعة

استخرج حقائق الحيوانات، والأسماء العلمية، وبيانات الموائل من Animal Corner. تعلم كيفية بناء قاعدة بيانات منظمة للحياة البرية للأبحاث أو التطبيقات.

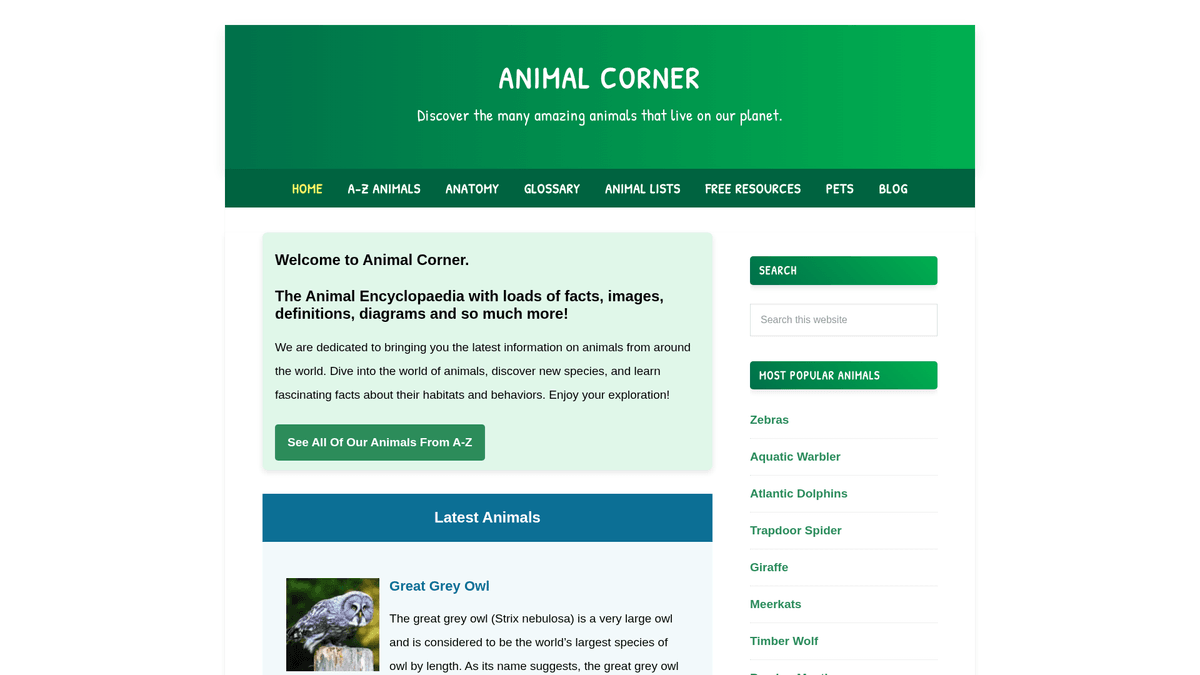

حول Animal Corner

اكتشف ما يقدمه Animal Corner وما هي البيانات القيمة التي يمكن استخراجها.

يعتبر Animal Corner موسوعة شاملة عبر الإنترنت مخصصة لتوفير ثروة من المعلومات حول مملكة الحيوان. يعمل الموقع كمورد تعليمي منظم للطلاب والمعلمين وعشاق الطبيعة، حيث يقدم ملفات تعريف مفصلة عن مجموعة واسعة من الأنواع التي تتراوح من الحيوانات الأليفة الشائعة إلى الحياة البرية المهددة بالانقراض. تنظم المنصة محتواها في فئات منطقية مثل الثدييات والطيور والزواحف والأسماك والبرمائيات واللافقاريات.

تتضمن كل قائمة على الموقع بيانات بيولوجية حيوية، بما في ذلك الأسماء الشائعة والعلمية، والخصائص الفيزيائية، والعادات الغذائية، والتوزيع الجغرافي. بالنسبة للمطورين والباحثين، تعد هذه البيانات ذات قيمة هائلة لإنشاء مجموعات بيانات منظمة يمكنها تشغيل التطبيقات التعليمية، أو تدريب نماذج machine learning للتعرف على الأنواع، أو دعم الدراسات البيئية واسعة النطاق. وبما أن الموقع يتم تحديثه بشكل متكرر بأنواع جديدة وحالات الحفظ، فإنه يظل مصدراً أساسياً لهواة التنوع البيولوجي.

لماذا تجريد Animal Corner؟

اكتشف القيمة التجارية وحالات الاستخدام لاستخراج البيانات من Animal Corner.

إنشاء قاعدة بيانات منظمة للتنوع البيولوجي للبحث الأكاديمي

جمع بيانات عالية الجودة لتطبيقات الهاتف المحمول الخاصة بالتعرف على الحياة البرية

تجميع الحقائق للمدونات التعليمية والمنصات ذات الطابع الطبيعي

مراقبة تحديثات حالة حفظ الأنواع عبر المناطق المختلفة

جمع البيانات التشريحية للدراسات البيولوجية المقارنة

بناء مجموعات بيانات تدريب لنماذج NLP التي تركز على الأوصاف البيولوجية

تحديات التجريد

التحديات التقنية التي قد تواجهها عند تجريد Animal Corner.

تحليل النصوص الوصفية إلى نقاط بيانات منظمة ودقيقة

التعامل مع عدم اتساق توفر حقول البيانات عبر مجموعات الأنواع المختلفة

التنقل والزحف إلى آلاف العناوين URL الخاصة بالأنواع الفردية بكفاءة

استخراج الأسماء العلمية التي غالباً ما تكون مدفونة داخل نصوص بين قوسين

إدارة الروابط الداخلية ومراجع الوسائط داخل الفقرات الوصفية

استخرج بيانات Animal Corner بالذكاء الاصطناعي

لا حاجة للبرمجة. استخرج البيانات في دقائق مع الأتمتة المدعومة بالذكاء الاصطناعي.

كيف يعمل

صف ما تحتاجه

أخبر الذكاء الاصطناعي بالبيانات التي تريد استخراجها من Animal Corner. فقط اكتب بلغة طبيعية — لا حاجة لأكواد أو محددات.

الذكاء الاصطناعي يستخرج البيانات

ذكاؤنا الاصطناعي يتصفح Animal Corner، يتعامل مع المحتوى الديناميكي، ويستخرج بالضبط ما طلبته.

احصل على بياناتك

احصل على بيانات نظيفة ومنظمة جاهزة للتصدير كـ CSV أو JSON أو إرسالها مباشرة إلى تطبيقاتك.

لماذا تستخدم الذكاء الاصطناعي للاستخراج

الذكاء الاصطناعي يجعل استخراج بيانات Animal Corner سهلاً بدون كتابة أكواد. منصتنا المدعومة بالذكاء الاصطناعي تفهم البيانات التي تريدها — فقط صفها بلغة طبيعية والذكاء الاصطناعي يستخرجها تلقائياً.

How to scrape with AI:

- صف ما تحتاجه: أخبر الذكاء الاصطناعي بالبيانات التي تريد استخراجها من Animal Corner. فقط اكتب بلغة طبيعية — لا حاجة لأكواد أو محددات.

- الذكاء الاصطناعي يستخرج البيانات: ذكاؤنا الاصطناعي يتصفح Animal Corner، يتعامل مع المحتوى الديناميكي، ويستخرج بالضبط ما طلبته.

- احصل على بياناتك: احصل على بيانات نظيفة ومنظمة جاهزة للتصدير كـ CSV أو JSON أو إرسالها مباشرة إلى تطبيقاتك.

Why use AI for scraping:

- اختيار مرئي بدون كود (no-code) لمجموعات حقائق الحيوانات المعقدة

- الزحف التلقائي لفئات الصفحات وفهارس A-Z دون الحاجة إلى برمجة

- التعامل مع تنظيف النصوص وتنسيقها مباشرة داخل الأداة

- تشغيل مجدول لالتقاط التحديثات المتعلقة بحالات الأنواع المهددة بالانقراض

- تصدير مباشر إلى Google Sheets أو JSON للتكامل الفوري مع التطبيقات

أدوات تجريد الويب بدون كود لـAnimal Corner

بدائل النقر والتأشير للتجريد المدعوم بالذكاء الاصطناعي

يمكن لعدة أدوات بدون كود مثل Browse.ai وOctoparse وAxiom وParseHub مساعدتك في تجريد Animal Corner بدون كتابة كود. تستخدم هذه الأدوات عادةً واجهات مرئية لتحديد البيانات، على الرغم من أنها قد تواجه صعوبة مع المحتوى الديناميكي المعقد أو إجراءات مكافحة البوتات.

سير العمل النموذجي مع أدوات بدون كود

التحديات الشائعة

منحنى التعلم

فهم المحددات ومنطق الاستخراج يستغرق وقتًا

المحددات تتعطل

تغييرات الموقع يمكن أن تكسر سير العمل بالكامل

مشاكل المحتوى الديناميكي

المواقع الغنية بـ JavaScript تتطلب حلولاً معقدة

قيود CAPTCHA

معظم الأدوات تتطلب تدخلاً يدويًا لـ CAPTCHA

حظر IP

الاستخراج المكثف قد يؤدي إلى حظر عنوان IP الخاص بك

أدوات تجريد الويب بدون كود لـAnimal Corner

يمكن لعدة أدوات بدون كود مثل Browse.ai وOctoparse وAxiom وParseHub مساعدتك في تجريد Animal Corner بدون كتابة كود. تستخدم هذه الأدوات عادةً واجهات مرئية لتحديد البيانات، على الرغم من أنها قد تواجه صعوبة مع المحتوى الديناميكي المعقد أو إجراءات مكافحة البوتات.

سير العمل النموذجي مع أدوات بدون كود

- تثبيت إضافة المتصفح أو التسجيل في المنصة

- الانتقال إلى الموقع المستهدف وفتح الأداة

- اختيار عناصر البيانات المراد استخراجها بالنقر

- تكوين محددات CSS لكل حقل بيانات

- إعداد قواعد التصفح لاستخراج صفحات متعددة

- التعامل مع CAPTCHA (غالبًا يتطلب حلاً يدويًا)

- تكوين الجدولة للتشغيل التلقائي

- تصدير البيانات إلى CSV أو JSON أو الاتصال عبر API

التحديات الشائعة

- منحنى التعلم: فهم المحددات ومنطق الاستخراج يستغرق وقتًا

- المحددات تتعطل: تغييرات الموقع يمكن أن تكسر سير العمل بالكامل

- مشاكل المحتوى الديناميكي: المواقع الغنية بـ JavaScript تتطلب حلولاً معقدة

- قيود CAPTCHA: معظم الأدوات تتطلب تدخلاً يدويًا لـ CAPTCHA

- حظر IP: الاستخراج المكثف قد يؤدي إلى حظر عنوان IP الخاص بك

أمثلة الكود

import requests

from bs4 import BeautifulSoup

# رابط URL المستهدف لحيوان معين

url = 'https://animalcorner.org/animals/african-elephant/'

# ترويسات قياسية لمحاكاة متصفح حقيقي

headers = {'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/91.0.4472.124 Safari/537.36'}

try:

response = requests.get(url, headers=headers)

response.raise_for_status()

soup = BeautifulSoup(response.text, 'html.parser')

# استخراج اسم الحيوان

title = soup.find('h1').text.strip()

print(f'Animal: {title}')

# استخراج الفقرة الأولى التي تحتوي عادةً على الاسم العلمي

intro = soup.find('p').text.strip()

print(f'Intro Facts: {intro[:150]}...')

except requests.exceptions.RequestException as e:

print(f'Error scraping Animal Corner: {e}')متى تستخدم

الأفضل لصفحات HTML الثابتة مع حد أدنى من JavaScript. مثالي للمدونات ومواقع الأخبار وصفحات المنتجات البسيطة.

المزايا

- ●أسرع تنفيذ (بدون عبء المتصفح)

- ●أقل استهلاك للموارد

- ●سهل التوازي مع asyncio

- ●ممتاز لواجهات API والصفحات الثابتة

القيود

- ●لا يمكنه تنفيذ JavaScript

- ●يفشل في تطبيقات الصفحة الواحدة والمحتوى الديناميكي

- ●قد يواجه صعوبة مع أنظمة مكافحة البوتات المعقدة

كيفية استخراج بيانات Animal Corner بالكود

Python + Requests

import requests

from bs4 import BeautifulSoup

# رابط URL المستهدف لحيوان معين

url = 'https://animalcorner.org/animals/african-elephant/'

# ترويسات قياسية لمحاكاة متصفح حقيقي

headers = {'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/91.0.4472.124 Safari/537.36'}

try:

response = requests.get(url, headers=headers)

response.raise_for_status()

soup = BeautifulSoup(response.text, 'html.parser')

# استخراج اسم الحيوان

title = soup.find('h1').text.strip()

print(f'Animal: {title}')

# استخراج الفقرة الأولى التي تحتوي عادةً على الاسم العلمي

intro = soup.find('p').text.strip()

print(f'Intro Facts: {intro[:150]}...')

except requests.exceptions.RequestException as e:

print(f'Error scraping Animal Corner: {e}')Python + Playwright

from playwright.sync_api import sync_playwright

def scrape_animal_corner():

with sync_playwright() as p:

# تشغيل المتصفح في وضع headless

browser = p.chromium.launch(headless=True)

page = browser.new_page()

page.goto('https://animalcorner.org/animals/african-elephant/')

# انتظار تحميل العنوان الرئيسي

title = page.inner_text('h1')

print(f'Animal Name: {title}')

# استخراج فقرات حقائق محددة

facts = page.query_selector_all('p')

for fact in facts[:3]:

print(f'Fact: {fact.inner_text()}')

browser.close()

if __name__ == "__main__":

scrape_animal_corner()Python + Scrapy

import scrapy

class AnimalSpider(scrapy.Spider):

name = 'animal_spider'

start_urls = ['https://animalcorner.org/animals/']

def parse(self, response):

# تتبع الروابط لصفحات الحيوانات الفردية داخل الدليل

for animal_link in response.css('a[href*="/animals/"]::attr(href)').getall():

yield response.follow(animal_link, self.parse_animal)

def parse_animal(self, response):

# استخراج البيانات المنظمة من ملفات تعريف الحيوانات

yield {

'common_name': response.css('h1::text').get().strip(),

'scientific_name': response.xpath('//p[contains(., "(")]/text()').re_first(r'\((.*?)\)'),

'description': ' '.join(response.css('p::text').getall()[:5])

}Node.js + Puppeteer

const puppeteer = require('puppeteer');

(async () => {

const browser = await puppeteer.launch();

const page = await browser.newPage();

await page.goto('https://animalcorner.org/animals/african-elephant/');

const data = await page.evaluate(() => {

// استخراج العنوان والفقرة التمهيدية

return {

title: document.querySelector('h1').innerText.trim(),

firstParagraph: document.querySelector('p').innerText.trim()

};

});

console.log('Extracted Data:', data);

await browser.close();

})();ماذا يمكنك فعله ببيانات Animal Corner

استكشف التطبيقات العملية والرؤى من بيانات Animal Corner.

تطبيق بطاقات تعليمية

إنشاء تطبيق تعليمي للهاتف المحمول يستخدم حقائق عن الحيوانات وصوراً عالية الجودة لتعليم الطلاب حول التنوع البيولوجي.

كيفية التنفيذ:

- 1كشط أسماء الحيوانات، والسمات الجسدية، والصور المميزة

- 2تصنيف الحيوانات حسب مستوى الصعوبة أو المجموعة البيولوجية

- 3تصميم واجهة اختبار تفاعلية باستخدام البيانات التي تم جمعها

- 4تنفيذ تتبع التقدم لمساعدة المستخدمين على إتقان التعرف على الأنواع

استخدم Automatio لاستخراج البيانات من Animal Corner وبناء هذه التطبيقات بدون كتابة كود.

ماذا يمكنك فعله ببيانات Animal Corner

- تطبيق بطاقات تعليمية

إنشاء تطبيق تعليمي للهاتف المحمول يستخدم حقائق عن الحيوانات وصوراً عالية الجودة لتعليم الطلاب حول التنوع البيولوجي.

- كشط أسماء الحيوانات، والسمات الجسدية، والصور المميزة

- تصنيف الحيوانات حسب مستوى الصعوبة أو المجموعة البيولوجية

- تصميم واجهة اختبار تفاعلية باستخدام البيانات التي تم جمعها

- تنفيذ تتبع التقدم لمساعدة المستخدمين على إتقان التعرف على الأنواع

- مجموعة بيانات للأبحاث الحيوانية

توفير مجموعة بيانات منظمة للباحثين الذين يقارنون الإحصائيات التشريحية عبر فصائل الأنواع المختلفة.

- استخراج إحصائيات عددية محددة مثل معدل ضربات القلب وفترة الحمل

- توحيد وحدات القياس (مثل الكيلوجرام، الأمتار) باستخدام تنظيف البيانات

- تنظيم البيانات حسب التصنيف العلمي (الرتبة، الفصيلة، الجنس)

- تصدير مجموعة البيانات النهائية إلى CSV لإجراء تحليل إحصائي متقدم

- ناشر تلقائي لمدونات الطبيعة

توليد محتوى يومي لوسائل التواصل الاجتماعي أو المدونات يتضمن حقائق عن 'حيوان اليوم' بشكل آلي.

- كشط مجموعة كبيرة من الحقائق المثيرة للاهتمام عن الحيوانات من الموسوعة

- جدولة سكربت لاختيار ملف تعريف حيوان عشوائي كل 24 ساعة

- تنسيق النص المستخرج في قالب منشور جذاب

- استخدام واجهات برمجة تطبيقات (API) لوسائل التواصل الاجتماعي لنشر المحتوى مع صورة الحيوان

- أداة مراقبة الحفظ

بناء لوحة معلومات تسلط الضوء على الحيوانات المدرجة حالياً تحت حالة 'مهددة بالانقراض' أو 'عرضة للانقراض'.

- كشط أسماء الأنواع جنباً إلى جنب مع حالة الحفظ الخاصة بها

- تصفية قاعدة البيانات لعزل فئات الأنواع المعرضة لخطر كبير

- ربط هذه الأنواع بمناطقها الجغرافية المسجلة

- إعداد عمليات كشط دورية لتتبع التغيرات في حالة الحفظ

عزز سير عملك مع أتمتة الذكاء الاصطناعي

يجمع Automatio بين قوة وكلاء الذكاء الاصطناعي وأتمتة الويب والتكاملات الذكية لمساعدتك على إنجاز المزيد في وقت أقل.

نصائح احترافية لتجريد Animal Corner

نصائح الخبراء لاستخراج البيانات بنجاح من Animal Corner.

ابدأ عملية الزحف (crawl) من صفحة قائمة A-Z لضمان تغطية شاملة لجميع الأنواع

استخدم التعبيرات النمطية (regular expressions) لاستخراج الأسماء العلمية التي توجد عادةً بين قوسين بجانب الاسم الشائع

اضبط تأخير الزحف (crawl delay) لمدة 1-2 ثانية بين الطلبات لاحترام موارد الموقع وتجنب القيود (rate limits)

استهدف مجلدات فرعية لفئات معينة مثل /mammals/ أو /birds/ إذا كنت تحتاج فقط إلى بيانات متخصصة

قم بتنزيل صور الحيوانات وتخزينها محلياً بدلاً من الربط المباشر بها (hotlinking) للحفاظ على استقرار تطبيقك

قم بتنظيف النصوص الوصفية عن طريق إزالة الروابط الداخلية بنمط الويكي لتوفير تجربة قراءة أكثر سلاسة

الشهادات

ماذا يقول مستخدمونا

انضم إلى الآلاف من المستخدمين الراضين الذين حولوا سير عملهم

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

ذو صلة Web Scraping

How to Scrape Bilregistret.ai: Swedish Vehicle Data Extraction Guide

How to Scrape Biluppgifter.se: Vehicle Data Extraction Guide

How to Scrape The AA (theaa.com): A Technical Guide for Car & Insurance Data

How to Scrape CSS Author: A Comprehensive Web Scraping Guide

How to Scrape Car.info | Vehicle Data & Valuation Extraction Guide

How to Scrape GoAbroad Study Abroad Programs

How to Scrape ResearchGate: Publication and Researcher Data

How to Scrape Statista: The Ultimate Guide to Market Data Extraction

الأسئلة الشائعة حول Animal Corner

ابحث عن إجابات للأسئلة الشائعة حول Animal Corner