كيفية كشط Exploit-DB | أداة كشط Exploit Database

تعلم كيفية كشط Exploit-DB للحصول على بيانات الثغرات وأكواد الاستغلال ومراجع CVE لتعزيز أبحاث الأمن السيبراني وخلاصات استخبارات التهديدات المؤتمتة.

تم اكتشاف حماية ضد البوتات

- Cloudflare

- جدار حماية تطبيقات الويب وإدارة البوتات على مستوى المؤسسات. يستخدم تحديات JavaScript وCAPTCHA وتحليل السلوك. يتطلب أتمتة المتصفح بإعدادات التخفي.

- تحديد معدل الطلبات

- يحد من الطلبات لكل IP/جلسة عبر الوقت. يمكن تجاوزه بالبروكسيات الدوارة وتأخير الطلبات والاستخراج الموزع.

- حظر IP

- يحظر عناوين IP المعروفة لمراكز البيانات والعناوين المُعلَّمة. يتطلب بروكسيات سكنية أو محمولة للتجاوز الفعال.

- تحدي JavaScript

- يتطلب تنفيذ JavaScript للوصول إلى المحتوى. الطلبات البسيطة تفشل؛ يلزم متصفح بدون واجهة مثل Playwright أو Puppeteer.

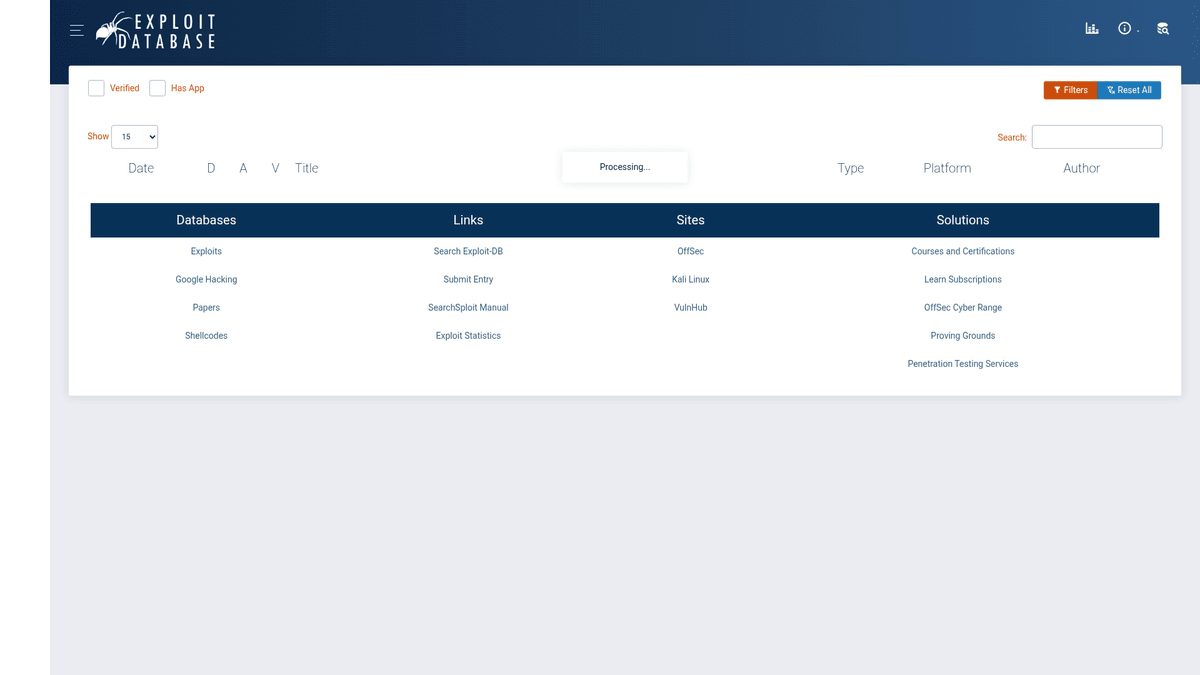

حول Exploit Database

اكتشف ما يقدمه Exploit Database وما هي البيانات القيمة التي يمكن استخراجها.

مستودع شامل للثغرات الأمنية

يعد Exploit Database (Exploit-DB) أرشيفاً متوافقاً مع CVE للثغرات العامة والبرامج الضعيفة المقابلة لها، تم تطويره للاستخدام من قبل مختبري الاختراق وباحثي الثغرات. يتم صيانته بواسطة OffSec (Offensive Security)، ويعمل كمركز رئيسي لمجتمع الأمن السيبراني لمشاركة أكواد إثبات المفهوم (PoC) والأبحاث عبر مختلف المنصات والتطبيقات. يعد المستودع أحد أكثر المصادر موثوقية لمحترفي الأمن في جميع أنحاء العالم.

تصنيف وعمق البيانات

ينظم الموقع البيانات في فئات دقيقة مثل الثغرات عن بعد (Remote Exploits)، وتطبيقات الويب، والثغرات المحلية، وShellcodes. يتضمن كل إدخال عادةً عنوان الثغرة، والتاريخ، والمؤلف، والمنصة، و CVE ID المرتبط بها، وكود الثغرة الخام. يتيح هذا النهج المنظم للباحثين الانتقال بسرعة بين أنواع مختلفة من الثغرات وسياقها التاريخي.

القيمة الاستراتيجية للعمليات الأمنية

يعد كشط هذه البيانات ذا قيمة عالية لـ مراكز العمليات الأمنية (SOCs) وفرق استخبارات التهديدات لربط الثغرات المعروفة بالثغرات الداخلية. من خلال أتمتة استخراج كود PoC والبيانات الوصفية، يمكن للمؤسسات إنشاء توقيعات أمنية مخصصة، وتعزيز دورة حياة إدارة الثغرات، وبناء خلاصات قوية لاستخبارات التهديدات.

لماذا تجريد Exploit Database؟

اكتشف القيمة التجارية وحالات الاستخدام لاستخراج البيانات من Exploit Database.

جمع استخبارات التهديدات في الوقت الفعلي

مزامنة قواعد بيانات الثغرات

البحث والتطوير الأمني المؤتمت

التكامل مع أدوات فحص الثغرات

تحليل اتجاهات الهجوم التاريخية

بناء توقيعات أمنية مخصصة

تحديات التجريد

التحديات التقنية التي قد تواجهها عند تجريد Exploit Database.

حماية Cloudflare القوية التي تتطلب تقنيات بصمة TLS متقدمة

تحميل المحتوى الديناميكي عبر AJAX لـ DataTables

حظر الـ IP المتكرر للطلبات عالية التردد

قيود صارمة على معدل تحميل أكواد PoC الخام

هيكل HTML متداخل ومعقد لتفاصيل الثغرات

استخرج بيانات Exploit Database بالذكاء الاصطناعي

لا حاجة للبرمجة. استخرج البيانات في دقائق مع الأتمتة المدعومة بالذكاء الاصطناعي.

كيف يعمل

صف ما تحتاجه

أخبر الذكاء الاصطناعي بالبيانات التي تريد استخراجها من Exploit Database. فقط اكتب بلغة طبيعية — لا حاجة لأكواد أو محددات.

الذكاء الاصطناعي يستخرج البيانات

ذكاؤنا الاصطناعي يتصفح Exploit Database، يتعامل مع المحتوى الديناميكي، ويستخرج بالضبط ما طلبته.

احصل على بياناتك

احصل على بيانات نظيفة ومنظمة جاهزة للتصدير كـ CSV أو JSON أو إرسالها مباشرة إلى تطبيقاتك.

لماذا تستخدم الذكاء الاصطناعي للاستخراج

الذكاء الاصطناعي يجعل استخراج بيانات Exploit Database سهلاً بدون كتابة أكواد. منصتنا المدعومة بالذكاء الاصطناعي تفهم البيانات التي تريدها — فقط صفها بلغة طبيعية والذكاء الاصطناعي يستخرجها تلقائياً.

How to scrape with AI:

- صف ما تحتاجه: أخبر الذكاء الاصطناعي بالبيانات التي تريد استخراجها من Exploit Database. فقط اكتب بلغة طبيعية — لا حاجة لأكواد أو محددات.

- الذكاء الاصطناعي يستخرج البيانات: ذكاؤنا الاصطناعي يتصفح Exploit Database، يتعامل مع المحتوى الديناميكي، ويستخرج بالضبط ما طلبته.

- احصل على بياناتك: احصل على بيانات نظيفة ومنظمة جاهزة للتصدير كـ CSV أو JSON أو إرسالها مباشرة إلى تطبيقاتك.

Why use AI for scraping:

- يتعامل مع تحديات Cloudflare وJavaScript تلقائياً

- ينفذ العمليات محلياً لاستخراج نظيف لبيانات DataTables

- تشغيل مجدول لمراقبة ثغرات zero-day على مدار الساعة

- واجهة بدون كود (no-code) تلغي صيانة التجاوزات المعقدة

- تصدير مباشر إلى تنسيق JSON منظم للتكامل مع SOC

أدوات تجريد الويب بدون كود لـExploit Database

بدائل النقر والتأشير للتجريد المدعوم بالذكاء الاصطناعي

يمكن لعدة أدوات بدون كود مثل Browse.ai وOctoparse وAxiom وParseHub مساعدتك في تجريد Exploit Database بدون كتابة كود. تستخدم هذه الأدوات عادةً واجهات مرئية لتحديد البيانات، على الرغم من أنها قد تواجه صعوبة مع المحتوى الديناميكي المعقد أو إجراءات مكافحة البوتات.

سير العمل النموذجي مع أدوات بدون كود

التحديات الشائعة

منحنى التعلم

فهم المحددات ومنطق الاستخراج يستغرق وقتًا

المحددات تتعطل

تغييرات الموقع يمكن أن تكسر سير العمل بالكامل

مشاكل المحتوى الديناميكي

المواقع الغنية بـ JavaScript تتطلب حلولاً معقدة

قيود CAPTCHA

معظم الأدوات تتطلب تدخلاً يدويًا لـ CAPTCHA

حظر IP

الاستخراج المكثف قد يؤدي إلى حظر عنوان IP الخاص بك

أدوات تجريد الويب بدون كود لـExploit Database

يمكن لعدة أدوات بدون كود مثل Browse.ai وOctoparse وAxiom وParseHub مساعدتك في تجريد Exploit Database بدون كتابة كود. تستخدم هذه الأدوات عادةً واجهات مرئية لتحديد البيانات، على الرغم من أنها قد تواجه صعوبة مع المحتوى الديناميكي المعقد أو إجراءات مكافحة البوتات.

سير العمل النموذجي مع أدوات بدون كود

- تثبيت إضافة المتصفح أو التسجيل في المنصة

- الانتقال إلى الموقع المستهدف وفتح الأداة

- اختيار عناصر البيانات المراد استخراجها بالنقر

- تكوين محددات CSS لكل حقل بيانات

- إعداد قواعد التصفح لاستخراج صفحات متعددة

- التعامل مع CAPTCHA (غالبًا يتطلب حلاً يدويًا)

- تكوين الجدولة للتشغيل التلقائي

- تصدير البيانات إلى CSV أو JSON أو الاتصال عبر API

التحديات الشائعة

- منحنى التعلم: فهم المحددات ومنطق الاستخراج يستغرق وقتًا

- المحددات تتعطل: تغييرات الموقع يمكن أن تكسر سير العمل بالكامل

- مشاكل المحتوى الديناميكي: المواقع الغنية بـ JavaScript تتطلب حلولاً معقدة

- قيود CAPTCHA: معظم الأدوات تتطلب تدخلاً يدويًا لـ CAPTCHA

- حظر IP: الاستخراج المكثف قد يؤدي إلى حظر عنوان IP الخاص بك

أمثلة الكود

import requests

from bs4 import BeautifulSoup

# Exploit-DB uses Cloudflare; simple requests might be blocked

url = 'https://www.exploit-db.com/'

headers = {'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/91.0.4472.124 Safari/537.36'}

try:

response = requests.get(url, headers=headers)

response.raise_for_status()

soup = BeautifulSoup(response.text, 'html.parser')

# Note: Main data is loaded via AJAX, initial HTML is a shell

print('Page Title:', soup.title.text)

except Exception as e:

print(f'Error encountered: {e}')متى تستخدم

الأفضل لصفحات HTML الثابتة مع حد أدنى من JavaScript. مثالي للمدونات ومواقع الأخبار وصفحات المنتجات البسيطة.

المزايا

- ●أسرع تنفيذ (بدون عبء المتصفح)

- ●أقل استهلاك للموارد

- ●سهل التوازي مع asyncio

- ●ممتاز لواجهات API والصفحات الثابتة

القيود

- ●لا يمكنه تنفيذ JavaScript

- ●يفشل في تطبيقات الصفحة الواحدة والمحتوى الديناميكي

- ●قد يواجه صعوبة مع أنظمة مكافحة البوتات المعقدة

كيفية استخراج بيانات Exploit Database بالكود

Python + Requests

import requests

from bs4 import BeautifulSoup

# Exploit-DB uses Cloudflare; simple requests might be blocked

url = 'https://www.exploit-db.com/'

headers = {'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/91.0.4472.124 Safari/537.36'}

try:

response = requests.get(url, headers=headers)

response.raise_for_status()

soup = BeautifulSoup(response.text, 'html.parser')

# Note: Main data is loaded via AJAX, initial HTML is a shell

print('Page Title:', soup.title.text)

except Exception as e:

print(f'Error encountered: {e}')Python + Playwright

from playwright.sync_api import sync_playwright

def scrape_exploit_db():

with sync_playwright() as p:

browser = p.chromium.launch(headless=True)

page = browser.new_page()

page.goto('https://www.exploit-db.com/')

# Wait for the DataTables to populate via AJAX

page.wait_for_selector('table#exploits-table')

rows = page.query_selector_all('table#exploits-table tbody tr')

for row in rows[:5]:

print(row.inner_text())

browser.close()

scrape_exploit_db()Python + Scrapy

import scrapy

class ExploitSpider(scrapy.Spider):

name = 'exploit_spider'

start_urls = ['https://www.exploit-db.com/']

def parse(self, response):

# Scrapy needs a JS middleware like scrapy-playwright for this site

for exploit in response.css('table#exploits-table tbody tr'):

yield {

'title': exploit.css('td.title a::text').get(),

'id': exploit.css('td.id::text').get(),

'cve': exploit.css('td.cve a::text').get()

}Node.js + Puppeteer

const puppeteer = require('puppeteer');

(async () => {

const browser = await puppeteer.launch();

const page = await browser.newPage();

await page.goto('https://www.exploit-db.com/', { waitUntil: 'networkidle2' });

const results = await page.evaluate(() => {

const rows = Array.from(document.querySelectorAll('table#exploits-table tbody tr'));

return rows.map(row => row.innerText);

});

console.log(results.slice(0, 5));

await browser.close();

})();ماذا يمكنك فعله ببيانات Exploit Database

استكشف التطبيقات العملية والرؤى من بيانات Exploit Database.

خلاصة استخبارات التهديدات في الوقت الفعلي

إنشاء تغذية مستمرة للثغرات الجديدة لتحذير فرق الأمن من التهديدات الناشئة.

كيفية التنفيذ:

- 1إعداد عملية scrape مجدولة للصفحة الرئيسية يومياً

- 2مقارنة EDB-IDs الجديدة بالسجلات التي تم كشطها سابقاً

- 3تفعيل تنبيهات Slack أو البريد الإلكتروني للثغرات الحرجة الجديدة

استخدم Automatio لاستخراج البيانات من Exploit Database وبناء هذه التطبيقات بدون كتابة كود.

ماذا يمكنك فعله ببيانات Exploit Database

- خلاصة استخبارات التهديدات في الوقت الفعلي

إنشاء تغذية مستمرة للثغرات الجديدة لتحذير فرق الأمن من التهديدات الناشئة.

- إعداد عملية scrape مجدولة للصفحة الرئيسية يومياً

- مقارنة EDB-IDs الجديدة بالسجلات التي تم كشطها سابقاً

- تفعيل تنبيهات Slack أو البريد الإلكتروني للثغرات الحرجة الجديدة

- ربط الثغرات وإدارة التصحيحات

مساعدة فرق تقنية المعلومات في تحديد أولويات تصحيحات البرامج بناءً على وجود كود ثغرة فعال.

- استخراج CVE IDs والبيانات الوصفية المرتبطة بالثغرة

- مقارنتها مع قوائم جرد البرامج الداخلية

- تحديد الأنظمة التي تتوفر لها ثغرات عامة لتصحيحها فوراً

- إنشاء توقيعات SIEM مؤتمتة

استخراج shellcode الخاص بإثبات المفهوم لتطوير توقيعات دفاعية لكشف التسلل.

- الانتقال إلى صفحات الثغرات الفردية وكشط الكود الخام

- تحليل الكود بحثاً عن أنماط بايت فريدة أو سلاسل شبكية

- تغذية الأنماط المستخرجة في مولدات قواعد SIEM أو IDS/IPS

- تحليل اتجاهات الثغرات التاريخية

تحليل بيانات الثغرات على مدار عقد من الزمن لفهم المنصات الأكثر استهدافاً بمرور الوقت.

- كشط الأرشيف بالكامل بما في ذلك التواريخ والمنصات والأنواع

- تجميع البيانات حسب المنصة والسنة

- تمثيل اتجاهات الهجوم مرئياً باستخدام أدوات BI مثل Tableau أو PowerBI

- مجموعات البيانات الأكاديمية للأمن السيبراني

توفير بيانات منظمة وعالية الجودة لنماذج machine learning التي تتنبأ بموثوقية الثغرات.

- كشط الثغرات التي تم التحقق منها مقابل غير المتحقق منها

- استخراج الكود المصدري الخام وسمات البيانات الوصفية

- تدريب الـ models لتصنيف أنماط الكود المرتبطة بالثغرات الناجحة

عزز سير عملك مع أتمتة الذكاء الاصطناعي

يجمع Automatio بين قوة وكلاء الذكاء الاصطناعي وأتمتة الويب والتكاملات الذكية لمساعدتك على إنجاز المزيد في وقت أقل.

نصائح احترافية لتجريد Exploit Database

نصائح الخبراء لاستخراج البيانات بنجاح من Exploit Database.

تحقق من مستودع GitLab الرسمي لـ Exploit-DB للحصول على بيانات CSV الضخمة قبل البدء في عملية scrape عالية الحجم.

استخدم headless browser مع إضافات stealth لتجاوز تحديات Cloudflare بفعالية.

قم بتنفيذ تأخير لا يقل عن 10-15 ثانية بين الطلبات لتجنب حظر الـ IP.

استهدف نقاط نهاية AJAX المحددة التي تستخدمها جداول DataTables في الموقع للحصول على مخرجات JSON أنظف.

استخدم residential proxies عالية الجودة لمحاكاة حركة مرور الباحثين الأمنيين الشرعيين.

قم بتنقية وتوحيد CVE IDs فور استخراجها لضمان اتساق قاعدة البيانات.

الشهادات

ماذا يقول مستخدمونا

انضم إلى الآلاف من المستخدمين الراضين الذين حولوا سير عملهم

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

ذو صلة Web Scraping

How to Scrape Biluppgifter.se: Vehicle Data Extraction Guide

How to Scrape Bilregistret.ai: Swedish Vehicle Data Extraction Guide

How to Scrape The AA (theaa.com): A Technical Guide for Car & Insurance Data

How to Scrape CSS Author: A Comprehensive Web Scraping Guide

How to Scrape Car.info | Vehicle Data & Valuation Extraction Guide

How to Scrape GoAbroad Study Abroad Programs

How to Scrape ResearchGate: Publication and Researcher Data

How to Scrape Statista: The Ultimate Guide to Market Data Extraction

الأسئلة الشائعة حول Exploit Database

ابحث عن إجابات للأسئلة الشائعة حول Exploit Database