كيفية سحب بيانات Goodreads: الدليل النهائي لـ Web Scraping في عام 2025

تعرف على كيفية سحب بيانات Goodreads للكتب والمراجعات والتقييمات في عام 2025. يغطي هذا الدليل تجاوز أنظمة الحماية من bot، وأمثلة كود Python، وحالات استخدام...

تم اكتشاف حماية ضد البوتات

- Cloudflare

- جدار حماية تطبيقات الويب وإدارة البوتات على مستوى المؤسسات. يستخدم تحديات JavaScript وCAPTCHA وتحليل السلوك. يتطلب أتمتة المتصفح بإعدادات التخفي.

- DataDome

- كشف البوتات في الوقت الفعلي بنماذج التعلم الآلي. يحلل بصمة الجهاز وإشارات الشبكة وأنماط السلوك. شائع في مواقع التجارة الإلكترونية.

- Google reCAPTCHA

- نظام CAPTCHA من جوجل. الإصدار 2 يتطلب تفاعل المستخدم، والإصدار 3 يعمل بصمت مع تقييم المخاطر. يمكن حله بخدمات CAPTCHA.

- تحديد معدل الطلبات

- يحد من الطلبات لكل IP/جلسة عبر الوقت. يمكن تجاوزه بالبروكسيات الدوارة وتأخير الطلبات والاستخراج الموزع.

- حظر IP

- يحظر عناوين IP المعروفة لمراكز البيانات والعناوين المُعلَّمة. يتطلب بروكسيات سكنية أو محمولة للتجاوز الفعال.

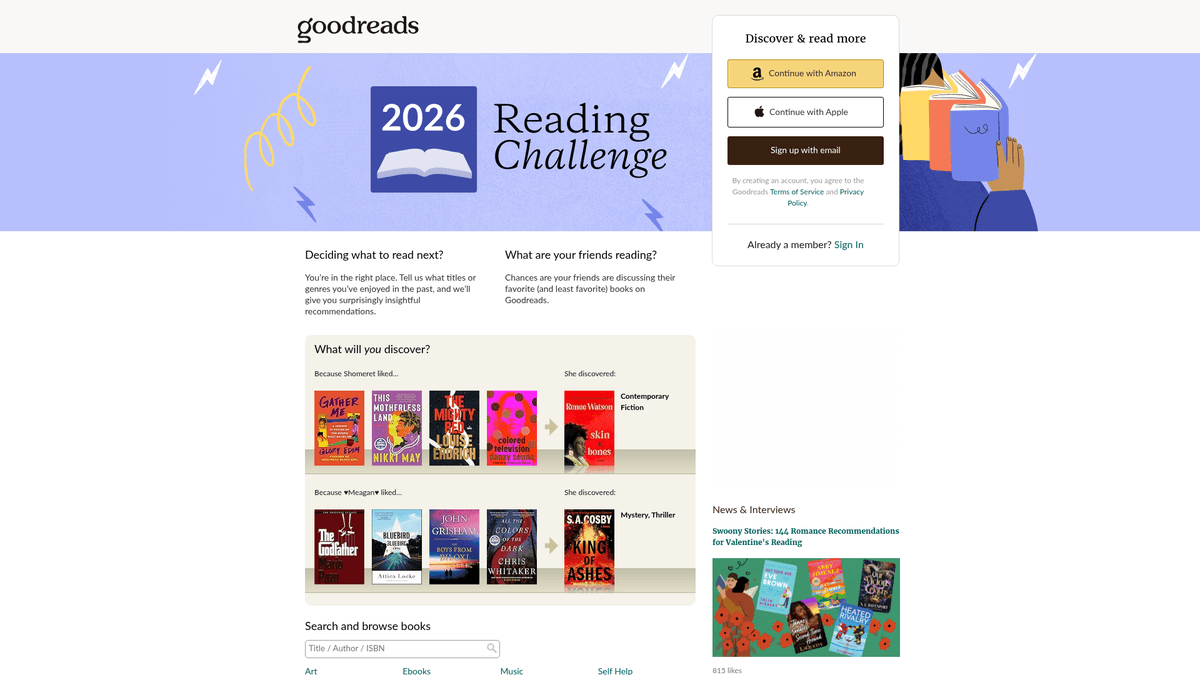

حول Goodreads

اكتشف ما يقدمه Goodreads وما هي البيانات القيمة التي يمكن استخراجها.

أكبر منصة للتصنيف الاجتماعي في العالم

Goodreads هي المنصة الرائدة في وسائل التواصل الاجتماعي لعشاق الكتب، تملكها وتديرها شركة Amazon. وهي بمثابة مستودع ضخم للبيانات الأدبية، حيث تضم الملايين من قوائم الكتب، والمراجعات التي ينشئها المستخدمون، والتعليقات التوضيحية، وقوائم القراءة. يتم تنظيم المنصة في أنواع أدبية و"رفوف" ينشئها المستخدمون، مما يوفر رؤى عميقة حول عادات القراءة العالمية والاتجاهات الأدبية.

كنز دفين من البيانات الأدبية

تحتوي المنصة على بيانات دقيقة بما في ذلك ISBN، والأنواع الأدبية، وقوائم مؤلفات الكتاب، وآراء القراء التفصيلية. بالنسبة للشركات والباحثين، تقدم هذه البيانات رؤى عميقة حول اتجاهات السوق وتفضيلات المستهلكين. تُعد البيانات المستخرجة من Goodreads لا تقدر بثمن للناشرين والمؤلفين والباحثين لإجراء التحليل التنافسي وتحديد الأنماط الأدبية الناشئة.

لماذا تسحب بيانات Goodreads؟

يوفر سحب البيانات من هذا الموقع وصولاً إلى مقاييس الشعبية في الوقت الفعلي، والتحليل التنافسي للمؤلفين، ومجموعات بيانات عالية الجودة لتدريب recommendation systems أو إجراء البحوث الأكاديمية في العلوم الإنسانية. يتيح للمستخدمين البحث في قاعدة بياناته الضخمة مع تتبع تقدم القراءة، مما يوفر نظرة فريدة على كيفية تفاعل المجموعات السكانية المختلفة مع الكتب.

لماذا تجريد Goodreads؟

اكتشف القيمة التجارية وحالات الاستخدام لاستخراج البيانات من Goodreads.

إجراء أبحاث السوق لاتجاهات صناعة النشر

إجراء sentiment analysis على مراجعات القراء

مراقبة الشعبية في الوقت الفعلي للعناوين الرائجة

بناء recommendation systems متقدمة بناءً على أنماط الرفوف

تجميع metadata للبحث الأكاديمي والثقافي

تحديات التجريد

التحديات التقنية التي قد تواجهها عند تجريد Goodreads.

تخفيف حدة الـ bot الهجومي من Cloudflare و DataDome

الاعتماد الكبير على JavaScript لعرض UI الحديثة

عدم اتساق UI بين تصميمات الصفحات القديمة وتلك القائمة على React

الـ rate limiting الصارم الذي يتطلب rotation متطور للـ proxy

استخرج بيانات Goodreads بالذكاء الاصطناعي

لا حاجة للبرمجة. استخرج البيانات في دقائق مع الأتمتة المدعومة بالذكاء الاصطناعي.

كيف يعمل

صف ما تحتاجه

أخبر الذكاء الاصطناعي بالبيانات التي تريد استخراجها من Goodreads. فقط اكتب بلغة طبيعية — لا حاجة لأكواد أو محددات.

الذكاء الاصطناعي يستخرج البيانات

ذكاؤنا الاصطناعي يتصفح Goodreads، يتعامل مع المحتوى الديناميكي، ويستخرج بالضبط ما طلبته.

احصل على بياناتك

احصل على بيانات نظيفة ومنظمة جاهزة للتصدير كـ CSV أو JSON أو إرسالها مباشرة إلى تطبيقاتك.

لماذا تستخدم الذكاء الاصطناعي للاستخراج

الذكاء الاصطناعي يجعل استخراج بيانات Goodreads سهلاً بدون كتابة أكواد. منصتنا المدعومة بالذكاء الاصطناعي تفهم البيانات التي تريدها — فقط صفها بلغة طبيعية والذكاء الاصطناعي يستخرجها تلقائياً.

How to scrape with AI:

- صف ما تحتاجه: أخبر الذكاء الاصطناعي بالبيانات التي تريد استخراجها من Goodreads. فقط اكتب بلغة طبيعية — لا حاجة لأكواد أو محددات.

- الذكاء الاصطناعي يستخرج البيانات: ذكاؤنا الاصطناعي يتصفح Goodreads، يتعامل مع المحتوى الديناميكي، ويستخرج بالضبط ما طلبته.

- احصل على بياناتك: احصل على بيانات نظيفة ومنظمة جاهزة للتصدير كـ CSV أو JSON أو إرسالها مباشرة إلى تطبيقاتك.

Why use AI for scraping:

- بناء أدوات سحب بيانات الكتب المعقدة بدون كود (no-code)

- التعامل التلقائي مع Cloudflare وأنظمة الحماية من bot

- التنفيذ السحابي لاستخراج كميات كبيرة من البيانات

- تشغيل مجدول لمراقبة تغيرات التصنيف اليومية

- سهولة التعامل مع المحتوى الديناميكي والتمرير اللانهائي

أدوات تجريد الويب بدون كود لـGoodreads

بدائل النقر والتأشير للتجريد المدعوم بالذكاء الاصطناعي

يمكن لعدة أدوات بدون كود مثل Browse.ai وOctoparse وAxiom وParseHub مساعدتك في تجريد Goodreads بدون كتابة كود. تستخدم هذه الأدوات عادةً واجهات مرئية لتحديد البيانات، على الرغم من أنها قد تواجه صعوبة مع المحتوى الديناميكي المعقد أو إجراءات مكافحة البوتات.

سير العمل النموذجي مع أدوات بدون كود

التحديات الشائعة

منحنى التعلم

فهم المحددات ومنطق الاستخراج يستغرق وقتًا

المحددات تتعطل

تغييرات الموقع يمكن أن تكسر سير العمل بالكامل

مشاكل المحتوى الديناميكي

المواقع الغنية بـ JavaScript تتطلب حلولاً معقدة

قيود CAPTCHA

معظم الأدوات تتطلب تدخلاً يدويًا لـ CAPTCHA

حظر IP

الاستخراج المكثف قد يؤدي إلى حظر عنوان IP الخاص بك

أدوات تجريد الويب بدون كود لـGoodreads

يمكن لعدة أدوات بدون كود مثل Browse.ai وOctoparse وAxiom وParseHub مساعدتك في تجريد Goodreads بدون كتابة كود. تستخدم هذه الأدوات عادةً واجهات مرئية لتحديد البيانات، على الرغم من أنها قد تواجه صعوبة مع المحتوى الديناميكي المعقد أو إجراءات مكافحة البوتات.

سير العمل النموذجي مع أدوات بدون كود

- تثبيت إضافة المتصفح أو التسجيل في المنصة

- الانتقال إلى الموقع المستهدف وفتح الأداة

- اختيار عناصر البيانات المراد استخراجها بالنقر

- تكوين محددات CSS لكل حقل بيانات

- إعداد قواعد التصفح لاستخراج صفحات متعددة

- التعامل مع CAPTCHA (غالبًا يتطلب حلاً يدويًا)

- تكوين الجدولة للتشغيل التلقائي

- تصدير البيانات إلى CSV أو JSON أو الاتصال عبر API

التحديات الشائعة

- منحنى التعلم: فهم المحددات ومنطق الاستخراج يستغرق وقتًا

- المحددات تتعطل: تغييرات الموقع يمكن أن تكسر سير العمل بالكامل

- مشاكل المحتوى الديناميكي: المواقع الغنية بـ JavaScript تتطلب حلولاً معقدة

- قيود CAPTCHA: معظم الأدوات تتطلب تدخلاً يدويًا لـ CAPTCHA

- حظر IP: الاستخراج المكثف قد يؤدي إلى حظر عنوان IP الخاص بك

أمثلة الكود

import requests

from bs4 import BeautifulSoup

# Target URL for a specific book

url = 'https://www.goodreads.com/book/show/1.Harry_Potter'

# Essential headers to avoid immediate blocking

headers = {'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) Chrome/119.0.0.0 Safari/537.36'}

try:

response = requests.get(url, headers=headers, timeout=10)

response.raise_for_status()

soup = BeautifulSoup(response.text, 'html.parser')

# Use data-testid for the modern React-based UI

title = soup.find('h1', {'data-testid': 'bookTitle'}).text.strip()

author = soup.find('span', {'data-testid': 'name'}).text.strip()

print(f'Title: {title}, Author: {author}')

except Exception as e:

print(f'Scraping failed: {e}')متى تستخدم

الأفضل لصفحات HTML الثابتة مع حد أدنى من JavaScript. مثالي للمدونات ومواقع الأخبار وصفحات المنتجات البسيطة.

المزايا

- ●أسرع تنفيذ (بدون عبء المتصفح)

- ●أقل استهلاك للموارد

- ●سهل التوازي مع asyncio

- ●ممتاز لواجهات API والصفحات الثابتة

القيود

- ●لا يمكنه تنفيذ JavaScript

- ●يفشل في تطبيقات الصفحة الواحدة والمحتوى الديناميكي

- ●قد يواجه صعوبة مع أنظمة مكافحة البوتات المعقدة

كيفية استخراج بيانات Goodreads بالكود

Python + Requests

import requests

from bs4 import BeautifulSoup

# Target URL for a specific book

url = 'https://www.goodreads.com/book/show/1.Harry_Potter'

# Essential headers to avoid immediate blocking

headers = {'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) Chrome/119.0.0.0 Safari/537.36'}

try:

response = requests.get(url, headers=headers, timeout=10)

response.raise_for_status()

soup = BeautifulSoup(response.text, 'html.parser')

# Use data-testid for the modern React-based UI

title = soup.find('h1', {'data-testid': 'bookTitle'}).text.strip()

author = soup.find('span', {'data-testid': 'name'}).text.strip()

print(f'Title: {title}, Author: {author}')

except Exception as e:

print(f'Scraping failed: {e}')Python + Playwright

from playwright.sync_api import sync_playwright

with sync_playwright() as p:

# Launching a browser is necessary for Cloudflare/JS pages

browser = p.chromium.launch(headless=True)

page = browser.new_page()

page.goto('https://www.goodreads.com/search?q=fantasy')

# Wait for the specific data attribute to render

page.wait_for_selector('[data-testid="bookTitle"]')

books = page.query_selector_all('.bookTitle')

for book in books:

print(book.inner_text().strip())

browser.close()Python + Scrapy

import scrapy

class GoodreadsSpider(scrapy.Spider):

name = 'goodreads_spider'

start_urls = ['https://www.goodreads.com/list/show/1.Best_Books_Ever']

def parse(self, response):

# Target the schema.org markup for more stable selectors

for book in response.css('tr[itemtype="http://schema.org/Book"]'):

yield {

'title': book.css('.bookTitle span::text').get(),

'author': book.css('.authorName span::text').get(),

'rating': book.css('.minirating::text').get(),

}

# Standard pagination handling

next_page = response.css('a.next_page::attr(href)').get()

if next_page:

yield response.follow(next_page, self.parse)Node.js + Puppeteer

const puppeteer = require('puppeteer');

(async () => {

const browser = await puppeteer.launch();

const page = await browser.newPage();

// Goodreads uses modern JS, so we wait for specific components

await page.goto('https://www.goodreads.com/book/show/1.Harry_Potter');

await page.waitForSelector('[data-testid="bookTitle"]');

const data = await page.evaluate(() => ({

title: document.querySelector('[data-testid="bookTitle"]').innerText,

author: document.querySelector('[data-testid="name"]').innerText,

rating: document.querySelector('.RatingStatistics__rating').innerText

}));

console.log(data);

await browser.close();

})();ماذا يمكنك فعله ببيانات Goodreads

استكشف التطبيقات العملية والرؤى من بيانات Goodreads.

التحليل التنبؤي للكتب الأكثر مبيعًا

يقوم الناشرون بتحليل مشاعر المراجعات المبكرة وسرعة الإضافة إلى الرفوف للتنبؤ بالنجاحات القادمة.

كيفية التنفيذ:

- 1مراقبة أعداد 'ترغب في قراءته' للكتب القادمة.

- 2سحب مراجعات النسخ المتقدمة (ARC) المبكرة.

- 3مقارنة الآراء ببيانات الكتب الأكثر مبيعًا التاريخية.

استخدم Automatio لاستخراج البيانات من Goodreads وبناء هذه التطبيقات بدون كتابة كود.

ماذا يمكنك فعله ببيانات Goodreads

- التحليل التنبؤي للكتب الأكثر مبيعًا

يقوم الناشرون بتحليل مشاعر المراجعات المبكرة وسرعة الإضافة إلى الرفوف للتنبؤ بالنجاحات القادمة.

- مراقبة أعداد 'ترغب في قراءته' للكتب القادمة.

- سحب مراجعات النسخ المتقدمة (ARC) المبكرة.

- مقارنة الآراء ببيانات الكتب الأكثر مبيعًا التاريخية.

- ذكاء المنافسة للمؤلفين

يتتبع المؤلفون أنماط الأنواع الأدبية واتجاهات التقييم لتحسين كتاباتهم وتسويقهم.

- سحب الكتب الأعلى تقييمًا في رف نوع أدبي معين.

- استخراج الأنماط المتكررة من مراجعات القراء.

- تحليل سرعة التقييم بعد الحملات التسويقية.

- محركات التوصية المتخصصة

يبني المطورون أدوات للعثور على كتب تطابق معايير محددة ومعقدة لا يدعمها الموقع الرئيسي.

- سحب الوسوم التي يحددها المستخدم ومقارنتها.

- ربط التقييمات للعثور على ارتباطات فريدة بين المؤلفين.

- إخراج النتائج عبر API إلى تطبيق ويب.

- تصفية الكتب بناءً على المشاعر

يستخدم الباحثون NLP على المراجعات لتصنيف الكتب بناءً على التأثير العاطفي بدلاً من النوع الأدبي.

- استخراج آلاف مراجعات المستخدمين لفئة معينة.

- تشغيل sentiment analysis واستخراج الكلمات المفتاحية.

- بناء مجموعة بيانات لنماذج machine learning.

عزز سير عملك مع أتمتة الذكاء الاصطناعي

يجمع Automatio بين قوة وكلاء الذكاء الاصطناعي وأتمتة الويب والتكاملات الذكية لمساعدتك على إنجاز المزيد في وقت أقل.

نصائح احترافية لتجريد Goodreads

نصائح الخبراء لاستخراج البيانات بنجاح من Goodreads.

استخدم دائمًا residential proxies لتجاوز حظر Cloudflare 403.

استهدف سمات data-testid المستقرة بدلاً من أسماء CSS class العشوائية.

قم بتحليل وسم السكريبت __NEXT_DATA__ JSON لاستخراج metadata بشكل موثوق.

قم بتنفيذ تأخيرات عشوائية تتراوح بين 3-7 ثوانٍ لمحاكاة سلوك التصفح البشري.

قم بإجراء web scraping خلال ساعات غير الذروة لتقليل مخاطر تفعيل rate limits.

راقب التحولات في UI بين صفحات PHP القديمة وتنسيق React الجديد.

الشهادات

ماذا يقول مستخدمونا

انضم إلى الآلاف من المستخدمين الراضين الذين حولوا سير عملهم

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

ذو صلة Web Scraping

How to Scrape Behance: A Step-by-Step Guide for Creative Data Extraction

How to Scrape YouTube: Extract Video Data and Comments in 2025

How to Scrape Bento.me | Bento.me Web Scraper

How to Scrape Vimeo: A Guide to Extracting Video Metadata

How to Scrape Social Blade: The Ultimate Analytics Guide

How to Scrape Imgur: A Comprehensive Guide to Image Data Extraction

How to Scrape Patreon Creator Data and Posts

How to Scrape Bluesky (bsky.app): API and Web Methods

الأسئلة الشائعة حول Goodreads

ابحث عن إجابات للأسئلة الشائعة حول Goodreads