كيفية القيام بـ scraping لموقع Signal NFX | دليل استخراج بيانات المستثمرين وشركات رأس المال الجريء (VC)

تعرف على كيفية القيام بـ scraping لملفات تعريف المستثمرين، وبيانات شركات رأس المال الجريء (VC)، وقوائم العملاء المحتملين من Signal NFX. اكتشف الاستراتيجيات...

تم اكتشاف حماية ضد البوتات

- Cloudflare

- جدار حماية تطبيقات الويب وإدارة البوتات على مستوى المؤسسات. يستخدم تحديات JavaScript وCAPTCHA وتحليل السلوك. يتطلب أتمتة المتصفح بإعدادات التخفي.

- تحديد معدل الطلبات

- يحد من الطلبات لكل IP/جلسة عبر الوقت. يمكن تجاوزه بالبروكسيات الدوارة وتأخير الطلبات والاستخراج الموزع.

- حظر IP

- يحظر عناوين IP المعروفة لمراكز البيانات والعناوين المُعلَّمة. يتطلب بروكسيات سكنية أو محمولة للتجاوز الفعال.

- Login Wall

- Google reCAPTCHA

- نظام CAPTCHA من جوجل. الإصدار 2 يتطلب تفاعل المستخدم، والإصدار 3 يعمل بصمت مع تقييم المخاطر. يمكن حله بخدمات CAPTCHA.

حول Signal (من قبل NFX)

اكتشف ما يقدمه Signal (من قبل NFX) وما هي البيانات القيمة التي يمكن استخراجها.

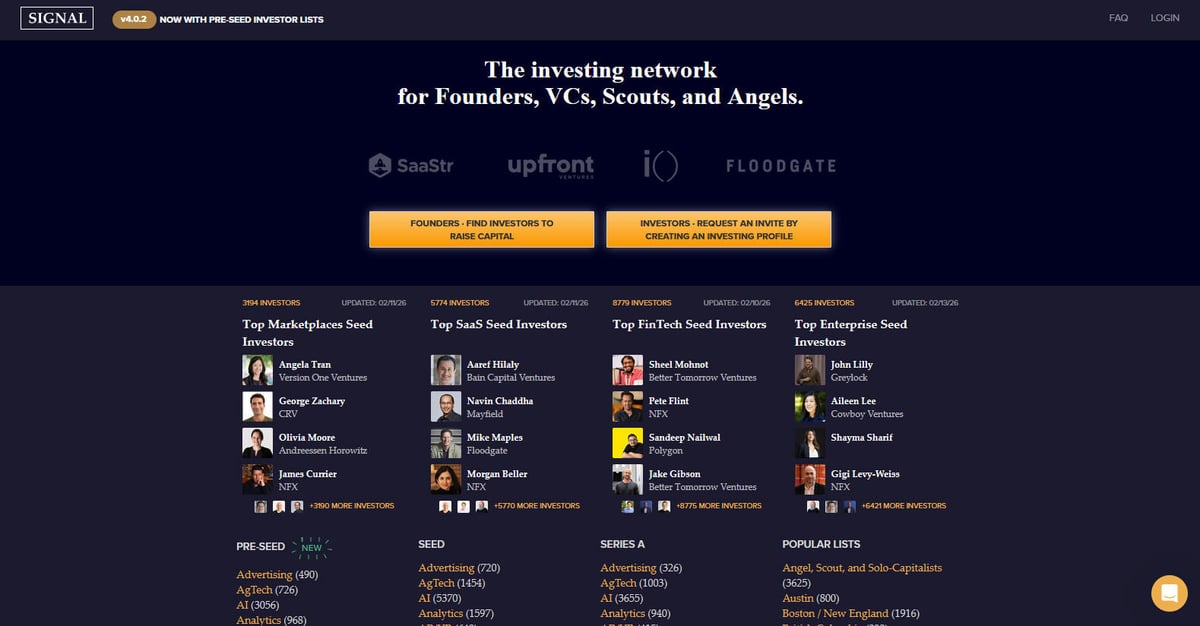

تعد Signal شبكة استثمارية قوية مصممة خصيصاً للمؤسسين، والـ VCs، والمستكشفين (scouts)، والمستثمرين الملائكة (angel investors). قامت شركة NFX، وهي شركة رأس مال جريء رائدة في المراحل الأولية (seed-stage)، بإنشاء المنصة وصيانتها، لتكون بمثابة دليل ضخم وأداة تشبيك لتسهيل جمع التمويل للشركات الناشئة. تهدف المنصة إلى جعل نظام الشركات الناشئة أكثر شفافية من خلال رسم خريطة للروابط بين المستثمرين ورواد الأعمال، لتحل محل جداول البيانات اليدوية ببيئة ديناميكية غنية بالبيانات.

تحتوي المنصة على آلاف الملفات الشخصية للمستثمرين، المصنفة حسب مرحلة الاستثمار المفضلة لديهم (من Pre-Seed إلى Series B)، وقطاعات الصناعة مثل AI، وSaaS، وFinTech، والمناطق الجغرافية. يمكن للمستخدمين العثور على معلومات مفصلة حول شركات رأس المال الجريء، والشركاء الأفراد، وتوجهاتهم الاستثمارية المحددة، والتي يتم تحديثها بشكل متكرر لتعكس مشهد السوق الحالي. تتميز كل قائمة عادةً بتركيز المستثمر، ومراحل الاستثمار المفضلة، وأطروحات الاستثمار المحددة، وتفضيلات المقدمة المباشرة من المؤسسين.

تعد عملية الـ scraping لموقع Signal ذات قيمة عالية للمؤسسين الذين يحتاجون إلى بناء قوائم مستثمرين مستهدفة دون تصفح آلاف الإدخالات يدوياً. كما توفر بيانات حيوية لباحثي السوق الذين يتتبعون اتجاهات رأس المال الجريء، والذكاء التنافسي لشركات الـ VC الأخرى، وبيانات لفرق المبيعات التي تستهدف بيئة الشركات الناشئة من خلال رسم خرائط العلاقات والتوصيات.

لماذا تجريد Signal (من قبل NFX)؟

اكتشف القيمة التجارية وحالات الاستخدام لاستخراج البيانات من Signal (من قبل NFX).

جمع تمويل مستهدف

بناء قوائم دقيقة للمستثمرين الذين يقودون جولات seed أو pre-seed في صناعتك المحددة.

أبحاث السوق

تحليل القطاعات التي تحظى بأكبر قدر من الاهتمام من شركات الـ VC الكبرى مثل Andreessen Horowitz أو Greylock.

توليد العملاء المحتملين (Lead Generation)

تحديد شركات الـ VC الجديدة والمستثمرين الأفراد الذين يدخلون أسواقاً جغرافية محددة مثل أمريكا اللاتينية أو جنوب شرق آسيا.

الذكاء التنافسي

مراقبة المحافظ الاستثمارية ومجالات التركيز للشركات المنافسة لفهم استراتيجية التوسع الخاصة بهم.

تجميع البيانات

إنشاء قاعدة بيانات داخلية شاملة لمنظومة رأس المال الجريء للتحليل الأكاديمي أو التجاري.

رسم خرائط العلاقات

استخراج بيانات الاتصال للعثور على أقصر مسار للحصول على مقدمات دافئة لمستثمرين بارزين.

تحديات التجريد

التحديات التقنية التي قد تواجهها عند تجريد Signal (من قبل NFX).

متطلبات تسجيل الدخول

معظم المعلومات التفصيلية للمستثمرين مخفية خلف جدار تسجيل الدخول، مما يتطلب إدارة الجلسة أو المصادقة الآلية.

معالجة الـ JavaScript

يستخدم الموقع التحميل الديناميكي لقوائم المستثمرين (Infinite Scroll)، مما يتطلب أداة scraping تعتمد على المتصفح لتنفيذ الـ JS.

تدابير مكافحة البوتات

استخدام Cloudflare WAF ونقاط نهاية API محددة لجلب البيانات يعني أن الطلبات العادية قد يتم حظرها بدون رؤوس (headers) مناسبة.

قيود المعدل (Rate Limits)

الـ scraping عالي التردد يمكن أن يؤدي إلى حظر IP أو اختبارات CAPTCHA نظراً للطبيعة المهنية والآمنة للشبكة.

هيكل DOM معقد

يستخدم الموقع عناصر ديناميكية ومكونات واجهة أمامية مخصصة، مما يتطلب selectors مستقرة لاستخراج بيانات موثوقة.

استخرج بيانات Signal (من قبل NFX) بالذكاء الاصطناعي

لا حاجة للبرمجة. استخرج البيانات في دقائق مع الأتمتة المدعومة بالذكاء الاصطناعي.

كيف يعمل

صف ما تحتاجه

أخبر الذكاء الاصطناعي بالبيانات التي تريد استخراجها من Signal (من قبل NFX). فقط اكتب بلغة طبيعية — لا حاجة لأكواد أو محددات.

الذكاء الاصطناعي يستخرج البيانات

ذكاؤنا الاصطناعي يتصفح Signal (من قبل NFX)، يتعامل مع المحتوى الديناميكي، ويستخرج بالضبط ما طلبته.

احصل على بياناتك

احصل على بيانات نظيفة ومنظمة جاهزة للتصدير كـ CSV أو JSON أو إرسالها مباشرة إلى تطبيقاتك.

لماذا تستخدم الذكاء الاصطناعي للاستخراج

الذكاء الاصطناعي يجعل استخراج بيانات Signal (من قبل NFX) سهلاً بدون كتابة أكواد. منصتنا المدعومة بالذكاء الاصطناعي تفهم البيانات التي تريدها — فقط صفها بلغة طبيعية والذكاء الاصطناعي يستخرجها تلقائياً.

How to scrape with AI:

- صف ما تحتاجه: أخبر الذكاء الاصطناعي بالبيانات التي تريد استخراجها من Signal (من قبل NFX). فقط اكتب بلغة طبيعية — لا حاجة لأكواد أو محددات.

- الذكاء الاصطناعي يستخرج البيانات: ذكاؤنا الاصطناعي يتصفح Signal (من قبل NFX)، يتعامل مع المحتوى الديناميكي، ويستخرج بالضبط ما طلبته.

- احصل على بياناتك: احصل على بيانات نظيفة ومنظمة جاهزة للتصدير كـ CSV أو JSON أو إرسالها مباشرة إلى تطبيقاتك.

Why use AI for scraping:

- إعداد بدون كود (No-Code): قم ببناء أداة scraping لموقع Signal بصرياً دون كتابة سكربتات معقدة للمصادقة أو معالجة الـ JS.

- تسجيل دخول آلي: تعامل بسهولة مع عملية تسجيل الدخول إلى Signal ضمن سير عمل Automatio للوصول إلى الملفات الشخصية المغلقة.

- التعامل مع المحتوى الديناميكي: ينتظر تلقائياً ويستخرج البيانات من القوائم الديناميكية وعناصر التمرير اللانهائي (infinite scroll).

- تحديثات مجدولة: اضبط أداة الـ scraping للعمل أسبوعياً للعثور على المستثمرين المضافين حديثاً أو قوائم القطاعات المحدثة دون تدخل يدوي.

- تصدير البيانات: تكامل مباشر لتصدير بيانات المستثمرين إلى Google Sheets أو CSV أو Webhooks للتواصل الفوري.

أدوات تجريد الويب بدون كود لـSignal (من قبل NFX)

بدائل النقر والتأشير للتجريد المدعوم بالذكاء الاصطناعي

يمكن لعدة أدوات بدون كود مثل Browse.ai وOctoparse وAxiom وParseHub مساعدتك في تجريد Signal (من قبل NFX) بدون كتابة كود. تستخدم هذه الأدوات عادةً واجهات مرئية لتحديد البيانات، على الرغم من أنها قد تواجه صعوبة مع المحتوى الديناميكي المعقد أو إجراءات مكافحة البوتات.

سير العمل النموذجي مع أدوات بدون كود

التحديات الشائعة

منحنى التعلم

فهم المحددات ومنطق الاستخراج يستغرق وقتًا

المحددات تتعطل

تغييرات الموقع يمكن أن تكسر سير العمل بالكامل

مشاكل المحتوى الديناميكي

المواقع الغنية بـ JavaScript تتطلب حلولاً معقدة

قيود CAPTCHA

معظم الأدوات تتطلب تدخلاً يدويًا لـ CAPTCHA

حظر IP

الاستخراج المكثف قد يؤدي إلى حظر عنوان IP الخاص بك

أدوات تجريد الويب بدون كود لـSignal (من قبل NFX)

يمكن لعدة أدوات بدون كود مثل Browse.ai وOctoparse وAxiom وParseHub مساعدتك في تجريد Signal (من قبل NFX) بدون كتابة كود. تستخدم هذه الأدوات عادةً واجهات مرئية لتحديد البيانات، على الرغم من أنها قد تواجه صعوبة مع المحتوى الديناميكي المعقد أو إجراءات مكافحة البوتات.

سير العمل النموذجي مع أدوات بدون كود

- تثبيت إضافة المتصفح أو التسجيل في المنصة

- الانتقال إلى الموقع المستهدف وفتح الأداة

- اختيار عناصر البيانات المراد استخراجها بالنقر

- تكوين محددات CSS لكل حقل بيانات

- إعداد قواعد التصفح لاستخراج صفحات متعددة

- التعامل مع CAPTCHA (غالبًا يتطلب حلاً يدويًا)

- تكوين الجدولة للتشغيل التلقائي

- تصدير البيانات إلى CSV أو JSON أو الاتصال عبر API

التحديات الشائعة

- منحنى التعلم: فهم المحددات ومنطق الاستخراج يستغرق وقتًا

- المحددات تتعطل: تغييرات الموقع يمكن أن تكسر سير العمل بالكامل

- مشاكل المحتوى الديناميكي: المواقع الغنية بـ JavaScript تتطلب حلولاً معقدة

- قيود CAPTCHA: معظم الأدوات تتطلب تدخلاً يدويًا لـ CAPTCHA

- حظر IP: الاستخراج المكثف قد يؤدي إلى حظر عنوان IP الخاص بك

أمثلة الكود

import requests

from bs4 import BeautifulSoup

# Signal requires login for full data access. This example uses a session.

session = requests.Session()

url = 'https://signal.nfx.com/investor-lists/top-marketplaces-seed-investors'

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/91.0.4472.124 Safari/537.36'

}

try:

# In a real scenario, you would need to POST login credentials here first

# session.post('https://signal.nfx.com/login', data={'email': '...', 'password': '...'})

response = session.get(url, headers=headers)

response.raise_for_status()

soup = BeautifulSoup(response.text, 'html.parser')

# Find investor cards in the list

investors = soup.select('.investor-card')

for investor in investors:

name = investor.select_one('.name').get_text(strip=True)

firm = investor.select_one('.firm-name').get_text(strip=True)

print(f'Investor: {name} | Firm: {firm}')

except Exception as e:

print(f'Error scraping Signal: {e}')متى تستخدم

الأفضل لصفحات HTML الثابتة مع حد أدنى من JavaScript. مثالي للمدونات ومواقع الأخبار وصفحات المنتجات البسيطة.

المزايا

- ●أسرع تنفيذ (بدون عبء المتصفح)

- ●أقل استهلاك للموارد

- ●سهل التوازي مع asyncio

- ●ممتاز لواجهات API والصفحات الثابتة

القيود

- ●لا يمكنه تنفيذ JavaScript

- ●يفشل في تطبيقات الصفحة الواحدة والمحتوى الديناميكي

- ●قد يواجه صعوبة مع أنظمة مكافحة البوتات المعقدة

كيفية استخراج بيانات Signal (من قبل NFX) بالكود

Python + Requests

import requests

from bs4 import BeautifulSoup

# Signal requires login for full data access. This example uses a session.

session = requests.Session()

url = 'https://signal.nfx.com/investor-lists/top-marketplaces-seed-investors'

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/91.0.4472.124 Safari/537.36'

}

try:

# In a real scenario, you would need to POST login credentials here first

# session.post('https://signal.nfx.com/login', data={'email': '...', 'password': '...'})

response = session.get(url, headers=headers)

response.raise_for_status()

soup = BeautifulSoup(response.text, 'html.parser')

# Find investor cards in the list

investors = soup.select('.investor-card')

for investor in investors:

name = investor.select_one('.name').get_text(strip=True)

firm = investor.select_one('.firm-name').get_text(strip=True)

print(f'Investor: {name} | Firm: {firm}')

except Exception as e:

print(f'Error scraping Signal: {e}')Python + Playwright

from playwright.sync_api import sync_playwright

def scrape_signal():

with sync_playwright() as p:

browser = p.chromium.launch(headless=True)

page = browser.new_page()

# Navigate to login

page.goto('https://signal.nfx.com/login')

page.fill('input[name="email"]', 'your_email@example.com')

page.fill('input[name="password"]', 'your_password')

page.click('button:has-text("Log In")')

# Wait for the listing page to load after login

page.wait_for_url('**/investors')

page.goto('https://signal.nfx.com/investor-lists/top-ai-seed-investors')

page.wait_for_selector('.investor-card')

# Scroll to load infinite content

for _ in range(5):

page.mouse.wheel(0, 4000)

page.wait_for_timeout(2000)

investors = page.query_selector_all('.investor-card')

for investor in investors:

name = investor.query_selector('.name').inner_text()

print(f'Found Investor: {name}')

browser.close()

scrape_signal()Python + Scrapy

import scrapy

class SignalSpider(scrapy.Spider):

name = 'signal_spider'

# Note: Requires scrapy-playwright for JavaScript rendering

start_urls = ['https://signal.nfx.com/investor-lists/top-saas-seed-investors']

def start_requests(self):

for url in self.start_urls:

yield scrapy.Request(url, meta={'playwright': True})

def parse(self, response):

for investor in response.css('.investor-card'):

yield {

'name': investor.css('.name::text').get(),

'firm': investor.css('.firm-name::text').get(),

'link': response.urljoin(investor.css('a::attr(href)').get())

}

# Scrapy logic for infinite scroll would require a custom Playwright handler

# to scroll down before passing the response back to parseNode.js + Puppeteer

const puppeteer = require('puppeteer');

(async () => {

const browser = await puppeteer.launch({ headless: true });

const page = await browser.newPage();

await page.setUserAgent('Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/91.0.4472.124 Safari/537.36');

// Handle Login first

await page.goto('https://signal.nfx.com/login');

await page.type('#user_email', 'your_email');

await page.type('#user_password', 'your_password');

await page.click('.btn-primary');

await page.waitForNavigation();

await page.goto('https://signal.nfx.com/investor-lists/top-fintech-seed-investors');

await page.waitForSelector('.investor-card');

const investors = await page.evaluate(() => {

const items = Array.from(document.querySelectorAll('.investor-card'));

return items.map(item => ({

name: item.querySelector('.name')?.innerText.trim(),

firm: item.querySelector('.firm-name')?.innerText.trim()

}));

});

console.log(investors);

await browser.close();

})();ماذا يمكنك فعله ببيانات Signal (من قبل NFX)

استكشف التطبيقات العملية والرؤى من بيانات Signal (من قبل NFX).

أتمتة التواصل لجمع التمويل

يمكن للمؤسسين استخدام البيانات لتحديد وترتيب أولويات المستثمرين الأكثر احتمالاً للاستثمار في مرحلتهم وقطاعهم المحدد.

كيفية التنفيذ:

- 1قم باستخراج قوائم المستثمرين في قطاعك (على سبيل المثال، 'أفضل مستثمري مرحلة Seed في مجال AI').

- 2قم بتصفية النتائج حسب 'آخر تحديث' للعثور على المشاركين النشطين الذين يمولون حالياً.

- 3تصدير البيانات إلى CRM مثل HubSpot أو Pipedrive لتتبع التواصل.

- 4استخدم روابط الملفات الشخصية لتحديد الاتصالات المشتركة للحصول على مقدمات دافئة.

استخدم Automatio لاستخراج البيانات من Signal (من قبل NFX) وبناء هذه التطبيقات بدون كتابة كود.

ماذا يمكنك فعله ببيانات Signal (من قبل NFX)

- أتمتة التواصل لجمع التمويل

يمكن للمؤسسين استخدام البيانات لتحديد وترتيب أولويات المستثمرين الأكثر احتمالاً للاستثمار في مرحلتهم وقطاعهم المحدد.

- قم باستخراج قوائم المستثمرين في قطاعك (على سبيل المثال، 'أفضل مستثمري مرحلة Seed في مجال AI').

- قم بتصفية النتائج حسب 'آخر تحديث' للعثور على المشاركين النشطين الذين يمولون حالياً.

- تصدير البيانات إلى CRM مثل HubSpot أو Pipedrive لتتبع التواصل.

- استخدم روابط الملفات الشخصية لتحديد الاتصالات المشتركة للحصول على مقدمات دافئة.

- تحليل المشهد التنافسي لرأس المال الجريء

يمكن لشركات رأس المال الجريء مراقبة مجالات التركيز وتوسعات الفريق لدى الشركات الأخرى للبقاء في دائرة المنافسة في المنظومة.

- قم بإجراء scraping دوري لقسم 'Firms' في Signal لتتبع التغييرات.

- تحديد الشركات التي تضيف 'Scouts' أو 'Angels' جدداً إلى شبكتها.

- تتبع التحولات في التركيز الاستثماري من خلال مراقبة التغيرات في أعداد قوائم القطاعات بمرور الوقت.

- استراتيجية التوسع الجغرافي

يمكن للشركات أو المستثمرين الذين يتطلعون لدخول أسواق جديدة تحديد اللاعبين الماليين الرئيسيين في مناطق محددة.

- استخراج قوائم خاصة بمناطق معينة مثل 'أمريكا اللاتينية'، أو 'إسرائيل'، أو 'الشرق الأوسط وشمال أفريقيا (MENA)'.

- تصنيف المستثمرين حسب نوع الشركة (رأس مال جريء مقابل مستثمر ملاك) لفهم مزيج رأس المال.

- رسم خريطة لبيئة التمويل المحلية لتحديد المستثمرين الرئيسيين المحتملين لدخول السوق.

- رسم خرائط العلاقات والتوصيات

تحليل الروابط الاجتماعية للعثور على المسار الأسهل للحصول على مقدمات دافئة لمستثمرين بارزين.

- استخراج بيانات الاتصالات المشتركة ومعلومات الرسم البياني الاجتماعي من ملفات تعريف المستثمرين.

- مطابقة الاتصالات المستخرجة مع شبكة LinkedIn الخاصة بك.

- ترتيب أولويات التواصل بناءً على قوة روابط الشبكة الحالية.

- أبحاث السوق حول القطاعات الناشئة

تحليل أي الصناعات الجديدة تكتسب الكثافة الأكبر في رسم الـ venture للتنبؤ بالترند القادم.

- استخراج وسوم قطاعات محددة وأعدادها عبر مراحل التمويل المختلفة.

- حساب نمو اهتمام المستثمرين في فئات معينة على فترات ربع سنوية.

- إنشاء تقارير لأصحاب المصلحة حول المجالات التي تتدفق إليها 'الأموال الذكية' حالياً.

عزز سير عملك مع أتمتة الذكاء الاصطناعي

يجمع Automatio بين قوة وكلاء الذكاء الاصطناعي وأتمتة الويب والتكاملات الذكية لمساعدتك على إنجاز المزيد في وقت أقل.

نصائح احترافية لتجريد Signal (من قبل NFX)

نصائح الخبراء لاستخراج البيانات بنجاح من Signal (من قبل NFX).

إدارة الجلسة (Session Management)

نظراً لأن الملفات الشخصية الكاملة تتطلب تسجيل الدخول، قم بالتقاط ملفات تعريف الارتباط (cookies) وإعادة استخدامها لتجنب محاولات تسجيل الدخول المتكررة التي تطلق تنبيهات أمنية.

اختيار بروكسي (proxy)

استخدم بروكسيات سكنية (residential proxies) عالية الجودة. غالباً ما يتم رصد عناوين IP الخاصة بمراكز البيانات بواسطة نظام حماية البوتات في Cloudflare على الشبكات المهنية.

احترام ملف Robots.txt

تحقق من ملف robots.txt الخاص بـ Signal لمعرفة المسارات المحظورة، وقم بضبط تأخير معقول للزحف (crawl delay) لتجنب تقييد السرعة.

محاكاة السلوك البشري

أضف تأخيرات عشوائية تتراوح بين 2-5 ثوانٍ بين تحميل الصفحات، وقم بمحاكاة حركات الماوس أو التمرير (scrolling) للبقاء بعيداً عن الرصد.

الـ scraping في ساعات خارج الذروة

قم بإجراء عمليات استخراج البيانات واسعة النطاق خلال فترات حركة المرور المنخفضة مثل عطلات نهاية الأسبوع لتقليل الضغط وتقليل احتمالية الاكتشاف.

استقرار الـ Selector

ابحث عن أنماط معرفات (ID) مستقرة أو سمات بيانات (data-testid) إذا كانت متوفرة، حيث أن أسماء الفئات (class names) الداخلية في Signal قد تتغير مع كل عملية تحديث للموقع.

الشهادات

ماذا يقول مستخدمونا

انضم إلى الآلاف من المستخدمين الراضين الذين حولوا سير عملهم

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

ذو صلة Web Scraping

How to Scrape Bilregistret.ai: Swedish Vehicle Data Extraction Guide

How to Scrape Biluppgifter.se: Vehicle Data Extraction Guide

How to Scrape CSS Author: A Comprehensive Web Scraping Guide

How to Scrape The AA (theaa.com): A Technical Guide for Car & Insurance Data

How to Scrape GoAbroad Study Abroad Programs

How to Scrape Car.info | Vehicle Data & Valuation Extraction Guide

How to Scrape ResearchGate: Publication and Researcher Data

How to Scrape Statista: The Ultimate Guide to Market Data Extraction

الأسئلة الشائعة حول Signal (من قبل NFX)

ابحث عن إجابات للأسئلة الشائعة حول Signal (من قبل NFX)