Jak scrapovat jup.ag: Průvodce webovým scraperem pro Jupiter DEX

Naučte se, jak scrapovat jup.ag pro získání cen pro token Solana, swap routes a objemů trhu v reálném čase. Objevte oficiální API Jupiter a obejděte Cloudflare...

Detekována anti-bot ochrana

- Cloudflare

- Podnikový WAF a správa botů. Používá JavaScript výzvy, CAPTCHA a analýzu chování. Vyžaduje automatizaci prohlížeče se stealth nastavením.

- Omezení rychlosti

- Omezuje požadavky na IP/relaci v čase. Lze obejít rotujícími proxy, zpožděním požadavků a distribuovaným scrapingem.

- Otisk prohlížeče

- Identifikuje boty pomocí vlastností prohlížeče: canvas, WebGL, písma, pluginy. Vyžaduje spoofing nebo skutečné profily prohlížeče.

- Otisk prohlížeče

- Identifikuje boty pomocí vlastností prohlížeče: canvas, WebGL, písma, pluginy. Vyžaduje spoofing nebo skutečné profily prohlížeče.

O Jupiter

Objevte, co Jupiter nabízí a jaká cenná data lze extrahovat.

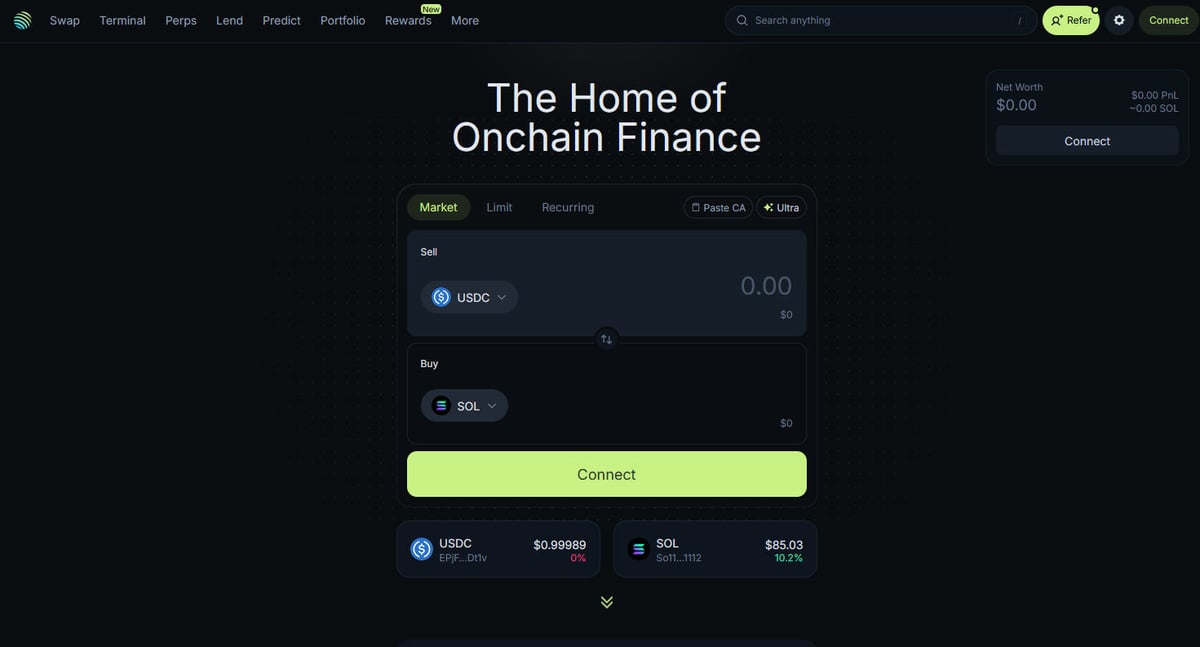

Centrum Solana DeFi

Jupiter je primární agregátor likvidity pro blockchain Solana, fungující jako „DeFi Superapp“, která optimalizuje směrování obchodů napříč stovkami fondů likvidity, aby uživatelům poskytla nejlepší ceny a minimální slippage. Je to centrální uzel pro on-chain finance na Solaně, který nabízí služby od jednoduchých swapů pro token až po pokročilé funkce, jako je obchodování perpetuals s pákou až 250x, limitní příkazy a průměrování nákladů (DCA). Platforma poskytuje kritická data pro ekosystém, včetně cen v reálném čase, hloubky likvidity a komplexních tržních metrik pro tisíce aktiv.

Technická architektura

Web je postaven na moderním technickém stacku využívajícím Next.js a React, což z něj činí vysoce dynamickou jednostránkovou aplikaci (SPA). Protože se ceny a trasy vypočítávají v reálném čase na základě aktuálního stavu blockchainu, frontend se neustále aktualizuje prostřednictvím WebSockets a vysokofrekvenčních volání API. Pro datové vědce, vývojáře a obchodníky jsou data z Jupiter považována za zlatý standard pro sledování tržního sentimentu na Solaně a posunů likvidity v celém ekosystému.

Proč na těchto datech záleží

Přístup k těmto datům je nezbytný pro budování obchodních botů, tržních dashboardů a provádění historických analýz na jedné z nejrychleji rostoucích blockchainových sítí. Scrapery se často zaměřují na Jupiter, aby sledovaly nové výpisy pro token, pohyby „velryb“ na trzích perpetuals nebo identifikovaly cenové rozdíly pro arbitráž. Přestože platforma nabízí oficiální API, přímé webové scrapování se často používá k zachycení přesného stavu UI a specifických dat o směrování, která nemusí být plně dostupná ve veřejných endpointech.

Proč Scrapovat Jupiter?

Objevte obchodní hodnotu a případy použití pro extrakci dat z Jupiter.

Sledování cen pro token Solana v reálném čase

Vývoj botů pro arbitrážní obchodování mezi DEXy

Sledování trendů v objemu trhu a likviditě

Identifikace nových výpisů pro token a tržního sentimentu

Agregace výnosů z půjček a sazeb financování perpetual kontraktů

Analýza historického dopadu ceny u velkých obchodů

Výzvy Scrapování

Technické výzvy, se kterými se můžete setkat při scrapování Jupiter.

Agresivní anti-bot ochrany Cloudflare

Požadavek na plné vykreslování JavaScriptu (React/Next.js)

Agresivní rate limiting založený na IP adrese u veřejných endpointů

Dynamické a obfuskované CSS selektory v UI

Vysokorychlostní aktualizace dat vyžadující nízko-latenční připojení

Scrapujte Jupiter pomocí AI

Žádný kód není potřeba. Extrahujte data během minut s automatizací poháněnou AI.

Jak to funguje

Popište, co potřebujete

Řekněte AI, jaká data chcete extrahovat z Jupiter. Stačí to napsat přirozeným jazykem — žádný kód ani selektory.

AI extrahuje data

Naše umělá inteligence prochází Jupiter, zpracovává dynamický obsah a extrahuje přesně to, co jste požadovali.

Získejte svá data

Získejte čistá, strukturovaná data připravená k exportu jako CSV, JSON nebo k odeslání přímo do vašich aplikací.

Proč používat AI pro scrapování

AI usnadňuje scrapování Jupiter bez psaní kódu. Naše platforma poháněná umělou inteligencí rozumí, jaká data chcete — stačí je popsat přirozeným jazykem a AI je automaticky extrahuje.

How to scrape with AI:

- Popište, co potřebujete: Řekněte AI, jaká data chcete extrahovat z Jupiter. Stačí to napsat přirozeným jazykem — žádný kód ani selektory.

- AI extrahuje data: Naše umělá inteligence prochází Jupiter, zpracovává dynamický obsah a extrahuje přesně to, co jste požadovali.

- Získejte svá data: Získejte čistá, strukturovaná data připravená k exportu jako CSV, JSON nebo k odeslání přímo do vašich aplikací.

Why use AI for scraping:

- No-code extrakce dat z dynamických SPA

- Automatické řešení Cloudflare a otisků prohlížeče

- Plánovaná extrakce pro nepřetržité sledování trhu

- Přímý export dat do Webhooků nebo Google Sheets

No-code webové scrapery pro Jupiter

Alternativy point-and-click k AI scrapingu

Několik no-code nástrojů jako Browse.ai, Octoparse, Axiom a ParseHub vám může pomoci scrapovat Jupiter bez psaní kódu. Tyto nástroje obvykle používají vizuální rozhraní pro výběr dat, i když mohou mít problémy se složitým dynamickým obsahem nebo anti-bot opatřeními.

Typický workflow s no-code nástroji

Běžné výzvy

Křivka učení

Pochopení selektorů a logiky extrakce vyžaduje čas

Selektory se rozbijí

Změny webu mohou rozbít celý pracovní postup

Problémy s dynamickým obsahem

Weby s hodně JavaScriptem vyžadují složitá řešení

Omezení CAPTCHA

Většina nástrojů vyžaduje ruční zásah u CAPTCHA

Blokování IP

Agresivní scrapování může vést k zablokování vaší IP

No-code webové scrapery pro Jupiter

Několik no-code nástrojů jako Browse.ai, Octoparse, Axiom a ParseHub vám může pomoci scrapovat Jupiter bez psaní kódu. Tyto nástroje obvykle používají vizuální rozhraní pro výběr dat, i když mohou mít problémy se složitým dynamickým obsahem nebo anti-bot opatřeními.

Typický workflow s no-code nástroji

- Nainstalujte rozšíření prohlížeče nebo se zaregistrujte na platformě

- Přejděte na cílový web a otevřete nástroj

- Vyberte datové prvky k extrakci kliknutím

- Nakonfigurujte CSS selektory pro každé datové pole

- Nastavte pravidla stránkování pro scrapování více stránek

- Vyřešte CAPTCHA (často vyžaduje ruční řešení)

- Nakonfigurujte plánování automatických spuštění

- Exportujte data do CSV, JSON nebo připojte přes API

Běžné výzvy

- Křivka učení: Pochopení selektorů a logiky extrakce vyžaduje čas

- Selektory se rozbijí: Změny webu mohou rozbít celý pracovní postup

- Problémy s dynamickým obsahem: Weby s hodně JavaScriptem vyžadují složitá řešení

- Omezení CAPTCHA: Většina nástrojů vyžaduje ruční zásah u CAPTCHA

- Blokování IP: Agresivní scrapování může vést k zablokování vaší IP

Příklady kódu

import requests

def get_jupiter_price(token_address):

# Použití oficiálního Jupiter Price API V2 je nejspolehlivější metoda

url = f"https://api.jup.ag/price/v2?ids={token_address}"

headers = {

"User-Agent": "Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/120.0.0.0 Safari/537.36",

"Accept": "application/json"

}

try:

response = requests.get(url, headers=headers)

response.raise_for_status()

data = response.json()

price_info = data['data'].get(token_address)

if price_info:

print(f"Token: {token_address} | Cena: ${price_info['price']}")

except Exception as e:

print(f"Došlo k chybě: {e}")

# Příklad: Získání ceny SOL

get_jupiter_price("So11111111111111111111111111111111111111112")Kdy použít

Nejlepší pro statické HTML stránky s minimem JavaScriptu. Ideální pro blogy, zpravodajské weby a jednoduché e-commerce produktové stránky.

Výhody

- ●Nejrychlejší provedení (bez režie prohlížeče)

- ●Nejnižší spotřeba zdrojů

- ●Snadná paralelizace s asyncio

- ●Skvělé pro API a statické stránky

Omezení

- ●Nemůže spustit JavaScript

- ●Selhává na SPA a dynamickém obsahu

- ●Může mít problémy se složitými anti-bot systémy

Jak scrapovat Jupiter pomocí kódu

Python + Requests

import requests

def get_jupiter_price(token_address):

# Použití oficiálního Jupiter Price API V2 je nejspolehlivější metoda

url = f"https://api.jup.ag/price/v2?ids={token_address}"

headers = {

"User-Agent": "Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/120.0.0.0 Safari/537.36",

"Accept": "application/json"

}

try:

response = requests.get(url, headers=headers)

response.raise_for_status()

data = response.json()

price_info = data['data'].get(token_address)

if price_info:

print(f"Token: {token_address} | Cena: ${price_info['price']}")

except Exception as e:

print(f"Došlo k chybě: {e}")

# Příklad: Získání ceny SOL

get_jupiter_price("So11111111111111111111111111111111111111112")Python + Playwright

from playwright.sync_api import sync_playwright

def scrape_jupiter_tokens():

with sync_playwright() as p:

# Spuštění prohlížeče, který dokáže vykreslit Next.js frontend

browser = p.chromium.launch(headless=True)

context = browser.new_context(

user_agent="Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/120.0.0.0 Safari/537.36"

)

page = context.new_page()

page.goto("https://jup.ag/tokens", wait_until="networkidle")

# Čekání na vykreslení položek seznamu tokenů v DOM

# Poznámka: Selektory musí být aktualizovány podle aktuálního buildu UI

page.wait_for_selector(".token-item")

tokens = page.query_selector_all(".token-item")

for token in tokens[:10]:

name = token.query_selector(".token-name").inner_text()

price = token.query_selector(".token-price").inner_text()

print(f"{name}: {price}")

browser.close()

scrape_jupiter_tokens()Python + Scrapy

import scrapy

import json

class JupiterTokenSpider(scrapy.Spider):

name = 'jupiter_tokens'

# Přímé volání JSON endpointu se seznamem tokenů, který používá frontend

start_urls = ['https://token.jup.ag/all']

def parse(self, response):

# Odpověď je surový JSON seznam všech ověřených tokenů

tokens = json.loads(response.text)

for token in tokens[:100]:

yield {

'symbol': token.get('symbol'),

'name': token.get('name'),

'address': token.get('address'),

'decimals': token.get('decimals'),

'logoURI': token.get('logoURI')

}Node.js + Puppeteer

const puppeteer = require('puppeteer');

(async () => {

const browser = await puppeteer.launch({ headless: true });

const page = await browser.newPage();

// Nastavení realistického User-Agent pro pomoc s obejitím základních filtrů

await page.setUserAgent('Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/120.0.0.0 Safari/537.36');

// Navigace na hlavní swap stránku

await page.goto('https://jup.ag/', { waitUntil: 'networkidle2' });

// Příklad extrakce elementu ceny pomocí částečného selektoru

const solPrice = await page.evaluate(() => {

const element = document.querySelector('div[class*="price"]');

return element ? element.innerText : 'Cena nenalezena';

});

console.log(`Živá cena SOL pozorovaná v UI: ${solPrice}`);

await browser.close();

})();Co Můžete Dělat S Daty Jupiter

Prozkoumejte praktické aplikace a poznatky z dat Jupiter.

Systém upozornění na cenovou arbitráž

Identifikujte cenové rozdíly mezi Jupiter a ostatními Solana DEXy pro provádění ziskových obchodů.

Jak implementovat:

- 1Scrapujte swapové kurzy v reálném čase z Jupiter Price API.

- 2Porovnejte kurzy s pooly likvidity Orca a Raydium.

- 3Nastavte automatická upozornění nebo exekuční hooky pro arbitrážní příležitosti.

Použijte Automatio k extrakci dat z Jupiter a vytvoření těchto aplikací bez psaní kódu.

Co Můžete Dělat S Daty Jupiter

- Systém upozornění na cenovou arbitráž

Identifikujte cenové rozdíly mezi Jupiter a ostatními Solana DEXy pro provádění ziskových obchodů.

- Scrapujte swapové kurzy v reálném čase z Jupiter Price API.

- Porovnejte kurzy s pooly likvidity Orca a Raydium.

- Nastavte automatická upozornění nebo exekuční hooky pro arbitrážní příležitosti.

- Dashboard pro sledování stavu trhu Solana

Sestavte makro pohled na aktivitu v Solana DeFi pro investory.

- Agregujte data o 24h objemu a TVL pro top tokens.

- Kategorizujte tokens podle sektorů (Meme, AI, RWA).

- Vizualizujte posuny likvidity mezi různými třídami aktiv v čase.

- Sniper pro výpis nových tokenů

Okamžitě detekujte a analyzujte nové tokens objevující se na ověřeném seznamu Jupiter.

- Pravidelně scrapujte endpoint se seznamem pro token.

- Porovnejte nové výsledky s lokální databází a najděte nové přírůstky.

- Analyzujte počáteční likviditu a objem pro posouzení potenciálu pro token.

- Sledování velryb a Perps

Monitorujte velké pozice a sazby financování na trhu Jupiter Perpetuals.

- Scrapujte data o open interest a funding rate ze sekce Perps.

- Sledujte logy velkých transakcí pro identifikaci chování peněženek.

- Sestavte modely sentimentu založené na poměru long/short pozic u hlavních aktiv.

- Služba pro agregaci výnosů

Poskytujte uživatelům nejlepší dostupné sazby půjček napříč vaulty Jupiter Lend.

- Scrapujte data APY pro různé stablecoiny a SOL páry.

- Vypočítejte čistý výnos po odečtení odhadovaných poplatků platformy.

- Automatizujte doporučení pro rebalanci za účelem optimalizace portfolia.

Zrychlete svuj workflow s AI automatizaci

Automatio kombinuje silu AI agentu, webove automatizace a chytrych integraci, aby vam pomohl dosahnout vice za kratsi cas.

Profesionální Tipy Pro Scrapování Jupiter

Odborné rady pro úspěšnou extrakci dat z Jupiter.

Vždy upřednostňujte oficiální API na api.jup.ag před pokusy o scrapování HTML frontendu.

Používejte rezidenční proxy k minimalizaci blokování ze strany Cloudflare, protože IP adresy datových center jsou často na černé listině.

Povolte ve svém scraperu HTTP2, abyste odpovídali standardním otiskům prohlížeče a vyhnuli se detekci.

Zkoumejte WebSocket spojení (wss

//) v záložce network pro nejefektivnější streamování cen v reálném čase.

Implementujte robustní zpracování chyb pro odpovědi 403 Forbidden, které indikují blokování Cloudflare.

Cilte na endpoint https

//token.jup.ag/all, pokud potřebujete pouze statický seznam ověřených adres pro token.

Reference

Co rikaji nasi uzivatele

Pridejte se k tisicum spokojenych uzivatelu, kteri transformovali svuj workflow

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Souvisejici Web Scraping

How to Scrape Moon.ly | Step-by-Step NFT Data Extraction Guide

How to Scrape Yahoo Finance: Extract Stock Market Data

How to Scrape Rocket Mortgage: A Comprehensive Guide

How to Scrape Open Collective: Financial and Contributor Data Guide

How to Scrape Indiegogo: The Ultimate Crowdfunding Data Extraction Guide

How to Scrape ICO Drops: Comprehensive Crypto Data Guide

How to Scrape Crypto.com: Comprehensive Market Data Guide

How to Scrape Coinpaprika: Crypto Market Data Extraction Guide

Casto kladene dotazy o Jupiter

Najdete odpovedi na bezne otazky o Jupiter