Sådan scraper du Goodreads: Den ultimative guide til web scraping 2025

Lær hvordan du scraper Goodreads for bogdata, anmeldelser og vurderinger i 2025. Denne guide dækker omgåelse af anti-bot, Python-kodeeksempler og use cases til...

Anti-bot beskyttelse opdaget

- Cloudflare

- Enterprise WAF og bot-håndtering. Bruger JavaScript-udfordringer, CAPTCHAs og adfærdsanalyse. Kræver browserautomatisering med stealth-indstillinger.

- DataDome

- Realtids bot-detektion med ML-modeller. Analyserer enhedsfingeraftryk, netværkssignaler og adfærdsmønstre. Almindelig på e-handelssider.

- Google reCAPTCHA

- Googles CAPTCHA-system. v2 kræver brugerinteraktion, v3 kører lydløst med risikovurdering. Kan løses med CAPTCHA-tjenester.

- Hastighedsbegrænsning

- Begrænser forespørgsler pr. IP/session over tid. Kan omgås med roterende proxyer, forespørgselsforsinkelser og distribueret scraping.

- IP-blokering

- Blokerer kendte datacenter-IP'er og markerede adresser. Kræver bolig- eller mobilproxyer for effektiv omgåelse.

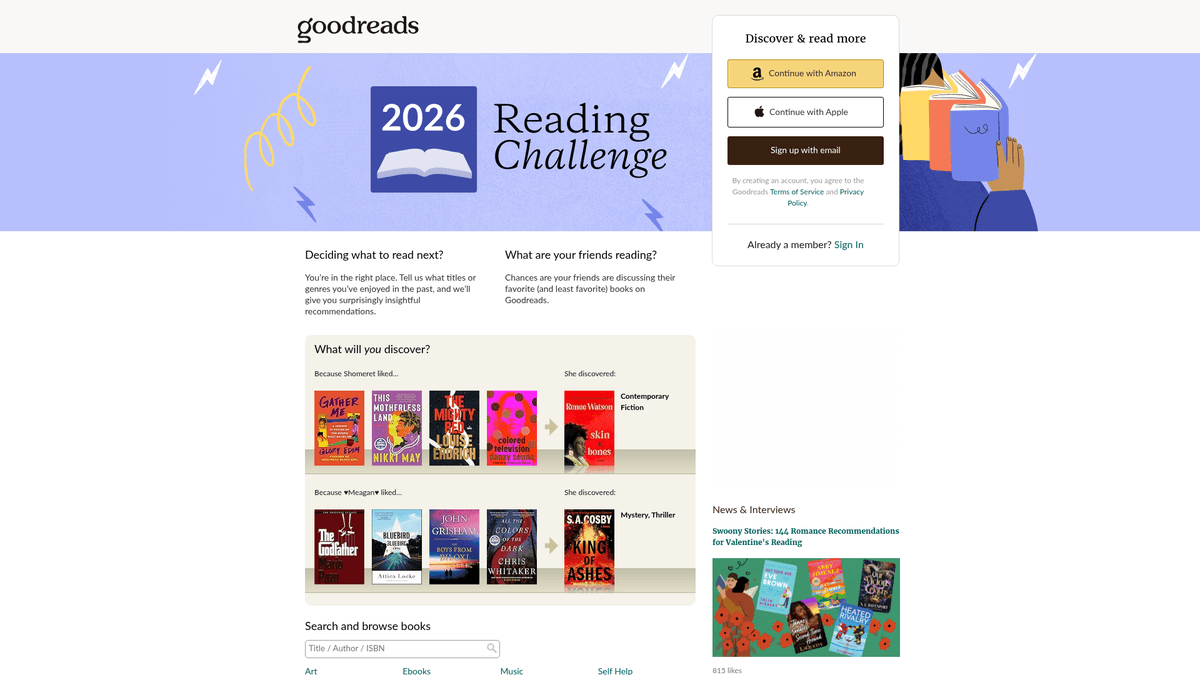

Om Goodreads

Opdag hvad Goodreads tilbyder og hvilke værdifulde data der kan udtrækkes.

Verdens største sociale platform for katalogisering

Goodreads er den førende sociale medieplatform for bogelskere, ejet og drevet af Amazon. Det fungerer som et massivt lager for litterære data med millioner af bogopslag, brugergenererede anmeldelser, noter og læselister. Platformen er organiseret i genrer og brugergenererede 'hylder', hvilket giver dyb indsigt i globale læsevaner og litterære tendenser.

En skattekiste af litterære data

Platformen indeholder detaljerede data, herunder ISBN'er, genrer, forfatterbibliografier og detaljerede læserholdninger. For virksomheder og forskere giver disse data dyb indsigt i markedstendenser og forbrugerpræferencer. Scraped data fra Goodreads er uvurderlige for forlag, forfattere og forskere til at udføre konkurrenceanalyser og identificere nye litterære motiver.

Hvorfor scrape Goodreads-data?

Scraping af dette site giver adgang til popularitetsmålinger i realtid, konkurrenceanalyser for forfattere og datasæt af høj kvalitet til træning af anbefalingssystemer eller til akademisk forskning inden for humaniora. Det giver brugerne mulighed for at søge i den massive database, mens de holder styr på læsefremskridt, hvilket giver et unikt indblik i, hvordan forskellige demografiske grupper interagerer med bøger.

Hvorfor Skrabe Goodreads?

Opdag forretningsværdien og brugsscenarier for dataudtrækning fra Goodreads.

Udføre markedsundersøgelser for tendenser i forlagsbranchen

Udføre sentiment analysis på læseranmeldelser

Overvåge popularitet i realtid for trending titler

Bygge avancerede anbefalingsmotorer baseret på mønstre i boghylder

Aggregere metadata til akademisk og kulturel forskning

Skrabningsudfordringer

Tekniske udfordringer du kan støde på når du skraber Goodreads.

Aggressiv Cloudflare og DataDome bot-modvirkning

Stor afhængighed af JavaScript til moderne UI-rendering

UI-inkonsekvens mellem ældre og React-baserede sidedesign

Streng rate limiting, der kræver sofistikeret proxy-rotation

Skrab Goodreads med AI

Ingen kode nødvendig. Udtræk data på minutter med AI-drevet automatisering.

Sådan fungerer det

Beskriv hvad du har brug for

Fortæl AI'en hvilke data du vil udtrække fra Goodreads. Skriv det bare på almindeligt sprog — ingen kode eller selektorer nødvendige.

AI udtrækker dataene

Vores kunstige intelligens navigerer Goodreads, håndterer dynamisk indhold og udtrækker præcis det du bad om.

Få dine data

Modtag rene, strukturerede data klar til eksport som CSV, JSON eller send direkte til dine apps og workflows.

Hvorfor bruge AI til skrabning

AI gør det nemt at skrabe Goodreads uden at skrive kode. Vores AI-drevne platform bruger kunstig intelligens til at forstå hvilke data du ønsker — beskriv det på almindeligt sprog, og AI udtrækker dem automatisk.

How to scrape with AI:

- Beskriv hvad du har brug for: Fortæl AI'en hvilke data du vil udtrække fra Goodreads. Skriv det bare på almindeligt sprog — ingen kode eller selektorer nødvendige.

- AI udtrækker dataene: Vores kunstige intelligens navigerer Goodreads, håndterer dynamisk indhold og udtrækker præcis det du bad om.

- Få dine data: Modtag rene, strukturerede data klar til eksport som CSV, JSON eller send direkte til dine apps og workflows.

Why use AI for scraping:

- No-code opbygning af komplekse bog-scrapers

- Automatisk håndtering af Cloudflare og anti-bot systemer

- Cloud-afvikling til dataekstraktion i store mængder

- Planlagte kørsler til overvågning af daglige rangændringer

- Nem håndtering af dynamisk indhold og infinite scroll

No-code webscrapere til Goodreads

Point-and-click alternativer til AI-drevet scraping

Flere no-code værktøjer som Browse.ai, Octoparse, Axiom og ParseHub kan hjælpe dig med at scrape Goodreads uden at skrive kode. Disse værktøjer bruger typisk visuelle interfaces til at vælge data, selvom de kan have problemer med komplekst dynamisk indhold eller anti-bot foranstaltninger.

Typisk workflow med no-code værktøjer

Almindelige udfordringer

Indlæringskurve

At forstå selektorer og ekstraktionslogik tager tid

Selektorer går i stykker

Webstedsændringer kan ødelægge hele din arbejdsgang

Problemer med dynamisk indhold

JavaScript-tunge sider kræver komplekse løsninger

CAPTCHA-begrænsninger

De fleste værktøjer kræver manuel indgriben for CAPTCHAs

IP-blokering

Aggressiv scraping kan føre til blokering af din IP

No-code webscrapere til Goodreads

Flere no-code værktøjer som Browse.ai, Octoparse, Axiom og ParseHub kan hjælpe dig med at scrape Goodreads uden at skrive kode. Disse værktøjer bruger typisk visuelle interfaces til at vælge data, selvom de kan have problemer med komplekst dynamisk indhold eller anti-bot foranstaltninger.

Typisk workflow med no-code værktøjer

- Installer browserudvidelse eller tilmeld dig platformen

- Naviger til målwebstedet og åbn værktøjet

- Vælg dataelementer med point-and-click

- Konfigurer CSS-selektorer for hvert datafelt

- Opsæt pagineringsregler til at scrape flere sider

- Håndter CAPTCHAs (kræver ofte manuel løsning)

- Konfigurer planlægning for automatiske kørsler

- Eksporter data til CSV, JSON eller forbind via API

Almindelige udfordringer

- Indlæringskurve: At forstå selektorer og ekstraktionslogik tager tid

- Selektorer går i stykker: Webstedsændringer kan ødelægge hele din arbejdsgang

- Problemer med dynamisk indhold: JavaScript-tunge sider kræver komplekse løsninger

- CAPTCHA-begrænsninger: De fleste værktøjer kræver manuel indgriben for CAPTCHAs

- IP-blokering: Aggressiv scraping kan føre til blokering af din IP

Kodeeksempler

import requests

from bs4 import BeautifulSoup

# Mål-URL for en specifik bog

url = 'https://www.goodreads.com/book/show/1.Harry_Potter'

# Essentielle headers for at undgå øjeblikkelig blokering

headers = {'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) Chrome/119.0.0.0 Safari/537.36'}

try:

response = requests.get(url, headers=headers, timeout=10)

response.raise_for_status()

soup = BeautifulSoup(response.text, 'html.parser')

# Brug data-testid til den moderne React-baserede UI

title = soup.find('h1', {'data-testid': 'bookTitle'}).text.strip()

author = soup.find('span', {'data-testid': 'name'}).text.strip()

print(f'Titel: {title}, Forfatter: {author}')

except Exception as e:

print(f'Scraping mislykkedes: {e}')Hvornår skal det bruges

Bedst til statiske HTML-sider med minimal JavaScript. Ideel til blogs, nyhedssider og simple e-handelsprodukt sider.

Fordele

- ●Hurtigste udførelse (ingen browser overhead)

- ●Laveste ressourceforbrug

- ●Let at parallelisere med asyncio

- ●Fremragende til API'er og statiske sider

Begrænsninger

- ●Kan ikke køre JavaScript

- ●Fejler på SPA'er og dynamisk indhold

- ●Kan have problemer med komplekse anti-bot systemer

Sådan scraper du Goodreads med kode

Python + Requests

import requests

from bs4 import BeautifulSoup

# Mål-URL for en specifik bog

url = 'https://www.goodreads.com/book/show/1.Harry_Potter'

# Essentielle headers for at undgå øjeblikkelig blokering

headers = {'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) Chrome/119.0.0.0 Safari/537.36'}

try:

response = requests.get(url, headers=headers, timeout=10)

response.raise_for_status()

soup = BeautifulSoup(response.text, 'html.parser')

# Brug data-testid til den moderne React-baserede UI

title = soup.find('h1', {'data-testid': 'bookTitle'}).text.strip()

author = soup.find('span', {'data-testid': 'name'}).text.strip()

print(f'Titel: {title}, Forfatter: {author}')

except Exception as e:

print(f'Scraping mislykkedes: {e}')Python + Playwright

from playwright.sync_api import sync_playwright

with sync_playwright() as p:

# Lancering af en browser er nødvendig for Cloudflare/JS-sider

browser = p.chromium.launch(headless=True)

page = browser.new_page()

page.goto('https://www.goodreads.com/search?q=fantasy')

# Vent på at den specifikke data-attribut renderes

page.wait_for_selector('[data-testid="bookTitle"]')

books = page.query_selector_all('.bookTitle')

for book in books:

print(book.inner_text().strip())

browser.close()Python + Scrapy

import scrapy

class GoodreadsSpider(scrapy.Spider):

name = 'goodreads_spider'

start_urls = ['https://www.goodreads.com/list/show/1.Best_Books_Ever']

def parse(self, response):

# Målret schema.org-markup for mere stabile selektorer

for book in response.css('tr[itemtype="http://schema.org/Book"]'):

yield {

'title': book.css('.bookTitle span::text').get(),

'author': book.css('.authorName span::text').get(),

'rating': book.css('.minirating::text').get(),

}

# Standard håndtering af paginering

next_page = response.css('a.next_page::attr(href)').get()

if next_page:

yield response.follow(next_page, self.parse)Node.js + Puppeteer

const puppeteer = require('puppeteer');

(async () => {

const browser = await puppeteer.launch();

const page = await browser.newPage();

// Goodreads bruger moderne JS, så vi venter på specifikke komponenter

await page.goto('https://www.goodreads.com/book/show/1.Harry_Potter');

await page.waitForSelector('[data-testid="bookTitle"]');

const data = await page.evaluate(() => ({

title: document.querySelector('[data-testid="bookTitle"]').innerText,

author: document.querySelector('[data-testid="name"]').innerText,

rating: document.querySelector('.RatingStatistics__rating').innerText

}));

console.log(data);

await browser.close();

})();Hvad Du Kan Gøre Med Goodreads-Data

Udforsk praktiske anvendelser og indsigter fra Goodreads-data.

Prædiktiv bestseller-analyse

Udgivere analyserer tidlige anmeldelser og hastigheden for boghylde-tilføjelser for at forudsige kommende hits.

Sådan implementeres:

- 1Overvåg 'Want to Read'-antal for kommende bøger.

- 2Scrape tidlige Advance Reader Copy (ARC) anmeldelser.

- 3Sammenlign sentiment mod historiske bestseller-data.

Brug Automatio til at udtrække data fra Goodreads og bygge disse applikationer uden at skrive kode.

Hvad Du Kan Gøre Med Goodreads-Data

- Prædiktiv bestseller-analyse

Udgivere analyserer tidlige anmeldelser og hastigheden for boghylde-tilføjelser for at forudsige kommende hits.

- Overvåg 'Want to Read'-antal for kommende bøger.

- Scrape tidlige Advance Reader Copy (ARC) anmeldelser.

- Sammenlign sentiment mod historiske bestseller-data.

- Konkurrencemæssig forfatter-intelligence

Forfattere sporer genre-motiver og vurderingstendenser for at optimere deres egen skrivning og markedsføring.

- Scrape de bedst bedømte bøger på en specifik genre-hylde.

- Udtræk tilbagevendende litterære motiver fra læseranmeldelser.

- Analyser vurderingshastighed efter markedsføringskampagner.

- Niche-anbefalingsmotorer

Udviklere bygger værktøjer til at finde bøger, der matcher specifikke, komplekse kriterier, som ikke understøttes af hovedsitet.

- Scrape brugerdefinerede tags og krydsreferér dem.

- Kortlæg vurderinger for at finde unikke korrelationer mellem forfattere.

- Lever resultater via en API til en webapplikation.

- Sentiment-baseret bogfiltrering

Forskere bruger NLP på anmeldelser til at kategorisere bøger baseret på følelsesmæssig påvirkning frem for genre.

- Udtræk tusindvis af brugeranmeldelser for en specifik kategori.

- Kør sentiment analysis og søgeordsudtrækning.

- Byg et datasæt til machine learning modeller.

Supercharg din arbejdsgang med AI-automatisering

Automatio kombinerer kraften fra AI-agenter, webautomatisering og smarte integrationer for at hjælpe dig med at udrette mere på kortere tid.

Professionelle Tips til Skrabning af Goodreads

Ekspertråd til succesfuld dataudtrækning fra Goodreads.

Brug altid residential proxies for at omgå Cloudflare 403-blokeringer.

Målret stabile data-testid-attributter frem for randomiserede CSS-klassenavne.

Parse __NEXT_DATA__ JSON-script-tagget for pålidelig ekstraktion af metadata.

Implementer tilfældige forsinkelser på mellem 3-7 sekunder for at efterligne menneskelig adfærd.

Scrape i ydertimerne for at reducere risikoen for at udløse rate limits.

Overvåg UI-skift mellem ældre PHP-sider og det nyere React-baserede layout.

Anmeldelser

Hvad vores brugere siger

Slut dig til tusindvis af tilfredse brugere, der har transformeret deres arbejdsgang

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Relateret Web Scraping

How to Scrape Behance: A Step-by-Step Guide for Creative Data Extraction

How to Scrape YouTube: Extract Video Data and Comments in 2025

How to Scrape Bento.me | Bento.me Web Scraper

How to Scrape Vimeo: A Guide to Extracting Video Metadata

How to Scrape Social Blade: The Ultimate Analytics Guide

How to Scrape Imgur: A Comprehensive Guide to Image Data Extraction

How to Scrape Patreon Creator Data and Posts

How to Scrape Bluesky (bsky.app): API and Web Methods

Ofte stillede spørgsmål om Goodreads

Find svar på almindelige spørgsmål om Goodreads