Sådan scraper du jup.ag: Jupiter DEX Web Scraper Guide

Lær hvordan du scraper jup.ag for real-tids Solana token-priser, swap-ruter og markedsvolumen. Opdag Jupiters officielle API'er og omgå Cloudflare anti-bot.

Anti-bot beskyttelse opdaget

- Cloudflare

- Enterprise WAF og bot-håndtering. Bruger JavaScript-udfordringer, CAPTCHAs og adfærdsanalyse. Kræver browserautomatisering med stealth-indstillinger.

- Hastighedsbegrænsning

- Begrænser forespørgsler pr. IP/session over tid. Kan omgås med roterende proxyer, forespørgselsforsinkelser og distribueret scraping.

- Browserfingeraftryk

- Identificerer bots gennem browseregenskaber: canvas, WebGL, skrifttyper, plugins. Kræver forfalskning eller ægte browserprofiler.

- Browserfingeraftryk

- Identificerer bots gennem browseregenskaber: canvas, WebGL, skrifttyper, plugins. Kræver forfalskning eller ægte browserprofiler.

Om Jupiter

Opdag hvad Jupiter tilbyder og hvilke værdifulde data der kan udtrækkes.

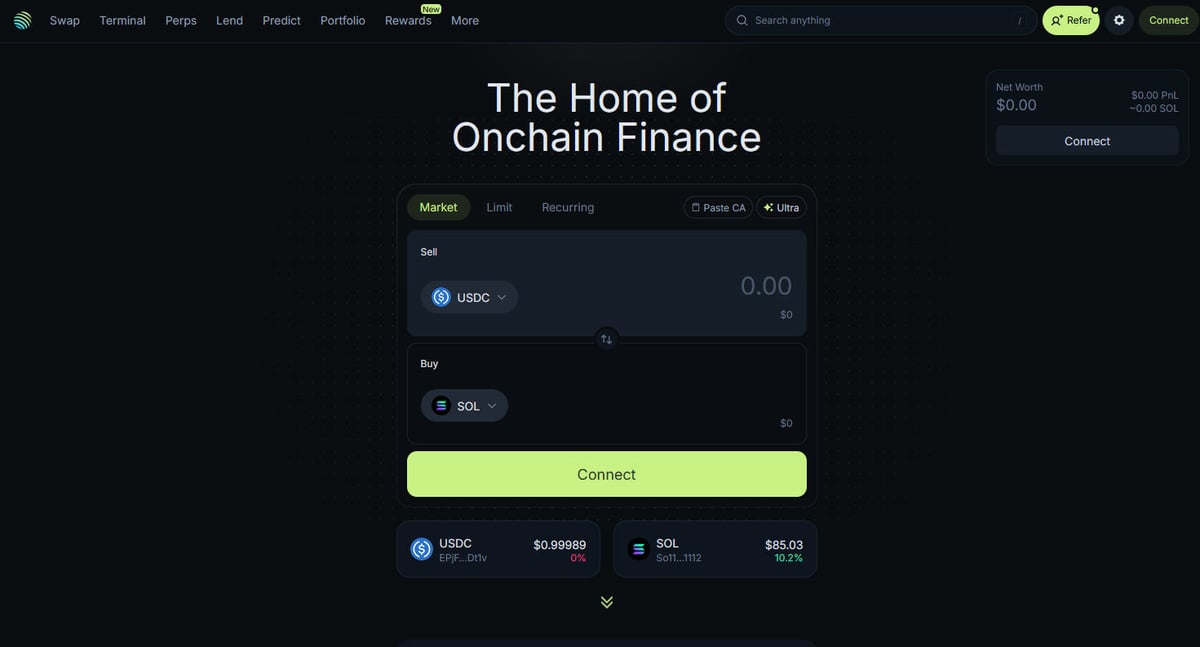

Centrum for Solana DeFi

Jupiter er den primære likviditetsaggregator for Solana-blockchainen og fungerer som en "DeFi Superapp", der optimerer trade routing på tværs af hundreder af likviditetspools for at give brugerne de bedste priser og minimal slippage. Det er det centrale knudepunkt for Solanas on-chain finansiering og tilbyder tjenester lige fra simple token-swaps til avancerede funktioner som perpetual trading med op til 250x gearing, limit orders og dollar-cost averaging (DCA). Platformen leverer kritiske data til økosystemet, herunder priser i realtid, likviditetsdybde og omfattende markedsmetrikker for tusindvis af aktiver.

Teknisk Arkitektur

Websitet er bygget på et moderne teknisk stack med Next.js og React, hvilket gør det til en yderst dynamisk single-page application (SPA). Da priser og ruter beregnes i realtid baseret på den aktuelle blockchain-status, opdateres frontend'en konstant via WebSockets og højfrekvente API-kald. For data scientists, udviklere og tradere anses Jupiters data for at være guldstandarden til sporing af Solana-markedsstemning og likviditetsforskydninger i hele økosystemet.

Hvorfor dataene er vigtige

Adgang til disse data er afgørende for at bygge trading-bots, markeds-dashboards og udføre historisk analyse på et af de hurtigst voksende blockchain-netværk. Scrapere målretter ofte Jupiter for at overvåge nye token-noteringer, spore "whale"-bevægelser på perpetual-markeder eller identificere prisafvigelser til arbitrage. Selvom platformen tilbyder officielle API'er, bruges direkte web scraping ofte til at fange den præcise UI-tilstand og specifikke routing-data, som måske ikke er fuldt eksponeret i offentlige endpoints.

Hvorfor Skrabe Jupiter?

Opdag forretningsværdien og brugsscenarier for dataudtrækning fra Jupiter.

Prisovervågning i realtid for Solana tokens

Udvikling af arbitrage-trading-bots mellem DEXs

Sporing af markedsvolumen og likviditetstrends

Identificering af nye token-noteringer og markedsstemning

Aggregering af udlånsafkast og perpetual funding rates

Analyse af historisk prispåvirkning for store handler

Skrabningsudfordringer

Tekniske udfordringer du kan støde på når du skraber Jupiter.

Aggressive Cloudflare anti-bot-beskyttelser

Krav om fuld JavaScript-rendering (React/Next.js)

Aggressiv IP-baseret rate limiting på offentlige endpoints

Dynamiske og obfuskerede CSS-selectors i brugerfladen

Højhastigheds-dataopdateringer, der kræver forbindelser med lav latency

Skrab Jupiter med AI

Ingen kode nødvendig. Udtræk data på minutter med AI-drevet automatisering.

Sådan fungerer det

Beskriv hvad du har brug for

Fortæl AI'en hvilke data du vil udtrække fra Jupiter. Skriv det bare på almindeligt sprog — ingen kode eller selektorer nødvendige.

AI udtrækker dataene

Vores kunstige intelligens navigerer Jupiter, håndterer dynamisk indhold og udtrækker præcis det du bad om.

Få dine data

Modtag rene, strukturerede data klar til eksport som CSV, JSON eller send direkte til dine apps og workflows.

Hvorfor bruge AI til skrabning

AI gør det nemt at skrabe Jupiter uden at skrive kode. Vores AI-drevne platform bruger kunstig intelligens til at forstå hvilke data du ønsker — beskriv det på almindeligt sprog, og AI udtrækker dem automatisk.

How to scrape with AI:

- Beskriv hvad du har brug for: Fortæl AI'en hvilke data du vil udtrække fra Jupiter. Skriv det bare på almindeligt sprog — ingen kode eller selektorer nødvendige.

- AI udtrækker dataene: Vores kunstige intelligens navigerer Jupiter, håndterer dynamisk indhold og udtrækker præcis det du bad om.

- Få dine data: Modtag rene, strukturerede data klar til eksport som CSV, JSON eller send direkte til dine apps og workflows.

Why use AI for scraping:

- No-code dataudtrækning fra dynamiske SPA'er

- Automatisk håndtering af Cloudflare og browser fingerprints

- Skemalagt ekstraktion til kontinuerlig markedsovervågning

- Direkte dataeksport til Webhooks eller Google Sheets

No-code webscrapere til Jupiter

Point-and-click alternativer til AI-drevet scraping

Flere no-code værktøjer som Browse.ai, Octoparse, Axiom og ParseHub kan hjælpe dig med at scrape Jupiter uden at skrive kode. Disse værktøjer bruger typisk visuelle interfaces til at vælge data, selvom de kan have problemer med komplekst dynamisk indhold eller anti-bot foranstaltninger.

Typisk workflow med no-code værktøjer

Almindelige udfordringer

Indlæringskurve

At forstå selektorer og ekstraktionslogik tager tid

Selektorer går i stykker

Webstedsændringer kan ødelægge hele din arbejdsgang

Problemer med dynamisk indhold

JavaScript-tunge sider kræver komplekse løsninger

CAPTCHA-begrænsninger

De fleste værktøjer kræver manuel indgriben for CAPTCHAs

IP-blokering

Aggressiv scraping kan føre til blokering af din IP

No-code webscrapere til Jupiter

Flere no-code værktøjer som Browse.ai, Octoparse, Axiom og ParseHub kan hjælpe dig med at scrape Jupiter uden at skrive kode. Disse værktøjer bruger typisk visuelle interfaces til at vælge data, selvom de kan have problemer med komplekst dynamisk indhold eller anti-bot foranstaltninger.

Typisk workflow med no-code værktøjer

- Installer browserudvidelse eller tilmeld dig platformen

- Naviger til målwebstedet og åbn værktøjet

- Vælg dataelementer med point-and-click

- Konfigurer CSS-selektorer for hvert datafelt

- Opsæt pagineringsregler til at scrape flere sider

- Håndter CAPTCHAs (kræver ofte manuel løsning)

- Konfigurer planlægning for automatiske kørsler

- Eksporter data til CSV, JSON eller forbind via API

Almindelige udfordringer

- Indlæringskurve: At forstå selektorer og ekstraktionslogik tager tid

- Selektorer går i stykker: Webstedsændringer kan ødelægge hele din arbejdsgang

- Problemer med dynamisk indhold: JavaScript-tunge sider kræver komplekse løsninger

- CAPTCHA-begrænsninger: De fleste værktøjer kræver manuel indgriben for CAPTCHAs

- IP-blokering: Aggressiv scraping kan føre til blokering af din IP

Kodeeksempler

import requests

def get_jupiter_price(token_address):

# Brug af den officielle Jupiter Price API V2 er den mest pålidelige metode

url = f"https://api.jup.ag/price/v2?ids={token_address}"

headers = {

"User-Agent": "Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/120.0.0.0 Safari/537.36",

"Accept": "application/json"

}

try:

response = requests.get(url, headers=headers)

response.raise_for_status()

data = response.json()

price_info = data['data'].get(token_address)

if price_info:

print(f"Token: {token_address} | Pris: ${price_info['price']}")

except Exception as e:

print(f"Der opstod en fejl: {e}")

# Eksempel: Hent SOL-pris

get_jupiter_price("So11111111111111111111111111111111111111112")Hvornår skal det bruges

Bedst til statiske HTML-sider med minimal JavaScript. Ideel til blogs, nyhedssider og simple e-handelsprodukt sider.

Fordele

- ●Hurtigste udførelse (ingen browser overhead)

- ●Laveste ressourceforbrug

- ●Let at parallelisere med asyncio

- ●Fremragende til API'er og statiske sider

Begrænsninger

- ●Kan ikke køre JavaScript

- ●Fejler på SPA'er og dynamisk indhold

- ●Kan have problemer med komplekse anti-bot systemer

Sådan scraper du Jupiter med kode

Python + Requests

import requests

def get_jupiter_price(token_address):

# Brug af den officielle Jupiter Price API V2 er den mest pålidelige metode

url = f"https://api.jup.ag/price/v2?ids={token_address}"

headers = {

"User-Agent": "Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/120.0.0.0 Safari/537.36",

"Accept": "application/json"

}

try:

response = requests.get(url, headers=headers)

response.raise_for_status()

data = response.json()

price_info = data['data'].get(token_address)

if price_info:

print(f"Token: {token_address} | Pris: ${price_info['price']}")

except Exception as e:

print(f"Der opstod en fejl: {e}")

# Eksempel: Hent SOL-pris

get_jupiter_price("So11111111111111111111111111111111111111112")Python + Playwright

from playwright.sync_api import sync_playwright

def scrape_jupiter_tokens():

with sync_playwright() as p:

# Start en browser, der kan rendre Next.js frontenden

browser = p.chromium.launch(headless=True)

context = browser.new_context(

user_agent="Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/120.0.0.0 Safari/537.36"

)

page = context.new_page()

page.goto("https://jup.ag/tokens", wait_until="networkidle")

# Vent på, at token-listeelementerne rendres i DOM'en

# Bemærk: Selectors skal opdateres baseret på det aktuelle UI-build

page.wait_for_selector(".token-item")

tokens = page.query_selector_all(".token-item")

for token in tokens[:10]:

name = token.query_selector(".token-name").inner_text()

price = token.query_selector(".token-price").inner_text()

print(f"{name}: {price}")

browser.close()

scrape_jupiter_tokens()Python + Scrapy

import scrapy

import json

class JupiterTokenSpider(scrapy.Spider):

name = 'jupiter_tokens'

# Tilgår direkte token-listen via JSON-endpointet brugt af frontenden

start_urls = ['https://token.jup.ag/all']

def parse(self, response):

# Svaret er en rå JSON-liste over alle verificerede tokens

tokens = json.loads(response.text)

for token in tokens[:100]:

yield {

'symbol': token.get('symbol'),

'name': token.get('name'),

'address': token.get('address'),

'decimals': token.get('decimals'),

'logoURI': token.get('logoURI')

}Node.js + Puppeteer

const puppeteer = require('puppeteer');

(async () => {

const browser = await puppeteer.launch({ headless: true });

const page = await browser.newPage();

// Indstil en realistisk User-Agent for at hjælpe med at omgå grundlæggende filtre

await page.setUserAgent('Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/120.0.0.0 Safari/537.36');

// Naviger til hovedsiden for swap

await page.goto('https://jup.ag/', { waitUntil: 'networkidle2' });

// Eksempel på ekstraktion af et priselement ved hjælp af en delvis selector

const solPrice = await page.evaluate(() => {

const element = document.querySelector('div[class*="price"]');

return element ? element.innerText : 'Pris ikke fundet';

});

console.log(`Live SOL-pris observeret i UI: ${solPrice}`);

await browser.close();

})();Hvad Du Kan Gøre Med Jupiter-Data

Udforsk praktiske anvendelser og indsigter fra Jupiter-data.

Alarmsystem til prisarbitrage

Identificer prisforskelle mellem Jupiter og andre Solana DEXs for at udføre profitable handler.

Sådan implementeres:

- 1Scrape real-tids swap-kurser fra Jupiters Price API.

- 2Sammenlign kurser med Orca og Raydium likviditetspools.

- 3Opsæt automatiserede alarmer eller execution hooks til arbitrage-muligheder.

Brug Automatio til at udtrække data fra Jupiter og bygge disse applikationer uden at skrive kode.

Hvad Du Kan Gøre Med Jupiter-Data

- Alarmsystem til prisarbitrage

Identificer prisforskelle mellem Jupiter og andre Solana DEXs for at udføre profitable handler.

- Scrape real-tids swap-kurser fra Jupiters Price API.

- Sammenlign kurser med Orca og Raydium likviditetspools.

- Opsæt automatiserede alarmer eller execution hooks til arbitrage-muligheder.

- Dashboard for Solana-markedets sundhed

Byg et makro-blik på Solana DeFi-aktivitet for investorer.

- Aggreger 24-timers volumen og TVL-data for de mest populære tokens.

- Kategoriser tokens efter sektorer (Meme, AI, RWA).

- Visualiser likviditetsforskydninger på tværs af forskellige aktivklasser over tid.

- Sniper til nye token-noteringer

Detekter og analyser nye tokens, der dukker op på Jupiters verificerede liste med det samme.

- Scrape regelmæssigt token-liste endpointet.

- Sammenlign de nye resultater med en lokal database for at finde nye tilføjelser.

- Analyser indledende likviditet og volumen for at vurdere en tokens potentiale.

- Whale og Perps-tracker

Overvåg store positioner og funding rates på Jupiter Perpetuals-markedet.

- Scrape open interest og funding rate-data fra Perps-sektionen.

- Spor store transaktionslogs for at identificere wallet-adfærd.

- Byg stemningsmodeller baseret på long/short-ratioer for store aktiver.

- Yield Aggregation-tjeneste

Giv brugerne de bedste udlånsrenter tilgængelige på tværs af Jupiter Lend-vaults.

- Scrape APY-data for forskellige stablecoins og SOL-par.

- Beregn nettoafkast efter estimerede platformgebyrer.

- Automatiser anbefalinger til rebalancering for porteføljeoptimering.

Supercharg din arbejdsgang med AI-automatisering

Automatio kombinerer kraften fra AI-agenter, webautomatisering og smarte integrationer for at hjælpe dig med at udrette mere på kortere tid.

Professionelle Tips til Skrabning af Jupiter

Ekspertråd til succesfuld dataudtrækning fra Jupiter.

Prioriter altid den officielle API på api.jup.ag, før du forsøger at scrape HTML-frontend'en.

Brug residential proxies for at minimere Cloudflare-blokeringer, da datacenter-IP'er ofte er sortlistet.

Aktiver HTTP2 i din scraper for at matche standard browser fingerprints og undgå detektering.

Undersøg WebSocket-forbindelser (wss

//) i netværksfanen for den mest effektive pris-streaming i realtid.

Implementer robust fejlhåndtering for 403 Forbidden-svar, som indikerer Cloudflare-blokering.

Målret din scraping mod https

//token.jup.ag/all endpointet, hvis du kun har brug for den statiske liste over verificerede token-adresser.

Anmeldelser

Hvad vores brugere siger

Slut dig til tusindvis af tilfredse brugere, der har transformeret deres arbejdsgang

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Relateret Web Scraping

How to Scrape Moon.ly | Step-by-Step NFT Data Extraction Guide

How to Scrape Yahoo Finance: Extract Stock Market Data

How to Scrape Rocket Mortgage: A Comprehensive Guide

How to Scrape Open Collective: Financial and Contributor Data Guide

How to Scrape Indiegogo: The Ultimate Crowdfunding Data Extraction Guide

How to Scrape ICO Drops: Comprehensive Crypto Data Guide

How to Scrape Crypto.com: Comprehensive Market Data Guide

How to Scrape Coinpaprika: Crypto Market Data Extraction Guide

Ofte stillede spørgsmål om Jupiter

Find svar på almindelige spørgsmål om Jupiter