Sådan scraper du whatsmydns.net: En komplet guide til DNS-data

Lær hvordan du scraper globale DNS-propageringsdata fra whatsmydns.net. Ekstraher A, MX, CNAME og TXT records i realtid fra globale servere automatisk.

Anti-bot beskyttelse opdaget

- Cloudflare

- Enterprise WAF og bot-håndtering. Bruger JavaScript-udfordringer, CAPTCHAs og adfærdsanalyse. Kræver browserautomatisering med stealth-indstillinger.

- Hastighedsbegrænsning

- Begrænser forespørgsler pr. IP/session over tid. Kan omgås med roterende proxyer, forespørgselsforsinkelser og distribueret scraping.

- JavaScript-udfordring

- Kræver JavaScript-udførelse for at få adgang til indhold. Enkle forespørgsler fejler; headless browser som Playwright eller Puppeteer er nødvendig.

- User-Agent Filtering

- Turnstile

Om whatsmydns.net

Opdag hvad whatsmydns.net tilbyder og hvilke værdifulde data der kan udtrækkes.

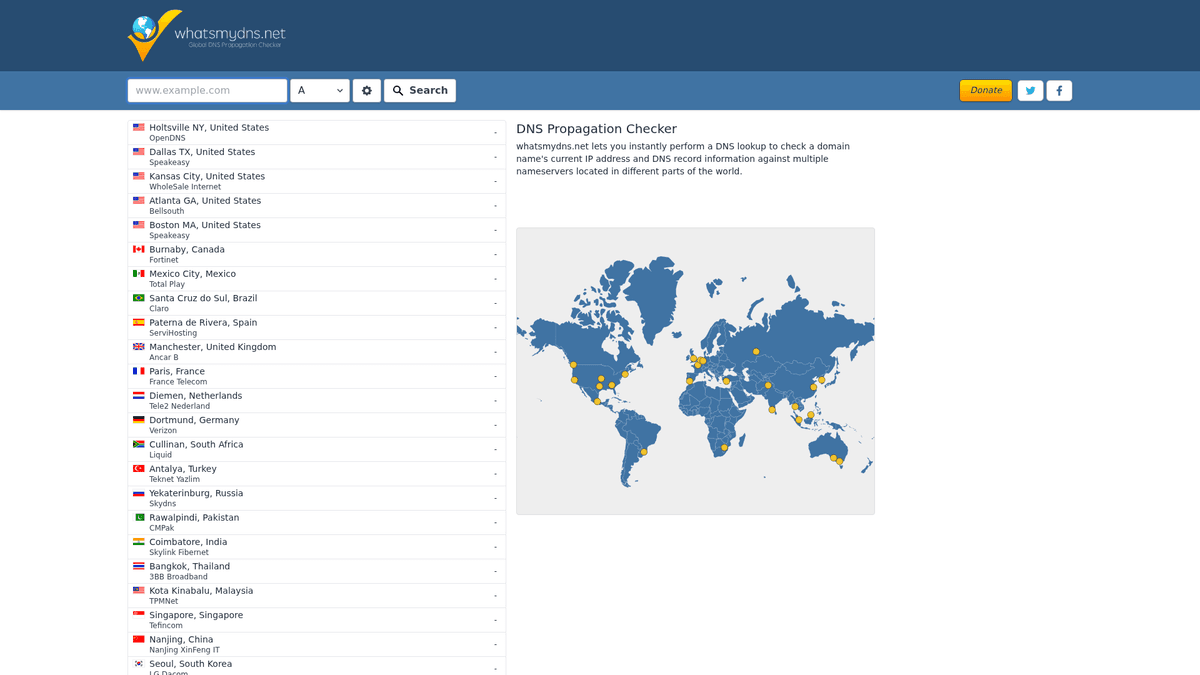

Global DNS-propageringsinfrastruktur

whatsmydns.net er et førende online-værktøj designet til systemadministratorer og udviklere til at spore DNS-propagering over hele kloden. Ved at forespørge dusinvis af DNS-servere placeret i forskellige geografiske regioner giver det et omfattende overblik over, hvordan et domæne opløses for brugere i forskellige lande. Denne synlighed er afgørende for at sikre, at DNS-ændringer, såsom IP-migreringer eller opdateringer af mailservere, er blevet implementeret succesfuldt på verdensplan.

Omfattende sporing af DNS-records

Platformen understøtter en bred vifte af DNS-record-typer, herunder A, AAAA, CNAME, MX, NS, PTR, SOA og TXT. For hver forespørgsel returnerer sitet en detaljeret liste over serverlokationer, de opløste værdier og status for propageringen. Disse data er kritiske for fejlfinding af tekniske problemer, der kun optræder i specifikke regioner på grund af ISP-caching eller fejlkonfigurerede lokale resolvers.

Strategisk dataværdi

Scraping af disse data gør det muligt for organisationer at automatisere tekniske audits og overvåge infrastrukturens sundhedstilstand. I stedet for manuelt at tjekke propagering kan virksomheder bygge automatiserede systemer, der verificerer record-nøjagtighed hvert par minutter. Dette er især værdifuldt under kritiske begivenheder som websitemigreringer eller sikkerhedsopdateringer, hvor enhver forsinkelse i DNS-opdateringer kan føre til nedetid eller serviceafbrydelser for en del af de globale brugere.

Hvorfor Skrabe whatsmydns.net?

Opdag forretningsværdien og brugsscenarier for dataudtrækning fra whatsmydns.net.

Realtidsovervågning af globale DNS-migreringer for enterprise-klienter

Konkurrentanalyse for at identificere CDN-løsninger brugt af topkonkurrenter

Automatiseret verificering af SSL/TLS-certifikatpropagering på tværs af regioner

Sikkerheds-auditing for at detektere uautoriserede DNS-ændringer eller hijacking

Performance-benchmarking af forskellige DNS-udbydere baseret på responshastighed

Skrabningsudfordringer

Tekniske udfordringer du kan støde på når du skraber whatsmydns.net.

Cloudflare anti-bot-beskyttelse kræver sofistikeret browser-mimicking

Dynamisk AJAX-baseret indlæsning af indhold gør statisk scraping umulig

Asynkrone server-svar, hvor data indlæses med forskellig hastighed per region

Kompleks indlejret tabelstruktur kræver præcise CSS- eller XPath-selektorer

Hyppige ændringer af de interne API-endpoints, der bruges til AJAX-kald

Skrab whatsmydns.net med AI

Ingen kode nødvendig. Udtræk data på minutter med AI-drevet automatisering.

Sådan fungerer det

Beskriv hvad du har brug for

Fortæl AI'en hvilke data du vil udtrække fra whatsmydns.net. Skriv det bare på almindeligt sprog — ingen kode eller selektorer nødvendige.

AI udtrækker dataene

Vores kunstige intelligens navigerer whatsmydns.net, håndterer dynamisk indhold og udtrækker præcis det du bad om.

Få dine data

Modtag rene, strukturerede data klar til eksport som CSV, JSON eller send direkte til dine apps og workflows.

Hvorfor bruge AI til skrabning

AI gør det nemt at skrabe whatsmydns.net uden at skrive kode. Vores AI-drevne platform bruger kunstig intelligens til at forstå hvilke data du ønsker — beskriv det på almindeligt sprog, og AI udtrækker dem automatisk.

How to scrape with AI:

- Beskriv hvad du har brug for: Fortæl AI'en hvilke data du vil udtrække fra whatsmydns.net. Skriv det bare på almindeligt sprog — ingen kode eller selektorer nødvendige.

- AI udtrækker dataene: Vores kunstige intelligens navigerer whatsmydns.net, håndterer dynamisk indhold og udtrækker præcis det du bad om.

- Få dine data: Modtag rene, strukturerede data klar til eksport som CSV, JSON eller send direkte til dine apps og workflows.

Why use AI for scraping:

- Bypasser automatisk Cloudflare med avanceret browser-efterligningsteknologi

- No-code setup giver mulighed for hurtig konfiguration af DNS-overvågning

- Håndterer ubesværet dynamisk AJAX-indlæsning med indbyggede vente-funktioner

- Planlagte kørsler sikrer kontinuerlig overvågning uden manuel indgriben

- Direkte integration med Google Sheets til realtidsrapportering

No-code webscrapere til whatsmydns.net

Point-and-click alternativer til AI-drevet scraping

Flere no-code værktøjer som Browse.ai, Octoparse, Axiom og ParseHub kan hjælpe dig med at scrape whatsmydns.net uden at skrive kode. Disse værktøjer bruger typisk visuelle interfaces til at vælge data, selvom de kan have problemer med komplekst dynamisk indhold eller anti-bot foranstaltninger.

Typisk workflow med no-code værktøjer

Almindelige udfordringer

Indlæringskurve

At forstå selektorer og ekstraktionslogik tager tid

Selektorer går i stykker

Webstedsændringer kan ødelægge hele din arbejdsgang

Problemer med dynamisk indhold

JavaScript-tunge sider kræver komplekse løsninger

CAPTCHA-begrænsninger

De fleste værktøjer kræver manuel indgriben for CAPTCHAs

IP-blokering

Aggressiv scraping kan føre til blokering af din IP

No-code webscrapere til whatsmydns.net

Flere no-code værktøjer som Browse.ai, Octoparse, Axiom og ParseHub kan hjælpe dig med at scrape whatsmydns.net uden at skrive kode. Disse værktøjer bruger typisk visuelle interfaces til at vælge data, selvom de kan have problemer med komplekst dynamisk indhold eller anti-bot foranstaltninger.

Typisk workflow med no-code værktøjer

- Installer browserudvidelse eller tilmeld dig platformen

- Naviger til målwebstedet og åbn værktøjet

- Vælg dataelementer med point-and-click

- Konfigurer CSS-selektorer for hvert datafelt

- Opsæt pagineringsregler til at scrape flere sider

- Håndter CAPTCHAs (kræver ofte manuel løsning)

- Konfigurer planlægning for automatiske kørsler

- Eksporter data til CSV, JSON eller forbind via API

Almindelige udfordringer

- Indlæringskurve: At forstå selektorer og ekstraktionslogik tager tid

- Selektorer går i stykker: Webstedsændringer kan ødelægge hele din arbejdsgang

- Problemer med dynamisk indhold: JavaScript-tunge sider kræver komplekse løsninger

- CAPTCHA-begrænsninger: De fleste værktøjer kræver manuel indgriben for CAPTCHAs

- IP-blokering: Aggressiv scraping kan føre til blokering af din IP

Kodeeksempler

import requests

from bs4 import BeautifulSoup

# Bemærk: Direkte requests kan blive blokeret af Cloudflare

url = 'https://www.whatsmydns.net/'

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) Chrome/119.0.0.0 Safari/537.36',

'Accept': 'text/html,application/xhtml+xml,xml;q=0.9,image/avif,image/webp,*/*;q=0.8'

}

def check_dns_static():

try:

# Tilgår forsiden for at få session/cookies

session = requests.Session()

response = session.get(url, headers=headers)

if response.status_code == 200:

soup = BeautifulSoup(response.text, 'html.parser')

# Statisk scraping er begrænset, da resultater indlæses via JS

print('Siden blev indlæst. JS-rendering er påkrævet for at se resultater.')

else:

print(f'Blokeret: HTTP {response.status_code}')

except Exception as e:

print(f'Fejl: {e}')

check_dns_static()Hvornår skal det bruges

Bedst til statiske HTML-sider med minimal JavaScript. Ideel til blogs, nyhedssider og simple e-handelsprodukt sider.

Fordele

- ●Hurtigste udførelse (ingen browser overhead)

- ●Laveste ressourceforbrug

- ●Let at parallelisere med asyncio

- ●Fremragende til API'er og statiske sider

Begrænsninger

- ●Kan ikke køre JavaScript

- ●Fejler på SPA'er og dynamisk indhold

- ●Kan have problemer med komplekse anti-bot systemer

Sådan scraper du whatsmydns.net med kode

Python + Requests

import requests

from bs4 import BeautifulSoup

# Bemærk: Direkte requests kan blive blokeret af Cloudflare

url = 'https://www.whatsmydns.net/'

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) Chrome/119.0.0.0 Safari/537.36',

'Accept': 'text/html,application/xhtml+xml,xml;q=0.9,image/avif,image/webp,*/*;q=0.8'

}

def check_dns_static():

try:

# Tilgår forsiden for at få session/cookies

session = requests.Session()

response = session.get(url, headers=headers)

if response.status_code == 200:

soup = BeautifulSoup(response.text, 'html.parser')

# Statisk scraping er begrænset, da resultater indlæses via JS

print('Siden blev indlæst. JS-rendering er påkrævet for at se resultater.')

else:

print(f'Blokeret: HTTP {response.status_code}')

except Exception as e:

print(f'Fejl: {e}')

check_dns_static()Python + Playwright

from playwright.sync_api import sync_playwright

def scrape_whatsmydns():

with sync_playwright() as p:

browser = p.chromium.launch(headless=True)

page = browser.new_page()

# Brug den hash-baserede URL til at trigge et specifikt DNS-opslag

page.goto('https://www.whatsmydns.net/#A/google.com')

# Vent på at resultattabellen bliver udfyldt med data

page.wait_for_selector('.results-table tr', timeout=15000)

# Ekstraher resultaterne

rows = page.query_selector_all('.results-table tr')

for row in rows:

location = row.query_selector('.location').inner_text()

result_val = row.query_selector('.value').inner_text()

print(f'[{location}] Opløst til: {result_val}')

browser.close()

scrape_whatsmydns()Python + Scrapy

import scrapy

from scrapy_playwright.page import PageMethod

class DNSPropagationSpider(scrapy.Spider):

name = 'dns_spider'

def start_requests(self):

# Scrapy-Playwright håndterer JS-rendering

yield scrapy.Request(

'https://www.whatsmydns.net/#A/example.com',

meta={

'playwright': True,

'playwright_page_methods': [

PageMethod('wait_for_selector', '.results-table tr')

]

}

)

def parse(self, response):

# Iterer gennem tabelrækkerne udtrukket via Playwright

for row in response.css('.results-table tr'):

yield {

'location': row.css('.location::text').get(),

'result': row.css('.value::text').get()

}Node.js + Puppeteer

const puppeteer = require('puppeteer');

(async () => {

const browser = await puppeteer.launch();

const page = await browser.newPage();

// Naviger direkte til DNS-tjek-URL'en

await page.goto('https://www.whatsmydns.net/#MX/microsoft.com', { waitUntil: 'networkidle2' });

// Vent på at de dynamiske serverrækker indlæses

await page.waitForSelector('.results-table tr');

const data = await page.evaluate(() => {

const rows = Array.from(document.querySelectorAll('.results-table tr'));

return rows.map(row => ({

location: row.querySelector('.location')?.innerText.trim(),

value: row.querySelector('.value')?.innerText.trim()

}));

});

console.log(data);

await browser.close();

})();Hvad Du Kan Gøre Med whatsmydns.net-Data

Udforsk praktiske anvendelser og indsigter fra whatsmydns.net-data.

Global Uptime-overvågning

IT-managere kan sikre, at deres tjenester er tilgængelige på verdensplan uden manuelle tjek.

Sådan implementeres:

- 1Planlæg en scrape af kritiske domæner hvert 30. minut

- 2Sammenlign scrapede IP-adresser med en masterliste over autoriserede IP'er

- 3Udløs en automatisk alarm via Webhook, hvis der opdages en uoverensstemmelse i en region

Brug Automatio til at udtrække data fra whatsmydns.net og bygge disse applikationer uden at skrive kode.

Hvad Du Kan Gøre Med whatsmydns.net-Data

- Global Uptime-overvågning

IT-managere kan sikre, at deres tjenester er tilgængelige på verdensplan uden manuelle tjek.

- Planlæg en scrape af kritiske domæner hvert 30. minut

- Sammenlign scrapede IP-adresser med en masterliste over autoriserede IP'er

- Udløs en automatisk alarm via Webhook, hvis der opdages en uoverensstemmelse i en region

- Kortlægning af CDN-brug

Marketinganalytikere kan identificere, hvilke content delivery networks konkurrenter bruger baseret på CNAME-records.

- Scrape CNAME-records for en liste over de 500 største domæner i branchen

- Krydsreferer måldomænerne med kendte CDN-udbydere (f.eks. Cloudflare, Akamai)

- Generer en rapport over markedsandelstendenser for infrastrukturudbydere

- Verificering af migrering uden nedetid

DevOps-teams kan bekræfte fuld propagering, før de nedlægger gammel infrastruktur.

- Udfør en DNS-ændring og sænk TTL-værdierne

- Scrape whatsmydns.net hvert 5. minut under migreringsvinduet

- Tag den gamle server ud af drift, først når 100 % af de globale noder rapporterer den nye IP

- Detektering af sikkerhedstrusler

Sikkerhedsanalytikere kan detektere DNS-poisoning eller uautoriserede ændringer i MX-records.

- Overvåg TXT- og MX-records for højtprofilerede virksomhedsdomæner

- Scrape propageringsstatus for at finde regioner, der serveres med 'forældede' eller ondsindede data

- Identificer specifikke geografiske regioner, hvor DNS-hijacking muligvis finder sted

- Historisk analyse af DNS-records

Forskere kan opbygge et datasæt over, hvordan DNS-records ændrer sig over tid til akademiske eller juridiske audits.

- Crawl records dagligt og gem resultaterne i en SQL-database

- Spor skift i udbyderes IP-ranges over måneder eller år

- Visualiser propageringshastigheden for forskellige DNS-udbydere ved hjælp af historiske statistikker

Supercharg din arbejdsgang med AI-automatisering

Automatio kombinerer kraften fra AI-agenter, webautomatisering og smarte integrationer for at hjælpe dig med at udrette mere på kortere tid.

Professionelle Tips til Skrabning af whatsmydns.net

Ekspertråd til succesfuld dataudtrækning fra whatsmydns.net.

Brug residential proxies for at undgå at udløse Cloudflares rate limits, når du udfører store mængder opslag.

Manipuler URL-fragmentet (#RecordType/Domain) for at bypass manuel formularindsendelse og trigge søgninger direkte.

Indbyg en ventetid på 10 sekunder efter den indledende indlæsning for at sikre, at alle globale resolvers har tid til at svare.

Tjek fanen Network i browseren for at identificere det interne JSON-endpoint, hvis du vil forsøge direkte API-scraping med gyldige headers.

Overvåg rækkerne med klassen 'status' for at skelne mellem vellykkede opløsninger og fejlede serverforespørgsler.

Randomiser din User-Agent-streng for at efterligne forskellige moderne browsere som Safari på Mac eller Edge på Windows.

Anmeldelser

Hvad vores brugere siger

Slut dig til tusindvis af tilfredse brugere, der har transformeret deres arbejdsgang

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Relateret Web Scraping

How to Scrape Bilregistret.ai: Swedish Vehicle Data Extraction Guide

How to Scrape Biluppgifter.se: Vehicle Data Extraction Guide

How to Scrape CSS Author: A Comprehensive Web Scraping Guide

How to Scrape The AA (theaa.com): A Technical Guide for Car & Insurance Data

How to Scrape GoAbroad Study Abroad Programs

How to Scrape Car.info | Vehicle Data & Valuation Extraction Guide

How to Scrape ResearchGate: Publication and Researcher Data

How to Scrape Statista: The Ultimate Guide to Market Data Extraction

Ofte stillede spørgsmål om whatsmydns.net

Find svar på almindelige spørgsmål om whatsmydns.net