Πώς να κάνετε Scraping στο Animal Corner | Wildlife & Nature Data Scraper

Εξάγετε πληροφορίες για ζώα, επιστημονικά ονόματα και δεδομένα βιοτόπων από το Animal Corner. Μάθετε πώς να δημιουργήσετε μια δομημένη βάση δεδομένων άγριας...

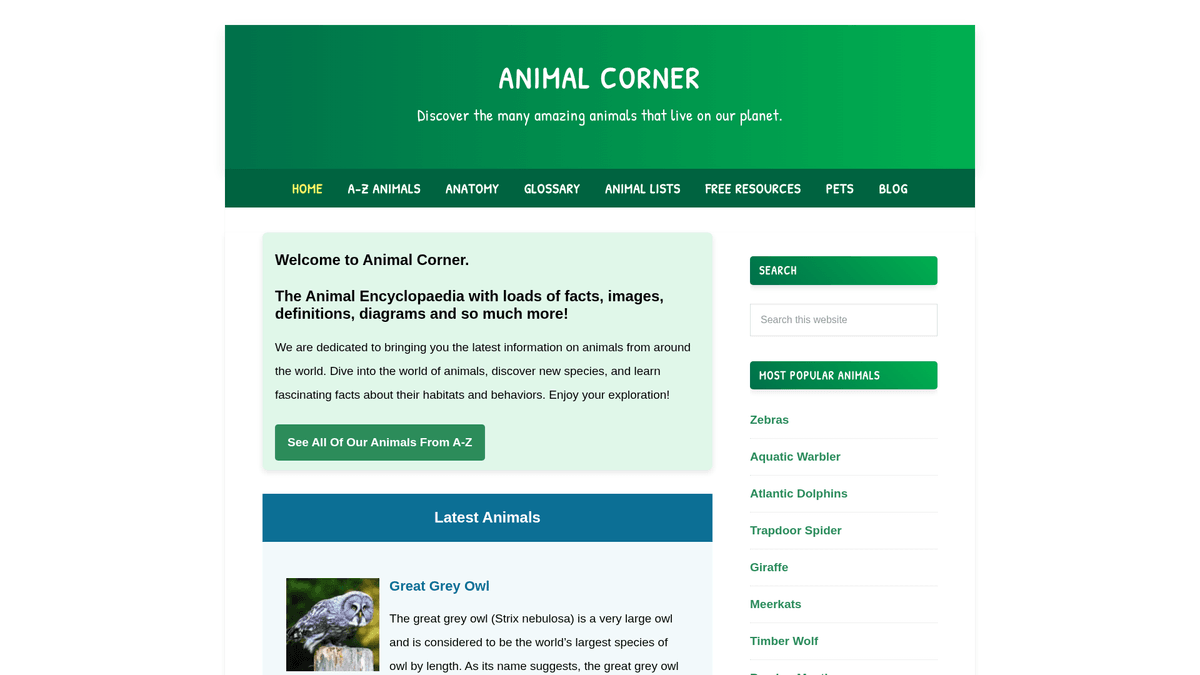

Σχετικά Με Animal Corner

Ανακαλύψτε τι προσφέρει το Animal Corner και ποια πολύτιμα δεδομένα μπορούν να εξαχθούν.

Το Animal Corner είναι μια ολοκληρωμένη διαδικτυακή εγκυκλοπαίδεια αφιερωμένη στην παροχή πληθώρας πληροφοριών για το ζωικό βασίλειο. Λειτουργεί ως ένας δομημένος εκπαιδευτικός πόρος για μαθητές, δασκάλους και λάτρεις της φύσης, προσφέροντας λεπτομερή προφίλ για μια τεράστια γκάμα ειδών, από κοινά κατοικίδια μέχρι απειλούμενη άγρια ζωή. Η πλατφόρμα οργανώνει το περιεχόμενό της σε λογικές κατηγορίες όπως θηλαστικά, πουλιά, ερπετά, ψάρια, αμφίβια και ασπόνδυλα.

Κάθε καταχώριση στον ιστότοπο περιέχει ζωτικά βιολογικά δεδομένα, συμπεριλαμβανομένων κοινών και επιστημονικών ονομάτων, φυσικών χαρακτηριστικών, διατροφικών συνηθειών και γεωγραφικής εξάπλωσης. Για προγραμματιστές και ερευνητές, αυτά τα δεδομένα είναι εξαιρετικά πολύτιμα για τη δημιουργία δομημένων συνόλων δεδομένων που μπορούν να τροφοδοτήσουν εκπαιδευτικές εφαρμογές, να εκπαιδεύσουν machine learning μοντέλα για την αναγνώριση ειδών ή να υποστηρίξουν οικολογικές μελέτες μεγάλης κλίμακας. Επειδή ο ιστότοπος ενημερώνεται συχνά με νέα είδη και καταστάσεις διατήρησης, παραμένει μια πρωταρχική πηγή για τους λάτρεις της βιοποικιλότητας.

Γιατί Να Κάνετε Scraping Το Animal Corner;

Ανακαλύψτε την επιχειρηματική αξία και τις περιπτώσεις χρήσης για την εξαγωγή δεδομένων από το Animal Corner.

Δημιουργία δομημένης βάσης δεδομένων βιοποικιλότητας για ακαδημαϊκή έρευνα

Συλλογή δεδομένων υψηλής ποιότητας για εφαρμογές αναγνώρισης άγριας ζωής

Συγκέντρωση στοιχείων για εκπαιδευτικά blogs και πλατφόρμες με θέμα τη φύση

Παρακολούθηση ενημερώσεων κατάστασης διατήρησης ειδών σε διάφορες περιοχές

Συλλογή ανατομικών δεδομένων για συγκριτικές βιολογικές μελέτες

Δημιουργία συνόλων δεδομένων εκπαίδευσης για NLP models που εστιάζουν σε βιολογικές περιγραφές

Προκλήσεις Scraping

Τεχνικές προκλήσεις που μπορεί να αντιμετωπίσετε κατά το scraping του Animal Corner.

Ανάλυση περιγραφικού κειμένου σε δομημένα, λεπτομερή σημεία δεδομένων

Διαχείριση της ασυνέπειας στη διαθεσιμότητα πεδίων δεδομένων μεταξύ διαφορετικών ομάδων ειδών

Πλοήγηση και crawling χιλιάδων μεμονωμένων URLs ειδών με αποτελεσματικότητα

Εξαγωγή επιστημονικών ονομάτων που συχνά βρίσκονται μέσα σε κείμενο σε παρενθέσεις

Διαχείριση εσωτερικών συνδέσμων και αναφορών πολυμέσων μέσα σε περιγραφικές παραγράφους

Κάντε scrape το Animal Corner με AI

Δεν απαιτείται κώδικας. Εξαγάγετε δεδομένα σε λίγα λεπτά με αυτοματισμό AI.

Πώς λειτουργεί

Περιγράψτε τι χρειάζεστε

Πείτε στην AI ποια δεδομένα θέλετε να εξαγάγετε από το Animal Corner. Απλά γράψτε σε φυσική γλώσσα — χωρίς κώδικα ή selectors.

Η AI εξάγει τα δεδομένα

Η τεχνητή νοημοσύνη μας πλοηγείται στο Animal Corner, διαχειρίζεται δυναμικό περιεχόμενο και εξάγει ακριβώς αυτό που ζητήσατε.

Λάβετε τα δεδομένα σας

Λάβετε καθαρά, δομημένα δεδομένα έτοιμα για εξαγωγή ως CSV, JSON ή αποστολή απευθείας στις εφαρμογές σας.

Γιατί να χρησιμοποιήσετε AI για scraping

Η AI καθιστά εύκολο το scraping του Animal Corner χωρίς να γράψετε κώδικα. Η πλατφόρμα μας με τεχνητή νοημοσύνη κατανοεί ποια δεδομένα θέλετε — απλά περιγράψτε τα σε φυσική γλώσσα και η AI τα εξάγει αυτόματα.

How to scrape with AI:

- Περιγράψτε τι χρειάζεστε: Πείτε στην AI ποια δεδομένα θέλετε να εξαγάγετε από το Animal Corner. Απλά γράψτε σε φυσική γλώσσα — χωρίς κώδικα ή selectors.

- Η AI εξάγει τα δεδομένα: Η τεχνητή νοημοσύνη μας πλοηγείται στο Animal Corner, διαχειρίζεται δυναμικό περιεχόμενο και εξάγει ακριβώς αυτό που ζητήσατε.

- Λάβετε τα δεδομένα σας: Λάβετε καθαρά, δομημένα δεδομένα έτοιμα για εξαγωγή ως CSV, JSON ή αποστολή απευθείας στις εφαρμογές σας.

Why use AI for scraping:

- Οπτική επιλογή σύνθετων μπλοκ στοιχείων για ζώα χωρίς κώδικα

- Αυτόματο crawling σελίδων κατηγοριών και ευρετηρίου A-Z χωρίς scripting

- Διαχείριση καθαρισμού και μορφοποίησης κειμένου απευθείας μέσα στο εργαλείο

- Προγραμματισμένες εκτελέσεις για την καταγραφή ενημερώσεων στις καταστάσεις απειλούμενων ειδών

- Άμεση εξαγωγή σε Google Sheets ή JSON για άμεση ενσωμάτωση σε εφαρμογές

No-code web scrapers για το Animal Corner

Εναλλακτικές point-and-click στο AI-powered scraping

Διάφορα no-code εργαλεία όπως Browse.ai, Octoparse, Axiom και ParseHub μπορούν να σας βοηθήσουν να κάνετε scraping στο Animal Corner χωρίς να γράψετε κώδικα. Αυτά τα εργαλεία συνήθως χρησιμοποιούν οπτικές διεπαφές για επιλογή δεδομένων, αν και μπορεί να δυσκολευτούν με σύνθετο δυναμικό περιεχόμενο ή μέτρα anti-bot.

Τυπική ροή εργασίας με no-code εργαλεία

Συνήθεις προκλήσεις

Καμπύλη μάθησης

Η κατανόηση επιλογέων και λογικής εξαγωγής απαιτεί χρόνο

Οι επιλογείς χαλάνε

Οι αλλαγές στον ιστότοπο μπορούν να χαλάσουν ολόκληρη τη ροή εργασίας

Προβλήματα δυναμικού περιεχομένου

Ιστότοποι με πολύ JavaScript απαιτούν σύνθετες λύσεις

Περιορισμοί CAPTCHA

Τα περισσότερα εργαλεία απαιτούν χειροκίνητη παρέμβαση για CAPTCHA

Αποκλεισμός IP

Το επιθετικό scraping μπορεί να οδηγήσει σε αποκλεισμό της IP σας

No-code web scrapers για το Animal Corner

Διάφορα no-code εργαλεία όπως Browse.ai, Octoparse, Axiom και ParseHub μπορούν να σας βοηθήσουν να κάνετε scraping στο Animal Corner χωρίς να γράψετε κώδικα. Αυτά τα εργαλεία συνήθως χρησιμοποιούν οπτικές διεπαφές για επιλογή δεδομένων, αν και μπορεί να δυσκολευτούν με σύνθετο δυναμικό περιεχόμενο ή μέτρα anti-bot.

Τυπική ροή εργασίας με no-code εργαλεία

- Εγκαταστήστε την επέκταση του προγράμματος περιήγησης ή εγγραφείτε στην πλατφόρμα

- Πλοηγηθείτε στον ιστότοπο-στόχο και ανοίξτε το εργαλείο

- Επιλέξτε στοιχεία δεδομένων για εξαγωγή με point-and-click

- Διαμορφώστε επιλογείς CSS για κάθε πεδίο δεδομένων

- Ρυθμίστε κανόνες σελιδοποίησης για scraping πολλών σελίδων

- Διαχειριστείτε CAPTCHA (συχνά απαιτεί χειροκίνητη επίλυση)

- Διαμορφώστε προγραμματισμό για αυτόματες εκτελέσεις

- Εξαγωγή δεδομένων σε CSV, JSON ή σύνδεση μέσω API

Συνήθεις προκλήσεις

- Καμπύλη μάθησης: Η κατανόηση επιλογέων και λογικής εξαγωγής απαιτεί χρόνο

- Οι επιλογείς χαλάνε: Οι αλλαγές στον ιστότοπο μπορούν να χαλάσουν ολόκληρη τη ροή εργασίας

- Προβλήματα δυναμικού περιεχομένου: Ιστότοποι με πολύ JavaScript απαιτούν σύνθετες λύσεις

- Περιορισμοί CAPTCHA: Τα περισσότερα εργαλεία απαιτούν χειροκίνητη παρέμβαση για CAPTCHA

- Αποκλεισμός IP: Το επιθετικό scraping μπορεί να οδηγήσει σε αποκλεισμό της IP σας

Παραδείγματα κώδικα

import requests

from bs4 import BeautifulSoup

# Target URL for a specific animal

url = 'https://animalcorner.org/animals/african-elephant/'

# Standard headers to mimic a real browser

headers = {'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/91.0.4472.124 Safari/537.36'}

try:

response = requests.get(url, headers=headers)

response.raise_for_status()

soup = BeautifulSoup(response.text, 'html.parser')

# Extracting animal name

title = soup.find('h1').text.strip()

print(f'Animal: {title}')

# Extracting first paragraph which usually contains the scientific name

intro = soup.find('p').text.strip()

print(f'Intro Facts: {intro[:150]}...')

except requests.exceptions.RequestException as e:

print(f'Error scraping Animal Corner: {e}')Πότε να χρησιμοποιήσετε

Ιδανικό για στατικές HTML σελίδες με ελάχιστη JavaScript. Τέλειο για blogs, ειδησεογραφικά sites και απλές σελίδες προϊόντων e-commerce.

Πλεονεκτήματα

- ●Ταχύτερη εκτέλεση (χωρίς overhead browser)

- ●Χαμηλότερη κατανάλωση πόρων

- ●Εύκολη παραλληλοποίηση με asyncio

- ●Εξαιρετικό για APIs και στατικές σελίδες

Περιορισμοί

- ●Δεν μπορεί να εκτελέσει JavaScript

- ●Αποτυγχάνει σε SPAs και δυναμικό περιεχόμενο

- ●Μπορεί να δυσκολευτεί με σύνθετα συστήματα anti-bot

Πώς να κάνετε scraping στο Animal Corner με κώδικα

Python + Requests

import requests

from bs4 import BeautifulSoup

# Target URL for a specific animal

url = 'https://animalcorner.org/animals/african-elephant/'

# Standard headers to mimic a real browser

headers = {'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/91.0.4472.124 Safari/537.36'}

try:

response = requests.get(url, headers=headers)

response.raise_for_status()

soup = BeautifulSoup(response.text, 'html.parser')

# Extracting animal name

title = soup.find('h1').text.strip()

print(f'Animal: {title}')

# Extracting first paragraph which usually contains the scientific name

intro = soup.find('p').text.strip()

print(f'Intro Facts: {intro[:150]}...')

except requests.exceptions.RequestException as e:

print(f'Error scraping Animal Corner: {e}')Python + Playwright

from playwright.sync_api import sync_playwright

def scrape_animal_corner():

with sync_playwright() as p:

# Launch headless browser

browser = p.chromium.launch(headless=True)

page = browser.new_page()

page.goto('https://animalcorner.org/animals/african-elephant/')

# Wait for the main heading to load

title = page.inner_text('h1')

print(f'Animal Name: {title}')

# Extract specific fact paragraphs

facts = page.query_selector_all('p')

for fact in facts[:3]:

print(f'Fact: {fact.inner_text()}')

browser.close()

if __name__ == "__main__":

scrape_animal_corner()Python + Scrapy

import scrapy

class AnimalSpider(scrapy.Spider):

name = 'animal_spider'

start_urls = ['https://animalcorner.org/animals/']

def parse(self, response):

# Follow links to individual animal pages within the directory

for animal_link in response.css('a[href*="/animals/"]::attr(href)').getall():

yield response.follow(animal_link, self.parse_animal)

def parse_animal(self, response):

# Extract structured data from animal profiles

yield {

'common_name': response.css('h1::text').get().strip(),

'scientific_name': response.xpath('//p[contains(., "(")]/text()').re_first(r'\((.*?)\)'),

'description': ' '.join(response.css('p::text').getall()[:5])

}Node.js + Puppeteer

const puppeteer = require('puppeteer');

(async () => {

const browser = await puppeteer.launch();

const page = await browser.newPage();

await page.goto('https://animalcorner.org/animals/african-elephant/');

const data = await page.evaluate(() => {

// Extract the title and introductory paragraph

return {

title: document.querySelector('h1').innerText.trim(),

firstParagraph: document.querySelector('p').innerText.trim()

};

});

console.log('Extracted Data:', data);

await browser.close();

})();Τι Μπορείτε Να Κάνετε Με Τα Δεδομένα Του Animal Corner

Εξερευνήστε πρακτικές εφαρμογές και πληροφορίες από τα δεδομένα του Animal Corner.

Εκπαιδευτική Εφαρμογή Flashcard

Δημιουργήστε μια εφαρμογή μάθησης για κινητά που χρησιμοποιεί στοιχεία για ζώα και εικόνες υψηλής ποιότητας για να διδάξει στους μαθητές τη βιοποικιλότητα.

Πώς να υλοποιήσετε:

- 1Κάντε scrape ονόματα ζώων, φυσικά χαρακτηριστικά και επιλεγμένες εικόνες

- 2Κατηγοριοποιήστε τα ζώα ανά επίπεδο δυσκολίας ή βιολογική ομάδα

- 3Σχεδιάστε μια διαδραστική διεπαφή κουίζ χρησιμοποιώντας τα συγκεντρωμένα δεδομένα

- 4Εφαρμόστε παρακολούθηση προόδου για να βοηθήσετε τους χρήστες να μάθουν την αναγνώριση ειδών

Χρησιμοποιήστε το Automatio για να εξάγετε δεδομένα από το Animal Corner και να δημιουργήσετε αυτές τις εφαρμογές χωρίς να γράψετε κώδικα.

Τι Μπορείτε Να Κάνετε Με Τα Δεδομένα Του Animal Corner

- Εκπαιδευτική Εφαρμογή Flashcard

Δημιουργήστε μια εφαρμογή μάθησης για κινητά που χρησιμοποιεί στοιχεία για ζώα και εικόνες υψηλής ποιότητας για να διδάξει στους μαθητές τη βιοποικιλότητα.

- Κάντε scrape ονόματα ζώων, φυσικά χαρακτηριστικά και επιλεγμένες εικόνες

- Κατηγοριοποιήστε τα ζώα ανά επίπεδο δυσκολίας ή βιολογική ομάδα

- Σχεδιάστε μια διαδραστική διεπαφή κουίζ χρησιμοποιώντας τα συγκεντρωμένα δεδομένα

- Εφαρμόστε παρακολούθηση προόδου για να βοηθήσετε τους χρήστες να μάθουν την αναγνώριση ειδών

- Σύνολο Δεδομένων Ζωολογικής Έρευνας

Παρέχετε ένα δομημένο σύνολο δεδομένων για ερευνητές που συγκρίνουν ανατομικά στατιστικά στοιχεία μεταξύ διαφορετικών οικογενειών ειδών.

- Εξάγετε συγκεκριμένα αριθμητικά στατιστικά όπως καρδιακό ρυθμό και περίοδο κύησης

- Κανονικοποιήστε τις μονάδες μέτρησης (π.χ. κιλά, μέτρα) χρησιμοποιώντας καθαρισμό δεδομένων

- Οργανώστε τα δεδομένα ανά επιστημονική ταξινόμηση (Τάξη, Οικογένεια, Γένος)

- Εξάγετε το τελικό σύνολο δεδομένων σε CSV για προηγμένη στατιστική ανάλυση

- Auto-Poster για Nature Blog

Δημιουργήστε αυτόματα καθημερινό περιεχόμενο για τα social media ή blog με στοιχεία για το 'Ζώο της Ημέρας'.

- Κάντε scrape μια μεγάλη δεξαμενή από ενδιαφέροντα στοιχεία για ζώα από την εγκυκλοπαίδεια

- Προγραμματίστε ένα script για την επιλογή ενός τυχαίου προφίλ ζώου κάθε 24 ώρες

- Μορφοποιήστε το εξαγόμενο κείμενο σε ένα ελκυστικό πρότυπο ανάρτησης

- Χρησιμοποιήστε social media APIs για να δημοσιεύσετε το περιεχόμενο με την εικόνα του ζώου

- Εργαλείο Παρακολούθησης Διατήρησης

Δημιουργήστε ένα dashboard που επισημαίνει τα ζώα που περιλαμβάνονται επί του παρόντος στην κατάσταση 'Κινδυνεύον' ή 'Ευάλωτο'.

- Κάντε scrape ονόματα ειδών μαζί με τη συγκεκριμένη κατάσταση διατήρησής τους

- Φιλτράρετε τη βάση δεδομένων για να απομονώσετε κατηγορίες ειδών υψηλού κινδύνου

- Αντιστοιχίστε αυτά τα είδη στις αναφερόμενες γεωγραφικές τους περιοχές

- Ρυθμίστε περιοδικές εκτελέσεις scraping για την παρακολούθηση αλλαγών στην κατάσταση διατήρησης

Ενισχύστε τη ροή εργασίας σας με Αυτοματισμό AI

Το Automatio συνδυάζει τη δύναμη των AI agents, του web automation και των έξυπνων ενσωματώσεων για να σας βοηθήσει να επιτύχετε περισσότερα σε λιγότερο χρόνο.

Επαγγελματικές Συμβουλές Για Το Scraping Του Animal Corner

Συμβουλές ειδικών για επιτυχημένη εξαγωγή δεδομένων από το Animal Corner.

Ξεκινήστε το crawl από τη σελίδα της λίστας A-Z για να διασφαλίσετε την πλήρη κάλυψη όλων των ειδών

Χρησιμοποιήστε regular expressions για να εξάγετε τα επιστημονικά ονόματα που συνήθως βρίσκονται σε παρένθεση δίπλα στο κοινό όνομα

Ορίστε μια καθυστέρηση crawl 1-2 δευτερολέπτων μεταξύ των αιτημάτων για να σεβαστείτε τους πόρους του ιστότοπου και να αποφύγετε τα rate limits

Στοχεύστε σε συγκεκριμένους υποφακέλους κατηγοριών όπως /mammals/ ή /birds/ εάν χρειάζεστε μόνο εξειδικευμένα δεδομένα

Κατεβάστε και αποθηκεύστε τις εικόνες των ζώων τοπικά αντί για hotlinking για να διατηρήσετε τη σταθερότητα της εφαρμογής σας

Καθαρίστε το περιγραφικό κείμενο αφαιρώντας τους εσωτερικούς συνδέσμους τύπου wiki για μια πιο ομαλή εμπειρία ανάγνωσης

Μαρτυρίες

Τι λένε οι χρήστες μας

Ενταχθείτε στις χιλιάδες ικανοποιημένων χρηστών που έχουν μεταμορφώσει τη ροή εργασίας τους

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Σχετικά Web Scraping

How to Scrape Bilregistret.ai: Swedish Vehicle Data Extraction Guide

How to Scrape Biluppgifter.se: Vehicle Data Extraction Guide

How to Scrape The AA (theaa.com): A Technical Guide for Car & Insurance Data

How to Scrape CSS Author: A Comprehensive Web Scraping Guide

How to Scrape Car.info | Vehicle Data & Valuation Extraction Guide

How to Scrape GoAbroad Study Abroad Programs

How to Scrape ResearchGate: Publication and Researcher Data

How to Scrape Statista: The Ultimate Guide to Market Data Extraction

Συχνές ερωτήσεις για Animal Corner

Βρείτε απαντήσεις σε συνηθισμένες ερωτήσεις σχετικά με το Animal Corner