Comment scraper Exploit-DB | Scraper pour Exploit Database

Apprenez à scraper Exploit-DB pour obtenir des données de vulnérabilité, des codes d'exploit et des références CVE afin d'alimenter la recherche en...

Protection Anti-Bot Détectée

- Cloudflare

- WAF et gestion de bots de niveau entreprise. Utilise des défis JavaScript, des CAPTCHAs et l'analyse comportementale. Nécessite l'automatisation du navigateur avec des paramètres furtifs.

- Limitation de débit

- Limite les requêtes par IP/session dans le temps. Peut être contourné avec des proxys rotatifs, des délais de requête et du scraping distribué.

- Blocage IP

- Bloque les IP de centres de données connues et les adresses signalées. Nécessite des proxys résidentiels ou mobiles pour contourner efficacement.

- Défi JavaScript

- Nécessite l'exécution de JavaScript pour accéder au contenu. Les requêtes simples échouent ; un navigateur headless comme Playwright ou Puppeteer est nécessaire.

À Propos de Exploit Database

Découvrez ce que Exploit Database offre et quelles données précieuses peuvent être extraites.

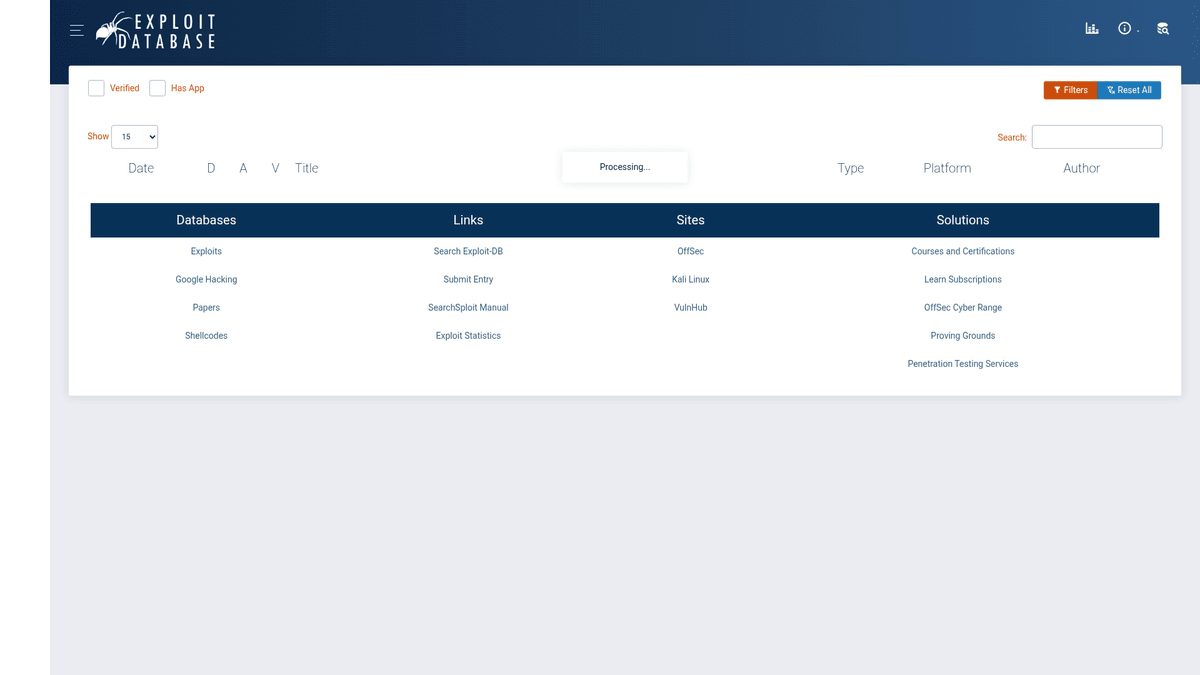

Répertoire complet de vulnérabilités

L'Exploit Database (Exploit-DB) est une archive conforme aux CVE d'exploits publics et de logiciels vulnérables correspondants, développée pour être utilisée par les testeurs de pénétration et les chercheurs en vulnérabilités. Maintenue par OffSec (Offensive Security), elle sert de hub central pour la communauté de la cybersécurité afin de partager des codes de preuve de concept (PoC) et des recherches sur diverses plateformes et applications. Ce répertoire est l'une des sources les plus fiables pour les professionnels de la sécurité dans le monde entier.

Catégorisation et profondeur des données

Le site organise les données en catégories granulaires telles que les exploits distants, les applications web, les exploits locaux et les shellcodes. Chaque entrée inclut généralement le titre de l'exploit, la date, l'auteur, la plateforme, le CVE ID associé et le code brut de l'exploit. Cette approche structurée permet aux chercheurs de basculer rapidement entre différents types de vulnérabilités et leur contexte historique.

Valeur stratégique pour les opérations de sécurité

Le scraping de ces données est extrêmement précieux pour les Security Operations Centers (SOCs) et les équipes de threat intelligence pour corréler les exploits connus avec les vulnérabilités internes. En automatisant l'extraction du code PoC et des métadonnées, les organisations peuvent créer des signatures de sécurité personnalisées, améliorer leur cycle de vie de gestion des vulnérabilités et construire des flux de threat intelligence robustes.

Pourquoi Scraper Exploit Database?

Découvrez la valeur commerciale et les cas d'utilisation pour l'extraction de données de Exploit Database.

Enrichissement du Threat Intelligence

Automatisez la collecte de nouveaux proof-of-concept d'exploits pour alimenter les centres d'opérations de sécurité internes et les plateformes de threat intelligence.

Priorisation des vulnérabilités

Croisez les vulnérabilités de vos actifs internes avec les exploits publics disponibles pour déterminer quels correctifs nécessitent une application immédiate.

Développement d'outils de sécurité

Intégrez du code d'exploit fonctionnel et du shellcode dans des frameworks de tests d'intrusion personnalisés ou des outils d'évaluation de sécurité automatisés.

Audit de conformité

Maintenez un historique des exploits pour des versions spécifiques de logiciels afin de garantir que les systèmes répondent aux exigences de sécurité réglementaires.

Surveillance des Zero-Day

Configurez des alertes pour les exploits nouvellement publiés ciblant des infrastructures critiques ou des logiciels d'entreprise largement utilisés.

Défis du Scraping

Défis techniques que vous pouvez rencontrer lors du scraping de Exploit Database.

Rendu basé sur JavaScript

La base de données principale des exploits est rendue via jQuery DataTables, ce qui la rend invisible pour les scrapers HTTP de base qui n'exécutent pas le JavaScript.

Murs anti-bot Cloudflare

Exploit-DB est protégé par Cloudflare, qui utilise le browser fingerprinting et des défis TLS pour bloquer le trafic non humain.

Limitation de débit (Rate Limiting) stricte

Les requêtes répétées pour les fichiers de code d'exploit brut déclenchent souvent des limitations de débit basées sur l'IP ou des bannissements temporaires si elles ne sont pas gérées correctement.

Chargement de contenu dynamique

Le site utilise AJAX pour charger les données des tableaux, ce qui oblige le scraper à attendre l'inactivité du réseau ou à intercepter des appels API spécifiques.

Scrapez Exploit Database avec l'IA

Aucun code requis. Extrayez des données en minutes avec l'automatisation par IA.

Comment ça marche

Décrivez ce dont vous avez besoin

Dites à l'IA quelles données vous souhaitez extraire de Exploit Database. Tapez simplement en langage naturel — pas de code ni de sélecteurs.

L'IA extrait les données

Notre intelligence artificielle navigue sur Exploit Database, gère le contenu dynamique et extrait exactement ce que vous avez demandé.

Obtenez vos données

Recevez des données propres et structurées, prêtes à exporter en CSV, JSON ou à envoyer directement à vos applications.

Pourquoi utiliser l'IA pour le scraping

L'IA facilite le scraping de Exploit Database sans écrire de code. Notre plateforme alimentée par l'intelligence artificielle comprend quelles données vous voulez — décrivez-les en langage naturel et l'IA les extrait automatiquement.

How to scrape with AI:

- Décrivez ce dont vous avez besoin: Dites à l'IA quelles données vous souhaitez extraire de Exploit Database. Tapez simplement en langage naturel — pas de code ni de sélecteurs.

- L'IA extrait les données: Notre intelligence artificielle navigue sur Exploit Database, gère le contenu dynamique et extrait exactement ce que vous avez demandé.

- Obtenez vos données: Recevez des données propres et structurées, prêtes à exporter en CSV, JSON ou à envoyer directement à vos applications.

Why use AI for scraping:

- Gestion automatique des anti-bots: Automatio gère nativement les défis Cloudflare et le browser fingerprinting, garantissant que vos tâches de scraping s'exécutent sans intervention manuelle.

- Sélection visuelle des données: Mappez facilement la structure complexe de DataTable en cliquant simplement sur les éléments que vous souhaitez extraire, évitant ainsi le codage complexe en CSS ou XPath.

- Synchronisation planifiée des données: Configurez votre scraper pour qu'il s'exécute à des intervalles spécifiques afin de garantir que vos flux de threat intelligence sont toujours à jour avec les derniers exploits.

Scrapers Web No-Code pour Exploit Database

Alternatives pointer-cliquer au scraping alimenté par l'IA

Plusieurs outils no-code comme Browse.ai, Octoparse, Axiom et ParseHub peuvent vous aider à scraper Exploit Database sans écrire de code. Ces outils utilisent généralement des interfaces visuelles pour sélectionner les données, bien qu'ils puissent avoir des difficultés avec le contenu dynamique complexe ou les mesures anti-bot.

Workflow Typique avec les Outils No-Code

Défis Courants

Courbe d'apprentissage

Comprendre les sélecteurs et la logique d'extraction prend du temps

Les sélecteurs cassent

Les modifications du site web peuvent casser tout le workflow

Problèmes de contenu dynamique

Les sites riches en JavaScript nécessitent des solutions complexes

Limitations des CAPTCHAs

La plupart des outils nécessitent une intervention manuelle pour les CAPTCHAs

Blocage d'IP

Le scraping agressif peut entraîner le blocage de votre IP

Scrapers Web No-Code pour Exploit Database

Plusieurs outils no-code comme Browse.ai, Octoparse, Axiom et ParseHub peuvent vous aider à scraper Exploit Database sans écrire de code. Ces outils utilisent généralement des interfaces visuelles pour sélectionner les données, bien qu'ils puissent avoir des difficultés avec le contenu dynamique complexe ou les mesures anti-bot.

Workflow Typique avec les Outils No-Code

- Installer l'extension de navigateur ou s'inscrire sur la plateforme

- Naviguer vers le site web cible et ouvrir l'outil

- Sélectionner en point-and-click les éléments de données à extraire

- Configurer les sélecteurs CSS pour chaque champ de données

- Configurer les règles de pagination pour scraper plusieurs pages

- Gérer les CAPTCHAs (nécessite souvent une résolution manuelle)

- Configurer la planification pour les exécutions automatiques

- Exporter les données en CSV, JSON ou se connecter via API

Défis Courants

- Courbe d'apprentissage: Comprendre les sélecteurs et la logique d'extraction prend du temps

- Les sélecteurs cassent: Les modifications du site web peuvent casser tout le workflow

- Problèmes de contenu dynamique: Les sites riches en JavaScript nécessitent des solutions complexes

- Limitations des CAPTCHAs: La plupart des outils nécessitent une intervention manuelle pour les CAPTCHAs

- Blocage d'IP: Le scraping agressif peut entraîner le blocage de votre IP

Exemples de Code

import requests

from bs4 import BeautifulSoup

# Exploit-DB utilise Cloudflare ; les requêtes simples peuvent être bloquées

url = 'https://www.exploit-db.com/'

headers = {'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/91.0.4472.124 Safari/537.36'}

try:

response = requests.get(url, headers=headers)

response.raise_for_status()

soup = BeautifulSoup(response.text, 'html.parser')

# Note : Les données principales sont chargées via AJAX, le HTML initial est une coquille

print('Titre de la page :', soup.title.text)

except Exception as e:

print(f'Erreur rencontrée : {e}')Quand Utiliser

Idéal pour les pages HTML statiques avec peu de JavaScript. Parfait pour les blogs, sites d'actualités et pages e-commerce simples.

Avantages

- ●Exécution la plus rapide (sans surcharge navigateur)

- ●Consommation de ressources minimale

- ●Facile à paralléliser avec asyncio

- ●Excellent pour les APIs et pages statiques

Limitations

- ●Ne peut pas exécuter JavaScript

- ●Échoue sur les SPAs et contenu dynamique

- ●Peut avoir des difficultés avec les systèmes anti-bot complexes

Comment Scraper Exploit Database avec du Code

Python + Requests

import requests

from bs4 import BeautifulSoup

# Exploit-DB utilise Cloudflare ; les requêtes simples peuvent être bloquées

url = 'https://www.exploit-db.com/'

headers = {'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/91.0.4472.124 Safari/537.36'}

try:

response = requests.get(url, headers=headers)

response.raise_for_status()

soup = BeautifulSoup(response.text, 'html.parser')

# Note : Les données principales sont chargées via AJAX, le HTML initial est une coquille

print('Titre de la page :', soup.title.text)

except Exception as e:

print(f'Erreur rencontrée : {e}')Python + Playwright

from playwright.sync_api import sync_playwright

def scrape_exploit_db():

with sync_playwright() as p:

browser = p.chromium.launch(headless=True)

page = browser.new_page()

page.goto('https://www.exploit-db.com/')

# Attendre que les DataTables se chargent via AJAX

page.wait_for_selector('table#exploits-table')

rows = page.query_selector_all('table#exploits-table tbody tr')

for row in rows[:5]:

print(row.inner_text())

browser.close()

scrape_exploit_db()Python + Scrapy

import scrapy

class ExploitSpider(scrapy.Spider):

name = 'exploit_spider'

start_urls = ['https://www.exploit-db.com/']

def parse(self, response):

# Scrapy a besoin d'un middleware JS comme scrapy-playwright pour ce site

for exploit in response.css('table#exploits-table tbody tr'):

yield {

'title': exploit.css('td.title a::text').get(),

'id': exploit.css('td.id::text').get(),

'cve': exploit.css('td.cve a::text').get()

}Node.js + Puppeteer

const puppeteer = require('puppeteer');

(async () => {

const browser = await puppeteer.launch();

const page = await browser.newPage();

await page.goto('https://www.exploit-db.com/', { waitUntil: 'networkidle2' });

const results = await page.evaluate(() => {

const rows = Array.from(document.querySelectorAll('table#exploits-table tbody tr'));

return rows.map(row => row.innerText);

});

console.log(results.slice(0, 5));

await browser.close();

})();Que Pouvez-Vous Faire Avec Les Données de Exploit Database

Explorez les applications pratiques et les insights des données de Exploit Database.

Flux de threat intelligence en temps réel

Créez un flux continu de nouveaux exploits pour avertir les équipes de sécurité des menaces émergentes.

Comment implémenter :

- 1Configurer un scraping programmé de la page d'accueil quotidiennement

- 2Comparer les nouveaux EDB-IDs avec les enregistrements précédemment scrapés

- 3Déclencher des alertes Slack ou email pour les nouveaux exploits critiques

Utilisez Automatio pour extraire des données de Exploit Database et créer ces applications sans écrire de code.

Que Pouvez-Vous Faire Avec Les Données de Exploit Database

- Flux de threat intelligence en temps réel

Créez un flux continu de nouveaux exploits pour avertir les équipes de sécurité des menaces émergentes.

- Configurer un scraping programmé de la page d'accueil quotidiennement

- Comparer les nouveaux EDB-IDs avec les enregistrements précédemment scrapés

- Déclencher des alertes Slack ou email pour les nouveaux exploits critiques

- Corrélation de vulnérabilités et correctifs

Aidez les équipes informatiques à prioriser les correctifs logiciels en fonction de l'existence d'un code d'exploit fonctionnel.

- Extraire les CVE IDs et les métadonnées d'exploit associées

- Effectuer un recoupement avec les listes d'inventaire logiciel internes

- Signaler les systèmes ayant des exploits publics disponibles pour un correctif immédiat

- Création automatisée de signatures SIEM

Extrayez le shellcode de preuve de concept pour développer des signatures défensives pour la détection d'intrusion.

- Naviguer vers les pages d'exploit individuelles et scraper le code brut

- Analyser le code pour identifier des motifs d'octets uniques ou des chaînes réseau

- Injecter les motifs extraits dans des générateurs de règles SIEM ou IDS/IPS

- Analyse des tendances historiques de vulnérabilités

Analysez une décennie de données d'exploits pour comprendre quelles plateformes sont les plus ciblées au fil du temps.

- Scraper l'intégralité de l'archive, y compris les dates, les plateformes et les types

- Agrégé les données par plateforme et par année

- Visualiser les tendances d'attaque à l'aide d'outils BI comme Tableau ou PowerBI

- Jeux de données académiques en cybersécurité

Fournissez des données structurées de haute qualité pour les modèles de machine learning prédisant la fiabilité des exploits.

- Scraper les exploits vérifiés par rapport aux non vérifiés

- Extraire le code source brut et les attributs de métadonnées

- Entraîner des models pour classer les motifs de code associés aux exploits réussis

Optimisez votre flux de travail avec l'Automatisation IA

Automatio combine la puissance des agents IA, de l'automatisation web et des integrations intelligentes pour vous aider a accomplir plus en moins de temps.

Conseils Pro pour Scraper Exploit Database

Conseils d'experts pour extraire avec succès les données de Exploit Database.

Intercepter les requêtes XHR

Au lieu de scraper le HTML rendu, recherchez les requêtes JSON internes effectuées par DataTables pour extraire directement des données propres et structurées.

Utiliser des proxys résidentiels

Utilisez des IP résidentielles de haute qualité pour éviter de déclencher le Web Application Firewall (WAF) agressif du site et les limitations de débit (rate limits).

Filtrer par statut de vérification

Vérifiez par programmation le champ de statut 'Verified' pour prioriser les codes d'exploit fonctionnels et de haute qualité pour vos jeux de données de sécurité.

Normaliser les identifiants CVE

Normalisez toujours les chaînes CVE extraites dans un format standard pour garantir une intégration facile avec d'autres bases de données de vulnérabilités comme la NVD.

Consulter le miroir GitLab

Avant de lancer un scraping intensif, consultez le dépôt officiel GitLab d'Exploit-DB pour obtenir des données CSV en vrac, plus faciles à traiter pour les archives historiques.

Témoignages

Ce Que Disent Nos Utilisateurs

Rejoignez des milliers d'utilisateurs satisfaits qui ont transforme leur flux de travail

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Associés Web Scraping

How to Scrape Biluppgifter.se: Vehicle Data Extraction Guide

How to Scrape Bilregistret.ai: Swedish Vehicle Data Extraction Guide

How to Scrape The AA (theaa.com): A Technical Guide for Car & Insurance Data

How to Scrape CSS Author: A Comprehensive Web Scraping Guide

How to Scrape Car.info | Vehicle Data & Valuation Extraction Guide

How to Scrape GoAbroad Study Abroad Programs

How to Scrape ResearchGate: Publication and Researcher Data

How to Scrape Statista: The Ultimate Guide to Market Data Extraction

Questions Fréquentes sur Exploit Database

Trouvez des réponses aux questions courantes sur Exploit Database