Comment scraper jup.ag : Guide du web scraper pour l'DEX Jupiter

Apprenez à scraper jup.ag pour obtenir les prix des tokens Solana, les routes de swap et les volumes de marché en temps réel. Découvrez les API officielles de...

Protection Anti-Bot Détectée

- Cloudflare

- WAF et gestion de bots de niveau entreprise. Utilise des défis JavaScript, des CAPTCHAs et l'analyse comportementale. Nécessite l'automatisation du navigateur avec des paramètres furtifs.

- Limitation de débit

- Limite les requêtes par IP/session dans le temps. Peut être contourné avec des proxys rotatifs, des délais de requête et du scraping distribué.

- Empreinte navigateur

- Identifie les bots par les caractéristiques du navigateur : canvas, WebGL, polices, plugins. Nécessite du spoofing ou de vrais profils de navigateur.

- Empreinte navigateur

- Identifie les bots par les caractéristiques du navigateur : canvas, WebGL, polices, plugins. Nécessite du spoofing ou de vrais profils de navigateur.

À Propos de Jupiter

Découvrez ce que Jupiter offre et quelles données précieuses peuvent être extraites.

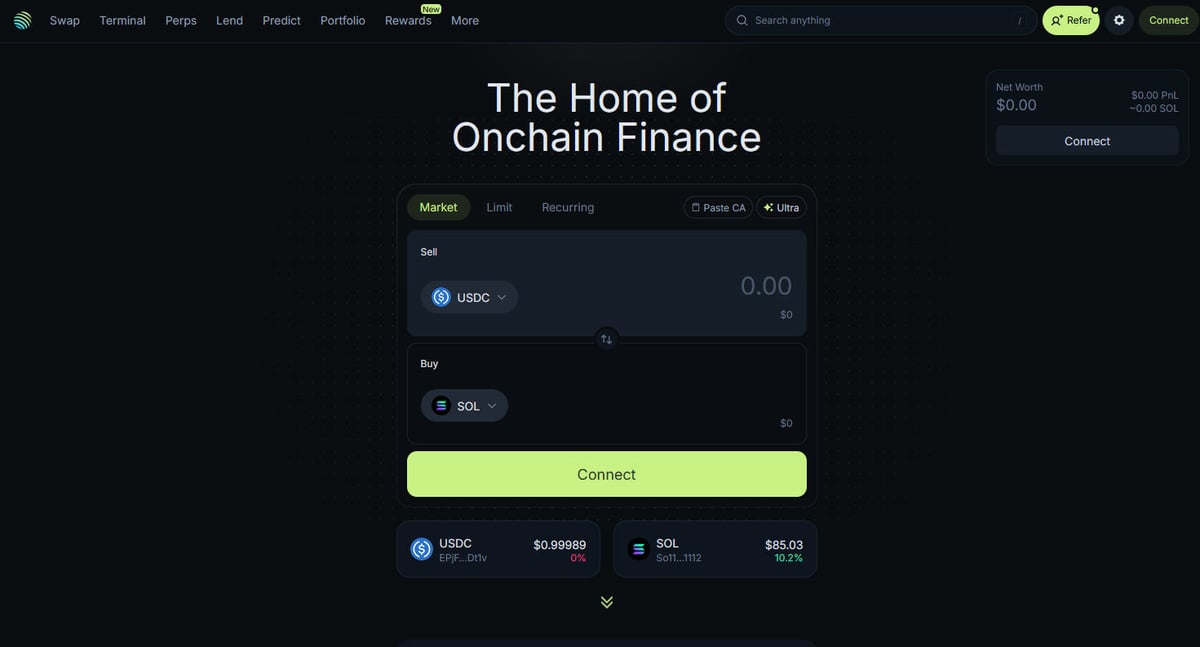

Le centre de la DeFi sur Solana

Jupiter est le principal agrégateur de liquidité pour la blockchain Solana, agissant comme une « DeFi Superapp » qui optimise le routage des transactions à travers des centaines de pools de liquidité pour fournir aux utilisateurs les meilleurs prix et un slippage minimal. C'est le pivot de la finance on-chain sur Solana, proposant des services allant du simple swap de tokens à des fonctionnalités avancées comme le trading de perpétuels avec un levier allant jusqu'à 250x, les ordres limités et le Dollar-Cost Averaging (DCA). La plateforme fournit des données critiques pour l'écosystème, notamment des prix en temps réel, la profondeur de liquidité et des métriques de marché complètes pour des milliers d'actifs.

Architecture Technique

Le site web est construit sur une pile technique moderne utilisant Next.js et React, ce qui en fait une application monopage (SPA) hautement dynamique. Comme les prix et les routes sont calculés en temps réel en fonction de l'état actuel de la blockchain, le frontend est constamment mis à jour via des WebSockets et des appels API à haute fréquence. Pour les data scientists, les développeurs et les traders, les données de Jupiter sont considérées comme la référence absolue (state-of-the-art) pour suivre le sentiment du marché Solana et les mouvements de liquidité à travers tout l'écosystème.

Pourquoi ces données sont importantes

L'accès à ces données est essentiel pour construire des bots de trading, des tableaux de bord de marché et mener des analyses historiques sur l'un des réseaux blockchain à la croissance la plus rapide. Les scrapers ciblent souvent Jupiter pour surveiller les nouveaux listings de tokens, suivre les mouvements des « whales » sur les marchés perpétuels ou identifier les écarts de prix pour l'arbitrage. Bien que la plateforme propose des API officielles, le web scraping direct est fréquemment utilisé pour capturer l'état exact de l'interface utilisateur et les données de routage spécifiques qui pourraient ne pas être totalement exposées via les endpoints publics.

Pourquoi Scraper Jupiter?

Découvrez la valeur commerciale et les cas d'utilisation pour l'extraction de données de Jupiter.

Suivi des prix en temps réel

Surveillez les prix des tokens Solana en temps réel pour obtenir un avantage sur le marché DeFi très volatil. Jupiter agrège la liquidité sur l'ensemble de l'écosystème, fournissant les taux de marché les plus précis disponibles.

Optimisation de bots de trading

Alimentez vos bots de trading automatisés avec des données haute fréquence sur les routes de swap et l'impact sur les prix pour l'arbitrage ou le sniping. Cela permet une exécution plus rapide et une meilleure découverte des prix par rapport au trading manuel.

Analyse du sentiment de marché

Suivez l'ajout de nouveaux tokens à la 'Strict List' de Jupiter pour identifier les projets tendance et la confiance de la communauté. L'analyse des variations de volume sur différents actifs aide à prédire les mouvements de marché plus larges.

Surveillance de la profondeur de liquidité

Scrapez les données de liquidité pour déterminer la profondeur de marché de tokens SPL spécifiques et évaluer le potentiel de slippage. C'est critique pour les traders à grande échelle et les fournisseurs de liquidité institutionnels.

Données de performance historique

Collectez le volume quotidien et l'historique des prix pour des tokens qui ne sont peut-être pas listés sur des bourses centralisées. Ces données sont essentielles pour le backtesting de stratégies de trading et la réalisation d'études de marché à long terme.

Mesures de croissance de l'écosystème

Mesurez le volume total et le nombre de transactions sur le réseau Solana en utilisant Jupiter comme indicateur. Cela aide les développeurs et les investisseurs à comprendre le taux d'adoption de la DeFi Solana au fil du temps.

Défis du Scraping

Défis techniques que vous pouvez rencontrer lors du scraping de Jupiter.

Dépendance au rendu JavaScript

Jupiter est construit comme une application monopage (SPA) complexe utilisant React, ce qui signifie que les données ne sont pas présentes dans le HTML initial. Vous devez utiliser un outil capable de restituer entièrement le JavaScript pour accéder aux prix et aux listes de tokens.

Protection Cloudflare agressive

Le site utilise le Web Application Firewall (WAF) de Cloudflare pour bloquer le trafic non issu d'un navigateur et les scripts automatisés. Contourner ces défis nécessite une gestion avancée des empreintes de navigateur et des headers.

Flux de données dynamique

Les prix et les routes de swap sont mis à jour plusieurs fois par seconde via WebSockets et des appels API haute fréquence. Capturer des instantanés cohérents de ces données nécessite une infrastructure de scraping à faible latency et un timing précis.

Limitation du débit sur les endpoints publics

Les endpoints API publics et les routes web font l'objet d'une limitation de débit stricte pour éviter les abus. Dépasser ces limites entraîne souvent des bannissements d'IP temporaires ou permanents, rendant les proxies résidentiels indispensables.

Volatilité des sélecteurs UI

Les mises à jour fréquentes du frontend de Jupiter peuvent modifier les classes CSS et les structures DOM sans préavis. Cela nécessite des scrapers dotés de sélecteurs robustes et flexibles ou une maintenance fréquente pour éviter les interruptions.

Scrapez Jupiter avec l'IA

Aucun code requis. Extrayez des données en minutes avec l'automatisation par IA.

Comment ça marche

Décrivez ce dont vous avez besoin

Dites à l'IA quelles données vous souhaitez extraire de Jupiter. Tapez simplement en langage naturel — pas de code ni de sélecteurs.

L'IA extrait les données

Notre intelligence artificielle navigue sur Jupiter, gère le contenu dynamique et extrait exactement ce que vous avez demandé.

Obtenez vos données

Recevez des données propres et structurées, prêtes à exporter en CSV, JSON ou à envoyer directement à vos applications.

Pourquoi utiliser l'IA pour le scraping

L'IA facilite le scraping de Jupiter sans écrire de code. Notre plateforme alimentée par l'intelligence artificielle comprend quelles données vous voulez — décrivez-les en langage naturel et l'IA les extrait automatiquement.

How to scrape with AI:

- Décrivez ce dont vous avez besoin: Dites à l'IA quelles données vous souhaitez extraire de Jupiter. Tapez simplement en langage naturel — pas de code ni de sélecteurs.

- L'IA extrait les données: Notre intelligence artificielle navigue sur Jupiter, gère le contenu dynamique et extrait exactement ce que vous avez demandé.

- Obtenez vos données: Recevez des données propres et structurées, prêtes à exporter en CSV, JSON ou à envoyer directement à vos applications.

Why use AI for scraping:

- Rendu Headless complet: Automatio gère naturellement le rendu JavaScript complexe de l'interface Jupiter, vous assurant de voir les mêmes données qu'un utilisateur humain. Vous n'avez pas à vous soucier des données manquantes qui ne se chargent qu'après la vue initiale de la page.

- Rotation intelligente des proxies: La rotation intégrée de proxies résidentiels vous permet de contourner Cloudflare et les limitations de débit basées sur l'IP sans effort. Cela garantit que vos sessions de scraping restent ininterrompues, même lors de l'interrogation de données à haute fréquence.

- Sélection visuelle des données: Sélectionnez facilement les prix des tokens, les volumes ou les routes spécifiques que vous souhaitez scraper à l'aide d'une interface pointer-cliquer. Il n'est pas nécessaire d'écrire des sélecteurs XPath ou CSS complexes pour cibler des éléments dynamiques.

- Planification automatisée: Configurez vos scrapers Jupiter pour qu'ils s'exécutent selon un calendrier précis, par exemple chaque minute ou chaque heure, afin de maintenir un ensemble de données frais. C'est parfait pour créer des tableaux de bord en temps réel ou des alertes de prix automatisées.

- Intégration directe des données: Envoyez vos données DeFi scrapées directement vers Google Sheets, Airtable ou votre propre base de données via des Webhooks. Cela élimine la saisie manuelle des données et simplifie votre flux de travail de trading ou de recherche.

Scrapers Web No-Code pour Jupiter

Alternatives pointer-cliquer au scraping alimenté par l'IA

Plusieurs outils no-code comme Browse.ai, Octoparse, Axiom et ParseHub peuvent vous aider à scraper Jupiter sans écrire de code. Ces outils utilisent généralement des interfaces visuelles pour sélectionner les données, bien qu'ils puissent avoir des difficultés avec le contenu dynamique complexe ou les mesures anti-bot.

Workflow Typique avec les Outils No-Code

Défis Courants

Courbe d'apprentissage

Comprendre les sélecteurs et la logique d'extraction prend du temps

Les sélecteurs cassent

Les modifications du site web peuvent casser tout le workflow

Problèmes de contenu dynamique

Les sites riches en JavaScript nécessitent des solutions complexes

Limitations des CAPTCHAs

La plupart des outils nécessitent une intervention manuelle pour les CAPTCHAs

Blocage d'IP

Le scraping agressif peut entraîner le blocage de votre IP

Scrapers Web No-Code pour Jupiter

Plusieurs outils no-code comme Browse.ai, Octoparse, Axiom et ParseHub peuvent vous aider à scraper Jupiter sans écrire de code. Ces outils utilisent généralement des interfaces visuelles pour sélectionner les données, bien qu'ils puissent avoir des difficultés avec le contenu dynamique complexe ou les mesures anti-bot.

Workflow Typique avec les Outils No-Code

- Installer l'extension de navigateur ou s'inscrire sur la plateforme

- Naviguer vers le site web cible et ouvrir l'outil

- Sélectionner en point-and-click les éléments de données à extraire

- Configurer les sélecteurs CSS pour chaque champ de données

- Configurer les règles de pagination pour scraper plusieurs pages

- Gérer les CAPTCHAs (nécessite souvent une résolution manuelle)

- Configurer la planification pour les exécutions automatiques

- Exporter les données en CSV, JSON ou se connecter via API

Défis Courants

- Courbe d'apprentissage: Comprendre les sélecteurs et la logique d'extraction prend du temps

- Les sélecteurs cassent: Les modifications du site web peuvent casser tout le workflow

- Problèmes de contenu dynamique: Les sites riches en JavaScript nécessitent des solutions complexes

- Limitations des CAPTCHAs: La plupart des outils nécessitent une intervention manuelle pour les CAPTCHAs

- Blocage d'IP: Le scraping agressif peut entraîner le blocage de votre IP

Exemples de Code

import requests

def get_jupiter_price(token_address):

# L'utilisation de l'API Price V2 officielle de Jupiter est la méthode la plus fiable

url = f"https://api.jup.ag/price/v2?ids={token_address}"

headers = {

"User-Agent": "Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/120.0.0.0 Safari/537.36",

"Accept": "application/json"

}

try:

response = requests.get(url, headers=headers)

response.raise_for_status()

data = response.json()

price_info = data['data'].get(token_address)

if price_info:

print(f"Token: {token_address} | Prix: ${price_info['price']}")

except Exception as e:

print(f"Une erreur est survenue : {e}")

# Exemple : Récupération du prix du SOL

get_jupiter_price("So11111111111111111111111111111111111111112")Quand Utiliser

Idéal pour les pages HTML statiques avec peu de JavaScript. Parfait pour les blogs, sites d'actualités et pages e-commerce simples.

Avantages

- ●Exécution la plus rapide (sans surcharge navigateur)

- ●Consommation de ressources minimale

- ●Facile à paralléliser avec asyncio

- ●Excellent pour les APIs et pages statiques

Limitations

- ●Ne peut pas exécuter JavaScript

- ●Échoue sur les SPAs et contenu dynamique

- ●Peut avoir des difficultés avec les systèmes anti-bot complexes

Comment Scraper Jupiter avec du Code

Python + Requests

import requests

def get_jupiter_price(token_address):

# L'utilisation de l'API Price V2 officielle de Jupiter est la méthode la plus fiable

url = f"https://api.jup.ag/price/v2?ids={token_address}"

headers = {

"User-Agent": "Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/120.0.0.0 Safari/537.36",

"Accept": "application/json"

}

try:

response = requests.get(url, headers=headers)

response.raise_for_status()

data = response.json()

price_info = data['data'].get(token_address)

if price_info:

print(f"Token: {token_address} | Prix: ${price_info['price']}")

except Exception as e:

print(f"Une erreur est survenue : {e}")

# Exemple : Récupération du prix du SOL

get_jupiter_price("So11111111111111111111111111111111111111112")Python + Playwright

from playwright.sync_api import sync_playwright

def scrape_jupiter_tokens():

with sync_playwright() as p:

# Lancer un navigateur capable de rendre le frontend Next.js

browser = p.chromium.launch(headless=True)

context = browser.new_context(

user_agent="Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/120.0.0.0 Safari/537.36"

)

page = context.new_page()

page.goto("https://jup.ag/tokens", wait_until="networkidle")

# Attendre que les éléments de la liste de tokens soient rendus dans le DOM

# Note : Les sélecteurs doivent être mis à jour selon le build actuel de l'interface

page.wait_for_selector(".token-item")

tokens = page.query_selector_all(".token-item")

for token in tokens[:10]:

name = token.query_selector(".token-name").inner_text()

price = token.query_selector(".token-price").inner_text()

print(f"{name}: {price}")

browser.close()

scrape_jupiter_tokens()Python + Scrapy

import scrapy

import json

class JupiterTokenSpider(scrapy.Spider):

name = 'jupiter_tokens'

# Accès direct à l'endpoint JSON de la liste de tokens utilisé par le frontend

start_urls = ['https://token.jup.ag/all']

def parse(self, response):

# La réponse est une liste JSON brute de tous les tokens vérifiés

tokens = json.loads(response.text)

for token in tokens[:100]:

yield {

'symbol': token.get('symbol'),

'name': token.get('name'),

'address': token.get('address'),

'decimals': token.get('decimals'),

'logoURI': token.get('logoURI')

}Node.js + Puppeteer

const puppeteer = require('puppeteer');

(async () => {

const browser = await puppeteer.launch({ headless: true });

const page = await browser.newPage();

// Définir un User-Agent réaliste pour aider à contourner les filtres de base

await page.setUserAgent('Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/120.0.0.0 Safari/537.36');

// Naviguer vers la page principale de swap

await page.goto('https://jup.ag/', { waitUntil: 'networkidle2' });

// Exemple d'extraction d'un élément de prix à l'aide d'un sélecteur partiel

const solPrice = await page.evaluate(() => {

const element = document.querySelector('div[class*="price"]');

return element ? element.innerText : 'Prix non trouvé';

});

console.log(`Prix SOL en direct observé dans l'interface : ${solPrice}`);

await browser.close();

})();Que Pouvez-Vous Faire Avec Les Données de Jupiter

Explorez les applications pratiques et les insights des données de Jupiter.

Système d'alerte d'arbitrage de prix

Identifiez les différences de prix entre Jupiter et d'autres DEXs Solana pour exécuter des transactions rentables.

Comment implémenter :

- 1Scrapez les taux de swap en temps réel depuis la Price API de Jupiter.

- 2Comparez les taux avec les pools de liquidité d'Orca et Raydium.

- 3Configurez des alertes automatisées ou des hooks d'exécution pour les opportunités d'arbitrage.

Utilisez Automatio pour extraire des données de Jupiter et créer ces applications sans écrire de code.

Que Pouvez-Vous Faire Avec Les Données de Jupiter

- Système d'alerte d'arbitrage de prix

Identifiez les différences de prix entre Jupiter et d'autres DEXs Solana pour exécuter des transactions rentables.

- Scrapez les taux de swap en temps réel depuis la Price API de Jupiter.

- Comparez les taux avec les pools de liquidité d'Orca et Raydium.

- Configurez des alertes automatisées ou des hooks d'exécution pour les opportunités d'arbitrage.

- Tableau de bord de santé du marché Solana

Construisez une vue macro de l'activité DeFi sur Solana pour les investisseurs.

- Agrégez le volume sur 24h et les données TVL pour les principaux tokens.

- Catégorisez les tokens par secteurs (Meme, AI, RWA).

- Visualisez les changements de liquidité à travers différentes classes d'actifs au fil du temps.

- Sniper de nouveaux listings de tokens

Détectez et analysez immédiatement les nouveaux tokens apparaissant sur la liste vérifiée de Jupiter.

- Scrapez régulièrement l'endpoint de la liste des tokens.

- Comparez les nouveaux résultats avec une base de données locale pour trouver les nouveaux ajouts.

- Analysez la liquidité initiale et le volume pour évaluer le potentiel du token.

- Traqueur de Whales et de Perpétuels

Surveillez les positions importantes et les taux de financement sur le marché des perpétuels de Jupiter.

- Scrapez l'intérêt ouvert (open interest) et les données de taux de financement depuis la section Perps.

- Suivez les journaux de transactions volumineuses pour identifier le comportement des wallets.

- Construisez des modèles de sentiment basés sur les ratios long/short des principaux actifs.

- Service d'agrégation de rendement

Fournissez aux utilisateurs les meilleurs taux de prêt disponibles à travers les vaults de Jupiter Lend.

- Scrapez les données APY pour divers stablecoins et paires SOL.

- Calculez le rendement net après déduction des frais de plateforme estimés.

- Automatisez les recommandations de rééquilibrage pour l'optimisation de portefeuille.

Optimisez votre flux de travail avec l'Automatisation IA

Automatio combine la puissance des agents IA, de l'automatisation web et des integrations intelligentes pour vous aider a accomplir plus en moins de temps.

Conseils Pro pour Scraper Jupiter

Conseils d'experts pour extraire avec succès les données de Jupiter.

Privilégier les endpoints API officiels

Dans la mesure du possible, utilisez les API officielles V6 Quote ou Price de Jupiter au lieu de scraper l'interface utilisateur. Ces endpoints sont conçus pour un accès programmatique haute performance et sont généralement plus stables.

Implémenter l'exponential backoff

Lorsque vos requêtes atteignent une limite de débit, utilisez une stratégie qui augmente progressivement le temps d'attente entre les tentatives. Cela aide à éviter que votre IP ne soit signalée comme malveillante par la couche de sécurité de Jupiter.

Filtrer via la 'Strict List'

Scrapez la 'Strict List' de tokens de Jupiter pour vous assurer de ne surveiller que les actifs vérifiés. C'est le meilleur moyen de filtrer les rugpulls à faible liquidité et les tokens frauduleux qui apparaissent dans la liste 'All'.

Utiliser des proxies résidentiels de haute qualité

Évitez d'utiliser des proxies de datacenter car ils sont souvent pré-blacklistés par Cloudflare. Les proxies résidentiels ou mobiles inspirent plus de confiance et sont moins susceptibles de déclencher des CAPTCHAs ou des erreurs 403 Forbidden.

Surveiller le trafic WebSocket

Utilisez l'inspecteur réseau de votre navigateur pour trouver les connexions WebSocket que Jupiter utilise pour les mises à jour en direct. Émuler ces connexions peut être plus efficace que de recharger la page pour obtenir des flux de prix en temps réel.

Prendre en compte les décimales des tokens

Extrayez toujours le champ 'decimals' des métadonnées du token lors du scraping des adresses de mint. C'est crucial pour convertir correctement les entiers bruts on-chain en montants de devise lisibles par l'homme.

Témoignages

Ce Que Disent Nos Utilisateurs

Rejoignez des milliers d'utilisateurs satisfaits qui ont transforme leur flux de travail

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Associés Web Scraping

How to Scrape Moon.ly | Step-by-Step NFT Data Extraction Guide

How to Scrape Yahoo Finance: Extract Stock Market Data

How to Scrape Rocket Mortgage: A Comprehensive Guide

How to Scrape Open Collective: Financial and Contributor Data Guide

How to Scrape Indiegogo: The Ultimate Crowdfunding Data Extraction Guide

How to Scrape ICO Drops: Comprehensive Crypto Data Guide

How to Scrape Crypto.com: Comprehensive Market Data Guide

How to Scrape Coinpaprika: Crypto Market Data Extraction Guide

Questions Fréquentes sur Jupiter

Trouvez des réponses aux questions courantes sur Jupiter