Comment scraper Signal NFX | Guide de scraping de base de données d'investisseurs et VC

Apprenez à scraper les profils d'investisseurs, les données de firmes VC et les listes de leads de Signal NFX. Découvrez des stratégies techniques pour la...

Protection Anti-Bot Détectée

- Cloudflare

- WAF et gestion de bots de niveau entreprise. Utilise des défis JavaScript, des CAPTCHAs et l'analyse comportementale. Nécessite l'automatisation du navigateur avec des paramètres furtifs.

- Limitation de débit

- Limite les requêtes par IP/session dans le temps. Peut être contourné avec des proxys rotatifs, des délais de requête et du scraping distribué.

- Blocage IP

- Bloque les IP de centres de données connues et les adresses signalées. Nécessite des proxys résidentiels ou mobiles pour contourner efficacement.

- Login Wall

- Google reCAPTCHA

- Système CAPTCHA de Google. v2 nécessite une interaction utilisateur, v3 fonctionne silencieusement avec un score de risque. Peut être résolu avec des services CAPTCHA.

À Propos de Signal (by NFX)

Découvrez ce que Signal (by NFX) offre et quelles données précieuses peuvent être extraites.

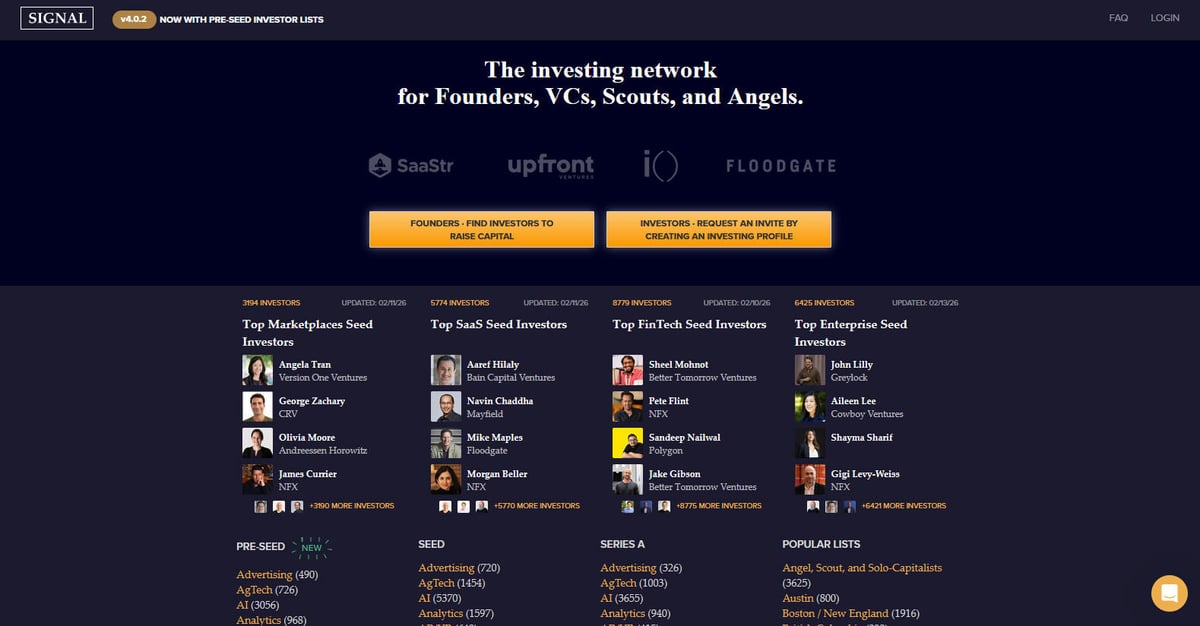

Signal est un puissant réseau d'investissement spécifiquement conçu pour les fondateurs, les VC, les scouts et les angel investors. Créée et maintenue par NFX, une importante société de venture capital spécialisée dans le seed-stage, la plateforme sert de répertoire massif et d'outil de networking pour faciliter la levée de fonds des startups. Elle vise à rendre l'écosystème du capital-risque plus transparent en cartographiant les connexions entre investisseurs et entrepreneurs, remplaçant efficacement les feuilles de calcul manuelles par un environnement dynamique riche en données.

La plateforme contient des milliers de profils d'investisseurs, catégorisés par leur étape d'investissement préférée (du Pre-Seed à la Series B), des secteurs industriels comme l'AI, le SaaS et la FinTech, et des régions géographiques. Les utilisateurs peuvent trouver des informations détaillées sur les sociétés de venture capital, les partenaires individuels et leurs thèses d'investissement spécifiques, qui sont fréquemment mises à jour pour refléter le paysage actuel du marché. Chaque fiche présente généralement l'objectif d'un investisseur, ses étapes d'investissement préférées, ses thèses d'investissement spécifiques et ses préférences directes d'introduction pour les fondateurs.

Scraper Signal est extrêmement précieux pour les fondateurs qui ont besoin de construire des listes de leads d'investisseurs ciblées sans parcourir manuellement des milliers d'entrées. Cela fournit également des données critiques pour les chercheurs de marché suivant les tendances du venture capital, de la veille concurrentielle pour d'autres sociétés de VC, et des données pour les équipes de vente ciblant l'écosystème des startups via la cartographie des relations et des introductions.

Pourquoi Scraper Signal (by NFX)?

Découvrez la valeur commerciale et les cas d'utilisation pour l'extraction de données de Signal (by NFX).

Constituer des pipelines d'investisseurs

Les fondateurs peuvent extraire des listes ciblées de VCs et de business angels correspondant à leur stade de financement et à leur secteur d'activité pour simplifier le processus de levée de fonds.

Analyser les tendances du venture capital

Le scraping de listes sectorielles permet aux chercheurs d'identifier les industries, telles que l'AI ou la ClimateTech, qui connaissent la plus forte densité d'investissements actifs en phase d'amorçage.

Génération de leads B2B

Les prestataires de services tels que les cabinets d'avocats, les recruteurs et les agences de marketing peuvent identifier les fonds de capital-risque actifs pour proposer leurs services aux entreprises du portefeuille nouvellement financées.

Cartographie des introductions qualifiées

En extrayant les données relationnelles des investisseurs et les affiliations aux firmes, les entrepreneurs peuvent tracer les chemins sociaux les plus efficaces pour obtenir des introductions chaleureuses.

Veille concurrentielle

Les firmes de venture capital peuvent surveiller les axes d'investissement et l'expansion des équipes des firmes concurrentes pour mieux comprendre le paysage concurrentiel de l'écosystème startup.

Étude de marché géographique

Identifiez les acteurs financiers clés et les investisseurs les plus actifs dans des régions spécifiques comme Israël, l'Europe ou l'Amérique latine pour des stratégies d'entrée sur le marché localisées.

Défis du Scraping

Défis techniques que vous pouvez rencontrer lors du scraping de Signal (by NFX).

Authentification complexe

Signal masque de nombreux profils détaillés et listes complètes d'investisseurs derrière une barrière de connexion, obligeant les scrapers à gérer les cookies de session et les flux d'authentification automatisés.

Rendu JS dynamique

La plateforme s'appuie fortement sur des frameworks JavaScript modernes pour charger le contenu dynamiquement via le défilement infini et AJAX, rendant les parseurs HTML traditionnels inefficaces.

Détection agressive des bots

NFX utilise Cloudfront et d'autres couches de sécurité qui surveillent les requêtes à haute fréquence, les empreintes de bots courantes et les adresses IP de data centers.

Structure de données imbriquée

L'extraction de données complètes nécessite de naviguer à travers plusieurs niveaux, notamment les pages des firmes, les sous-pages des partenaires et les tags de catégories sectorielles.

Limitation de débit et bridage

Accéder à des centaines de profils en peu de temps déclenche souvent des bannissements IP temporaires ou des défis CAPTCHA destinés à empêcher la collecte de données à grande échelle.

Scrapez Signal (by NFX) avec l'IA

Aucun code requis. Extrayez des données en minutes avec l'automatisation par IA.

Comment ça marche

Décrivez ce dont vous avez besoin

Dites à l'IA quelles données vous souhaitez extraire de Signal (by NFX). Tapez simplement en langage naturel — pas de code ni de sélecteurs.

L'IA extrait les données

Notre intelligence artificielle navigue sur Signal (by NFX), gère le contenu dynamique et extrait exactement ce que vous avez demandé.

Obtenez vos données

Recevez des données propres et structurées, prêtes à exporter en CSV, JSON ou à envoyer directement à vos applications.

Pourquoi utiliser l'IA pour le scraping

L'IA facilite le scraping de Signal (by NFX) sans écrire de code. Notre plateforme alimentée par l'intelligence artificielle comprend quelles données vous voulez — décrivez-les en langage naturel et l'IA les extrait automatiquement.

How to scrape with AI:

- Décrivez ce dont vous avez besoin: Dites à l'IA quelles données vous souhaitez extraire de Signal (by NFX). Tapez simplement en langage naturel — pas de code ni de sélecteurs.

- L'IA extrait les données: Notre intelligence artificielle navigue sur Signal (by NFX), gère le contenu dynamique et extrait exactement ce que vous avez demandé.

- Obtenez vos données: Recevez des données propres et structurées, prêtes à exporter en CSV, JSON ou à envoyer directement à vos applications.

Why use AI for scraping:

- Gestion simplifiée de la connexion: Automatio vous permet d'enregistrer visuellement le processus de connexion et de stocker les sessions, permettant au bot d'accéder aux données d'investisseurs restreintes sans intervention manuelle.

- Défilement infini intégré: L'outil gère le chargement dynamique sans effort, faisant défiler automatiquement les longues listes d'investisseurs et capturant les données au fur et à mesure qu'elles apparaissent dans le navigateur.

- Interaction de type humain: Automatio imite les comportements de navigation naturels et s'intègre aux proxies résidentiels pour contourner la sécurité Cloudfront et éviter la détection.

- Sélection visuelle des données: Les utilisateurs peuvent pointer et cliquer pour sélectionner des points de données complexes tels que les thèses d'investissement ou les préférences de contact, quelle que soit la complexité HTML sous-jacente.

- Synchronisation CRM sans code: Exportez automatiquement les données d'investisseurs scrapées directement vers Google Sheets ou des CRM, éliminant le besoin de scripts personnalisés pour formater et transférer les données.

Scrapers Web No-Code pour Signal (by NFX)

Alternatives pointer-cliquer au scraping alimenté par l'IA

Plusieurs outils no-code comme Browse.ai, Octoparse, Axiom et ParseHub peuvent vous aider à scraper Signal (by NFX) sans écrire de code. Ces outils utilisent généralement des interfaces visuelles pour sélectionner les données, bien qu'ils puissent avoir des difficultés avec le contenu dynamique complexe ou les mesures anti-bot.

Workflow Typique avec les Outils No-Code

Défis Courants

Courbe d'apprentissage

Comprendre les sélecteurs et la logique d'extraction prend du temps

Les sélecteurs cassent

Les modifications du site web peuvent casser tout le workflow

Problèmes de contenu dynamique

Les sites riches en JavaScript nécessitent des solutions complexes

Limitations des CAPTCHAs

La plupart des outils nécessitent une intervention manuelle pour les CAPTCHAs

Blocage d'IP

Le scraping agressif peut entraîner le blocage de votre IP

Scrapers Web No-Code pour Signal (by NFX)

Plusieurs outils no-code comme Browse.ai, Octoparse, Axiom et ParseHub peuvent vous aider à scraper Signal (by NFX) sans écrire de code. Ces outils utilisent généralement des interfaces visuelles pour sélectionner les données, bien qu'ils puissent avoir des difficultés avec le contenu dynamique complexe ou les mesures anti-bot.

Workflow Typique avec les Outils No-Code

- Installer l'extension de navigateur ou s'inscrire sur la plateforme

- Naviguer vers le site web cible et ouvrir l'outil

- Sélectionner en point-and-click les éléments de données à extraire

- Configurer les sélecteurs CSS pour chaque champ de données

- Configurer les règles de pagination pour scraper plusieurs pages

- Gérer les CAPTCHAs (nécessite souvent une résolution manuelle)

- Configurer la planification pour les exécutions automatiques

- Exporter les données en CSV, JSON ou se connecter via API

Défis Courants

- Courbe d'apprentissage: Comprendre les sélecteurs et la logique d'extraction prend du temps

- Les sélecteurs cassent: Les modifications du site web peuvent casser tout le workflow

- Problèmes de contenu dynamique: Les sites riches en JavaScript nécessitent des solutions complexes

- Limitations des CAPTCHAs: La plupart des outils nécessitent une intervention manuelle pour les CAPTCHAs

- Blocage d'IP: Le scraping agressif peut entraîner le blocage de votre IP

Exemples de Code

import requests

from bs4 import BeautifulSoup

# Signal requires login for full data access. This example uses a session.

session = requests.Session()

url = 'https://signal.nfx.com/investor-lists/top-marketplaces-seed-investors'

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/91.0.4472.124 Safari/537.36'

}

try:

# In a real scenario, you would need to POST login credentials here first

# session.post('https://signal.nfx.com/login', data={'email': '...', 'password': '...'})

response = session.get(url, headers=headers)

response.raise_for_status()

soup = BeautifulSoup(response.text, 'html.parser')

# Find investor cards in the list

investors = soup.select('.investor-card')

for investor in investors:

name = investor.select_one('.name').get_text(strip=True)

firm = investor.select_one('.firm-name').get_text(strip=True)

print(f'Investor: {name} | Firm: {firm}')

except Exception as e:

print(f'Error scraping Signal: {e}')Quand Utiliser

Idéal pour les pages HTML statiques avec peu de JavaScript. Parfait pour les blogs, sites d'actualités et pages e-commerce simples.

Avantages

- ●Exécution la plus rapide (sans surcharge navigateur)

- ●Consommation de ressources minimale

- ●Facile à paralléliser avec asyncio

- ●Excellent pour les APIs et pages statiques

Limitations

- ●Ne peut pas exécuter JavaScript

- ●Échoue sur les SPAs et contenu dynamique

- ●Peut avoir des difficultés avec les systèmes anti-bot complexes

Comment Scraper Signal (by NFX) avec du Code

Python + Requests

import requests

from bs4 import BeautifulSoup

# Signal requires login for full data access. This example uses a session.

session = requests.Session()

url = 'https://signal.nfx.com/investor-lists/top-marketplaces-seed-investors'

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/91.0.4472.124 Safari/537.36'

}

try:

# In a real scenario, you would need to POST login credentials here first

# session.post('https://signal.nfx.com/login', data={'email': '...', 'password': '...'})

response = session.get(url, headers=headers)

response.raise_for_status()

soup = BeautifulSoup(response.text, 'html.parser')

# Find investor cards in the list

investors = soup.select('.investor-card')

for investor in investors:

name = investor.select_one('.name').get_text(strip=True)

firm = investor.select_one('.firm-name').get_text(strip=True)

print(f'Investor: {name} | Firm: {firm}')

except Exception as e:

print(f'Error scraping Signal: {e}')Python + Playwright

from playwright.sync_api import sync_playwright

def scrape_signal():

with sync_playwright() as p:

browser = p.chromium.launch(headless=True)

page = browser.new_page()

# Navigate to login

page.goto('https://signal.nfx.com/login')

page.fill('input[name="email"]', 'your_email@example.com')

page.fill('input[name="password"]', 'your_password')

page.click('button:has-text("Log In")')

# Wait for the listing page to load after login

page.wait_for_url('**/investors')

page.goto('https://signal.nfx.com/investor-lists/top-ai-seed-investors')

page.wait_for_selector('.investor-card')

# Scroll to load infinite content

for _ in range(5):

page.mouse.wheel(0, 4000)

page.wait_for_timeout(2000)

investors = page.query_selector_all('.investor-card')

for investor in investors:

name = investor.query_selector('.name').inner_text()

print(f'Found Investor: {name}')

browser.close()

scrape_signal()Python + Scrapy

import scrapy

class SignalSpider(scrapy.Spider):

name = 'signal_spider'

# Note: Requires scrapy-playwright for JavaScript rendering

start_urls = ['https://signal.nfx.com/investor-lists/top-saas-seed-investors']

def start_requests(self):

for url in self.start_urls:

yield scrapy.Request(url, meta={'playwright': True})

def parse(self, response):

for investor in response.css('.investor-card'):

yield {

'name': investor.css('.name::text').get(),

'firm': investor.css('.firm-name::text').get(),

'link': response.urljoin(investor.css('a::attr(href)').get())

}

# Scrapy logic for infinite scroll would require a custom Playwright handler

# to scroll down before passing the response back to parseNode.js + Puppeteer

const puppeteer = require('puppeteer');

(async () => {

const browser = await puppeteer.launch({ headless: true });

const page = await browser.newPage();

await page.setUserAgent('Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/91.0.4472.124 Safari/537.36');

// Handle Login first

await page.goto('https://signal.nfx.com/login');

await page.type('#user_email', 'your_email');

await page.type('#user_password', 'your_password');

await page.click('.btn-primary');

await page.waitForNavigation();

await page.goto('https://signal.nfx.com/investor-lists/top-fintech-seed-investors');

await page.waitForSelector('.investor-card');

const investors = await page.evaluate(() => {

const items = Array.from(document.querySelectorAll('.investor-card'));

return items.map(item => ({

name: item.querySelector('.name')?.innerText.trim(),

firm: item.querySelector('.firm-name')?.innerText.trim()

}));

});

console.log(investors);

await browser.close();

})();Que Pouvez-Vous Faire Avec Les Données de Signal (by NFX)

Explorez les applications pratiques et les insights des données de Signal (by NFX).

Automatisation de la prospection pour la levée de fonds

Les fondateurs peuvent utiliser les données pour identifier et prioriser les investisseurs les plus susceptibles d'investir dans leur étape et leur secteur spécifiques.

Comment implémenter :

- 1Scrapez des listes d'investisseurs dans votre secteur (ex: 'Top AI Seed Investors').

- 2Filtrez les résultats par 'Last Updated' pour trouver les participants actifs qui financent actuellement.

- 3Exportez vers un CRM comme HubSpot ou Pipedrive pour le suivi de la prospection.

- 4Utilisez les liens de profil pour identifier les connexions mutuelles pour des introductions chaleureuses.

Utilisez Automatio pour extraire des données de Signal (by NFX) et créer ces applications sans écrire de code.

Que Pouvez-Vous Faire Avec Les Données de Signal (by NFX)

- Automatisation de la prospection pour la levée de fonds

Les fondateurs peuvent utiliser les données pour identifier et prioriser les investisseurs les plus susceptibles d'investir dans leur étape et leur secteur spécifiques.

- Scrapez des listes d'investisseurs dans votre secteur (ex: 'Top AI Seed Investors').

- Filtrez les résultats par 'Last Updated' pour trouver les participants actifs qui financent actuellement.

- Exportez vers un CRM comme HubSpot ou Pipedrive pour le suivi de la prospection.

- Utilisez les liens de profil pour identifier les connexions mutuelles pour des introductions chaleureuses.

- Analyse du paysage concurrentiel des VC

Les sociétés de venture capital peuvent surveiller les domaines d'intervention et les expansions d'équipe d'autres firmes pour rester compétitives dans l'écosystème.

- Scrapez périodiquement la section 'Firms' de Signal pour suivre les changements.

- Identifiez quelles sociétés ajoutent de nouveaux 'Scouts' ou 'Angels' à leur réseau.

- Suivez les évolutions des priorités d'investissement en surveillant les changements dans le nombre de listes par secteur au fil du temps.

- Stratégie d'expansion géographique

Les entreprises ou investisseurs cherchant à pénétrer de nouveaux marchés peuvent identifier les acteurs financiers clés dans des régions spécifiques.

- Scrapez des listes spécifiques à une région comme 'LatAm', 'Israel' ou 'MENA'.

- Catégorisez les investisseurs par type de firme (VC vs Angel) pour comprendre le mix de capitaux.

- Cartographiez l'environnement de financement local pour identifier les investisseurs leaders potentiels pour une entrée sur le marché.

- Cartographie des relations et des introductions

Analysez les connexions sociales pour trouver le chemin de moindre résistance pour des introductions chaleureuses auprès de VC de haut niveau.

- Extrayez les données de connexion mutuelle et les informations du graphe social à partir des profils d'investisseurs.

- Recoupez les connexions scrapées avec votre propre réseau LinkedIn.

- Priorisez la prospection en fonction de la force des nœuds de réseau existants.

- Étude de marché sur les secteurs émergents

Analysez quelles nouvelles industries gagnent le plus de densité dans le graphe du venture capital pour prédire la prochaine tendance.

- Scrapez les tags de secteurs spécifiques et les comptages à travers différentes étapes de financement.

- Calculez la croissance de l'intérêt des investisseurs pour des catégories spécifiques par intervalles trimestriels.

- Créez des rapports pour les parties prenantes sur l'endroit où l'argent intelligent ('smart money') circule actuellement.

Optimisez votre flux de travail avec l'Automatisation IA

Automatio combine la puissance des agents IA, de l'automatisation web et des integrations intelligentes pour vous aider a accomplir plus en moins de temps.

Conseils Pro pour Scraper Signal (by NFX)

Conseils d'experts pour extraire avec succès les données de Signal (by NFX).

Cibler les URL par secteur spécifique

Au lieu de crawler l'intégralité du site, utilisez les URL spécifiques des listes d'investisseurs pour des secteurs comme le SaaS ou la Fintech afin d'obtenir des données pré-catégorisées et structurées.

Utiliser des proxies résidentiels

Acheminez toujours votre trafic de scraping via des proxies résidentiels de haute qualité pour éviter le signalement immédiat de votre IP, fréquent avec les fournisseurs de data centers sur cette plateforme.

Implémenter des délais aléatoires

Injectez des intervalles de sommeil aléatoires entre 3 et 7 secondes pour simuler un chercheur humain consultant les profils, ce qui aide à éviter de déclencher les limitations de débit.

Réutiliser les cookies de session

Pour minimiser les activités suspectes, maintenez votre session de connexion sur plusieurs requêtes plutôt que de vous connecter et de vous déconnecter pour chaque page que vous scrapez.

Surveiller les requêtes XHR internes

Utilisez les outils de développement du navigateur pour trouver les endpoints JSON en arrière-plan qui alimentent les listes d'investisseurs, car ils contiennent souvent des données plus propres que le code HTML brut.

Scraper pendant les heures creuses

Exécutez les tâches d'extraction de données volumineuses pendant les week-ends ou tard dans la nuit (fuseau horaire de l'Est des États-Unis) lorsque le trafic global et la surveillance de la plateforme sont généralement moins restrictifs.

Témoignages

Ce Que Disent Nos Utilisateurs

Rejoignez des milliers d'utilisateurs satisfaits qui ont transforme leur flux de travail

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Associés Web Scraping

How to Scrape Bilregistret.ai: Swedish Vehicle Data Extraction Guide

How to Scrape Biluppgifter.se: Vehicle Data Extraction Guide

How to Scrape CSS Author: A Comprehensive Web Scraping Guide

How to Scrape The AA (theaa.com): A Technical Guide for Car & Insurance Data

How to Scrape GoAbroad Study Abroad Programs

How to Scrape Car.info | Vehicle Data & Valuation Extraction Guide

How to Scrape ResearchGate: Publication and Researcher Data

How to Scrape Statista: The Ultimate Guide to Market Data Extraction

Questions Fréquentes sur Signal (by NFX)

Trouvez des réponses aux questions courantes sur Signal (by NFX)