Claude 3.7 Sonnet

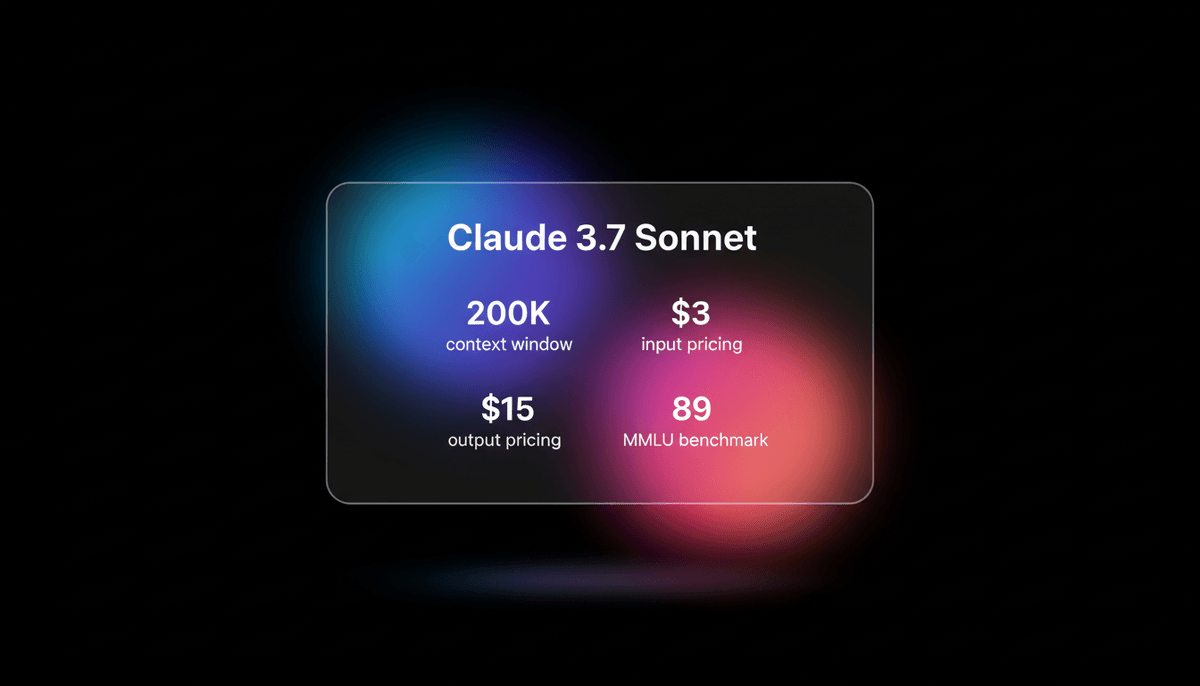

Claude 3.7 Sonnet est le premier model de raisonnement hybride d'Anthropic, offrant des capacités de codage de pointe, un context window de 200k et une...

À propos de Claude 3.7 Sonnet

Découvrez les capacités, fonctionnalités et façons d'utiliser Claude 3.7 Sonnet.

Hybrid Reasoning et Transparence

Claude 3.7 Sonnet représente une étape majeure dans l'architecture des LLM en tant que premier model de 'hybrid reasoning' d'Anthropic. Il permet aux utilisateurs de basculer entre des réponses standard à faible latency et un mode 'extended thinking' qui affiche sa chain-of-thought interne. Cette transparence offre aux utilisateurs une vision claire de la logique du model, le rendant particulièrement efficace pour le dépannage complexe et les tâches de reasoning à enjeux élevés.

Maîtrise de l'ingénierie logicielle

Conçu avec un accent mis sur l'ingénierie logicielle et des résultats prêts pour la production, le model a établi de nouveaux standards industriels sur des benchmarks comme SWE-Bench Verified. Il excelle dans le 'vibe coding', où les développeurs décrivent une intention de haut niveau et le model gère l'implémentation sur plusieurs fichiers. Il traite les refactorisations complexes et les décisions architecturales avec une précision qui surpasse les précédents frontier models.

Context window massif et outils agentic

Avec un context window massif de 200 000 tokens et un ensemble d'outils agentic nommé Claude Code, il se transforme d'un simple chatbot en un partenaire technique collaboratif. Il est capable de gérer des cycles de vie complets de projets, de la révision initiale de la documentation aux workflows git automatisés et à l'exécution des tests, garantissant un développement rapide et sans bug.

Cas d'utilisation de Claude 3.7 Sonnet

Découvrez les différentes façons d'utiliser Claude 3.7 Sonnet pour obtenir d'excellents résultats.

Vibe Coding

Création de logiciels fonctionnels à partir de zéro en décrivant l'intention en langage naturel.

Debugging avancé

Utilisation du 'extended thinking' pour analyser des logs complexes et fournir des correctifs précis en un coup d'œil.

Analyse de large contexte

Révision et refactorisation de bases de code entières ou de documentations techniques volumineuses dans un seul prompt.

Développement agentic

Alimentation d'outils en terminal comme Claude Code pour automatiser les workflows git et l'exécution des tests.

Génération d'UI Frontend

Création de composants React et Svelte élégants et maintenables avec une sensibilité au design intégrée.

Recherche factuelle

Analyse de documents PDF massifs et de jeux de données avec une grande précision et de faibles taux d'hallucination.

Points forts

Limitations

Démarrage rapide API

anthropic/claude-3.7-sonnet

import Anthropic from '@anthropic-ai/sdk';

const anthropic = new Anthropic({

apiKey: process.env.ANTHROPIC_API_KEY,

});

const msg = await anthropic.messages.create({

model: "claude-3-7-sonnet-20250219",

max_tokens: 1024,

thinking: { type: "enabled", budget_tokens: 1024 },

messages: [{ role: "user", content: "Write a high-performance Rust function for matrix multiplication." }],

});

console.log(msg.content);Installez le SDK et commencez à faire des appels API en quelques minutes.

Ce que les gens disent de Claude 3.7 Sonnet

Voyez ce que la communauté pense de Claude 3.7 Sonnet

“Claude 3.7 Sonnet est le meilleur model d'IA de codage au monde ; il m'a bluffé sur des tâches difficiles.”

“Avec un seul prompt, il a tout réussi parfaitement sur un projet TypeScript complexe.”

“Claude Code avec Sonnet 3.7 est bien meilleur que Cline et actuellement le meilleur outil.”

“Le saut qualitatif avec des models de premier plan comme le 3.7 a transformé ma vision des choses.”

“Claude 3.7 c'est du lourd, ça frappe différemment... clairement le GOAT, sérieux”

“Le mode reasoning de Claude 3.7 est un changement de paradigme complet pour le debugging logique.”

Vidéos sur Claude 3.7 Sonnet

Regardez des tutoriels, critiques et discussions sur Claude 3.7 Sonnet

“Le nouveau model 3.7 a absolument écrasé tous les autres models... désormais capable de résoudre 70,3 % des problèmes GitHub”

“L'utilisation d'un langage fortement typé ainsi que le TDD sont des moyens pour l'IA de valider que le code qu'elle écrit est réellement valide”

“Le model est incroyablement intelligent pour suivre les instructions”

“Les performances sur SWE-bench sont tout simplement incroyables”

“Le reasoning visible change la donne pour la transparence”

“Claude 3.7 Sonnet... c'est probablement le meilleur LLM pour la génération de code”

“Si vous utilisez l'API, vous pouvez générer 128 000 tokens d'un coup”

“La limite de sortie de 128k est une mise à jour massive”

“Sa sensibilité au design pour les composants frontend est inégalée”

“L'utilisation d'outils et les capacités agentic sont au cœur de ce model”

“Le reasoning devrait être une capacité intégrée des frontier models plutôt qu'un model entièrement séparé”

“Claude 3.7 parvient à surpasser ces models [DeepSeek, o3] de manière assez significative”

“La latency est légèrement plus élevée en mode reasoning”

“Il bat DeepSeek R1 sur plusieurs tâches de suivi d'instructions”

“Anthropic s'est vraiment concentré sur des résultats prêts pour la production”

Optimisez votre flux de travail avec l'Automatisation IA

Automatio combine la puissance des agents IA, de l'automatisation web et des integrations intelligentes pour vous aider a accomplir plus en moins de temps.

Conseils Pro pour Claude 3.7 Sonnet

Conseils d'experts pour tirer le meilleur parti de Claude 3.7 Sonnet.

Budget de réflexion

Utilisez le mode 'extended thinking' spécifiquement pour la logique complexe ou la planification d'architecture afin d'obtenir des résultats de meilleure qualité.

Contrôle du contexte

Utilisez régulièrement /clear ou redémarrez les chats pour économiser sur les coûts de contexte et éviter que le model ne devienne lent.

Vérification

Demandez à Claude d'écrire et d'exécuter des tests pour son propre code en utilisant l'outil Claude Code pour garantir la stabilité en production.

Spécifications Markdown

Fournissez les exigences des fonctionnalités dans des fichiers Markdown structurés pour un meilleur suivi des instructions lors de projets d'envergure.

Témoignages

Ce Que Disent Nos Utilisateurs

Rejoignez des milliers d'utilisateurs satisfaits qui ont transforme leur flux de travail

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Associés AI Models

Grok-3

xAI

Grok-3 is xAI's flagship reasoning model, featuring deep logic deduction, a 128k context window, and real-time integration with X for live research and coding.

GLM-4.7

Zhipu (GLM)

GLM-4.7 by Zhipu AI is a flagship 358B MoE model featuring a 200K context window, elite 73.8% SWE-bench performance, and native Deep Thinking for agentic...

Claude Sonnet 4.5

Anthropic

Anthropic's Claude Sonnet 4.5 delivers world-leading coding (77.2% SWE-bench) and a 200K context window, optimized for the next generation of autonomous agents.

Claude Opus 4.5

Anthropic

Claude Opus 4.5 is Anthropic's most powerful frontier model, delivering record-breaking 80.9% SWE-bench performance and advanced autonomous agency for coding.

Grok-4

xAI

Grok-4 by xAI is a frontier model featuring a 2M token context window, real-time X platform integration, and world-record reasoning capabilities.

Kimi K2.5

Moonshot

Discover Moonshot AI's Kimi K2.5, a 1T-parameter open-source agentic model featuring native multimodal capabilities, a 262K context window, and SOTA reasoning.

GPT-5.1

OpenAI

GPT-5.1 is OpenAI’s advanced reasoning flagship featuring adaptive thinking, native multimodality, and state-of-the-art performance in math and technical...

Qwen3.5-397B-A17B

alibaba

Qwen3.5-397B-A17B is Alibaba's flagship open-weight MoE model. It features native multimodal reasoning, a 1M context window, and a 19x decoding throughput...

Questions Fréquentes sur Claude 3.7 Sonnet

Trouvez des réponses aux questions courantes sur Claude 3.7 Sonnet