Qwen3-Coder-Next

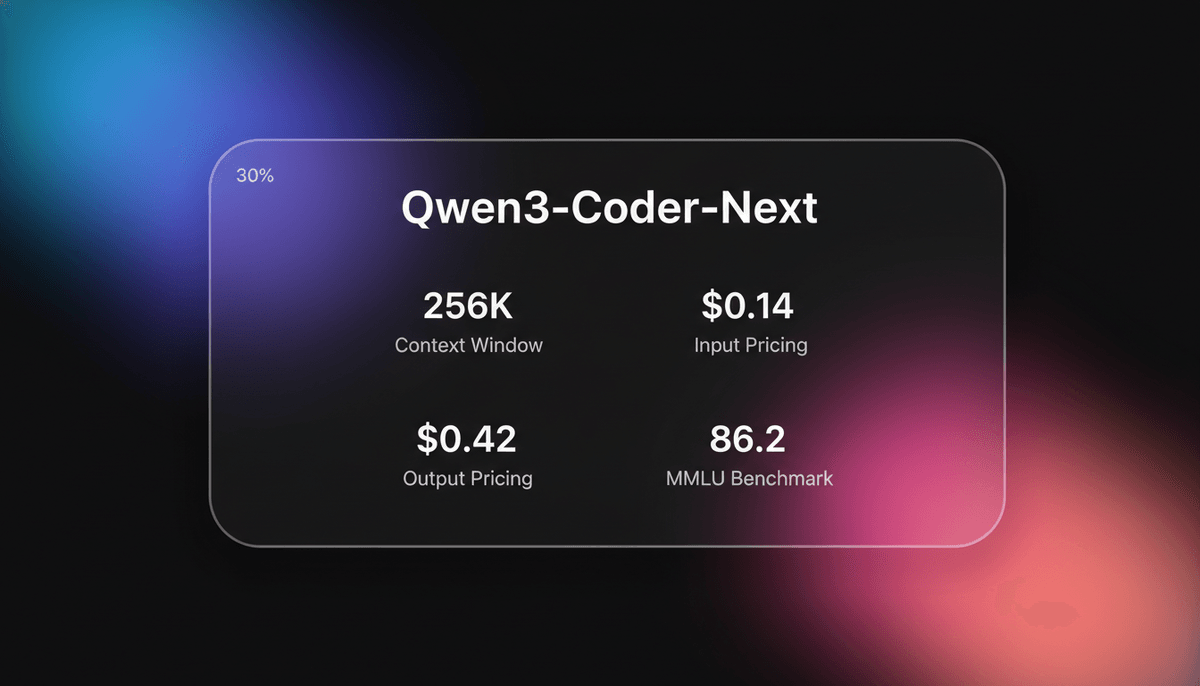

Qwen3-Coder-Next est le model de codage d'élite sous licence Apache 2.0 d'Alibaba Cloud, doté d'une architecture MoE de 80B et d'un context window de 256k pour...

À propos de Qwen3-Coder-Next

Découvrez les capacités, fonctionnalités et façons d'utiliser Qwen3-Coder-Next.

Aperçu du Model

Qwen3-Coder-Next est un model de langage open-weight de pointe conçu par l'équipe Qwen d'Alibaba Cloud, spécifiquement optimisé pour les agents de codage et les environnements de développement locaux. Basé sur l'architecture Qwen3-Next-80B-A3B-Base, il utilise une conception sophistiquée de Mixture-of-Experts (MoE) avec une attention hybride (Gated DeltaNet et Gated Attention). Cela permet au model de maintenir une base de connaissances massive de 80 milliards de parameters tout en n'activant que 3 milliards de parameters par token, ce qui se traduit par un reasoning de niveau flagship avec la vitesse d'inference et l'empreinte mémoire d'un model beaucoup plus petit.

Spécialisation Agentic

Le model représente une évolution vers la mise à l'échelle des signaux d'entraînement agentic plutôt que du simple nombre brut de parameters. Il a été entraîné sur plus de 800 000 tâches de codage vérifiables associées à des environnements exécutables, lui permettant d'apprendre directement des retours de l'environnement. Cette recette d'entraînement spécialisée met l'accent sur le reasoning à long terme, l'utilisation d'outils et la capacité à récupérer après des échecs d'exécution — des capacités cruciales pour les workflows modernes de "vibe coding" et les frameworks agentic autonomes comme OpenClaw.

Performance Locale

Avec un context window natif de 256K capable d'extrapolation supplémentaire, Qwen3-Coder-Next est positionné de manière unique comme l'assistant de codage local le plus puissant disponible. Publié sous la licence Apache 2.0, il permet aux développeurs de construire, déboguer et déployer des bases de code entières dans un environnement privé et sécurisé sans dépendre d'API cloud propriétaires.

Cas d'utilisation de Qwen3-Coder-Next

Découvrez les différentes façons d'utiliser Qwen3-Coder-Next pour obtenir d'excellents résultats.

Développement agentic local

Alimenter des agents de codage autonomes capables de planifier, d'exécuter et de déboguer des logiciels localement sans que les données sensibles ne quittent la machine.

Prototypage web complexe

Générer des applications full-stack fonctionnelles, incluant des visualisations 3D et des jeux interactifs, à partir de simples prompt en langage naturel.

Analyse de larges dépôts

Utiliser le context window de 256K pour ingérer et raisonner sur des structures de projets multi-fichiers complètes pour le refactoring et l'optimisation.

Audit de sécurité automatisé

Scanner les bases de code à la recherche de vulnérabilités complexes comme l'injection SQL et l'exposition d'identifiants en clair avec des suggestions de correction fondées.

Synthèse de recherche technique

Scraper et analyser des documentations académiques ou techniques denses pour produire des rapports HTML organisés et exploitables.

Migration de systèmes multi-langages

Traduire une logique métier complexe et des contraintes spécifiques au matériel entre différents langages de programmation avec une haute fidélité.

Points forts

Limitations

Démarrage rapide API

alibaba/qwen-3-coder-next

import OpenAI from 'openai';

const client = new OpenAI({

apiKey: process.env.DASHSCOPE_API_KEY,

baseURL: 'https://dashscope.aliyuncs.com/compatible-mode/v1'

});

async function main() {

const completion = await client.chat.completions.create({

model: 'qwen-3-coder-next',

messages: [{ role: 'user', content: 'Write a React hook for debouncing a value.' }],

});

console.log(completion.choices[0].message.content);

}

main();Installez le SDK et commencez à faire des appels API en quelques minutes.

Ce que les gens disent de Qwen3-Coder-Next

Voyez ce que la communauté pense de Qwen3-Coder-Next

“Ce model est incroyable pour le code et se compare favorablement à la concurrence”

“L'architecture permet une longueur de contexte massive sans faire exploser la RAM”

“Alibaba domine le secteur des modèles open-weights avec cette architecture MoE”

“Enfin un model local qui gère un contexte de 256k sans ramer”

“Je vois un décodage stable de ~7,8 tok/s sur CPU, ce qui est suffisant pour un code reviewer local”

“Qwen3 Coder est essentiellement l'aboutissement pour les configurations de développement locales.”

Vidéos sur Qwen3-Coder-Next

Regardez des tutoriels, critiques et discussions sur Qwen3-Coder-Next

“Nous avons également une longueur de contexte de 256k, ce qui est très robuste, surtout pour quelque chose qui peut être exécuté localement.”

“Nous avons notre résultat à une vitesse de 26,17 tokens par seconde... un résultat assez long.”

“C'est un model très excitant... il montre un potentiel extrême pour le codage agentic.”

“La précision sur les tâches Python est tout simplement stupéfiante pour un model open weight.”

“Je pense que ce model enterre officiellement le besoin d'assistants de codage payants pour la plupart des développeurs.”

“Il est construit sur un model de 3 milliards de parameters actifs pour un total de 80 milliards de parameters.”

“Ce n'est pas seulement un model d'IA de codage avec un context window de 200k... c'est absolument intuitif.”

“Pour les utilisateurs quotidiens, vous pouvez simplement lui demander de scraper une page web, d'analyser le contenu et de générer un rapport propre.”

“La façon dont il gère les projets multi-fichiers localement change la donne pour la confidentialité.”

“Le function calling semble beaucoup plus réactif par rapport à la version précédente.”

“Écrire des histoires à 62 tokens par seconde. Boum. C'était rapide.”

“On bombarde là... 150 tokens par seconde avec le batching... c'est incroyable.”

“Ce jeu de course automobile était en fait meilleur que la version sur Claude... il faut lui accorder ça.”

“L'architecture MoE brille vraiment quand on regarde l'efficacité token-par-watt.”

“La quantification ne semble pas nuire au reasoning autant que je m'y attendais.”

Optimisez votre flux de travail avec l'Automatisation IA

Automatio combine la puissance des agents IA, de l'automatisation web et des integrations intelligentes pour vous aider a accomplir plus en moins de temps.

Conseils Pro pour Qwen3-Coder-Next

Conseils d'experts pour tirer le meilleur parti de Qwen3-Coder-Next.

Optimisation de la bande passante matérielle

Pour l'échelle 80B, assurez-vous que votre système utilise une mémoire à haut débit (canaux multiples) pour éviter les goulots d'étranglement de l'inference sur les configurations uniquement CPU.

Débogage itératif

Réinjectez les propres erreurs d'exécution du model dans le prompt ; il est spécifiquement entraîné pour reconnaître les échecs d'exécution et affiner sa logique.

Prompting riche en contexte

Maximisez le context window de 256K en fournissant les fichiers de dépendances pertinents et les schémas d'architecture pour réduire les hallucinations.

Affinage esthétique

Lors de la génération d'UI, demandez explicitement des couleurs et des transitions CSS pour passer outre la tendance naturelle du model vers des mises en page minimalistes.

Témoignages

Ce Que Disent Nos Utilisateurs

Rejoignez des milliers d'utilisateurs satisfaits qui ont transforme leur flux de travail

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Associés AI Models

MiniMax M2.5

minimax

MiniMax M2.5 is a SOTA MoE model featuring a 1M context window and elite agentic coding capabilities at disruptive pricing for autonomous agents.

GLM-5

Zhipu (GLM)

GLM-5 is Zhipu AI's 744B parameter open-weight powerhouse, excelling in long-horizon agentic tasks, coding, and factual accuracy with a 200k context window.

GPT-5.4

OpenAI

GPT-5.4 is OpenAI's frontier model featuring a 1.05M context window and Extreme Reasoning. It excels at autonomous UI interaction and long-form data analysis.

Gemini 3.1 Flash-Lite

Gemini 3.1 Flash-Lite is Google's fastest, most cost-efficient model. Features 1M context, native multimodality, and 363 tokens/sec speed for scale.

GPT-5.3 Instant

OpenAI

Explore GPT-5.3 Instant, OpenAI's "Anti-Cringe" model. Features a 128K context window, 26.8% fewer hallucinations, and a natural, helpful tone for everyday...

Gemini 3.1 Pro

Gemini 3.1 Pro is Google's elite multimodal model featuring the DeepThink reasoning engine, a 1M+ context window, and industry-leading ARC-AGI logic scores.

Claude Sonnet 4.6

Anthropic

Claude Sonnet 4.6 offers frontier performance for coding and computer use with a massive 1M token context window for only $3/1M tokens.

Qwen3.5-397B-A17B

alibaba

Qwen3.5-397B-A17B is Alibaba's flagship open-weight MoE model. It features native multimodal reasoning, a 1M context window, and a 19x decoding throughput...

Questions Fréquentes sur Qwen3-Coder-Next

Trouvez des réponses aux questions courantes sur Qwen3-Coder-Next