A CoinCatapult scrapelése: A végső útmutató a kriptó adatokhoz

Ismerje meg, hogyan nyerhet ki projektneveket, szavazatszámokat, contract address adatokat és bevezetési dátumokat a CoinCatapult oldalról. Tökéletes DeFi...

Anti-bot védelem észlelve

- Cloudflare

- Vállalati szintű WAF és botkezelés. JavaScript kihívásokat, CAPTCHA-kat és viselkedéselemzést használ. Böngészőautomatizálás szükséges rejtett beállításokkal.

- Sebességkorlátozás

- IP/munkamenet alapú kéréseket korlátoz időben. Forgó proxykkal, kéréskésleltetéssel és elosztott scrapinggel megkerülhető.

- IP-blokkolás

- Ismert adatközponti IP-ket és megjelölt címeket blokkol. Lakossági vagy mobil proxyk szükségesek a hatékony megkerüléshez.

- JavaScript kihívás

- JavaScript végrehajtást igényel a tartalom eléréséhez. Egyszerű kérések sikertelenek; headless böngésző szükséges, mint a Playwright vagy Puppeteer.

A(z) CoinCatapult Névjegye

Fedezze fel, mit kínál a(z) CoinCatapult és milyen értékes adatok nyerhetők ki.

A DeFi felfedezésének indítópultja

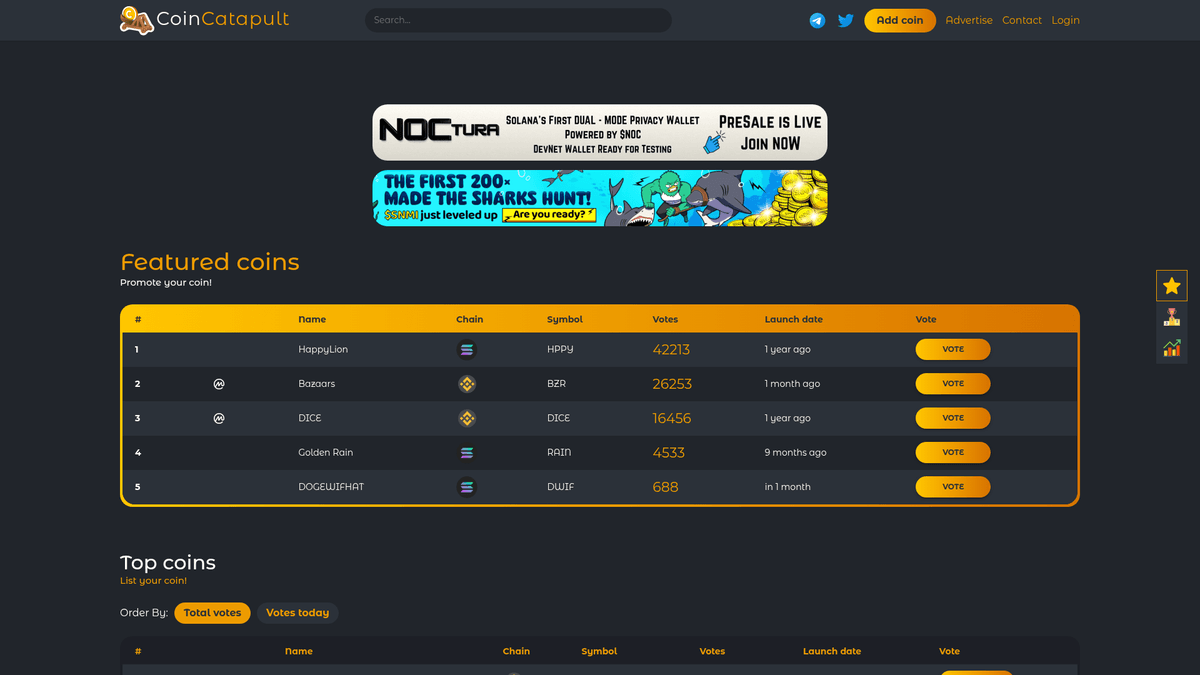

A CoinCatapult egy népszerű kriptovaluta-listázó és közösségi szavazóplatform, amely a korai szakaszban lévő DeFi projektekre összpontosít. Digitális csomópontként szolgál, ahol a fejlesztők új tokeneket listáznak a láthatóság növelése érdekében, míg a kereskedők a platformot használják a nagy potenciállal rendelkező „drágakövek” felfedezésére a közösségi szavazatok és népszerűségi rangsorok alapján.

Átfogó listázási adatok

A platform több ezer listázást tartalmaz különböző blockchain hálózatokon, beleértve a Solana, a Binance Smart Chain és az Ethereum hálózatokat. Minden bejegyzés kritikus metaadatokat tartalmaz, például a bevezetés állapotát, a valós idejű szavazatszámokat és a közösségi linkeket, így elsődleges forrás az új token-bevezetések dinamikájának nyomon követéséhez.

Miért fontosak az adatok?

A CoinCatapult scrapelése rendkívül értékes a kriptopiaci kutatók, marketingügynökségek és blockchain fejlesztők számára. Az adatok kinyerésével a felhasználók azonosíthatják a trendi réseket, monitorozhatják a különböző láncok versenyhelyzetét, és lead generálást végezhetnek biztonsági auditálási vagy marketing szolgáltatásokhoz az új projektulajdonosok számára.

Miért Kell Scrapelni a(z) CoinCatapult-t?

Fedezze fel a(z) CoinCatapult-ból történő adatkinyerés üzleti értékét és felhasználási eseteit.

Az új DeFi projektlisták valós idejű monitorozása korai befektetés céljából.

Lead generálás okos szerződés auditálási és biztonsági szolgáltatásokhoz.

Szenzimentelemzés a napi és összesített közösségi szavazatok dinamikája alapján.

Piackutatás a trendi blockchain hálózatok nyomon követésére.

Versenytárs-elemzés más kriptó listázó platformok számára.

Adataggregáció kriptó híroldalak és irányítópult eszközök számára.

Scraping Kihívások

Technikai kihívások, amelyekkel a(z) CoinCatapult scrapelésekor találkozhat.

A Cloudflare bot-elleni védelme kifinomult megkerülési technikákat igényel.

A szavazatszámok dinamikus frissítése JavaScript renderelést igényelhet.

Az agresszív rate limit bizonyos IP-tartományokon gyakran ideiglenes blokkoláshoz vezet.

Inkonzisztens táblázatszerkezetek a különböző kategóriaoldalakon.

Scrapeld a CoinCatapult-t AI-val

Nincs szükség kódolásra. Nyerj ki adatokat percek alatt AI-vezérelt automatizálással.

Hogyan működik

Írd le, mire van szükséged

Mondd el az AI-nak, milyen adatokat szeretnél kinyerni a CoinCatapult-ról. Csak írd be természetes nyelven — nincs szükség kódra vagy szelektorokra.

Az AI kinyeri az adatokat

Mesterséges intelligenciánk navigál a CoinCatapult-on, kezeli a dinamikus tartalmat, és pontosan azt nyeri ki, amit kértél.

Kapd meg az adataidat

Kapj tiszta, strukturált adatokat, amelyek készen állnak CSV, JSON exportra vagy közvetlenül az alkalmazásaidba küldésre.

Miért érdemes AI-t használni a scrapeléshez

Az AI megkönnyíti a CoinCatapult scrapelését kódírás nélkül. Mesterséges intelligenciával működő platformunk megérti, milyen adatokra van szükséged — csak írd le természetes nyelven, és az AI automatikusan kinyeri őket.

How to scrape with AI:

- Írd le, mire van szükséged: Mondd el az AI-nak, milyen adatokat szeretnél kinyerni a CoinCatapult-ról. Csak írd be természetes nyelven — nincs szükség kódra vagy szelektorokra.

- Az AI kinyeri az adatokat: Mesterséges intelligenciánk navigál a CoinCatapult-on, kezeli a dinamikus tartalmat, és pontosan azt nyeri ki, amit kértél.

- Kapd meg az adataidat: Kapj tiszta, strukturált adatokat, amelyek készen állnak CSV, JSON exportra vagy közvetlenül az alkalmazásaidba küldésre.

Why use AI for scraping:

- Automatikusan megkerüli a Cloudflare-t és más bot-felismerő rendszereket.

- A no-code felület lehetővé teszi a gyors adatkinyerést szkriptek írása nélkül.

- Az időzített futtatások lehetővé teszik az új projektbevezetések 24/7-es monitorozását.

- Közvetlen integráció a Google Sheets-szel az azonnali adatelemzéshez.

No-Code Web Scraperek a CoinCatapult számára

Kattints-és-válassz alternatívák az AI-alapú scrapeléshez

Számos no-code eszköz, mint a Browse.ai, Octoparse, Axiom és ParseHub segíthet a CoinCatapult scrapelésében kódírás nélkül. Ezek az eszközök általában vizuális felületeket használnak az adatok kiválasztásához, bár nehézségeik lehetnek összetett dinamikus tartalmakkal vagy anti-bot intézkedésekkel.

Tipikus Munkafolyamat No-Code Eszközökkel

Gyakori Kihívások

Tanulási görbe

A szelektorok és a kinyerési logika megértése időt igényel

Szelektorok elromlanak

A weboldal változásai tönkretehetik a teljes munkafolyamatot

Dinamikus tartalom problémák

JavaScript-gazdag oldalak komplex megoldásokat igényelnek

CAPTCHA korlátozások

A legtöbb eszköz manuális beavatkozást igényel CAPTCHA esetén

IP blokkolás

Az agresszív scraping az IP blokkolásához vezethet

No-Code Web Scraperek a CoinCatapult számára

Számos no-code eszköz, mint a Browse.ai, Octoparse, Axiom és ParseHub segíthet a CoinCatapult scrapelésében kódírás nélkül. Ezek az eszközök általában vizuális felületeket használnak az adatok kiválasztásához, bár nehézségeik lehetnek összetett dinamikus tartalmakkal vagy anti-bot intézkedésekkel.

Tipikus Munkafolyamat No-Code Eszközökkel

- Böngésző bővítmény telepítése vagy regisztráció a platformon

- Navigálás a célweboldalra és az eszköz megnyitása

- Adatelemek kiválasztása kattintással

- CSS szelektorok konfigurálása minden adatmezőhöz

- Lapozási szabályok beállítása több oldal scrapeléséhez

- CAPTCHA kezelése (gyakran manuális megoldás szükséges)

- Ütemezés konfigurálása automatikus futtatásokhoz

- Adatok exportálása CSV, JSON formátumba vagy API-n keresztüli csatlakozás

Gyakori Kihívások

- Tanulási görbe: A szelektorok és a kinyerési logika megértése időt igényel

- Szelektorok elromlanak: A weboldal változásai tönkretehetik a teljes munkafolyamatot

- Dinamikus tartalom problémák: JavaScript-gazdag oldalak komplex megoldásokat igényelnek

- CAPTCHA korlátozások: A legtöbb eszköz manuális beavatkozást igényel CAPTCHA esetén

- IP blokkolás: Az agresszív scraping az IP blokkolásához vezethet

Kod peldak

import requests

from bs4 import BeautifulSoup

# CoinCatapult requires a real browser User-Agent

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/91.0.4472.124 Safari/537.36'

}

url = 'https://coincatapult.com/'

try:

response = requests.get(url, headers=headers)

# Check for Cloudflare/Block status

response.raise_for_status()

soup = BeautifulSoup(response.text, 'html.parser')

# Select rows from the main listing table

rows = soup.select('table tbody tr')

for row in rows:

cols = row.find_all('td')

if len(cols) > 5:

name = cols[2].get_text(strip=True)

symbol = cols[4].get_text(strip=True)

votes = cols[5].get_text(strip=True)

print(f'Project: {name} | Symbol: {symbol} | Votes: {votes}')

except Exception as e:

print(f'An error occurred: {e}')Mikor Használjuk

A legjobb statikus HTML oldalakhoz, ahol a tartalom szerver oldalon töltődik. A leggyorsabb és legegyszerűbb megközelítés, amikor JavaScript renderelés nem szükséges.

Előnyök

- ●Leggyorsabb végrehajtás (nincs böngésző overhead)

- ●Legalacsonyabb erőforrás-fogyasztás

- ●Könnyen párhuzamosítható asyncio-val

- ●Kiváló API-khoz és statikus oldalakhoz

Korlátok

- ●Nem tudja végrehajtani a JavaScriptet

- ●Nem működik SPA-knál és dinamikus tartalmaknál

- ●Problémái lehetnek összetett anti-bot rendszerekkel

How to Scrape CoinCatapult with Code

Python + Requests

import requests

from bs4 import BeautifulSoup

# CoinCatapult requires a real browser User-Agent

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/91.0.4472.124 Safari/537.36'

}

url = 'https://coincatapult.com/'

try:

response = requests.get(url, headers=headers)

# Check for Cloudflare/Block status

response.raise_for_status()

soup = BeautifulSoup(response.text, 'html.parser')

# Select rows from the main listing table

rows = soup.select('table tbody tr')

for row in rows:

cols = row.find_all('td')

if len(cols) > 5:

name = cols[2].get_text(strip=True)

symbol = cols[4].get_text(strip=True)

votes = cols[5].get_text(strip=True)

print(f'Project: {name} | Symbol: {symbol} | Votes: {votes}')

except Exception as e:

print(f'An error occurred: {e}')Python + Playwright

from playwright.sync_api import sync_playwright

def scrape_coincatapult():

with sync_playwright() as p:

# Launching with a real browser head can help bypass basic checks

browser = p.chromium.launch(headless=True)

page = browser.new_page()

# Navigate to the site

page.goto('https://coincatapult.com/', wait_until='networkidle')

# Wait for the table to render

page.wait_for_selector('table')

# Extract data using Javascript evaluation

coins = page.evaluate("""() => {

const rows = Array.from(document.querySelectorAll('table tbody tr'));

return rows.map(row => {

const tds = row.querySelectorAll('td');

return {

name: tds[2]?.innerText.trim(),

chain: tds[3]?.querySelector('img')?.alt || 'Unknown',

votes: tds[5]?.innerText.trim()

};

});

}""")

for coin in coins:

print(coin)

browser.close()

if __name__ == '__main__':

scrape_coincatapult()Python + Scrapy

import scrapy

class CoinSpider(scrapy.Spider):

name = 'coincatapult_spider'

start_urls = ['https://coincatapult.com/']

def parse(self, response):

# Iterate through table rows using CSS selectors

for row in response.css('table tbody tr'):

yield {

'name': row.css('td:nth-child(3)::text').get(),

'symbol': row.css('td:nth-child(5)::text').get(),

'votes': row.css('td:nth-child(6)::text').get(),

'launch_date': row.css('td:nth-child(7)::text').get()

}

# Basic pagination handling if a 'Next' link exists

next_page = response.css('ul.pagination li.next a::attr(href)').get()

if next_page:

yield response.follow(next_page, self.parse)Node.js + Puppeteer

const puppeteer = require('puppeteer');

(async () => {

const browser = await puppeteer.launch({ headless: true });

const page = await browser.newPage();

// Set a realistic viewport

await page.setViewport({ width: 1280, height: 800 });

// Go to CoinCatapult

await page.goto('https://coincatapult.com/', { waitUntil: 'networkidle2' });

const data = await page.evaluate(() => {

const results = [];

const rows = document.querySelectorAll('table tbody tr');

rows.forEach(row => {

const cells = row.querySelectorAll('td');

if (cells.length >= 6) {

results.push({

name: cells[2].innerText.trim(),

chain: cells[3].querySelector('img')?.alt || 'N/A',

votes: cells[5].innerText.trim()

});

}

});

return results;

});

console.log(data);

await browser.close();

})();Mit Tehet a(z) CoinCatapult Adataival

Fedezze fel a(z) CoinCatapult adataiból származó gyakorlati alkalmazásokat és betekintéseket.

Valós idejű bálna riasztások

Automatizált rendszer, amely értesíti a kereskedőket, ha egy projekt rövid idő alatt hatalmas szavazati lendületet kap.

Hogyan implementáljuk:

- 1Scrapelje a 'Votes Today' oszlopot 30 percenként.

- 2Hasonlítsa össze az aktuális szavazatokat az előző scraping adataival.

- 3Állítson be riasztást, ha egy projekt szavazatszáma több mint 50%-kal nő egy órán belül.

Használja az Automatio-t adatok kinyeréséhez a CoinCatapult-ből és építse meg ezeket az alkalmazásokat kódírás nélkül.

Mit Tehet a(z) CoinCatapult Adataival

- Valós idejű bálna riasztások

Automatizált rendszer, amely értesíti a kereskedőket, ha egy projekt rövid idő alatt hatalmas szavazati lendületet kap.

- Scrapelje a 'Votes Today' oszlopot 30 percenként.

- Hasonlítsa össze az aktuális szavazatokat az előző scraping adataival.

- Állítson be riasztást, ha egy projekt szavazatszáma több mint 50%-kal nő egy órán belül.

- Kriptó marketing megkeresés

Azonosítsa az új DeFi projektulajdonosokat, akiknek professzionális marketingre vagy listázási szolgáltatásokra lehet szükségük.

- Nyerje ki naponta a Telegram és Twitter linkeket a 'New Coins' szekcióból.

- Kategorizálja a projekteket blockchain szerint (pl. SOL, ETH) a specifikus közösségek megcélzásához.

- Küldjön személyre szabott megkereséseket a projekt hivatalos közösségi csatornáira.

- Ökoszisztéma egészségügyi jelentések

Jelentések készítése arról, hogy mely blockchain hálózatok (Solana vs. BSC) vonzzák a legtöbb fejlesztőt.

- Scrapelje az összes projektlistát és a hozzájuk tartozó blockchain hálózatot.

- Számolja meg havonta az új bevezetések számát hálózatonként.

- Vizualizálja a növekedési trendeket annak azonosításához, hogy melyik ökoszisztéma dominálja a 'degen' piacot.

- Bevezetés előtti lead generálás

Találja meg a 'Presale' vagy 'Launch Date' státuszú projekteket okos szerződés auditálási szolgáltatások felajánlásához.

- Szűrje a scraping eredményeket olyan projektekre, ahol a 'Launch Date' a jövőben van.

- Nyerje ki a contract address adatot (ha szerepel) vagy a közösségi elérhetőségeket.

- Küldjön audit ajánlatokat a fejlesztőknek, mielőtt élesednének a mainnet hálózaton.

Turbozd fel a munkafolyamatodat AI automatizalasal

Az Automatio egyesiti az AI ugynokk, a web automatizalas es az okos integraciok erejet, hogy segitsen tobbet elerni kevesebb ido alatt.

Profi Tippek a(z) CoinCatapult Scrapeléséhez

Szakértői tanácsok a(z) CoinCatapult-ból történő sikeres adatkinyeréshez.

Használjon lakossági proxykat az adatközponti IP-k helyett a Cloudflare biztonsági rétegeinek megkerüléséhez.

Alkalmazzon véletlenszerű, 5 és 15 másodperc közötti várakozási időket a rate limit elkerülése érdekében.

A nagy adatmennyiség kezeléséhez gyűjtse külön a kategóriaspecifikus oldalakat (pl. Solana, BSC).

A magasabb sikerességi arány érdekében használjon headless böngészőt, például Playwright-ot vagy Puppeteer-t 'Stealth' pluginokkal.

A kinyert contract address adatokat tárolja adatbázisban az on-chain adatokkal való összevetéshez.

Figyelje a 'New Coins' szekciót 10-15 percenként, hogy azonnal értesüljön az új listázásokról.

Velemenyek

Mit mondanak a felhasznaloink

Csatlakozz tobb ezer elegedett felhasznalohoz, akik atalakitottak a munkafolyamatukat

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Kapcsolodo Web Scraping

How to Scrape Biluppgifter.se: Vehicle Data Extraction Guide

How to Scrape The AA (theaa.com): A Technical Guide for Car & Insurance Data

How to Scrape Bilregistret.ai: Swedish Vehicle Data Extraction Guide

How to Scrape CSS Author: A Comprehensive Web Scraping Guide

How to Scrape GoAbroad Study Abroad Programs

How to Scrape Car.info | Vehicle Data & Valuation Extraction Guide

How to Scrape ResearchGate: Publication and Researcher Data

How to Scrape Statista: The Ultimate Guide to Market Data Extraction

Gyakran ismetelt kerdesek a CoinCatapult-rol

Talalj valaszokat a CoinCatapult-val kapcsolatos gyakori kerdesekre