Hogyan gyűjtsünk adatokat a Signal NFX-ről | Befektetői és VC adatbázis scraping útmutató

Ismerje meg, hogyan gyűjthet befektetői profilokat, VC cégadatokat és lead listákat a Signal NFX-ről. Fedezze fel a technikai stratégiákat tőkebevonáshoz és...

Anti-bot védelem észlelve

- Cloudflare

- Vállalati szintű WAF és botkezelés. JavaScript kihívásokat, CAPTCHA-kat és viselkedéselemzést használ. Böngészőautomatizálás szükséges rejtett beállításokkal.

- Sebességkorlátozás

- IP/munkamenet alapú kéréseket korlátoz időben. Forgó proxykkal, kéréskésleltetéssel és elosztott scrapinggel megkerülhető.

- IP-blokkolás

- Ismert adatközponti IP-ket és megjelölt címeket blokkol. Lakossági vagy mobil proxyk szükségesek a hatékony megkerüléshez.

- Login Wall

- Google reCAPTCHA

- A Google CAPTCHA rendszere. v2 felhasználói interakciót igényel, v3 csendesen fut kockázatértékeléssel. CAPTCHA szolgáltatásokkal megoldható.

A(z) Signal (by NFX) Névjegye

Fedezze fel, mit kínál a(z) Signal (by NFX) és milyen értékes adatok nyerhetők ki.

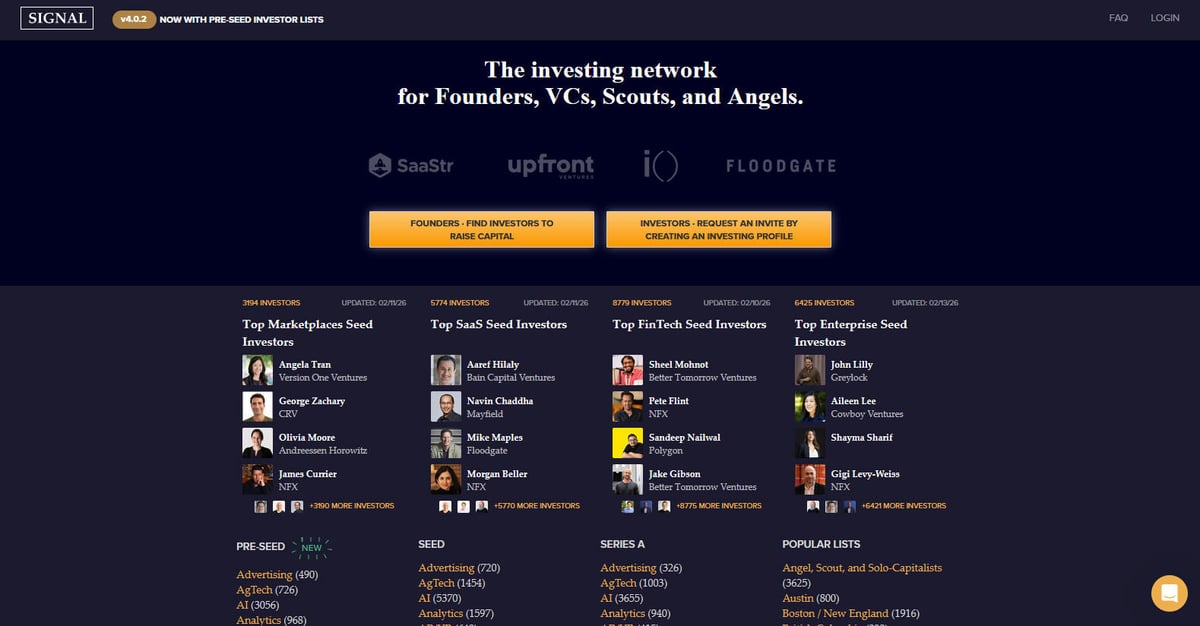

A Signal egy hatékony befektetői hálózat, amelyet kifejezetten alapítók, VC-k, scoutok és angyalbefektetők számára terveztek. Az NFX, egy neves seed-fázisú kockázati tőke társaság hozta létre és tartja karban. A platform hatalmas címtárként és hálózati eszközként szolgál a startup tőkebevonás megkönnyítésére. Célja, hogy átláthatóbbá tegye a venture ökoszisztémát a befektetők és vállalkozók közötti kapcsolatok feltérképezésével, hatékonyan váltva fel a manuális táblázatokat egy dinamikus, adatokban gazdag környezettel.

A platform több ezer befektetői profilt tartalmaz, kategóriákba sorolva az előnyben részesített befektetési szakasz (a Pre-Seed-től a Series B-ig), iparági szektorok (például AI, SaaS és FinTech) és földrajzi régiók szerint. A felhasználók részletes információkat találhatnak a kockázati tőke társaságokról, az egyéni partnerekről és azok specifikus befektetési fókuszáról, amelyeket gyakran frissítenek a piaci helyzetnek megfelelően. Minden bejegyzés jellemzően tartalmazza a befektető fókuszát, preferált szakaszait, befektetési téziseit és az alapítói bemutatkozásra vonatkozó preferenciákat.

A Signal adatainak gyűjtése rendkívül értékes azon alapítók számára, akiknek célzott befektetői listákat kell építeniük anélkül, hogy manuálisan böngésznének át több ezer bejegyzést. Kritikus adatokat szolgáltat a piaci kutatóknak a VC trendek követéséhez, versenyelőnyt nyújt más VC cégeknek, és értékes információkkal szolgál a startup ökoszisztémát célzó sales csapatok számára a kapcsolati hálók feltérképezése révén.

Miért Kell Scrapelni a(z) Signal (by NFX)-t?

Fedezze fel a(z) Signal (by NFX)-ból történő adatkinyerés üzleti értékét és felhasználási eseteit.

Célzott tőkebevonás

Készítsen precíz listákat azokról a befektetőkről, akik az Ön iparágában vezetnek seed vagy pre-seed köröket.

Piackutatás

Elemezze, mely szektorok kapják a legnagyobb figyelmet az olyan élvonalbeli VC-ktől, mint az Andreessen Horowitz vagy a Greylock.

Lead generálás

Azonosítsa az új VC cégeket és egyéni befektetőket, akik specifikus földrajzi piacokra, például Latin-Amerikába vagy Délkelet-Ázsiába lépnek be.

Versenytárs-figyelés

Kövesse nyomon a konkurens venture cégek portfólióját és fókuszterületeit terjeszkedési stratégiájuk megértéséhez.

Adataggregáció

Hozzon létre egy átfogó belső adatbázist a kockázati tőke ökoszisztémáról akadémiai vagy üzleti elemzésekhez.

Kapcsolati térképezés

Nyerjen ki kapcsolati adatokat, hogy megtalálja a legkönnyebb utat a neves VC-khez való bemutatkozáshoz.

Scraping Kihívások

Technikai kihívások, amelyekkel a(z) Signal (by NFX) scrapelésekor találkozhat.

Bejelentkezési kötelezettség

A legtöbb részletes befektetői információ bejelentkezés mögé van rejtve, ami munkamenet-kezelést vagy automatizált hitelesítést igényel.

JavaScript renderelés

Az oldal dinamikus betöltést használ a befektetői listákhoz (Infinite Scroll), amihez böngészőalapú scraper szükséges a JS futtatásához.

Bot-ellenes intézkedések

A Cloudflare WAF használata és a specifikus API végpontok az adatlekéréshez azt jelentik, hogy a standard kérések blokkolva lehetnek megfelelő headerek nélkül.

Sebességkorlátozások (Rate Limits)

A nagy frekvenciájú scraping IP-tiltást vagy CAPTCHA-t válthat ki a hálózat professzionális és biztonságos jellege miatt.

Összetett DOM struktúra

Az oldal dinamikus elemeket és egyedi frontend komponenseket használ, ami stabil szelektorokat igényel a megbízható adatkinyeréshez.

Scrapeld a Signal (by NFX)-t AI-val

Nincs szükség kódolásra. Nyerj ki adatokat percek alatt AI-vezérelt automatizálással.

Hogyan működik

Írd le, mire van szükséged

Mondd el az AI-nak, milyen adatokat szeretnél kinyerni a Signal (by NFX)-ról. Csak írd be természetes nyelven — nincs szükség kódra vagy szelektorokra.

Az AI kinyeri az adatokat

Mesterséges intelligenciánk navigál a Signal (by NFX)-on, kezeli a dinamikus tartalmat, és pontosan azt nyeri ki, amit kértél.

Kapd meg az adataidat

Kapj tiszta, strukturált adatokat, amelyek készen állnak CSV, JSON exportra vagy közvetlenül az alkalmazásaidba küldésre.

Miért érdemes AI-t használni a scrapeléshez

Az AI megkönnyíti a Signal (by NFX) scrapelését kódírás nélkül. Mesterséges intelligenciával működő platformunk megérti, milyen adatokra van szükséged — csak írd le természetes nyelven, és az AI automatikusan kinyeri őket.

How to scrape with AI:

- Írd le, mire van szükséged: Mondd el az AI-nak, milyen adatokat szeretnél kinyerni a Signal (by NFX)-ról. Csak írd be természetes nyelven — nincs szükség kódra vagy szelektorokra.

- Az AI kinyeri az adatokat: Mesterséges intelligenciánk navigál a Signal (by NFX)-on, kezeli a dinamikus tartalmat, és pontosan azt nyeri ki, amit kértél.

- Kapd meg az adataidat: Kapj tiszta, strukturált adatokat, amelyek készen állnak CSV, JSON exportra vagy közvetlenül az alkalmazásaidba küldésre.

Why use AI for scraping:

- No-code beállítás: Építsen Signal scrapert vizuálisan, anélkül, hogy bonyolult szkripteket írna a hitelesítéshez vagy a JS rendereléshez.

- Automatizált bejelentkezés: Könnyen kezelheti a Signal bejelentkezési folyamatát az Automatio munkafolyamaton belül a zárt profilok eléréséhez.

- Dinamikus tartalomkezelés: Automatikusan vár és kinyeri az adatokat a dinamikus listákból és az infinite scroll elemekből.

- Ütemezett frissítések: Állítsa be a scrapert heti futtatásra, hogy manuális beavatkozás nélkül megtalálja az újonnan hozzáadott befektetőket vagy frissített szektorlistákat.

- Adat-export: Közvetlen integráció a befektetői lead-ek Google Sheets-be, CSV-be vagy Webhook-on keresztül történő exportálásához az azonnali kapcsolattartás érdekében.

No-Code Web Scraperek a Signal (by NFX) számára

Kattints-és-válassz alternatívák az AI-alapú scrapeléshez

Számos no-code eszköz, mint a Browse.ai, Octoparse, Axiom és ParseHub segíthet a Signal (by NFX) scrapelésében kódírás nélkül. Ezek az eszközök általában vizuális felületeket használnak az adatok kiválasztásához, bár nehézségeik lehetnek összetett dinamikus tartalmakkal vagy anti-bot intézkedésekkel.

Tipikus Munkafolyamat No-Code Eszközökkel

Gyakori Kihívások

Tanulási görbe

A szelektorok és a kinyerési logika megértése időt igényel

Szelektorok elromlanak

A weboldal változásai tönkretehetik a teljes munkafolyamatot

Dinamikus tartalom problémák

JavaScript-gazdag oldalak komplex megoldásokat igényelnek

CAPTCHA korlátozások

A legtöbb eszköz manuális beavatkozást igényel CAPTCHA esetén

IP blokkolás

Az agresszív scraping az IP blokkolásához vezethet

No-Code Web Scraperek a Signal (by NFX) számára

Számos no-code eszköz, mint a Browse.ai, Octoparse, Axiom és ParseHub segíthet a Signal (by NFX) scrapelésében kódírás nélkül. Ezek az eszközök általában vizuális felületeket használnak az adatok kiválasztásához, bár nehézségeik lehetnek összetett dinamikus tartalmakkal vagy anti-bot intézkedésekkel.

Tipikus Munkafolyamat No-Code Eszközökkel

- Böngésző bővítmény telepítése vagy regisztráció a platformon

- Navigálás a célweboldalra és az eszköz megnyitása

- Adatelemek kiválasztása kattintással

- CSS szelektorok konfigurálása minden adatmezőhöz

- Lapozási szabályok beállítása több oldal scrapeléséhez

- CAPTCHA kezelése (gyakran manuális megoldás szükséges)

- Ütemezés konfigurálása automatikus futtatásokhoz

- Adatok exportálása CSV, JSON formátumba vagy API-n keresztüli csatlakozás

Gyakori Kihívások

- Tanulási görbe: A szelektorok és a kinyerési logika megértése időt igényel

- Szelektorok elromlanak: A weboldal változásai tönkretehetik a teljes munkafolyamatot

- Dinamikus tartalom problémák: JavaScript-gazdag oldalak komplex megoldásokat igényelnek

- CAPTCHA korlátozások: A legtöbb eszköz manuális beavatkozást igényel CAPTCHA esetén

- IP blokkolás: Az agresszív scraping az IP blokkolásához vezethet

Kod peldak

import requests

from bs4 import BeautifulSoup

# A Signal bejelentkezést igényel a teljes adathozzáféréshez. Ez a példa session-t használ.

session = requests.Session()

url = 'https://signal.nfx.com/investor-lists/top-marketplaces-seed-investors'

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/91.0.4472.124 Safari/537.36'

}

try:

# Valós környezetben itt kellene először POST-olni a bejelentkezési adatokat

# session.post('https://signal.nfx.com/login', data={'email': '...', 'password': '...'})

response = session.get(url, headers=headers)

response.raise_for_status()

soup = BeautifulSoup(response.text, 'html.parser')

# Befektetői kártyák keresése a listában

investors = soup.select('.investor-card')

for investor in investors:

name = investor.select_one('.name').get_text(strip=True)

firm = investor.select_one('.firm-name').get_text(strip=True)

print(f'Befektető: {name} | Cég: {firm}')

except Exception as e:

print(f'Hiba a Signal scraping során: {e}')Mikor Használjuk

A legjobb statikus HTML oldalakhoz, ahol a tartalom szerver oldalon töltődik. A leggyorsabb és legegyszerűbb megközelítés, amikor JavaScript renderelés nem szükséges.

Előnyök

- ●Leggyorsabb végrehajtás (nincs böngésző overhead)

- ●Legalacsonyabb erőforrás-fogyasztás

- ●Könnyen párhuzamosítható asyncio-val

- ●Kiváló API-khoz és statikus oldalakhoz

Korlátok

- ●Nem tudja végrehajtani a JavaScriptet

- ●Nem működik SPA-knál és dinamikus tartalmaknál

- ●Problémái lehetnek összetett anti-bot rendszerekkel

How to Scrape Signal (by NFX) with Code

Python + Requests

import requests

from bs4 import BeautifulSoup

# A Signal bejelentkezést igényel a teljes adathozzáféréshez. Ez a példa session-t használ.

session = requests.Session()

url = 'https://signal.nfx.com/investor-lists/top-marketplaces-seed-investors'

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/91.0.4472.124 Safari/537.36'

}

try:

# Valós környezetben itt kellene először POST-olni a bejelentkezési adatokat

# session.post('https://signal.nfx.com/login', data={'email': '...', 'password': '...'})

response = session.get(url, headers=headers)

response.raise_for_status()

soup = BeautifulSoup(response.text, 'html.parser')

# Befektetői kártyák keresése a listában

investors = soup.select('.investor-card')

for investor in investors:

name = investor.select_one('.name').get_text(strip=True)

firm = investor.select_one('.firm-name').get_text(strip=True)

print(f'Befektető: {name} | Cég: {firm}')

except Exception as e:

print(f'Hiba a Signal scraping során: {e}')Python + Playwright

from playwright.sync_api import sync_playwright

def scrape_signal():

with sync_playwright() as p:

browser = p.chromium.launch(headless=True)

page = browser.new_page()

# Navigáció a bejelentkezéshez

page.goto('https://signal.nfx.com/login')

page.fill('input[name="email"]', 'sajat_email@example.com')

page.fill('input[name="password"]', 'sajat_jelszo')

page.click('button:has-text("Log In")')

# Várakozás a lista oldal betöltésére bejelentkezés után

page.wait_for_url('**/investors')

page.goto('https://signal.nfx.com/investor-lists/top-ai-seed-investors')

page.wait_for_selector('.investor-card')

# Görgetés az infinite content betöltéséhez

for _ in range(5):

page.mouse.wheel(0, 4000)

page.wait_for_timeout(2000)

investors = page.query_selector_all('.investor-card')

for investor in investors:

name = investor.query_selector('.name').inner_text()

print(f'Talált befektető: {name}')

browser.close()

scrape_signal()Python + Scrapy

import scrapy

class SignalSpider(scrapy.Spider):

name = 'signal_spider'

# Megjegyzés: JavaScript rendereléshez scrapy-playwright szükséges

start_urls = ['https://signal.nfx.com/investor-lists/top-saas-seed-investors']

def start_requests(self):

for url in self.start_urls:

yield scrapy.Request(url, meta={'playwright': True})

def parse(self, response):

for investor in response.css('.investor-card'):

yield {

'name': investor.css('.name::text').get(),

'firm': investor.css('.firm-name::text').get(),

'link': response.urljoin(investor.css('a::attr(href)').get())

}

# Az infinite scroll kezeléséhez egyedi Playwright handler szükséges

# a görgetéshez, mielőtt a válasz visszakerülne a parse függvényhezNode.js + Puppeteer

const puppeteer = require('puppeteer');

(async () => {

const browser = await puppeteer.launch({ headless: true });

const page = await browser.newPage();

await page.setUserAgent('Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/91.0.4472.124 Safari/537.36');

// Először a bejelentkezés kezelése

await page.goto('https://signal.nfx.com/login');

await page.type('#user_email', 'sajat_email@valami.hu');

await page.type('#user_password', 'sajat_jelszo');

await page.click('.btn-primary');

await page.waitForNavigation();

await page.goto('https://signal.nfx.com/investor-lists/top-fintech-seed-investors');

await page.waitForSelector('.investor-card');

const investors = await page.evaluate(() => {

const items = Array.from(document.querySelectorAll('.investor-card'));

return items.map(item => ({

name: item.querySelector('.name')?.innerText.trim(),

firm: item.querySelector('.firm-name')?.innerText.trim()

}));

});

console.log(investors);

await browser.close();

})();Mit Tehet a(z) Signal (by NFX) Adataival

Fedezze fel a(z) Signal (by NFX) adataiból származó gyakorlati alkalmazásokat és betekintéseket.

Tőkebevonási megkeresések automatizálása

Az alapítók felhasználhatják az adatokat azon befektetők azonosítására és priorizálására, akik a legnagyobb valószínűséggel fektetnek be az adott fázisban és szektorban.

Hogyan implementáljuk:

- 1Gyűjtse ki az iparágában tevékenykedő befektetők listáját (pl. 'Top AI Seed Investors').

- 2Szűrje az eredményeket az 'Utoljára frissítve' (Last Updated) alapján az aktív befektetők megtalálásához.

- 3Exportálja az adatokat olyan CRM-be, mint a HubSpot vagy a Pipedrive a megkeresések követéséhez.

- 4Használja a profil linkeket a közös ismerősök azonosításához a személyes bemutatkozásokhoz.

Használja az Automatio-t adatok kinyeréséhez a Signal (by NFX)-ből és építse meg ezeket az alkalmazásokat kódírás nélkül.

Mit Tehet a(z) Signal (by NFX) Adataival

- Tőkebevonási megkeresések automatizálása

Az alapítók felhasználhatják az adatokat azon befektetők azonosítására és priorizálására, akik a legnagyobb valószínűséggel fektetnek be az adott fázisban és szektorban.

- Gyűjtse ki az iparágában tevékenykedő befektetők listáját (pl. 'Top AI Seed Investors').

- Szűrje az eredményeket az 'Utoljára frissítve' (Last Updated) alapján az aktív befektetők megtalálásához.

- Exportálja az adatokat olyan CRM-be, mint a HubSpot vagy a Pipedrive a megkeresések követéséhez.

- Használja a profil linkeket a közös ismerősök azonosításához a személyes bemutatkozásokhoz.

- VC piaci versenyelemzés

A kockázati tőke társaságok figyelemmel kísérhetik más cégek fókuszterületeit és csapatbővítéseit, hogy versenyképesek maradjanak az ökoszisztémában.

- Rendszeresen gyűjtse a Signal 'Firms' (Cégek) szekciójának adatait a változások követéséhez.

- Azonosítsa, mely cégek vesznek fel új 'Scout'-okat vagy 'Angyalokat' a hálózatukba.

- Kövesse nyomon a befektetési fókusz eltolódásait a szektorlisták számának változása alapján.

- Földrajzi terjeszkedési stratégia

Az új piacokra belépni kívánó vállalatok vagy befektetők azonosíthatják az adott régiók kulcsfontosságú pénzügyi szereplőit.

- Gyűjtse ki a régió-specifikus listákat, mint például 'LatAm', 'Israel' vagy 'MENA'.

- Kategorizálja a befektetőket cégtípus szerint (VC vs Angyal) a tőkeösszetétel megértéséhez.

- Térképezze fel a helyi finanszírozási környezetet a potenciális lead befektetők azonosításához a piacra lépéskor.

- Kapcsolati háló és bemutatkozás térképezés

Elemezze a társadalmi kapcsolatokat, hogy megtalálja a legkönnyebb utat a neves VC-khez való személyes bemutatkozáshoz.

- Nyerje ki a közös kapcsolati adatokat és a social graph információkat a befektetői profilokból.

- Vesse össze a kinyert kapcsolatokat a saját LinkedIn hálózatával.

- Priorizálja a megkereséseket a meglévő hálózati csomópontok erőssége alapján.

- Piackutatás feltörekvő szektorokról

Elemezze, mely új iparágak sűrűsége nő a leggyorsabban a venture gráfban a következő trendek megjóslásához.

- Gyűjtse ki a specifikus szektor tageket és azok gyakoriságát a különböző finanszírozási szakaszokban.

- Számítsa ki a befektetői érdeklődés növekedését specifikus kategóriákban negyedéves bontásban.

- Készítsen jelentéseket az érdekelt felek számára arról, hogy merre áramlik jelenleg az 'okos pénz'.

Turbozd fel a munkafolyamatodat AI automatizalasal

Az Automatio egyesiti az AI ugynokk, a web automatizalas es az okos integraciok erejet, hogy segitsen tobbet elerni kevesebb ido alatt.

Profi Tippek a(z) Signal (by NFX) Scrapeléséhez

Szakértői tanácsok a(z) Signal (by NFX)-ból történő sikeres adatkinyeréshez.

Munkamenet-kezelés

Mivel a teljes profilok eléréséhez bejelentkezés szükséges, mentse el és használja újra a sütiket (cookies), hogy elkerülje az ismételt bejelentkezési kísérleteket, amelyek biztonsági riasztásokat válthatnak ki.

Proxy választás

Használjon kiváló minőségű lakossági proxykat. Az adatközponti IP-címeket a Cloudflare bot-védelme gyakran jelöli meg a professzionális hálózatokon.

Robots.txt tiszteletben tartása

Ellenőrizze a Signal robots.txt fájlját, hogy lássa, mely útvonalak korlátozottak, és állítson be ésszerű crawl delay-t a korlátozások elkerülése érdekében.

Emberi viselkedés szimulálása

Adjon véletlenszerű, 2-5 másodperces késleltetéseket az oldalak betöltése közé, és szimuláljon egérmozgást vagy görgetést az észrevétlenség érdekében.

Adatgyűjtés csúcsidőn kívül

A nagyszabású scraping folyamatokat alacsony forgalmú időszakokban, például hétvégén végezze, hogy csökkentse a szerverterhelést és a detektálás valószínűségét.

Szelektorok stabilitása

Keressen stabil ID mintákat vagy data attribútumokat (data-testid), ha elérhetőek, mivel a Signal belső class nevei változhatnak a frissítések során.

Velemenyek

Mit mondanak a felhasznaloink

Csatlakozz tobb ezer elegedett felhasznalohoz, akik atalakitottak a munkafolyamatukat

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Kapcsolodo Web Scraping

How to Scrape Bilregistret.ai: Swedish Vehicle Data Extraction Guide

How to Scrape Biluppgifter.se: Vehicle Data Extraction Guide

How to Scrape CSS Author: A Comprehensive Web Scraping Guide

How to Scrape The AA (theaa.com): A Technical Guide for Car & Insurance Data

How to Scrape GoAbroad Study Abroad Programs

How to Scrape Car.info | Vehicle Data & Valuation Extraction Guide

How to Scrape ResearchGate: Publication and Researcher Data

How to Scrape Statista: The Ultimate Guide to Market Data Extraction

Gyakran ismetelt kerdesek a Signal (by NFX)-rol

Talalj valaszokat a Signal (by NFX)-val kapcsolatos gyakori kerdesekre