Cara Scrape jup.ag: Panduan Web Scraper DEX Jupiter

Pelajari cara scrape jup.ag untuk harga token Solana real-time, rute swap, dan volume pasar. Temukan API resmi Jupiter dan cara melewati anti-bot Cloudflare.

Perlindungan Anti-Bot Terdeteksi

- Cloudflare

- WAF dan manajemen bot tingkat enterprise. Menggunakan tantangan JavaScript, CAPTCHA, dan analisis perilaku. Memerlukan otomatisasi browser dengan pengaturan stealth.

- Pembatasan kecepatan

- Membatasi permintaan per IP/sesi dari waktu ke waktu. Dapat dilewati dengan proxy berputar, penundaan permintaan, dan scraping terdistribusi.

- Sidik jari browser

- Mengidentifikasi bot melalui karakteristik browser: canvas, WebGL, font, plugin. Memerlukan spoofing atau profil browser asli.

- Sidik jari browser

- Mengidentifikasi bot melalui karakteristik browser: canvas, WebGL, font, plugin. Memerlukan spoofing atau profil browser asli.

Tentang Jupiter

Temukan apa yang ditawarkan Jupiter dan data berharga apa yang dapat diekstrak.

Pusat DeFi Solana

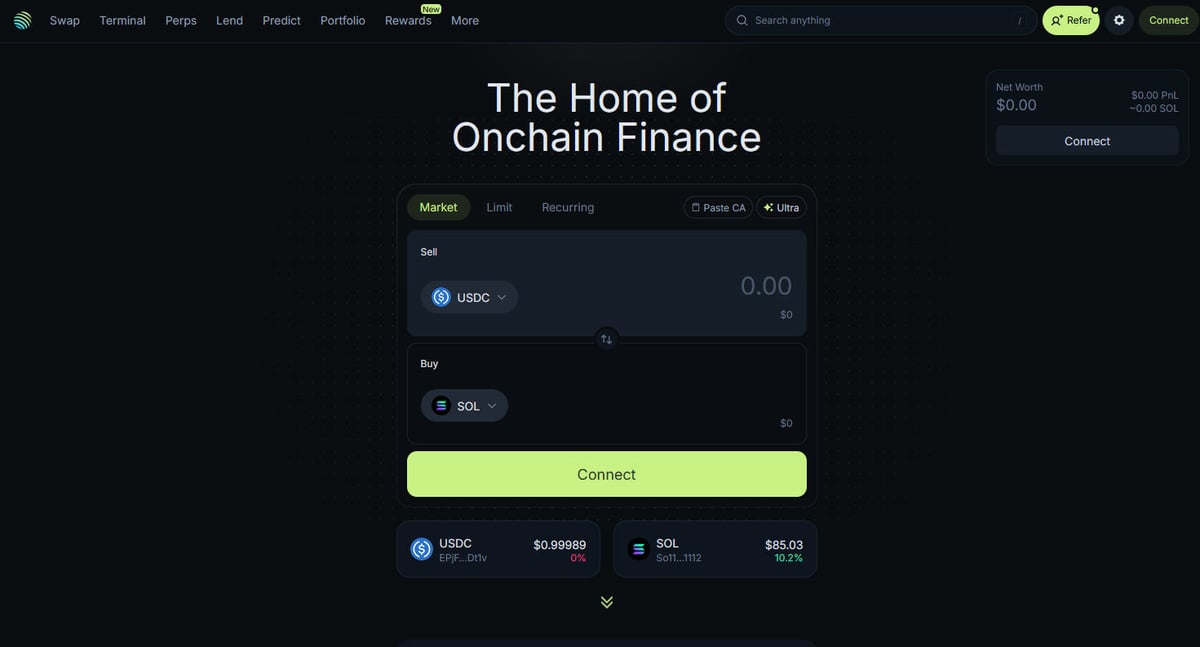

Jupiter adalah aggregator likuiditas utama untuk blockchain Solana, yang bertindak sebagai "DeFi Superapp" yang mengoptimalkan rute perdagangan di ratusan liquidity pool untuk memberikan harga terbaik dan slippage minimal kepada pengguna. Ini adalah pusat keuangan on-chain Solana, yang menawarkan layanan mulai dari token swap sederhana hingga fitur canggih seperti perpetual trading dengan leverage hingga 250x, limit orders, dan dollar-cost averaging (DCA). Platform ini menyediakan data kritis bagi ekosistem, termasuk harga real-time, kedalaman likuiditas, dan metrik pasar komprehensif untuk ribuan aset.

Arsitektur Teknis

Situs web ini dibangun di atas tumpukan teknis modern menggunakan Next.js dan React, menjadikannya aplikasi satu halaman (SPA) yang sangat dinamis. Karena harga dan rute dihitung secara real-time berdasarkan status blockchain saat ini, frontend terus diperbarui melalui WebSockets dan panggilan API frekuensi tinggi. Bagi ilmuwan data, developer, dan trader, data Jupiter dianggap sebagai standar emas untuk melacak sentimen pasar Solana dan pergeseran likuiditas di seluruh ekosistem.

Mengapa Data Ini Penting

Mengakses data ini sangat penting untuk membangun bot trading, dasbor pasar, dan melakukan analisis historis pada salah satu jaringan blockchain dengan pertumbuhan tercepat. Scraper sering menargetkan Jupiter untuk memantau listing token baru, melacak pergerakan "whale" di pasar perpetual, atau mengidentifikasi perbedaan harga untuk arbitrase. Meskipun platform ini menawarkan API resmi, scraping web langsung sering digunakan untuk menangkap status UI yang tepat dan data perutean spesifik yang mungkin tidak sepenuhnya diekspos di endpoint publik.

Mengapa Melakukan Scraping Jupiter?

Temukan nilai bisnis dan kasus penggunaan untuk ekstraksi data dari Jupiter.

Pemantauan harga real-time untuk token Solana

Mengembangkan bot trading arbitrase antar DEX

Melacak volume pasar dan tren likuiditas

Mengidentifikasi listing token baru dan sentimen pasar

Mengagregasi yield pinjaman dan perpetual funding rates

Menganalisis dampak harga historis untuk perdagangan besar

Tantangan Scraping

Tantangan teknis yang mungkin Anda hadapi saat melakukan scraping Jupiter.

Perlindungan anti-bot Cloudflare yang agresif

Kebutuhan untuk perenderan JavaScript penuh (React/Next.js)

Rate limiting berbasis IP yang agresif pada endpoint publik

Selektor CSS yang dinamis dan dikaburkan (obfuscated) di UI

Pembaruan data berkecepatan tinggi yang membutuhkan koneksi dengan latency rendah

Scrape Jupiter dengan AI

Tanpa koding. Ekstrak data dalam hitungan menit dengan otomatisasi berbasis AI.

Cara Kerjanya

Jelaskan apa yang Anda butuhkan

Beritahu AI data apa yang ingin Anda ekstrak dari Jupiter. Cukup ketik dalam bahasa sehari-hari — tanpa kode atau selektor.

AI mengekstrak data

Kecerdasan buatan kami menjelajahi Jupiter, menangani konten dinamis, dan mengekstrak persis apa yang Anda minta.

Dapatkan data Anda

Terima data bersih dan terstruktur siap diekspor sebagai CSV, JSON, atau dikirim langsung ke aplikasi Anda.

Mengapa menggunakan AI untuk scraping

AI memudahkan scraping Jupiter tanpa menulis kode. Platform berbasis kecerdasan buatan kami memahami data apa yang Anda inginkan — cukup jelaskan dalam bahasa sehari-hari dan AI akan mengekstraknya secara otomatis.

How to scrape with AI:

- Jelaskan apa yang Anda butuhkan: Beritahu AI data apa yang ingin Anda ekstrak dari Jupiter. Cukup ketik dalam bahasa sehari-hari — tanpa kode atau selektor.

- AI mengekstrak data: Kecerdasan buatan kami menjelajahi Jupiter, menangani konten dinamis, dan mengekstrak persis apa yang Anda minta.

- Dapatkan data Anda: Terima data bersih dan terstruktur siap diekspor sebagai CSV, JSON, atau dikirim langsung ke aplikasi Anda.

Why use AI for scraping:

- Ekstraksi data tanpa kode dari SPA dinamis

- Penanganan otomatis Cloudflare dan browser fingerprints

- Ekstraksi terjadwal untuk pemantauan pasar berkelanjutan

- Ekspor data langsung ke Webhooks atau Google Sheets

Web Scraper Tanpa Kode untuk Jupiter

Alternatif klik-dan-pilih untuk scraping berbasis AI

Beberapa alat tanpa kode seperti Browse.ai, Octoparse, Axiom, dan ParseHub dapat membantu Anda melakukan scraping Jupiter tanpa menulis kode. Alat-alat ini biasanya menggunakan antarmuka visual untuk memilih data, meskipun mungkin kesulitan dengan konten dinamis kompleks atau tindakan anti-bot.

Alur Kerja Umum dengan Alat Tanpa Kode

Tantangan Umum

Kurva pembelajaran

Memahami selector dan logika ekstraksi membutuhkan waktu

Selector rusak

Perubahan situs web dapat merusak seluruh alur kerja

Masalah konten dinamis

Situs berbasis JavaScript memerlukan solusi yang kompleks

Keterbatasan CAPTCHA

Sebagian besar alat memerlukan intervensi manual untuk CAPTCHA

Pemblokiran IP

Scraping agresif dapat menyebabkan IP Anda diblokir

Web Scraper Tanpa Kode untuk Jupiter

Beberapa alat tanpa kode seperti Browse.ai, Octoparse, Axiom, dan ParseHub dapat membantu Anda melakukan scraping Jupiter tanpa menulis kode. Alat-alat ini biasanya menggunakan antarmuka visual untuk memilih data, meskipun mungkin kesulitan dengan konten dinamis kompleks atau tindakan anti-bot.

Alur Kerja Umum dengan Alat Tanpa Kode

- Instal ekstensi browser atau daftar di platform

- Navigasi ke situs web target dan buka alat

- Pilih elemen data yang ingin diekstrak dengan point-and-click

- Konfigurasikan selector CSS untuk setiap field data

- Atur aturan paginasi untuk scraping beberapa halaman

- Tangani CAPTCHA (sering memerlukan penyelesaian manual)

- Konfigurasikan penjadwalan untuk eksekusi otomatis

- Ekspor data ke CSV, JSON atau hubungkan melalui API

Tantangan Umum

- Kurva pembelajaran: Memahami selector dan logika ekstraksi membutuhkan waktu

- Selector rusak: Perubahan situs web dapat merusak seluruh alur kerja

- Masalah konten dinamis: Situs berbasis JavaScript memerlukan solusi yang kompleks

- Keterbatasan CAPTCHA: Sebagian besar alat memerlukan intervensi manual untuk CAPTCHA

- Pemblokiran IP: Scraping agresif dapat menyebabkan IP Anda diblokir

Contoh Kode

import requests

def get_jupiter_price(token_address):

# Menggunakan Jupiter Price API V2 resmi adalah metode yang paling andal

url = f"https://api.jup.ag/price/v2?ids={token_address}"

headers = {

"User-Agent": "Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/120.0.0.0 Safari/537.36",

"Accept": "application/json"

}

try:

response = requests.get(url, headers=headers)

response.raise_for_status()

data = response.json()

price_info = data['data'].get(token_address)

if price_info:

print(f"Token: {token_address} | Harga: ${price_info['price']}")

except Exception as e:

print(f"Terjadi kesalahan: {e}")

# Contoh: Mengambil harga SOL

get_jupiter_price("So11111111111111111111111111111111111111112")Kapan Digunakan

Terbaik untuk halaman HTML statis di mana konten dimuat di sisi server. Pendekatan tercepat dan paling sederhana ketika rendering JavaScript tidak diperlukan.

Kelebihan

- ●Eksekusi tercepat (tanpa overhead browser)

- ●Konsumsi sumber daya terendah

- ●Mudah diparalelkan dengan asyncio

- ●Bagus untuk API dan halaman statis

Keterbatasan

- ●Tidak dapat mengeksekusi JavaScript

- ●Gagal pada SPA dan konten dinamis

- ●Mungkin kesulitan dengan sistem anti-bot kompleks

How to Scrape Jupiter with Code

Python + Requests

import requests

def get_jupiter_price(token_address):

# Menggunakan Jupiter Price API V2 resmi adalah metode yang paling andal

url = f"https://api.jup.ag/price/v2?ids={token_address}"

headers = {

"User-Agent": "Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/120.0.0.0 Safari/537.36",

"Accept": "application/json"

}

try:

response = requests.get(url, headers=headers)

response.raise_for_status()

data = response.json()

price_info = data['data'].get(token_address)

if price_info:

print(f"Token: {token_address} | Harga: ${price_info['price']}")

except Exception as e:

print(f"Terjadi kesalahan: {e}")

# Contoh: Mengambil harga SOL

get_jupiter_price("So11111111111111111111111111111111111111112")Python + Playwright

from playwright.sync_api import sync_playwright

def scrape_jupiter_tokens():

with sync_playwright() as p:

# Jalankan browser yang dapat merender frontend Next.js

browser = p.chromium.launch(headless=True)

context = browser.new_context(

user_agent="Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/120.0.0.0 Safari/537.36"

)

page = context.new_page()

page.goto("https://jup.ag/tokens", wait_until="networkidle")

# Tunggu elemen daftar token merender di DOM

# Catatan: Selektor harus diperbarui berdasarkan build UI saat ini

page.wait_for_selector(".token-item")

tokens = page.query_selector_all(".token-item")

for token in tokens[:10]:

name = token.query_selector(".token-name").inner_text()

price = token.query_selector(".token-price").inner_text()

print(f"{name}: {price}")

browser.close()

scrape_jupiter_tokens()Python + Scrapy

import scrapy

import json

class JupiterTokenSpider(scrapy.Spider):

name = 'jupiter_tokens'

# Langsung mengakses endpoint JSON daftar token yang digunakan oleh frontend

start_urls = ['https://token.jup.ag/all']

def parse(self, response):

# Respons adalah daftar JSON mentah dari semua token yang terverifikasi

tokens = json.loads(response.text)

for token in tokens[:100]:

yield {

'symbol': token.get('symbol'),

'name': token.get('name'),

'address': token.get('address'),

'decimals': token.get('decimals'),

'logoURI': token.get('logoURI')

}Node.js + Puppeteer

const puppeteer = require('puppeteer');

(async () => {

const browser = await puppeteer.launch({ headless: true });

const page = await browser.newPage();

// Atur User-Agent yang realistis untuk membantu melewati filter dasar

await page.setUserAgent('Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/120.0.0.0 Safari/537.36');

// Navigasi ke halaman swap utama

await page.goto('https://jup.ag/', { waitUntil: 'networkidle2' });

// Contoh mengekstrak elemen harga menggunakan selektor parsial

const solPrice = await page.evaluate(() => {

const element = document.querySelector('div[class*="price"]');

return element ? element.innerText : 'Harga tidak ditemukan';

});

console.log(`Harga live SOL yang diamati di UI: ${solPrice}`);

await browser.close();

})();Apa yang Dapat Anda Lakukan Dengan Data Jupiter

Jelajahi aplikasi praktis dan wawasan dari data Jupiter.

Sistem Peringatan Arbitrase Harga

Identifikasi perbedaan harga antara Jupiter dan DEX Solana lainnya untuk mengeksekusi perdagangan yang menguntungkan.

Cara mengimplementasikan:

- 1Scrape nilai tukar real-time dari Price API Jupiter.

- 2Bandingkan nilai dengan liquidity pool Orca dan Raydium.

- 3Siapkan peringatan otomatis atau hook eksekusi untuk peluang arbitrase.

Gunakan Automatio untuk mengekstrak data dari Jupiter dan membangun aplikasi ini tanpa menulis kode.

Apa yang Dapat Anda Lakukan Dengan Data Jupiter

- Sistem Peringatan Arbitrase Harga

Identifikasi perbedaan harga antara Jupiter dan DEX Solana lainnya untuk mengeksekusi perdagangan yang menguntungkan.

- Scrape nilai tukar real-time dari Price API Jupiter.

- Bandingkan nilai dengan liquidity pool Orca dan Raydium.

- Siapkan peringatan otomatis atau hook eksekusi untuk peluang arbitrase.

- Dasbor Kesehatan Pasar Solana

Bangun pandangan tingkat makro dari aktivitas DeFi Solana untuk investor.

- Agregasikan data volume 24 jam dan TVL untuk token teratas.

- Kategorikan token berdasarkan sektor (Meme, AI, RWA).

- Visualisasikan pergeseran likuiditas di berbagai kelas aset dari waktu ke waktu.

- Sniper Listing Token Baru

Deteksi dan analisis token baru yang muncul di daftar terverifikasi Jupiter dengan segera.

- Lakukan scraping endpoint daftar token secara rutin.

- Bandingkan hasil baru dengan database lokal untuk menemukan penambahan baru.

- Analisis likuiditas awal dan volume untuk menilai potensi token.

- Pelacak Whale dan Perps

Pantau posisi besar dan funding rates di pasar Jupiter Perpetuals.

- Scrape data open interest dan funding rate dari bagian Perps.

- Lacak log transaksi besar untuk mengidentifikasi perilaku dompet.

- Bangun model sentimen berdasarkan rasio long/short dari aset utama.

- Layanan Agregasi Yield

Berikan pengguna tingkat pinjaman terbaik yang tersedia di seluruh vault Jupiter Lend.

- Scrape data APY untuk berbagai stablecoin dan pasangan SOL.

- Hitung hasil bersih setelah estimasi biaya platform.

- Otomatiskan rekomendasi rebalancing untuk optimasi portofolio.

Tingkatkan alur kerja Anda dengan Otomatisasi AI

Automatio menggabungkan kekuatan agen AI, otomatisasi web, dan integrasi cerdas untuk membantu Anda mencapai lebih banyak dalam waktu lebih singkat.

Tips Pro untuk Scraping Jupiter

Saran ahli untuk ekstraksi data yang sukses dari Jupiter.

Selalu utamakan API resmi di api.jup.ag sebelum mencoba melakukan scraping pada frontend HTML.

Gunakan residential proxies untuk meminimalkan pemblokiran Cloudflare, karena IP datacenter sering kali masuk dalam daftar hitam.

Aktifkan HTTP2 pada scraper Anda agar sesuai dengan fingerprint browser standar dan menghindari deteksi.

Periksa koneksi WebSocket (wss

//) di tab jaringan untuk streaming harga real-time yang paling efisien.

Terapkan penanganan kesalahan yang kuat untuk respons 403 Forbidden, yang mengindikasikan pemblokiran oleh Cloudflare.

Targetkan endpoint https

//token.jup.ag/all jika Anda hanya membutuhkan daftar statis alamat token yang terverifikasi.

Testimoni

Apa Kata Pengguna Kami

Bergabunglah dengan ribuan pengguna puas yang telah mengubah alur kerja mereka

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Terkait Web Scraping

How to Scrape Moon.ly | Step-by-Step NFT Data Extraction Guide

How to Scrape Yahoo Finance: Extract Stock Market Data

How to Scrape Rocket Mortgage: A Comprehensive Guide

How to Scrape Open Collective: Financial and Contributor Data Guide

How to Scrape Indiegogo: The Ultimate Crowdfunding Data Extraction Guide

How to Scrape ICO Drops: Comprehensive Crypto Data Guide

How to Scrape Crypto.com: Comprehensive Market Data Guide

How to Scrape Coinpaprika: Crypto Market Data Extraction Guide

Pertanyaan yang Sering Diajukan tentang Jupiter

Temukan jawaban untuk pertanyaan umum tentang Jupiter