Come fare scraping di jup.ag: Guida al Web Scraper per Jupiter DEX

Scopri come fare lo scraping di jup.ag per ottenere prezzi dei token Solana in tempo reale, swap routes e volumi di mercato. Esplora le API ufficiali di...

Protezione Anti-Bot Rilevata

- Cloudflare

- WAF e gestione bot di livello enterprise. Usa sfide JavaScript, CAPTCHA e analisi comportamentale. Richiede automazione del browser con impostazioni stealth.

- Rate Limiting

- Limita le richieste per IP/sessione nel tempo. Può essere aggirato con proxy rotanti, ritardi nelle richieste e scraping distribuito.

- Fingerprinting del browser

- Identifica i bot tramite caratteristiche del browser: canvas, WebGL, font, plugin. Richiede spoofing o profili browser reali.

- Fingerprinting del browser

- Identifica i bot tramite caratteristiche del browser: canvas, WebGL, font, plugin. Richiede spoofing o profili browser reali.

Informazioni Su Jupiter

Scopri cosa offre Jupiter e quali dati preziosi possono essere estratti.

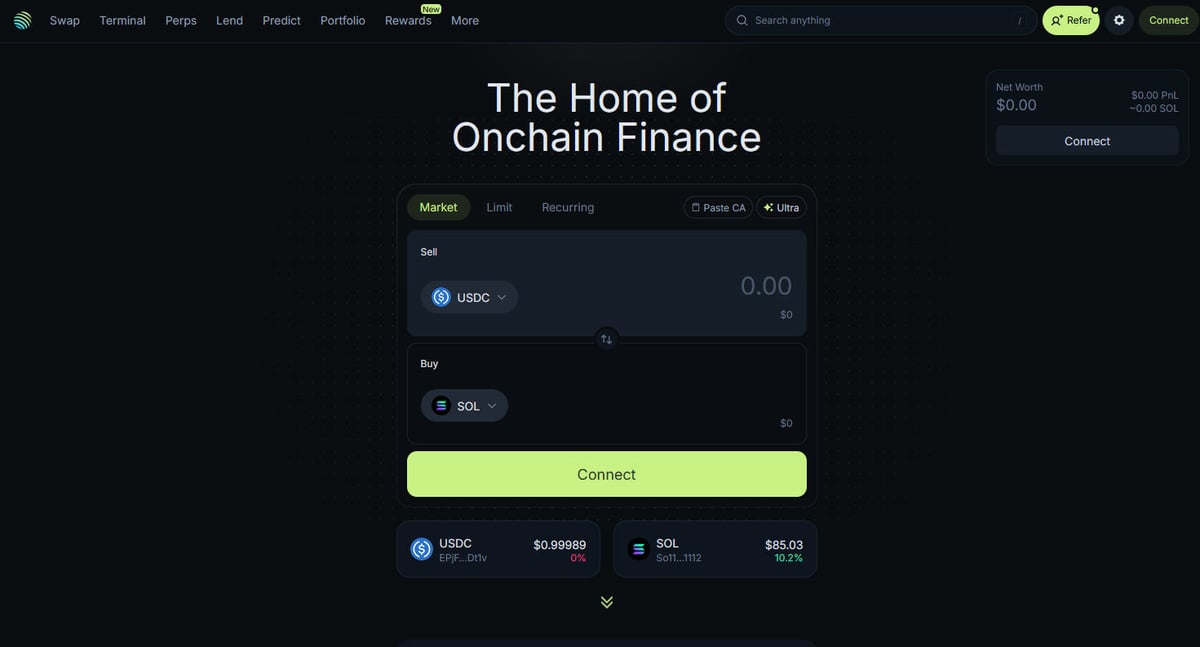

L'Hub della DeFi su Solana

Jupiter è il principale aggregatore di liquidità per la blockchain Solana, operando come una "DeFi Superapp" che ottimizza il routing degli scambi attraverso centinaia di pool di liquidità per fornire agli utenti i prezzi migliori e uno slippage minimo. È l'hub centrale per la finanza on-chain di Solana, offrendo servizi che vanno dai semplici swap di token a funzionalità avanzate come il trading perpetual con leva fino a 250x, limit orders e dollar-cost averaging (DCA). La piattaforma fornisce dati critici per l'ecosistema, inclusi prezzi in tempo reale, profondità della liquidità e metriche di mercato complete per migliaia di asset.

Architettura Tecnica

Il sito web è costruito su uno stack tecnologico moderno utilizzando Next.js e React, il che lo rende una single-page application (SPA) altamente dinamica. Poiché i prezzi e i percorsi sono calcolati in tempo reale in base allo stato attuale della blockchain, il frontend si aggiorna costantemente tramite WebSockets e chiamate API ad alta frequenza. Per data scientist, sviluppatori e trader, i dati di Jupiter sono considerati il gold standard per monitorare il sentiment del mercato Solana e gli spostamenti di liquidità nell'intero ecosistema.

Perché i dati sono importanti

L'accesso a questi dati è essenziale per costruire trading bots, dashboard di mercato e condurre analisi storiche su una delle reti blockchain a più rapida crescita. Gli scraper spesso puntano a Jupiter per monitorare i nuovi listini di token, tracciare i movimenti delle "whale" nei mercati perpetual o identificare discrepanze di prezzo per l'arbitraggio. Sebbene la piattaforma offra API ufficiali, lo scraping diretto del web è frequentemente utilizzato per catturare lo stato esatto della UI e i dati di routing specifici che potrebbero non essere completamente esposti negli endpoint pubblici.

Perché Fare Scraping di Jupiter?

Scopri il valore commerciale e i casi d'uso per l'estrazione dati da Jupiter.

Monitoraggio dei prezzi in tempo reale

Monitora i prezzi dei token Solana in tempo reale per ottenere un vantaggio nel mercato DeFi altamente volatile. Jupiter aggrega la liquidità in tutto l'ecosistema, fornendo i tassi di mercato più accurati disponibili.

Ottimizzazione dei bot di trading

Invia dati sulle swap routes ad alta frequenza e sull'impatto dei prezzi ai trading bot automatizzati per arbitraggio o sniping. Ciò consente un'esecuzione più rapida e una migliore price discovery rispetto al trading manuale.

Analisi del sentiment di mercato

Traccia l'aggiunta di nuovi token alla 'Strict' list di Jupiter per identificare i progetti di tendenza e la fiducia della community. Analizzare gli spostamenti di volume tra diversi asset aiuta a prevedere i movimenti di mercato più ampi.

Monitoraggio della profondità di liquidità

Esegui lo scraping dei dati sulla liquidità per determinare la profondità di mercato di specifici token SPL e valutare il potenziale di slippage. Questo è fondamentale per i trader su larga scala e i fornitori di liquidità istituzionali.

Dati storici sulle performance

Raccogli il volume giornaliero e la cronologia dei prezzi per i token che potrebbero non essere quotati sugli exchange centralizzati. Questi dati sono essenziali per il backtesting delle strategie di trading e per condurre ricerche di mercato a lungo termine.

Metriche di crescita dell'ecosistema

Misura il volume totale e il conteggio delle transazioni nella rete Solana utilizzando Jupiter come proxy. Questo aiuta sviluppatori e investitori a comprendere il tasso di adozione della DeFi su Solana nel tempo.

Sfide dello Scraping

Sfide tecniche che potresti incontrare durante lo scraping di Jupiter.

Dipendenza dal rendering JavaScript

Jupiter è costruito come una complessa Single Page Application (SPA) utilizzando React, il che significa che i dati non sono presenti nell'HTML iniziale. È necessario utilizzare uno strumento in grado di eseguire completamente il rendering JavaScript per accedere ai prezzi e alle liste dei token.

Protezione Cloudflare aggressiva

Il sito utilizza il Web Application Firewall (WAF) di Cloudflare per bloccare il traffico non proveniente da browser e gli script automatizzati. Superare queste sfide richiede fingerprinting avanzato del browser e gestione degli header.

Flusso di dati dinamico

I prezzi e le swap routes si aggiornano più volte al secondo tramite WebSocket e chiamate API ad alta frequenza. Catturare snapshot coerenti di questi dati richiede un'infrastruttura di scraping a bassa latency e un timing preciso.

Rate Limiting sugli endpoint pubblici

Gli endpoint API pubblici e le rotte web sono rigorosamente limitati per prevenire abusi. Il superamento di questi limiti comporta spesso ban temporanei o permanenti dell'IP, rendendo necessari i proxy residenziali.

Volatilità dei selettori UI

Gli aggiornamenti frequenti al frontend di Jupiter possono causare cambiamenti nelle classi CSS e nelle strutture DOM senza preavviso. Ciò richiede che gli scraper abbiano selettori robusti e flessibili o una manutenzione frequente per evitare interruzioni.

Scraping di Jupiter con l'IA

Nessun codice richiesto. Estrai dati in minuti con l'automazione basata sull'IA.

Come Funziona

Descrivi ciò di cui hai bisogno

Di' all'IA quali dati vuoi estrarre da Jupiter. Scrivi semplicemente in linguaggio naturale — nessun codice o selettore necessario.

L'IA estrae i dati

La nostra intelligenza artificiale naviga Jupiter, gestisce contenuti dinamici ed estrae esattamente ciò che hai richiesto.

Ottieni i tuoi dati

Ricevi dati puliti e strutturati pronti per l'esportazione in CSV, JSON o da inviare direttamente alle tue applicazioni.

Perché Usare l'IA per lo Scraping

L'IA rende facile lo scraping di Jupiter senza scrivere codice. La nostra piattaforma basata sull'intelligenza artificiale capisce quali dati vuoi — descrivili in linguaggio naturale e l'IA li estrae automaticamente.

How to scrape with AI:

- Descrivi ciò di cui hai bisogno: Di' all'IA quali dati vuoi estrarre da Jupiter. Scrivi semplicemente in linguaggio naturale — nessun codice o selettore necessario.

- L'IA estrae i dati: La nostra intelligenza artificiale naviga Jupiter, gestisce contenuti dinamici ed estrae esattamente ciò che hai richiesto.

- Ottieni i tuoi dati: Ricevi dati puliti e strutturati pronti per l'esportazione in CSV, JSON o da inviare direttamente alle tue applicazioni.

Why use AI for scraping:

- Rendering headless completo: Automatio gestisce naturalmente il pesante rendering JavaScript dell'interfaccia di Jupiter, assicurandoti di vedere gli stessi dati di un utente umano. Non dovrai preoccuparti dei dati mancanti che vengono caricati solo dopo la visualizzazione iniziale della pagina.

- Rotazione intelligente dei proxy: La rotazione integrata dei proxy residenziali ti consente di bypassare Cloudflare e il rate limiting basato su IP senza sforzo. Questo assicura che le tue sessioni di scraping rimangano ininterrotte anche durante il polling dei dati ad alte frequenze.

- Selezione visiva dei dati: Seleziona facilmente i prezzi dei token, i volumi o le rotte specifiche che desideri estrarre utilizzando un'interfaccia point-and-click. Non è necessario scrivere complessi selettori XPath o CSS per puntare a elementi dinamici.

- Programmazione automatizzata: Imposta i tuoi scraper per Jupiter in modo che vengano eseguiti secondo una pianificazione precisa, ad esempio ogni minuto o ogni ora, per mantenere un dataset aggiornato. Perfetto per creare dashboard in tempo reale o avvisi sui prezzi automatizzati.

- Integrazione diretta dei dati: Invia i tuoi dati DeFi estratti direttamente a Google Sheets, Airtable o al tuo database tramite Webhook. Questo elimina l'inserimento manuale dei dati e ottimizza il tuo flusso di lavoro di trading o ricerca.

Scraper Web No-Code per Jupiter

Alternative point-and-click allo scraping alimentato da IA

Diversi strumenti no-code come Browse.ai, Octoparse, Axiom e ParseHub possono aiutarti a fare scraping di Jupiter senza scrivere codice. Questi strumenti usano interfacce visive per selezionare i dati, anche se possono avere difficoltà con contenuti dinamici complessi o misure anti-bot.

Workflow Tipico con Strumenti No-Code

Sfide Comuni

Curva di apprendimento

Comprendere selettori e logica di estrazione richiede tempo

I selettori si rompono

Le modifiche al sito web possono rompere l'intero flusso di lavoro

Problemi con contenuti dinamici

I siti con molto JavaScript richiedono soluzioni complesse

Limitazioni CAPTCHA

La maggior parte degli strumenti richiede intervento manuale per i CAPTCHA

Blocco IP

Lo scraping aggressivo può portare al blocco del tuo IP

Scraper Web No-Code per Jupiter

Diversi strumenti no-code come Browse.ai, Octoparse, Axiom e ParseHub possono aiutarti a fare scraping di Jupiter senza scrivere codice. Questi strumenti usano interfacce visive per selezionare i dati, anche se possono avere difficoltà con contenuti dinamici complessi o misure anti-bot.

Workflow Tipico con Strumenti No-Code

- Installare l'estensione del browser o registrarsi sulla piattaforma

- Navigare verso il sito web target e aprire lo strumento

- Selezionare con point-and-click gli elementi dati da estrarre

- Configurare i selettori CSS per ogni campo dati

- Impostare le regole di paginazione per lo scraping di più pagine

- Gestire i CAPTCHA (spesso richiede risoluzione manuale)

- Configurare la pianificazione per le esecuzioni automatiche

- Esportare i dati in CSV, JSON o collegare tramite API

Sfide Comuni

- Curva di apprendimento: Comprendere selettori e logica di estrazione richiede tempo

- I selettori si rompono: Le modifiche al sito web possono rompere l'intero flusso di lavoro

- Problemi con contenuti dinamici: I siti con molto JavaScript richiedono soluzioni complesse

- Limitazioni CAPTCHA: La maggior parte degli strumenti richiede intervento manuale per i CAPTCHA

- Blocco IP: Lo scraping aggressivo può portare al blocco del tuo IP

Esempi di Codice

import requests

def get_jupiter_price(token_address):

# L'uso dell'API ufficiale Jupiter Price V2 è il metodo più affidabile

url = f"https://api.jup.ag/price/v2?ids={token_address}"

headers = {

"User-Agent": "Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/120.0.0.0 Safari/537.36",

"Accept": "application/json"

}

try:

response = requests.get(url, headers=headers)

response.raise_for_status()

data = response.json()

price_info = data['data'].get(token_address)

if price_info:

print(f"Token: {token_address} | Prezzo: ${price_info['price']}")

except Exception as e:

print(f"Si è verificato un errore: {e}")

# Esempio: Recupero del prezzo di SOL

get_jupiter_price("So11111111111111111111111111111111111111112")Quando Usare

Ideale per pagine HTML statiche con JavaScript minimo. Perfetto per blog, siti di notizie e pagine prodotto e-commerce semplici.

Vantaggi

- ●Esecuzione più veloce (senza overhead del browser)

- ●Consumo risorse minimo

- ●Facile da parallelizzare con asyncio

- ●Ottimo per API e pagine statiche

Limitazioni

- ●Non può eseguire JavaScript

- ●Fallisce su SPA e contenuti dinamici

- ●Può avere difficoltà con sistemi anti-bot complessi

Come Fare Scraping di Jupiter con Codice

Python + Requests

import requests

def get_jupiter_price(token_address):

# L'uso dell'API ufficiale Jupiter Price V2 è il metodo più affidabile

url = f"https://api.jup.ag/price/v2?ids={token_address}"

headers = {

"User-Agent": "Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/120.0.0.0 Safari/537.36",

"Accept": "application/json"

}

try:

response = requests.get(url, headers=headers)

response.raise_for_status()

data = response.json()

price_info = data['data'].get(token_address)

if price_info:

print(f"Token: {token_address} | Prezzo: ${price_info['price']}")

except Exception as e:

print(f"Si è verificato un errore: {e}")

# Esempio: Recupero del prezzo di SOL

get_jupiter_price("So11111111111111111111111111111111111111112")Python + Playwright

from playwright.sync_api import sync_playwright

def scrape_jupiter_tokens():

with sync_playwright() as p:

# Avvia un browser in grado di renderizzare il frontend Next.js

browser = p.chromium.launch(headless=True)

context = browser.new_context(

user_agent="Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/120.0.0.0 Safari/537.36"

)

page = context.new_page()

page.goto("https://jup.ag/tokens", wait_until="networkidle")

# Attendi che gli elementi della lista token vengano renderizzati nel DOM

# Nota: I selettori devono essere aggiornati in base alla build attuale della UI

page.wait_for_selector(".token-item")

tokens = page.query_selector_all(".token-item")

for token in tokens[:10]:

name = token.query_selector(".token-name").inner_text()

price = token.query_selector(".token-price").inner_text()

print(f"{name}: {price}")

browser.close()

scrape_jupiter_tokens()Python + Scrapy

import scrapy

import json

class JupiterTokenSpider(scrapy.Spider):

name = 'jupiter_tokens'

# Accesso diretto all'endpoint JSON della lista token usato dal frontend

start_urls = ['https://token.jup.ag/all']

def parse(self, response):

# La risposta è una lista JSON grezza di tutti i token verificati

tokens = json.loads(response.text)

for token in tokens[:100]:

yield {

'symbol': token.get('symbol'),

'name': token.get('name'),

'address': token.get('address'),

'decimals': token.get('decimals'),

'logoURI': token.get('logoURI')

}Node.js + Puppeteer

const puppeteer = require('puppeteer');

(async () => {

const browser = await puppeteer.launch({ headless: true });

const page = await browser.newPage();

// Imposta un User-Agent realistico per aiutare a bypassare i filtri di base

await page.setUserAgent('Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/120.0.0.0 Safari/537.36');

// Naviga alla pagina principale di swap

await page.goto('https://jup.ag/', { waitUntil: 'networkidle2' });

// Esempio di estrazione di un elemento di prezzo utilizzando un selettore parziale

const solPrice = await page.evaluate(() => {

const element = document.querySelector('div[class*="price"]');

return element ? element.innerText : 'Prezzo non trovato';

});

console.log(`Prezzo SOL live osservato nella UI: ${solPrice}`);

await browser.close();

})();Cosa Puoi Fare Con I Dati di Jupiter

Esplora applicazioni pratiche e insight dai dati di Jupiter.

Sistema di Alert per Arbitraggio di Prezzo

Identifica le differenze di prezzo tra Jupiter e altri DEX di Solana per eseguire operazioni di trading profittevoli.

Come implementare:

- 1Esegui lo scraping dei tassi di swap in tempo reale dalla Price API di Jupiter.

- 2Confronta i tassi con le pool di liquidità di Orca e Raydium.

- 3Imposta avvisi automatici o hook di esecuzione per opportunità di arbitraggio.

Usa Automatio per estrarre dati da Jupiter e costruire queste applicazioni senza scrivere codice.

Cosa Puoi Fare Con I Dati di Jupiter

- Sistema di Alert per Arbitraggio di Prezzo

Identifica le differenze di prezzo tra Jupiter e altri DEX di Solana per eseguire operazioni di trading profittevoli.

- Esegui lo scraping dei tassi di swap in tempo reale dalla Price API di Jupiter.

- Confronta i tassi con le pool di liquidità di Orca e Raydium.

- Imposta avvisi automatici o hook di esecuzione per opportunità di arbitraggio.

- Dashboard sulla Salute del Mercato Solana

Costruisci una vista a livello macro dell'attività DeFi su Solana per gli investitori.

- Aggrega i dati sul volume 24h e TVL per i token principali.

- Categorizza i token per settori (Meme, AI, RWA).

- Visualizza gli spostamenti di liquidità tra diverse classi di asset nel tempo.

- Sniper per Nuovi Listini Token

Rileva e analizza immediatamente i nuovi token che appaiono nella lista verificata di Jupiter.

- Esegui regolarmente lo scraping dell'endpoint della lista token.

- Confronta i nuovi risultati con un database locale per trovare nuove aggiunte.

- Analizza la liquidità iniziale e il volume per valutare il potenziale del token.

- Tracker di Whale e Perps

Monitora le grandi posizioni e i funding rates nel mercato Jupiter Perpetuals.

- Esegui lo scraping dei dati su open interest e funding rate dalla sezione Perps.

- Traccia i log delle transazioni di grandi dimensioni per identificare il comportamento dei wallet.

- Costruisci modelli di sentiment basati sui rapporti long/short degli asset principali.

- Servizio di Aggregazione di Yield

Fornisci agli utenti i migliori tassi di prestito disponibili attraverso i vault di Jupiter Lend.

- Esegui lo scraping dei dati APY per varie stablecoin e coppie SOL.

- Calcola il rendimento netto dopo le commissioni stimate della piattaforma.

- Automatizza le raccomandazioni di ribilanciamento per l'ottimizzazione del portafoglio.

Potenzia il tuo workflow con l'automazione AI

Automatio combina la potenza degli agenti AI, dell'automazione web e delle integrazioni intelligenti per aiutarti a fare di piu in meno tempo.

Consigli Pro per lo Scraping di Jupiter

Consigli esperti per estrarre con successo i dati da Jupiter.

Privilegiare gli endpoint API ufficiali

Laddove possibile, utilizza le API ufficiali V6 Quote o Price di Jupiter invece di fare lo scraping dell'interfaccia utente. Questi endpoint sono progettati per l'accesso programmatico ad alte prestazioni e sono generalmente più stabili.

Implementare l'Exponential Backoff

Quando le tue richieste raggiungono un rate limit, utilizza una strategia che aumenti progressivamente il tempo di attesa tra i tentativi. Questo aiuta a evitare che il tuo IP venga contrassegnato come dannoso dai sistemi di sicurezza di Jupiter.

Filtrare tramite la Strict List

Esegui lo scraping della 'Strict' token list di Jupiter per assicurarti di monitorare solo asset verificati. Questo è il modo migliore per filtrare rugpull a bassa liquidità e scam token che appaiono nella lista 'All'.

Utilizzare proxy residenziali di alta qualità

Evita di utilizzare proxy di datacenter poiché sono spesso pre-inseriti nelle blacklist di Cloudflare. I proxy residenziali o mobili godono di maggiore fiducia ed è meno probabile che attivino CAPTCHA o errori 403 Forbidden.

Monitorare il traffico WebSocket

Usa l'inspector di rete del browser per trovare le connessioni WebSocket che Jupiter utilizza per gli aggiornamenti live. Emulare queste connessioni può essere più efficiente rispetto al ricaricamento della pagina per i feed dei prezzi in tempo reale.

Considerare i decimali dei token

Estrai sempre il campo 'decimals' dai metadati dei token quando esegui lo scraping degli indirizzi mint. Questo è fondamentale per convertire correttamente gli interi grezzi on-chain in importi di valuta leggibili dall'uomo.

Testimonianze

Cosa dicono i nostri utenti

Unisciti a migliaia di utenti soddisfatti che hanno trasformato il loro workflow

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Correlati Web Scraping

How to Scrape Moon.ly | Step-by-Step NFT Data Extraction Guide

How to Scrape Yahoo Finance: Extract Stock Market Data

How to Scrape Rocket Mortgage: A Comprehensive Guide

How to Scrape Open Collective: Financial and Contributor Data Guide

How to Scrape Indiegogo: The Ultimate Crowdfunding Data Extraction Guide

How to Scrape ICO Drops: Comprehensive Crypto Data Guide

How to Scrape Crypto.com: Comprehensive Market Data Guide

How to Scrape Coinpaprika: Crypto Market Data Extraction Guide

Domande frequenti su Jupiter

Trova risposte alle domande comuni su Jupiter