jup.agのスクレイピング方法:Jupiter DEX ウェブスクレイパーガイド

jup.ag をスクレイピングして、リアルタイムの Solana token 価格、スワップルート、市場ボリュームを取得する方法を学びましょう。Jupiter の公式 API や Cloudflare アンチボットの回避方法を紹介します。

ボット対策検出

- Cloudflare

- エンタープライズ級のWAFとボット管理。JavaScriptチャレンジ、CAPTCHA、行動分析を使用。ステルス設定でのブラウザ自動化が必要。

- レート制限

- 時間あたりのIP/セッションごとのリクエストを制限。ローテーションプロキシ、リクエスト遅延、分散スクレイピングで回避可能。

- ブラウザフィンガープリント

- ブラウザの特性でボットを識別:canvas、WebGL、フォント、プラグイン。スプーフィングまたは実際のブラウザプロファイルが必要。

- ブラウザフィンガープリント

- ブラウザの特性でボットを識別:canvas、WebGL、フォント、プラグイン。スプーフィングまたは実際のブラウザプロファイルが必要。

Jupiterについて

Jupiterが提供するものと抽出可能な貴重なデータを発見してください。

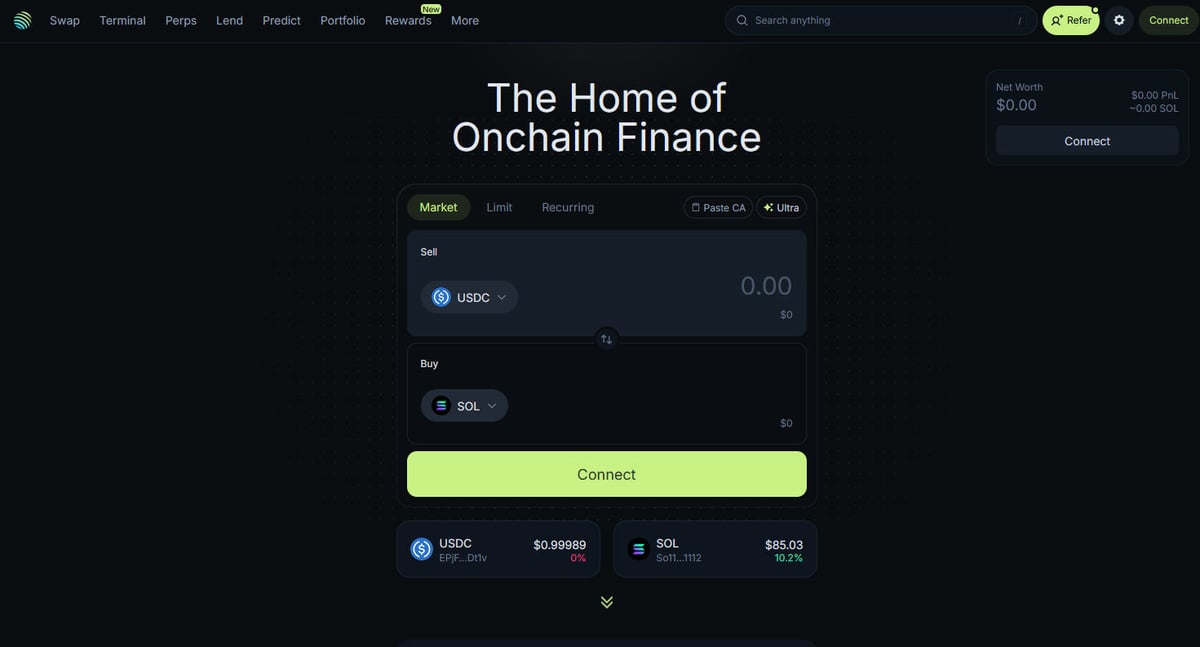

Solana DeFi のハブ

Jupiter は Solana ブロックチェーンにおける主要なリクイディティアグリゲーターであり、数百のリクイディティプールにわたるトレードルーティングを最適化し、ユーザーに最良の価格と最小限のスリッページを提供する「DeFi スーパーアプリ」として機能しています。Solana のオンチェーンファイナンスの中心的なハブであり、単純な token スワップから、最大 250 倍のレバレッジを備えたパーペチュアル取引、指値注文、ドルコスト平均法(DCA)などの高度な機能まで、幅広いサービスを提供しています。このプラットフォームは、数千のアセットに関するリアルタイムの価格設定、リクイディティの深さ、包括的な市場指標など、エコシステムにとって重要なデータを提供しています。

技術アーキテクチャ

ウェブサイトは Next.js と React を使用したモダンな技術スタックで構築されており、非常に動的なシングルページアプリケーション(SPA)となっています。価格やルートは現在のブロックチェーンの状態に基づいてリアルタイムで計算されるため、フロントエンドは WebSockets や高頻度の API コールを介して常に更新されています。データサイエンティスト、開発者、トレーダーにとって、Jupiter のデータは Solana の市場センチメントやエコシステム全体のリクイディティの推移を追跡するためのゴールドスタンダードとみなされています。

なぜこのデータが重要なのか

このデータへのアクセスは、トレーディングボットや市場ダッシュボードの構築、および急成長しているブロックチェーンネットワークの一つである Solana での履歴分析を行うために不可欠です。スクレイパーは、新しい token のリスティングを監視したり、パーペチュアル市場での「クジラ(大口投資家)」の動きを追跡したり、アービトラージのための価格差を特定したりするために Jupiter をターゲットにすることがよくあります。プラットフォームは公式 API を提供していますが、公開エンドポイントでは完全に公開されていない正確な UI 状態や特定のルーティングデータを取得するために、直接的なウェブスクレイピングが頻繁に使用されます。

なぜJupiterをスクレイピングするのか?

Jupiterからのデータ抽出のビジネス価値とユースケースを発見してください。

Solana token のリアルタイム価格監視

DEX 間のアービトラージトレーディングボットの開発

市場ボリュームとリクイディティトレンドの追跡

新規 token リスティングと市場センチメントの特定

レンディング利回りとパーペチュアル・ファンディングレートの集計

大規模取引のための過去の価格インパクトの分析

スクレイピングの課題

Jupiterのスクレイピング時に遭遇する可能性のある技術的課題。

強力な Cloudflare アンチボット保護

完全な JavaScript レンダリング(React/Next.js)が必要

公開エンドポイントに対する IP ベースの強力なレート制限

UI における動的で難読化された CSS セレクター

低 latency な接続を必要とする高速なデータ更新

JupiterをAIでスクレイピング

コーディング不要。AI搭載の自動化で数分でデータを抽出。

仕組み

必要なものを記述

Jupiterから抽出したいデータをAIに伝えてください。自然言語で入力するだけ — コードやセレクターは不要です。

AIがデータを抽出

人工知能がJupiterをナビゲートし、動的コンテンツを処理し、あなたが求めたものを正確に抽出します。

データを取得

CSV、JSONでエクスポートしたり、アプリやワークフローに直接送信できる、クリーンで構造化されたデータを受け取ります。

なぜスクレイピングにAIを使うのか

AIを使えば、コードを書かずにJupiterを簡単にスクレイピングできます。人工知能搭載のプラットフォームが必要なデータを理解します — 自然言語で記述するだけで、AIが自動的に抽出します。

How to scrape with AI:

- 必要なものを記述: Jupiterから抽出したいデータをAIに伝えてください。自然言語で入力するだけ — コードやセレクターは不要です。

- AIがデータを抽出: 人工知能がJupiterをナビゲートし、動的コンテンツを処理し、あなたが求めたものを正確に抽出します。

- データを取得: CSV、JSONでエクスポートしたり、アプリやワークフローに直接送信できる、クリーンで構造化されたデータを受け取ります。

Why use AI for scraping:

- 動的な SPA からのノーコードデータ抽出

- Cloudflare とブラウザフィンガープリントの自動処理

- 継続的な市場監視のためのスケジュール実行

- Webhook や Google スプレッドシートへの直接データエクスポート

Jupiter用ノーコードWebスクレイパー

AI搭載スクレイピングのポイント&クリック代替手段

Browse.ai、Octoparse、Axiom、ParseHubなどのノーコードツールは、コードを書かずにJupiterをスクレイピングするのに役立ちます。これらのツールは視覚的なインターフェースを使用してデータを選択しますが、複雑な動的コンテンツやアンチボット対策には苦戦する場合があります。

ノーコードツールでの一般的なワークフロー

一般的な課題

学習曲線

セレクタと抽出ロジックの理解に時間がかかる

セレクタの破損

Webサイトの変更によりワークフロー全体が壊れる可能性がある

動的コンテンツの問題

JavaScript多用サイトは複雑な回避策が必要

CAPTCHAの制限

ほとんどのツールはCAPTCHAに手動介入が必要

IPブロック

過度なスクレイピングはIPのブロックにつながる可能性がある

Jupiter用ノーコードWebスクレイパー

Browse.ai、Octoparse、Axiom、ParseHubなどのノーコードツールは、コードを書かずにJupiterをスクレイピングするのに役立ちます。これらのツールは視覚的なインターフェースを使用してデータを選択しますが、複雑な動的コンテンツやアンチボット対策には苦戦する場合があります。

ノーコードツールでの一般的なワークフロー

- ブラウザ拡張機能をインストールするかプラットフォームに登録する

- ターゲットWebサイトに移動してツールを開く

- ポイント&クリックで抽出するデータ要素を選択する

- 各データフィールドのCSSセレクタを設定する

- 複数ページをスクレイピングするためのページネーションルールを設定する

- CAPTCHAに対処する(多くの場合手動解決が必要)

- 自動実行のスケジュールを設定する

- データをCSV、JSONにエクスポートするかAPIで接続する

一般的な課題

- 学習曲線: セレクタと抽出ロジックの理解に時間がかかる

- セレクタの破損: Webサイトの変更によりワークフロー全体が壊れる可能性がある

- 動的コンテンツの問題: JavaScript多用サイトは複雑な回避策が必要

- CAPTCHAの制限: ほとんどのツールはCAPTCHAに手動介入が必要

- IPブロック: 過度なスクレイピングはIPのブロックにつながる可能性がある

コード例

import requests

def get_jupiter_price(token_address):

# 公式の Jupiter Price API V2 を使用するのが最も信頼性の高い方法です

url = f"https://api.jup.ag/price/v2?ids={token_address}"

headers = {

"User-Agent": "Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/120.0.0.0 Safari/537.36",

"Accept": "application/json"

}

try:

response = requests.get(url, headers=headers)

response.raise_for_status()

data = response.json()

price_info = data['data'].get(token_address)

if price_info:

print(f"Token: {token_address} | 価格: ${price_info['price']}")

except Exception as e:

print(f"エラーが発生しました: {e}")

# 例: SOL の価格を取得

get_jupiter_price("So11111111111111111111111111111111111111112")いつ使うか

JavaScriptが最小限の静的HTMLページに最適。ブログ、ニュースサイト、シンプルなEコマース製品ページに理想的。

メリット

- ●最速の実行(ブラウザオーバーヘッドなし)

- ●最小限のリソース消費

- ●asyncioで簡単に並列化

- ●APIと静的ページに最適

制限事項

- ●JavaScriptを実行できない

- ●SPAや動的コンテンツで失敗

- ●複雑なアンチボットシステムで苦戦する可能性

コードでJupiterをスクレイピングする方法

Python + Requests

import requests

def get_jupiter_price(token_address):

# 公式の Jupiter Price API V2 を使用するのが最も信頼性の高い方法です

url = f"https://api.jup.ag/price/v2?ids={token_address}"

headers = {

"User-Agent": "Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/120.0.0.0 Safari/537.36",

"Accept": "application/json"

}

try:

response = requests.get(url, headers=headers)

response.raise_for_status()

data = response.json()

price_info = data['data'].get(token_address)

if price_info:

print(f"Token: {token_address} | 価格: ${price_info['price']}")

except Exception as e:

print(f"エラーが発生しました: {e}")

# 例: SOL の価格を取得

get_jupiter_price("So11111111111111111111111111111111111111112")Python + Playwright

from playwright.sync_api import sync_playwright

def scrape_jupiter_tokens():

with sync_playwright() as p:

# Next.js フロントエンドをレンダリングできるブラウザを起動

browser = p.chromium.launch(headless=True)

context = browser.new_context(

user_agent="Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/120.0.0.0 Safari/537.36"

)

page = context.new_page()

page.goto("https://jup.ag/tokens", wait_until="networkidle")

# DOM に token リスト項目がレンダリングされるのを待つ

# 注意: セレクターは現在の UI ビルドに基づいて更新する必要があります

page.wait_for_selector(".token-item")

tokens = page.query_selector_all(".token-item")

for token in tokens[:10]:

name = token.query_selector(".token-name").inner_text()

price = token.query_selector(".token-price").inner_text()

print(f"{name}: {price}")

browser.close()

scrape_jupiter_tokens()Python + Scrapy

import scrapy

import json

class JupiterTokenSpider(scrapy.Spider):

name = 'jupiter_tokens'

# フロントエンドで使用されている token リストの JSON エンドポイントを直接ヒットする

start_urls = ['https://token.jup.ag/all']

def parse(self, response):

# レスポンスはすべての検証済み token の生の JSON リストです

tokens = json.loads(response.text)

for token in tokens[:100]:

yield {

'symbol': token.get('symbol'),

'name': token.get('name'),

'address': token.get('address'),

'decimals': token.get('decimals'),

'logoURI': token.get('logoURI')

}Node.js + Puppeteer

const puppeteer = require('puppeteer');

(async () => {

const browser = await puppeteer.launch({ headless: true });

const page = await browser.newPage();

// 基本的なフィルターを回避するために、現実的な User-Agent を設定します

await page.setUserAgent('Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/120.0.0.0 Safari/537.36');

// メインのスワップページに移動

await page.goto('https://jup.ag/', { waitUntil: 'networkidle2' });

// 部分一致セレクターを使用して価格要素を抽出する例

const solPrice = await page.evaluate(() => {

const element = document.querySelector('div[class*="price"]');

return element ? element.innerText : '価格が見つかりません';

});

console.log(`UIで確認されたライブ SOL 価格: ${solPrice}`);

await browser.close();

})();Jupiterデータで何ができるか

Jupiterデータからの実用的なアプリケーションとインサイトを探索してください。

価格アービトラージアラートシステム

Jupiter と他の Solana DEX 間の価格差を特定し、収益性の高い取引を実行します。

実装方法:

- 1Jupiter の Price API からリアルタイムのスワップレートをスクレイピングします。

- 2Orca や Raydium のリクイディティプールとレートを比較します。

- 3アービトラージの機会に対して自動アラートまたは実行フックを設定します。

Automatioを使用してJupiterからデータを抽出し、コードを書かずにこれらのアプリケーションを構築しましょう。

Jupiterデータで何ができるか

- 価格アービトラージアラートシステム

Jupiter と他の Solana DEX 間の価格差を特定し、収益性の高い取引を実行します。

- Jupiter の Price API からリアルタイムのスワップレートをスクレイピングします。

- Orca や Raydium のリクイディティプールとレートを比較します。

- アービトラージの機会に対して自動アラートまたは実行フックを設定します。

- Solana 市場健全性ダッシュボード

投資家向けに Solana DeFi 活動のマクロレベルのビューを構築します。

- 主要な token の 24 時間ボリュームと TVL データを集計します。

- token をセクター(ミーム、AI、RWA)ごとに分類します。

- 時間の経過に伴う異なるアセットクラス間のリクイディティの推移を可視化します。

- 新規 token リスティング・スナイパー

Jupiter の検証済みリストに新しく登場した token を即座に検出して分析します。

- token リストのエンドポイントを定期的にスクレイピングします。

- 新しい結果をローカルデータベースと比較して、新規追加を検出します。

- 初期のリクイディティとボリュームを分析して、token の可能性を評価します。

- 大口投資家(クジラ)および Perps トラッカー

Jupiter パーペチュアル市場における大規模なポジションとファンディングレートを監視します。

- Perps セクションから未決済建玉(OI)とファンディングレートのデータをスクレイピングします。

- 大規模なトランザクションログを追跡して、ウォレットの行動を特定します。

- 主要アセットのロング/ショート比率に基づいてセンチメント model を構築します。

- イールドアグリゲーションサービス

Jupiter Lend ボルト全体で利用可能な最高の貸付レートをユーザーに提供します。

- さまざまなステーブルコインと SOL ペアの APY データをスクレイピングします。

- 推定されるプラットフォーム手数料を差し引いた純利益を計算します。

- ポートフォリオ最適化のためのリバランス推奨を自動化します。

ワークフローを強化する AI自動化

AutomatioはAIエージェント、ウェブ自動化、スマート統合のパワーを組み合わせ、より短時間でより多くのことを達成するお手伝いをします。

Jupiterスクレイピングのプロのヒント

Jupiterからデータを正常に抽出するための専門家のアドバイス。

HTMLフロントエンドをスクレイピングしようとする前に、常に api.jup.ag の公式 API を優先してください。

データセンターの IP はブラックリストに登録されていることが多いため、Cloudflare によるブロックを最小限に抑えるには、レジデンシャルプロキシを使用してください。

標準的なブラウザのフィンガープリントと一致させて検知を避けるために、スクレイパーで HTTP2 を有効にしてください。

最も効率的なリアルタイムの価格ストリーミングを行うには、開発者ツールのネットワークタブで WebSocket 接続(wss://)を確認してください。

Cloudflare によるブロックを示す 403 Forbidden レスポンスに対して、堅牢なエラーハンドリングを実装してください。

検証済みの token アドレスの静的なリストのみが必要な場合は、https

//token.jup.ag/all エンドポイントをターゲットにしてください。

お客様の声

ユーザーの声

ワークフローを変革した何千人もの満足したユーザーに加わりましょう

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

関連 Web Scraping

How to Scrape Moon.ly | Step-by-Step NFT Data Extraction Guide

How to Scrape Yahoo Finance: Extract Stock Market Data

How to Scrape Rocket Mortgage: A Comprehensive Guide

How to Scrape Open Collective: Financial and Contributor Data Guide

How to Scrape Indiegogo: The Ultimate Crowdfunding Data Extraction Guide

How to Scrape ICO Drops: Comprehensive Crypto Data Guide

How to Scrape Crypto.com: Comprehensive Market Data Guide

How to Scrape Coinpaprika: Crypto Market Data Extraction Guide

Jupiterについてのよくある質問

Jupiterに関するよくある質問への回答を見つけてください