Signal NFXをスクレイピングする方法 | 投資家&VCデータベース・スクレイピングガイド

Signal NFXから投資家プロフィール、VCファームのデータ、およびリードリストをスクレイピングする方法を学びましょう。資金調達や市場調査のための技術的な戦略を紹介します。

ボット対策検出

- Cloudflare

- エンタープライズ級のWAFとボット管理。JavaScriptチャレンジ、CAPTCHA、行動分析を使用。ステルス設定でのブラウザ自動化が必要。

- レート制限

- 時間あたりのIP/セッションごとのリクエストを制限。ローテーションプロキシ、リクエスト遅延、分散スクレイピングで回避可能。

- IPブロック

- 既知のデータセンターIPとフラグ付きアドレスをブロック。効果的に回避するにはレジデンシャルまたはモバイルプロキシが必要。

- Login Wall

- Google reCAPTCHA

- GoogleのCAPTCHAシステム。v2はユーザー操作が必要、v3はリスクスコアリングでサイレント動作。CAPTCHAサービスで解決可能。

Signal (by NFX)について

Signal (by NFX)が提供するものと抽出可能な貴重なデータを発見してください。

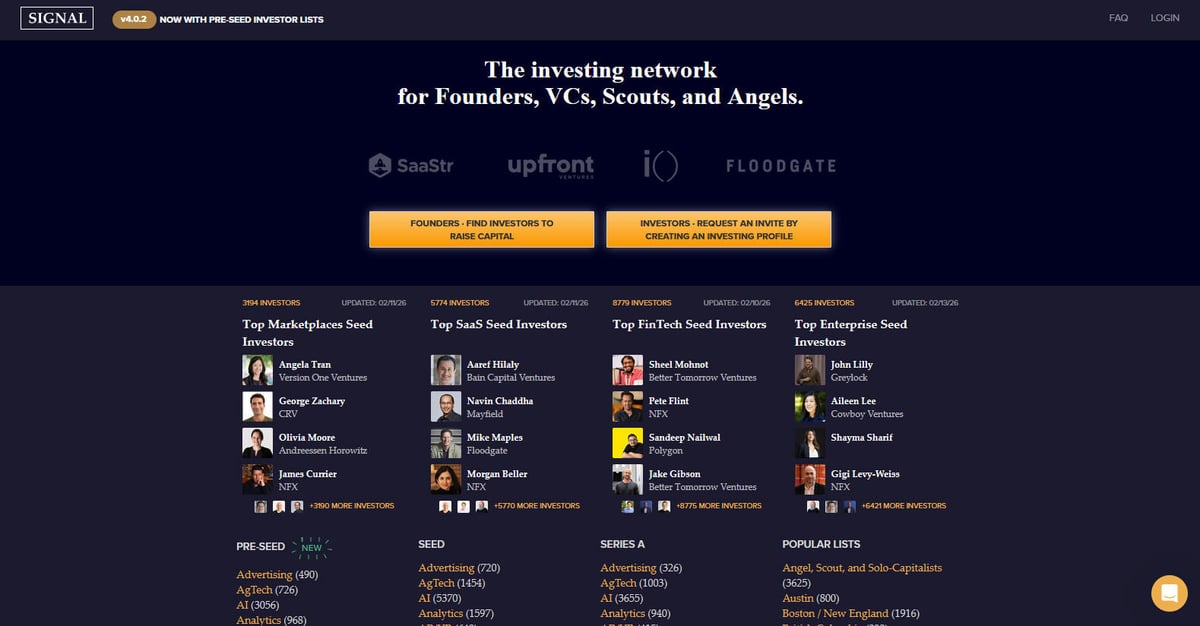

Signalは、ファウンダー、VC、スカウト、エンジェル投資家のために特別に設計された強力な投資ネットワークです。著名なシード期のベンチャーキャピタル企業であるNFXによって作成・運営されているこのプラットフォームは、スタートアップの資金調達を促進するための巨大なディレクトリおよびネットワーキングツールとして機能しています。投資家と起業家の間のつながりをマッピングすることで、手動のスプレッドシートを動的でデータ豊富な環境に置き換え、ベンチャーエコシステムの透明性を高めることを目的としています。

このプラットフォームには数千の投資家プロフィールが含まれており、優先する投資ステージ(Pre-SeedからSeries Bまで)、AI、SaaS、FinTechなどの業界セクター、および地理的地域によって分類されています。ユーザーは、ベンチャーキャピタル企業、個々のパートナー、および彼らの特定の投資フォーカスに関する詳細な情報を見つけることができ、これらは現在の市場状況を反映するために頻繁に更新されます。各掲載内容には、通常、投資家のフォーカス、優先する投資ステージ、特定の投資テーマ、および直接のファウンダー紹介に関する好みが記載されています。

Signalのスクレイピングは、数千のエントリを手動で閲覧することなく、ターゲットを絞った投資家リードリストを作成する必要があるファウンダーにとって非常に価値があります。また、ベンチャーキャピタルのトレンドを追跡する市場調査者、他のVC企業の競合インテリジェンス、および関係性や紹介のマッピングを通じてスタートアップエコシステムをターゲットとするセールスチームにとっても重要なデータを提供します。

なぜSignal (by NFX)をスクレイピングするのか?

Signal (by NFX)からのデータ抽出のビジネス価値とユースケースを発見してください。

ターゲットを絞った資金調達

特定の業界でシードまたはプレシードラウンドをリードする投資家の正確なリストを作成できます。

市場調査

Andreessen HorowitzやGreylockのようなトップティアのVCがどのセクターに最も注目しているかを分析できます。

リードジェネレーション

ラテンアメリカや東南アジアなどの特定の地域市場に参入している新しいVC企業や個別の投資家を特定できます。

競合インテリジェンス

競合するベンチャー企業のポートフォリオや注力分野を監視し、その拡大戦略を理解できます。

データの集約

学術的またはビジネス的な分析のために、ベンチャーキャピタルエコシステムの包括的な内部データベースを構築できます。

関係性のマッピング

つながりデータを抽出して、著名なVCへのウォームイントロダクションを得るための最短経路を見つけることができます。

スクレイピングの課題

Signal (by NFX)のスクレイピング時に遭遇する可能性のある技術的課題。

ログインの必要性

ほとんどの詳細な投資家情報はログイン壁の背後に隠されているため、セッション管理や自動認証が必要になります。

JavaScriptレンダリング

サイトは投資家リストに動的読み込み(無限スクロール)を使用しているため、JavaScriptを実行できるブラウザベースのスクレイパーが必要です。

アンチボット対策

Cloudflare WAFの使用やデータ取得のための特定のAPIエンドポイントにより、適切なヘッダーがない標準的なリクエストはブロックされる可能性があります。

レート制限

ネットワークの専門的かつ安全な性質上、高頻度のスクレイピングはIPバンやCAPTCHAを引き起こす可能性があります。

複雑なDOM構造

サイトは動的な要素やカスタムフロントエンドコンポーネントを使用しているため、信頼性の高いデータ抽出には安定したセレクターが必要です。

Signal (by NFX)をAIでスクレイピング

コーディング不要。AI搭載の自動化で数分でデータを抽出。

仕組み

必要なものを記述

Signal (by NFX)から抽出したいデータをAIに伝えてください。自然言語で入力するだけ — コードやセレクターは不要です。

AIがデータを抽出

人工知能がSignal (by NFX)をナビゲートし、動的コンテンツを処理し、あなたが求めたものを正確に抽出します。

データを取得

CSV、JSONでエクスポートしたり、アプリやワークフローに直接送信できる、クリーンで構造化されたデータを受け取ります。

なぜスクレイピングにAIを使うのか

AIを使えば、コードを書かずにSignal (by NFX)を簡単にスクレイピングできます。人工知能搭載のプラットフォームが必要なデータを理解します — 自然言語で記述するだけで、AIが自動的に抽出します。

How to scrape with AI:

- 必要なものを記述: Signal (by NFX)から抽出したいデータをAIに伝えてください。自然言語で入力するだけ — コードやセレクターは不要です。

- AIがデータを抽出: 人工知能がSignal (by NFX)をナビゲートし、動的コンテンツを処理し、あなたが求めたものを正確に抽出します。

- データを取得: CSV、JSONでエクスポートしたり、アプリやワークフローに直接送信できる、クリーンで構造化されたデータを受け取ります。

Why use AI for scraping:

- ノーコード設定: 認証やJavaScriptレンダリングのための複雑なスクリプトを書くことなく、視覚的にSignalスクレイパーを構築できます。

- 自動ログイン: 制限されたプロフィールにアクセスするために、Automatioのワークフロー内でSignalのログインプロセスを簡単に処理できます。

- 動的コンテンツの処理: 動的なリストや無限スクロール要素からのデータを自動的に待機し、抽出します。

- スケジュール実行: スクレイパーを毎週実行するように設定し、手動の介入なしで新しく追加された投資家や更新されたセクターリストを見つけることができます。

- データエクスポート: 投資家リードをGoogleスプレッドシート、CSV、またはWebhookに直接エクスポートして、即座にアウトリーチに活用できる直接統合機能。

Signal (by NFX)用ノーコードWebスクレイパー

AI搭載スクレイピングのポイント&クリック代替手段

Browse.ai、Octoparse、Axiom、ParseHubなどのノーコードツールは、コードを書かずにSignal (by NFX)をスクレイピングするのに役立ちます。これらのツールは視覚的なインターフェースを使用してデータを選択しますが、複雑な動的コンテンツやアンチボット対策には苦戦する場合があります。

ノーコードツールでの一般的なワークフロー

一般的な課題

学習曲線

セレクタと抽出ロジックの理解に時間がかかる

セレクタの破損

Webサイトの変更によりワークフロー全体が壊れる可能性がある

動的コンテンツの問題

JavaScript多用サイトは複雑な回避策が必要

CAPTCHAの制限

ほとんどのツールはCAPTCHAに手動介入が必要

IPブロック

過度なスクレイピングはIPのブロックにつながる可能性がある

Signal (by NFX)用ノーコードWebスクレイパー

Browse.ai、Octoparse、Axiom、ParseHubなどのノーコードツールは、コードを書かずにSignal (by NFX)をスクレイピングするのに役立ちます。これらのツールは視覚的なインターフェースを使用してデータを選択しますが、複雑な動的コンテンツやアンチボット対策には苦戦する場合があります。

ノーコードツールでの一般的なワークフロー

- ブラウザ拡張機能をインストールするかプラットフォームに登録する

- ターゲットWebサイトに移動してツールを開く

- ポイント&クリックで抽出するデータ要素を選択する

- 各データフィールドのCSSセレクタを設定する

- 複数ページをスクレイピングするためのページネーションルールを設定する

- CAPTCHAに対処する(多くの場合手動解決が必要)

- 自動実行のスケジュールを設定する

- データをCSV、JSONにエクスポートするかAPIで接続する

一般的な課題

- 学習曲線: セレクタと抽出ロジックの理解に時間がかかる

- セレクタの破損: Webサイトの変更によりワークフロー全体が壊れる可能性がある

- 動的コンテンツの問題: JavaScript多用サイトは複雑な回避策が必要

- CAPTCHAの制限: ほとんどのツールはCAPTCHAに手動介入が必要

- IPブロック: 過度なスクレイピングはIPのブロックにつながる可能性がある

コード例

import requests

from bs4 import BeautifulSoup

# Signalは完全なデータアクセスのためにログインが必要です。この例ではセッションを使用します。

session = requests.Session()

url = 'https://signal.nfx.com/investor-lists/top-marketplaces-seed-investors'

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/91.0.4472.124 Safari/537.36'

}

try:

# 実際のシナリオでは、最初にここでログイン資格情報をPOSTする必要があります

# session.post('https://signal.nfx.com/login', data={'email': '...', 'password': '...'})

response = session.get(url, headers=headers)

response.raise_for_status()

soup = BeautifulSoup(response.text, 'html.parser')

# リスト内の投資家カードを見つける

investors = soup.select('.investor-card')

for investor in investors:

name = investor.select_one('.name').get_text(strip=True)

firm = investor.select_one('.firm-name').get_text(strip=True)

print(f'Investor: {name} | Firm: {firm}')

except Exception as e:

print(f'Error scraping Signal: {e}')いつ使うか

JavaScriptが最小限の静的HTMLページに最適。ブログ、ニュースサイト、シンプルなEコマース製品ページに理想的。

メリット

- ●最速の実行(ブラウザオーバーヘッドなし)

- ●最小限のリソース消費

- ●asyncioで簡単に並列化

- ●APIと静的ページに最適

制限事項

- ●JavaScriptを実行できない

- ●SPAや動的コンテンツで失敗

- ●複雑なアンチボットシステムで苦戦する可能性

コードでSignal (by NFX)をスクレイピングする方法

Python + Requests

import requests

from bs4 import BeautifulSoup

# Signalは完全なデータアクセスのためにログインが必要です。この例ではセッションを使用します。

session = requests.Session()

url = 'https://signal.nfx.com/investor-lists/top-marketplaces-seed-investors'

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/91.0.4472.124 Safari/537.36'

}

try:

# 実際のシナリオでは、最初にここでログイン資格情報をPOSTする必要があります

# session.post('https://signal.nfx.com/login', data={'email': '...', 'password': '...'})

response = session.get(url, headers=headers)

response.raise_for_status()

soup = BeautifulSoup(response.text, 'html.parser')

# リスト内の投資家カードを見つける

investors = soup.select('.investor-card')

for investor in investors:

name = investor.select_one('.name').get_text(strip=True)

firm = investor.select_one('.firm-name').get_text(strip=True)

print(f'Investor: {name} | Firm: {firm}')

except Exception as e:

print(f'Error scraping Signal: {e}')Python + Playwright

from playwright.sync_api import sync_playwright

def scrape_signal():

with sync_playwright() as p:

browser = p.chromium.launch(headless=True)

page = browser.new_page()

# ログインページへ移動

page.goto('https://signal.nfx.com/login')

page.fill('input[name="email"]', 'your_email@example.com')

page.fill('input[name="password"]', 'your_password')

page.click('button:has-text("Log In")')

# ログイン後のリストページ読み込みを待機

page.wait_for_url('**/investors')

page.goto('https://signal.nfx.com/investor-lists/top-ai-seed-investors')

page.wait_for_selector('.investor-card')

# 無限スクロールをロードするためにスクロール

for _ in range(5):

page.mouse.wheel(0, 4000)

page.wait_for_timeout(2000)

investors = page.query_selector_all('.investor-card')

for investor in investors:

name = investor.query_selector('.name').inner_text()

print(f'Found Investor: {name}')

browser.close()

scrape_signal()Python + Scrapy

import scrapy

class SignalSpider(scrapy.Spider):

name = 'signal_spider'

# 注:JavaScriptレンダリングにはscrapy-playwrightが必要です

start_urls = ['https://signal.nfx.com/investor-lists/top-saas-seed-investors']

def start_requests(self):

for url in self.start_urls:

yield scrapy.Request(url, meta={'playwright': True})

def parse(self, response):

for investor in response.css('.investor-card'):

yield {

'name': investor.css('.name::text').get(),

'firm': investor.css('.firm-name::text').get(),

'link': response.urljoin(investor.css('a::attr(href)').get())

}

# 無限スクロールのScrapyロジックには、パースにレスポンスを返す前に

# 下にスクロールするためのカスタムPlaywrightハンドラーが必要ですNode.js + Puppeteer

const puppeteer = require('puppeteer');

(async () => {

const browser = await puppeteer.launch({ headless: true });

const page = await browser.newPage();

await page.setUserAgent('Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/91.0.4472.124 Safari/537.36');

// 最初にログインを処理

await page.goto('https://signal.nfx.com/login');

await page.type('#user_email', 'your_email');

await page.type('#user_password', 'your_password');

await page.click('.btn-primary');

await page.waitForNavigation();

await page.goto('https://signal.nfx.com/investor-lists/top-fintech-seed-investors');

await page.waitForSelector('.investor-card');

const investors = await page.evaluate(() => {

const items = Array.from(document.querySelectorAll('.investor-card'));

return items.map(item => ({

name: item.querySelector('.name')?.innerText.trim(),

firm: item.querySelector('.firm-name')?.innerText.trim()

}));

});

console.log(investors);

await browser.close();

})();Signal (by NFX)データで何ができるか

Signal (by NFX)データからの実用的なアプリケーションとインサイトを探索してください。

資金調達アウトリーチの自動化

ファウンダーは、データを活用して、自身の特定のステージやセクターに投資する可能性が最も高い投資家を特定し、優先順位を付けることができます。

実装方法:

- 1業界内の投資家リストをスクレイピングする(例:「Top AI Seed Investors」)。

- 2「Last Updated」で結果をフィルタリングし、現在資金提供を行っているアクティブな参加者を見つける。

- 3HubSpotやPipedriveなどのCRMにエクスポートして、アウトリーチの進捗を追跡する。

- 4プロフィールのリンクを使用して、ウォームイントロダクション(紹介)のための相互のつながりを特定する。

Automatioを使用してSignal (by NFX)からデータを抽出し、コードを書かずにこれらのアプリケーションを構築しましょう。

Signal (by NFX)データで何ができるか

- 資金調達アウトリーチの自動化

ファウンダーは、データを活用して、自身の特定のステージやセクターに投資する可能性が最も高い投資家を特定し、優先順位を付けることができます。

- 業界内の投資家リストをスクレイピングする(例:「Top AI Seed Investors」)。

- 「Last Updated」で結果をフィルタリングし、現在資金提供を行っているアクティブな参加者を見つける。

- HubSpotやPipedriveなどのCRMにエクスポートして、アウトリーチの進捗を追跡する。

- プロフィールのリンクを使用して、ウォームイントロダクション(紹介)のための相互のつながりを特定する。

- VC競合状況の分析

ベンチャー企業は、他の企業の注力分野やチームの拡大を監視することで、エコシステム内での競争力を維持できます。

- Signalの「Firms」セクションを定期的にスクレイピングして変更を追跡する。

- どの企業が新しい「スカウト」や「エンジェル」をネットワークに加えているかを特定する。

- セクターリストのカウントの変化を長期的にモニタリングすることで、投資フォーカスの推移を追跡する。

- 地域拡大戦略

新しい市場への参入を検討している企業や投資家は、特定の地域の主要な金融プレイヤーを特定できます。

- 「LatAm」、「Israel」、「MENA」などの地域固有のリストをスクレイピングする。

- 投資家を企業タイプ(VC vs エンジェル)で分類し、資本構成を理解する。

- 地域の資金調達環境をマッピングし、市場参入のための潜在的なリード投資家を特定する。

- 関係性と紹介のマッピング

ソーシャルなつながりを分析して、著名なVCへのウォームイントロダクションを得るための最短経路を見つけます。

- 投資家プロフィールから相互のつながりデータとソーシャルグラフ情報を抽出する。

- スクレイピングしたつながりを自身のLinkedInネットワークと照合する。

- 既存のネットワークノードの強さに基づいてアウトリーチの優先順位を付ける。

- 新興セクターの市場調査

ベンチャーグラフの中でどの新しい業界の密度が最も高まっているかを分析し、次のトレンドを予測します。

- 異なる資金調達ステージにおける特定のセクタータグとカウントをスクレイピングする。

- 特定のカテゴリに対する投資家の関心の伸びを四半期ごとに算出する。

- 「スマートマネー」が現在どこに流れているかについて、ステークホルダー向けのレポートを作成する。

ワークフローを強化する AI自動化

AutomatioはAIエージェント、ウェブ自動化、スマート統合のパワーを組み合わせ、より短時間でより多くのことを達成するお手伝いをします。

Signal (by NFX)スクレイピングのプロのヒント

Signal (by NFX)からデータを正常に抽出するための専門家のアドバイス。

セッション管理

完全なプロフィールを表示するにはログインが必要なため、セキュリティアラートを回避するために、ログイン状態のCookieを取得して再利用し、繰り返しのログイン試行を避けてください。

プロキシの選択

高品質なレジデンシャルプロキシを使用してください。データセンターのIPは、プロフェッショナル向けネットワーク上のCloudflareのボット保護によってフラグを立てられやすい傾向があります。

Robots.txtの遵守

Signalのrobots.txtファイルを確認して、制限されているパスを把握し、スロットリングを避けるために適切なクロール遅延(crawl delay)を設定してください。

人間のような挙動のシミュレーション

検出を回避するために、ページ読み込みの間にランダムな2〜5秒の遅延を追加し、マウスの動きやスクロールをシミュレートしてください。

オフピーク時のスクレイピング

負荷を軽減し、検出確率を下げるために、週末などのトラフィックが少ない時間帯に大規模なスクレイピングを実行してください。

セレクターの安定性

Signalの内部クラス名はデプロイごとに変更される可能性があるため、安定したIDパターンや、利用可能な場合はデータ属性(data-testidなど)を探してください。

お客様の声

ユーザーの声

ワークフローを変革した何千人もの満足したユーザーに加わりましょう

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

関連 Web Scraping

How to Scrape Bilregistret.ai: Swedish Vehicle Data Extraction Guide

How to Scrape Biluppgifter.se: Vehicle Data Extraction Guide

How to Scrape CSS Author: A Comprehensive Web Scraping Guide

How to Scrape The AA (theaa.com): A Technical Guide for Car & Insurance Data

How to Scrape GoAbroad Study Abroad Programs

How to Scrape Car.info | Vehicle Data & Valuation Extraction Guide

How to Scrape ResearchGate: Publication and Researcher Data

How to Scrape Statista: The Ultimate Guide to Market Data Extraction

Signal (by NFX)についてのよくある質問

Signal (by NFX)に関するよくある質問への回答を見つけてください