Hoe Animal Corner te scrapen | Wildlife & Natuur Data Scraper

Extraheer feiten over dieren, wetenschappelijke namen en habitatdata van Animal Corner. Leer hoe je een gestructureerde wildlife-database bouwt voor onderzoek...

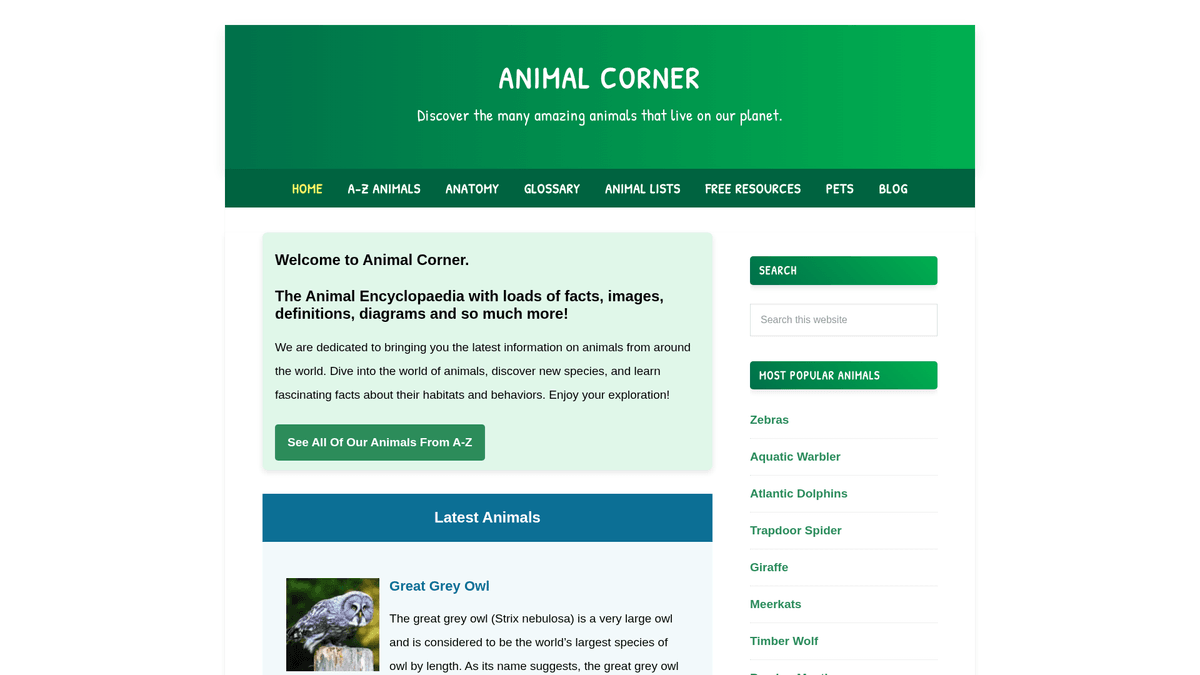

Over Animal Corner

Ontdek wat Animal Corner biedt en welke waardevolle gegevens kunnen worden geëxtraheerd.

Animal Corner is een uitgebreide online encyclopedie die zich richt op het bieden van een schat aan informatie over het dierenrijk. Het dient als een gestructureerde educatieve bron voor studenten, docenten en natuurliefhebbers, met gedetailleerde profielen van een breed scala aan soorten, variërend van gewone huisdieren tot bedreigde wilde dieren. Het platform organiseert de content in logische categorieën zoals zoogdieren, vogels, reptielen, vissen, amfibieën en ongewervelden.

Elke vermelding op de site bevat essentiële biologische data, waaronder algemene en wetenschappelijke namen, fysieke kenmerken, voedingsgewoonten en geografische verspreiding. Voor ontwikkelaars en onderzoekers is deze data ontzettend waardevol voor het maken van gestructureerde datasets die educatieve applicaties kunnen voeden, machine learning models kunnen trainen voor de identificatie van soorten, of grootschalige ecologische studies kunnen ondersteunen. Omdat de site regelmatig wordt bijgewerkt met nieuwe soorten en beschermingsstatussen, blijft het een primaire bron voor biodiversiteitsliefhebbers.

Waarom Animal Corner Scrapen?

Ontdek de zakelijke waarde en gebruiksmogelijkheden voor data-extractie van Animal Corner.

Creëer een gestructureerde biodiversiteitsdatabase voor academisch onderzoek

Verzamel data van hoge kwaliteit voor mobiele apps voor wildlife-identificatie

Verzamel feiten voor educatieve blogs en platforms met een natuurthema

Monitor updates over de beschermingsstatus van soorten in verschillende regio's

Verzamel anatomische data voor vergelijkende biologische studies

Bouw trainingsdatasets voor NLP models die zich richten op biologische beschrijvingen

Scraping Uitdagingen

Technische uitdagingen die u kunt tegenkomen bij het scrapen van Animal Corner.

Het parsen van beschrijvende tekst naar gestructureerde, granulaire datapunten

Het omgaan met inconsistente beschikbaarheid van datavelden tussen verschillende groepen soorten

Het efficiënt navigeren en crawlen van duizenden individuele URLs van soorten

Het extraheren van wetenschappelijke namen die vaak begraven liggen in tekst tussen haakjes

Het beheren van interne links en mediareferenties binnen beschrijvende paragrafen

Scrape Animal Corner met AI

Geen code nodig. Extraheer gegevens in minuten met AI-aangedreven automatisering.

Hoe het werkt

Beschrijf wat je nodig hebt

Vertel de AI welke gegevens je wilt extraheren van Animal Corner. Typ het gewoon in natuurlijke taal — geen code of selectors nodig.

AI extraheert de gegevens

Onze kunstmatige intelligentie navigeert Animal Corner, verwerkt dynamische content en extraheert precies wat je hebt gevraagd.

Ontvang je gegevens

Ontvang schone, gestructureerde gegevens klaar om te exporteren als CSV, JSON of direct naar je applicaties te sturen.

Waarom AI gebruiken voor scraping

AI maakt het eenvoudig om Animal Corner te scrapen zonder code te schrijven. Ons AI-aangedreven platform gebruikt kunstmatige intelligentie om te begrijpen welke gegevens je wilt — beschrijf het in natuurlijke taal en de AI extraheert ze automatisch.

How to scrape with AI:

- Beschrijf wat je nodig hebt: Vertel de AI welke gegevens je wilt extraheren van Animal Corner. Typ het gewoon in natuurlijke taal — geen code of selectors nodig.

- AI extraheert de gegevens: Onze kunstmatige intelligentie navigeert Animal Corner, verwerkt dynamische content en extraheert precies wat je hebt gevraagd.

- Ontvang je gegevens: Ontvang schone, gestructureerde gegevens klaar om te exporteren als CSV, JSON of direct naar je applicaties te sturen.

Why use AI for scraping:

- No-code visuele selectie van complexe blokken met feiten over dieren

- Automatisch crawlen van categorie- en A-Z-indexpagina's zonder scripting

- Behandelt het opschonen en formatteren van tekst rechtstreeks in de tool

- Geplande runs om updates van de status van bedreigde soorten vast te leggen

- Directe export naar Google Sheets of JSON voor directe app-integratie

No-Code Web Scrapers voor Animal Corner

Point-and-click alternatieven voor AI-aangedreven scraping

Verschillende no-code tools zoals Browse.ai, Octoparse, Axiom en ParseHub kunnen u helpen Animal Corner te scrapen zonder code te schrijven. Deze tools gebruiken visuele interfaces om data te selecteren, hoewel ze moeite kunnen hebben met complexe dynamische content of anti-bot maatregelen.

Typische Workflow met No-Code Tools

Veelvoorkomende Uitdagingen

Leercurve

Het begrijpen van selectors en extractielogica kost tijd

Selectors breken

Websitewijzigingen kunnen je hele workflow kapotmaken

Problemen met dynamische content

JavaScript-zware sites vereisen complexe oplossingen

CAPTCHA-beperkingen

De meeste tools vereisen handmatige interventie voor CAPTCHAs

IP-blokkering

Agressief scrapen kan leiden tot blokkering van je IP

No-Code Web Scrapers voor Animal Corner

Verschillende no-code tools zoals Browse.ai, Octoparse, Axiom en ParseHub kunnen u helpen Animal Corner te scrapen zonder code te schrijven. Deze tools gebruiken visuele interfaces om data te selecteren, hoewel ze moeite kunnen hebben met complexe dynamische content of anti-bot maatregelen.

Typische Workflow met No-Code Tools

- Browserextensie installeren of registreren op het platform

- Navigeren naar de doelwebsite en de tool openen

- Data-elementen selecteren met point-and-click

- CSS-selectors configureren voor elk dataveld

- Paginatieregels instellen voor het scrapen van meerdere pagina's

- CAPTCHAs afhandelen (vereist vaak handmatige oplossing)

- Planning configureren voor automatische uitvoering

- Data exporteren naar CSV, JSON of verbinden via API

Veelvoorkomende Uitdagingen

- Leercurve: Het begrijpen van selectors en extractielogica kost tijd

- Selectors breken: Websitewijzigingen kunnen je hele workflow kapotmaken

- Problemen met dynamische content: JavaScript-zware sites vereisen complexe oplossingen

- CAPTCHA-beperkingen: De meeste tools vereisen handmatige interventie voor CAPTCHAs

- IP-blokkering: Agressief scrapen kan leiden tot blokkering van je IP

Codevoorbeelden

import requests

from bs4 import BeautifulSoup

# Target URL for a specific animal

url = 'https://animalcorner.org/animals/african-elephant/'

# Standard headers to mimic a real browser

headers = {'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/91.0.4472.124 Safari/537.36'}

try:

response = requests.get(url, headers=headers)

response.raise_for_status()

soup = BeautifulSoup(response.text, 'html.parser')

# Extracting animal name

title = soup.find('h1').text.strip()

print(f'Animal: {title}')

# Extracting first paragraph which usually contains the scientific name

intro = soup.find('p').text.strip()

print(f'Intro Facts: {intro[:150]}...')

except requests.exceptions.RequestException as e:

print(f'Error scraping Animal Corner: {e}')Wanneer Gebruiken

Ideaal voor statische HTML-pagina's met minimale JavaScript. Perfect voor blogs, nieuwssites en eenvoudige e-commerce productpagina's.

Voordelen

- ●Snelste uitvoering (geen browser overhead)

- ●Laagste resourceverbruik

- ●Makkelijk te paralleliseren met asyncio

- ●Uitstekend voor API's en statische pagina's

Beperkingen

- ●Kan geen JavaScript uitvoeren

- ●Faalt op SPA's en dynamische content

- ●Kan moeite hebben met complexe anti-bot systemen

Hoe Animal Corner te Scrapen met Code

Python + Requests

import requests

from bs4 import BeautifulSoup

# Target URL for a specific animal

url = 'https://animalcorner.org/animals/african-elephant/'

# Standard headers to mimic a real browser

headers = {'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/91.0.4472.124 Safari/537.36'}

try:

response = requests.get(url, headers=headers)

response.raise_for_status()

soup = BeautifulSoup(response.text, 'html.parser')

# Extracting animal name

title = soup.find('h1').text.strip()

print(f'Animal: {title}')

# Extracting first paragraph which usually contains the scientific name

intro = soup.find('p').text.strip()

print(f'Intro Facts: {intro[:150]}...')

except requests.exceptions.RequestException as e:

print(f'Error scraping Animal Corner: {e}')Python + Playwright

from playwright.sync_api import sync_playwright

def scrape_animal_corner():

with sync_playwright() as p:

# Launch headless browser

browser = p.chromium.launch(headless=True)

page = browser.new_page()

page.goto('https://animalcorner.org/animals/african-elephant/')

# Wait for the main heading to load

title = page.inner_text('h1')

print(f'Animal Name: {title}')

# Extract specific fact paragraphs

facts = page.query_selector_all('p')

for fact in facts[:3]:

print(f'Fact: {fact.inner_text()}')

browser.close()

if __name__ == "__main__":

scrape_animal_corner()Python + Scrapy

import scrapy

class AnimalSpider(scrapy.Spider):

name = 'animal_spider'

start_urls = ['https://animalcorner.org/animals/']

def parse(self, response):

# Follow links to individual animal pages within the directory

for animal_link in response.css('a[href*="/animals/"]::attr(href)').getall():

yield response.follow(animal_link, self.parse_animal)

def parse_animal(self, response):

# Extract structured data from animal profiles

yield {

'common_name': response.css('h1::text').get().strip(),

'scientific_name': response.xpath('//p[contains(., "(")]/text()').re_first(r'\((.*?)\)'),

'description': ' '.join(response.css('p::text').getall()[:5])

}Node.js + Puppeteer

const puppeteer = require('puppeteer');

(async () => {

const browser = await puppeteer.launch();

const page = await browser.newPage();

await page.goto('https://animalcorner.org/animals/african-elephant/');

const data = await page.evaluate(() => {

// Extract the title and introductory paragraph

return {

title: document.querySelector('h1').innerText.trim(),

firstParagraph: document.querySelector('p').innerText.trim()

};

});

console.log('Extracted Data:', data);

await browser.close();

})();Wat U Kunt Doen Met Animal Corner Data

Verken praktische toepassingen en inzichten uit Animal Corner data.

Educatieve Flashcard App

Maak een mobiele leerapplicatie die feiten over dieren en afbeeldingen van hoge kwaliteit gebruikt om studenten over biodiversiteit te leren.

Hoe te implementeren:

- 1Scrape dierennamen, fysieke kenmerken en uitgelichte afbeeldingen

- 2Categoriseer dieren op moeilijkheidsgraad of biologische groep

- 3Ontwerp een interactieve quiz-interface met de verzamelde data

- 4Implementeer voortgangsregistratie om gebruikers te helpen bij het beheersen van de identificatie van soorten

Gebruik Automatio om data van Animal Corner te extraheren en deze applicaties te bouwen zonder code te schrijven.

Wat U Kunt Doen Met Animal Corner Data

- Educatieve Flashcard App

Maak een mobiele leerapplicatie die feiten over dieren en afbeeldingen van hoge kwaliteit gebruikt om studenten over biodiversiteit te leren.

- Scrape dierennamen, fysieke kenmerken en uitgelichte afbeeldingen

- Categoriseer dieren op moeilijkheidsgraad of biologische groep

- Ontwerp een interactieve quiz-interface met de verzamelde data

- Implementeer voortgangsregistratie om gebruikers te helpen bij het beheersen van de identificatie van soorten

- Zoölogische Onderzoeksdataset

Bied een gestructureerde dataset voor onderzoekers die anatomische statistieken over verschillende families van soorten vergelijken.

- Extraheer specifieke numerieke statistieken zoals hartslag en draagtijd

- Normaliseer meeteenheden (bijv. kilogram, meter) met behulp van data cleaning

- Organiseer de data op wetenschappelijke classificatie (Orde, Familie, Geslacht)

- Exporteer de uiteindelijke dataset naar CSV voor geavanceerde statistische analyse

- Natuurblog Auto-Poster

Genereer automatisch dagelijkse content voor sociale media of blogs met 'Dier van de Dag' feiten.

- Scrape een grote hoeveelheid interessante feiten over dieren uit de encyclopedie

- Plan een script om elke 24 uur een willekeurig dierprofiel te selecteren

- Formatteer de geëxtraheerde tekst in een aantrekkelijk post-template

- Gebruik sociale media APIs om de content te publiceren met de afbeelding van het dier

- Beschermingsmonitoringtool

Bouw een dashboard dat dieren benadrukt die momenteel als 'Bedreigd' of 'Kwetsbaar' op de lijst staan.

- Scrape soortnamen samen met hun specifieke beschermingsstatus

- Filter de database om diercategorieën met een hoog risico te isoleren

- Breng deze soorten in kaart in hun gerapporteerde geografische regio's

- Stel periodieke scraping-runs in om veranderingen in de beschermingsstatus te volgen

Supercharge je workflow met AI-automatisering

Automatio combineert de kracht van AI-agents, webautomatisering en slimme integraties om je te helpen meer te bereiken in minder tijd.

Pro Tips voor het Scrapen van Animal Corner

Expertadvies voor het succesvol extraheren van gegevens uit Animal Corner.

Begin je crawl op de A-Z-lijstpagina om een volledige dekking van alle soorten te garanderen

Gebruik regular expressions om wetenschappelijke namen te extraheren die vaak tussen haakjes bij de algemene naam staan

Stel een crawl delay in van 1-2 seconden tussen verzoeken om de resources van de site te respecteren en rate limits te vermijden

Richt je op specifieke categorie-submappen zoals /mammals/ of /birds/ als je alleen nichegegevens nodig hebt

Download en bewaar afbeeldingen van dieren lokaal in plaats van ze te hotlinken om de stabiliteit van je applicatie te behouden

Schoon de beschrijvende tekst op door interne wiki-stijl links te verwijderen voor een soepelere leeservaring

Testimonials

Wat onze gebruikers zeggen

Sluit je aan bij duizenden tevreden gebruikers die hun workflow hebben getransformeerd

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Gerelateerd Web Scraping

How to Scrape Bilregistret.ai: Swedish Vehicle Data Extraction Guide

How to Scrape Biluppgifter.se: Vehicle Data Extraction Guide

How to Scrape The AA (theaa.com): A Technical Guide for Car & Insurance Data

How to Scrape CSS Author: A Comprehensive Web Scraping Guide

How to Scrape Car.info | Vehicle Data & Valuation Extraction Guide

How to Scrape GoAbroad Study Abroad Programs

How to Scrape ResearchGate: Publication and Researcher Data

How to Scrape Statista: The Ultimate Guide to Market Data Extraction

Veelgestelde vragen over Animal Corner

Vind antwoorden op veelvoorkomende vragen over Animal Corner