Hoe jup.ag te scrapen: Jupiter DEX Web Scraper Gids

Leer hoe je jup.ag kunt scrapen voor real-time Solana token prijzen, swap routes en marktvolumes. Ontdek Jupiter's officiële API's en omzeil Cloudflare...

Anti-Bot Beveiliging Gedetecteerd

- Cloudflare

- Enterprise WAF en botbeheer. Gebruikt JavaScript-uitdagingen, CAPTCHAs en gedragsanalyse. Vereist browserautomatisering met stealth-instellingen.

- Snelheidsbeperking

- Beperkt verzoeken per IP/sessie over tijd. Kan worden omzeild met roterende proxy's, verzoekvertragingen en gedistribueerde scraping.

- Browserfingerprinting

- Identificeert bots via browserkenmerken: canvas, WebGL, lettertypen, plugins. Vereist spoofing of echte browserprofielen.

- Browserfingerprinting

- Identificeert bots via browserkenmerken: canvas, WebGL, lettertypen, plugins. Vereist spoofing of echte browserprofielen.

Over Jupiter

Ontdek wat Jupiter biedt en welke waardevolle gegevens kunnen worden geëxtraheerd.

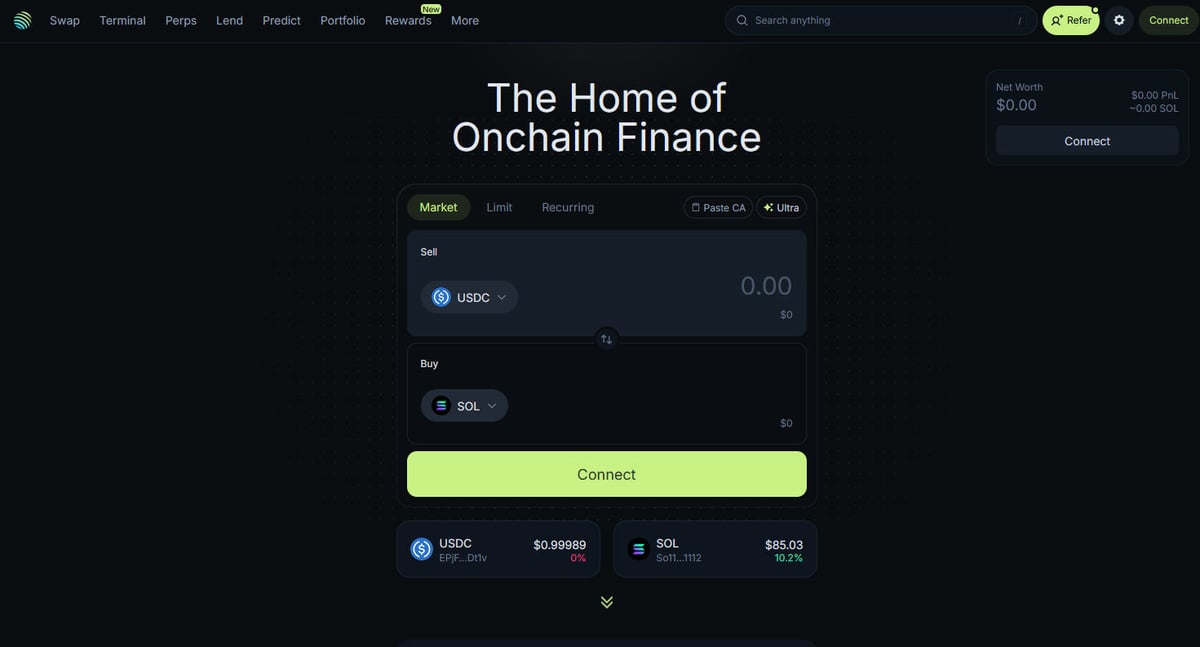

Het Hart van Solana DeFi

Jupiter is de primaire liquidity aggregator voor de Solana blockchain en fungeert als een "DeFi Superapp" die trade routing optimaliseert over honderden liquidity pools om gebruikers de beste prijzen en minimale slippage te bieden. Het is het centrale knooppunt voor Solana's on-chain finance en biedt diensten variërend van eenvoudige token swaps tot geavanceerde functies zoals perpetual trading met tot 250x leverage, limit orders en dollar-cost averaging (DCA). Het platform biedt cruciale data voor het ecosysteem, waaronder real-time pricing, liquidity depth en uitgebreide marktstatistieken voor duizenden assets.

Technische Architectuur

De website is gebouwd op een moderne technische stack met Next.js en React, waardoor het een zeer dynamische single-page application (SPA) is. Omdat prijzen en routes in real-time worden berekend op basis van de huidige blockchain-status, wordt de frontend constant bijgewerkt via WebSockets en high-frequency API calls. Voor data scientists, developers en traders wordt de data van Jupiter beschouwd als de gouden standaard voor het volgen van het Solana-marktsentiment en liquiditeitsverschuivingen in het hele ecosysteem.

Waarom de Data Belangrijk is

Toegang tot deze data is essentieel voor het bouwen van trading bots, marktdashboards en het uitvoeren van historische analyses op een van de snelst groeiende blockchain-netwerken. Scrapers richten zich vaak op Jupiter om nieuwe token listings te monitoren, "whale"-bewegingen in perpetual markten te volgen of prijsverschillen voor arbitrage te identificeren. Hoewel het platform officiële API's aanbiedt, wordt directe web scraping vaak gebruikt om de exacte UI-status en specifieke routing-data vast te leggen die mogelijk niet volledig worden weergegeven in publieke endpoints.

Waarom Jupiter Scrapen?

Ontdek de zakelijke waarde en gebruiksmogelijkheden voor data-extractie van Jupiter.

Real-time prijsmonitoring voor Solana tokens

Ontwikkelen van arbitrage trading bots tussen DEX'en

Volgen van marktvolume en liquiditeitstrends

Identificeren van nieuwe token listings en marktsentiment

Aggregeren van lending yields en perpetual funding rates

Analyseren van historische prijsimpact voor grote trades

Scraping Uitdagingen

Technische uitdagingen die u kunt tegenkomen bij het scrapen van Jupiter.

Agressieve Cloudflare anti-bot bescherming

Vereiste voor volledige JavaScript rendering (React/Next.js)

Agressieve IP-gebaseerde rate limiting op publieke endpoints

Dynamische en geobfusceerde CSS-selectors in de UI

Hoge snelheid van data-updates die low-latency verbindingen vereisen

Scrape Jupiter met AI

Geen code nodig. Extraheer gegevens in minuten met AI-aangedreven automatisering.

Hoe het werkt

Beschrijf wat je nodig hebt

Vertel de AI welke gegevens je wilt extraheren van Jupiter. Typ het gewoon in natuurlijke taal — geen code of selectors nodig.

AI extraheert de gegevens

Onze kunstmatige intelligentie navigeert Jupiter, verwerkt dynamische content en extraheert precies wat je hebt gevraagd.

Ontvang je gegevens

Ontvang schone, gestructureerde gegevens klaar om te exporteren als CSV, JSON of direct naar je applicaties te sturen.

Waarom AI gebruiken voor scraping

AI maakt het eenvoudig om Jupiter te scrapen zonder code te schrijven. Ons AI-aangedreven platform gebruikt kunstmatige intelligentie om te begrijpen welke gegevens je wilt — beschrijf het in natuurlijke taal en de AI extraheert ze automatisch.

How to scrape with AI:

- Beschrijf wat je nodig hebt: Vertel de AI welke gegevens je wilt extraheren van Jupiter. Typ het gewoon in natuurlijke taal — geen code of selectors nodig.

- AI extraheert de gegevens: Onze kunstmatige intelligentie navigeert Jupiter, verwerkt dynamische content en extraheert precies wat je hebt gevraagd.

- Ontvang je gegevens: Ontvang schone, gestructureerde gegevens klaar om te exporteren als CSV, JSON of direct naar je applicaties te sturen.

Why use AI for scraping:

- No-code data-extractie uit dynamische SPA's

- Automatische afhandeling van Cloudflare en browser-fingerprints

- Geplande extractie voor continue marktmonitoring

- Directe data-export naar Webhooks of Google Sheets

No-Code Web Scrapers voor Jupiter

Point-and-click alternatieven voor AI-aangedreven scraping

Verschillende no-code tools zoals Browse.ai, Octoparse, Axiom en ParseHub kunnen u helpen Jupiter te scrapen zonder code te schrijven. Deze tools gebruiken visuele interfaces om data te selecteren, hoewel ze moeite kunnen hebben met complexe dynamische content of anti-bot maatregelen.

Typische Workflow met No-Code Tools

Veelvoorkomende Uitdagingen

Leercurve

Het begrijpen van selectors en extractielogica kost tijd

Selectors breken

Websitewijzigingen kunnen je hele workflow kapotmaken

Problemen met dynamische content

JavaScript-zware sites vereisen complexe oplossingen

CAPTCHA-beperkingen

De meeste tools vereisen handmatige interventie voor CAPTCHAs

IP-blokkering

Agressief scrapen kan leiden tot blokkering van je IP

No-Code Web Scrapers voor Jupiter

Verschillende no-code tools zoals Browse.ai, Octoparse, Axiom en ParseHub kunnen u helpen Jupiter te scrapen zonder code te schrijven. Deze tools gebruiken visuele interfaces om data te selecteren, hoewel ze moeite kunnen hebben met complexe dynamische content of anti-bot maatregelen.

Typische Workflow met No-Code Tools

- Browserextensie installeren of registreren op het platform

- Navigeren naar de doelwebsite en de tool openen

- Data-elementen selecteren met point-and-click

- CSS-selectors configureren voor elk dataveld

- Paginatieregels instellen voor het scrapen van meerdere pagina's

- CAPTCHAs afhandelen (vereist vaak handmatige oplossing)

- Planning configureren voor automatische uitvoering

- Data exporteren naar CSV, JSON of verbinden via API

Veelvoorkomende Uitdagingen

- Leercurve: Het begrijpen van selectors en extractielogica kost tijd

- Selectors breken: Websitewijzigingen kunnen je hele workflow kapotmaken

- Problemen met dynamische content: JavaScript-zware sites vereisen complexe oplossingen

- CAPTCHA-beperkingen: De meeste tools vereisen handmatige interventie voor CAPTCHAs

- IP-blokkering: Agressief scrapen kan leiden tot blokkering van je IP

Codevoorbeelden

import requests

def get_jupiter_price(token_address):

# Het gebruik van de officiële Jupiter Price API V2 is de meest betrouwbare methode

url = f"https://api.jup.ag/price/v2?ids={token_address}"

headers = {

"User-Agent": "Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/120.0.0.0 Safari/537.36",

"Accept": "application/json"

}

try:

response = requests.get(url, headers=headers)

response.raise_for_status()

data = response.json()

price_info = data['data'].get(token_address)

if price_info:

print(f"Token: {token_address} | Prijs: ${price_info['price']}")

except Exception as e:

print(f"Er is een fout opgetreden: {e}")

# Voorbeeld: Ophalen van SOL prijs

get_jupiter_price("So11111111111111111111111111111111111111112")Wanneer Gebruiken

Ideaal voor statische HTML-pagina's met minimale JavaScript. Perfect voor blogs, nieuwssites en eenvoudige e-commerce productpagina's.

Voordelen

- ●Snelste uitvoering (geen browser overhead)

- ●Laagste resourceverbruik

- ●Makkelijk te paralleliseren met asyncio

- ●Uitstekend voor API's en statische pagina's

Beperkingen

- ●Kan geen JavaScript uitvoeren

- ●Faalt op SPA's en dynamische content

- ●Kan moeite hebben met complexe anti-bot systemen

Hoe Jupiter te Scrapen met Code

Python + Requests

import requests

def get_jupiter_price(token_address):

# Het gebruik van de officiële Jupiter Price API V2 is de meest betrouwbare methode

url = f"https://api.jup.ag/price/v2?ids={token_address}"

headers = {

"User-Agent": "Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/120.0.0.0 Safari/537.36",

"Accept": "application/json"

}

try:

response = requests.get(url, headers=headers)

response.raise_for_status()

data = response.json()

price_info = data['data'].get(token_address)

if price_info:

print(f"Token: {token_address} | Prijs: ${price_info['price']}")

except Exception as e:

print(f"Er is een fout opgetreden: {e}")

# Voorbeeld: Ophalen van SOL prijs

get_jupiter_price("So11111111111111111111111111111111111111112")Python + Playwright

from playwright.sync_api import sync_playwright

def scrape_jupiter_tokens():

with sync_playwright() as p:

# Start een browser die de Next.js frontend kan renderen

browser = p.chromium.launch(headless=True)

context = browser.new_context(

user_agent="Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/120.0.0.0 Safari/537.36"

)

page = context.new_page()

page.goto("https://jup.ag/tokens", wait_until="networkidle")

# Wacht tot de tokenlijst-items zijn gerenderd in de DOM

# Let op: Selectors moeten worden bijgewerkt op basis van de huidige UI build

page.wait_for_selector(".token-item")

tokens = page.query_selector_all(".token-item")

for token in tokens[:10]:

name = token.query_selector(".token-name").inner_text()

price = token.query_selector(".token-price").inner_text()

print(f"{name}: {price}")

browser.close()

scrape_jupiter_tokens()Python + Scrapy

import scrapy

import json

class JupiterTokenSpider(scrapy.Spider):

name = 'jupiter_tokens'

# Direct benaderen van het token list JSON endpoint dat door de frontend wordt gebruikt

start_urls = ['https://token.jup.ag/all']

def parse(self, response):

# De response is een ruwe JSON-lijst van alle geverifieerde tokens

tokens = json.loads(response.text)

for token in tokens[:100]:

yield {

'symbol': token.get('symbol'),

'name': token.get('name'),

'address': token.get('address'),

'decimals': token.get('decimals'),

'logoURI': token.get('logoURI')

}Node.js + Puppeteer

const puppeteer = require('puppeteer');

(async () => {

const browser = await puppeteer.launch({ headless: true });

const page = await browser.newPage();

// Stel een realistische User-Agent in om basisfilters te helpen omzeilen

await page.setUserAgent('Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/120.0.0.0 Safari/537.36');

// Navigeer naar de hoofd swap-pagina

await page.goto('https://jup.ag/', { waitUntil: 'networkidle2' });

// Voorbeeld van het extraheren van een prijselement met een gedeeltelijke selector

const solPrice = await page.evaluate(() => {

const element = document.querySelector('div[class*="price"]');

return element ? element.innerText : 'Prijs niet gevonden';

});

console.log(`Live SOL-prijs waargenomen in UI: ${solPrice}`);

await browser.close();

})();Wat U Kunt Doen Met Jupiter Data

Verken praktische toepassingen en inzichten uit Jupiter data.

Prijs Arbitrage Meldingssysteem

Identificeer prijsverschillen tussen Jupiter en andere Solana DEX'en om winstgevende trades uit te voeren.

Hoe te implementeren:

- 1Scrape real-time swap-koersen van de Jupiter Price API.

- 2Vergelijk koersen met Orca en Raydium liquidity pools.

- 3Stel geautomatiseerde meldingen of execution hooks in voor arbitrage-mogelijkheden.

Gebruik Automatio om data van Jupiter te extraheren en deze applicaties te bouwen zonder code te schrijven.

Wat U Kunt Doen Met Jupiter Data

- Prijs Arbitrage Meldingssysteem

Identificeer prijsverschillen tussen Jupiter en andere Solana DEX'en om winstgevende trades uit te voeren.

- Scrape real-time swap-koersen van de Jupiter Price API.

- Vergelijk koersen met Orca en Raydium liquidity pools.

- Stel geautomatiseerde meldingen of execution hooks in voor arbitrage-mogelijkheden.

- Solana Market Health Dashboard

Bouw een macro-overzicht van Solana DeFi-activiteit voor investeerders.

- Aggregeer 24-uurs volume en TVL-data voor top-tokens.

- Categoriseer tokens per sector (Meme, AI, RWA).

- Visualiseer liquiditeitsverschuivingen tussen verschillende activaklassen over de tijd.

- New Token Listing Sniper

Detecteer en analyseer onmiddellijk nieuwe tokens die op de geverifieerde lijst van Jupiter verschijnen.

- Scrape regelmatig het token list endpoint.

- Vergelijk de nieuwe resultaten met een lokale database om nieuwe toevoegingen te vinden.

- Analyseer initiële liquiditeit en volume om het potentieel van de token te beoordelen.

- Whale en Perps Tracker

Monitor grote posities en funding rates in de Jupiter Perpetuals markt.

- Scrape open interest en funding rate data uit de Perps-sectie.

- Volg grote transactielogboeken om wallet-gedrag te identificeren.

- Bouw sentiment-modellen op basis van long/short ratio's van belangrijke assets.

- Yield Aggregation Service

Bied gebruikers de beste rentetarieven die beschikbaar zijn in de Jupiter Lend vaults.

- Scrape APY-data voor verschillende stablecoins en SOL-paren.

- Bereken het netto rendement na geschatte platformkosten.

- Automateer rebalancing-aanbevelingen voor portfolio-optimalisatie.

Supercharge je workflow met AI-automatisering

Automatio combineert de kracht van AI-agents, webautomatisering en slimme integraties om je te helpen meer te bereiken in minder tijd.

Pro Tips voor het Scrapen van Jupiter

Expertadvies voor het succesvol extraheren van gegevens uit Jupiter.

Prioriteer altijd de officiële API op api.jup.ag voordat je probeert de HTML frontend te scrapen.

Gebruik residential proxies om Cloudflare-blokkades te minimaliseren, aangezien datacenter IP's vaak op de zwarte lijst staan.

Schakel HTTP2 in je scraper in om overeen te komen met standaard browser-fingerprints en detectie te voorkomen.

Inspecteer WebSocket-verbindingen (wss

//) in het netwerk-tabblad voor de meest efficiënte real-time price streaming.

Implementeer robuuste foutafhandeling voor 403 Forbidden-responses, wat duidt op Cloudflare-blokkering.

Richt je op het https

//token.jup.ag/all endpoint als je alleen de statische lijst met geverifieerde token-adressen nodig hebt.

Testimonials

Wat onze gebruikers zeggen

Sluit je aan bij duizenden tevreden gebruikers die hun workflow hebben getransformeerd

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Gerelateerd Web Scraping

How to Scrape Moon.ly | Step-by-Step NFT Data Extraction Guide

How to Scrape Yahoo Finance: Extract Stock Market Data

How to Scrape Rocket Mortgage: A Comprehensive Guide

How to Scrape Open Collective: Financial and Contributor Data Guide

How to Scrape Indiegogo: The Ultimate Crowdfunding Data Extraction Guide

How to Scrape ICO Drops: Comprehensive Crypto Data Guide

How to Scrape Crypto.com: Comprehensive Market Data Guide

How to Scrape Coinpaprika: Crypto Market Data Extraction Guide

Veelgestelde vragen over Jupiter

Vind antwoorden op veelvoorkomende vragen over Jupiter