Jak scrapować Animal Corner | Scraper danych o dzikiej przyrodzie i naturze

Wyodrębniaj ciekawostki o zwierzętach, nazwy naukowe i dane o siedliskach z Animal Corner. Dowiedz się, jak zbudować strukturyzowaną bazę danych o przyrodzie...

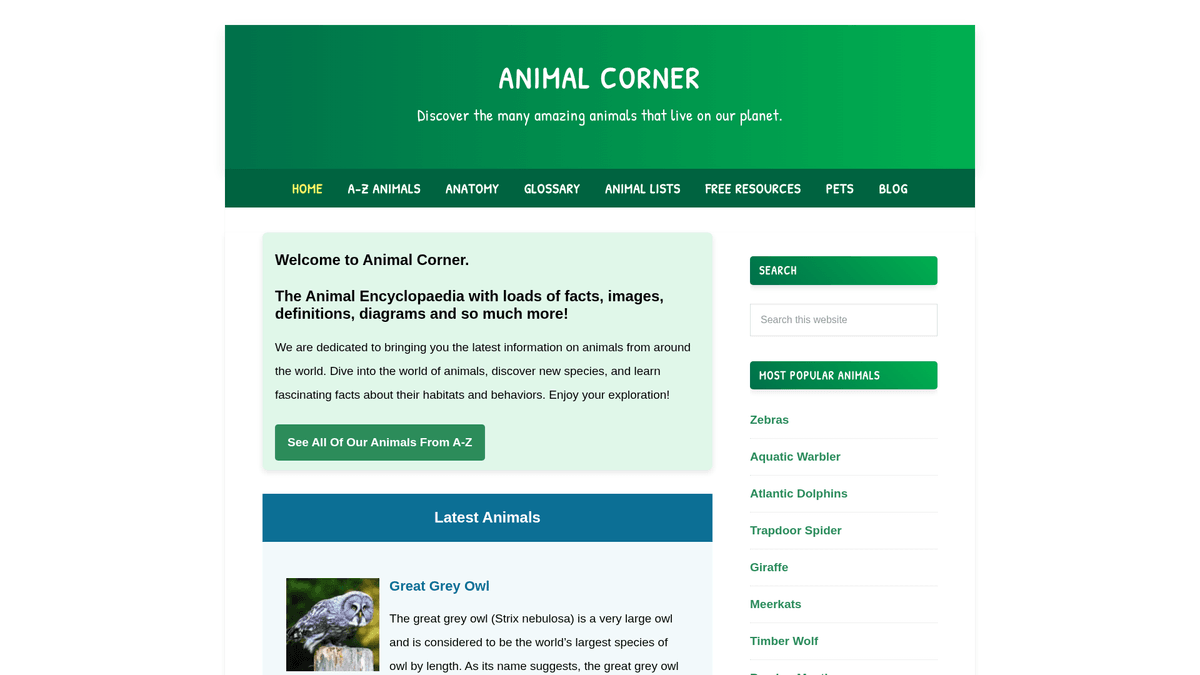

O Animal Corner

Odkryj, co oferuje Animal Corner i jakie cenne dane można wyodrębnić.

Animal Corner to kompleksowa encyklopedia online poświęcona dostarczaniu bogatych informacji o królestwie zwierząt. Służy jako uporządkowane źródło edukacyjne dla uczniów, nauczycieli i entuzjastów przyrody, oferując szczegółowe profile szerokiej gamy gatunków – od pospolitych zwierząt domowych po zagrożoną dziką przyrodę. Platforma organizuje swoje treści w logiczne kategorie, takie jak ssaki, ptaki, gady, ryby, płazy i bezkręgowce.

Każdy wpis w witrynie zawiera istotne dane biologiczne, w tym nazwy zwyczajowe i naukowe, cechy fizyczne, nawyki żywieniowe oraz rozmieszczenie geograficzne. Dla deweloperów i badaczy dane te są niezwykle cenne przy tworzeniu strukturyzowanych zbiorów danych, które mogą zasilać aplikacje edukacyjne, trenować modele machine learning do identyfikacji gatunków lub wspierać badania ekologiczne na dużą skalę. Ponieważ strona jest często aktualizowana o nowe gatunki i statusy ochrony, pozostaje głównym źródłem dla pasjonatów bioróżnorodności.

Dlaczego Scrapować Animal Corner?

Odkryj wartość biznesową i przypadki użycia ekstrakcji danych z Animal Corner.

Tworzenie strukturyzowanej bazy danych o bioróżnorodności do badań naukowych

Gromadzenie wysokiej jakości danych dla aplikacji mobilnych do identyfikacji dzikiej przyrody

Agregowanie faktów dla blogów edukacyjnych i platform o tematyce przyrodniczej

Monitorowanie aktualizacji statusu ochrony gatunków w różnych regionach

Zbieranie danych anatomicznych do porównawczych badań biologicznych

Budowanie zbiorów treningowych dla modeli NLP koncentrujących się na opisach biologicznych

Wyzwania Scrapowania

Wyzwania techniczne, które możesz napotkać podczas scrapowania Animal Corner.

Parsowanie opisowych tekstów na strukturyzowane, szczegółowe punkty danych

Obsługa niespójności w dostępności pól danych dla różnych grup gatunków

Wydajne nawigowanie i crawling tysięcy adresów URL poszczególnych gatunków

Wyodrębnianie nazw naukowych często ukrytych w tekście w nawiasach

Zarządzanie linkami wewnętrznymi i odniesieniami do mediów w akapitach opisowych

Scrapuj Animal Corner z AI

Bez kodowania. Wyodrębnij dane w kilka minut dzięki automatyzacji opartej na AI.

Jak to działa

Opisz, czego potrzebujesz

Powiedz AI, jakie dane chcesz wyodrębnić z Animal Corner. Po prostu wpisz to w języku naturalnym — bez kodu czy selektorów.

AI wyodrębnia dane

Nasza sztuczna inteligencja nawiguje po Animal Corner, obsługuje dynamiczną treść i wyodrębnia dokładnie to, o co prosiłeś.

Otrzymaj swoje dane

Otrzymaj czyste, ustrukturyzowane dane gotowe do eksportu jako CSV, JSON lub do bezpośredniego przesłania do twoich aplikacji.

Dlaczego warto używać AI do scrapowania

AI ułatwia scrapowanie Animal Corner bez pisania kodu. Nasza platforma oparta na sztucznej inteligencji rozumie, jakich danych potrzebujesz — po prostu opisz je w języku naturalnym, a AI wyodrębni je automatycznie.

How to scrape with AI:

- Opisz, czego potrzebujesz: Powiedz AI, jakie dane chcesz wyodrębnić z Animal Corner. Po prostu wpisz to w języku naturalnym — bez kodu czy selektorów.

- AI wyodrębnia dane: Nasza sztuczna inteligencja nawiguje po Animal Corner, obsługuje dynamiczną treść i wyodrębnia dokładnie to, o co prosiłeś.

- Otrzymaj swoje dane: Otrzymaj czyste, ustrukturyzowane dane gotowe do eksportu jako CSV, JSON lub do bezpośredniego przesłania do twoich aplikacji.

Why use AI for scraping:

- Wizualny wybór złożonych bloków danych o zwierzętach bez użycia kodu

- Automatyczny crawling stron kategorii i indeksów A-Z bez konieczności pisania skryptów

- Czyszczenie i formatowanie tekstu bezpośrednio wewnątrz narzędzia

- Zaplanowane uruchomienia w celu wychwytywania aktualizacji statusów gatunków zagrożonych

- Bezpośredni eksport do Google Sheets lub JSON dla natychmiastowej integracji z aplikacją

Scrapery No-Code dla Animal Corner

Alternatywy point-and-click dla scrapingu opartego na AI

Różne narzędzia no-code jak Browse.ai, Octoparse, Axiom i ParseHub mogą pomóc w scrapowaniu Animal Corner bez pisania kodu. Te narzędzia używają wizualnych interfejsów do wyboru danych, choć mogą mieć problemy ze złożoną dynamiczną zawartością lub zabezpieczeniami anti-bot.

Typowy Workflow z Narzędziami No-Code

Częste Wyzwania

Krzywa uczenia

Zrozumienie selektorów i logiki ekstrakcji wymaga czasu

Selektory się psują

Zmiany na stronie mogą zepsuć cały przepływ pracy

Problemy z dynamiczną treścią

Strony bogate w JavaScript wymagają złożonych obejść

Ograniczenia CAPTCHA

Większość narzędzi wymaga ręcznej interwencji przy CAPTCHA

Blokowanie IP

Agresywne scrapowanie może prowadzić do zablokowania IP

Scrapery No-Code dla Animal Corner

Różne narzędzia no-code jak Browse.ai, Octoparse, Axiom i ParseHub mogą pomóc w scrapowaniu Animal Corner bez pisania kodu. Te narzędzia używają wizualnych interfejsów do wyboru danych, choć mogą mieć problemy ze złożoną dynamiczną zawartością lub zabezpieczeniami anti-bot.

Typowy Workflow z Narzędziami No-Code

- Zainstaluj rozszerzenie przeglądarki lub zarejestruj się na platformie

- Przejdź do docelowej strony i otwórz narzędzie

- Wybierz elementy danych do wyodrębnienia metodą point-and-click

- Skonfiguruj selektory CSS dla każdego pola danych

- Ustaw reguły paginacji do scrapowania wielu stron

- Obsłuż CAPTCHA (często wymaga ręcznego rozwiązywania)

- Skonfiguruj harmonogram automatycznych uruchomień

- Eksportuj dane do CSV, JSON lub połącz przez API

Częste Wyzwania

- Krzywa uczenia: Zrozumienie selektorów i logiki ekstrakcji wymaga czasu

- Selektory się psują: Zmiany na stronie mogą zepsuć cały przepływ pracy

- Problemy z dynamiczną treścią: Strony bogate w JavaScript wymagają złożonych obejść

- Ograniczenia CAPTCHA: Większość narzędzi wymaga ręcznej interwencji przy CAPTCHA

- Blokowanie IP: Agresywne scrapowanie może prowadzić do zablokowania IP

Przykłady kodu

import requests

from bs4 import BeautifulSoup

# Target URL for a specific animal

url = 'https://animalcorner.org/animals/african-elephant/'

# Standard headers to mimic a real browser

headers = {'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/91.0.4472.124 Safari/537.36'}

try:

response = requests.get(url, headers=headers)

response.raise_for_status()

soup = BeautifulSoup(response.text, 'html.parser')

# Extracting animal name

title = soup.find('h1').text.strip()

print(f'Animal: {title}')

# Extracting first paragraph which usually contains the scientific name

intro = soup.find('p').text.strip()

print(f'Intro Facts: {intro[:150]}...')

except requests.exceptions.RequestException as e:

print(f'Error scraping Animal Corner: {e}')Kiedy Używać

Najlepsze dla statycznych stron HTML z minimalnym JavaScript. Idealne dla blogów, serwisów informacyjnych i prostych stron produktowych e-commerce.

Zalety

- ●Najszybsze wykonanie (bez narzutu przeglądarki)

- ●Najniższe zużycie zasobów

- ●Łatwe do zrównoleglenia z asyncio

- ●Świetne dla API i stron statycznych

Ograniczenia

- ●Nie może wykonywać JavaScript

- ●Zawodzi na SPA i dynamicznej zawartości

- ●Może mieć problemy ze złożonymi systemami anti-bot

Jak scrapować Animal Corner za pomocą kodu

Python + Requests

import requests

from bs4 import BeautifulSoup

# Target URL for a specific animal

url = 'https://animalcorner.org/animals/african-elephant/'

# Standard headers to mimic a real browser

headers = {'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/91.0.4472.124 Safari/537.36'}

try:

response = requests.get(url, headers=headers)

response.raise_for_status()

soup = BeautifulSoup(response.text, 'html.parser')

# Extracting animal name

title = soup.find('h1').text.strip()

print(f'Animal: {title}')

# Extracting first paragraph which usually contains the scientific name

intro = soup.find('p').text.strip()

print(f'Intro Facts: {intro[:150]}...')

except requests.exceptions.RequestException as e:

print(f'Error scraping Animal Corner: {e}')Python + Playwright

from playwright.sync_api import sync_playwright

def scrape_animal_corner():

with sync_playwright() as p:

# Launch headless browser

browser = p.chromium.launch(headless=True)

page = browser.new_page()

page.goto('https://animalcorner.org/animals/african-elephant/')

# Wait for the main heading to load

title = page.inner_text('h1')

print(f'Animal Name: {title}')

# Extract specific fact paragraphs

facts = page.query_selector_all('p')

for fact in facts[:3]:

print(f'Fact: {fact.inner_text()}')

browser.close()

if __name__ == "__main__":

scrape_animal_corner()Python + Scrapy

import scrapy

class AnimalSpider(scrapy.Spider):

name = 'animal_spider'

start_urls = ['https://animalcorner.org/animals/']

def parse(self, response):

# Follow links to individual animal pages within the directory

for animal_link in response.css('a[href*="/animals/"]::attr(href)').getall():

yield response.follow(animal_link, self.parse_animal)

def parse_animal(self, response):

# Extract structured data from animal profiles

yield {

'common_name': response.css('h1::text').get().strip(),

'scientific_name': response.xpath('//p[contains(., "(")]/text()').re_first(r'\((.*?)\)'),

'description': ' '.join(response.css('p::text').getall()[:5])

}Node.js + Puppeteer

const puppeteer = require('puppeteer');

(async () => {

const browser = await puppeteer.launch();

const page = await browser.newPage();

await page.goto('https://animalcorner.org/animals/african-elephant/');

const data = await page.evaluate(() => {

// Extract the title and introductory paragraph

return {

title: document.querySelector('h1').innerText.trim(),

firstParagraph: document.querySelector('p').innerText.trim()

};

});

console.log('Extracted Data:', data);

await browser.close();

})();Co Możesz Zrobić Z Danymi Animal Corner

Poznaj praktyczne zastosowania i wnioski z danych Animal Corner.

Edukacyjna aplikacja z fiszkami

Stwórz mobilną aplikację do nauki, która wykorzystuje fakty o zwierzętach i wysokiej jakości obrazy, aby uczyć o bioróżnorodności.

Jak wdrożyć:

- 1Pobieraj nazwy zwierząt, cechy fizyczne i wyróżnione obrazy

- 2Kategoryzuj zwierzęta według poziomu trudności lub grupy biologicznej

- 3Zaprojektuj interfejs interaktywnego quizu na podstawie zebranych danych

- 4Wdróż śledzenie postępów, aby pomóc użytkownikom opanować rozpoznawanie gatunków

Użyj Automatio do wyodrębnienia danych z Animal Corner i budowania tych aplikacji bez pisania kodu.

Co Możesz Zrobić Z Danymi Animal Corner

- Edukacyjna aplikacja z fiszkami

Stwórz mobilną aplikację do nauki, która wykorzystuje fakty o zwierzętach i wysokiej jakości obrazy, aby uczyć o bioróżnorodności.

- Pobieraj nazwy zwierząt, cechy fizyczne i wyróżnione obrazy

- Kategoryzuj zwierzęta według poziomu trudności lub grupy biologicznej

- Zaprojektuj interfejs interaktywnego quizu na podstawie zebranych danych

- Wdróż śledzenie postępów, aby pomóc użytkownikom opanować rozpoznawanie gatunków

- Zbiór danych do badań zoologicznych

Dostarcz strukturyzowany zbiór danych dla badaczy porównujących statystyki anatomiczne między różnymi rodzinami gatunków.

- Wyodrębnij konkretne statystyki numeryczne, takie jak tętno i okres ciąży

- Znormalizuj jednostki miary (np. kilogramy, metry) poprzez czyszczenie danych

- Uporządkuj dane według klasyfikacji naukowej (rząd, rodzina, rodzaj)

- Eksportuj finalny zbiór danych do formatu CSV w celu zaawansowanej analizy statystycznej

- Automatyczny publikator na bloga przyrodniczego

Automatycznie generuj codzienne treści do mediów społecznościowych lub na bloga, prezentując fakty z cyklu „Zwierzę dnia”.

- Pobieraj dużą pulę ciekawostek o zwierzętach z encyklopedii

- Zaplanuj skrypt wybierający losowy profil zwierzęcia co 24 godziny

- Sformatuj wyodrębniony tekst w angażujący szablon postu

- Użyj API mediów społecznościowych, aby publikować treści wraz ze zdjęciem zwierzęcia

- Narzędzie do monitorowania ochrony przyrody

Zbuduj dashboard, który wyróżnia zwierzęta aktualnie znajdujące się na listach ze statusem „zagrożone” lub „narażone”.

- Pobieraj nazwy gatunków wraz z ich specyficznym statusem ochrony

- Filtruj bazę danych, aby wyodrębnić kategorie gatunków wysokiego ryzyka

- Przypisz te gatunki do zgłoszonych regionów geograficznych

- Skonfiguruj cykliczne sesje scrapowania, aby śledzić zmiany w statusie ochrony

Przyspiesz swoj workflow z automatyzacja AI

Automatio laczy moc agentow AI, automatyzacji web i inteligentnych integracji, aby pomoc Ci osiagnac wiecej w krotszym czasie.

Profesjonalne Porady dla Scrapowania Animal Corner

Porady ekspertów dotyczące skutecznej ekstrakcji danych z Animal Corner.

Zacznij crawl od strony z listą A-Z, aby zapewnić kompleksowe pokrycie wszystkich gatunków

Używaj wyrażeń regularnych do wyodrębniania nazw naukowych, które często znajdują się w nawiasach obok nazwy zwyczajowej

Ustaw opóźnienie (crawl delay) na 1-2 sekundy między żądaniami, aby szanować zasoby witryny i unikać limitów rate limits

Kieruj się na konkretne podfoldery kategorii, takie jak /mammals/ lub /birds/, jeśli potrzebujesz tylko danych niszowych

Pobieraj i przechowuj obrazy zwierząt lokalnie, zamiast stosować hotlinking, aby utrzymać stabilność aplikacji

Oczyść teksty opisowe, usuwając wewnętrzne linki w stylu wiki, aby zapewnić płynniejszy odbiór treści

Opinie

Co mowia nasi uzytkownicy

Dolacz do tysiecy zadowolonych uzytkownikow, ktorzy przeksztalcili swoj workflow

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Powiazane Web Scraping

How to Scrape Bilregistret.ai: Swedish Vehicle Data Extraction Guide

How to Scrape Biluppgifter.se: Vehicle Data Extraction Guide

How to Scrape The AA (theaa.com): A Technical Guide for Car & Insurance Data

How to Scrape CSS Author: A Comprehensive Web Scraping Guide

How to Scrape Car.info | Vehicle Data & Valuation Extraction Guide

How to Scrape GoAbroad Study Abroad Programs

How to Scrape ResearchGate: Publication and Researcher Data

How to Scrape Statista: The Ultimate Guide to Market Data Extraction

Często Zadawane Pytania o Animal Corner

Znajdź odpowiedzi na częste pytania o Animal Corner