Jak scrapować CoinCatapult: Kompletny przewodnik po danych kryptowalutowych

Dowiedz się, jak wyodrębniać nazwy projektów, liczbę głosów, adresy kontraktów i daty startu z CoinCatapult. Idealne rozwiązanie do analiz DeFi i generowania...

Wykryto ochronę przed botami

- Cloudflare

- Korporacyjny WAF i zarządzanie botami. Używa wyzwań JavaScript, CAPTCHA i analizy behawioralnej. Wymaga automatyzacji przeglądarki z ustawieniami stealth.

- Ograniczanie szybkości

- Ogranicza liczbę żądań na IP/sesję w czasie. Można obejść za pomocą rotacyjnych proxy, opóźnień żądań i rozproszonego scrapingu.

- Blokowanie IP

- Blokuje znane IP centrów danych i oznaczone adresy. Wymaga rezydencjalnych lub mobilnych proxy do skutecznego obejścia.

- Wyzwanie JavaScript

- Wymaga wykonania JavaScript, aby uzyskać dostęp do treści. Proste żądania nie przejdą; potrzebna przeglądarka headless jak Playwright lub Puppeteer.

O CoinCatapult

Odkryj, co oferuje CoinCatapult i jakie cenne dane można wyodrębnić.

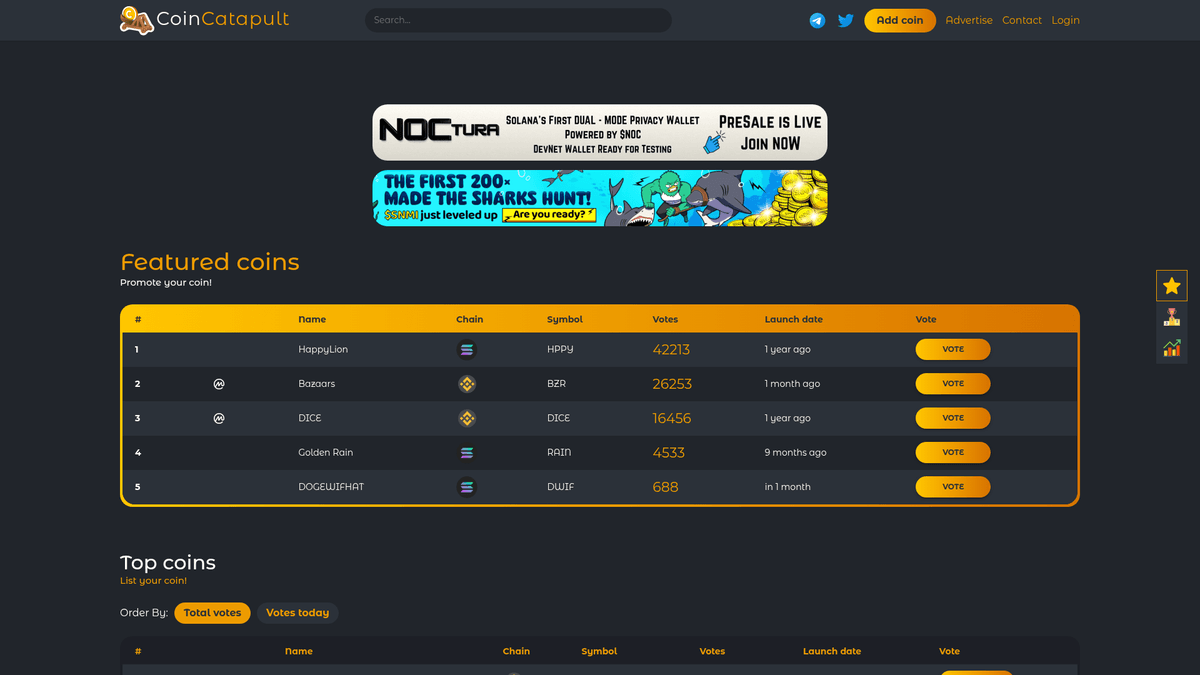

Launchpad do odkrywania DeFi

CoinCatapult to popularna platforma listingowa i społecznościowa służąca do głosowania na projekty DeFi we wczesnej fazie rozwoju. Służy jako cyfrowe centrum, w którym deweloperzy umieszczają nowe tokeny, aby zyskać widoczność, podczas gdy traderzy wykorzystują platformę do odkrywania potencjalnych „perełek” dzięki głosom społeczności i rankingom popularności.

Kompleksowe dane o listingach

Platforma zawiera tysiące projektów z różnych sieci blockchain, w tym Solana, Binance Smart Chain oraz Ethereum. Każdy wpis dostarcza kluczowych metadanych, takich jak status startu, liczba głosów w czasie rzeczywistym oraz linki społecznościowe, co czyni ją głównym źródłem do śledzenia dynamiki nowych tokenów.

Dlaczego te dane są ważne

Scrapowanie CoinCatapult jest niezwykle wartościowe dla badaczy rynku krypto, agencji marketingowych i deweloperów blockchain. Wyodrębniając te dane, użytkownicy mogą identyfikować trendujące nisze, monitorować krajobraz konkurencyjny różnych sieci (chains) oraz generować leady dla usług audytu bezpieczeństwa lub marketingu skierowanego do właścicieli nowych projektów.

Dlaczego Scrapować CoinCatapult?

Odkryj wartość biznesową i przypadki użycia ekstrakcji danych z CoinCatapult.

Monitorowanie nowych projektów DeFi w czasie rzeczywistym dla wczesnych inwestycji.

Generowanie leadów dla usług audytu smart kontraktów i bezpieczeństwa.

Analiza nastrojów na podstawie dziennej i całkowitej dynamiki głosów społeczności.

Badania rynkowe w celu śledzenia trendujących sieci blockchain.

Analiza konkurencji dla innych platform listingowych.

Agregacja danych dla serwisów informacyjnych krypto i narzędzi analitycznych.

Wyzwania Scrapowania

Wyzwania techniczne, które możesz napotkać podczas scrapowania CoinCatapult.

Zabezpieczenia anty-botowe Cloudflare wymagają zaawansowanych technik omijania.

Dynamiczne aktualizacje liczby głosów mogą wymagać renderowania JavaScript.

Agresywne limity zapytań (rate limiting) na konkretne zakresy IP często prowadzą do tymczasowych blokad.

Niespójne struktury tabel na różnych stronach kategorii.

Scrapuj CoinCatapult z AI

Bez kodowania. Wyodrębnij dane w kilka minut dzięki automatyzacji opartej na AI.

Jak to działa

Opisz, czego potrzebujesz

Powiedz AI, jakie dane chcesz wyodrębnić z CoinCatapult. Po prostu wpisz to w języku naturalnym — bez kodu czy selektorów.

AI wyodrębnia dane

Nasza sztuczna inteligencja nawiguje po CoinCatapult, obsługuje dynamiczną treść i wyodrębnia dokładnie to, o co prosiłeś.

Otrzymaj swoje dane

Otrzymaj czyste, ustrukturyzowane dane gotowe do eksportu jako CSV, JSON lub do bezpośredniego przesłania do twoich aplikacji.

Dlaczego warto używać AI do scrapowania

AI ułatwia scrapowanie CoinCatapult bez pisania kodu. Nasza platforma oparta na sztucznej inteligencji rozumie, jakich danych potrzebujesz — po prostu opisz je w języku naturalnym, a AI wyodrębni je automatycznie.

How to scrape with AI:

- Opisz, czego potrzebujesz: Powiedz AI, jakie dane chcesz wyodrębnić z CoinCatapult. Po prostu wpisz to w języku naturalnym — bez kodu czy selektorów.

- AI wyodrębnia dane: Nasza sztuczna inteligencja nawiguje po CoinCatapult, obsługuje dynamiczną treść i wyodrębnia dokładnie to, o co prosiłeś.

- Otrzymaj swoje dane: Otrzymaj czyste, ustrukturyzowane dane gotowe do eksportu jako CSV, JSON lub do bezpośredniego przesłania do twoich aplikacji.

Why use AI for scraping:

- Automatycznie omija Cloudflare i inne systemy wykrywania botów.

- Interfejs no-code pozwala na szybką ekstrakcję bez pisania skryptów.

- Harmonogram zadań umożliwia całodobowe monitorowanie nowych projektów.

- Bezpośrednia integracja z Google Sheets dla natychmiastowej analizy danych.

Scrapery No-Code dla CoinCatapult

Alternatywy point-and-click dla scrapingu opartego na AI

Różne narzędzia no-code jak Browse.ai, Octoparse, Axiom i ParseHub mogą pomóc w scrapowaniu CoinCatapult bez pisania kodu. Te narzędzia używają wizualnych interfejsów do wyboru danych, choć mogą mieć problemy ze złożoną dynamiczną zawartością lub zabezpieczeniami anti-bot.

Typowy Workflow z Narzędziami No-Code

Częste Wyzwania

Krzywa uczenia

Zrozumienie selektorów i logiki ekstrakcji wymaga czasu

Selektory się psują

Zmiany na stronie mogą zepsuć cały przepływ pracy

Problemy z dynamiczną treścią

Strony bogate w JavaScript wymagają złożonych obejść

Ograniczenia CAPTCHA

Większość narzędzi wymaga ręcznej interwencji przy CAPTCHA

Blokowanie IP

Agresywne scrapowanie może prowadzić do zablokowania IP

Scrapery No-Code dla CoinCatapult

Różne narzędzia no-code jak Browse.ai, Octoparse, Axiom i ParseHub mogą pomóc w scrapowaniu CoinCatapult bez pisania kodu. Te narzędzia używają wizualnych interfejsów do wyboru danych, choć mogą mieć problemy ze złożoną dynamiczną zawartością lub zabezpieczeniami anti-bot.

Typowy Workflow z Narzędziami No-Code

- Zainstaluj rozszerzenie przeglądarki lub zarejestruj się na platformie

- Przejdź do docelowej strony i otwórz narzędzie

- Wybierz elementy danych do wyodrębnienia metodą point-and-click

- Skonfiguruj selektory CSS dla każdego pola danych

- Ustaw reguły paginacji do scrapowania wielu stron

- Obsłuż CAPTCHA (często wymaga ręcznego rozwiązywania)

- Skonfiguruj harmonogram automatycznych uruchomień

- Eksportuj dane do CSV, JSON lub połącz przez API

Częste Wyzwania

- Krzywa uczenia: Zrozumienie selektorów i logiki ekstrakcji wymaga czasu

- Selektory się psują: Zmiany na stronie mogą zepsuć cały przepływ pracy

- Problemy z dynamiczną treścią: Strony bogate w JavaScript wymagają złożonych obejść

- Ograniczenia CAPTCHA: Większość narzędzi wymaga ręcznej interwencji przy CAPTCHA

- Blokowanie IP: Agresywne scrapowanie może prowadzić do zablokowania IP

Przykłady kodu

import requests

from bs4 import BeautifulSoup

# CoinCatapult requires a real browser User-Agent

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/91.0.4472.124 Safari/537.36'

}

url = 'https://coincatapult.com/'

try:

response = requests.get(url, headers=headers)

# Check for Cloudflare/Block status

response.raise_for_status()

soup = BeautifulSoup(response.text, 'html.parser')

# Select rows from the main listing table

rows = soup.select('table tbody tr')

for row in rows:

cols = row.find_all('td')

if len(cols) > 5:

name = cols[2].get_text(strip=True)

symbol = cols[4].get_text(strip=True)

votes = cols[5].get_text(strip=True)

print(f'Project: {name} | Symbol: {symbol} | Votes: {votes}')

except Exception as e:

print(f'An error occurred: {e}')Kiedy Używać

Najlepsze dla statycznych stron HTML z minimalnym JavaScript. Idealne dla blogów, serwisów informacyjnych i prostych stron produktowych e-commerce.

Zalety

- ●Najszybsze wykonanie (bez narzutu przeglądarki)

- ●Najniższe zużycie zasobów

- ●Łatwe do zrównoleglenia z asyncio

- ●Świetne dla API i stron statycznych

Ograniczenia

- ●Nie może wykonywać JavaScript

- ●Zawodzi na SPA i dynamicznej zawartości

- ●Może mieć problemy ze złożonymi systemami anti-bot

Jak scrapować CoinCatapult za pomocą kodu

Python + Requests

import requests

from bs4 import BeautifulSoup

# CoinCatapult requires a real browser User-Agent

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/91.0.4472.124 Safari/537.36'

}

url = 'https://coincatapult.com/'

try:

response = requests.get(url, headers=headers)

# Check for Cloudflare/Block status

response.raise_for_status()

soup = BeautifulSoup(response.text, 'html.parser')

# Select rows from the main listing table

rows = soup.select('table tbody tr')

for row in rows:

cols = row.find_all('td')

if len(cols) > 5:

name = cols[2].get_text(strip=True)

symbol = cols[4].get_text(strip=True)

votes = cols[5].get_text(strip=True)

print(f'Project: {name} | Symbol: {symbol} | Votes: {votes}')

except Exception as e:

print(f'An error occurred: {e}')Python + Playwright

from playwright.sync_api import sync_playwright

def scrape_coincatapult():

with sync_playwright() as p:

# Launching with a real browser head can help bypass basic checks

browser = p.chromium.launch(headless=True)

page = browser.new_page()

# Navigate to the site

page.goto('https://coincatapult.com/', wait_until='networkidle')

# Wait for the table to render

page.wait_for_selector('table')

# Extract data using Javascript evaluation

coins = page.evaluate("""() => {

const rows = Array.from(document.querySelectorAll('table tbody tr'));

return rows.map(row => {

const tds = row.querySelectorAll('td');

return {

name: tds[2]?.innerText.trim(),

chain: tds[3]?.querySelector('img')?.alt || 'Unknown',

votes: tds[5]?.innerText.trim()

};

});

}""")

for coin in coins:

print(coin)

browser.close()

if __name__ == '__main__':

scrape_coincatapult()Python + Scrapy

import scrapy

class CoinSpider(scrapy.Spider):

name = 'coincatapult_spider'

start_urls = ['https://coincatapult.com/']

def parse(self, response):

# Iterate through table rows using CSS selectors

for row in response.css('table tbody tr'):

yield {

'name': row.css('td:nth-child(3)::text').get(),

'symbol': row.css('td:nth-child(5)::text').get(),

'votes': row.css('td:nth-child(6)::text').get(),

'launch_date': row.css('td:nth-child(7)::text').get()

}

# Basic pagination handling if a 'Next' link exists

next_page = response.css('ul.pagination li.next a::attr(href)').get()

if next_page:

yield response.follow(next_page, self.parse)Node.js + Puppeteer

const puppeteer = require('puppeteer');

(async () => {

const browser = await puppeteer.launch({ headless: true });

const page = await browser.newPage();

// Set a realistic viewport

await page.setViewport({ width: 1280, height: 800 });

// Go to CoinCatapult

await page.goto('https://coincatapult.com/', { waitUntil: 'networkidle2' });

const data = await page.evaluate(() => {

const results = [];

const rows = document.querySelectorAll('table tbody tr');

rows.forEach(row => {

const cells = row.querySelectorAll('td');

if (cells.length >= 6) {

results.push({

name: cells[2].innerText.trim(),

chain: cells[3].querySelector('img')?.alt || 'N/A',

votes: cells[5].innerText.trim()

});

}

});

return results;

});

console.log(data);

await browser.close();

})();Co Możesz Zrobić Z Danymi CoinCatapult

Poznaj praktyczne zastosowania i wnioski z danych CoinCatapult.

Alerty wielorybów (Whale Alerts) w czasie rzeczywistym

Zautomatyzowany system powiadamiający traderów, gdy projekt zyskuje ogromną dynamikę głosów w krótkim czasie.

Jak wdrożyć:

- 1Scrapuj kolumnę 'Votes Today' co 30 minut.

- 2Porównaj aktualną liczbę głosów z danymi z poprzedniego pobrania.

- 3Uruchom alert, jeśli liczba głosów projektu wzrośnie o ponad 50% w ciągu godziny.

Użyj Automatio do wyodrębnienia danych z CoinCatapult i budowania tych aplikacji bez pisania kodu.

Co Możesz Zrobić Z Danymi CoinCatapult

- Alerty wielorybów (Whale Alerts) w czasie rzeczywistym

Zautomatyzowany system powiadamiający traderów, gdy projekt zyskuje ogromną dynamikę głosów w krótkim czasie.

- Scrapuj kolumnę 'Votes Today' co 30 minut.

- Porównaj aktualną liczbę głosów z danymi z poprzedniego pobrania.

- Uruchom alert, jeśli liczba głosów projektu wzrośnie o ponad 50% w ciągu godziny.

- Outreach w marketingu krypto

Identyfikuj właścicieli nowych projektów DeFi, którzy mogą potrzebować profesjonalnych usług marketingowych lub listingowych.

- Codziennie wyodrębniaj linki do Telegrama i Twittera z sekcji 'New Coins'.

- Kategoryzuj projekty według blockchain (np. SOL, ETH), aby dotrzeć do konkretnych społeczności.

- Wysyłaj spersonalizowane wiadomości do oficjalnych kanałów społecznościowych projektów.

- Raporty kondycji ekosystemów

Generuj raporty pokazujące, które sieci blockchain (np. Solana vs BSC) przyciągają więcej deweloperów.

- Scrapuj wszystkie listingi projektów wraz z powiązaną siecią blockchain.

- Zliczaj liczbę nowych startów w danej sieci w skali miesiąca.

- Wizualizuj trendy wzrostu, aby zidentyfikować, który ekosystem dominuje na rynku 'degen'.

- Generowanie leadów przedstartowych

Znajduj projekty o statusie 'Presale' lub nadchodzącej dacie startu, aby oferować usługi audytu smart kontraktów.

- Filtruj wyniki scrapowania dla projektów, których 'Launch Date' przypada w przyszłości.

- Wyodrębnij adres kontraktu (jeśli jest podany) lub dane kontaktowe do mediów społecznościowych.

- Przedstawiaj oferty audytu deweloperom przed ich wejściem na mainnet.

Przyspiesz swoj workflow z automatyzacja AI

Automatio laczy moc agentow AI, automatyzacji web i inteligentnych integracji, aby pomoc Ci osiagnac wiecej w krotszym czasie.

Profesjonalne Porady dla Scrapowania CoinCatapult

Porady ekspertów dotyczące skutecznej ekstrakcji danych z CoinCatapult.

Używaj rezydencjalnych serwerów proxy zamiast adresów IP z centrów danych, aby ominąć zabezpieczenia Cloudflare.

Zastosuj losowe interwały oczekiwania (sleep) między 5 a 15 sekundami, aby uniknąć aktywowania rate limits.

Scrapuj strony konkretnych kategorii (np. Solana, BSC) oddzielnie, aby efektywniej zarządzać dużymi wolumenami danych.

Wykorzystaj przeglądarki headless, takie jak Playwright lub Puppeteer, z wtyczkami typu 'Stealth', aby uzyskać wyższą skuteczność.

Przechowuj wyodrębnione adresy kontraktów (contract addresses) w bazie danych, aby przeprowadzać weryfikację krzyżową z danymi on-chain.

Monitoruj sekcję 'New Coins' co 10-15 minut, aby wyłapać nowe listingi natychmiast po ich pojawieniu się.

Opinie

Co mowia nasi uzytkownicy

Dolacz do tysiecy zadowolonych uzytkownikow, ktorzy przeksztalcili swoj workflow

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Jonathan Kogan

Co-Founder/CEO, rpatools.io

Automatio is one of the most used for RPA Tools both internally and externally. It saves us countless hours of work and we realized this could do the same for other startups and so we choose Automatio for most of our automation needs.

Mohammed Ibrahim

CEO, qannas.pro

I have used many tools over the past 5 years, Automatio is the Jack of All trades.. !! it could be your scraping bot in the morning and then it becomes your VA by the noon and in the evening it does your automations.. its amazing!

Ben Bressington

CTO, AiChatSolutions

Automatio is fantastic and simple to use to extract data from any website. This allowed me to replace a developer and do tasks myself as they only take a few minutes to setup and forget about it. Automatio is a game changer!

Sarah Chen

Head of Growth, ScaleUp Labs

We've tried dozens of automation tools, but Automatio stands out for its flexibility and ease of use. Our team productivity increased by 40% within the first month of adoption.

David Park

Founder, DataDriven.io

The AI-powered features in Automatio are incredible. It understands context and adapts to changes in websites automatically. No more broken scrapers!

Emily Rodriguez

Marketing Director, GrowthMetrics

Automatio transformed our lead generation process. What used to take our team days now happens automatically in minutes. The ROI is incredible.

Powiazane Web Scraping

How to Scrape Biluppgifter.se: Vehicle Data Extraction Guide

How to Scrape The AA (theaa.com): A Technical Guide for Car & Insurance Data

How to Scrape Bilregistret.ai: Swedish Vehicle Data Extraction Guide

How to Scrape CSS Author: A Comprehensive Web Scraping Guide

How to Scrape GoAbroad Study Abroad Programs

How to Scrape Car.info | Vehicle Data & Valuation Extraction Guide

How to Scrape ResearchGate: Publication and Researcher Data

How to Scrape Statista: The Ultimate Guide to Market Data Extraction

Często Zadawane Pytania o CoinCatapult

Znajdź odpowiedzi na częste pytania o CoinCatapult